基于卷积神经网络的超分辨率失真控制图像重构研究

2024-04-19舒忠郑波儿

舒忠,郑波儿

基于卷积神经网络的超分辨率失真控制图像重构研究

舒忠1,2,郑波儿1

(1.荆楚理工学院 电子信息工程学院,湖北 荆门 448000;2.荆门融媒网络科技有限公司,湖北 荆门 448000)

解决超分辨率图像重构模型中存在的功能单元之间关联性差,图像色度特征提取完整性不强、超分辨率重构失真控制和采样过程残差控制偏弱等问题。通过在卷积神经网络模型引入双激活函数,提高模型中各功能单元之间的兼容连接性;引用密集连接卷积神经网络构建超分辨率失真控制单元,分别实现对4个色度分量进行卷积补偿运算;将残差插值函数应用于上采样单元中,使用深度反投影网络规则实现超分辨率色度特征插值运算。设计的模型集联了内部多个卷积核,实现了超分辨率色度失真补偿,使用了统一的处理权值,确保了整个模型内部组成单元的有机融合。相关实验结果验证了本文图像重构模型具有良好可靠性、稳定性和高效性。

卷积神经网络;超分辨率;激活函数;转置卷积;深度反投影网络模型;图像重构

早期的图像压缩失真恢复方法通常以最近邻域法和线性插值法为基础并加以相应的改进,其失真恢复结果并不理想,以伪彩色和边缘锯齿效应等现象表现最为突出[1]。随着残差插值方法[2-5]的提出,对基于伪彩色和边缘锯齿效应的图像压缩失真现象起到较好的约束作用。近些年来,随着深度学习字典在压缩图像重构领域的广泛应用,特别是应用卷积神经网络(Convolutional Neural Networks,CNN)通过设计2个或3个阶段的图像色度参数控制[6-8],进行压缩编码失真恢复处理;还有通过残差插值与CNN结合的压缩编码失真控制[9-11]、超分辨率(Super-Resolution)图像处理机制与CNN结合的压缩编码失真控制[12-14]等压缩图像重构方法等。

以上基于残差插值、基于CNN模型应用和基于超分辨率处理三大类图像重构方法,处理机制的总体思想在本质上是一致的,都是以分量为首要突破口,充分利用颜色分量的失真控制恢复经验,指导其他颜色分量进行恢复重构。3种方法只关注了下采样过程在图像重构中的重要性,忽视了对上采样过程的影响因素。其中,基于残差插值的图像重构过度依赖复杂的数学模型运算,忽略了对机器学习模型存在优势的充分利用。基于CNN模型应用和基于超分辨率处理2种图像重构方法则过度依赖CCN网络模型的结构优势,将色彩空间转换采样处理和图像重构处理融合在一起,使得CCN网络模型结构过度复杂。以上因素的存在,是本文开展相关研究的依据。

本文结合对基于残差插值和基于深度学习的压缩编码图像重构原理的分析,以卷积神经网络为处理平台,制定压缩编码图像重构策略。主要的研究目标包括:减小卷积神经网络模型的构建复杂度,提高处理效率;对图像边缘特征提取的损失进行有效控制,提高图像边缘特征的描述准确性;在图像重构的边缘特征映射策略中,引入多次上采样策略,提高上采样图像像素采集的准确度;选取上采样提取的有效图像边缘特征实现图像重构。

1 本文图像重构模型构建

1.1 模型总体架构

通过对当前经典的压缩图像重构和失真控制策略进行分析,本文提出的压缩编码图像重构模型,重点考虑2个方面的因素:由于图像压缩编码后存在亮度和色度失真,因此压缩图像重构消除失真影响最有效的环节应在上采样之前;由于卷积神经网络模型的层次结构丰富,具有较大的可扩展性,在应用中会出现失真残差值的梯度过度增大或梯度完全消失2种情况,将超分辨率图像处理策略应用于残差计算,可以大幅简化卷积神经网络的层次结构。本文设计的基于卷积神经网络的超分辨率失真控制重构模型(Convolutional Neural Networks Super Resolution Model,CNN-SR-M)处理流程如图1所示。

图1 基于卷积神经网络的超分辨率失真控制重构模型处理流程

1.2 模型构建

1.2.1 图像色度特征提取单元

CNN-SR-M模型各功能单元内部结构和处理策略如下:

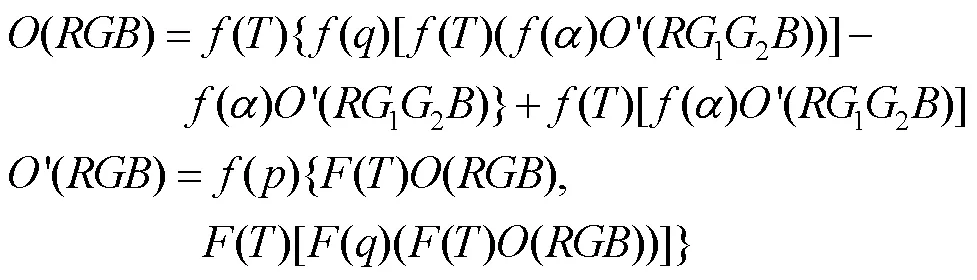

图像色度特征提取单元使用LeNet-5[15]作为基本的CNN模型,通过卷积运算提取图像色度特征,省去LeNet-5中的池化、全连接层结构,该单元可以提取图像各颜色通道的边缘特征信息,本质上就是需要对边缘特征进行残差补偿的信息。色度特征提取使用的卷积核激活函数采用Rectified Linear Unit(ReLU)[16],ReLU优于CNN模型中常用的Sigmoid和Tanh激活函数。ReLU的计算方法简单,通过设计有效的阈值就可以控制神经元的开启,不需要进行复杂的导数求极值运算,还可以获取产生色度边缘信息的稀疏特征;由于ReLU可以引入多个图像样本参与模型进行训练,可以防止出现误差过大产生的过拟合现象,避免了与正则化(Droupout)结合时而造成的兼容性差等问题。色度特征提取单元设计了2个卷积层,设定第2个卷积核的数量为第1个卷积核的2倍。定义图像色度特征提取的输出为(12),压缩编码图像的输入为(12),使用ReLU的激活函数的卷积层为(),Sigmoid激活函数卷积层为()。本文保留原始CNN模型中的Sigmoid激活函数卷积层()的原因是以保证CNN模型结构设计的一致性,便于与CNN-SR-M模型中其他功能单元建立联系,防止各功能单元之间完全独立,影响各单元之间的兼容性连接。图像色度特征提取单元的主要运算规则为:

1.2.2 超分辨率失真控制单元

在超分辨率失真控制单元中,引用密集连接卷积神经网络模型(Densely Connected Convolutional Networks,DenseNet)的结构框架,与图像色度特征提取单元匹配,该单元也是由卷积层组成,使用Leaky ReLU激活函数和Sigmoid激活函数设计2类卷积层。定义其卷积层为();使用Sigmoid激活函数的卷积层与图像色度特征提取单元中的定义完全相同。超分辨率失真控制单元内部密集连接卷积层组成结构及处理流程如图2所示。

图2 超分辨率失真控制单元的内部组成结构和处理流程

1.2.3 上采样单元

上采样单元的核心目标为将压缩编码后的12图像映射为失真补偿后的重构图像,包括制定12向色彩空间转换的上采样策略、向12色彩空间转换的下采样策略、设计上采样残差插值函数等过程,关键是将残差插值函数应用于上采样中。在上采样中,需要对生成的、、3个分量色度特征进行超分辨率处理,针对空间坐标维度的扩大,不仅要提高3个分量色度特征图的维度(横纵2个方向的尺寸),还要对增加的空间坐标维度的像素点进行特征值插值,特征插值就是通过残差插值函数完成的。上采样单元通过设计一个卷积层()用于上、下采样的信息交换,主要是获取上采样和下采样的权重分配控制参数,特别是上采样对色度特征的增强控制;设计一个转置卷积层(),主要用于上采样过程对各个色度分量特征的维度进行扩大,对下采样过程各个色度分量特征的维度进行缩小。除引入一个Sigmoid卷积层()与整个CNN-SR-M模型其他功能单元建立联系外,()和()卷积层使用Parametric Rectified Linear Unit(PReLU)作为激活函数。使用PReLU激活函数的原因主要是充分应用了其更强的自适应性,实现对处理权值的灵活控制。依据以上对上采样单元主要功能的论述,在设计的上采样单元中应包含上采样子单元、下采样子单元、残差插值函数和Sigmoid卷积层,其总体结构如图3a所示,上采样子单元和下采样子单元的内部结构如图3b和图3c所示。

本文上采样色度特征图维度扩展选择了转置卷积(Transposed Convolution)实现拼接,转置卷积根据对卷积运算核的维度控制,实现色度特征的维度进行扩展,其扩展只涉及特征图的维度,与特征图的值无关;同时,可以非常方便地在基于CNN的模型中进行部署。上采样色度特征值的插值运算选择了深度反投影网络(Deep Back-Projection Networks,DBPN)方法。DBPN插值方法同时针对上采样和下采样2个过程进行迭代运算,依据前一次迭代运算产生的采样误差,对下一次迭代运算进行修正,在CNN等机器学习模型中实现对误差的最小化控制。图3所示的上采样单元设计,应用转置卷积拼接进行超分辨率色度特征图空间扩展,应用DBPN插值运算进行超分辨率色度特征插值运算。

图3 上采样单元的总体组成结构和处理流程

依据图3所示的上采样单元处理流程,针对上采样和下采样子单元,在定义()和()卷积层的基础上,还需要定义一个下采样子单元卷积层(),在此,()转置卷积层本质上就是上采样子单元卷积层。针对上采样单元的总体结构模型,定义整个上采样单元卷积层为(),其卷积核使用PReLU作为激活函数;定义上采样子单元为(),以转置卷积运算为核心;定义下采样子单元为(),激活函数同为PReLU。上采样单元的处理过程可以表示为:

1.2.4 色度特征融合单元

色度特征融合单元的主要功能是将经过上采样单元完成失真补偿后特征图映射为图像,也就是依据图像特征重构完整图像,其实现方法也较为简单。本文方法是在CNN模型中通过构建卷积层直接完成。

2 实验与讨论

2.1 实验方案

本文实验使用的计算机处理器为AMD Ryzen 5 5600G with Radeon Graphics 3.90 GHz,内存为16.0 GB,操作系统为Windows10,64位,使用的实验软件为Matlab2014a。实验选用LeNet-5模型作为卷积神经网络的预训练模型,使用Stanford Dogs Dataset犬类图像数据集、CompCars汽车类图像数据集、Flowers花卉类图像数据集、Home Objects客厅类图像数据集作为模型的测试数据集,以提高构建模型的泛化精度。LeNet-5模型的输入层—隐层—输出层的节点分配分别为10—6—1。其中,隐层中第1层的神经元设置为8个,后续层神经元设置为8递增;最小训练速度为0.9,尽量取最大值,但能够保持训练过程的权重分配变化和收敛变化适中;模型训练的迭代次数设置为100,迭代步长为1。预训练模型通过对以上3个图像数据集进行训练,完成模型的正则化,验证以上超参数设置的准确性,确保实验中重构图像的可靠性和准确性。

实验内容主要包括:在超分辨率失真控制单元中,对选择Leaky ReLU和ReLU激活函数构建卷积核的性能进行比较验证,对选择LeNet-5模型和DenseNet模型构建卷积网络模型的性能进行比较验证,对构建模型的处理权重的取值进行验证;在上采样单元中,对选择张量拼接和转置卷积2种上采样色度特征图维度扩展方法进行比较分析,对选择渐进式采样和深度反投影网络2种上采样色度特征插值方法进行比较分析;本文设计的CNN-SR-M模型与文献[3]、文献[8]、文献[11]、文献[17]和文献[18] 5种经典和较新的图像重构失真控制方法进行比较分析。实验结果评价指标详见以上实验中的相关论述。

2.2 结果与讨论

2.2.1 超分辨率失真控制性能评价

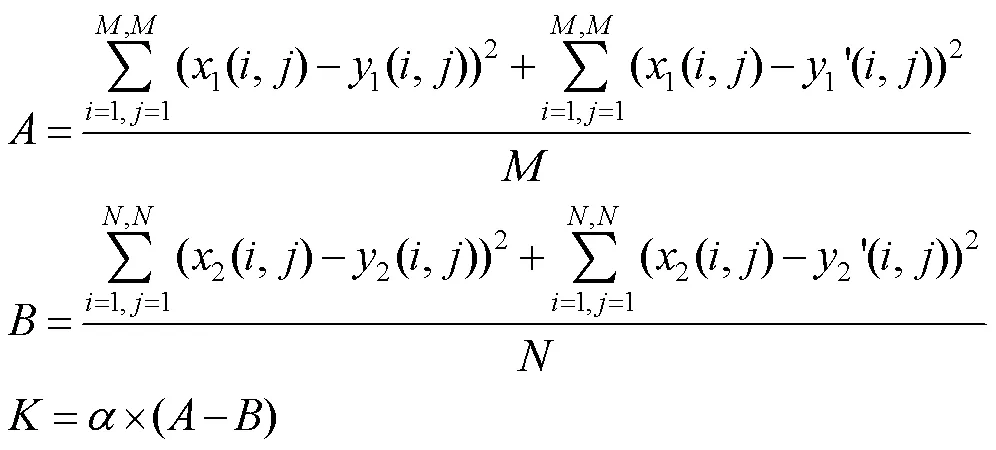

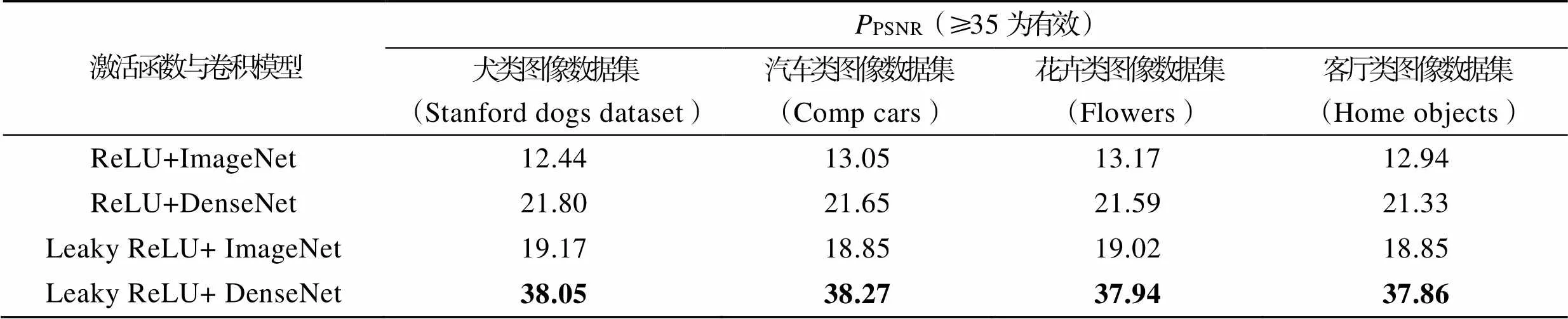

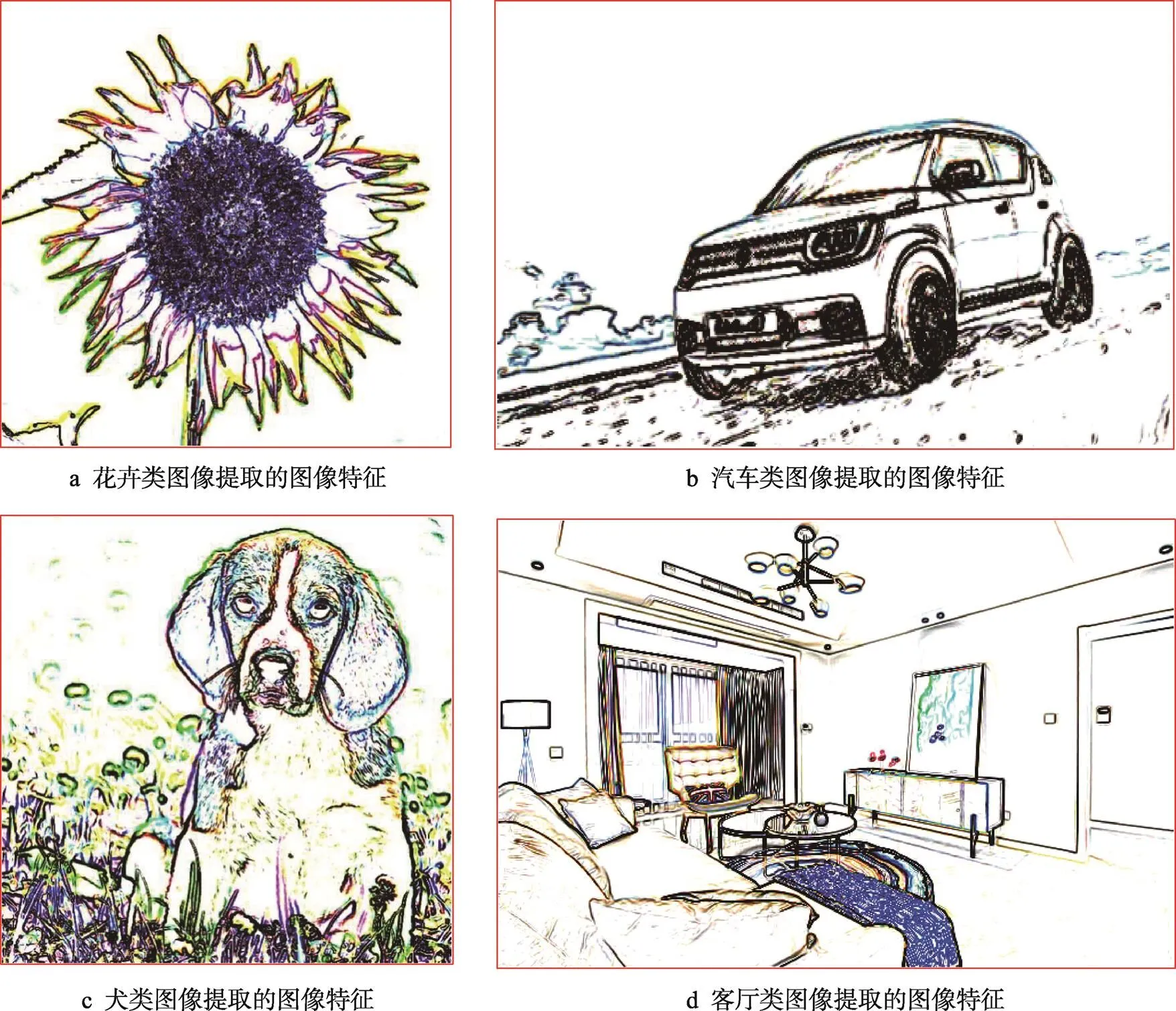

在表1~3统计的实验数据中,使用Leaky ReLU激活函数构建DenseNet模型时,对失真补偿的信息最多,通过使用高斯平滑滤波器对失真补偿后的色度特征图进行检测,补偿信息均为有效高频信息,不存在噪声。失真补偿后的色度特征图的PSNR也在35以上,由于针对的检测对象为图像特征信息,因此,设定的PSNR的有效值为≥35,如果是针对完整的图像,PSNR的有效值应为≥40。在DenseNet模型使用权值的检测中,当=0时,统计数据表明,处理过程不仅没有对失真进行补偿,还造成了色度特征的大量损失;当=0.2和=0.3时,失真补偿后的色度特征图的PSNR均在35以上,=0.2时效果最佳;当=0.2~0.8时,起到了色度特征补偿的作用,且补偿效果依次下降;当=0.9和=1.0时,也会造成色度特征的小幅损失。表1统计的实验数据直观地体现了本文设计的超分辨率失真控制单元,起到了色度特征补偿的作用,在多个不同类型的图像测试中,其失真补偿控制具有良好的可靠性和稳定性。

表1 使用不同激活函数和卷积网络模型的色度特征补偿统计数据

Tab.1 Statistical data on chromaticity feature compensation using different activation functions and convolutional network models

表2 使用不同激活函数和卷积网络模型的失真控制质量评价数据

Tab.2 Quality evaluation data for distortion control using different activation functions and convolutional network models

表3 使用不同卷积权重对色度特征失真补偿控制的质量评价数据

Tab.3 Quality evaluation data on chromaticity feature distortion compensation control using different convolutional weights

图4 使用Leaky ReLU激活函数构建DenseNet模型采集的图像色度边缘特征图

2.2.2 上采样色度特征维度扩展与色度特征插值性能评价

表4 使用不同上采样维度扩展和色度特征插值组合的重构图像与原图像平均误差检测结果

Tab.4 Average error detection results of reconstructed images and original images using different upsampling dimension extensions and chromaticity feature interpolation combinations

表5 使用不同上采样维度扩展和色度特征插值组合的原图像与重构图像SSIM值有效性检测结果

Tab.5 Effectiveness detection results of SSIM values for original and reconstructed images using different upsampling dimension extensions and chromaticity feature interpolation combinations

注:如果满足0≤((,))≤1、0≤(y(,))≤1即为yes,否则为no。

表6 使用不同上采样维度扩展和色度特征插值组合的原图像与重构图像SSIM值对称性检测结果

Tab.6 Detection results of SSIM value symmetry between original and reconstructed images using different upsampling dimension extensions and chromaticity feature interpolation combinations

注:如果满足(y(,),(,))=((,),y(,))即为yes,否则为no。

表7 使用不同上采样维度扩展和色度特征插值组合的重构图像SSIM值检测结果

Tab.7 Reconstructed image SSIM value detection results using different upsampling dimension extensions and chromaticity feature interpolation combinations

2.2.3 图像重构失真控制性能评价

表8 6种图像重构失真控制方法的输入图像和重构图像之间标准差测试统计结果

Tab.8 Statistical results of standard deviation test between input image and reconstructed image for six image reconstruction distortion control methods

表9 6种图像重构失真控制方法的输入图像和重构图像之间平均梯度比测试统计结果

Tab.9 Statistical results of average gradient ratio test between input image and reconstructed image for six image reconstruction distortion control methods

表10 6种图像重构失真控制方法的复合峰值信噪比测试统计结果

Tab.10 Statistical results of composite peak signal-to-noise ratio test for six image reconstruction distortion control methods

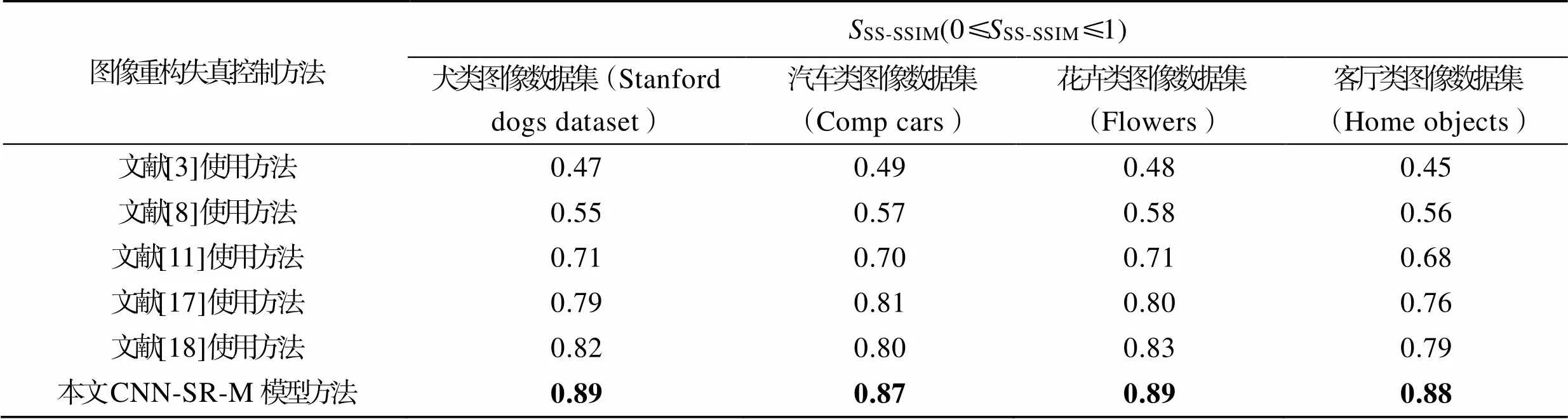

表11 6种图像重构失真控制方法的视觉敏感度检测结构相似度测试统计结果

Tab.11 Statistical results of visual sensitivity detection structure similarity test for six image reconstruction distortion control methods

表12 6种图像重构失真控制方法完成图像重构处理时间的测试统计结果

Tab.12 Statistical results of image reconstruction processing time for six image reconstruction distortion control methods

基于视觉敏感度检测的结构相似度值的计算方法为:

表8~12统计的数据非常直观地表明,本文设计的CNN-SR-M模型在图像重构的性能、失真控制和处理效率方面都具有一定的优势。

3 结语

本文通过对残差插值、残差插值与深度学习融合、残差插值与超分辨率处理融合的压缩编码图像重构原理进行分析,充分复用卷积层在图像色度特征提取方面的优势,结合超分辨率处理在图像色度残差插值失真控制方面的优势,设计了CNN-SR-M针对图像压缩编码的重构模型。相关研究工作得出以下结论:

1)图像色彩空间转换中的上采样过程非常重要。

2)压缩编码色度特征残差损失计算处理与色度特征超分辨率强化处理之间需要进行关联,压缩编码色度特征与失真强化色度特征也需要实现相关。

3)图像重构失真控制需要引入去池化处理机制,并对全连接层进行改进。

4)完整的CNN-SR-M模型需要保证各功能单元中的激活函数应具有兼容性、处理权重可统一进行分配。

5)图像重构上采样特征图维度扩展应采用转置卷积,色度特征值的插值效果可依据峰值信噪比作为评判指标,残差插值函数设计中应包含失真控制残差插值和模型的处理权值。

通过对CNN-SR-M模型中3个主要组成单元的性能进行实验检测,客观评价指标和主观视觉感受的统计结果表明,本文制定的基于卷积神经网络的超分辨率失真控制图像重构策略,在实际应用中具有良好可靠性、稳定性和高效性。

后续研究工作的主要方向:提高图像色度特征提取的精准性;通过下采样实现图像色度及色度特征的精细划分;强化超分辨率处理与色度失真插值运算之间的关系。

[1] HUA L, XIE L, CHEN H. A Color Interpolation Algorithm for Bayer Pattern Digital Cameras Based on Green Components and Color Difference Space[C]// In Proceedings of the 2010 IEEE Interna-tional Conference on Progress in Informatics and Computing. New York: IEEE, 2010: 791-795.

[2] KIKU D, MONNO Y, TANAKA M, et al. Beyond Color Difference: Residual Interpolation for Color Image Demosaicking[J]. IEEE Transactions on Image Processing, 2016, 25(3): 1288-1300.

[3] MONNO Y, KIKU D, TANAKA M, et al. Adaptive Residual Interpolation for Color and Multispectral Image Demosaicking[J]. Sensors, 2017, 17(12): 2787.

[4] 夏皓, 吕宏峰, 罗军, 等. 图像超分辨率深度学习研究及应用进展[J]. 计算机工程与应用, 2021, 57(24): 51-60.

XIA H, LYU H F, LUO J, et al. Survey on Deep Learning Based Image Super-Resolution[J]. Computer Engineering and Applications, 2021, 57(24): 51-60.

[5] 王海琳, 韩正昊, 李力, 等. 基于残差和高频替换的SONY-RGBW阵列彩色重构方法[J]. 激光与光电子学进展, 2021, 58(20): 66-78.

WANG H L, HAN Z H, LI L, et al. Residual and High-Frequency Replacement Based Color Reconstruction Method for SONY-RGBW Array[J]. Laser & Optoelectronics Progress, 2021, 58(20): 66-78.

[6] TAN R, ZHANG K, ZUO W, et al. Color Image Demosaicking Via Deep Residual Learning[C]// In Proceedings of the 2018 International Conference on Multimedia and Expo. New York: IEEE, 2018: 6-18.

[7] CUI K, JIN Z, STEINBACH E. Color Image Demosaicking Using a 3-stage Convolutional Neural Network Structure[C]// In Proceedings of the 2018 IEEE International Conference on Image Processing. New York: IEEE, 2018: 2177-2181.

[8] WANG Y, YIN S, ZHU S, et al. NTSDCN: New Three Stage Deep Convolutional Image Demosaicking Network[J]. IEEE Transactions on Circuits and Systems for Video Technology(Early Access), 2020, 31(9): 3725-3729.

[9] SHI W, CABALLERO J, HUSZÁR F, et al. Real-Time Single Image and Video Super-Resolution Using an Efficient Sub-Pixel Convolutional Neural Network[C]// In Proceedings of the 2016 IEEE International Conference on Computer Vision and Pattern Recognition. New York: IEEE, 2016: 1874-1883.

[10] 汤漫, 杨斌. 基于快速残差插值和卷积神经网络的去马赛克算法[J]. 南华大学学报(自然科学版), 2019, 33(6): 68-76.

TANG M, YANG B. Efficient Demosaicking Algorithm Based on Residual Interpolation and Convolution Neural Network[J]. Journal of University of South China (Science and Technology), 2019, 33(6): 68-76.

[11] LIU L, JIA X, LIU J, et al. Joint Demosaicing and Denoising with Self Guidance[C]// In Proceedings of the 2020 IEEE International Conference on Computer Vision and Pattern Recognition. New York: IEEE, 2020: 2240-2249.

[12] 马昊宇, 徐之海, 冯华君, 等. 基于小递归卷积神经网络的图像超分辨算法[J]. 光子学报, 2018, 47(4): 0410004.

MA H Y, XU Z H, FENG H J, et al. Image Super-Resolution Based on Tiny Recurrent Convolutional Neural Network[J]. Acta Photonica Sinica, 2018, 47(4): 185-193.

[13] FENG L, ZHANG X. A Dual-Network Based Super-Resolution for Compressed High Definition Video[C]// In Proceedings of the 2018 Advances in Multimedia Information Processing. New York: IEEE, 2018: 600-610.

[14] CHEN H G, HE X H, REN C, et al. CISRDCNN: Super-Resolution of Compressed Images Using Deep Convolutional Neural Networks[J]. Neurocomputing, 2018, 285(4):204-219.

[15] 王济民, 魏怡, 周宇, 等. 基于LeNet-5卷积神经网络和颜色特征的限速标志识别[J]. 计算机科学, 2021, 48(S02): 345-350.

WANG J M, WEI Y, ZHOU Y, et al. Speed Limit Sign Recognition Based on LeNet-5 CNN and Color Feature[J]. Computer Science, 2021, 48(S2): 345-350.

[16] CHAITY B, TATHAGATA M, EDUARDO P J. Feature Representations Using the Reflected Rectified Linear Unit(RReLU) Activation[J]. Big Data Mining and Analytics, 2020, 3(2): 102-120.

[17] 潘泽民, 覃亚丽, 郑欢, 等. 基于深度神经网络的块压缩感知图像重构[J]. 计算机科学, 2022, 49(S2): 510-518.

PAN Z M, QIN Y L, ZHENG H, et al. Block-Based Compressed Sensing of Image Reconstruction Based on Deep Neural Netork[J]. Computer Science, 2022, 49(S2): 510-518.

[18] 郑铠涛, 李海艳, 甘华权, 等. 基于低秩约束和全变分正则化的CUP-VISAR压缩图像重构算法[J]. 强激光与粒子束, 2023, 35(7): 74-82.

ZHENG K T, LI H Y, GAN H Q, et al. CUP-VISAR Image Reconstruction Based on Low-Rank Prior Andtotal-Variation Regularization[J]. High Power Laser and Particle Beams, 2023, 35(7): 74-82.

[19] 黄友文, 唐欣, 周斌. 结合双注意力和结构相似度量的图像超分辨率重建网络[J]. 液晶与显示, 2022, 37(3): 367-375.

HUANG Y W, TANG X, ZHOU B. Image Super-Resolution Reconstruction Network with Dual Attention and Structural Similarity Measure[J]. Chinese Journal of Liquid Crystals and Displays, 2022, 37(3): 367-375.

Image Reconstruction of Super-resolution Distortion Control Based on Convolutional Neural Network

SHU Zhong1,2, ZHENG Bo'er1

(1. School of Electronic Information Engineering, Jingchu University of Technology, Hubei Jingmen 448000, China; 2. Jingmen Rongmei Network Technology Co., Ltd., Hubei Jingmen 448000, China)

The work aims to solve problems of poor correlation between functional units, weak completeness of image chromaticity feature extraction, weak distortion control in super-resolution reconstruction, and residual control in sampling process in super-resolution image reconstruction models. By introducing the double activation function into the convolutional neural network model, the compatibility and connectivity between the functional units in the model were improved. A super-resolution distortion control unit was constructed using a dense connected convolutional neural network to perform convolutional compensation operations on four chromatic components, respectively. The residual interpolation function was applied to the upsampling unit and deep backprojection network rules were used to achieve super-resolution chromaticity feature interpolation operations. The designed model set combined multiple convolutional kernels internally to achieve super-resolution chromaticity distortion compensation. A unified processing weight was used to ensure the organic fusion of the internal components of the entire model. In conclusion, the relevant experimental results verify that the image reconstruction model proposed in this paper has good reliability, stability, and efficiency.

convolutional neural networks; super resolution; activation function; transposed convolution; deep back-projection networks (DBPN); image reconstruction

TP391.41;TP183;TS80

A

1001-3563(2024)07-0222-12

10.19554/j.cnki.1001-3563.2024.07.028

2023-04-15

湖北省荆门市科学技术研究与开发计划重点项目(2023YFZD056)