M-SWF域红外与可见光图像结构相似性融合

2024-04-11田时舜刘广丽邹文斌

李 威,田时舜,刘广丽,邹文斌

M-SWF域红外与可见光图像结构相似性融合

李 威,田时舜,刘广丽,邹文斌

(深圳大学 电子与信息工程学院,广东 深圳 518060)

为了解决常规滤波器组在红外与可见光图像融合领域中存在提取结构信息不充分和融合视觉效果不佳的问题,本文提出了一种基于多尺度滑动窗口滤波器(Multi-scale Sliding Window Filter,M-SWF)图像融合方法。首先,提出一种基于SWF的多尺度图像分解方法实现对源图像的结构细节层和基础层提取;其次,采用L1范数融合规则(L1-Fusion, L1F)整合结构细节层,提取图像的结构信息;然后,利用一种图像能量贡献融合规则(Energy Attribute-Fusion, EAF)整合基础层,突出显著性目标;最后,融合图像通过叠加整合后的多尺度结构细节层和基础层得到。实验首先通过分析能量贡献系数,从主客观方面得到M-SWF域内红外与可见光图像融合较为适宜的能量贡献系数;其次,在该取值下,本文提出的M-SWF融合模型与其他的融合方法相比,不仅提高了对源图像结构信息的提取能力,而且通过整合图像的能量属性,改善了融合效果不佳问题,有效地突出了显著性目标。

红外图像;可见光图像;图像融合;滑动窗口滤波器;结构相似性

0 引言

红外成像传感器根据热辐射机理实现对目标物体的捕获,然而缺乏对场景的细节呈现;相反,可见光成像传感器通过光学反射机制能够细腻地显示同一场景下的目标纹理和细节信息。多源图像融合领域内的红外与可见光图像融合能够生成单幅具有鲁棒性的图像,提供给后台决策者更全面的场景信息,方便决策者做出最佳的决定,因此被应用于目标跟踪、遥感遥测和物联网系统等领域[1-9]。

近年来,为了满足不同图像平滑和锐化的需求,具有边缘保持特性的滤波器组被应用于图像融合领域,如:高斯滤波器和导向滤波器。2013年,Li等人基于导向滤波器提出了一种快速有效的图像融合模型(Guided Filtering Fusion,GFF[10]),该方法利用导向滤波的加权技术保障了源图像与融合结果之间的空间一致性,但细节信息存在局部丢失;为了保留更多的边缘信息,2015年,Kumar等人提出了一种基于交叉双边滤波器的融合方法(Cross Bilateral Filtering,CBF[11]),CBF考虑了相邻像素之间的相似性,有效地提高了细节信息的提取;虽然基于CBF的融合方法对图像边缘纹理提取有较好的表现,但是融合过程将图像噪音和图像信息混淆,导致融合结果不佳;而为了避免噪音的生成,Kun等人在2017年基于结构滤波器提出了一种快速滤波图像融合方法(Fast Filtering Image Fusion,FFIF[12]),FFIF通过图像的均值和方差有效地避免了噪音的生成,但无法突出目标信息。

随着机器学习研究的深入,神经网络逐渐成为图像融合方向较为热门的研究工具。2019年,Wu等人提出了一种残差网络(Residual Network, Resnet[13])新颖融合框架。该方法首先将Resnet用于从源图像中提取深度特征;其次利用ZCA和l1-norm对深度特征进行归一化并获得初始权重图;最后通过加权平均融合策略重构融合图像;该方法能够较好地提高图像视觉效果,但是由于算法过于复杂,融合结果存在一定的人为影响。为了实现深度次的特征提取,Tan等人在2021年基于加权平均曲率滤波器和脉冲耦合神经网络(Pulse Coupled Neural Network,PCNN)提出了一种多模态融合方法(Multi-Level Edge Preserving Filtering,MLEPF)[14],该方法虽然通过加权平均曲率滤波器实现了源图像多级特征信息提取,但受限于源图像曝光度,容易使得融合结果存在斑块。

基于上述的分析可知,当前红外与可见光图像融合的研究目的主要有两方面:①加大提取源图像的特征信息量,使得融合图像与源图像之间具有较为完整的相似契合度;②在实现源图像结构相似度融合的同时,一方面减少或抑制噪斑及人造伪影的产生,另一方面显著性地突出目标物体,以便能够满足人体的视觉感知系统。为了达成上述目的,本文基于多尺度滑动窗口滤波器(Multi-scale Sliding Window Filter,M-SWF)提出了一种红外与可见光图像结构相似性融合方法,该方法利用滑动窗口滤波器(Sliding Window Filter,SWF[15])对源图像实现多尺度水平分解,得到源图像的多层级结构细节层和基础层;该方法简练,避免了因算法复杂性带来的人为干扰,同时为了保留结构细节信息,L1范数融合规则(L1-Fusion,L1F)被应用于整合结构信息;另外,一种基于图像能量贡献融合规则(Energy Attribute-Fusion,EAF)被用于突出目标,以提高视觉效果。

1 M-SWF域红外与可见光图像融合

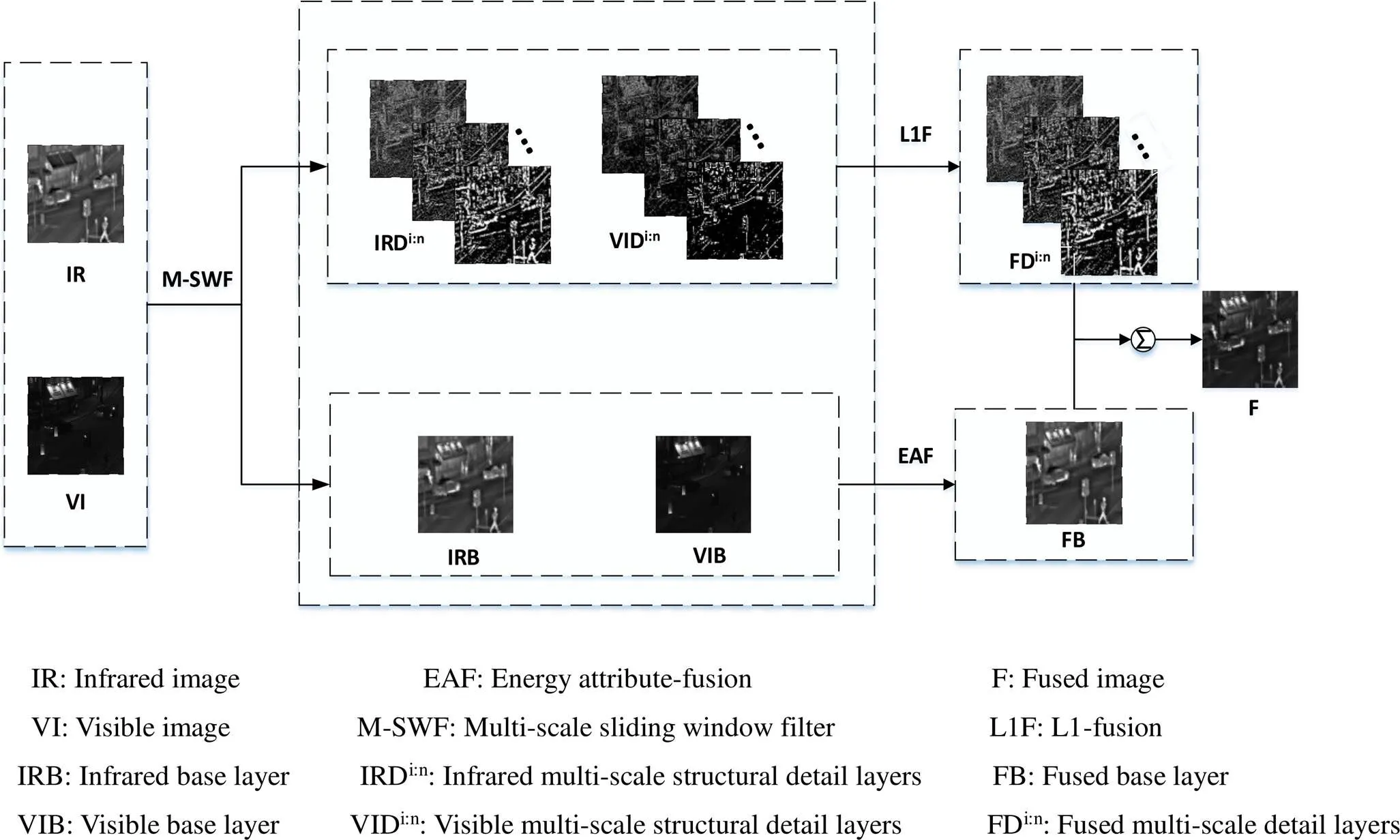

图1为本文在M-SWF域内提出的红外与可见光图像融合框架。M-SWF融合模型主要分为四步:

1)M-SWF域内源图像分解

利用M-SWF实现源图像的多尺度分解,得到对应的多尺度结构细节层和基础层。

2)多尺度结构细节层融合

利用L1-fusion融合规则实现多尺度结构信息融合,以保留较完整的细节信息。

3)基础层融合

利用EAF融合规则实现基础层融合,以显著地突出目标。

4)源图像重构

采用叠加求和的融合方法实现源图像的重构,得到融合图像。

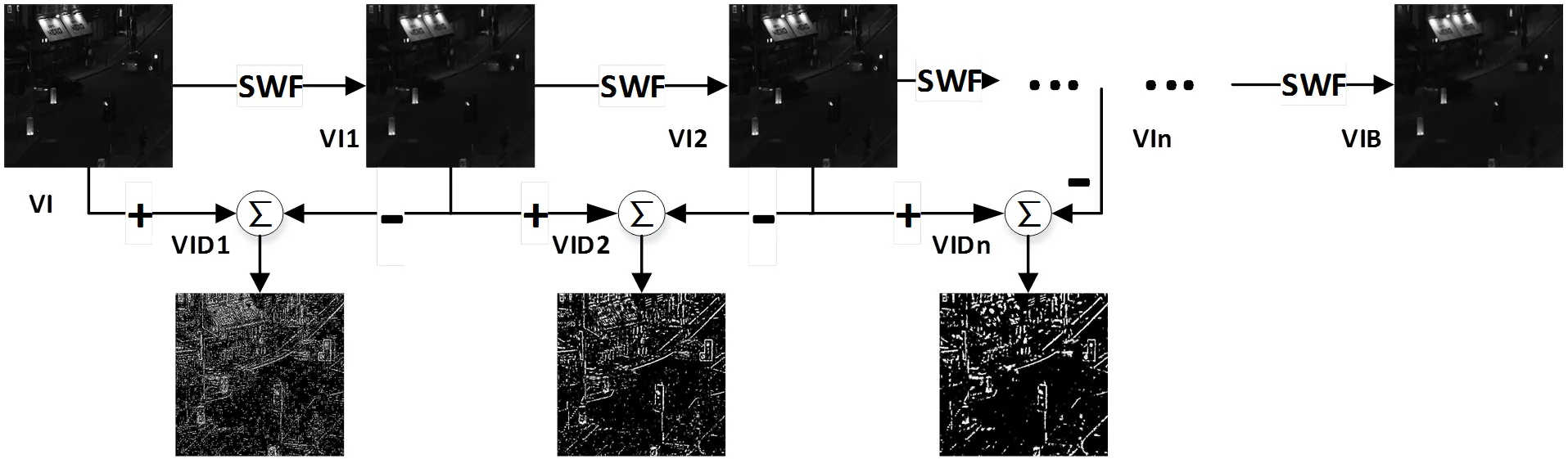

1.1 M-SWF域内源图像分解

SWF是一种强边缘结构保持滤波器,SWF利用不同尺寸窗口()在单个像素中心实现8邻域图像结构信息的保留。图2为可见光图像“Road”在不同尺寸窗口下的处理结果,从图2可以看出,值越小对图像的边缘信息保留越多,图像更加清晰立体。基于SWF对图像边缘结构信息的敏感性,一种用于图像多尺度水平分解方法M-SWF被提出并且用于对源图像多尺度成分的提取。图3为可见光图像“Road”的分解实例,其中VI为“Road”图像,SWF为SWF图像处理过程,VI1,VI2和VI分别是经过SWF处理后的图像;VID1,VID2和VID分别是分解后利用对数放大后的多尺度结构细节;VIB为基础层。通过M-SWF多尺度分解得到源图像的多尺度结构细节层和基础层,详细的M-SWF多尺度水平分解过程用公式表示如下:

VID1=VI-VI1(1)

VID=(VID-1)-VID(2)

VIB=SWF(VID-1) (3)

图1 M-SWF图像融合框架

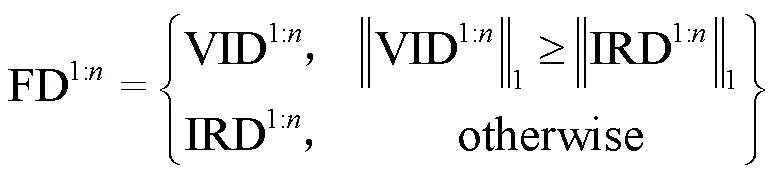

1.2 多尺度结构细节层融合

从图3 M-SWF的分解框架可以看出随着分解层数的变大,VI图像变得更加清晰和立体,图像当中的保留的能量信息和边缘信息越来越明显。在自然图像处理过程,如果图像当中某点的像素较大,反映在图像上是人体视觉感知最为明显的一个区域或者一个位置,这也是图像当中较为重要的一个信息点。而L1范数融合规则[16]主要是把图像中每个像素的绝对值作为图像活动水平测量值来评估该点的重要性。因此为了最大程度地保留细节信息,通过L1范数对图像处理取最大值,以保证融合结果存在较为明显和重要的图像信息点;融合后的多尺度结构细节层FD1:n通过公式(4)得到:

图3 M-SWF图像分解

1.3 基础层融合

在M-SWF图像分解过程中,基础层图像是不断地经过SWF进行保边处理,层层筛选出多尺度结构细节信息的同时得到一个包含源图像最粗糙的近似图像,其中以能量强度信息较为明显。为了实现融合结果不模糊,并且融合目标突出以达到契合人体视觉系统的效果,一种基于图像能量贡献的融合规则被引入整合基础层图像,从而得到融合后的基础层图像FB。EAF的融合过程如下:

1)分别利用均值滤波器和中值滤波器得到基础层图像的均值和中值图像属性,进而构造基础层图像的能量属性值;

A=1I+2I(5)

式中:(∈IRB,VIB)为待处理的源图像基础层;1和2分别为均值滤波处理和中值滤波处理;A表示为基础层的能量属性值。

2)利用能量属性值构建能量贡献函数,从而提取基础层的能量强度信息;

I=exp(|-A|) (6)

式中:exp为指数函数;为能量属性参数量。

3)重构融合后的基础层;

式中:IRB和VIB分别为IRB和VIB的能量强度信息。

1.4 源图像重构

融合图像通过公式(8)叠加求和得到:

2 实验分析

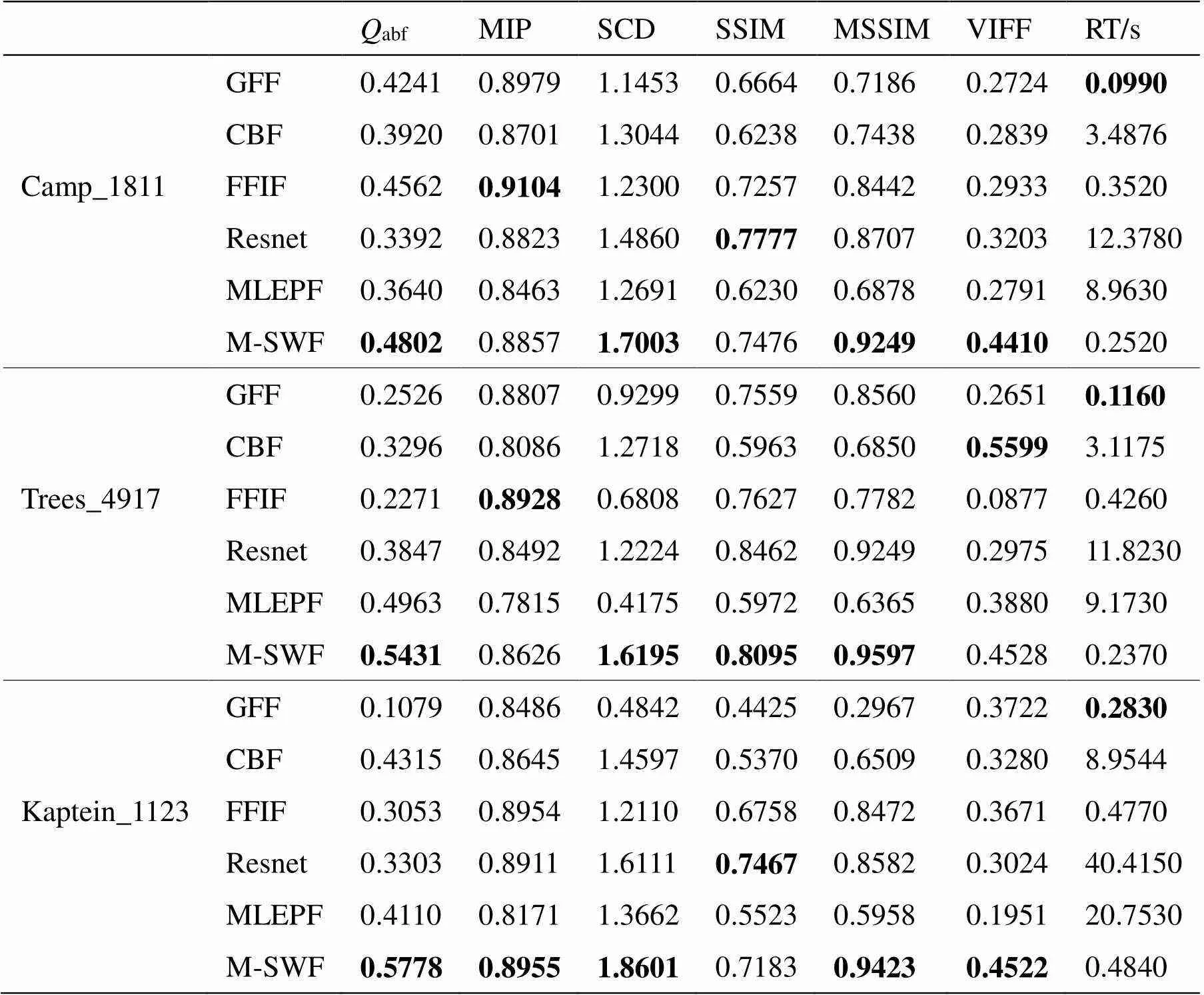

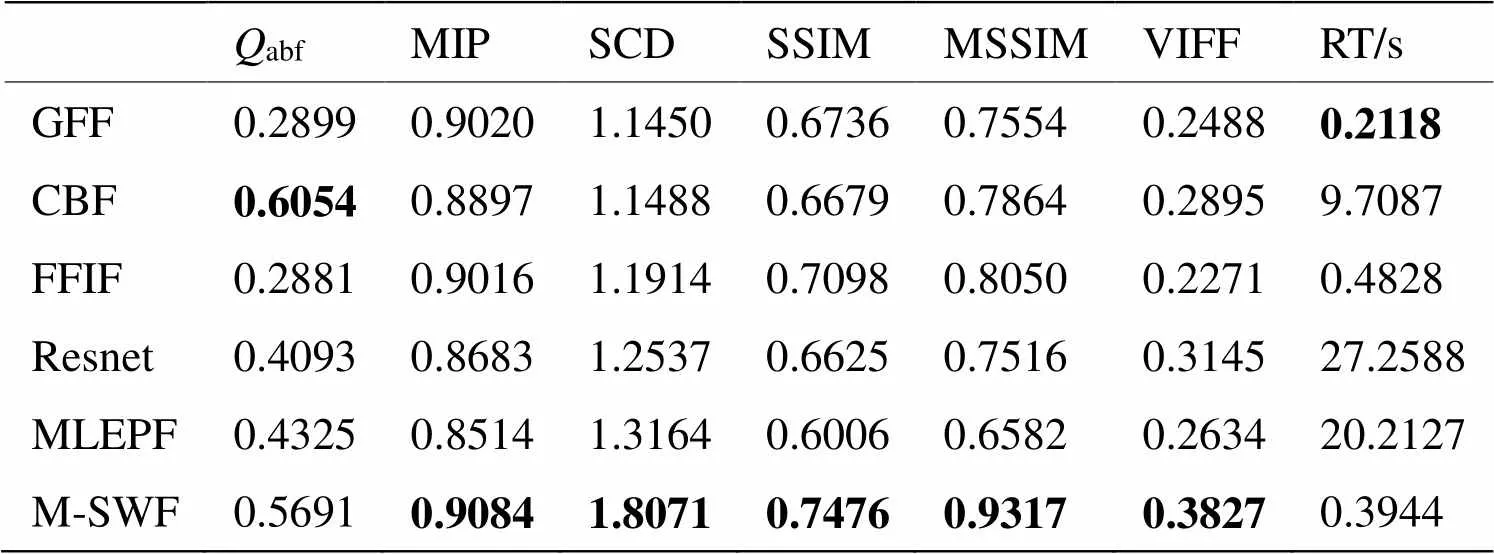

实验的数据图像集全都来自于文献[17]中的TNO[18]数据集(包含21组数据组),本节选取了3对图像组进行主客观分析。实验仿真软件为MATLAB R2018b,电脑是搭载3.6GHz AMD Ryzen 5 2600X六核处理器的Win10系统。5种图像融合算法被用于对比评价M-SWF,分别为GFF、CBF、FFIF、Resnet和MLEPF;其中GFF、CBF、FFIF和MLEPF都是以常规滤波器进行融合,另外GFF、CBF和MLEPF也为多尺度图像融合,FFIF为以结构信息为重心的融合方法,而Resnet和MLEPF都是最近与神经网络相结合的融合算法。为了综合评价M-SWF,首先对M-SWF融合过程中能量属性变量进行分析,得到M-SWF融合模型下的较佳值;其次,在该取值下,对融合结果进行主客观两个方面进行分析,其中客观定量分析方面,选取了6种融合评价指标进行定量分析,分别为基于梯度信息指标(Gradient-based Fusion Performance,abf[19])、基于像素的互信息量(Mutual information based on Pixel, MIP[13])、差异相关性的总和(Sum of the Correlations of Differences, SCD[20])、基于结构相似性的度量(Structural Similarity, SSIM[1])、多层次结构相似性度量(Multilevel structural similarity, MSSIM[1])和视觉保真度(Visual Information Fildelity for Fusion, VIFF[1]),以上评价指标数值越大融合效果越好;此外,通过计算融合方法的运行时间(RT)来分析算法的时效性,越小越好。

2.1 能量属性变量分析

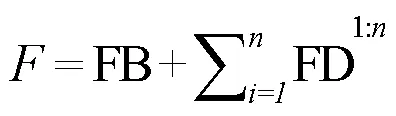

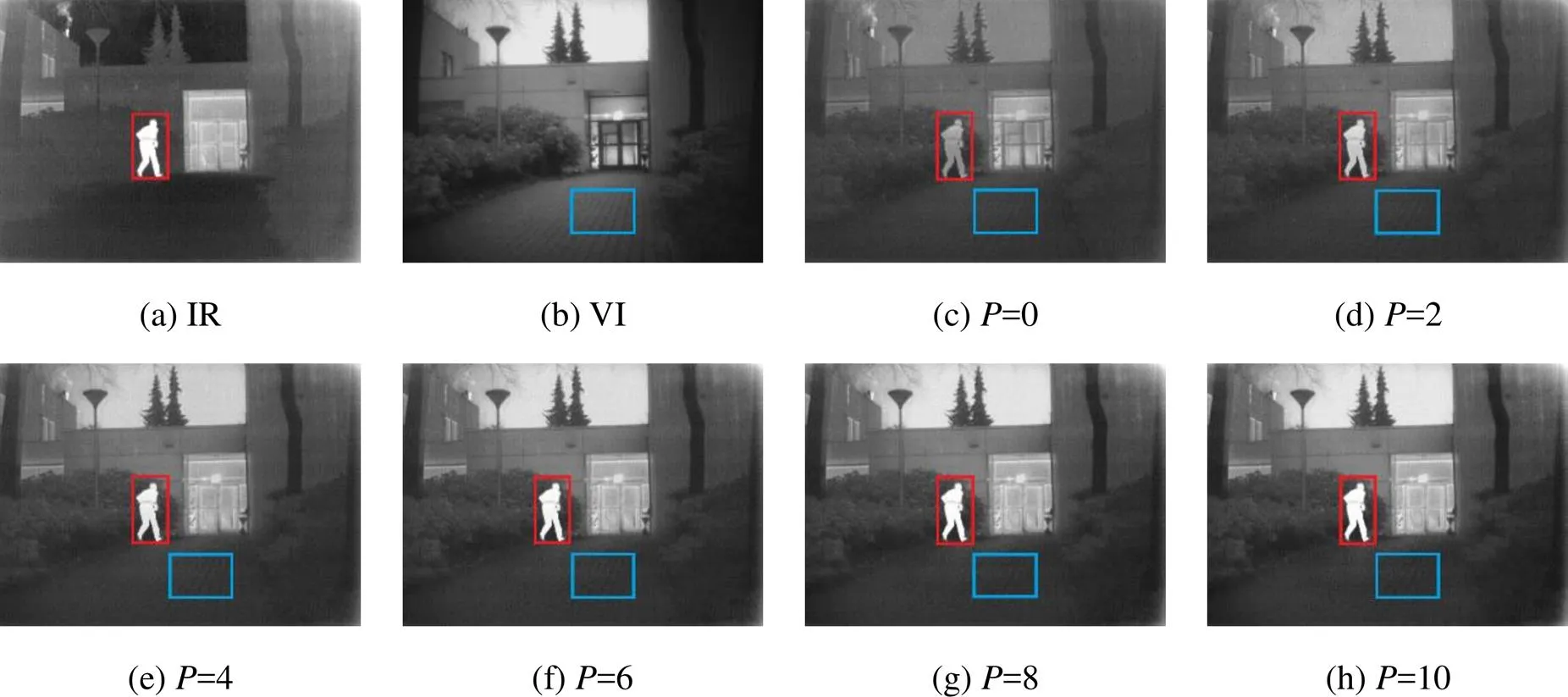

能量属性变量用于整合源图像的基础层信息,以实现突出目标的目的。实验仿真过程通过调节变量,得到融合结果图4;其中红色方框标记的是人,蓝色标记的是路面。由图4能够较为清楚地发现,随着值增大行人越加突出,能量强度越大;但是,路面的纹理越来越不清楚,丢失了VI图像当中的纹理成分。因此为了获得M-SWF最佳的融合效果,对图4当中的融合结果进行了定量分析,得到的客观数据如表1所示,其中粗体字标记的为最佳数据。从表1能够观察到图4(d)(=2)的数据值在abf、SSIM较好,但是随着值增大,abf和SSIM评价指标减小,这主要源于引入的红外光谱信息过多,掩盖了可见光细节层信息,导致融合图像纹理细节不清晰;而另一方面SCD和VIFF定量值却不断增大,这表明融合结果保留了大量的红外显著性能量信息,能够突出主要目标;其次RT运行时间保持在0.510s左右不会对整体算法的时效性形成太大的影响;而由于融合指标MIP和MSSIM的最优值分别位于=6和=8,因此为了使得M-SWF的融合结果一方面能够减少或抑制噪斑及人造伪影的产生,另一方面能够突出显著性目标,从整体综合的角度考虑,将能量属性参数值取为各个评价参数较为适中的数值,不会使得某个参数过低或过高影响融合效果,因此令=4进行后续的主客观分析。

图4 不同参数P的M-SWF融合结果

表1 不同P值下的融合定量数据

2.2 主观分析

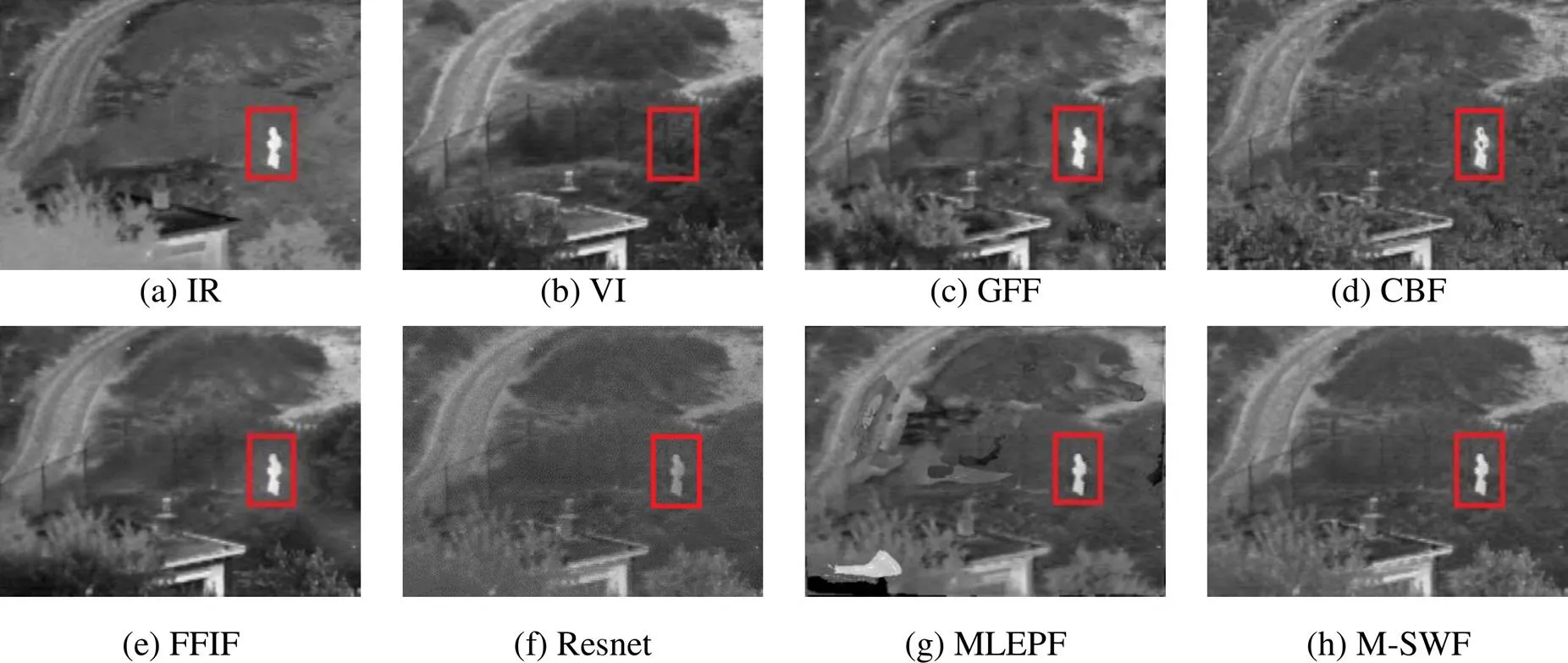

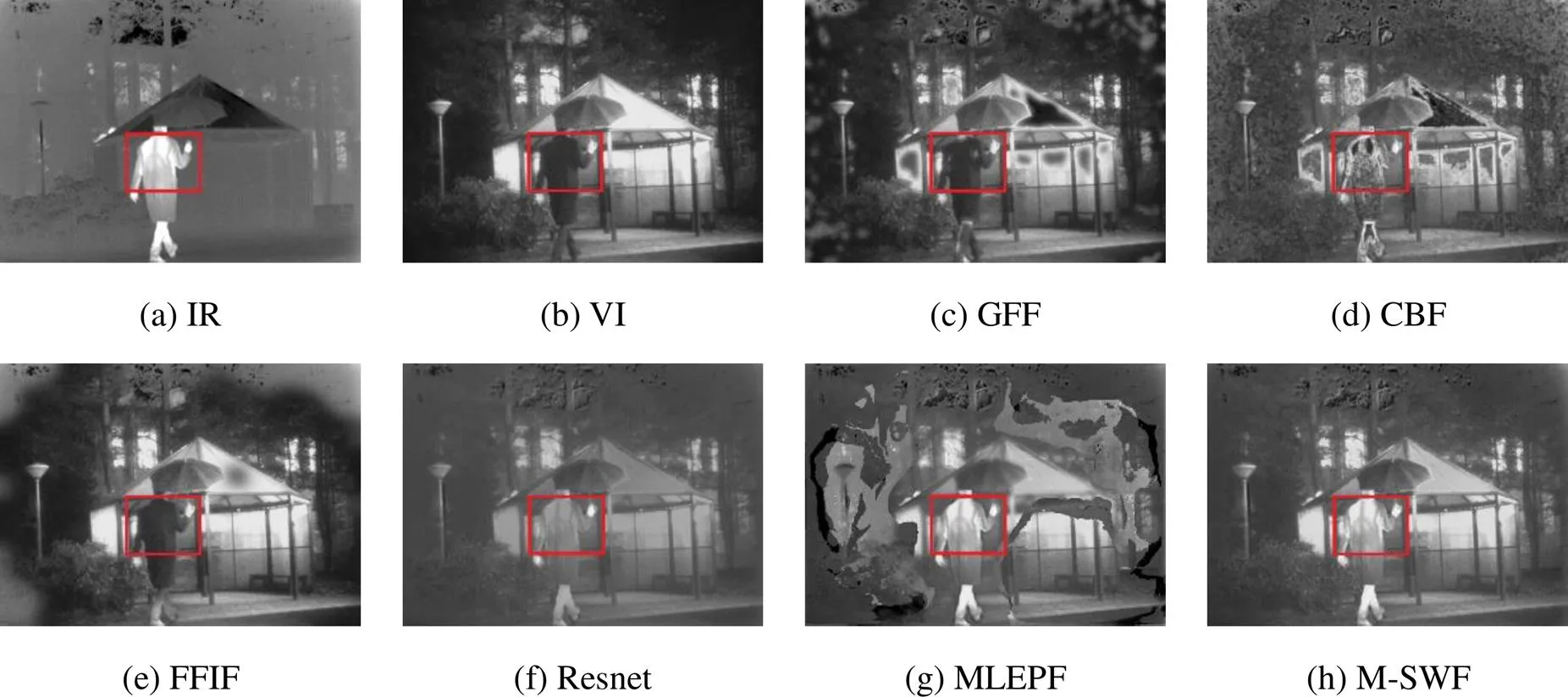

实验首先选取了3对图像数据组进行主观分析,分别为“Camp_1811”、“Trees_4917”和“Kaptein_1123”,融合结果如图5~图7所示。

图5源图像数据组呈现的是一个从高往低处看的屋顶视角,选取分析的是红色方框标记的人;与GFF、Resnet和MLEPF的融合结果相对比,M-SWF得到的融合结果当中“人”更加地突出,能量强度更为明显;CBF得到的融合结果中被标记的人存在一个黑色小斑点,另外FFIF的融合结果中人物目标附近存在光晕;而M-SWF表现良好。图6源图像数据组描述一幅树下行人的场景,选取分析的是树下的人;整体上看,GFF、CBF和MLEPF得到的融合结果存在噪音或者人造伪影现象,另外与FFIF和Resnet相比,M-SWF在融合“人”有不错的表现。图7源图像数据组是一幅行人路过凉亭的画面,选取分析的是行人的后背;从被标记的区域观察到,M-SWF具有良好的融合效果,并且无人造伪影等不佳现象。

2.3 客观分析

客观分析指的是从实际出发,对结果进行客观公正的定量评价。表2为图5~图7中各个融合结果的客观定量数据,其中粗体字标记的为最佳数据。从“Camp_1811”客观数据可以发现:M-SWF在abf、SCD、MSSIM和VIFF指标上表现最佳,这表明M-SWF能较好地规避人造伪影现象,并且融合效果较好;其次从“Trees_4917”定量数据观察到:M-SWF在abf、SCD、SSIM和MSSIM上排名第一,这说明M-SWF能够很好地整合源图像的结构信息,并且融合结果不含或存在较少的人为影响;而从“Kaptein_1123”的数据可以看出:除了SSIM和运行时间表现略差,其他的数据都是最佳,这表征M-SWF对Kaptein_1123融合有很好的融合效果;而在运行时间上,M-SWF的略高于GFF和FFIF,低于CBF常规滤波器组融合方法和Resnet、MLEPF神经网络的融合方法;针对个别评价指标略差的情况,这主要受到能量属性参数影响,从表1可以看出,值在MIP、SSIM和MSSIM指标上,具有小范围的峰值,因此合适值的选取,会对M-SWF有小尺度的影响。表3为TNO数据集21组数据图像的平均客观定量数据,从表3能够看出M-SWF在MIP、SCD、SSIM、MSSIM和VIFF评价指标上略优于其他对比的融合方法,而在运行时间上仅高于GFF,这表明提出的融合方法M-SWF能够较快地提取源图像的结构细节信息,在保证融合效果的同时,能够显著性地突出目标;在abf评价指标略低于CBF,这主要来源基础层EAF融合引入了过多的显著性能量,使得红外光谱信息过多而掩盖了可见光细节信息;而在运行时间上略低于GFF,这主要在于GFF仅通过简便的滤波图像处理和加权叠加融合,减少了融合过程中的计算参数量。整体而言,M-SWF在实现多源图像融合方面具有一定的优势,能够实现多源图像之间时效的结构相似性融合。

图5 不同方法在“Camp_1811”图像下的融合结果

图7 不同方法在“Kaptein_1123”图像下的融合结果

表2 客观评价数据

表3 TNO数据集上的平均客观评价数据

3 结论

针对图像融合过程中提取结构信息不充分和融合效果不佳的问题,本文基于SWF提出了一种多尺度水平图像融合方法M-SWF。利用SWF对图像边缘结构信息的敏感性,对源图像进行了多尺度水平特征信息提取,得到多尺度结构细节层和基础层;采用L1F融合规则实现了多尺度结构信息层的融合;采用EAF图像能量贡献融合规则实现了基础层融合;最后叠加求和重构源图像。实验首先分析了M-SWF下较为合适的能量属性参数取值;其次对融合图像进行主客观分析,结果表明M-SWF与常规的滤波器组融合相比具有一定的优势,能够保留结构细节信息的同时不产生人造伪影现象,并且融合结果能够突出目标,符合人体的视觉系统。

[1] MA Jiayi, MA Yong, LI Chang. Infrared and visible image fusion methods and applications: a survey [J]., 2019, 45: 153-178. DOI: 0.1016/j.inffus.2018.02.004。

[2] ZHAO Z, XU S, ZHANG C, et al. Bayesian fusion for infrared and visible images[J]., 2020, 177: 165-168. DOI: 10.1016/ j.sigpro.2020.107734

[3] HUAN Kewei, LI Xiangyang, CAO Yutong, et al. Infrared and visible image fusion of convolutional neural network and NSST[J]., 2022, 51(3): 20210139. DOI: 10.3788/IRLA20210139.

[4] CHENG Boyang, LI Ting, WANG Yulin. Fusion of infrared and visible light images based on visual saliency weighting and maximum gradient singular value[J]., 2022, 15(4): 675-688. DOI: 10.37188/CO.2022-0124

[5] 李威, 李忠民. 一种基于EASSF的红外与可见光图像视觉保真度融合[J]. 红外技术, 2022, 44(7): 686-692. LI Wei, LI Zhongmin. Visual fidelity fusion of infrared and visible image using edge-aware smoothing-sharpening filter[J]., 2022, 44(7): 686-692.

[6] 李永萍, 杨艳春, 党建武, 等. 基于变换域VGGNet19的红外与可见光图像融合[J]. 红外技术, 2022, 44(12): 1293-1300. LI Yongping, YANG Yanchun, DANG Jianwu, et al. Infrared and visible image fusion based on transform domain VGGNet19[J]., 2022, 44(12): 1293-1300.

[7] 雷大江, 杜加浩, 张莉萍, 等. 联合多流融合和多尺度学习的卷积神经网络遥感图像融合方法[J]. 电子与信息学报, 2022, 44(1): 237-244. Doi: 10.11999/JEIT200792. LEI Dajiang, DU Jiahao, ZHANG Liping, et al. Multi-stream architecture and multi-scale convolutional neural network for remote sensing image fusion [J]., 2022, 44(1): 237-244. Doi: 10.11999/JEIT200792.

[8] 马梁, 苟于涛, 雷涛, 等. 基于多尺度特征融合的遥感图像小目标检测[J]. 光电工程, 2022, 49(4): 49-65. MA Liang, GOU Yutao, LEI Tao, et al. Small object detection based on multi-scale feature fusion using remote sensing images[J], 2022, 49(4): 49-65.

[9] 钱金卓, 马骏, 李峰, 等. 面向CMOS遥感相机的多曝光图像融合方法[J]. 遥感信息, 2022, 37(4): 51-57. QIAN Jinzhuo, MA Jun, LI Feng, et al. Multi-exposure image fusion method for CMOS remote sensing camera [J]., 2022, 37(4): 51-57.

[10] LI Shutao, KANG Xudong, HU Jianwen. Image fusion with guided filtering[J]., 2013, 22(7): 2864-2875. Doi: 10.1109/TIP.2013.2244222.

[11] Shreyamsha Kumar B K. Image fusion based on pixel significance using cross bilateral filter[J]., 2015, 9(5): 1193-1204. Doi:10.1007/s11760-013-0556-9.

[12] ZHAN K, XIE Yuange, MIN Yufang. Fast filtering image fusion[J]., 2017, 26(6): 063004. Doi: 10.1117/1.JEI.26.6.063004.

[13] LI Hui, WU Xiaojun, Tariq S Durrani. Infrared and visible image fusion with ResNet and zero-phase component analysis[J]., 2019, 102: 1030390. Doi: 10.1016/j.infrared.2019.-103039.

[14] TAN Wei, Thitn W, XIANG P, et al. Multi-modal brain image fusion based on multi-level edge-preserving filtering[J]., 2021, 64: 102280. Doi: 10.1016/j. bspc.2020.102280.

[15] YIN Hui, GONG Yuanhao, QIU Guoping. Side window guided filtering[J]., 2019, 165: 315-330. Doi: 10.1016/j.sigpro. 2019.07.026.

[16] LI Xiaosong, ZHOU Fuqiang, TAN Haishu, et al. Multimodal medical image fusion based on joint bilateral filter and local gradient energy[J]., 2021, 569: 302-325.

[17] LI Hui, WU Xiaojun. DenseFuse: a fusion approach to infrared and visible images [J].2019, 28(5): 2614-2623. Doi: 10.1109/TIP.2018.2887342.

[18] Toet A. TNO Image Fusion Dataset[EB/OL]. [2022-10-30]. http://figshare.com/articles/-TNO_Image_ Fusion_Dataset/1008029.

[19] Xydeas C S, Petrovic V. Objective image fusion performance measure [J]., 2000, 36(4): 308-309. Doi: 10.1109/ICCV.2005.175.

[20] Aslantas V, Bendes E. A new image quality metric for image fusion: the sum of the correlations of differences[J]., 2015, 69(12): 1890-1896. Doi: 10.1016/j.aeue.2015.09.004.

Structural Similarity Fusion of Infrared and Visible Image in the M-SWF Domain

LI Wei,TIAN Shishun,LIU Guangli,ZOU Wenbin

(College of Electronics and Information Engineering, Shenzhen University, Shenzhen 518060, China)

This study introduces a multiscale sliding window filter (M-SWF) image fusion method to address issues with traditional filter banks in infrared and visible image fusion. First, a multiscale image decomposition method based on SWF is proposed to extract the structural detail layers and base layers of the source image. Second, the L1 norm fusion rule (L1-Fusion, L1F) is used to integrate the structural detail layers, which can extract the structure of the image. Then, to highlight the salient objects, energy attribute fusion (EAF), which is a rule for fusing image energy contributions, is used to integrate the base layers, and the fusion results are obtained by stacking the integrated multiscale structure detail layers and base layers. The energy contribution coefficient was analyzed, and a suitable energy contribution coefficient was obtained for the fusion of infrared and visible images in the M-SWF domain from subjective and objective perspectives. Compared with other fusion methods, the M-SWF not only improves the ability to extract the structural information of the source image but also improves the poor fusion effect and effectively highlights salient targets by integrating the energy attributes of the image.

infrared image, visible image, image fusion, side window filter, structural similarity

A

1001-8891(2024)03-0280-08

2022-11-14;

2023-03-08.

李威(1997-),男,博士研究生,主要从事图像处理的研究,E-mail:lv2881314@163.com。

邹文斌(1981-),男,博士,副教授,主要从事图像处理的研究,E-mail:wzou@szu.edu.cn。

国家自然科学基金项目(62171294,62101344),广东省自然科学基金(2022A1515010159),深圳自然科学基金(JCYJ20200109105832261, JCYJ20190808122409660),深圳市科技计划重点项目(20220810180617001)。