基于PPYOLOE的师生互助训练半监督目标检测网络

2024-03-29张国山魏金满

张国山,魏金满

基于PPYOLOE的师生互助训练半监督目标检测网络

张国山,魏金满

(天津大学电气自动化与信息工程学院,天津 300072)

随着深度学习技术的发展,基于卷积神经网络的目标检测技术成为当前计算机视觉领域的研究热点之一.目前主流的目标检测算法依赖于监督学习方式,需要在大量有标注图像数据上训练网络,然而,无标签的数据易于获取,而有标签的数据收集起来通常很困难,标注也耗时和耗力.为了解决数据标注难以获取的问题,提出了教师学生互助训练的半监督目标检测(PPYOLOE-SSOD)算法.首先,同时训练一个学生模型和逐渐改进的教师模型,使用教师模型筛选高质量伪标签,将伪标签作为未标注图像的回归目标,指导学生模型训练,挖掘未标注图像的知识信息,为了减小参数传递的不稳定性,每次迭代学生模型使用指数移动平均方法更新教师模型参数;此外,引入不同种类的半监督数据增强方法来增强网络的抗干扰能力;最后,针对无标注数据的学习,新增无监督学习分支,使用密集学习方式对模型预测得到的特征进行处理,通过对教师模型预测的分类特征排序,自动选择高质量特征作为教师模型生成的伪标签,从而避免了繁琐的伪标签后处理,提升网络的精度和训练速度.在MS COCO 数据集上,通过使用半监督学习方法,PPYOLOE 在1%、5%、10%的标注数据集上分别得到了1.4%、1.6%、2.1%的精度提升.与其他半监督目标检测算法比较,PPYOLOE-SSOD算法的精度达到最优.代码已开源在https://github.com/wjm202/ PPYYOLOE-SSOD.

半监督学习;目标检测;PPYOLOE;师生互助训练

目前使用全监督学习方法的目标检测[1-3]技术已经发展到瓶颈,仅使用有标注数据集难以使检测模型性能得到进一步提升,同时在部分下游任务的训练中,存在实例级数据标注难以获取的问题,因此使用有标注数据和无标注数据相结合的半监督学习方法[4-6]得到了广泛关注.当前的半监督学习方法主要分为以下3步:①使用有标注数据训练一个基线教师模型;②使用基线教师模型对无标注数据进行预测;③将无标注数据预测后的结果送入学生模型进行训练.

与知识蒸馏[7]不同,半监督学习的教师学生模型均采用相同的模型结构.半监督学习常用的训练方法大致可以分为两类:一类是一致性正则化,该方法通过对未标记的图像施加不同的扰动来构建正则化损失,鼓励对同一图像的不同扰动来产生类似的预测,其中扰动包括模型级扰动[8]、图像增强[9-12]和对抗性训练[13];另一类是自我训练,又名伪标记方法,教师模型使用弱图像增强数据为预测结果打上伪标签,而利用强图像增强的数据送给学生模型训练,然后与已标记的数据联合训练模型.在伪标记方法中,伪标签通常使用基于置信度的阈值过滤处理,教师模型只能保留具有高置信度的图像作为伪标签.

近年来应用有标数据和无标数据训练网络的半监督学习取得了重要进展,但是大部分研究都聚焦于图像分类任务,对于需要大量注释的目标检测任务少有涉及.文献[14]作为半监督目标检测的最先一批的算法,它首先通过预先训练好的模型生成伪标签,然后将它们反馈给网络,并通过调整损失函数比重进行模型微调.文献[15]为未标记的数据引入了更复杂的增强功能,包括Mix-up和Mosiac.目前的这些半监督目标检测方法,均是在Faster-RCNN[16]进行的实验,目前尚无在YOLO[17]系列的目标检测模型上相关的半监督目标检测工作.相比Faster-RCNN,YOLO系列模型兼具速度快和精度高的优点,最新推出的YOLO系列模型PPYOLOE,在MS COCO[18]数据集中已经接近目前基于CNN[19]的目标检测算法的最高精度,因此将半监督学习应用到YOLO系列模型中,将可能突破模型精度提升的瓶颈,考虑到YOLO模型的复杂结构,将半监督学习方法应用到YOLO系列不是一件简单的工作.

本文采用师生互助训练方式,设计了在线伪标签更新的半监督学习框架PPYOLOE-SSOD,在该框架中教师能够实时向学生模型传递伪标签,并进行教师模型参数的实时更新,提高了模型的训练速度和精度;此外,本文改进了无监督分支的伪标签策略,在分类分支引入质量焦点损失(quality focal loss)[20],并在回归分支引入分布焦点损失(distribution focal loss)[21],使用更适合于YOLO系列无锚框密集检测器的密集伪标签方案,避免了冗余的后处理,使训练速度和精度得到提升;之后,本文为半监督目标检测框架设计了多种强数据增强和弱数据增强,通过对输入图像施加不同程度的扰动,降低网络过拟合到少量标注数据的风险.在MS COCO数据集上的实验表明,在1%、5%、10%的标注数据上精度分别能够提升1.4%、1.6%、2.1%,充分证明了本文方法的有效性.

1 相关工作

1.1 YOLO系列目标检测

单级目标探测器由于其优异的速度和精度的权衡而在实时应用中非常流行.在单级探测器中,最突出的体系结构是YOLO系列[22-24].YOLO目标检测算法的核心在于模型的体积小,计算速度快.它可以通过神经网络直接输出边界框的位置和类别.自YOLO模型提出以来,YOLO系列标检测器在网络结构、标签分配等方面都发生了巨大的变化.YOLO系列检测器通常由两部分组成:一个是提取特征的主干网络,即基础网络,一般在ImageNet数据集上进行预训练;另一个是预测对象类别和边界框的头部.近几年,颈部被构建在主干与头部之间,用于汇集不同的特征图.以往的YOLO模型以基于锚定的方式分配地面真值框(GTbox).然而,锚框机制引入了许多超参数,并依赖于手工设计,基于上述原因,PP-YOLOv2[25]中引入了无锚框方法.此外为了得到全局最优的分配策略,YOLOX[26]引入了先进的动态标签分配方法SIMOTA,以提高标签匹配的准确度,在精度方面显著优于YOLOv5[27].

1.2 半监督目标检测

2 本文算法

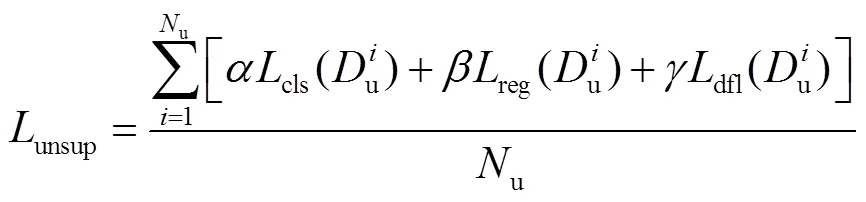

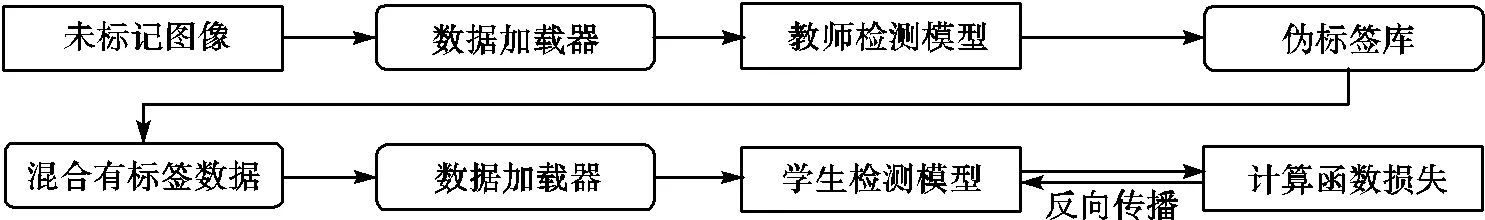

图1展示了本文的半监督算法结构,本文使用的半监督算法框架总共包含两个PPYOLOE模型,分别被称作学生模型和教师模型.在训练过程中有标注图像和经过强图像增强的未标注图像被送入学生模型中,经过弱图像增强的未标注图像被送入教师模型中,将教师模型的预测结果作为伪标签来指导学生模型训练.学生模型通过标记图像和未标记图像的检测损失来学习.学生模型参数通过指数移动平均方法(EMA)[32]对教师模型的参数进行更新.损失函数的计算为

图1 PPYOLOE-SSOD半监督检测算法流程

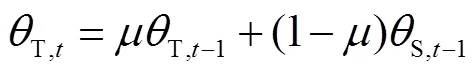

教师模型在训练过程中只进行伪标签推理,不进行梯度反向传播,EMA参数更新为

2.1 PPYOLOE介绍

本文的半监督目标检测算法所选用的基准模型是PPYOLOE的s版本,其网络结构如图2所示. PPYOLOE在速度和准确性权衡方面优于YOLOv5和YOLOX.在640×640的分辨率下,PPYOLOE-s的mAP=43.7,FPS=208.3.在特征提取网络部分其保持着优越的泛化能力和训练速度,设计了CSPRepResNet作为主干网络,颈部网络也采用了新设计的CSPPAN,通过神经网络宽度乘法和深度乘法灵活地配置模型的大小.PPYOLOE的头部网络可以认为是任务相关的自回归模块,由于分类和回归需要关注的高层语义特征不同,PPOYOLOE将输入的特征解码成回归任务和分类任务相关的特征,使用ESE模块替换TOOD[33]中的层注意力模块,将分类分支的对齐简化,将回归分支的损失函数替换为分布焦点损失,以TOOD中的头部网络为基础去掉冗余的卷积,引入解耦特征结构和通道层的自注意力机制,来提取更加细致的特征.

图2 PPYOLOE算法结构

2.2 无监督标签匹配策略:密集伪标签

以往的目标检测算法选择教师模型预测的分类分数大于指定分类分数阈值的预测框作为伪标签,并经过非极大值抑制处理(NMS)后送入学生模型进行损失计算,然而这种方法不仅对模型的非极大值抑制参数的选择有苛刻的要求,还会造成一定的监督信息损失.如图3所示,本文对训练集上的图像进行了伪标签的可视化,通过修改密集伪标签的学习区域,可以通过选择额外的样本来很容易地实现硬负挖掘,绿色点表示地面真值框的特征点分布,红色点和蓝色点分别表示采用NMS 和密集伪标签的方式特征点分布.经过NMS后大部分特征点被过滤掉,造成了一定量的监督信息损失,而密集伪标签很好地保留了物体的关键信息.

与经过NMS选取的硬标签不同,密集伪标签的分类分数表示连续值(值在0~1之间),由于PPYOLOE所使用的分类损失函数变焦点损失(varifocal loss)只能处理离散的二进制值(0或1),本文改进了质量焦点损失作为无监督部分的分类损失函数,其计算式为

图3 使用NMS阈值过滤的伪标签选择策略与密集伪标签选择策略对比

步骤1 统计最后一层特征层的特征点数,=××(和表示特征层的长和宽,表示训练批次).

步骤2 选取前×作为保留的特征点数量.

步骤3 根据个特征点所预测的训练集类别中的最大值进行排序,选择分类分数最大的前×个特征点作为计算无监督损失值的特征点.

步骤4 根据前×个特征点的索引值选择对应的方框和分类分数.

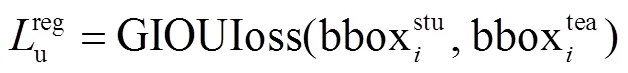

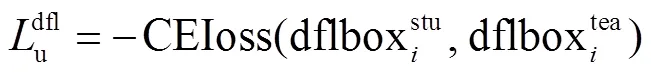

步骤5 计算无监督部分的分类损失和回归损失,分类损失函数和回归损失函数以及额外的分布焦点损失函数的表示分别为

2.3 图像增强策略

在引入未标注数据学习时,由于缺乏监督信息,这些未标注数据很容易关注模型的训练偏离的有效目标,由于模型的学习能力本身较强,从而导致模型在半监督学习中过拟合大量的未标注数据,并且由于YOLO系列模型缺乏二级检测器对预测框的二次处理,本文重新设计了PPYOLOE的图像增强策略.

本文对教师模型和学生模型分别使用不同强度的图像增强,具体地,对教师模型的输入采用弱图像增强(图像旋转、图像缩放等),保证伪标签的质量;而对学生的输入,采用强图像增强(高斯噪声、颜色抖动、随机擦除和灰度变换等),增加学生模型的训练难度,防止过拟合.在训练过程中所使用的图像增强效果如图4所示,图4(a)表示没经过图像增强的图像(原图),图4(b)、(c)、(d)、(e)分别表示经过高斯噪声、颜色抖动、随机擦除和灰度变换后的图像.

(a)原图 (b)高斯噪声 (c)颜色抖动 (d)随机擦除 (e)灰度变换

图4 教师模型所使用的强数据增强

Fig. 4 Strong data augmentations used in the teacher model

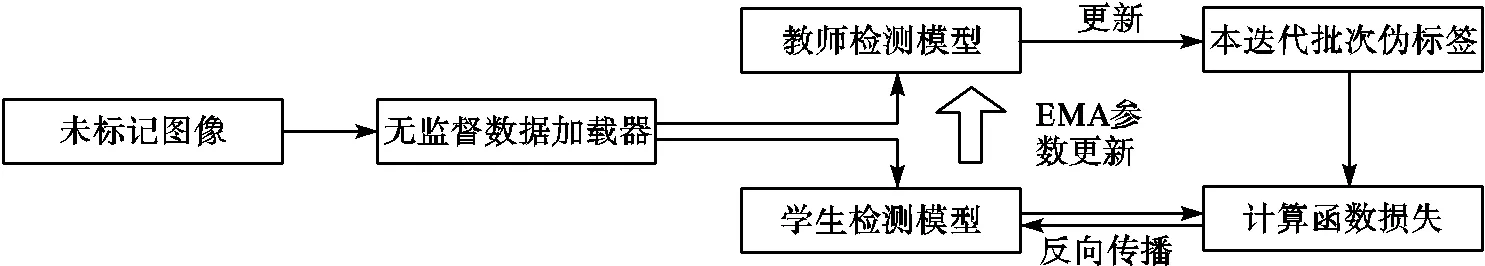

2.4 实时更新伪标签和模型参数的方法

如图5(a)所示,在以往的半监督图像分类方法中通常用有标注数据训练一个教师模型;生成伪标签,将无标注数据输入进教师网络中,得到的目标框预测结果,将这些目标框预测结果作为伪标签存储在伪标签库中,待所有的未标记图像均被打上伪标签后使用这些伪标签重新载入到数据加载器中进行模型的无监督训练.然而这种方法无法做到随着训练进程实时更新伪标签,导致在模型的性能有所提高时,下一个迭代的伪标签的质量没能做到及时更新,因此本文重新设计半监督算法的伪标签标注流程,如图5(b)所示,本文新建立了用于半监督两种数据加载器,一种是用于传递监督数据的加载器,另一种是无监督数据加载器.无监督数据加载器在每个迭代分别向教师模型和学生模型送入同一未标记图像,并在该迭代直接对教师的伪标记计算损失值,更新学生参数,之后教师模型的参数会通过EMA方式同步得到更新,使教师模型下一迭代得到的伪标签有更高的质量.

(a)离线更新伪标签和模型参数方法

(b)实时更新伪标签和模型参数方法

图5 伪标签更新方法比较

Fig.5 Comparison of pseudo label update methods

3 实验结果与分析

3.1 实验数据集

本文在目标检测公开数据集MS COCO和PASCAL VOC数据集上验证所提方法的有效性,MS COCO数据集包含 80个目标类别,它包含约115000 张训练图像、5000张验证图像本文使用训练集(train2017)训练,使用验证集(val2017)进行评估.PASCAL VOC数据集则使用VOC07 test数据集评估.在目标检测中,因为有物体定位框,图像分类中的精度并不适用,本文使用均值平均精度(mean of average precision,mAP)作为评价指标,均值平均精度表示所有类别的平均精度求和除以所有类别.

3.2 实施细节

本文代码使用PPYOLOE在obj365数据集上的预训练,用8张23G P40显卡训练模型在前80批次进行全监督训练,在这个训练过程中,不使用无标注数据,学习策略使用动量=0.9和权重衰减系数=0.0005的随机梯度下降(SGD),基础学习率为0.01,使用余弦学习速率调度,总时间段为80批次,预热阶段为3批次,在预热阶段使用ATSSAssigner静态匹配策略,在预热阶段后,使用TaskAlignedAssigner动态策略,总批次为64.在经过80批次的全监督训练后,开启半监督训练,对学生模型和教师模型分别载入全监督阶段训练好的权重参数,在此过程中向学生模型送入有标注数据以及经过强图像增强的未标注数据,向教师模型送入经过弱图像增强的未标注数据,在半监督训练过程持续80批次,使用TaskAlignedAssigner动态策略基本学习率为0.01,无监督部分的总批次为128,有监督部分的总批次同样为128.无监督部分和有监督部分权重为1∶1,无监督部分的分类损失、回归损失和DFL损失比为1.0∶2.5∶0.5.

3.3 方法有效性验证

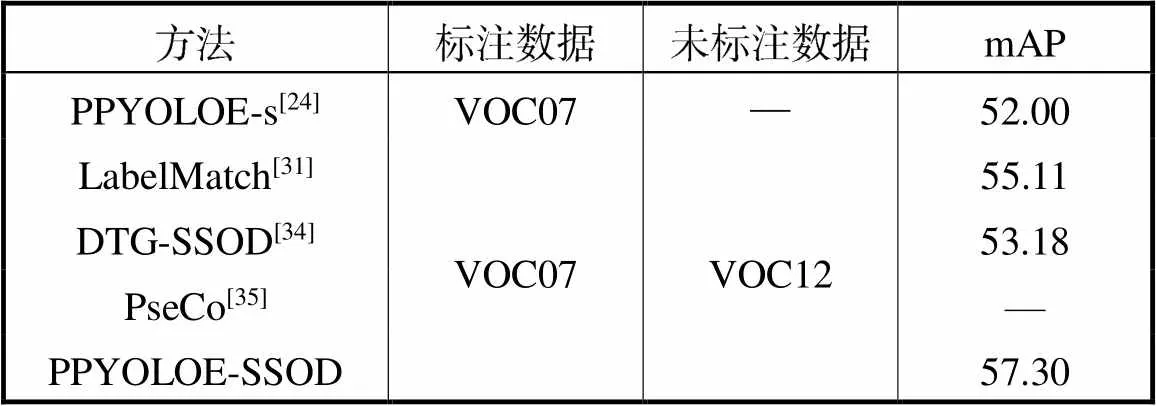

本文方法和PPYOLOE-s的全监督训练结果以及其他半监督目标检测算法在MS COCO数据集和PASCAL VOC数据集上进行了比较.遵循STAC的有效性验证方式,使用MS COCO数据集的训练集train2017中的1%、5%和10%的图像采样作为标记的训练数据,以train2017剩余的未采样图像作为未标记训练数据.对于所有比例的标注数据集,STAC随机抽取5个不同的数据组,得到的最终的性能指标是这5个数据组上的平均值.实验结果如表1所示,在使用1%、5%和10%的训练集数据作为有标记数据集进行半监督训练,PPYOLOE模型精度mAP分别提升了1.4%、1.6%、2.1%.使用PASCAL VOC数据集的VOC07数据集作为有标注数据,VOC12作为无标注数据,实验结果如表2所示.在半监督训练中,PPYOLOE模型精度mAP提升了5.3%.

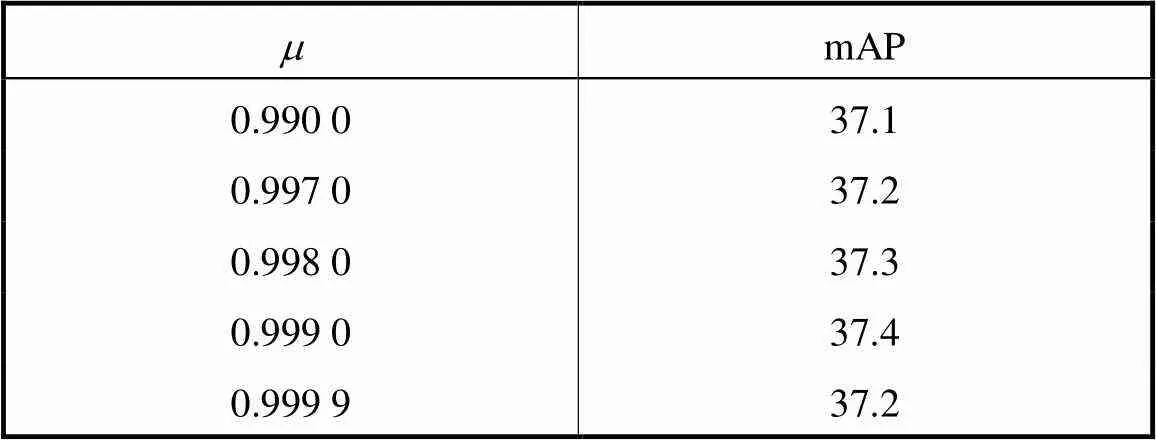

3.4 消融实验

所有消融实验均是在训练集的10%作为有标注数据其余作为无标注数据的设置下进行的,本文对所使用的无监督学习密集伪伪标签选择策略与其他半监督目标检测算法中的硬标签选择策略非极大值抑制进行了比较,使用密集伪标签选择策略相比于硬标签选择策略,mAP提升了0.4%,训练速度由平均训练2.4张/s,提升至平均训练3.1张/s.

表1 PPYOLOE-SSOD在MS COCO数据集半监督训练精度提升效果

Tab.1 PPYOLOE-SSOD accuracy improvement effect in MS COCO

表2 PPYOLOE-SSOD在PASCAL VOC数据集的半监督训练精度

Tab.2 Semi-supervised training accuracies of PPYOLOE-SSOD in the PASCAL VOC dataset

表3 特征点选择区域对比实验

Tab.3 Comparison experiment of feature point selection area

表4 半监督训练中使用的强图像增强

Tab.4 Strong image enhancement used in semi-supervised training

表5 EMA权重更新参数对比实验

Tab.5 Comparison experiment of EMA weighting pa-rameter update

3.5 实验结果可视化

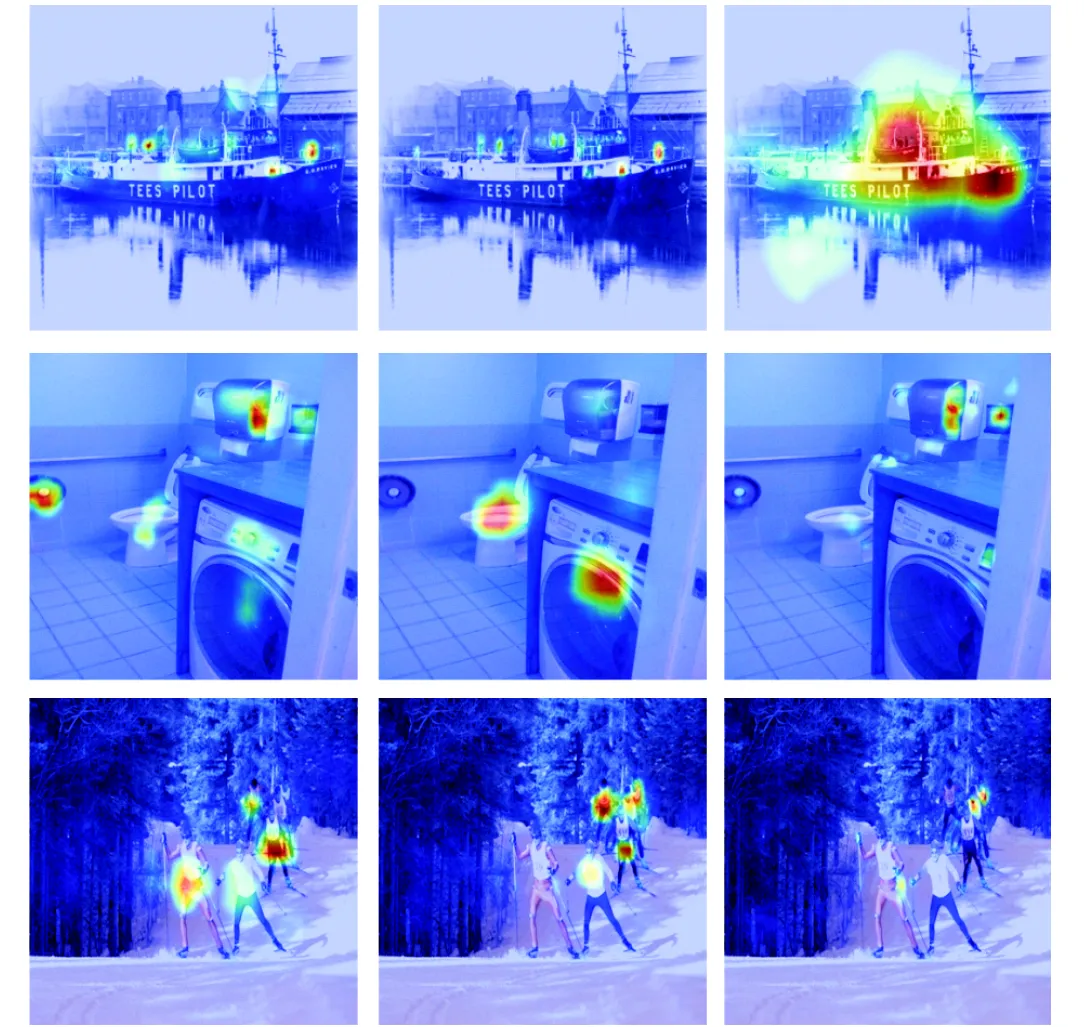

为了充分验证密集伪标签策略的有效性,本文对PPYOLOE-SSOD模型的头部分类分数预测结果进行了可视化,如图6所示,分类得分高的区域均准确地对应在了需要检测的物体目标上.

(a)第3特征层(b)第4特征层(c)第5特征层

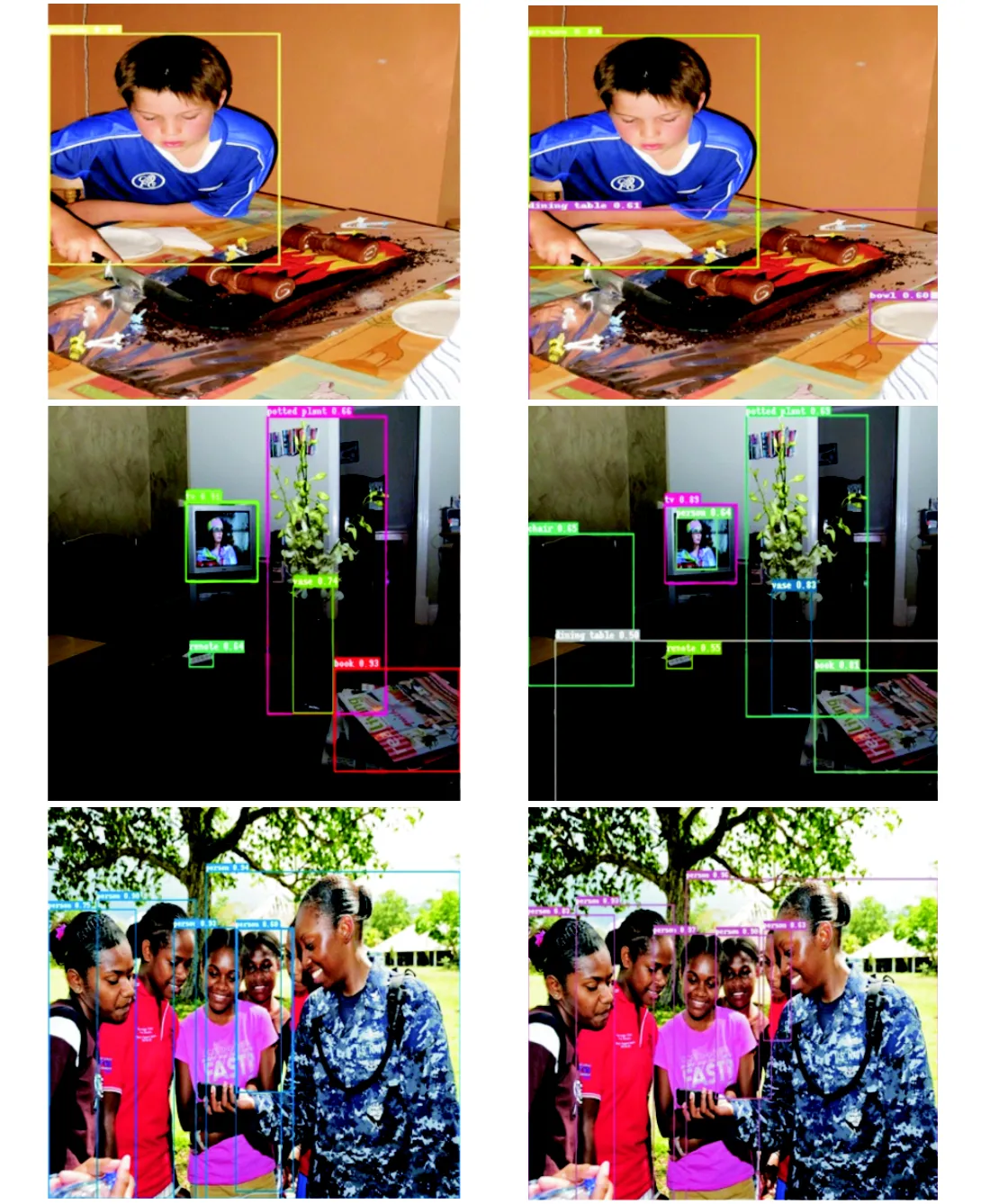

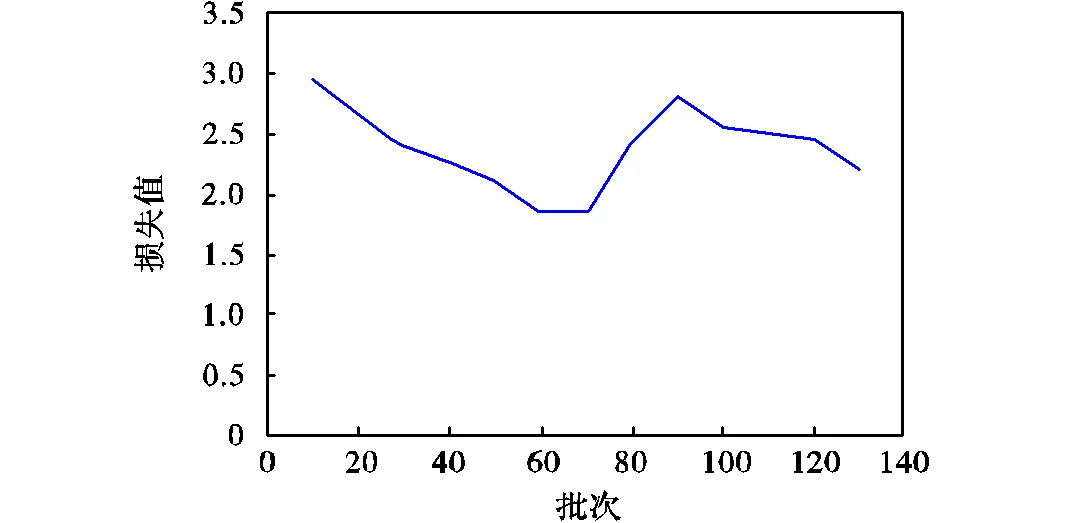

与监督基线相比,本文方法的可视化检测结果如图7所示,图7(a)、(b)分别表示使用半监督方法前后的检测效果,可以观察到使用本文提出的半监督方法后,模型能够检测出大部分漏检物体,检测精度提高.训练过程的损失曲线如图8所示.在训练的早期阶段,网络的精度不足,难以获得高质量的伪标签.半监督模型的损失大部分由有标注数据获得,随着模型精度的提升,有监督部分损失逐渐减小,更多高质量的伪标签参与训练,导致模型的损失上升,随着半监督训练趋于饱和,模型总体的损失曲线下降,并趋于平稳.

(a)PPYOLOE-s预测结果 (b)PPYOLOE-SSOD预测结果

图7 模型预测结果可视化展示

Fig.7 Visual display of model prediction results

图8 损失变化曲线

4 结 语

本文针对全监督学习的模型精度难以提升以及数据集注释难以获取的问题,提出了一种新型的基于YOLO系列的半监督目标检测方法(PPYOLOE-SSOD).该方法利用教师学生互助训练方式挖掘未标注数据的知识信息,并通过密集学习的伪标签选择策略,使模型避免了硬标签依赖于非极大值抑制等冗余后处理的困扰,并改进了模型的图像增强方法和训练流程,使模型的训练速度和最终精度得到了进一步提升,本文在MS COCO公开数据集上比对了本文算法与监督基线算法和其他半监督检测算法的检测性能,并通过对比实验验证了本文算法的有效性,明显优于其他半监督目标检测算法.

[1] Deng J,Xuan X J,Wang W F,et al. A review of re-search on object detection based on deep learning [C]//Journal of Physics Conference Series. Kunming,China,2020:12028-12067.

[2] Park H J,Kang J W,Kim B G. SSFPN:Scale se-quence(S2)feature-based feature pyramid network for object detection[J]. Sensors,2023,23(9):4432-4440.

[3] Carion N,Massa F,Synnaeve G,et al. End-to-end object detection with transformers[C]//Computer Vision-ECCV 2020:16th European Conference. Glasgow,UK,2020:213-229.

[4] Sohn K,Berthelot D,Carlini N,et al. Fixmatch:Simplifying semi-supervised learning with consistency and confidence[C]//Advances in Neural Information Processing Systems. Beijing,China,2020:596-608.

[5] Zhou H Y,Ge Z,Liu S T,et al. Dense teacher:Dense pseudo-labels for semi-supervised object detec-tion[C]//Computer Vision-ECCV 2022:17th European Conference. Tel Aviv,Israel,2022:35-50.

[6] Zang Y H,Zhou K Y,Huang C,et al. Semi-supervised and long-tailed object detection with CascadeMatch[J]. International Journal of Computer Vision,2023,131(3):1-15.

[7] Chen G B,Choi W G,Yu X,et al. Learning efficient object detection models with knowledge distilla-tion[C]//Advances in Neural Information Processing Systems. Long Beach,USA,2017:1010-1022.

[8] Berthelot D,Carlini N,Goodfellow I,et al. Mixmatch:A holistic approach to semi-supervised learning[C]//Advances in Neural Information Processing Systems. Vancouver,Canada,2019:980-994.

[9] Zhang X F,Dai L W. Image enhancement based on rough set and fractional order differentiator[J]. Fractal and Fractional,2022,6(4):214-215.

[10] Yan H,Zhang J X,Zhang X F. Injected infrared and visible image fusion via L1decomposition model and guided filtering[J]. IEEE Transactions on Computational Imaging,2022,8(3):162-173.

[11] Zhang X F,Liu R,Ren J X,et al. Adaptive fractional image enhancement algorithm based on rough set and particle swarm optimization[J]. Fractal and Fractional,2022,6(2):100-101.

[12] Shorten C,Khoshgoftaar T M. A survey on image data augmentation for deep learning[J]. Journal of Big Data,2019,6(1):1-48.

[13] Din N U,Javed K,Bae S,et al. A novel GAN-based network for unmasking of masked face[J]. IEEE Access,2020,8:44276-44287.

[14] Sohn K,Zhang Z,Li C L,et al. A simple semi-supervised learning framework for object detection [EB/OL]. https://arxiv.org/abs/2005.04757,2020-05-10.

[15] Zhou Q,Yu C H,Wang Z B,et al. Instant-teaching:An end-to-end semi-supervised object detection frame-work[C]//2021 IEEE/CVF Conference on Computer Vi-sion and Pattern Recognition. Kuala Lumpur,Malaysia,2021:4081-4090.

[16] Ren S Q,He K M,Girshick R,et al. Faster R-CNN:Towards real-time object detection with region proposal networks[C]//Advances in Neural Information Processing Systems. Montreal,Canada,2015:28-36.

[17] Redmon J,Divvala S,Girshick R,et al. You only look once:Unified,real-time object detection[C]//2016 IEEE Conference on Computer Vision and Pattern Rec-ognition. Las Vegas,USA,2016:779-788.

[18] Lin T Y,Maire M,Belongie S,et al. Microsoft coco:Common objects in context[C]//Computer Vi-sion-ECCV 2014:13th European Conference. Zurich,Switzerland,2014:740-755.

[19] Neelapu R,Devi G L,Rao K S. Deep learning based conventional neural network architecture for medical im-age classification[J]. Traitement Du Signal,2018,35(2):169.

[20] Li X,Wang W H,Wu L J,et al. Generalized focal loss:Learning qualified and distributed bounding boxes for dense object detection[C]//Advances in Neural In-formation Processing Systems. Beijing,China,2020:21002-21012.

[21] Li X,Wang W H,Hu X L,et al. Generalized focal loss v2:Learning reliable localization quality estimation for dense object detection[C]//2021 IEEE/CVF Confer-ence on Computer Vision and Pattern Recognition. Kuala Lumpur,Malaysia,2021:11632-11641.

[22] Li C Y,Li L L,Jiang H L,et al. YOLOv6:A single-stage object detection framework for industrial applica-tions[EB/OL]. https://arxiv.org/abs/2209.02976,2022-09-07.

[23] Wang C Y,Bochkovskiy A,Liao H Y M. YOLOv7:Trainable bag-of-freebies sets new state-of-the-art for real-time object detectors[EB/OL]. https://arxiv.org/abs/ 2209.02976,2022-07-06.

[24] Xu S L,Wang X X,Lü W Y,et al. PP-YOLOE:An evolved version of YOLO[EB/OL]. https://arxiv.org/abs/ 2203.16250,2022-03-30.

[25] Huang X,Wang X X,Lü W Y,et al. PP-YOLOv2:A practical object detector[EB/OL]. https://arxiv.org/abs/ 2104.10419,2021-04-21.

[26] Ge Z,Liu S T,Wang F,et al. Yolox:Exceeding yolo series in 2021[EB/OL]. https://arxiv.org/abs/2107. 08430,2021-07-18.

[27] Wu T H,Wang T W,Liu Y Q. Real-time vehicle and distance detection based on improved YOLOv5 net-work[C]//2021 3rd World Symposium on Artificial Intel-ligence. Guangzhou,China,2021:24-28.

[28] Liu Y C,Ma C Y,He Z,et al. Unbiased teacher for semi-supervised object detection[EB/OL]. https://arxiv. org/abs/2102.09480,2021-02-18.

[29] Xu M D,Zhang Z,Hu H,et al. End-to-end semi-supervised object detection with soft teacher[C]//2021 IEEE/CVF International Conference on Computer Vision. Kuala Lumpur,Malaysia,2021:3060-3069.

[30] Zhang F Y,Pan T X,Wang B. Semi-supervised object detection with adaptive class-rebalancing self-training [C]//2022 AAAI Conference on Artificial Intelligence. Vancouver,Canada,2022:3252-3261.

[31] Chen B B,Chen W J,Yang S C,et al. Label matching semi-supervised object detection[C]//2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans,USA,2022:14381-14390.

[32] Tarvainen A,Valpola H. Mean teachers are better role models:Weight-averaged consistency targets improve semi-supervised deep learning results[C]//Advances in Neural Information Processing Systems. Long Beach,USA,2017:30-40.

[33] Feng C J,Zhong Y J,Gao Y,et al. TOOD:Task-aligned one-stage object detection[C]//2021 IEEE/CVF International Conference on Computer Vision. Kuala Lumpur,Malaysia,2021:3490-3499.

[34] Li G,Li X,Wang Y J,et al. DTG-SSOD:Dense teacher guidance for semi-supervised object detection[EB/OL]. https://arxiv.org/abs/2209.02976,2022-07-06.

[35] Li G,Li X,Wang Y J,et al. Pseco:Pseudo labeling and consistency training for semi-supervised object de-tection[EB/OL]. http://arxiv.org/abs/2203.16317v1,2022-07-22.

Teacher-Student Mutual Training for Semi-Supervised Object DetectionBased on PPYOLOE

Zhang Guoshan,Wei Jinman

(School of Electrical and Information Engineering,Tianjin University,Tianjin 300072,China)

With the continuous advancements in deep learning,object-detection technology based on convolutional neural network has become a research hotspot in the field of computer vision. Currently,mainstream object-detection algorithms rely on supervised learning and training models on extensive labeled data. However,unlabeled data are easy to obtain,while labeled data are usually challenging,time-consuming,and labor-intensive to collect. This study proposed a semi-supervised object-detection(PPYOLOE-SSOD)algorithmbased on teacher-student mutual training to easily obtain data annotations. First,the student and gradually improved teacher models were trained simultaneously. The teacher model was then used to filter high-quality pseudo labels,which guided students during model training and extracted information from unlabeled images. Further,the exponential average method was used in each iteration to update the teacher model parameters to reduce the instability of parameter transfer. In addition,different data-augmentation methods were introduced to enhance the anti-interference ability of the network. Finally,the unsupervised learning branch was added for the learning of unlabeled data,and the features predicted by the model were processed using an intensive learning method. By sorting the classification features predicted by the teacher model,high-quality features were automatically selected as the pseudo labels generated by the teacher model,thus avoiding the tedious post-processing of pseudo labels and improving the accuracy and training speed of the network. On the MS COCO dataset,the accuracy of the PPYOLOE is improved by 1.4%,1.6%,and 2.1% on 1%,5%,and 10% labeled datasets,respectively,using the semi-supervised learning method. Compared with other SSOD algorithms,PPYOLOE-SSOD achieves the highest accuracy. The source code is at https://github.com/ wjm202/PPYYOLOE-SSOD.

semi-supervised learning;object detection;PPYOLOE;teacher-student mutual training

TP391.4

A

0493-2137(2024)04-0415-09

10.11784/tdxbz202302035

2023-02-22;

2023-06-23.

张国山(1961— ),男,博士,教授.

张国山,zhanggs@tju.edu.cn.

国家自然科学基金资助项目(62073237).

the National Natural Science Foundation of China(No.62073237).

(责任编辑:孙立华)