脉冲神经网络研究现状与应用进展

2024-01-19刘浩柴洪峰孙权云昕李鑫

刘浩 ,柴洪峰 ,孙权 ,云昕 ,李鑫

(1. 建信金融科技有限责任公司基础技术中心,上海 200120;2. 复旦大学计算机科学技术学院,上海 200438;3. 复旦大学金融科技研究院,上海 200438;4. 中国银联股份有限公司金融科技研究院,上海 201201;5. 上海大学悉尼工商学院,上海 200444)

一、前言

人工神经网络(ANN)作为人工智能技术发展的重要推动力,经过几代进化,已成为分析和解决问题的重要工具。第一代ANN被称为感知机,代表性的是1958年美国构建的两层神经元网络[1],可以模拟人类可感觉、可识别、可记忆和可反应的感知能力。第二代ANN是20世纪80年代中期出现的基于联结主义的多层人工神经网络[2],特别是2006年以来以卷积神经网络(CNN)为基础的深度学习方案引领了人工智能发展[3]。尽管ANN的发展取得了显著进步,但深度神经网络在功耗效率、安全性、可解释性和在线学习能力等方面仍面临诸多挑战,制约了ANN的进一步应用。

作为自然界最卓越的智能体,生物大脑成为人工智能研究最重要的参考对象。近年来,脑科学与人工智能的研究在相互促进中快速发展,尤其是类脑计算研究受到广泛关注。类脑计算是一种模仿神经生理学和生理心理学机制、以计算建模为依托、通过软硬件协同实现的机器智能计算,兼具生物合理性和计算高效性,未来有望成为人工智能新的计算范式。类脑计算不是对人脑神经元进行简单模拟,而是对人脑的信息处理机制、复杂工作方式、学习、思考、推理、决策的本质性机理进行深层次的探索和模拟。各国纷纷部署类脑计算发展研究,以期在新一轮世界科技革命竞争中掌握主导权。美国、欧盟、日本等国家和地区组织了以类脑计算为核心的脑科学计划。美国在2013年提出了“人脑计划”,将神经信息学、高性能计算、脑机接口、类脑相关理论建模等列为研究重点。欧盟在2013年推出“人类脑计划”,在大脑模拟、神经形态计算、医学信息学和神经机器人等领域开展联合攻关。日本在2008年启动“脑科学战略研究项目”,重点布局神经信息基础技术、脑科学与教育社会、脑科学与信息产业、脑科学与健康等领域的研究。我国在2016年发布《“十三五”国家科技创新规划》,将脑科学与类脑研究纳入“科技创新2030—重大项目”。

在类脑计算研究中,脉冲神经网络(SNN)占据核心地位,是最具有生物意义、最类似大脑运行机制的神经网络模型,被认为是新一代的神经网络[4]。SNN以脉冲神经元为计算单元,模仿人类大脑的信息编码和处理过程。SNN和ANN具有显著差异。在处理数据方式方面,SNN采用离散事件(脉冲)对数据进行编码处理,与ANN相比,能耗显著降低、计算能力更加突出[5]。在神经元模型方面,ANN通常采用大量简单的计算单元,如修正线性单元(ReLU)、sigmoid函数、tanh函数等,将这些单元相互连接形成复杂神经网络;SNN则采用具有记忆的非差分神经元模型构造神经网络,如霍奇金 - 赫胥黎(H-H)模型、泄漏积分发射(LIF)模型等,具备可提取数据时空特征、功耗更低、更适合并行计算的优势,已被广泛应用于语音识别[6,7]、视觉处理[8,9]、医疗诊断[10,11]等领域。

在存算分离的冯·诺依曼计算架构上,大规模的SNN模型处理需要较多时间和功耗,因而,SNN硬件实现技术的相关研究成为当今研究的热点。神经形态硬件设计模式主要包括模拟电路、数字电路和数模混合电路。模拟电路设计模式的功耗较低,数字电路设计模式对于处理大规模SNN模型更为灵活、成本更低[12,13]。现场可编程逻辑门阵列(FPGA)在软硬件协同设计时,在实现模型量化和稀疏化方面具有独特优势,被认为是实现数字神经形态平台的核心技术方案之一;目前在单个FPGA设备上已尝试处理SNN模型,相比于中央处理器(CPU)和图形处理器(GPU)实现方式,其速度更快、功耗更低[14,15]。此外,研究人员结合数字电路技术和模拟电路设计方法,开发数模混合电路设计模式,克服了传统模拟电路抗干扰能力较弱、保密性较差等缺陷。

本文首先介绍SNN的基本要素及学习算法,包括神经元模型、突触可塑性机制、信息编码方式和SNN训练算法;其次,细致梳理SNN相关软、硬件的研究进展,从计算机视觉、自然语言处理、推理决策等方面详细阐述SNN的最新应用情况。相关研究内容可为人工智能领域技术发展、产业应用等提供全面、客观、科学的评价和建议,以期促进技术创新和产业发展。

二、脉冲神经网络的基本要素及学习算法

SNN的基本要素及其相关生物学理论基础主要包括具有动力学特性的神经元模型、突触可塑性机制、基于脉冲序列的信息编码方式,进而形成低能耗、高鲁棒性、高认知能力的新一代人工智能模型。SNN领域的核心训练算法和技术主要包括:有监督学习、无监督学习、ANN向SNN转化和其他进化算法。

(一)神经元模型

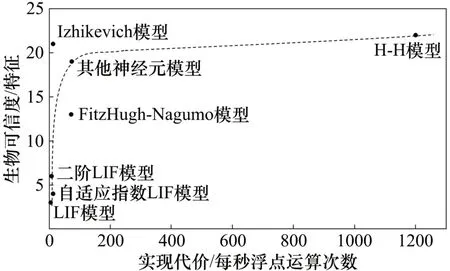

脉冲神经元与传统ANN神经元的结构相似,但工作行为具有较大差异。经过多年发展,已建立了多种脉冲神经元模型,如H-H模型、LIF模型、Izhikevich模型和脉冲响应模型(SRM)等。这些模型刻画了神经元的生物动力学特性,具有一定的计算复杂性。以下对4种具有代表性的神经元模型进行介绍。

1. H-H模型

1952年,Hodgkin和Huxley研究了神经元中动作电位的启动与传播机制,提出了电流通过膜电位的数学模型[16],即H-H模型。H-H模型准确表述了神经元的真实动力学特性,是生物学意义上最合理的脉冲神经元模型[17]。然而,H-H模型的微分方程需要连续计算,每模拟1 ms约需要1200次浮点运算[18],计算复杂性较高。因此,此模型不太适合大规模的SNN模拟计算。

2. Leaky Integrate-and-Fire模型

1907年,Lapicque提出了Integrate-and-Fire(I&F)模型,输入脉冲可以集成到膜电位中,如果达到定义的阈值,则输出产生脉冲,膜电位回落至静息状态[17]。LIF模型是I&F神经元模型的重要类型之一,增加了膜电位的泄漏。LIF模型简化了神经元动作电位过程,具有模拟神经元脉冲效率较高、计算成本较低等特性,成为大规模SNN中采用的主要神经元模型[19,20]。此外,基于亚阈值晶体管和电容器电位表现,较容易对神经元集成和衰减动力学特性建模,因此,在SNN硬件实现研究中,也广泛运用LIF神经元模型[19]。在LIF模型的基础上还存在诸多变体,如指数LIF模型、二阶LIF模型以及自适应指数LIF模型等[21]。

3. Izhikevich模型

2003年,Izhikevich提出了一个兼具H-H模型动力学特性和LIF模型计算效率的神经元模型[22],即Izhikevich模型。这是一个二维脉冲神经元模型,每1 ms模拟需要约13次浮点运算[18],可应用于处理较为复杂的工程问题,如模拟海马体功能。

4. 脉冲响应模型(SRM)

SRM是基于LIF模型提出的一种通用模型,更加精确地描述了输入脉冲对膜电位的影响[23]。与LIF模型不同,SRM包含了对于重置和不应期的模拟。此外,SRM模型采用滤波器的方法描述膜电位变化,而LIF模型则采用微分方程进行刻画。

总体而言,目前已提出了多种在生物可信度和计算可行性方面存在一定差异的脉冲神经元模型[24](见图1),用户可以权衡二者利弊,根据自身需求选择合适的神经元模型。LIF模型因其较低的实现代价,已广泛应用于神经元动力学特性的刻画;但与H-H等复杂神经元模型相比,LIF模型在生物可信度方面仍存在不足。因此,建立一个计算效率高且生物学上更合理的神经元模型仍是当前亟待研究的问题[25]。

图1 不同神经元模型的生物可信度与实现代价

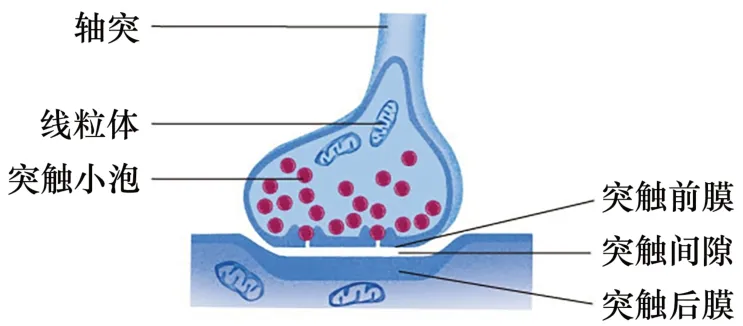

(二)突触可塑性机制

突触是神经元之间在功能上发生联系的部位,是信息传递的关键部位(见图2)。当上游神经元放电时,脉冲信号通过突触刺激下游神经元的膜电位。从功能来看,突触可以分为兴奋性突触和抑制性突触两类。突触前神经元脉冲通过突触传递,影响突触后神经元的活动,若输入的脉冲增加突触后神经元的膜电位,即为兴奋性突触;若输入的脉冲降低突触后神经元的膜电位,即为抑制性突触。突触连接强度决定了神经元膜电位变化的大小,可视为两个神经元连接的权重表征。研究发现,突触强度是可调节的,会随着突触连接的前后神经元发放脉冲的相对时间推移而增强或减弱,这种现象被称为脉冲时间相关的突触可塑性(STDP)[26]。STDP规则揭示了突触结构内权重变化的过程,已被引入SNN模型,用来增加生物可信度。

图2 突触结构

(三)信息编码

在生物神经系统中,信息是被分散编码并通过动态神经来表达的。神经脉冲序列是信息在神经系统中的一种重要表达方式。为了描述这种神经活动,研究人员提出了多种编码方法,其中频率编码和时间编码是两种较为常见的神经信息编码方式[27]。

频率编码是通过神经元的脉冲发射频率来传递信息的,如图3(a)所示。频率编码机制较为简单,在复杂任务处理方面具有突出的表现[28,29]。时间编码是通过神经元的脉冲时间序列来传递信息的,包括时滞编码、排序编码、相位编码等,分别如图3(b)、图3(c)、图3(d)所示。在时滞编码中,神经脉冲的产生时间与刺激的强度呈负相关[30]。排序编码是对脉冲到达的顺序进行特定编码[31],可以更好与LIF神经元模型结合,实现高斯差分滤波效果,有利于特征提取[32]。相位编码根据背景振荡对脉冲相位中的信息进行编码,已应用于机器人导航和嗅觉系统[33]。频率编码和时间编码主要关注的是单个神经元的信息编码方式。除此之外,研究人员还提出了群编码,即联合多个神经元对刺激产生的信息进行编码。在群编码中,每个神经元都可以生成具有精确时间的脉冲序列,同时还包含与其他神经元的关系(如高斯接受域),有助于提升信息编码的生物可信性[34]。

图3 脉冲信息编码方式

信息编码的方式会显著影响SNN的性能表现。神经元模型、软件框架、硬件约束、应用场景和目标等对于信息编码方式的选择都具有重要影响[35]。总体来看,当前大多数信息编码方式只是从不同角度完成对神经元信息的表征,在任务表现、功耗等方面还有较大提升空间。探索研发一种更为通用、理想、全面的SNN信息编码方式仍将是未来研究的重点问题。

(四)学习算法

SNN的神经元信息以脉冲序列进行传递,不再满足连续可微的性质,因此传统的ANN学习算法不能直接应用于SNN。研究人员在考虑各类神经元模型与信息编码的差异性、平衡生物合理性及计算可行性的基础上,提出了多种训练算法,主要包括有监督学习算法、无监督学习算法、ANN向SNN转化和进化算法。

1. 有监督学习算法

有监督学习算法通常是利用带有标签的训练数据,学习一个从输入变量到输出变量的函数映射关系。在SNN中,这种标签以具有时序属性的目标脉冲序列形式进行编码。算法旨在学习网络的连接权重,以便特定地识别各种输入并输出相应的目标脉冲序列。在SNN的有监督学习算法中,大部分监督学习规则是基于梯度优化的方法,学习目标是试图最小化目标脉冲序列和输出脉冲序列之间的误差。脉冲信号在时间维度上是离散的,脉冲形式的激活函数是不可微的,导致SNN无法直接应用基于误差反向传播的梯度优化算法。因此,SNN监督学习算法研究受到众多研究者的关注,已提出了多种有监督学习算法[36~41]。

2. 无监督学习算法

无监督学习通过对无标签样本数据的学习来揭示数据的内在特性及规律。SNN的无监督学习算法是基于Hebb学习规则建立的。其中,STDP学习规则是Hebb学习规则的典型代表,可以直观反映两个神经元之间的突触强度取决于突触前和突触后脉冲的相对时间[42,43]。如果刺激突触前神经元末梢,突触后电位增加导致突触传递效率保持长时间强化,则代表突触的权重增加,这种现象被称为长时程增强作用(LTP);如果神经元受到反复刺激后,突触传递效率明显且持续降低,则代表突触的权重降低,这种现象被称为长时程抑制作用(LTD)[44,45]。LTP、LTD两种可塑性为理解和描述STDP学习规则中神经元之间复杂的相互作用提供了重要理论支撑[46]。近年来,研究人员基于STDP学习规则提出了多种SNN无监督学习算法[45~49]。由于更注重网络相近两层的连接、缺乏与网络其他部分的关联和协调,STDP学习规则在应用于多层网络时的准确性不足。

3. ANN向SNN转换

SNN神经元复杂的动态行为和对时间的高度敏感性,导致SNN训练算法设计面临较大挑战,算法成熟度欠缺。一些研究者开始关注将ANN直接转化为SNN,即利用较为成熟的ANN训练算法来训练深度神经网络,然后通过频率编码将ANN中ReLU函数的神经元非线性激活值转换为SNN中I&F神经元脉冲发放率,实现ANN向SNN的转化,从而避免了直接训练SNN的难题[28,29,50~52]。ANN转换为SNN的优点有:一是可以广泛利用基于ANN开发的高效学习训练技术,如应用于分类任务的先进深度学习网络可以转换为SNN,并且可以将其直接部署在专为模拟神经元和突触操作而设计的神经形态硬件上,简化了从理论到实用的转变过程;二是相比于传统ANN,由ANN转化的SNN在实现较高准确性的同时降低了信号传输和计算的成本,即使对于ImageNet和CIFAR-10等具有挑战性的大型数据集,其精度损失也很小[29,53]。然而,ANN向SNN转化的技术方法仍存在一些缺陷。一是ANN向SNN转化具有一定要求,如不能采用最大池化、批归一化等方法。二是大部分ANN向SNN转化所采用的信息编码方法为频率编码,通常需要大量输入脉冲,仿真步数较长,这与降低额外能耗的原始目标有所相悖。三是有关ANN向SNN转换方法的研究主要集中于开发新结构的转换技术和减少与ANN之间的性能差距,对SNN特性的研究并不深入,不利于推动SNN的进一步发展。

4. 进化算法

进化算法受生物的演化机制启发,通过模拟繁殖、突变、遗传重组、自然选择等演化过程,对最优化问题的候选解做演化计算。与传统的基于微积分的方法和穷举方法等优化算法相比,进化算法是一种成熟的、高鲁棒性和广泛适用性的全局优化方法,具有自组织、自适应、自学习的特性,能够不受问题性质的限制,有效处理传统优化算法难以解决的复杂问题。研究人员试图将进化算法与SNN有机结合起来,基于进化算法训练SNN,有效对脉冲神经元突触的权重进行优化,提高对复杂问题的求解能力[54~58]。然而,进化算法的计算较为耗时,适应度函数计算成本较高[59];同时,基于进化算法训练的SNN在解决特大规模问题方面具有一定的局限性[60]。

三、脉冲神经网络软件与硬件研究进展

SNN软件模拟器提供了一个可控且灵活的研究和开发环境,可模拟神经元动态行为和脉冲传播,实现SNN学习训练、快速建模和仿真。脉冲神经形态芯片是模仿生物神经系统结构和功能的硬件,具有高度并行和事件驱动的特点,能显著提高SNN的运算速度和能效。为了解SNN软件与硬件的情况,首先对主流的SNN软件模拟器从模拟计算方法、编程语言、并行度、主要功能等方面进行介绍;其次,对基于数模混合电路和全数字电路设计的神经形态芯片进行介绍。

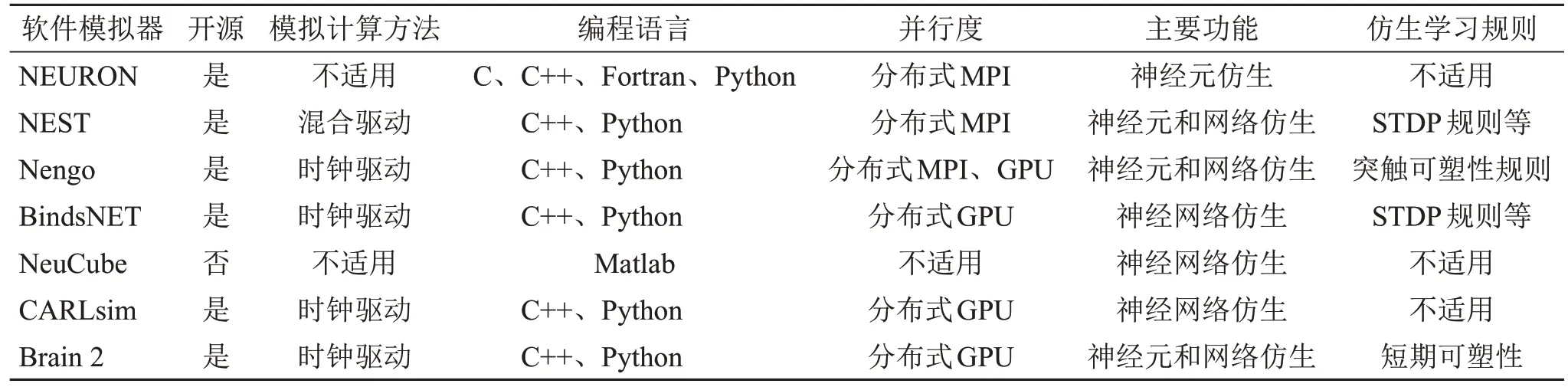

(一)SNN软件模拟器

SNN软件模拟器可以帮助SNN建模和学习训练,快速运行基于SNN设计的应用程序。现有的SNN软件模拟器在脉冲神经元模型的生物可信度、模拟计算速度和硬件平台支持方面具有很大差异。根据神经元动力模型的评估方式,可以将SNN软件模拟器分为两大类:时钟驱动和事件驱动。时钟驱动指神经元状态变量的更新限定在给定的离散时间点上;事件驱动指只有当脉冲神经元发放脉冲时,神经形态系统才会触发计算[61]。

多数SNN软件模拟器采用时钟驱动计算方法,可以充分利用CPU和GPU并行计算资源,适用于模拟复杂度较高的大型神经网络,但其存在大量无效计算、仿真精度受时间步长限制、侧向抑制失效的情况。基于事件驱动的SNN模拟器更新的神经元状态次数较少,可以高精度地处理脉冲信息,具有较高的运算速度,适合时空稀疏的神经网络[62]。在选择SNN软件模拟器计算方法时,可以主要考虑神经网络架构复杂度、硬件资源支持、仿真需求和目标等因素。

目前,主流的SNN软件模拟器包括NEURON、NEST、Nengo、BindsNET、NeuCube、CARLsim、Brain 2等,如表1所示。① NEURON是用来模拟单个神经元或者神经元网络的仿真软件,为神经元网络中实现电信号和化学信号的生物学模型提供了强大且灵活的环境[63]。在数字模拟时,用户只需考虑神经元的几何形状参数、生物物理参数以及神经元之间的连接关系等信息,不需要考虑底层的数值求解方法,这有助于用户能够更专注于思考科学问题本身而不是其背后的数学模型和数值分析处理,因此成为国际上最受欢迎的神经建模工具之一。此平台支持C、C++、Fortran、Python等多种编程语言,可满足用户不同的编程需求。② NEST是专为仿真大型异构神经网络而设计的软件[64],不仅可以模拟哺乳动物的视觉 / 听觉皮层信息处理的SNN模型,还可以模拟层状皮质网络、平衡随机网络、可塑性等动力学模型。NEST可以支持集成式MPI、OpenMP通信协议,通过分布式计算显著提高仿真速度。③ Nengo是一个以图形和脚本为基础的大型神经系统仿真软件,其神经网络模型能够高度模拟人的大脑思维方式[65],具有高度的扩展性和灵活性;用户可以自定义神经元类型和学习规则,构建和运行深度神经网络,并可在不同的神经形态硬件上模拟模型。④ BindsNET主要利用PyTorch进行矩阵计算来模拟SNN,可直接依靠自动梯度求导机制对SNN进行训练和学习[66]。⑤ NeuCube可支持基于频率编码的SNN模型,可在GPU进行加速计算,支持与Matlab和Java的交互;但NeuCube不是开源项目,在应用范围和可用性方面受到一定限制[67]。⑥ CARLsim是一个基于GPU加速的大规模脉冲神经网络仿真系统,可以在通用的X86 CPU和标准GPU上模拟基于Izhikevich模型构建的SNN[68]。⑦ Brain 2是用于模拟SNN的开源仿真软件,其设计方式易于学习和使用,非常灵活且易于扩展[69];可以支持多种类型的神经元模型(如H-H模型、LIF模型),可针对存在不同类型神经元的大规模SNN进行仿真模拟。Brain 2使用代码生成技术,可以自动将用户定义模型转换为可执行的低级别C++代码,不需要用户操作即可编译和运行。

表1 主流的SNN软件模拟器

(二)硬件实现

脉冲神经形态硬件的设计方式主要包括三类:模拟电路、全数字电路和数模混合电路。模拟电路可以使用物理过程描述脉冲神经元动态性能,实值物理变量拥有几乎无限的精度,能够以低廉的成本完成对SNN神经元状态的连续性更新[70,71]。由于模拟电路抗干扰能力较弱、保密性较差,导致路由网络部分的跨核和跨芯片的长程数据传输难以精确完成。为克服此缺陷,研究者采用数字电路技术重新设计路由网路,而计算核仍主要采用模拟电路设计方式,总体呈现数模混合的架构特点。表2对基于数模混合电路的神经形态芯片进行了总结。① BrainScaleS芯片是数模神经网络芯片的典型代表之一,其核心是基于180 nm 互补金属氧化物半导体(CMOS)工艺设计的高输入计数模拟神经网络(HICANN)芯片,具有良好的生物解释性和可配置性,可以实现比生物大脑快1000~100 000倍的运行速度[72]。该芯片单个晶圆片中有352个芯片,每个芯片内部含有512个LIF神经元,共计有131 072条连接突触,系统功耗约为1 kW。② Neurogrid芯片是基于硅晶体管亚阈值状态的CMOS电流模电路研发的神经形态芯片。该芯片包含16个神经网络计算核,每个计算核内部拥有256 256个神经元,可以实时模拟百万级数量的神经元和60亿突触连接,支持仿真H-H等复杂神经元模型,每个芯片尺寸为12×14 mm2,系统总功耗为3.1 W[73]。③ ROLLS芯片采用180 nm一层多晶硅6层金属(1P6M)CMOS工艺制造,拥有256个神经元和12.8万个突触连接,面积为51.44 mm2,在典型应用下的功耗仅为4 mW[74]。该芯片专门用于研究仿生突触学习机制,可支持实现SNN在线实时学习。④ DYNAPs芯片连接采用二维网络路由拓扑,芯片内计算核之间采用树形结构路由拓扑,这种路由结构融合了网络拓扑的低带宽需求和树形拓扑的低延迟优势[75]。该芯片有4个计算核,单核包含256个神经元,可以通过配置参数广泛支持基于事件驱动的神经网络架构。

表2 基于数模混合电路的神经形态芯片

除晶体管外,还有一种基于新型纳米忆阻器件来模拟电特性的混合电路。忆阻器是一种两端纳米电子器件,其主要特点是能够保持并根据经过的电荷量改变电导状态[76],被视为一种模拟生物突触的理想工具。在SNN中,忆阻器不仅能够模拟突触权重,还可以根据输入的脉冲信号动态调整这些权重。这种调整机制模拟了生物突触的长时程可塑性,如LTP和LTD。忆阻器的引入为SNN提供了一种更紧凑、高能效的计算模式。忆阻器的高密度特性可实现存算一体化,使矩阵与向量的乘法运算更为高效,提高了SNN的计算速度和能效。然而,忆阻器在SNN中的应用还面临一些挑战,如器件的稳定性、漏电问题以及与其他电子组件的集成问题[77,78]。尽管如此,许多研究团队正在努力克服这些限制,使忆阻器成为神经形态计算的核心组件储备。

数字电路设计方式是用比特来表示脉冲神经元所有状态变量,这意味着状态变量的精度取决于用于表示状态变量的比特数。状态变量的精度对于基本操作的耗能和存储内存要求具有重要影响。与模拟电路相比,数字电路可以有效控制神经元状态变量的精度,并且能够在最先进的芯片制造工艺上实现[79],如FPGA和专用集成电路等芯片工艺。表3对基于数字电路的神经形态芯片进行了总结。① TrueNorth芯片是由国际商业机器公司(IBM)基于28 nm高级低功耗(LPP)CMOS工艺制造的全数字可伸缩神经形态芯片。该芯片使用了4096个神经突触核心和54亿个晶体管,产生的效果相当于100万个神经元和2.56亿个突触,运行期间的功率仅为70 mW;具有很好的扩展性,能够通过外部连接组成更为复杂的神经网络系统,在图像处理、语音识别、事件预测等方面展现出卓越性能[50]。② SpiNNaker是可以支持实时仿真大规模SNN的全数字电路神经形态计算平台,每个芯片集成了18个同构ARM968处理器核和128 MB的片外直接内存访问(DMA)控制器,在运行频率为180 MHz时的功耗约为1 W,尺寸面积为102 mm2。该芯片可仿真近1000个神经元,支持多种神经元动力学模型,包括H-H模型、LIF模型和Izhikevich模型等,具有高度的编程灵活性[80]。③ Loihi是英特尔公司(Intel)推出的在线学习神经形态芯片,具有树突计算、层次化链接、突触延迟、发放阈值自适应、核对核多播、可塑性机制支持等特性[81]。Loihi 1芯片采用了Intel 14 nm FinFET工艺制造,核心面积为60 mm2,有128个神经形态核心和3个X86处理器核心;其中,单核最多包含1024个神经元和16 MB突触容量,拥有12.8万个神经元和1.28亿个突触,每个神经元可以有24个变量状态。Loihi 2是Intel第一个采用极紫外光刻(EUV)工艺节点Intel 4 制造的芯片,核心面积降至31 mm2,集成了128个神经形态核心和6个低功耗的X86处理器核心;得益于制造工艺的大幅提升,神经元数量提升至100万个,突触数量略微降至1.2亿个。Loihi 2可以根据神经元模型要求,最高分配4096个变量状态,其处理速度是Loihi 1的10倍。④ TianJic是清华大学研发的世界首款异构融合类脑计算芯片,采用极易扩展的2D-mesh众核互联结构[82]。初代芯片基于联华电子公司(UMC) 28 nm制程工艺制造,单核包含256个神经元,尺寸面积约为0.078 mm2,在14.44 mm2硅片上集成的突触数量超1000万个,在支持SNN学习训练的同时,也能够为ANN运算提供算力(峰值为1.3 TOPS)。第二代芯片具有更好的灵活性和扩展性,密度提升约20%,速度至少提高了10倍。基于TianJic芯片构建的可扩展通用人工智能开发演示平台,展示了无人驾驶自行车的车身平衡控制、目标实时跟踪、语音命令识别、自动避障和自主决策等功能。⑤ Darwin是浙江大学与杭州电子科技大学基于硅材料打造的SNN类脑芯片,初代芯片内含500万个晶体管,包含2048个神经元和超过400万个神经突触,尺寸面积为25 mm2。Darwin 2基于55 nm CMOS工艺技术制造,单芯片由576个内核组成,每个内核支持256个神经元、神经突触超过1000万个。基于792个Darwin 2芯片构建的国内首台类脑计算机,支持1.2亿个脉冲神经元和近1000亿个突触,相当于老鼠大脑神经元的数量,典型运行功耗为350~500 W。在强大的软件和硬件支持下,该计算机实现了对异构计算资源的统一调度和管理,为大规模SNN计算任务提供了操作和服务平台,已用于目标检测、路径规划等智能任务处理。

表3 基于数字电路的神经形态芯片

四、脉冲神经网络应用研究进展

SNN在计算能力、模型泛化和硬件实现等方面持续提升,已在计算机视觉、自然语言处理和推理决策等训练任务中取得了显著进展。在计算机视觉领域,SNN在目标检测、动作识别等方向拥有广阔的应用前景,其能量效率和计算性能得到显著提升。在自然语言处理方面,SNN在语义认知、语音识别等任务中展现出显著的发展潜力,通过模拟神经元脉冲活动提供了更接近生物神经系统的信息处理方式。在推理决策领域,SNN成功应用于资源分配、知识表示与生成等任务,利用神经脉冲的时空特性实现实时学习与决策。SNN在这些任务中的研究进展为人工智能领域带来了新的突破与机遇,预示着未来SNN将在更多行业领域发挥关键作用。

(一)计算机视觉任务

在计算机视觉任务中,SNN通常面临处理高维、连续像素数据的挑战,这需要更高效的技术来编码和解码脉冲序列。近年来,研究人员通过改进脉冲神经元和脉冲编码技术,显著提高了SNN在图像分类、目标检测等任务中的性能。SNN在与时间相关的计算机视觉任务中表现出了巨大潜力,如动作识别和光流估计等,为未来计算机视觉研究带来新的契机。

1. 图像分类

近年来,SNN在图像分类任务方面的研究进展迅速,取得了一些令人瞩目的成果。Xu等[45]提出了结合CNN和SNN学习能力的深度CovDenseSNN新型混合框架;该框架使用无监督STDP学习规则更新模型框架参数,适用于神经形态硬件,可有效处理现代图像分类等任务。Qu等[47]开发了横向抑制和稳态抑制两种硬件友好型方法,减少了抑制连接数量,降低了硬件成本。研究学者采用STDP学习规则调整输入层和学习层的突触权值,在手写数字图片数据集MNIST上模拟数字识别任务;该方法在保持最先进性能的同时,使学习效率提高了30%~50%。Tavanaei等[49]提出了一种训练多层脉冲卷积神经网络的方法,训练过程包括两部分:首先基于STDP学习规则进行无监督特征提取,然后通过近似梯度下降进行脉冲模式分类。实验表明,该方法在MNIST数据集上对手写体数字分类任务具有较好的效果。Lee等[38]将脉冲神经元的膜电位作为可微变量,认定脉冲处的不连续为噪声,使SNN下的误差反向传播机制遵循与传统深度学习网络相同的原理。该技术方案可以更精确地捕获脉冲统计数据;通过在MNIST测试集上评估发现,相比传统CNN,可以用较少的计算操作获得更高的精度。Wu等[39]结合逐层空间域和时间相关时态域,提出了一种用于训练高性能SNN的时空反向传播算法(STBP),解决了SNN中脉冲信息不可微的问题。通过在静态MNIST、动态N-MNIST等数据集进行评估,结果表明,此算法与现有先进的SNN算法相比精度更高。Rueckauer等[51]提出了一种可以允许大部分CNN向SNN转化的方案,并在MNIST、CIFAR-10以及更具挑战性的ImageNet数据集上进行了测试评估,发现在实现同样准确率时的算力能耗下降了1/2。Sengupta等[29]提出了一种ANN向深层SNN转换的方法,摆脱了残差网络架构和牛津大学视觉几何研究组提出的VGG模型的限制,在CIFAR-10、ImageNet等复杂数据集上展示了较高的准确率。Wang等[52]针对现有ANN向SNN转化方法存在占用大量存储空间的问题,提出了一种有效的脉冲神经元权重与阈值平衡转化技术方法,可获得具有二进制权重的SNN,显著降低了内存存储,并在MNIST数据集上实现了较高的识别精度。

2. 目标检测

SNN具有高度并行的信息处理能力、极低的功耗特性,已在多个目标检测基准数据集上展示出优越的性能,能够处理各种复杂场景的实时目标检测任务。Kim等[83]提出了一种基于SNN的目标检测模型,并在目标检测数据集(PASCAL VOC)和微软标注图像识别数据集(MS COCO)上进行测试,发现与应用深度神经网络进行目标检测的效果相当。Kim等[84]提出了一种阈值电压平衡方法,从准确性、延迟和突触操作数量三方面提高了基于SNN目标检测模型的性能。此方法不仅实现了快速的收敛速度,而且在突触操作数量显著减少的情况下实现了最先进的目标检测精度。Chakraborty等[85]提出了一种基于脉冲混合神经网络的高效鲁棒目标检测方法。与基于深度神经网络的目标检测方法相比,此方法表现出更好的精度且更加节能。Jiang等[86]设计了一种基于霍夫变换的SNN,并利用神经形态视觉传感器提供的异步事件流进行管道物体检测和跟踪;此外还进一步验证了基于SNN的目标检测和自主跟踪方法的有效性、准确性,并在CPU和GPU上进行了性能比较。结果表明,SNN模型在GPU上的性能最好,在CPU上的精度最高。Vemuru[87]提出了一种基于SNN的边缘检测器设计方式,发现其在低曝光时间生成8位图像的目标检测方面具有优势,检测时间约为几毫秒。基于此发现,可以尝试将可见光谱下工作的事件相机(如硅视网膜)与神经形态模拟器相结合,开发出在弱光条件下检测目标物体的新型人工智能应用。Demertzis等[88]基于进化脉冲神经网络开发了一种半监督异常检测系统,能够快速地检测异常网络攻击行为。

3. 动作识别

SNN在动作识别任务中也表现出强大的潜力,可以有效处理时间序列数据,已被成功应用于复杂的动作识别任务,如手势识别和运动信息感知等。Cheng等[89]提出了一种脉冲发射时间搜索算法,显著提高了SNN的前向传播速率。此外,利用表面肌电信号,将所提出的SNN用于手势识别,识别准确率达到97.4%。Tsang等[90]提出了一种利用调频连续波雷达进行手势识别的SNN方法,并在Soli和Dop-NET两个公开数据集中进行了测试验证,准确率达到98%以上。Safa等[91]提出了一种用于雷达手势识别的4-b权重脉冲神经网络,在4个处理时间步长内就实现了93%的准确率。Xing等[92]提出了一种脉冲卷积递归神经网络,利用卷积运算和递归连通性来维护基于事件序列数据的时空关系,可以较好地解决基于神经形态视觉数据的识别问题,如人类手势识别。该网络利用脉冲层误差重新分配训练机制(SLAYER),并在DVS手势数据集上进行验证,对10类手势的识别准确率均达到了96.59%。Liu等[93]提出了一种基于事件的动作识别脉冲神经网络,可提取从事件到局部再到全局感知的多层次运动信息,进行动作识别。经过大量的实验测试,证明了此SNN架构在动作识别任务中的有效性。Banerjee等[94]提出了一种学习动作信息的空间和时间特征的脉冲卷积神经网络,在测试数据集中实现了85%的准确率,与经典技术获得的效果相当。该方法可部署到连接雷达的神经形态边缘设备上,以减少推理延迟。

4. 光流估计

SNN在光流估计任务中展现了重要的研究价值。SNN利用其独特的信息编码机制,能够对高速移动的物体进行精确的运动追踪。近期研究已经证明,SNN在光流估计的准确性和鲁棒性上均有很好的表现。Lee等[95]提出了一种SNN和ANN深度混合的神经网络架构Spike-FlowNet,可在不牺牲性能的情况下有效地估计稀疏事件相机输出的光流。该网络在MVSEC数据集上进行了光流预测能力和计算效率的评估,结果表明,Spike-FlowNet在光流预测能力方面优于成熟的ANN。Paredes-Valleś等[96]提出了一种可以进行分层特征提取的SNN架构,实现了局部和全局的运动感知。Cuadrado等[97]提出了一种能够进行密集光流估计的SNN,并使用该网络在事件传感器数据集DSEC上训练以及估计驾驶场景的光流。Zhang等[98]提出了一种端到端的SNN来预测事件相机离散时空数据的光流,并与现有方法在公共数据集上进行了实验对比,结果表明,在光流估计精度方面与现有最好的方法效果相当,而功耗比现有算法节省99%以上。Chaney等[99]提出了一种可用于密集光流估计的完全自监督卷积SNN,并在MVSEC数据集上进行测试验证,结果表明,其在功耗方面表现较为优秀。

表4对典型计算机视觉任务算法在公开数据集上的评测结果进行了总结。

表4 典型计算机视觉任务算法在公开数据集上的评测结果

(二)自然语言处理任务

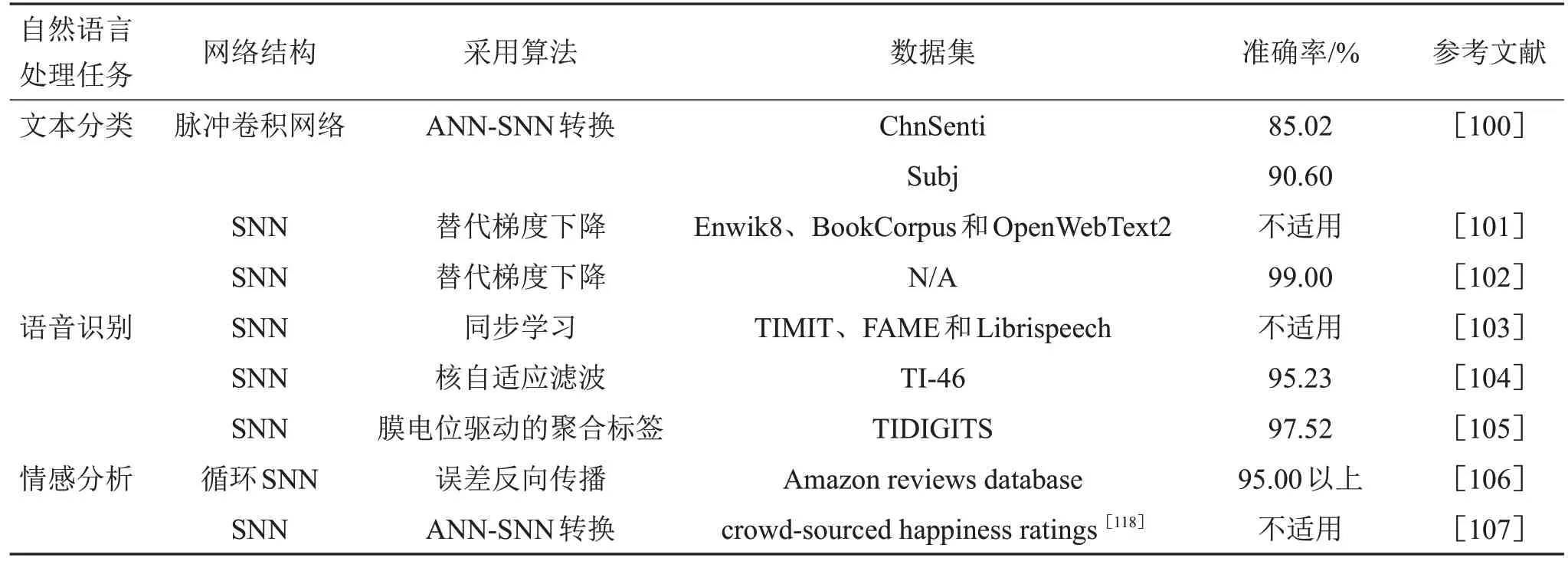

在自然语言处理任务中,更加有效地表示和处理语言的序列性及上下文信息是当前面临的技术难题。SNN具备模拟生物神经元的优势和独特的信息编码能力,可以处理大规模的语义数据并进行深层次的语义理解。近期,SNN在文本分类、语音识别和情感分析等自然语言处理任务中的应用均取得了一定的进展。表5对典型自然语言处理任务算法在公开数据集上的评测结果进行了总结。

表5 典型自然语言处理任务算法在公开数据集上的评测结果

在文本分类任务方面,Lyu等[100]提出了一种“转换+微调”的两步法来训练SNN,并在英语、汉语等多个数据集上进行文本分类任务测试,结果表明,该网络可以以更少的能量消耗获得与DNN相当的效果,同时在对抗性攻击方面有更强的鲁棒性。Zhu等[101]提出了一种基于SNN的生成式语言模型“SpikeGPT”,成功将SNN与Transformer架构结合,在相关测试集上实现了与ANN相当的性能,同时能耗显著降低。Mo等[102]提出了一个新型脉冲时空信道概念,在信息传递方向引入时间维度,扩大神经元之间的连接;同时结合替代梯度下降算法,设计了一种SNN训练算法,具有更快的收敛速度和更高的文本分类识别精度。

在语音识别任务方面,Wu等[103]基于SNN构建了一个大词汇量自动语音识别模型,在较低能耗下可以准确地对每个音频帧进行分类,能够高质量地完成语音识别任务。Li等[104]提出了一种基于脉冲序列的语音识别和关键词发现系统,具有较好的噪声鲁棒性和较快的计算速度。Zhang等[105]提出了一个基于SNN的语音识别框架,其中连续帧的频谱信息使用阈值编码进行编码,利用一种新型膜电位驱动的聚合标签算法进行学习训练,有效提高了分类精度。

在情感分析任务方面,Solairaj等[106]提出了一种基于SNN的在线产品评论情感分析系统,并在亚马逊评论数据库进行测评,相比现有的技术方法,其准确率有较大提升。Diehl等[107]提出了一种基于SNN的文本情感分析方法,并在神经形态硬件TrueNorth上实现。该方法在情感分析数据集上进行了测试验证,表现出与原始DNN相当的效果。

(三)推理决策任务

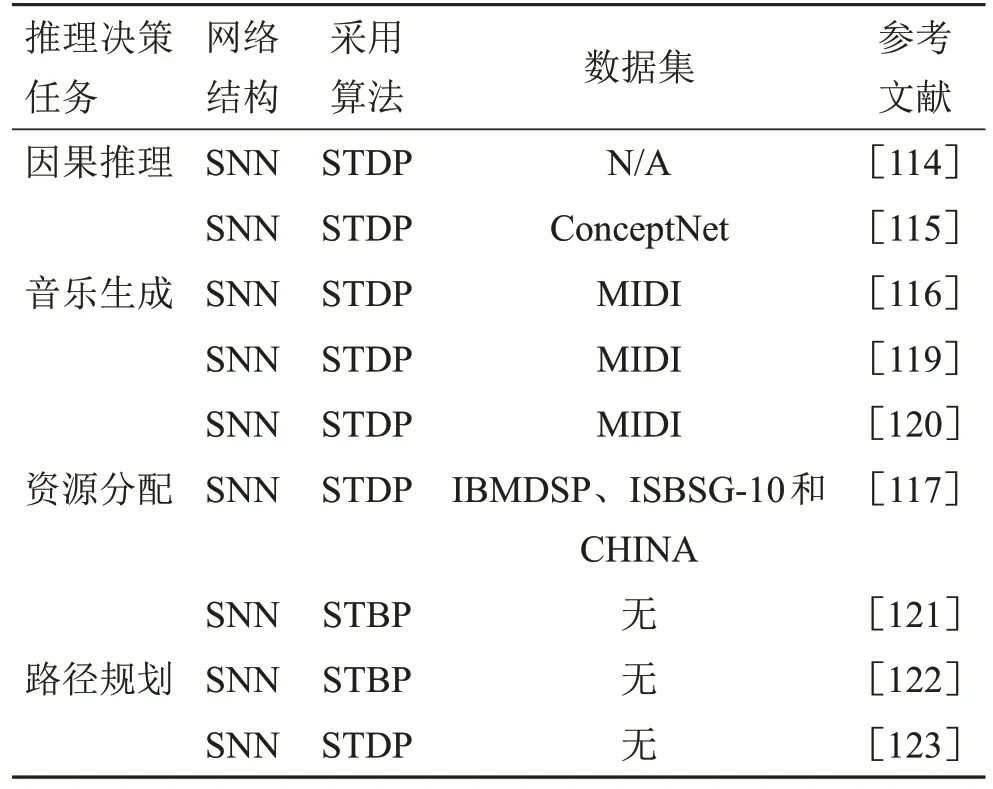

SNN在智能推理与决策任务方面展现出了较好的应用价值。SNN具备生物学动态仿真特性和低延迟等优势,在处理时空信息上表现出色,已在因果推理、智能决策任务中发挥重要作用,如音乐生成、资源分配、路径规划等。但SNN通常依赖于时间序列的输入,因此在处理需要快速决策的复杂任务时可能面临延迟问题。随着SNN学习算法的不断发展和网络结构的持续优化,SNN的推理速度和准确性将进一步提升,为实现自适应、更高效的智能系统奠定基础。表6对典型推理决策任务算法进行了总结。

表6 典型推理决策任务算法总结

Fang等[114]提出了一种基于STDP学习规则和群编码机制的SNN,在因果图任务中展示了其在因果推理方面的可能性。Fang等[115]基于群编码、STDP学习规则和奖励机制,提出了一种用于知识表示与推理的图脉冲神经网络。通过实验研究发现,该网络可以很好地完成传递与非传递关系推理、提取与生成知识等任务,不仅有更好的可解释性和生物可信性,而且达到了与图卷积人工神经网络相当的精度,并具有更快的收敛速度。Zeng等[116]提出了基于SNN的脑启发认知智能平台BrainCog,支持各种大脑启发的认知功能,包括知识表示、因果推理、智能决策等。基于突触可塑性和信息编码机制,该平台可以捕捉音乐的时序动态,利用SNN处理时间序列数据的优势,仿真生物大脑处理音乐创作的复杂性,完成音乐生成、符号序列生成、演绎推理和归纳推理等任务。Venkataiah等[117]提出了一种用于软件项目开发过程中资源分配的SNN,能够更准确地估计软件开发过程的成本,实现资源优化配置,提高项目管理效率。Steffen等[123]提出了一种可在三维地图上进行路径规划的SNN,能够对周围环境实现快速模拟并确定最优行进路径。SNN的并行处理能力和时序决策特性使其能实时响应环境的变化,动态调整路径规划策略,以适应不断变化的约束条件和优化目标,有效规避障碍和规划行进路线,提升路径规划的灵活性和效率。

(四)行业应用场景

当前,世界正从数字化向智能化转型,作为核心驱动力的人工智能算法模型也正在不断升级进化。近10年,以深度学习为代表的ANN在自然语言处理、图像识别和智能决策等方面取得了丰硕成果,可以匹敌人脑甚至超越人脑。相较于深度学习神经网络,SNN融合了受生物启发、高效的神经信息处理机制,具有更稳定且鲁棒的信息表征能力、更高效节能的计算优势,在一定程度上解决了传统ANN难以处理的时空数据问题和高能耗问题。随着SNN等类脑技术和产业的成熟,其应用场景将覆盖医疗健康、工业检测、民生消费、智能交通、安防联控和智慧金融等行业。

1. 医疗健康

人工智能技术已成为医疗健康行业信息化和智能化建设的重要支撑,推动着行业的不断发展。然而,医疗健康行业仍面临实时健康监测高功耗、大量生物信号数据精准模式不易识别等技术难题。SNN等类脑智能技术和高端集成电路的不断进步,推动神经形态计算市场的快速发展,其在医疗健康领域的应用也在不断扩大和深化,为现有技术难题提供了有力的解决方案。目前,已有一些创新技术公司着手设计针对神经形态计算的硬件解决方案,通过可穿戴设备监测心电、眼电、肌电、呼吸等生理信号,借助分类器模型对人不同的状态进行判别分析,以达到预期的分类识别效果[124~128]。该解决方案在不干涉人正常生活的情况下,能够对人体自然状态下的精神状态实现低功率边缘感测处理和异常瞬时监测,为生命安全提供有效保障。此外,神经形态计算在神经预测与新兴疗法领域进行了探索应用。研究人员将监测到的个体大脑信息与其他数据融合并进行分析,实现个体化的神经预测,主要包括智力测试、脑疾病诊断、认知障碍分析以及犯罪倾向预测等[129~132]。针对抑郁症患者,医生可通过对眼窝前额皮质进行开环的神经刺激,调节与抑郁相关的大脑子网,从而缓解中度和重度抑郁病症。

2. 工业检测

自工业时代以来,制造商一直在使用不同的技术来监控装配线上的工艺和产品质量。目前的科技水平已经能够在大部分生产流程中实现缺陷和异常检测自动化,但传统视觉检测的最大局限性是反应相对缓慢,在对高速移动物体质量检测方面存在不足。相较于传统基于帧的视觉传感器,神经形态视觉传感器不受固定帧速率的限制,可以提供高精度的时间数据,且对绝对照明不敏感,可以对运动物体的相对变化快速作出反应。因此,神经形态视觉传感器在边缘检测和动态视觉识别方面具有明显优势。Belbachir等[133]在研究中使用的视觉感知系统可以有效处理工业自动化视觉任务,如对运动物体计件、分类和表面检测。Ni等[134]利用神经形态视觉传感器对工业微型机床高速运动的机械手进行跟踪,凭借其超过4000 Hz的刷新频率,成功实现了微米级物体拾取放置任务。神经形态视觉感知系统将智能自动化制造行业的生产水平提升到一个更高的层次,有效提高了质量控制与质量保证水平。

3. 民生消费

智能语音作为智能时代人机交互的关键接口,在家居、办公、玩具、支付等民生消费场景驱动着行业快速发展,不断实现技术突破。目前,语音控制类的智能硬件产品在很多场景下存在语音交互体验不足、远距离语音交互存在障碍、语音识别率需进一步提升等问题,特别是针对汉语普通话、方言语音区别特征,如清音、浊音、鼻音、非鼻音等,在识别解码过程中模型匹配准确率较低。近年来,SNN在语音识别方面取得了显著的进步[103~105,135,136],有效提高了处理复杂语音模式的能力,降低了语音识别误差,尤其是在嘈杂环境下的表现较为优异。未来,基于SNN的低功耗语音识别和口令识别技术,将成为解决噪声干扰问题和打破距离瓶颈的重要方法之一,并推动智能家居、智能办公和智能玩具等场景人机语音交互提升至更高水平。

4. 智能交通

交通领域是人工智能技术应用较早的领域之一,尤其是在智能座舱和自动驾驶方面,不少汽车公司陆续推出解决方案,让司乘人员享受智能出行带来的便捷。智能座舱是智能汽车上与司乘人员交互最密切的部分,通过神经形态软硬件框架可提升自然语义理解和视觉感知能力,主动感知人的需求,实现人与车的全空间交互。当前的自动驾驶解决方案多基于深度学习算法进行设计并已取得一定成效,但仍存在一定的局限性,如自主学习、自适应能力弱,高度依赖于模型构建;计算资源消耗比较大,CPU、GPU消耗量大;逻辑分析和推理能力不足,仅具备感知识别能力。类脑智能技术可为自动驾驶领域带来重大突破,一些研究学者已开展相关研究。Guo等[137]使用新型动态视觉传感器CeleX的脉冲信号重构插帧来提高图像序列帧率,并将其运用于驾驶员的疲劳检测系统;Li等[138]将基于事件驱动和基于帧的摄像机结合,运用于自动驾驶的目标联合检测,在极端光照条件和高速运动场景下均表现出强劲的性能。可以预见,未来可以将传统人工智能在搜索、计算、推演、学习能力上的优势与类脑智能技术在思考、创新、应变能力上的优势进行有机的结合,使自动驾驶迈向更高阶的全场景智能驾驶。

5. 安防联控

安防行业是人工智能技术落地比较成熟的应用领域,其先进性和未来的可发展性毋庸置疑。目前,在安防领域广泛使用的机器视觉系统需要先进行信息探测然后再对其处理,所使用的图像传感器在探测目标图像的同时会产生大量冗余信息。这些冗余信息通过有限的带宽传输至计算机或者图像处理器进行处理和分析,从而导致较大的时间延迟和较高的功耗。因此,构建具备同步信息探测和处理功能的类脑视觉传感器对于智能安防领域的发展至关重要。一些研究人员和类脑智能公司尝试开发基于事件驱动的神经形态处理器,并将其应用在图像视觉传感器中。这种处理器具有低功耗、低延迟特性,支持视觉传感器等物联网设备永久在线,可以对监测区出现的人员、车辆等图像视觉数据实时监控和处理,实现异常事件的实时报警提示[139~141]。随着类脑智能、物联网、云计算技术与超高清、热成像、全景监控等传统安防技术的深度融合,安防联控行业智能化将向更高水平跃升。

6. 智慧金融

随着大数据和人工智能等技术的发展,科技进步对传统的投资组合管理方法提出了挑战。特别是均值 - 方差优化法,在估算资产回报分布和考虑风险收益时可能存在偏差,且未充分考虑投资者动态资金局限和交易成本。此外,现代金融数据具有高维度、高噪声、非线性等特点,深度神经网络模型在一定程度上解决了上述问题,但存在能耗高、“黑箱”特性等,难以准确把握数据中的非平稳动态和复杂的交互作用,对模型的因果关系及经济学原理解释仍十分有限。这也影响了人工智能神经网络在经济、金融等社会科学应用中的推广。类脑计算模拟人脑处理信息的方式,具备更强的抽象与归纳、推理与决策能力,为资产管理提供了新的思路,应用前景广阔。Saeidi[142]等提出了一种神经形态计算框架,将SNN的低功耗、高鲁棒性能力与深度神经网络的学习能力相结合,有效提升了模型学习过程中重要信息的传递和训练能力。该框架在神经形态芯片Loihi上部署实现,并在加密货币市场上进行了测试验证,是一种节能的投资组合优化解决方案。Ho等[143]提出了一种基于类脑技术研发的日内金融交易系统,其预测模型模仿人脑海马区的突触运行机制和信息处理方式,具有更强的鲁棒性和自适应能力。该系统将预测功能引入到平滑异同移动平均线(MACD)趋势信号计算中,缓解了MACD指标的滞后性。通过对标准普尔500指数进行实验测试后发现,该系统具有高度准确的预测能力,能够及时识别交易机会,可为投资者带来更为丰厚的收益回报。

类脑计算还可用于金融市场风险管理。投资者运用类脑计算技术,可以更准确地分析金融市场的波动情况,有助于识别和预测金融市场风险,在优化交易策略的同时降低风险。Mateńczuk等[144]将SNN应用于金融时间序列的预测分析中,分析了交易型开放式指数证券投资基金的风险收益。Gao等[145]使用基于STDP学习规则的SNN无监督学习算法预测了金融时间序列的价格峰值,并提出了3种高频交易策略对原油和黄金期货价格的日内高频数据进行了回溯测试。实验结果表明,该方法可以较好地识别隐藏在历史价格时间序列中的信息,进而预测价格峰值,在持续盈利的同时有效控制市场风险。

总体来看,SNN在计算机视觉领域的成熟度相对较高,在医疗健康、工业检测、智能驾驶、智能安防等领域已有应用,但在金融、社会科学领域的应用仍处于起步探索阶段。随着类脑复杂系统、类脑控制等理论与方法的持续研究和突破,SNN将广泛应用于各行业。

五、脉冲神经网络技术发展及前瞻

我国在以SNN技术为核心的类脑计算领域布局较为滞后,与发达国家相比,在基础研究、技术应用和产业生态等方面均存在一定差距,面临技术积淀不够、人才储备不足和生态活力欠缺等挑战。为突破这一局面,推动SNN、深度强化学习等类脑技术的创新发展,加快与国际先进水平实现接轨,本文从技术攻关、实际应用和生态建设三方面提出了推动SNN技术发展的建议。

一是加强关键核心技术攻关。持续加强脑科学与类脑基础研究,在脑工作原理和运作机理取得突破的基础上,加强原创性、共性技术及设备攻关,加大对高精度生物神经系统仿真模拟平台、类脑计算学习机制、SNN算法模型等研究的投入力度。加强多学科交叉合作,鼓励脑科学与心理认知科学、电子信息学、量子信息科学、计算机科学、人体工程学等学科融合,支持建立多学科协同的研究模式,促进类脑计算重大理论创新,实现关键核心技术突破。

二是推动技术成果转化应用。具有原创技术的“硬科技”企业,在发展初期通常面临市场基础较弱、市场转化难等问题。为此,建议推动产业链技术链融合贯通,强化竞争优势,通过先期技术产品在市场上的价值实现,支持后续类脑技术的深度开发,加快推动科技成果转化应用形成良性循环。聚合企业、高校和科研院所的优势研究力量,倡导对类脑计算科研成果进行“价值发掘 - 价值培育 - 价值实现”的全生命周期管理,加强对前沿科技成果的储备,促进“产学研”合作对接,支持创新技术成果尽快从实验室走向市场。

三是持续优化产业生态格局。建立健全多层次、跨领域的合作机制,推动技术、资本、产业及政府等资源的高效整合,在政策、场地、资金方面支持类脑计算产业发展。逐步完善类脑计算产业标准体系,前瞻布局SNN、神经形态芯片等技术标准研究,充分发挥产业标准对推动技术进步、服务企业发展、加强行业指导、引领产业升级的先导性作用。推动打造跨学科交叉、国际化培养、“产学研”结合的新型人才培养模式,以科学研究为牵引,构建类脑计算综合性人才培养机制,为类脑计算产业发展提供坚实的智力支持。

值得指出的是,当前的SNN研究虽然已取得了显著进展,但仍有诸多问题需要深入探讨和着力解决。例如,需要研究并构建具备生物可信度、多模态协作和多时空尺度联合表征的高效脉冲编码理论与模型;探索多突触可塑性的协调机制和生物神经网络的全局可塑性机制,建立高效的深度SNN学习算法,实现多认知任务协同背景下的类脑智能学习、推理和决策;研究在小样本和非完全信息环境下的高效自主SNN学习算法,提高在不同任务中的高效、鲁棒决策能力;针对大规模深层SNN,研究高性能的学习算法,并探索其在大规模复杂实际场景中的应用。

可以预见,SNN是下一代人工智能的重点发展方向之一,在类脑计算研究中处于核心地位。生物学、认知科学、信息学等学科的交叉与融合,有助于持续完善类脑计算中的信息编码、处理、学习与推理等理论,提升SNN响应外部环境变化的实时性和自适应性,降低计算和通信的能耗,促进大规模SNN新模型的构建和部署,支持实现高可解释性、强泛化能力的人工智能,从而拓展人工智能的更广阔应用前景。

利益冲突声明

本文作者在此声明彼此之间不存在任何利益冲突或财务冲突。

Received date:September 18, 2023;Revised date:November 8, 2023

Corresponding author:Chai Hongfeng is a professor of the Institute of Financial Technology, Fudan University, and a member of the Chinese Academy of Engineering. His major research field is financial information engineering management. E-mail: chaihongfeng@cae.cn

Funding project:National Key R&D Program of China (2021YFC3300600);Chinese Academy of Engineering project “Strategic Research on Financial Risk Monitoring and Early Warning System under the Background of Digital Transformation” (2023-XY-43); National Natural Science Fund project (72201161); Joint Research Project of Yangtze River Delta Community of Sci-tech Innovation (2022CSJGG0800, 2021-YF09-00114-GX, PO3522083587, PO3522083675, HP2300490)