ChpoBERT:面向中文政策文本的预训练模型

2024-01-03沈思陈猛冯暑阳许乾坤刘江峰王飞王东波

沈思,陈猛,冯暑阳,许乾坤,刘江峰,王飞,王东波

(1. 南京理工大学经济管理学院,南京 210094;2. 南京农业大学信息管理学院,南京 210095;3. 江苏省科技情报研究所,南京 210042)

0 引 言

政策文本是政府政策行为的反映,也是记录政策发展走势、政策意图的重要载体,而政策文本研究则是观察、梳理政策过程的重要途径[1]。对于政策文本的类别,Chilton等[2]从3个层面进行了划分,本研究的政策文本主要为“政府或国家或地区的各级权力或行政机关以文件形式颁布的法律、法规、部门规章等官方文献”。目前,政策文本研究主要分为两类:定性研究与定量研究。其中,定性研究要求研究者拥有较高的实践经验和分析能力[3],而定量研究则需要研究者拥有大量的数据和高性能的计算模型。随着我国治理体系的不断完善和政府信息公开化的发展,政策文本研究所能获取的数据量愈加庞大,分类体系愈加复杂,同时相应增长的还有定性分析所需的人力成本。在数据驱动下的政策文本研究中,将政策文本转换为结构化的数据,再基于相应的机器学习模型进行计算和分析,这种定量研究的方法极大降低了人力成本,成为政策文本研究的发展趋势[3]。当前,政策定量化研究的内涵越来越丰富,涌现出政策文本计算、政策计量、政策文献计量等研究方向[4-7]。政策文本计算主要通过自然语言处理、机器学习、可视化技术等进行政策文本分析,其中在机器学习方面,比较受关注的是深度学习领域的预训练语言模型技术。2003年,Bengio等[8]提出NNLM模型(neural network lan‐guage model),神经网络技术开始被用于语言模型的构建。在此基础上,word2vec[9]、GloVe[10]模型进一步优化性能,静态词向量的诞生使神经网络方法大规模应用于自然语言处理成为可能。随着深度学习的发展,CNN(convolutional neural network)、RNN(recurrent neural network)和LSTM(long short-term memory)等神经网络模型诞生[11-13]。2018年,Google基于Transformer编码器提出了BERT(bidirectional encoder representations from transform‐ers)模型[14],其在预训练方法上的创新推动了预训练模型的发展。在BERT模型的基础上,Facebook AI团队推出了RoBERTa[15]模型。由于其突出的性能,BERT与RoBERTa模型被广泛应用于自然语言处理研究,提高了自然语言处理理解和文本挖掘研究的整体水平。随着深度学习技术的不断发展,政策文本研究与深度学习的关联也愈发密切。已有学者通过具体探究验证了深度学习技术和预训练模型对政策文本研究的推动作用[16-18]。

目前,针对政策全文本数据的预训练模型构建尚处于起步阶段,为了提升政策文本领域知识挖掘的整体性能,本研究通过爬取259个政府官方网站的政策文本构建了较为完备的中文政策全文本数据集,在数据集上继续预训练获得了关于中文政策文本的预训练模型,弥补了在中文政策文本研究上预训练模型的缺失,且在3个自然语言处理的下游任务上模型的性能得到了验证。

1 研究回顾

在大数据时代,对海量的政策文本进行深度挖掘和利用成为一个亟待解决的重要问题。通过对已有政策研究的梳理可以发现,政策文本方面的研究已从定性分析逐渐转移到定量分析。政策文本量化通过一系列的转换范式将非结构化政策文本转换为抽象化、特征化的计算机可处理的结构化数据[19]。近年来,在数据驱动研究范式的推进下,预训练技术与政策文本相结合逐渐成为政策文本知识挖掘的主流趋势。

政策文本知识挖掘主要通过机器学习挖掘政策文本中所蕴含的知识,实现政策文本的智能化分析,在一定程度上弥补了内容分析法和文献计量方法研究的不足。在传统机器学习和自然语言处理基础上的政策文本知识挖掘代表性研究如下。在对政策文本进行自动分词的基础上,王晶金等[20]借助政策分析工具,对两份科技成果转移转化的部委政策文本进行了分析,针对科技成果转移转化过程中存在的缺陷提出了有效的建议。基于科技政策的功能定位和用语特征,郑新曼等[21]通过PMI(pointwise mutual information)和TextRank算法构建了科技政策文本的程度词典。通过把自然语言处理技术融入政策文本,魏宇等[22]构建了基于语义分析的政策量化模型,借助所挖掘出来的语义知识分析了中央及地方的旅游交通政策的外部属性和内部结构的差异。基于LDA(latent Dirichlet allocation)模型,Du等[23]考察了4种JPCAP(joint prevention and control of atmospheric pollution)政策中政策强度对大气污染物排放的影响,并提出了优化对策和解决问题的建议。通过构建LDA主题模型和k-means聚类模型,Song等[24]识别了食品安全政策中的热点话题,并从4个方面对中国的食品安全政策进行了分析。基于教师队伍建设改革的政策文本,杜燕萍[25]通过LDA主题模型的知识挖掘,提出了有针对性的改革对策。上述自然语言处理和文本挖掘技术能够快速、高效地处理大量的政策文本,在一定程度上弥补了定性方法分析深度不够和效率低的问题。但随着政策文本数据的增加及对深度语义知识挖掘需求的提升,把深度学习特别是预训练模型与政策文本数据结合起来进行知识挖掘,成为获取深层、多维和细颗粒度知识的关键。

神经网络语言模型(neural network language model,NNLM)是最早的词嵌入(word embed‐dings)模型。word2vec模型采用无监督的方式学习语义知识,优化了计算效率,被广泛地应用于工业界。为了弥补word2vec模型难以统计全局信息的不足,GloVe模型进一步利用词共现矩阵,使得词向量充分兼顾到语料库的全局特征,但word2vec和GloVe仍不能解决一词多义性问题。上下文嵌入模型ELMo(embeddings from language models)通过学习单词、句法以及语义特征,实现了根据输入句的上下文语境获得每个词的词嵌入向量。BERT预训练模型采用双向语言模型能够更好地利用上下文的双向信息,同时基于Transformer结构更好地捕捉全局信息。

从预训练模型生成的流程上看,预训练技术一般是在一个基础数据集上进行任务训练,生成一个基础网络,并通过将基础网络学习到的特征进行微调或训练新的任务,进而解决人工智能相应的下游任务。因此,预训练模型只需从共性出发,学习特定任务的特征,不仅节省了大量的时间,而且拥有更好的泛化效果。在这一范式下,基于BERT的相应领域化预训练模型得以构建并应用。围绕自然科学的学术全文本和人文社会科学摘要,在BERT模型的基础上,Beltagy等[26]和Shen等[27]分别训练和构建了SciBERT和SsciBERT模型,并在相应的下游任务上进行了验证,整体上效果较为突出。Lee等[28]在生物医学语料库上对BERT完成了进一步的训练,构建了BioBERT领域化预训练模型,同时在生物医学文本的验证上取得了较好的成绩。在法律文本上,Chalkidis等[29]构建了LEGAL-BERT预训练模型,并在领域任务上验证了所构建模型的性能。在金融文本数据上,Araci[30]提出了一种基于BERT的FinBERT用于处理金融领域的NLP(natural lan‐guage processing)任务,并在具体数据集上验证了FinBERT的效果。杨晨等[31]在BERT的基础上提出一种侧重学习情感特征的预训练方法,所得到的SentiBERT在情感任务上取得了更优的效果。在藏文文本上,李亮[32]构建了藏文ALBERT预训练模型,并在分类任务上对模型进行了验证,效果较为突出。一方面,上述领域化模型的构建为本研究政策文本预训练模型的构建提供了探究视角和方案上的支持;另一方面,为模型具体的训练提供了方法和技术上的支撑。相关学者已将通用预训练模型引入与政策相关的研究当中。Zhang等[33]基于《纽约时报》的大规模新闻语料库对预训练模型进行微调,提出了一个基于BERT的模型用于预测美国的政策变化。朱娜娜等[34]提出了基于预训练语言模型的政策识别方法,在小规模数据上获得了较优的结果。基于预训练语言模型BERT,关海山等[35]在融入规则的基础上,实现了在税收优惠政策法规的表征、关键要素抽取和税收优惠的可视化查询等多个维度上的探究。在政策文本的知识建模与关联问答中,华斌等[36]采用BERT语义相似度计算并完成了对答案的评估。上述研究表明,预训练技术与政策文本研究的融合是大势所趋,一方面,通过预训练技术对政策文本进行挖掘,可以更好地获取政策文本的多维知识;另一方面,通过预训练模型对政策文本进行识别、分析、表示等处理,可以在更大程度上提高政策文本处理的效率。但当前政策文本领域所使用的预训练模型均是通用的预训练模型,缺乏基于大规模政策文本构建的政策文本预训练模型,本研究对此进行了探究。

2 研究方法

本研究由模型的预训练和模型的性能验证两个部分构成。在预训练阶段,利用掩码语言模型(masked language model,MLM)和全词掩码(whole word masking,WWM)任务分别基于BERT-base-Chinese和Chinese-RoBERTa-wwm-ext模型对政策全文本数据集进行预训练,模型初步评价的指标为困惑度。在模型的性能验证阶段,通过对比预训练语言模型和基准模型在自动分词、词性标注和命名实体识别上的效果来评判政策文本预训练模型的性能。

2.1 研究框架

目前,采用领域数据构建预训练模型的研究通常分为模型的预训练和模型的性能验证两大部分。

在模型的预训练阶段中,实验步骤设计的整体性呈现如图1所示。

图1 模型预训练实验步骤

(1)数据获取与预处理。首先,进行系统而全面的调研,确定政策数据源的网站;其次,通过开发Python爬虫工具,获取全国及各省市的政策文本数据,进行数据清洗,同时将政策文本的标题与全文作为预训练数据的基本单元;最后,将所有基本单元合并,并将数据按99∶1划分为训练数据集和验证数据集。

(2)模型预训练。基准模型使用Huggingface网站(https://github.com/sinovation/ZEN)提供的Py‐torch版BERT-base-Chinese和Chinese-RoBERTawwm-ext,并设定训练集任务为MLM和WWM。

(3)预训练模型性能初步测评。在信息论中,困惑度(perplexity)[37]被用于度量一个概率分布或概率模型预测样本的好坏程度。在语言模型评测中,困惑度被定义为测试集概率的倒数,一般认为困惑度较低时语言模型性能较好。因此,本研究将其作为初步评价预训练模型性能指标。

2.2 数据源

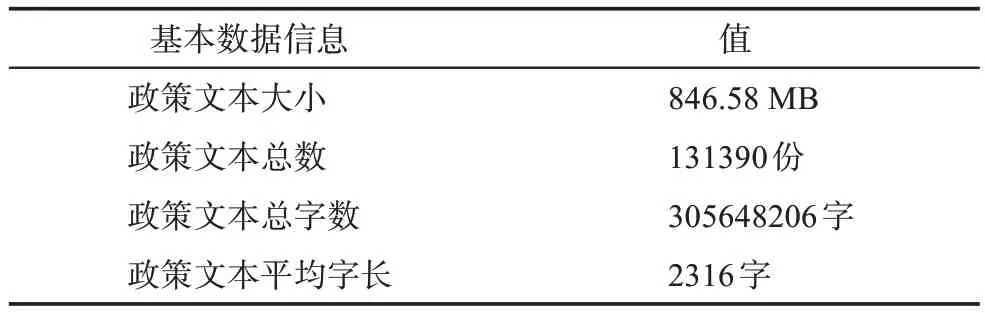

本研究中预训练模型构建所使用的政策文本数据来自全国及省市的政策发布平台,具体包括国家发展和改革委员会、财政部、科学技术部和工业和信息化部,北京、天津、河北等省和直辖市的中小企业公共服务平台、发改委、财政厅、科技厅、工业和信息化厅,以及深圳、广州、苏州等经济发展前沿城市的中小企业公共服务平台、发改委、财政局、科技局、工业和信息化局。政策文本按照政策发布平台划分为国家级政策文本、省级政策文本与市级政策文本。国家级政策主要着重于宏观层面、面向全国,且在法律效力上高于省级政策和市级政策,而省级政策和市级政策则根据地方经济社会发展制定,侧重点有所不同。在出现政策内容相矛盾时,市级政策一般服从省级政策,省级政策一般服从国家级政策。不同平台所发布的政策在内容上也存在差异,发改委拟定经济和社会发展政策,财政部(厅、局)发布财税政策,科技部(厅、局)发布科技创新政策,工信部(厅、局)发布产业政策,中小企业公共服务平台发布针对中小企业发展的政策方针。基于所设计的网络爬虫共获取到145043份政策文本,经过剔除明显非政策文本的政策新闻、政策解释等内容,最后得到131390份政策全文本,总字数为305648206,政策文本具体的分布情况如表1所示。为了确保所获取数据的全面性,在获取国家级数据的基础上,也获取了省级的政策数据,但部分省级数据公开度有待提高,所以,在具体获取到的数据量上各个省份存在差异,具体如表2所示。

表1 数据基本信息表

表2 政策文本发布机构分布表

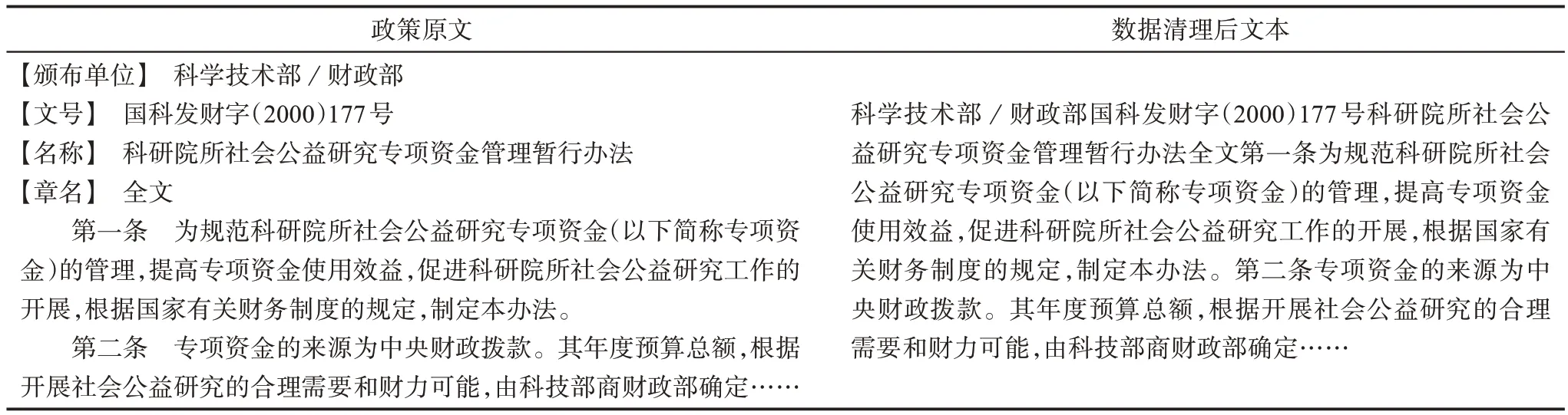

2.3 数据预处理

通过对抓取数据的分析,本研究发现少量数据存在非法字符、字符中夹带内容标签(如【一图读懂】【问答解读】等)以及文本中存在大量空白、换行等问题。对于上述数据存在的问题,本研究的具体操作和处理如下:针对数据中存在的非法字符,搜集所有非法字符的类别,替换去除;对于字符中夹带的内容标签,将标签连同内容一并去除;对于文本中存在大量空白、换行的问题,遍历文本内容替换去除;对于存在大量html标签的文本,观察发现该类文本通常存在内容缺失,利用Python正则表达式甄别出该类数据并剔除。数据预处理示例如表3所示。

表3 数据预处理示例

2.4 基线模型选取

当前,预训练技术已成为自然语言处理领域的标志性技术,并且极大地提升了自然语言处理任务的性能。面对不同的任务,通过微调已有基础预训练模型而不是从头训练已经成为一种共识。通过迁移预训练模型并进行微调,可有效地从大量标记以及未标记的数据中获取领域特征知识。针对中文政策文本,本研究以BERT-base-Chinese和Chinese-Ro‐BERTa-wwm-ext两个中文预训练模型为基线,基于MLM和WWM任务进行预训练,得到了被命名为ChpoBERT-mlm、ChpoRoBERTa-mlm、ChpoBERT-wwm和ChpoRoBERTa-wwm的中文政策预训练模型,其中Chpo为Chinese policy的简称,同时ChpoBERT系列模型全部在Github进行了开源,链接为https://github.com/S-T-Full-Text-Knowledge-Min‐ing/ChpoBERT。

(1)BERT-base-Chinese

BERT是2018年由Google AI研究院发布的一种预训练模型,在自然语言处理的各项下游任务上取得了优异的成绩,成为自然语言处理发展史上的一个里程碑。BERT设计了两个任务:一个是MLM,它用15%的概率随机地对训练序列中的token用mask token([MASK])进行替换,然后预测[MASK]处原有的单词;另一个是NSP(next sen‐tence prediction),用于预测两个句子是否连在一起。在BERT的基础上,谷歌还发布了一个多语言版本BERT-base-multilingual和一个中文版本BERT-base-Chinese。在继续预训练阶段使用中文语料数据的情形下,BERT-base-Chinese通常会有更好的效果。在文本内容上,政策文本有其独特的语言表述方式,例如,政策文本中会大量出现“请”“经”“为”“各”等单字词,且政策文本的行文逻辑较强,政策文本数据的这两个特点正好对应了BERT-base-Chinese的两个任务。

(2)RoBERTa-wwm

在BERT基础上的改进版RoBERTa模型能支持更大的模型参数量、更大的batch size(批处理量)、更多的训练数据。WWM与MLM的区别在于当一个词的部分被MASK之后,整个词都会被MASK。这是专门针对像中文这种语言文本而设计的任务,因为在处理中文语料时,MLM只能MASK独立的文本,而WWM会将被MASK的字的整个词全部MASK。中文政策文本中除了大量出现的单字词外,也存在中文政策文本特有的多字词,如“关于”“根据”“务必”“通知”“批准”等,而WWM在处理多字词方面有着更为突出的性能。针对同一个基准模型,利用MLM和WWM任务对语料库进行预训练,对比不同任务下预训练模型的性能更有助于把握语料文本的特性及更合适的继续预训练方式。

(3)ERNIE-Gram-zh

ERNIE(enhanced representation through knowl‐edge integration)是百度基于飞桨平台研发的语义理解框架,其基于BERT模型做了进一步优化,并且在中文的NLP任务上达到了较为突出的性能。ERNIE-Gram模型更进一步地提出显示、完备的ngram掩码语言模型,以实现显示的n-gram语义单元知识建模。在语义理解能力上,ERNIE-Gram可以实现同时学习细粒度和粗粒度语义信息,能在预训练过程中实现单一位置多语义粒度层次预测和显示的语义信号学习,并在中文任务的NLI、阅读理解等语义理解任务上取得了较好的成绩。针对前两种模型基于token的掩码方式,本研究增加了ERNIEGram-zh进行对照,以进一步验证所预训练的中文政策文本模型的性能。

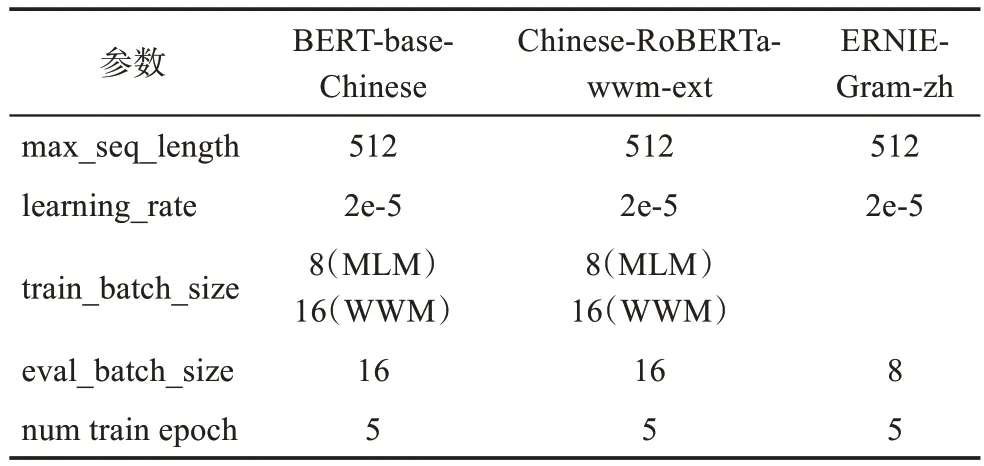

2.5 实验环境与参数

训练语料文本的每一行都包括两列,分别是标题和内容。本研究对国家级和省市级的文本内容平均字数进行了统计,绝大多数政策文本的内容远远大于512个字,所以在实验前设置最大序列长度为512的基础上去除了line by line参数,将单个文本内容混合多行处理,而不是每超过512个字符就另外算作一个文本内容。基于所获取预训练政策文本的整体规模,为了取得较好的预训练学习效果,本研究将初始学习率设置为2e-5,进行5轮训练,根据服务器配置和模型限制,将train_batch_size设置为8和16。基于所获取预训练政策文本的整体数据规模和神经网络模型在训练过程中所需的整体算力,本研究采用高性能NVIDIA Tesla P40处理器来完成实验。计算机配置如下:操作系统为CentOS 3.10.0;CPU为48颗Intel(R) Xeon(R) CPU E5-2650 v4 @ 2.20GHz;内存256GB;GPU为2块NVIDIA Tesla P40;显存24GB。模型预训练参数值如表4所示。

表4 预训练模型参数设置

2.6 预训练模型的评价指标

本研究采用困惑度(perplexity)初步评价预训练模型的性能。在信息论中,perplexity被用于度量一个概率分布或概率模型预测样本的好坏程度,被应用到自然语言处理中,则可用于衡量语言概率模型的优劣。相较于其他衡量方式,使用perplexity来度量更加直观,在perplexity值相差较大的情况下,perplexity值越低,模型性能越好。具体计算公式为

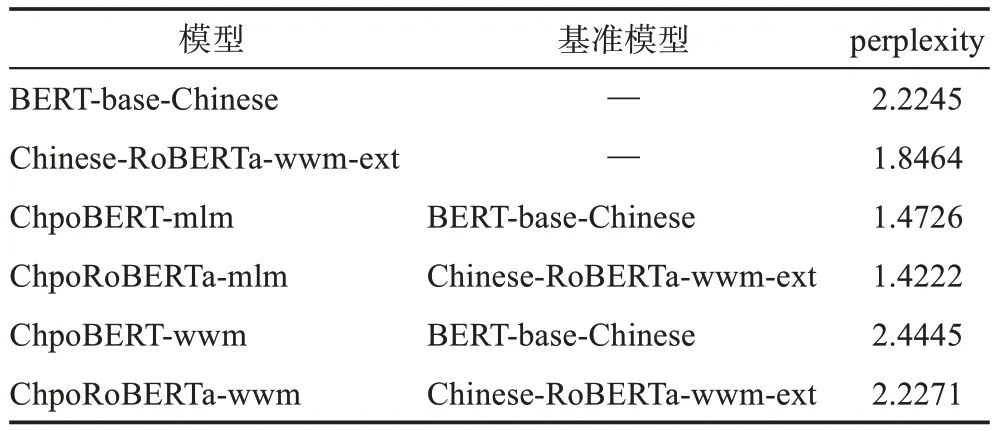

其中,S表示句子;N表示句子长度;p(wi)是第i个词的概率,而第一个词的概率为p(w1|w0),w0是占位符,表示句子的起始。以sentence=“国务院关于同意在全面深化服务贸易创新发展试点地区暂时调整实施有关行政法规和国务院文件规定的批复国函”为例,p(w1|w0)表示sentence这句话以“国”字开头的概率,同理p(w2|w1)表示该句在第一个字为“国”的条件下,第二个字为“务”的概率,由公式(1)可知,预测效果越好,则p的概率越大,per‐plexity值越小。本研究进行了MLM和WWM两个任务在两个模型上的预训练实验,所得语言模型perplexity值如表5所示。

表5 预训练模型perplexity值

由表5可知,预训练模型和基准模型的perplex‐ity差值并不显著。一般来说,perplexity值越小,模型越好。其中,ChpoBERT-mlm的perplexity小于基准模型,而ChpoBERT-wwm的perplexity值大于基准模型,初步判断ChpoBERT-mlm的性能优于ChpoB‐ERT-wwm。同样地,ChpoRoBERTa-mlm的perplexi‐ty值小于基准模型,ChpoRoBERTa-wwm的perplexi‐ty大于基准模型,初步判断ChpoRoBERTa-mlm的性能优于ChpoRoBERTa-wwm。在微调阶段,初步认为ChpoBERT-mlm和ChpoRoBERTa-mlm的效果要优于基准模型,而ChpoBERT-wwm和ChpoRoBERTawwm的效果要逊于基准模型。

3 预训练模型性能验证

困惑度能够在某种程度上反映预训练模型的效果,但为了进一步判断预训练模型是否能够更好地完成自然语言处理的相应任务,仍需对其进行更进一步的性能验证实验。结合所筛选、整理和加工的语料数据,本研究设计了自动分词、自动词性标注和实体识别3个验证实验。

3.1 验证数据

(1)自动分词语料数据

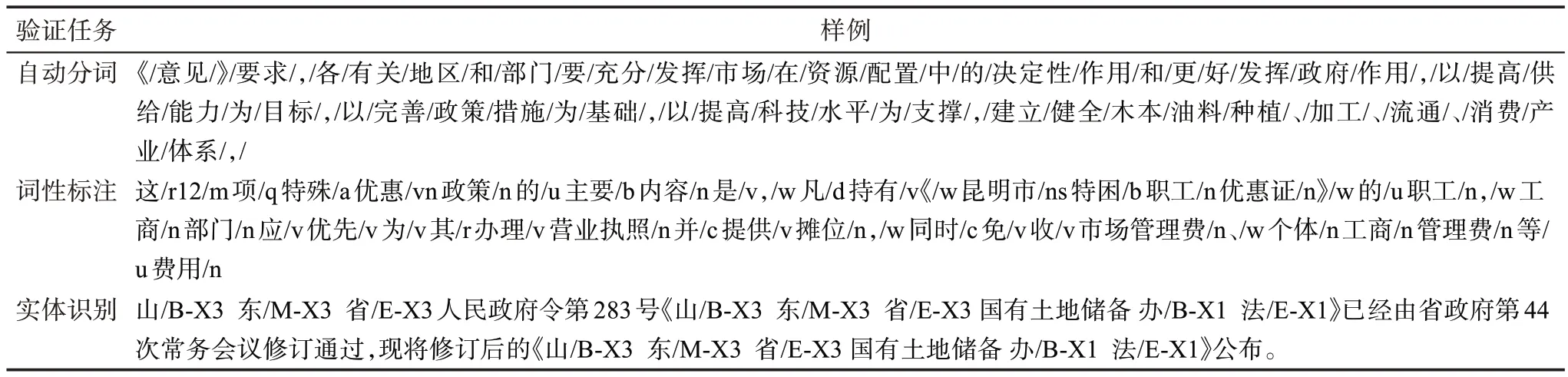

自动分词验证语料数据集来源于南京农业大学新时代人民日报分词语料库(http://corpus.njau.edu.cn/)[38],该语料库由黄水清等基于2015年至2018年之间共9个月的《人民日报》数据构建而成,在多项测评上,比北京大学计算语言研究所构建的1988年人民日报分词语料性能表现更为突出。基于该语料库,经过人工多次和反复的筛选,从中选取与政策相关的文本共374篇,总字数为78311字,并按照9∶1划分训练集和测试集。所选出来的验证数据集完成了人工的分词精加工,可以支撑对所构建的预训练模型在自动分词任务上的验证,具体的分词的政策文本样例如表6所示。

表6 验证数据样例

(2)自动词性标注语料数据

自动词性标注验证数据集来源于经过词性标注的北京大学人民日报语料,该语料由北京大学计算语言学研究所俞士汶等[39]基于《人民日报》1998年的纯文本语料构建,是我国第一个大型的现代汉语词性标注语料库。基于词性标注语料库,在人工精筛选的基础上,获取了445篇有关政策的语料文本,共计112028字。该语料以词为单位切分并标注了词性,按照9∶1划分训练集和测试集。选出来的语料经过人工词性标注,在汉语自然语言处理领域具有权威性和标志性。具体的词性标注的语料样例如表6所示。

(3)实体识别语料数据

基于所获取的政策文本,本研究选取了982篇用于标注实体,其中682篇为科技政策文本(共计902048字),300篇为其他领域的政策文本(共计1016346字),按照9∶1划分训练集和测试集。在制定的实体标注规范的基础上,基于“BIOES”标注集完成对所获取政策文本中实体的人工标注,从而构建中文政策预训练模型的验证数据集。数据集中所标注的实体共有4类,分别为政策性质、政策时间、适用区域和政策领域,具体的标注实体样例如表6所示。

3.2 验证指标及模型参数

本研究的预训练模型验证将结合混淆矩阵,对于词汇的分词、词性的标注和实体的识别性能使用精确率P(precision)、召回率R(recall)、F1值(F1-score)指标进行评价。对于总体分词、标注和识别性能,使用宏平均(macro-avg)和加权平均(weighted-avg)中的P、R、F1-score指标进行评价,混淆矩阵表如表7所示。具体计算公式为

表7 混淆矩阵表

同时,宏平均为所有类别的指标值的算数平均值,即宏精确率、宏召回率和宏F1值,具体计算公式为

同理,加权平均将样本数量占样本总数比例作为计算平均值的权重,指标为加权精确率、加权召回率和加权F1值,具体计算公式为

在自动分词、词性标注和实体识别的参数设置上,本研究将训练阶段的batch size和测试阶段的batch size均设为32,最大句长设为256,共训练3轮。为避免模型在训练初期因学习率过大而造成训练误差加大,设置warmup_propotion为0.4。此外,本研究针对不同的下游任务测试了不同的学习率,使模型在下游任务中均获得了较好的表现。

3.3 验证结果分析

(1)词汇分词结果

分词是自然语言处理领域的基础任务,对政策文本的精确分词是挖掘政策文本知识内涵的基础。由表8可知,ChpoBERT系列模型在分词任务上的表现相较于基准模型上均有一定程度的提升,除ChpoRoBERTa-wwm在分词的召回率上略低于基准模型Chinese-RoBERTa-wwm-ext外,ChopBERT系列模型在全部3项指标上均超越了基准模型。在所有模型中,ChpoBERT-wwm在分词任务上的准确率、召回率和调和平均值上表现均为最佳,分别为97.27%、97.60%和97.43%。ERNIE模型在7个模型中表现最差,分词的准确率、召回率和调和值均低于其他模型。在分词验证任务中,原始BERT模型在准确率、召回率和调和平均值上均优于原始Ro‐BERTa模型,而基于MLM和WWM任务继续预训练的ChpoBERT-mlm和ChpoBERT-wwm在准确率、召回率和调和平均值上的表现也均优于ChpoRo‐BERTa-mlm和ChpoRoBERTa-wwm。政策文本分词验证的结果如表8所示。

表8 政策文本分词结果

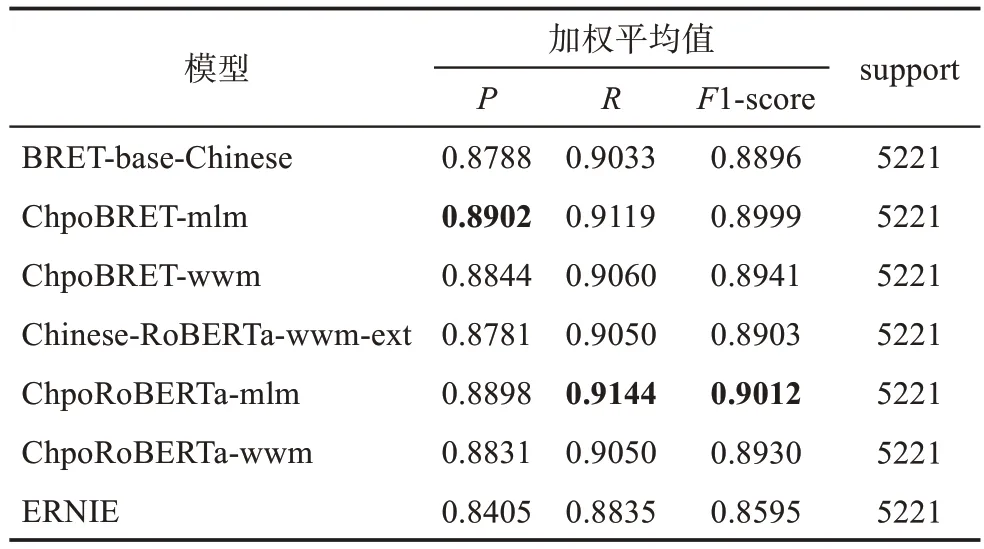

(2)词性标注结果

词性标注是自然语言处理的基础模块,是句法分析、信息抽取等工作的基础。语料中不同词性的词在数量上存在较大差异,导致整体宏平均值较低,因此,只以准确率、召回率、调和平均值的加权平均值作为词性标注任务的评价指标。由表9可知,ChpoBERT系列模型在全部3项指标上均超越了基准模型,其中ChpoBRET-mlm在准确率上的加权平均值上表现最优,达到89.02%,比基准模型提升了1.14个百分点,ChpoRoBERTa-mlm在召回率与调和平均值上的加权平均值表现最优,分别为91.44%、90.12%,比基准模型提升了0.94个和1.09个百分点。ERNIE表现最差,与其他模型存在较大差距,准确率、召回率与调和平均值的加权平均值分别为84.05%、88.35%和85.95%。此外,Chpo‐BRET-mlm在词性标注任务上的表现优于Chpo‐BRET-wwm,ChpoRoBERTa-mlm在词性标注任务上的表现同样也优于ChpoRoBERTa-wwm。基于预训练模型的词性标注结果比较如表9所示。

表9 基于预训练模型的词性标注识别结果比较

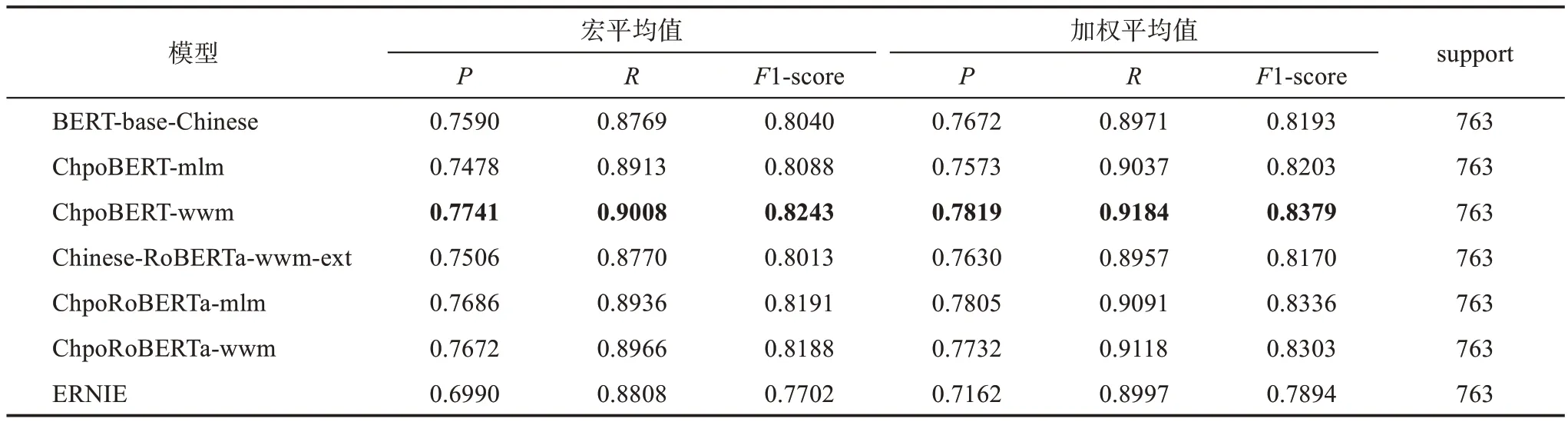

(3)实体识别结果

实体识别作为自然语言处理的基础任务,能够为信息检索、关系抽取、知识问答系统等提供有效的实体知识支撑。为了进一步确认预训练模型的性能,本研究在政策文本预训练模型以及基准模型上,使用验证数据集进行实体识别任务以进行比对,具体结果如表10所示。

表10 实体识别结果验证

从实验结果可以看出,ChpoBERT系列模型在实体识别效果上均高于其他3种模型。在宏平均上,ChpoBERT-wwm在准确率、召回率和F1值上表现最优,分别为77.41%、90.08%和82.43%,分别比基准模型BERT-base-Chinese提升了1.51个、2.39个和2.03个百分点。ChpoRoBERTa-mlm和ChpoRoBERTa-wwm在准确率、召回率和F1值上均优于基准模型,与基准模型Chinese-RoBERTa-wwmext相比,ChpoRoBERTa-mlm在3项指标上分别提升了1.80个、1.66个和1.78个百分点,ChpoRoBERTawwm在3项指标上分别提升了1.66个、1.96个和1.75个百分点。ERNIE在所有模型中表现最差,准确率、召回率和F1值分别为69.90%、88.08%和77.02%。

在加权平均上,ChpoBERT-wwm在准确率、召回率和F1值上表现最优,分别为78.19%、91.84%和83.79%,比基准模型提升了1.47个、2.13个和1.86个百分点。ChpoRoBERTa-mlm和ChpoRoBERTa-wwm在准确率、召回率和F1值相较于基准模型Chinese-RoBERTa-wwm-ext均有一定的提升,ChpoRoBERTamlm在准确率、召回率和F1值上分别提升了1.75个、1.34个和1.66个百分点,ChpoRoBERTa-wwm在准确率、召回率和F1值上分别提升了1.02个、1.61个和1.33个百分点。ERNIE在所有模型中表现最差,准确率、召回率和F1值分别为71.62%、89.97%和78.94%。

4 讨 论

首先,以BERT-base-Chinese和Chinese-RoBERTawwm-ext两个中文预训练模型为基准模型,结合海量中文政策文本所构建的ChpoBERT系列模型在困惑度上相较于基准模型,最优的模型低了0.7924,表现出了较优的性能。在自动分词、词性标注和实体识别的自然语言处理下游任务上,政策文本预训练模型也表现得较为突出。上述性能判定和验证实验结果表明,在政策文本的这一领域化数据上所构建的预训练模型具有较强的应用性。一方面,从人工智能大语言模型的角度,所构建的预训练模型成为政策文本知识挖掘的基础模型支撑资源,在一定程度上确保了政策文本领域展开领域化信息智能处理的可能性;另一方面,所构建的预训练模型可以直接应用于中文政策文本的自动分词、词性标注、实体识别、关键词抽取和语义标注等自然语言处理的基础任务,同时也可以支撑政策文本的自动分类、自动聚类、智能信息检索、智能知识推送和智能评估等应用性探究。

其次,面向259个国家级、省级和市级等目标网站,所获取的3亿多字的中文政策文本不仅为相关研究者展开数据驱动下的政策全文本计量、内容分析和文体风格等的研究提供了有力的数据支撑,而且为构建中文政策预训练模型奠定了坚实的数据基础。但目前所获取的政策文本数据存在两个方面的问题,一方面,目前通过网站所获取的国家级、省级和市级政策文本是不全面的,并且缺乏对过去政策文本的搜集;另一方面,目前没有获取县级以下的政策文本。上述数据缺失的问题导致了预训练模型的整体性能有待提升,这是因为在预训练模型构建过程中数据量是基础和关键。通过各种渠道和方法增加政策文本数据的总量是未来进一步提升政策预训练模型性能所需要重点强化的任务。

最后,通过选取精加工的经过分词和词性标注的政策文本和精标注政策文本中的实体,本研究构建了自动分词、词性标注和实体识别的数据集,并设计了相对应的政策文本预训练模型的3个验证实验。从验证结果来看,所构建的预训练模型整体性能较为突出,这也说明了所构建模型的领域适应性和构建领域预训练模型的必要性。但由于目前没有公开的与政策文本相关的精加工数据集,本研究在有限的时间和人力基础上所搜集和加工的验证数据集存在数据规模小、精标注浅和覆盖面窄等问题。上述问题在一定程度上影响了验证所构建政策预训练模型性能的完整性、精准性和全面性。在未来的研究中,扩大、拓展和增强验证数据集的规模、深度和广度是构建政策预训练模型必须要完善的工作。

5 结 论

近年来,政策文本的智能信息处理是信息科学领域的研究热点之一。基于中文政策全文本语料库,本研究构建了中文政策文本的预训练模型,一方面,通过困惑度指标对所构建预训练模型进行了初步的性能判定;另一方面,通过对比预训练语言模型和基准模型在下游任务上的性能进一步验证所构建预训练模型的性能。研究结果表明,政策文本的预训练模型在自动分词、词性标注、实体识别上相较于基准模型取得了较优的效果。诚然,本研究也存在不足之处,一方面,政策文本的数据量有待于扩大,特别是非网上的数据;另一方面,验证集的数量、类别和加工的精细度均有待于完善。因此,通过扩大政策文本的规模训练性能更加突出的预训练模型,同时结合不同主题的政策文本细化预训练模型是未来需要探究的内容。