基于字词融合和多头注意力的专利实体识别

2023-12-20王腾科朱广丽李瀚臣刘云朵张顺香

王腾科,朱广丽+,李瀚臣,刘云朵,张顺香

(1.安徽理工大学 计算机科学与工程学院,安徽 淮南 232001; 2.合肥综合性国家科学中心 人工智能研究院,安徽 合肥 230088)

0 引 言

中文专利主要由非结构化的文本数据组成,对中文专利文本进行命名实体识别(named entity recognition,NER)研究可以促进专利行业中专利审查[1]、专利检索[2]和专利主题挖掘[3]等相关技术发展,为行业加快信息化和智能化奠定基础[4]。中文专利文本包含大量专业词汇,这些专业词汇语义丰富,信息量大。为了丰富文本特征表示,大多数模型通过修改模型结构来融合词信息,但在融合过程中词内字符和边界字符的位置信息未得到充分利用,难以区分相同字符在词首和词尾的特征差异。

为了利用词信息提高中文专利命名实体识别的准确率,需要考虑以下几点:①如何利用字词位置关系信息优化字词融合,从而丰富文本特征表示;②如何利用字词融合后的文本特征表示来提高专利实体识别准确率。

基于上述考虑,提出一种基于字词融合和多头注意力的专利实体识别模型(CWMA),用于提高中文专利实体识别的准确率。该模型主要通过构建词集来区分词首、词内和词尾3种位置关系,再以拼接的方式融合字词语义,从而丰富文本特征表示;并且借助多头注意力调整权重来捕获上下文的重要信息,增强模型的特征提取能力。

1 研究现状分析

专利实体识别是指从专利文献中识别反映技术特点的命名实体。目前的研究方法可分为基于机器学习的方法和基于深度学习的方法。

1.1 基于机器学习的方法

基于机器学习的方法将NER转化为序列标注任务。陈伟等[5]利用维特比算法识别专利实体,但是随着文本长度的增加,算法复杂度会随之增加。Arora等[6]使用支持向量机(support vector machine,SVM)对不同类型的损失分配权重来提高性能,但是SVM面对大规模数据的处理能力不佳。Xu等[7]结合多特征和CRF对产品评论文本进行半监督学习,CRF[8]不仅能较好地捕获全局上下文信息,而且对大规模数据的处理能力较强。Jang等[9]通过句法结构分析处理专利数据,从名词短语和SAO(subject action object)结构中获得候选实体,并通过中心性指标来评判候选实体的重要性,进而识别专利实体。基于机器学习的方法因依赖特征工程建设而需要消耗大量人力成本。

1.2 基于深度学习的方法

随着神经网络的火热,基于深度学习的方法在NER中广受欢迎。双向门控循环单元BiGRU[10]在NER中常用于处理长距离的上下文信息。An等[11]引入多头注意力来学习文本的全局信息和多层次语义特征,用于增强特征表示的多样性。近年来,在中文命名实体识别(Chinese named entity recognition,CNER)中引入词信息被验证是有效的。面向中文生物专利文本,Saad等[12]发现使用字和词的联合嵌入方法要优于仅使用词嵌入的方法。Zhang等[13]利用Lattice结构将词信息嵌入到字符嵌入向量中,但将模型输入从链式序列转化为图结构的方法,会增加模型的计算成本。Liu等[14]在Latticce基础上,将词信息编码成一个固定大小的向量,优化模型的计算复杂度,在Resume数据集上的准确率达到了95.27%。罗艺雄等[15]融合字符、拼音、五笔等特征,在自建新能源领域专利数据集上的准确率达到了90.58%。

从上述研究中发现,字词融合在CNER中能取得较好的成果,但是在面向专利文本时,准确率显著下降。本文通过依据字词之间的位置关系来优化字词融合过程,用于丰富文本特征表示,并利用多头注意力增强字符之间的依赖关系,从而提高专利实体识别的准确率。

2 基于位置关系的字词融合方法

2.1 字向量表示

(1)

2.2 词向量表示

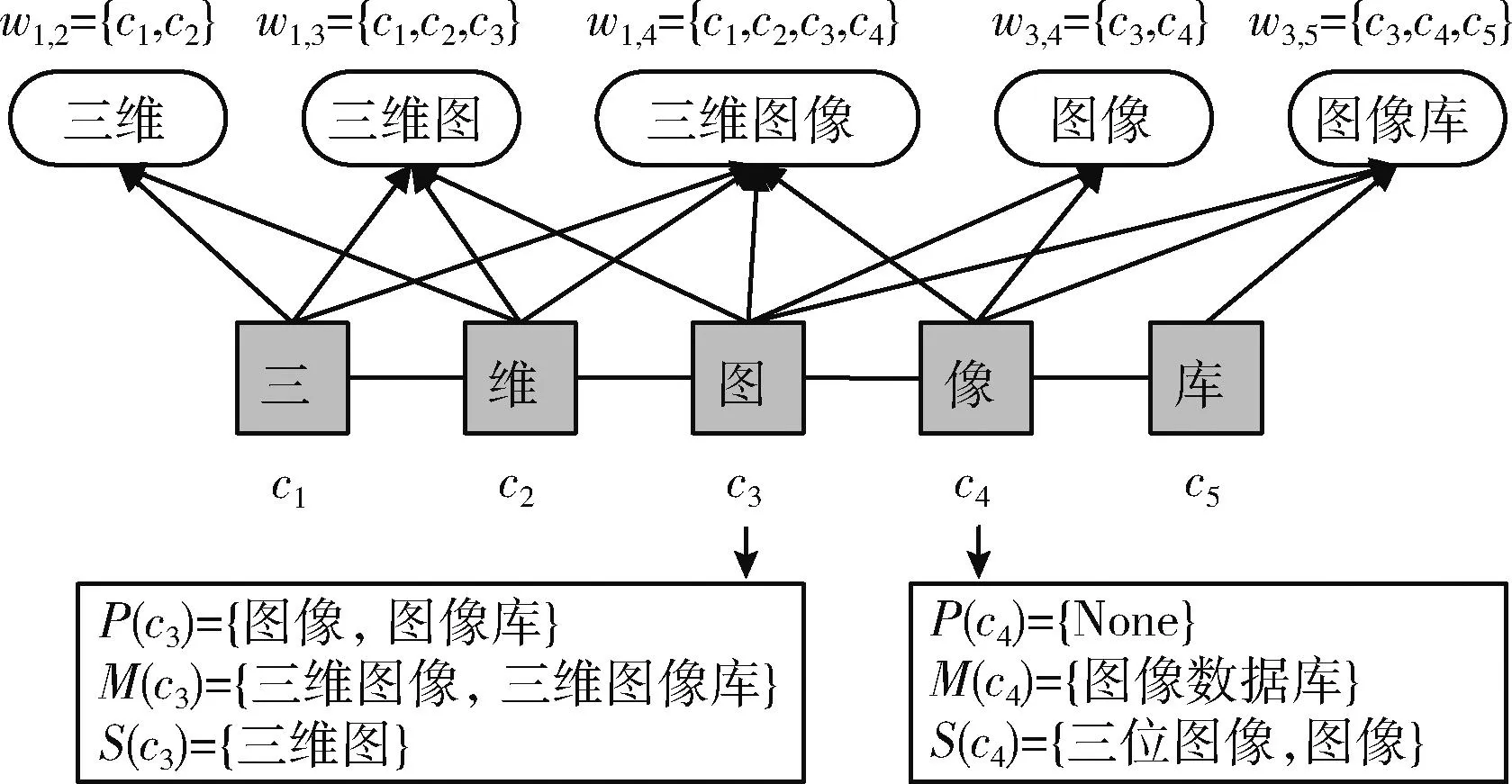

基于字符在词中位置,为字符构造词首、词内、词尾3种词集,将包含该字符的潜在词划分到不同词集,用于表示同一个字符在不同位置所表达的语义信息。词集的构建如图1所示。

图1 词集构建方法

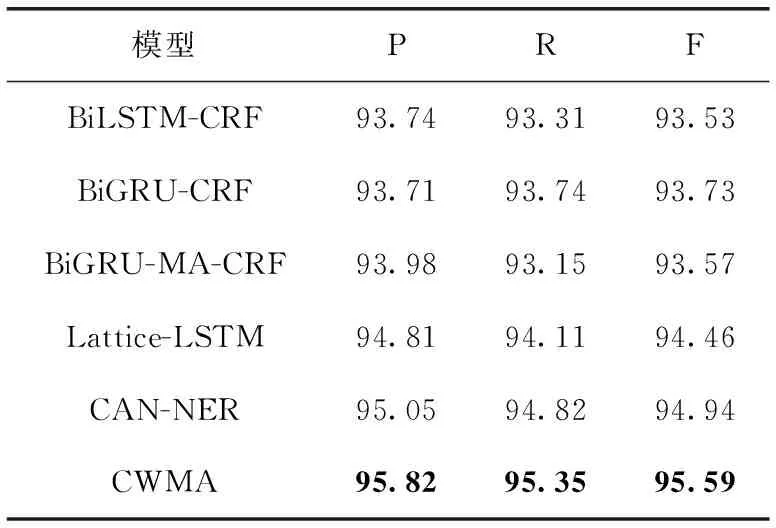

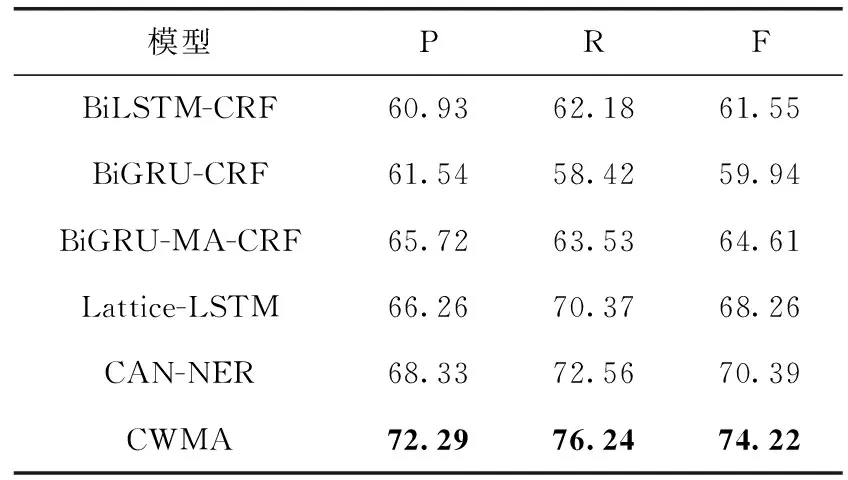

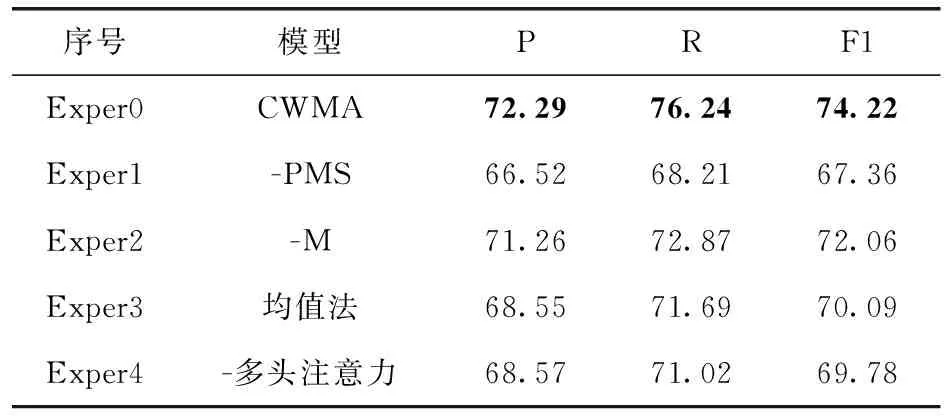

定义1 词首、词内和词尾3种词集。设P(ci) 表示以字符ci为开头的词wi,j集合,即词首词集;M(ck) 表示字符ck在其内部的词wi,j集合(其中i P(ci)={wi,k,∀wi,k∈L,i (2) M(ci)={wi,k,∀wi,k∈L,1≤j (3) S(ci)={wj,i,∀wj,i∈L,1≤j (4) 其中,L表示词典,该词典是在CTB(Chinese Treebank 6.0)语料库上训练得到的。如果词集为空,即无匹配词,则会在词集中添加特殊词“None”。 定义2 加权求和方法。加权求和法依据词的频率来调整权重,对词集内的词进行加权求和。设z(w) 表示词w在数据样本中的频率。其中Z表示字符的3种词集中所有词频的总和,如式(5)所示,其中P、M和S是与字符ci相关的3种词集的简写 (5) 设v(S) 表示词集S的词向量,词集S的加权求和过程如式(6)所示,其中ew(w) 表示由Word2Vec训练得到的词向量 (6) 基于位置关系的字词融合方法先构建词集,随后将词集编码成固定大小的词向量,再与字向量进行拼接融合得到嵌入向量,其过程如图2所示。 图2 基于位置关系的字词融合方法 首先,构造当前字符ci的词集P(ci)、M(ci) 和S(ci), 依据字符在词中位置,将词分配到对应词集。基于Word2Vec技术得到词向量,依据词频对词集内所有词向量进行加权求和,将词集的词信息压缩到一个固定维度的词向量内,获得v(P)、v(M) 和v(S)。 最终将3种词向量拼接后得到与当前字符相关的词向量v(ci), 如式(7)所示 v(ci)=[v(P);v(M);v(S)] (7) 最后,把字符的词向量拼接在字符的字向量之后得到嵌入向量xi,如式(8)所示 (8) 算法1:融合字词信息的文本特征表示算法。 输入:输入的文本字符序列C={c1,c2,…,cn}, 数据集dataset; 输出:嵌入向量序列X={x1,x2,…,xn}; (2)forcinC (3) build word sets (P(c),M(c),S(c)) (4)end for (5)forcinC (6)xc=BERT(c) (7)v(P),v(M),v(S) = WeightedSum(P(c),M(c),S(c),Dict) (8)x=concatenate(v(P);v(M);v(S);v(c)) (9)end for (10)returnX={x1,x2,…,xn} 算法说明:算法1依据字词位置关系,融合字词获得嵌入向量,作为文本特征表示。首先,步骤(1)是基于数据集文本统计词频;步骤(2)~步骤(4)是为每一个字符c构建3种词集P(c),M(c),S(c); 步骤(5)~步骤(9)是由预训练模型获取每一个字符的字向量xc和词集向量v(c), 具体方法如式(1)和式(6)所示,步骤(8)是通过拼接融合字词语义信息,最后步骤(10)返回嵌入向量序列作为文本特征表示X。 假设输入序列的长度为n,构建词集的过程需要遍历输入序列,时间复杂度为O(n);获取字向量和词向量时间复杂度都为O(n)。综上所述,算法总体复杂度为O(n)。 CWMA模型的如图3所示,整体结构自下而上分为4部分:①文本特征表示,通过基于位置关系的字词融合方法得到文本特征向量;②上下文信息提取,利用BiGRU编码器从文本特征向量中获取上下文信息;③多头注意力,利用多头注意力调整上下文信息的权重来增强字符之间的依赖关系;④标签解码,依据相邻标签之间的制约关系对输出进行解码并生成实体标签。 专利文本的语句长度较长,使用传统循环神经网络RNN会出现梯度爆炸和梯度消失的问题。GRU凭借门控结构可以过滤传输信息,极大缓解这类问题。对于给定输入嵌入向量X={x1,x2,…,xn}, 每个时刻t中各单元的隐藏状态ht计算如式(9)~式(12)所示 zt=σ(Wz[ht-1,xt]) (9) rt=σ(Wr[ht-1,xt]) (10) hct=tanh(Wh[rtht-1,xt]) (11) (12) 其中,zt和rt分别是t时刻更新门和重置门的状态;hct为t时刻候选隐藏层的状态;ht为t时刻隐藏层的状态;Wz、Wr、Wh为状态更新时的权重矩阵。 面向专利文本时,采用BiGRU实现前后文的交互,使模型能捕获序列中每个字符对于当前字符的关联语义。BiGRU通过构造正反两个方向的GRU隐藏层,得到隐藏信息输出ht如式(13)~式(15)所示 (13) (14) (15) 虽然通过BiGRU编码器可以获取语句中上下文信息,但是无法突出上下文的关键信息。上下文中不同的字符对当前字符的关联依赖程度是不同的,而BiGRU编码器只能对信息进行保留和删除。本文引入多头注意力来克服BiGRU对上下文信息权重分配单一的问题。注意力机制先通过目标向量Q和上下文信息向量K进行相似度计算得到注意力权重,依据权重来重构原始向量V,得到新向量。计算如式(16)所示,其中Attention(Q,K,V) 是重构后的V向量 (16) 式中:dk是目标向量Q和上下文信息向量K的维度。多头注意力多用于获取文本的多重特征,表示多个字符之间的依赖关系。利用训练后的权重矩阵对Q、K、V进行k次映射,将表示不同特征的结果拼接得到字符的最终特征表示向量b,多头注意力的计算公式如式(17)、式(18)所示 (17) b=Concat(head1,head2,…,headk)WO (18) BiGRU编码器的输出序列H={h1,h2,…,hn}, 经过多头注意力调整权重来增强字符之间的紧密关系后生成序列B={b1,b2,…,bn}。 使用CRF对经BiGRU和多头注意力处理后的编码序列B={b1,b2,…,bn} 进行解码,生成标签序列Y={y1,y2,…,yn} 的概率计算过程如式(19)所示 (19) loss=-log(P(Y|S)) (20) 表1 CCP数据集中各类实体数量 采取准确率P、召回率R和综合评估指标F1作为实验评估标准,如式(21)~式(23)所示 (21) (22) (23) 其中,TP是边界和类别都被预测准确的实体数量;FP是边界或类别被识别错误的实体数量;FN是没有被识别的实体数量。 为了验证模型CWMA的有效性,对以下6种模型在两个数据集上进行对比实验。 ①BiLSTM-CRF:结合BiLSTM和CRF的经典神经网络模型。②BiGRU-CRF:在①的基础上使用BiGRU替换BiLSTM。③BiGRU-MA-CRF:在②中,引入多头注意力在BiGRU和CRF之间,在获得上下文信息后,利用多头注意力用于捕获字符间依赖关系。④Lattice-LSTM[13]:构建Lattice-LSTM神经网络将词信息嵌入到词尾字符中用于丰富文本表示。⑤CAN-NER[16]:使用基于字符的卷积神经网络来捕获语句中潜在词信息,再利用GRU和全局注意力获取全局上下文信息。⑥CWMA:本文提出的模型。 模型的训练环境主要由处理器i5-12400F和显卡NVIDIA GeForce RTX 3060构成,使用的PyTorch版本为1.11.0。在训练过程中,使用bert-base-chinese(https://huggingface.co/bert-base-chinese)生成维度为768的字向量,使用Word2Vec生成维度为40的词集向量。训练的初始学习率设置为0.0015,模型优化采用Adam。 在专利文本的实验中,考虑到摘要文本长度普遍在300字左右的特点,相较于面向Resume数据集的模型输入的最大序列长度250,在面向CCP数据集的实验中设置最大序列长度为350。 实验一:CWMA模型在公共数据集上的有效性验证。6种模型在Resume数据集上的结果见表2。 表2 各模型在Resume数据集上的结果对比 从表2中可以看出,本文提出的CWMA模型表现的性能最优,在准确率、召回率和F1值3个指标上都达到了最优,分别是95.82%、95.35%和95.59%。对比前3个模型的实验结果发现,BiGRU的性能优于BiLSTM,并且引入多头注意力机制能提高模型的性能。其中,后3个模型代表字词融合方法,其模型性能要优于前3个代表字粒度的模型,对于中文命名实体识别,字词融合方法可以为字粒度模型提供更丰富的语义信息,获得更优的性能。同时,在3个字词融合模型中CWMA的实验结果是最优的,在字词融合过程中考虑字与词的位置关系,并依据位置关系训练词集向量,能够更好地表示文本语义。 实验二:CWMA模型在专利数据集上的有效性验证。6种模型在CCP数据集上的结果见表3。 比较表2和表3的实验结果可以发现:面向专利文本的命名实体识别更具有挑战性,相同模型在专利数据集上的3个指标都低于Resume数据集。但是相较于BiGRU-CRF,在专利数据上的CWMA模型准确率提高了11.36%,大于在Resume数据上所提升的2.08%。验证了字词融合方法在专利实体识别的性能提升更显著。这是因为专利中存在大量由多个词组成的复杂实体,例如:“三维图像框架数据库”等,依据位置信息构建词集可以有效地区分不同词对当前字符的影响,从而提高模型的准确率。而相比CAN-NER,CWMA在专利数据上在3个指标上分别提高了3.96%、3.68%和3.83%。总体而言,提出的CWMA模型在实验中表现最好,对专利实体识别提升幅度大。 表3 各模型在CCP数据集上的结果对比 为了研究模型各组成部分的贡献,在CCP数据集上进行消融实验,实验结果如表4和图4所示。 表4 在CCP数据集上的消融实验结果 图4 消融实验结果 本文对字词融合方法的3个步骤以及模型中的多头注意力机制进行消融实验。其中,Exper0表示本文提出的CWMA模型;Exper1的“-PMS”表示在CWMA模型上去除构建词集的步骤,只对词进行加权求和;Exper2的“-M”表示在CWMA模型的嵌入向量中不引入M词集,只融合B和E词集;Exper3的“均值法”表示不引入词频信息,使用均值法取代CWMA模型的加权求和法;Exper4表示在CWMA模型中去除多头注意力模块。 Exper1、Exper2、Exper3分别验证了字词融合方法中的3个步骤都能丰富文本特征表示。其中构建词集的步骤对于模型影响最大,分别下降了5.77%、8.03%和6.86%,在字词融合中考虑字与词之间的位置信息能有效提高模型性能。在对比实验中LatticeLSTM未给词内字符融合相关词信息,而本文引入M词集能够缓解词内字符丢失词信息的问题。同时,加权求和法优于均值法的结果证明依据统计数据中的词频是有效的。 Exper4验证了多头注意力对CWMA模型有着明显的提升。去除多头注意力后,3种指标分别下降了3.72%、5.22%和4.44%,表明使用多头注意力能有效地关注到语句中字符之间的依赖关系。 本文提出的基于字词融合和多头注意力的专利实体识别模型CWMA,依据字符在词中位置信息进行拼接融合字词语义信息,获取了更完整的文本表示特征,并结合BiGRU和多头注意力共同对文本特征进行提取,提高了专利实体识别准确率。实验结果表明,利用字符在词中位置来丰富文本表示和增强字符之间依赖关系对于中文命名实体识别是有必要的。未来工作将考虑在模型中引入自动识别技术词的机制来缓解词典的滞后性问题。2.3 基于位置关系的字词融合

3 基于字词融合和多头注意力的专利实体识别模型

3.1 文本特征表示

3.2 上下文信息提取

3.3 多头注意力

3.4 标签解码

4 实验与结果分析

4.1 数据集和评估标准

4.2 实验方法和模型参数

4.3 对比实验

4.4 消融实验

5 结束语