基于改进DeepSort的行人跟踪方法研究

2023-12-15林志坚陈平平

王 瑞,林志坚,陈平平

(福州大学 物理与信息工程学院,福建 福州 350108)

0 引言

随着物质生活水平的提高,人们开始对个人安全更加关注,行人跟踪可以在不同的摄像头视角或时间段内准确识别和匹配同一个行人,可以准确追踪和识别潜在威胁,有助于提高公共安全和个人安全。研究人员在行人跟踪算法方面致力于提升行人跟踪的准确率,减少行人丢失ID的现象。

近来年,研究人员在DeepSort跟踪算法上进行了大量的研究,赵元龙等人[1]引入速度方向因素,提出一种新的代价矩阵确定方式,优化级联匹配流程,减少目标ID切换。涂书琴等人[2]引入二次交并比匹配,相比较原算法的一次交并比匹配,提升了跟踪的稳定性。何维堃等人[3]引入Haar-like特征匹配,反映目标的明暗变化,优化了匹配机制,增强了目标跟踪的鲁棒性。在DeepSort行人重识别网络中,Kalayeh等人[4]提出通过语义分割提取目标特征网络SP-reid,降低了数据集噪声对模型训练的影响。Sun等人[5]提出了一种新的行人重识别网络PCB,对目标进行局部特征提取,将特征分成多个区域进行提取。黄印等人[6]提出了一种融合局部特征和全局特征的行人重识别网络。贺愉婷等人[7]提出一种GAN网络,对行人重识别网络的训练集进行增强,这些方法有效的提升了行人重识别的准确率。以上文献的优化方法为本文的研究提供了新的思路。

基于此,由于现有的算法和模型对复杂场景的行人跟踪还存在行人在被遮挡后目标ID丢失、跟踪稳定性差的现象。本文采用DeepSort跟踪算法对行人进行跟踪,采用YOLOv5[8]作为行人检测器,对DeepSort中的行人重识别网络进行改进,在原行人重识别网络的基础上,将RGB特征和灰度特征进行迭代深度融合(Iterative Deep Aggregation,IDA)[9],加深了特征提取网络维度。由于改进后的重识别网络可同时输出灰度特征和融合后的特征,在此基础上,计算灰度特征和融合后特征的最小余弦距离矩阵,进行加权处理,提出一种新的余弦距离矩阵计算方式,并通过实验验证方案的可行性。

1 行人跟踪算法方案

1.1 Deepsort行人跟踪算法架构

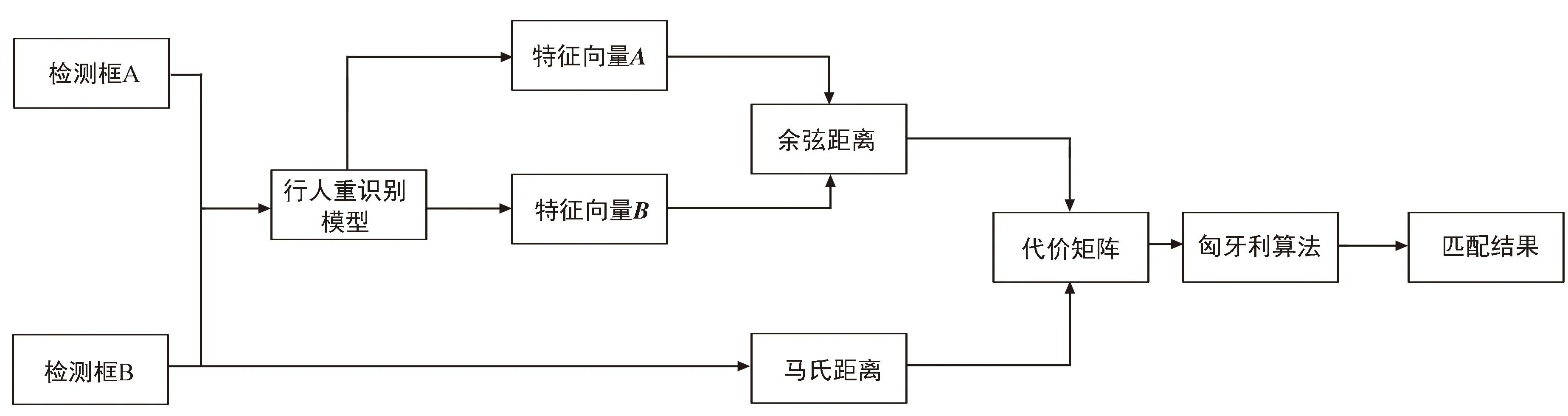

DeepSort[10]是一种基于深度学习的目标跟踪算法,它结合了深度学习和经典的Sort算法,用于在视频序列中进行多目标跟踪。DeepSort在Sort[11]跟踪算法的基础上,引入级联匹配,优化了跟踪性能。DeepSort跟踪算法架构如图1所示。

图1 DeepSort算法流程架构Fig.1 DeepSort algorithm process architecture

主要步骤如下:① 采用YOLOv5检测器检测出图像中的行人,获取到目标检测框;② 将目标检测框与通过上一帧卡尔曼预测的预测框进行级联匹配;③ 将级联匹配中匹配失败的检测框和预测框再进行一次IOU匹配;④ 根据匹配的结果判断检测框和预测框是否符合条件;⑤ 更新目标的状态。

1.2 级联匹配

级联匹配是DeepSort算法的核心部分,其流程如图2所示。

图2 级联匹配流程Fig.2 Cascade matching process

首先根据YOLOv5模型检测出图像中的人物检测框A,通过卡尔曼滤波器[12]对上一帧目标的运动轨迹进行预测,得到预测框B。然后将检测框A和预测框B输入到行人重识别网络,分别提取出行人检测框和预测框的特征向量A和特征向量B。计算出特征向量A和特征向量B之间的最小余弦距离矩阵,最小余弦距离计算公式为:

(1)

式中:τj为第j个检测框中的特征向量,τk为跟踪器中存储的第i个特征向量。之后根据检测框A和检测框B计算出检测框之间的马氏距离(平方)矩阵:

(2)

式中:dj为一个数据点的特征向量,yi为数据集的均值向量,si为数据集的协方差矩阵。根据最小余弦距离矩阵和马氏距离矩阵构建代价矩阵:

c(i,j)=(1-λ)d(1)(i,j)+λd(2)(i,j),

(3)

式中:λ为权重系数。代价矩阵用于表示每个检测到的人物框与预测的目标位置之间的匹配程度。根据代价矩阵通过识匈牙利算法进行最优匹配,从而关联每个检测到的人物框与其对应的预测目标。在级联匹配中,利用行人重别网络提取检测框和预测框的特征尤为重要,更为有效的特征提取可以改善级联匹配的结果,减少目标的匹配误差。传统的DeepSort算法中,提取特征的行人重识别网络为六维残差网络,结构如表1所示,输入图像经过两层卷积后,经过6个残差块,再经过批处理和L2正则化输出128维度的特征向量,简称六维残差网络。

表1 六维残差网络每层输出特征尺寸Tab.1 Output feature size of each layer of the 6-dimensional residual network

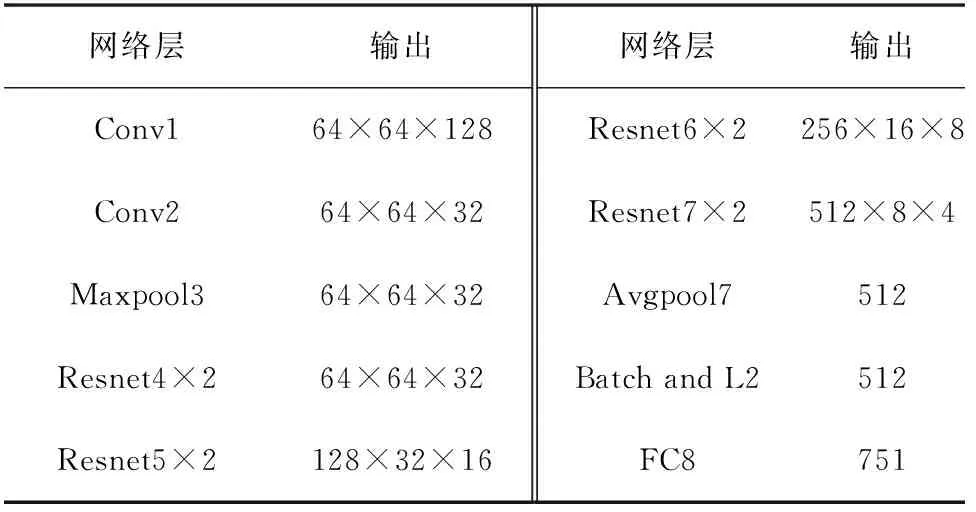

但是由于128维度的特征向量无法提取更深层次的特征,因此广泛用于传统DeepSort算法的重识别网络采用的是八维残差网络,其网络结构如表2所示。在八维残差网络[11]中,输入图像经过两个卷积层一个最大池化层,后面连接8个残差网络,经过平均池化层和批处理及L2正则化后输出512维度的特征向量。

表2 八维残差网络每层输出特征尺寸Tab.2 Output feature size of each layer of the 8-dimensional residual network

1.3 改进行人重识别网络

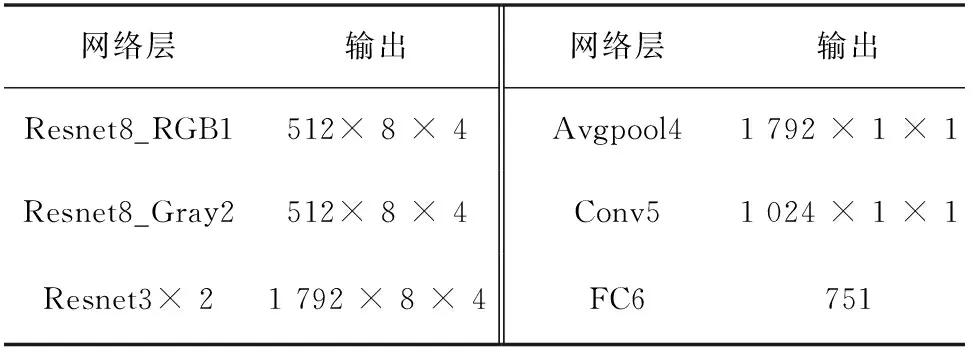

为了更好地提取复杂场景下行人的特征,满足实际行人跟踪的需求,本文在八维残差网络的基础上改进了一种融合灰度特征的网络,网络结构如图2所示。改进的行人重识别网络分为两个分支,首先是RGB图像分支,其主干网络为用于DeepSort算法中的八维残差网络,RGB图像经过八维残差网络,输出512维特征,这里的八维残差网络相对于原始的八维特征提取网络去除了全连接层以及最大池化层,网络的输出为512维特征向量。其次是灰度图像分支,由于灰度图像是单通道图像,所以需要对灰度图像进行通道扩展,将其扩展为3通道的图像,扩展的方式是直接将单通道图像复制成3通道,灰度图像同样经过去除全连接层和最大池化层的八维残差网络,输出512维特征向量。之后将RGB分支残差网络和灰度分支残差网络进行特征融合,得到1 792维度特征,再将1 792维度特征再经过一个两层残差块,避免由于网络加深导致梯度消失的现象,再进行全局自适应均值池化层,之后连接一个1×1卷积层[13]进行降维处理,最后输入到全连接层进行分类处理。

为了更好地展示网络结构,表3展示了图像在网络中经过不同阶段后提取到的特征向量尺寸。

图3 改进的行人重识别网络结构Fig.3 Improved pedestrian re-identification network structure

表3 改进后行人重识别网络每层输出特征尺寸Tab.3 Output feature size of each layer of the improved person re-identification network

由于灰度图像相对于RGB图像只包含一个通道的信息,因此其数据量较小,并且相较于RGB图像对于光照变化的影响更小,也因此更加稳定,同时灰度图像的边缘信息相当于RGB图像更加明显,有助于特征信息的提取。参照文献[14],文中灰度图像分支的输入图像为灰度图像,由RGB图像经过灰度转换得到。

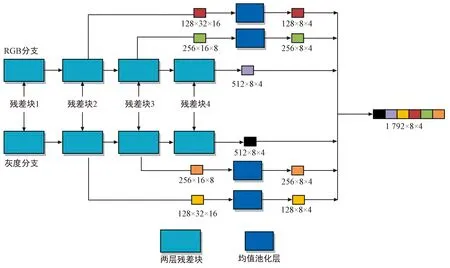

本文的网络采用了迭代深度融合,将两个来源不同的特征信息相结合,即灰度图像的特征和RGB图像的特征进行迭代深度融合,特征融合提高了特征提取的鲁棒性和性能,使得网络提取的特征更加的丰富和全面,其融合的方式如图4所示。

图4 特征融合过程Fig.4 Feature fusion process

在特征融合过程中,RGB分支的残差块2提取的特征为 128×32×16,残差块3提取的特征为256×16×8,残差块4提取的特征为512×8×4。为了使特征融合时特征的长和宽相匹配,将残差块2提取的特征经过一个池化窗口为4×4、步长为4的平均池化层,输出特征为128×8×4;残差块3提取的特征经过一个池化窗口为2×2、步长为2的平均池化层,输出特征为256×8×4。同样,在灰度分支中,经过相同的操作,获取到128×8×4、256×8×4的特征,最后将6个特征进行维度上的拼接,得到1 792×8×4的特征。

本文改进的模型采用了灰度特征损失Lossg、RGB特征损失Lossr以及融合后的特征损失Lossf作为组合的损失函数来优化模型。为了衡量模型的预测输出与实际标签之间的差异,采用了交叉熵损失函数作为模型的损失度量,交叉熵损失[15]的计算公式如下:

(4)

式中:n表示一个批次行人图片总数,p(xi)表示真实概率分布,q(xi)表示预测概率分布。在改进的模型中,将灰度特征损失、RGB特征损失和融合后的特征损失分别计算,并将它们叠加在一起得到总体的损失函数,其公式如下[16]:

L=Lossg+Lossr+Lossf。

(5)

通过最小化总体损失函数,改进的模型将能够优化其参数,使得预测输出更接近于实际标签,从而提高模型的性能。

1.4 改进DeepSort算法

余弦距离矩阵在DeepSort算法中对于人物在长期遮挡后恢复身份起着关键作用,改进的行人重识别网络可以同时输出灰度特征和融合后的特征,在此基础上利用此特性提出了一种新的余弦矩阵计算方法,新的余弦矩阵计算公式为:

d(3)(i,j)=kdfusion(i,j)+(1-k)dgray(i,j),

(6)

式中:dgray(i,j)为灰度分支所提取的特征向量所确定的余弦矩阵,dfusion(i,j)为融合灰度特征网络提取的特征向量确定的余弦矩阵,k为比值,它是一个动态变化的值,通过每帧图像的饱和度来确定,即k等于饱和度。

图片的饱和度是色彩模型HSV的属性之一,饱和度的取值范围为0~1,饱和度越高,代表着图片色彩更加的鲜艳,较高的色彩饱和度说明图片中的彩色占据着主要成分,较低的饱和度说明灰色和白色占主要成分。图片的饱和度计算公式如下:

(7)

式中:p(i)为单个像素的饱和度,n为图片的像素点个数。当该帧图片的饱和度较低时,说明该帧图片以灰度色彩为主,k值较低,此时dfusion(i,j)的值在确定余弦矩阵中的占比较低,dgray(i,j)的值在确定余弦矩阵中的占比较高,余弦矩阵主要以灰度特征来确定。当该帧图片的饱和度较高时,说明该帧图片以彩色为主,k值较高,此时dfusion(i,j)的值在确定余弦矩阵中的占比较高,dgray(i,j)的值在确定余弦矩阵中的占比较低,余弦矩阵主要以融合后的特征来确定。

2 仿真实验结果与分析

模型训练采用的电脑配置CPU为E5-2686 V4,GPU为Tesla P4 8 GB,内存为32 GB,系统为Ubuntu18.04.5 LTS,cuda版本为11.0,pytorch版本为1.7,python版本3.8.5。

2.1 数据集选取与模型训练

改进的行人重识别网络使用了常见的Market1501数据集进行训练,这个数据集是行人重识别领域中最重要的之一。它包含了来自6个摄像头的1 501名行人的图像序列,每个行人都有多张图像。训练集包括751个不同的ID,共有12 936张图片,而测试集包括750个不同的ID,共有19 732张图片,总共32 668张图片。每个行人都有一个唯一的ID,这些ID用于识别不同行人之间的关系。这个数据集通常用于算法研究和性能评估。

为了保证模型的准确性,行人重识别网络模型训练的参数保持一致模型数据输入图片统一设置为128×64,初始学习率为0.01,经过20 epoch后,学习率乘0.1。训练批次大小为64,训练周期数为80轮。

2.2 评价指标

本文指标采用多项指标进行评估:误差率、平均数比率(IDF1)[17]、多目标跟踪精度(Multiple Object Tracking Accuracy,MOTA)、帧率。其中,误差率的公式如下:

(8)

式中:α为误差率,TP为真正例数量,TN为真负例数量,FP为假正例数量,FN为假负例数量;α越小,代表着模型训练的精度越高。多目标跟踪准确率指标是衡量多目标跟踪算法精确性方面最重要的指标,MOTA的数值越高代表跟踪精确度越好。平均数比率代表被检测和跟踪的目标中获取正确的ID的检测目标的比例,综合考虑ID准确率和ID召回率,代表二者的调和均值,帧率是指在图像或视频中每秒钟显示的帧数,它表示了图像或视频的连续性和平滑度。

2.3 结果分析

为了证明融合灰度特征后误差率的有效性,进行了一系列实验来对比不同网络的表现。针对特征提取使用了4种不同的网络:提取RGB特征的六维残差网络、仅提取灰度特征的八维残差网络、提取RGB特征的八维残差网络、融合了灰度和RGB特征的改进网络。

实验结果如图5所示,可以看出,在训练40轮后,误差率趋于稳定,模型训练收敛。

图5 不同模型误差率对比Fig.5 Comparison of error rates of different models

表4为最终的误差率,八维提取灰度特征的网络在训练过程中误差率较高,达到了39.814%。这表明仅使用灰度图像的信息在该任务上效果最差,可能由于丢失了彩色图像中的关键信息,导致网络难以准确地进行特征学习和匹配。六维和八维提取RGB特征的网络表现相对较好,在训练过程中误差率分别为29.427%和16.644%。相比仅使用灰度特征,RGB图像包含了更丰富的信息,包括颜色和纹理等,因此网络能够学到更具有判别性的特征,从而降低了误差率。改进的网络融合了灰度和RGB特征,其误差率为10.253%,效果最好。这说明融合不同通道的信息可以充分利用灰度和彩色图像各自的优势,提高了模型的性能。通过融合灰度特征,网络能够更好地进行跨通道的特征组合,提高了特征的鲁棒性和区分度,从而显著地降低了误差率。

表4 模型最终误差率Tab.4 Final error rates of the model

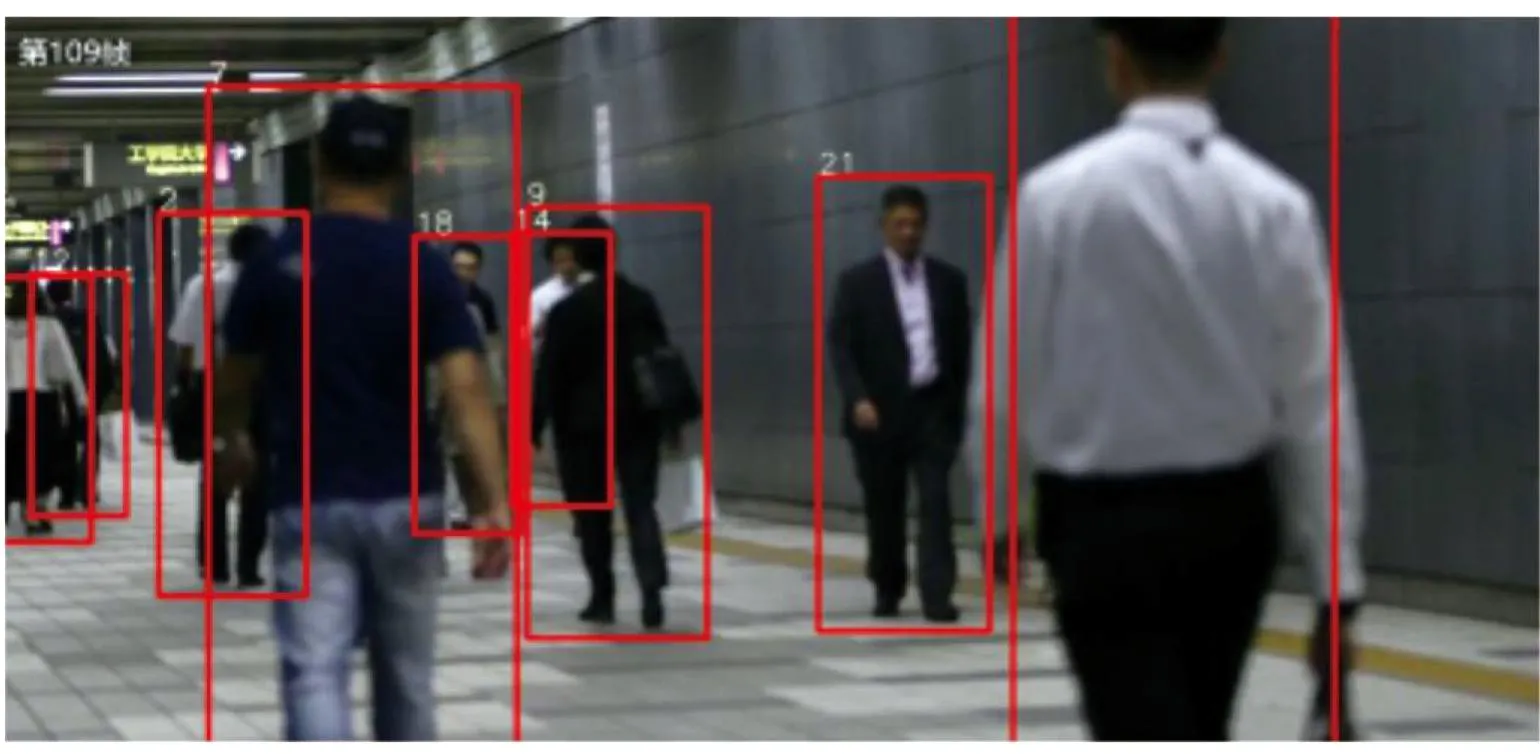

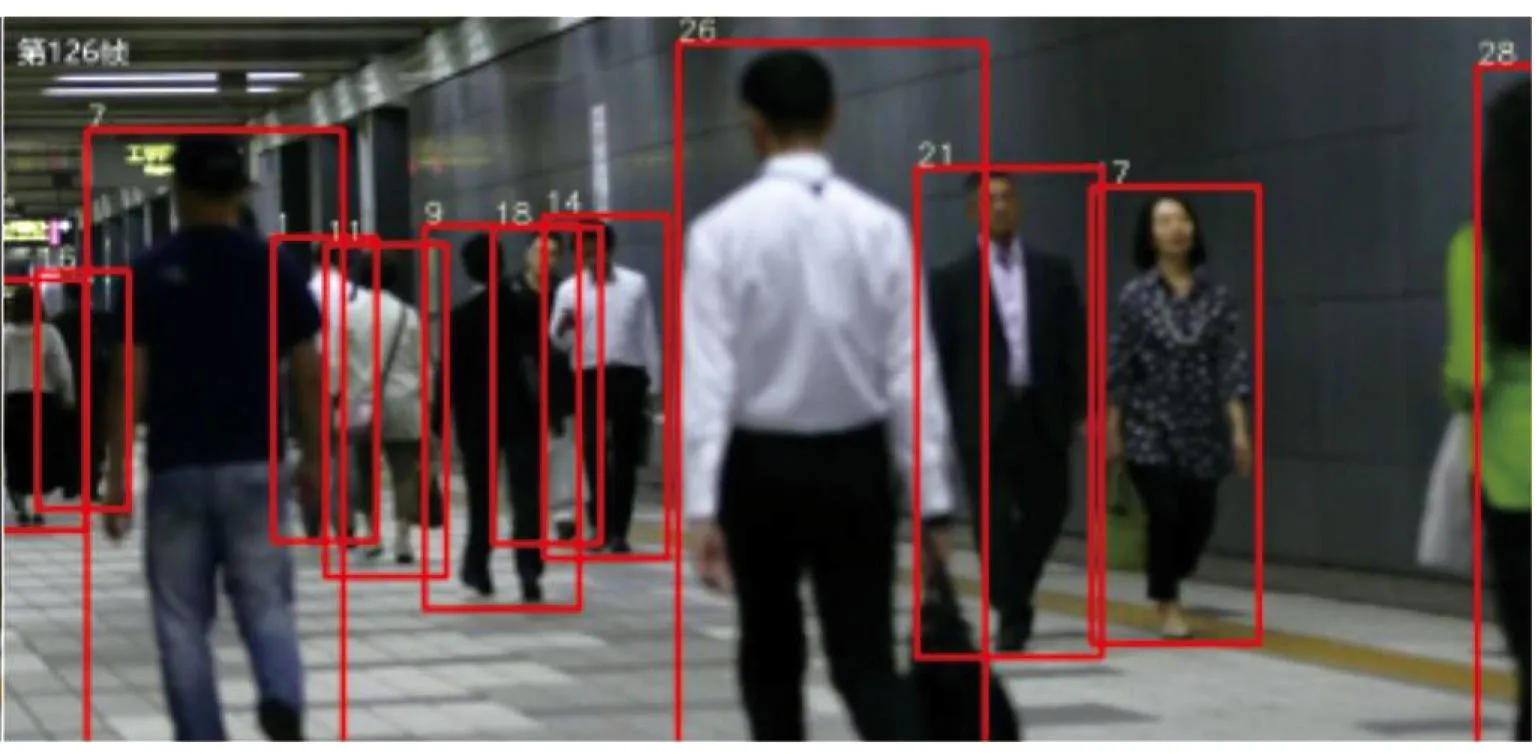

本文在实验场景为地下通道的行人跟踪场景,对比了原始DeepSort算法和优化后的DeepSort算法的跟踪效果。图6展示了原始DeepSort算法和融合灰度特征网络在191帧跟踪情况下的对比结果。通过对比可以观察到,相较于原始的DeepSort算法,DeepSort+改进行人重识别网络在行人跟踪时表现出更好的性能。在该网络下,相同的行人ID数值变小,这意味着减少了ID切换的次数。通过改进行人重识别网络,能够更好地学习到行人的特征,提高了行人的区分度,从而降低了ID切换的频率。

(a) 原始算法

(b) 改进算法图6 原始网络与特征融合网络跟踪效果对比Fig.6 Comparison of tracking effect between original network and feature fusion network

图7展示了DeepSort+改进行人重识别网络在跟踪时前后帧的变化情况,可以观察到ID数18和14在被遮挡后,ID发生了切换,变成了11和1。虽然改进行人重识别网络在一定程度上减少了ID切换,但仍然出现了这样的情况。

(a) 第109帧

(b) 第126帧图7 特征融合网络109帧和126帧对比效果Fig.7 Comparison of 109 frames and 126 frames of feature fusion network

图8展示了DeepSort+改进行人重识别网络同时改进余弦矩阵在跟踪时前后帧的变化情况,可以看出,ID数18和14在被遮挡后,ID保持原样,没有发生跳转。这说明通过结合改进的余弦矩阵,进一步增强了行人跟踪算法的稳定性。

(a) 第109帧

(b) 第126帧图8 特征融合网络加改进余弦距离109帧和126帧对比效果Fig.8 Feature fusion network plus improved cosine distance 109 frame and 126 frame comparison effect

基于上述地下通道场景,自行构建了数据集。为了保证不同算法性能提升的有效性,所有的算法对比都为该数据集,对比算法结果如表5所示。

表5 DeepSort算法结合模型性能指标Tab.5 DeepSort algorithm combined with model performance indicators

实验结果表明,改进了行人重识别网络和余弦矩阵的DeepSort算法有效增强了行人跟踪的稳定性和准确性。

3 结束语

本文通过采用YOLOv5检测器结合改进的DeepSort算法,对复杂场景下的行人跟踪进行了研究,旨在提高跟踪的稳定性并满足实际需求。为了优化行人重识别网络,采用了迭代深度融合的方法,将灰度和RGB特征进行融合,从而降低了模型的误差率。此外,通过改进级联匹配中余弦矩阵的计算方式,分别计算灰度特征和融合特征的余弦矩阵,并加权得到新的余弦矩阵,有效减少了DeepSort算法在跟踪过程中目标丢失的问题。

实验结果显示,相对于传统的DeepSort算法中使用的八维残差网络,改进的重识别网络使误差率降低了6.391%。而与传统的DeepSort算法相比,结合了改进的重识别网络和改进的余弦矩阵的DeepSort算法在多目标精度和平均数比率指标上分别提升了0.9%和8.1%。

这些结果表明,本文提出的方法在行人跟踪方面取得了显著改进。通过优化行人重识别网络和改进余弦矩阵计算方式,成功地提高了跟踪的准确性和稳定性。这对于许多实际应用场景,如视频监控、智能交通系统等具有重要的意义。未来的研究可以进一步探索其他的改进方法,以进一步提升行人跟踪算法的性能,并将其应用于更广泛的领域。