人工智能社会公正风险的维度与测量〔*〕

2023-12-08亓光,刘鑫

亓 光, 刘 鑫

(中国矿业大学 马克思主义学院, 江苏 徐州 221116)

2023年初,随着ChatGPT的流行成为社会广泛关注的“人工智能”大事件,图灵测试已死〔1〕的观点甚嚣尘上。然而,“人之巧乃可与造化者同功乎”的千年之问依然未解。而在移动互联网、大数据、云计算、物联网等相关技术迭代升级与经济社会高质量发展需求的双重驱动下,人工智能(Artificial Intelligence,AI)则不断迎来新突破,引发人们固有生活方式和劳动方式的遽变,将整个世界以一种前所未有的形式紧密联系起来;同时,随着人工智能在生产生活中的应用越发广泛,与人工智能相关的社会公正风险问题也应运而生,造成了更大的不确定性。认真对待人工智能时代的社会公正风险,不仅要深思其挑战,阐明其基本理论,还应对社会公正风险本身进行测控,唯如此,才能真正做好迎接人工智能时代的准备。

一、文献分析与问题的提出

人工智能的社会公正风险具有不同的问题域。自约翰·麦卡锡首次提出“人工智能”概念以来,人工智能演进近70年,人们从“图灵测试”的技术事实判断,已经发展到“人工智能关系”等社会价值的问题域。在这里,人工智能被划分为“弱人工智能”和“强人工智能”,〔2〕二者之间存在“奇点”,而人工智能甚至有发展为“超人工智能”〔3〕的可能。现实性考量人工智能的社会公正风险,需要在“弱—强—超”的标准中作出前提判断。就现实问题分析而言,我们应将社会公正风险的测量基本限定于“现实性问题”,以弱人工智能为本研究的问题域。

在本问题域内,学术界已经对人工智能的社会公正风险问题进行了大量研究,相关成果涵盖了哲学、政治学、伦理学、法学、社会学、经济学等学科,关涉生产、生活、社会分配等诸多维度,尤以人类的主体性危机为主。这里的核心问题是“人工智能产品是否应该具有主体性地位”。以这个问题为中心,衍生出了“如何防范和解决人工智能产品所带来的伦理行为异化风险”的伦理问题,涉及人的自我异化、人的主体异化、人的交往异化等不同维度,而关涉社会公正等伦理风险的研究成果呈现出五种代表性观点(如表1所示)。

表1 公正风险领域、产生途径及代表性观点

由表1不难发现,在与人类具有相近智能发展水平的主体性物种出现以前,社会公正风险产生的原因主要在于AI技术对生产方式和劳动力结构的改变,人工智能智能化的特性使得其在传统的社会公正问题研究中形成了一个“真空地带”,更是为社会公正风险的滋生提供了温床,并且加剧了风险的不确定性和复杂性。当前,学界广泛关注基于传统的社会公正测量标准围绕“人工智能对社会公正有何风险”的现象观察与预测展开,相关成果已为推动各国政府和非政府组织在制定人工智能伦理原则与技术标准、健全法律法规、加强监管等方面提供了学理支撑。与此同时,关于人工智能所引起的社会公正问题边界之“暗涌之变”的趋势加速显现,因而亟待从理论上加以考量。然而,任何标准都有其适用范围,人工智能介入引发了社会公正边界条件的改变,公正测量的标准也会随之发生改变,这就意味着既有标准下社会公正与不公正之间的界限被重新划定。缺乏历史条件的限定会让公正标准变成外化于社会的、先验的存在,通过一种抽象的、永恒的、普遍的标准来衡量不同社会发展条件下的公正程度的这种企图本身就是不公正的。如果没有及时对弱人工智能问题域中社会公正的测量维度和边界进行更新,就会导致其测量效度随之明显降低,让在弱人工智能问题域中的社会公正风险易于泛化为一般性社会公正风险问题,从而不可避免地陷入对人工智能所诱发的普罗透斯式的公正乱象的追逐中。在新问题域下重审社会公正测量的维度,在理论上有助于打破基于西方社会条件而生成的社会公正框架体系,推动建立本土化的社会公正标准;在现实中有利于更加准确地把握公正风险的发生条件和防范化解途径,继而为解决社会深层矛盾与利益分歧提供前瞻性的理论探寻和实践指引。

二、从“应然”到“现实”:测量社会公正的基本维度

众所周知,公正是一种理想价值,也是衡量社会文明的重要尺度。社会公正是伴随社会发展而逐步形成的政治伦理概念,在这里,“公正”主要指“以正义为依据,来进行现实社会层面上的基本制度的设计和安排,试图将‘应然’和‘实然’两者有机统一起来,因而带有明显的现实性”。〔9〕

(一)社会公正的“应然”之维:哲学性与历史性的统一

“我们是当代的哲学同时代人,而不是当代的历史同时代人”,〔10〕弱人工智能问题域中新的历史发展同样也呼唤着哲学层面对社会公正问题的重新阐释,人工智能正在从自下而上的物质生产条件和自上而下的思维认知水平两个方向重塑着社会公正新的“应然”标准。

我们认为,规范性研究重视阐释价值原则的正确性是其典型的思考方式,以此证明体现着这种价值原则的制度安排合理性,其最早可以追溯到柏拉图的“理念”之辩,沿循着一代代哲人对“公正”的追求由德性向权利的转变,政治与道德日益相分离,这种分离在19世纪中期受到科学主义冲击后达到顶点,又随着20世纪70年代罗尔斯《正义论》的发表而复归,也将“正义”议题推到了当代政治哲学研究的中心。规范性研究至少从三个方面为弱人工智能问题域下社会公正风险考量提供了学理支撑:一是肯定了公正原则作为防范化解社会风险基本准则的合理性和必要性;二是察觉并承认了“存在”的不合理性,跳出了对“存在即合理”的消极顺从;三是试图从哲学“应然”层面建立人工智能伦理规范的“最大公约数”。哲学性层面的“应然”研究对于推动各国达成“人工智能伦理”(Ethics of AI)共识发挥了基础性的作用,但现有的“人工智能伦理”原则在实际执行层面的苍白无力证明了仅仅以哲学层面的伦理道德来规范AI伦理之“应然”是不够的,因为规范性研究对于不公正现状的批判还不够彻底,甚至在一定程度上借由对现象的批判遮蔽了不公正乱象的本质——资本主义私有制带来的公正分配主体与分配对象的分离,必然导致社会公正不能惠及所有人——资本主义生产方式的私有性质决定了只有以抽象人性论为前提条件才能推导出人与人之间自由与平等的原则。无论是追求社会整体幸福最大化的功利主义,还是强调个体优先及权利保护的自由主义,抑或主张以共同体为基础进而实现道德再造的社群主义,都以人类理性作为道德原则推演的前提,所谓“无知之幕”的背后实则是狭义的“抽象的人”。由此可见,人工智能借助算法所形成的类人的“理性”似乎比复杂的人类理性更为“理性”。然而,哲学化的正义原则并不会以更加合理的形式在人工智能上得以体现,正因为哲学化正义原则是抽象的且不以主体为改变的,那么弱人工智能体的理性同样也是抽象的,人工智能体之“理性”赋予仍然受制于其创造者背后的人的逻辑,其核心是资本逻辑,只能服务于资本的生产与再生产。由于资本的价值增殖倾向固化在所谓的理性算法中,从而必然将滑向更为隐蔽的造成人类社会不平等的新方式。

如果说哲学性上的“应然”为社会公正的实现描绘了“彼岸”的图景,那么历史性的“应然”则为社会公正的实现提供了“此岸”的依循。人类从未停止过对社会公正的追求,但“关于永恒公平的观念不仅因时因地而变,甚至也因人而异”。〔11〕历史唯物主义认为,事物的内在矛盾是支配一切事物的发展变化的根本原因,必须“始终站在现实历史的基础上,不是从观念出发来解释实践,而是从物质实践出发来解释各种观念形态”。〔12〕一方面,在不同生产方式下,人们接受的社会公正观念各不相同。弱人工智能问题域下社会公正的“应然”受社会物质生产实践的支配,并从对由这种实践所形成的不合理的社会关系的批判中产生。以这种标准指导实践,形成了公正的规范关系、社会价值,不偏不倚地消解社会分歧、释放社会活力。另一方面,随着资本主义的全球扩张,新自由主义的社会公正观形成了话语霸权,资本主义意识形态在社会公正话语形成、发展过程中的渗透、支配趋势越发明显,资本主义的全球扩张与意识形态化的新自由主义公正话语相互支撑。不难发现,当今西方社会公正理论大多致力于将原本难以整合的共性利益还原为个性的利益诉求,以程序公正代替实质公正。事实上,现代社会对实质公正的追求并不拒斥基于哲学思辨和现实情境而设计的程序公正,相较于以绝对数量为依据来衡量社会公正情况的实质公正,程序公正更倾向于考察过程设定中的公正性,强调个体应该拥有对过程的控制权力,程序必须符合该个人所接受的基本道德和伦理价值。〔13〕程序公正为确保社会公正理念最大限度的实现提供了可行性的解决方案,对于实现社会的政治安全与经济发展目标发挥着不可替代的作用,弱人工智能问题域下的社会公正是实质公正价值与程序公正价值的辩证统一。

(二)合理性追问:时代化的马克思主义公正评判标准何以“现实操作”

马克思关于正义的意见是内隐的、批判性的,在其著作中检索“正义”(Gerechtigkeit)一词所得到的“实际上几乎比任何一个流行的新闻专栏作家能想到的类似的分析结果都要少”。〔14〕因此,相较于“文本性”剖析马克思的公正观,更应该关注对马克思的批判性观点进行类型化建构,以具体的历史眼光来发现现实的公正风险。这体现在四重批判里。第一重批判:从抽象到现实。马克思批判永恒公平观,戳穿了西方近代各种正义原则形而上的超验本质,主张以历史的、具体的社会公正标准将公正问题重新拉回到现实的社会经济关系中,并将观念与社会现实经济运动的关系摆正,澄明了物质生产之于公正观念的决定性作用。马克思反对抽象的道德说教,主张让“从口头说的、思考出来的、设想出来的”〔15〕人回归到“真正的人”,这种对现实的观照使弱人工智能问题域中“解释世界”和“改变世界”的社会公正成为可能。第二重批判:从空谈到实践。马克思指出“资本主义社会—社会主义社会—共产主义社会”的生产方式分别对应“按资分配—按劳分配—按需分配”的分配方式。在这里,分配公正问题是三维的,即谁(主体)以何种方式(原则)将资源分配给谁(对象)。在弱人工智能问题域,按劳分配的弊病依然不可避免,必须认识到改变分配方式的前提是改变生产方式。第三重批判:从唯心到唯物。恩格斯指出,人与人之间的平等程度受制于生产力发展水平,在马克思和恩格斯那里,社会生产力的极大解放能够为大范围的社会公正的实现提供现实的可能,同时,社会公正的实现也是以承认社会成员之间合理的差距为限定条件的,这种平等权利的实现也并非平均主义下粗暴的“一刀切”式的平等,社会与政治生活将始终建立在个体的差异性之上,关键在于如何将差别限定在社会所认可的合理限度之内。第四重批判:从剥削到解放。马克思充分揭露了资产阶级社会公正观的虚伪与狭隘,而摆在无产阶级面前的实现社会公正的道路有且仅有一条,那就是联合起来“扬弃”私有制继而实现社会全体成员的全面自由发展。“只有当人认识到自身‘固有的力量’是社会力量,并把这种力量组织起来因而不再把社会力量以政治力量的形式同自身分离的时候,只有到了那个时候,人的解放才能完成。”〔16〕

在上述架构内,马克思的社会公正研判可以延伸出四个维度的标准。一是平等维度,即“一切人,或至少是一个国家的一切公民,或一个社会的一切成员,都应当有平等的政治地位和社会地位”。〔17〕对人与人之间平等程度的测量是马克思恩格斯评判社会公正与否的核心依据。二是分配维度,即彻底改变“在道德上是公平的甚至在法律上是公平的,从社会上来看可能远不是公平的”〔18〕现实,真正实现生产资料的公有制。三是机会维度,即重视机会公正自下而上的特点,使人不论其家庭背景、先天禀赋、所处环境如何,都拥有平等的参与机会、被挑选机会、获得的机会等,〔19〕将机会公正充分纳入社会公正测量。四是人的解放维度,即现实的社会公正是“为一个更高级的、以每一个个人的全面而自由的发展为基本原则的社会形式建立现实基础”,〔20〕每个人全面而自由的发展是人类获得解放的根本价值目标,将“以人为本”作为衡量社会公正的关键指标。

(三)社会公正的“实然”之维:建构性测量的客观性与主观性的统一

社会公正应是具体的,正是由于社会公正涉及的因素复杂多变,所以社会公正的测度与评价始终是个难题。多年来,国内外在制定测量社会公正的标准上做了诸多努力,相关标准的最大公约数基本上都覆盖对就业率、医疗水平、贫困人口比例、收入差距、基础教育覆盖率的考察,核心是对社会贫富差距的测量(基尼系数、洛伦兹曲线、鲁宾霍德指数等)。提出社会公正问题的目的在于解决现实的社会矛盾,与人们对现状的不满密不可分,现实的社会公正在很大程度上是由现实的不公正所测量的,即所谓的“社会非正义是原生的,而社会正义则是派生的”。〔21〕在这里,社会不公正主要在横向与纵向两个方向形成,因此弱人工智能问题域下社会公正的客观测量维度应该兼顾分域的横向维度与分层的纵向维度:横向的不公正影响资源配置的均匀程度(如义务教育覆盖率、基尼系数、高中阶段毕业生性别比等),资源的相对匮乏是其产生的主要原因,人工智能可以通过增加资源总量、降低准入门槛、优化配置手段和培育公正意识来提升社会横向公正水平,反之亦然;纵向的不公正是建立在经济水平、政治地位、社会影响力等不平等方面的结构性压迫(国内相关测量指标有司法公正指数、廉政指数、重大决策听证率等)之上的,这种不平等被以制度和文化的形式固化,而不以个体差异为转移,人工智能对于这种结构性压迫的纾解或加深同样影响着社会总体公正水平。由此可见,弱人工智能问题域下社会公正风险的防控体系应该是立体的,使横向公正在最广范围内由中心向边缘辐射,使纵向公正在最大程度上由顶层向底层贯穿。

社会公正与否的判断标准,不仅受到相对客观的显性标准对社会公正现状评估的影响,还深受主观的、社会成员价值观的影响,甚至对个人和家庭状况的认知以及对自身生活环境质量的感受比实际的社会经济地位特征更能影响人们面对分配不公时的态度。〔22〕因此,社会公正的评判标准有必要兼顾客观的反映社会公正现状的“硬指标”与主观的反映社会成员心理感知的“软指标”。〔23〕社会公正感与量化的贫富差距指标相比,具有更多的主观属性,而通常的测量方式是问卷调查。比如,在2021年中国综合社会调查(CGSS)问卷和2021年中国社会状况综合调查(CSS)问卷中均设置了与社会公正感知测量强相关的问题。与此同时,可逆性检验一致也对个体公正感知具有一定的检验作用,但检验结果受个体主观影响较大,且当检验对象为群体乃至整个社会时,可逆性检验的加总便成了明显的难题。一般而言,人们在观念层面对公正与否的判断原则包括应得原则、平均原则和需求原则,但在一个利益分化和利益主体多元化的社会中,最终决定不同社会成员的社会公正评价的主导判断原则是不尽相同的。相对剥夺(relative deprivation)理论认为,人们在局部范围内与他人或自己过去状况的比较影响着人们的分配公平感,预期需求满足与实际需求满足之间差距的增大,会导致社会成员相对剥夺感的积聚,影响其对于自身所处境况是否“公正”的判断。而相对剥夺感很容易受到互联网舆论、广告、新闻的影响,进而引发对政府的信任危机,在弱人工智能问题域中,人们的公正感知在一定程度上被塑造、扭曲、替代、集合,但是其本质仍然建立在现有的社会生产方式之上,生产方式起着基础性和决定性的作用,社会公正观是社会经济基础的从属与派生,是对生产方式相适应或相矛盾的反映。在这里,人工智能内嵌于互联网,更能赋予互联网以无限的操作空间,而日常生产生活与互联网的联系越紧密,人类自然而然被这张网越发牢固地裹挟住。

无论怎样,确立较为科学合理的社会公正指标体系有助于从纷繁复杂的“实然”中将现实社会公正问题简化为量表和数据的组合,但指标的选取、指数权重赋予、补偿效应的修正、调查样本的抽取、数据的处理以及分析模型的选择等,都会影响最后结果的有效性、稳定性和适用性。当人工智能处于不同生命周期时,社会公正风险可能也会随之呈现出不同的表征,风险的具体形式和等级也是随着时间和技术的发展而动态变化着的,人工智能各技术环节的参与者的风险视角不同,所关心的测量指标也有不同的侧重点,以上这些都为具体的公正指标制定带来了困难。目前,基于简单共识即平等、分配、机会、人的解放和公正感知的五种基本维度,我们就具备了初步型构人工智能影响社会公正的“现象—本质”结构。

三、人工智能的公正风险:社会不公正的现实范型

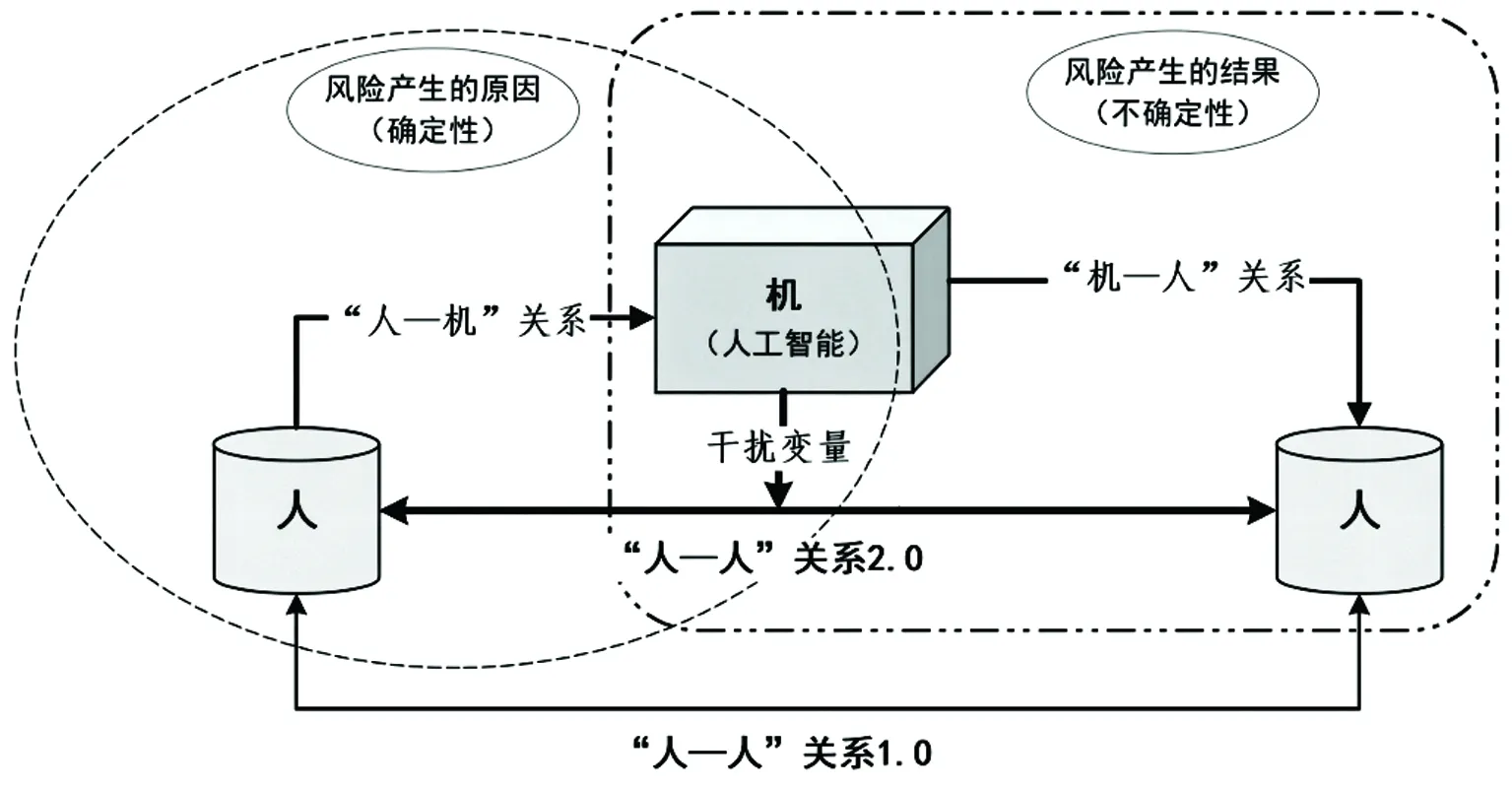

在弱人工智能问题域中,人工智能以“人工”属性为先决条件,而人是社会公正评价的自变量和承载一切后果的因变量。在人与人的关系之间引入人工智能,便直接生成了“人—机”关系(人类对人工智能的作用)与“机—人”关系(人工智能对人类的反作用),而二者共同构成了“人—机—人”的新的关系(如图1所示)。人工智能之于社会公正的风险滋生于“机—人”关系所带来的不确定性,解决的可能性在于“人—机”关系所带来的确定性,测量人工智能的社会公正风险可以通过对“人—机”关系的回溯,来审视“机—人”关系中所寓的社会不公正现象的内在诱因。

图1 “人—机—人”关系示意图

(一)“机—人”关系:人工智能如何“带来”社会不公正

在弱人工智能问题域中,人工智能可能造成五个典型的社会公正问题:不平等差距问题,即AI扩大还是缩小了平等差距;分配公正问题,即AI使分配方式更为公正还是不公正;机会公正问题,即AI是否促进了机会公正的实现;人的解放问题,即AI是否使人的发展变得更加全面而自由;公正感知问题,即AI对个体社会公正感的影响是积极的还是消极的。

第一,人工智能之于不平等差距。基于缔结社会的贡献以及“人的种属尊严”,社会成员因其为人而应具有平等“资格”并享有平等的权利。诚然,人工智能的应用促进了一些领域不平等差距的缩小,在一定程度上弥合了不同地区之间教育水平差距所带来的受教育权利不平等的等等鸿沟。与此同时,人工智能也确实造成或加剧了某些领域的不公,如利用人工智能侵犯公民知情权,数字民主威胁真正民主;高科技企业利用大数据“杀熟”,技术垄断加剧不正当竞争;人工智能“武器化”,成为威胁世界和平的新达摩克利斯之剑。在这些领域中,社会公正的测量将变得越发复杂和困难。

第二,人工智能之于分配公正。资源配置结果的公平程度是分配公正的核心,而人工智能作为资本的价值规定,既是分配方式也是机制,贯穿于社会的权利分配、资源分配和劳动分配中。〔24〕人工智能为分配公正提供了新解决方案,但它的研发、使用和创新依然是以营利为目的,这就必然造成核心技术被垄断,弱化少数群体和弱势群体的道德关怀等问题。事实上,数字资本是一种必须被配置的生产资源,但数字劳动却弱化了生产与生活、工作与娱乐之间的界限,数字劳工(digital labor)/玩工(playbour)的权益保护问题也将变得越发突出。

第三,人工智能之于机会公正。在调整产业结构和重构社会分工模式的同时,人工智能改变了劳动市场格局,引发结构性失业的社会风险,使大批“无业阶级”沦为“无用阶级”,导致社会贫富差距进一步拉大,有人甚至利用人工智能的技术不透明性,将性别、族裔或宗教等因素带入算法偏见,加剧了社会歧视问题。这是一种新型社会歧视,而且会持续介入人们的日常生产生活,造成不同受教育水平、不同经济条件群体之间的机会不平等,进而还会造成整个社会的犯罪率上升、人民幸福感下降、社会凝聚力降低、政府信任度下降甚至社会动荡等一系列严重的问题。

第四,人工智能之于人的解放。强调人的解放,就要突出以人为本的理念。作为第四次工业革命中的代表性技术,人工智能通过对生产要素重组广泛赋能人类生产生活,极大地提高了生产效率,便利了人们的生活,智能化作业也将一些工人从艰苦危险的工作环境中解放了出来,但AI技术也极有可能造成技术宰制人类的新风险。“如果人工智能被黑客攻击和操纵,提供看似客观但实际上是隐藏得很好的有偏见的信息或扭曲的观点,那么人工智能可能会成为危险的宣传机器”,〔25〕而未成年人过度依赖或者沉迷人工智能则可能造成“代际性”的巨大公正风险。

第五,人工智能之于公正感知。人工智能对社会公正感存在屏蔽和放大两种取向,其借助互联网通过操纵舆论或利用“信息茧房”机制来弱化、强化甚至扭曲个体对社会不公情况的认知,影响其安全感、认同感、幸福感,进而影响其行为模式、政治参与度等。当人工智能与移动互联网、智能手机等深度结合,社会成员的公正感知就会被精准、迅速、跨区域地扩散和传播,忽视其引发的集群效应则可能会使主流意识形态失去对舆论和突发事件的控制权,元宇宙、VR技术则会强化“奶头乐”风险,“非正当”的公正感则可能取代合理的公正感。

(二)“人—机”关系:人工智能对社会公正风险的诱因分析

借助伊壁鸠鲁悖论(Epicurean Paradox)的本质设问,我们确实要思考:人类已经以主宰者的面貌存在于世上,那么人工智能所带来的社会公正风险问题究竟是源于人们在技术面前的“无能”还是人性之“恶”呢?

一方面,技术的“无能”何以通过人工智能诱发社会公正风险?现阶段人工智能的技术研发主要集中在机器学习、数据挖掘、自然语言处理、计算机视觉、语音识别、机器人技术等六大热门领域,致力于实现对人类躯体的全方位模仿。受限于脑神经科学的发展水平,人工智能体的“思维”本质仍是基于算法和数据投喂与反馈来进行概率推理,继而进行思考结果的模仿,无法真正还原人类思维过程。就此而言,算法偏见与数据采集偏见是人工智能诱发社会公正风险的两个主要来源。众所周知,只有人会歧视,而算法不会。人工智能从被设计到投入使用再到重新调试的整个过程中,所涉及的生产者、运营者、使用者都是具体的人,因此主观偏见难以避免。事实上,偏见的形成与社会背景与知识的局限性、目标用户的偏好指向性、最大化市场利益的趋向性、特殊政治考虑的变化性等具有密切关系。弱人工智能问题域下,在设计环节中,算法工程师的偏见内嵌、程序运行中的偏见循环与累计效应会导致算法偏见的引入;在运营环节中,对目标用户针对性地选择、对系统的人为干预也会引入算法偏见;在使用环节中,人机互动中的偏见习得、机器学习中的数据筛选同样会导致算法偏见的引入。

同时,算法的强专业性、不透明性、垄断性和不确定性的特点也为隐性权力的存在起到了推波助澜的作用。其一,算法的强专业性特点使得人工智能在投入使用的过程中,实际上通过算法关联形成了一种基于为他人造成后果的能力不对称分布的权力方法。〔26〕其二,科学的本质是解蔽,但技术却可以利用解蔽造成新的遮蔽。众所周知,人工智能经常采用算法“黑箱”(Black Box)来掩盖其内部运行机制,这正是算法不透明性的主要来源,造成了人工智能的可解释性差,加大了监管和规范难度,为算法权力的隐性运行提供了可操作的空间。其三,由于算法的开发往往涉及商业机密和知识产权,核心技术被科技巨头垄断,无法开源共享,为算法权力的隐性运行构建了技术壁垒。其四,算法投入使用后就要依赖于海量且不断更新的数据,根据机器学习等进行负反馈调节和交互式改进,不再完全遵循工程师的初始设定,最终结果越发难以预测,必然产生算法偏差。在运用大数据技术和人工智能算法形成用户精准画像的过程中,数据采集无法始终保证不偏不倚,这就增加了算法权力隐性运行的不确定性,是典型的社会不公正。

另一方面,人性之“恶”何以通过人工智能诱发社会公正风险?通过机器学习,人工智能在一定程度上能够胜任“建筑师”的角色,但生成式人工智能越来越“类人”的回答,也只是通过对用户偏好数据的采集实现高效、充分但仍旧是机械的“投其所好”。众所周知,人工智能的生命力在于技术创新。人工智能可以创造巨大生产潜能与活力,还可以刺激消费、促进制造业向发达国家回流等。人工智能创新背后的推动力首先是资本对超额剩余价值的逐利性,人性之“恶”的具象化即为资本的逻辑,资本家增加劳动生产力的首要办法就在于分工的精细化以及“更全面地应用和经常地改进机器”。〔27〕为了获取生产的超额剩余价值,企业进行技术革新,在努力“把自然科学发展到它的最高点”的同时,〔28〕进行技术垄断。人工智能极大地遮蔽了劳动力本质,它将“越来越多的‘人手’从工作岗位上排挤出去。而排挤的速度,比国内的工厂吸收和雇用这些被排挤的‘人手’的速度要快得多”。〔29〕数字劳动则将原本的生产与生活、工作与娱乐之间的界限模糊化,形成隐性的无偿劳动,创造新的剩余价值来源,产生了新剥削形式。在这里,《资本论》的利润率计算公式p=s/(c+v)依然能够通过有效补充而应用于数字劳动的分析上,即可变资本v可被拆解为固定员工的工资与从事用户生成内容生产的用户工资:

在这里,s为剩余价值(surplus value),c为不变资本(constant capital),v1为支付给固定员工的工资,v2为支付给互联网用户(users)的工资,〔30〕对利润率的追求,意味着工人将被无限剥削。资本主义借由人工智能转嫁矛盾,将资本家与劳动者的矛盾转嫁给科技与人类,可以在一定程度上缓解阶级矛盾。虽然部分西方马克思主义论者看到了科技发展的负面影响,但没有深入其资本逻辑本质,而仅仅是“用科技批判代替了政治经济学批判”。〔31〕在弱人工智能问题域中,资本对劳动者剩余价值的压榨仍然是科技创新发展的重要驱动力。

与此同时,作为一种科学技术,它不可避免具有资本的内在规定,因此人工智能本身就是一种权力。它既能赋能人类生活,又强化权力约束效应。在推动“物的人格化”的同时,人工智能也是人格的物化。效率工资理论认为,高于市场均衡水平的工资可以提高工人的努力水平,也就降低了雇主为每一单位有效劳动支付的成本,特别在互联网、人工智能的行业中,“采用机器所造成的一定量资本推动的工人人数的减少,即构成剩余价值的一个因素的减少,在某种程度上产生了恰恰是机械工厂所特有的趋势,即延长绝对劳动时间的趋势”,〔32〕机器的资本主义应用“一方面创造了无限度地延长工作日的新的强大动机,并且使劳动方式本身和社会劳动体的性质发生这样的变革,以致打破对这种趋势的抵抗,另一方面,部分地由于使资本过去无法染指的那些工人阶层受资本的支配,部分地由于使那些被机器排挤的工人游离出来,制造了过剩的劳动人口,这些人不得不听命于资本强加给他们的规律”。〔33〕于是,公私领域的界限逐渐模糊,人工智能的广泛运用强化了对工人工作流程的监视与对其工作节奏的控制,弱化了工人之间的交流以及对工人居家工作的劳动保障,使工人阶级逐渐原子化,〔34〕越来越难汇合到一起捍卫自身利益,这就让集中化的意识形态控制更加有效。

四、化解风险的可能方向:社会公正指向下人工智能的规范再造

2023年9月,《自然》(Nature)杂志刊发了一份对全球1600多名研究人员进行调查的文章,结果显示,半数以上的受访者认为未来十年人工智能对其研究领域“非常重要”或“必不可少”,他们普遍担心AI技术对科学的影响,商业公司对人工智能的计算资源的主导和人工智能工具的所有权也是一些受访者关心的问题。〔35〕当前,我国正处于社会深度转型期,经济增长速度放缓,社会成员的主体意识和权益意识逐渐增强,对社会公正的需求也日益旺盛,以市场为核心的分配方式与利益分配调整之间的矛盾日益尖锐,由此带来的贫富差距、东西部区域发展差距、城乡差距等弊端也逐渐凸显出来,因此必须面向社会公正“重构”人工智能。

(一)普适性批判:科学自主制定人工智能发展的基本规范

21世纪以来,人工智能的发展以一种全新的形式,与互联网、大数据等从不同侧面,将人与人之间的“息息相关”朝着更深层次、更多面向、更高水平的方向推进,也使得人工智能的社会公正风险超越了国家边界,具有全球属性。国家间技术合作的背后是竞争性驱动下普遍性规则对于各个国家在AI应用与监管领域的秩序重塑,如美国、欧盟都高度重视且争取把控AI全球标准的制定权,它们加速出台一系列法案,并强调这些法案的普遍适用性,这就让后发国家特别是处于AI应用早期的国家成为被动接受者甚至受害者。2013年,德国政府提出了以信息物理系统为技术核心的“工业4.0”计划,而全世界至今大约有三分之二的国际机械制造标准来自“德国标准化学会标准”,德国已然占有相关领域的主动权、话语权、统治权;2016年,日本提出以超智能社会为核心愿景的“社会5.0”构想,主张通过在世界上率先推进知识产权化和国际标准化,以及广泛引进人才等手段来维持和强化日本在科技领域的竞争力。经验表明,人工智能公正原则和技术规则的制定应该坚持普遍性和特殊性相结合,既要凝聚全球共识,又要抵制单边霸权,坚决捍卫本国自主规则制定权,制定符合自己国情的AI发展准则,掌握规则制定的话语权与科技发展的主动权,防止少数掌握大量数据、巨大存储空间和强大计算能力的公司与国家凭借其影响力垄断AI市场。

(二)工具性导向:积极回归人工智能的工具本质

以效率为主导的市场逻辑下,自由竞争不仅不会促进公正,在一定程度上还会抑制公正,甚至引起更大的危机,需要通过对人工智能进行规范来防范可能对人类主体性地位造成的威胁。2016年以来,人工智能伦理原则的制定过程迅速经历了制定伦理原则、达成共识、投入实践三个阶段,力图将伦理原则与价值要求融入、嵌入人工智能研发与应用的全生命周期。2023年1月,美国商务部国家标准与技术研究院(NIST)发布了《人工智能风险管理框架1.0》(Artificial Intelligence Risk Management Framework,AI RMF 1.0),该文概述了值得信赖的人工智能系统的七大特征:有效和可靠、安全、牢固和有弹性、负责任和透明、可解释和可说明、加强隐私、公平且有害偏见得到控制。〔36〕进入新发展阶段以来,我国采取主动应对策略,人工智能的综合治理进入了新阶段。2017年,国务院发布的《新一代人工智能发展规划》就明确提出了我国人工智能治理的“三步走”战略目标,该目标要求从法律法规、伦理规范和政策体系等各层面各领域各角度全面推动人工智能治理体系构建,使人工智能回归到工具的现实本质,更加符合高质量发展的要求。

(三)结构性革新:深刻调整人工智能的需求侧和供给侧资源配置

当今世界,“资本主义固有的生产社会化和生产资料私人占有之间的矛盾依然存在”,〔37〕新生的数字化、虚拟化、智能化的经济发展又进一步激化资本主义经济结构的内在矛盾,而人工智能的介入加剧了个别企业生产的有序性和整个社会生产的无序性之间的不协调。尤其是在“人工智能+互联网”模式下,借助于互联网思维的底层逻辑——流量为王,大量吸引用户入场,创造了很多需求,但这些在一定程度上是被塑造的结果,存在巨大的泡沫。对于我国而言,维护社会公正,就必须将人工智能刺激下的供需差距维持在可控范围,从需求侧和供给侧进行双向结构革新:在需求侧,识别、挖掘、创造新的需求;在供给侧,优化资源配置,打破发达国家对人工智能产业链上游技术的封锁,增加中高端供给,以人工智能激发落后产能活力,增强供给侧结构对需求侧结构的适应性。通过优化人工智能布局以及结构性增/减税政策的引导,智能红利也许可以成为人口红利的替代品。

(四)解放性旨归:充分发挥人工智能的生产力水平提升作用

人工智能的发展是科学技术发展的一个维度,而科学技术发展的最终目的是推动人类社会的进步。“任何解放都是使人的世界即各种关系回归于人自身。”〔38〕在社会主义中国,坚持科学技术是第一生产力,既要大力提升生产力水平,又要将内部发展水平的差距维持在可控范围内,既要避免社会撕裂的塔西佗陷阱,又要增强抵御风险的能力,防止社会公正风险转化为政治风险,进而真正实现共同富裕与社会政治稳定的共轭。在这里,坚持创新驱动发展必须突出以维护最广大人民群众的根本利益为技术创新价值的最高衡量标准,不断实现以人的全面发展为终极价值目标的“革命性”科学技术变革。在马克思主义技术创新观与当代中国的具体实践相结合过程中,锻造以人为本的技术创新观,不断提高劳动者素质,完善分配结构,健全技术要素参与分配机制,有效实现资源配置和竞争环境的公平,修订相关法律法规,加强劳动者权益保护。我们应当最大限度发挥我国的制度优势,将人工智能的发展置于社会主义现代化强国建设的“全过程”中,以不断化解其社会公正风险实现人民共享的社会主义国家的技术伦理优越性。

注释:

〔1〕“图灵测试”指,如果一台机器能够与人类展开对话(通过电传设备)而不能被辨别出其机器身份,则认为该机器具有智能。

〔2〕约翰·希尔勒提出,以“是否具有意识”为区分标准将人工智能划分为弱人工智能和强人工智能。弱人工智能指的是“受人支配的、不具有自我意识的机器”,只能解决特定领域的问题。强人工智能指的是“全方位模拟人类能力甚至超过人类而应对各种挑战的通用智能系统”,基本上能够胜任人类所有工作。参见Searle,John R.,“Minds,Brains,and Programs”,Behavioral and Brain SciencesVol.3,No.3,1980,pp.417-424。

〔3〕〔英〕尼克·波斯特洛姆:《超级智能——路线图、危险性与应对策略》,张体伟等译,北京:中信出版社,2015年。

〔4〕Phil McNally,Sohail Inayatullah,“The Rights of Robots:Technology,Culture and Law in the 21st Century”,FuturesVol.20,No.2,1988,pp.119-136.

〔5〕〔30〕Fuchs C.,“Labor in Informational Capitalism and on the Internet”,The Information SocietyVol.26,No.3,2010,pp.179-196.

〔6〕高奇琦:《智能革命与国家治理现代化初探》,《中国社会科学》2020年第7期。

〔7〕Cass R.Sunstein,Infotopia:How Many Minds Produce KnowledgeOxford:Oxford University Press,2006,p.9.

〔8〕孙伟平:《人工智能与人的“新异化”》,《中国社会科学》2020年第12期。

〔9〕吴忠民:《社会公正何以可能》,北京:人民出版社,2017年,第8页。

〔10〕〔12〕〔15〕〔16〕〔27〕〔38〕《马克思恩格斯文集》第1卷,北京:人民出版社,2009年,第9、544、525、46、735-736、46页。

〔11〕《马克思恩格斯文集》第3卷,北京:人民出版社,2009年,第323页。

〔13〕Colquitt,J.A.,Conlon,D.E.,et al.,“Justice at the Millennium:A Meta-analytic Review of 25 Years of Organizational Justice Research”,Journal of Applied PsychologyVol.86,No.3,2001,p.425.

〔14〕〔美〕威廉·麦克布莱德、王贵贤:《马克思、恩格斯与其他人论正义》,《马克思主义与现实》2008年第5期。

〔17〕《马克思恩格斯全集》第26卷,北京:人民出版社,2014年,第109页。

〔18〕〔29〕《马克思恩格斯全集》第25卷,北京:人民出版社,2001年,第488、490页。

〔19〕黄秀华:《机会公平的影响因素及实现途径》,《广西社会科学》2011年第4期。

〔20〕〔33〕《马克思恩格斯文集》第5卷,北京:人民出版社,2009年,第683、469页。

〔21〕〔爱尔兰〕维托里奥·布法切:《社会非正义》,洪燕妮译,南京:江苏人民出版社,2020年,第4页。

〔22〕Martin Kreidl,“Perceptions of Poverty and Wealth in Western and Post-Communist Countries”,Social Justice ResearchVol.13,No.2,2000,pp.151-176.

〔23〕T.R.Tyler,K.A.Rasinski,et al.,“The Influence of Perceived Injustice on the Endorsement of Political Leaders”,Journal of Applied Social PsychologyVol.15,No.8,1985,pp.700-725.

〔24〕唐代兴:《人工智能发展带动的社会公正危机》,《人文杂志》2020年第8期。

〔25〕Jim Chilton,“The New Risks ChatGPT Poses to Cybersecurity”,Harvard Business Review Digital ArticlesApril 21,2023,https://hbr.org/2023/04/the-new-risks-chatgpt-poses-to-cybersecurity.

〔26〕Neyland D.,Möllers N.,“Algorithmic IF…THEN Rules and the Conditions and Consequences of Power”,Information,Communication &SocietyVol.20,No.1,2017,pp.45-62.

〔28〕《马克思恩格斯文集》第8卷,北京:人民出版社,2009年,第90页。

〔31〕刘英杰:《作为意识形态的科学技术》,北京:商务印书馆,2011年,第4页。

〔32〕《马克思恩格斯全集》第37卷,北京:人民出版社,2019年,第192页。

〔34〕〔英〕乌苏拉·胡斯:《高科技无产阶级的形成——真实世界里的虚拟工作》,任海龙译,北京:北京大学出版社,2011年,第111页。

〔35〕Van Noorden R.,Perkel J.M.,“AI and Science:What 1,600 Researchers Think”,NatureVol.621,No.7980,2023,pp.672-675.

〔36〕National Institute of Standards and Technology,Artificial Intelligence Risk Management Framework(AI RMF 1.0)January 24,2023,https://nvlpubs.nist.gov/nistpubs/ai/NIST.AI.100-1.pdf.

〔37〕习近平:《在哲学社会科学工作座谈会上的讲话》,北京:人民出版社,2016年,第14页。