基于改进人工势场与强化学习融合算法的路径规划研究

2023-11-27冯恒莉

冯恒莉

(1.江苏联合职业技术学院苏州工业园区分院,江苏 苏州 215000;2.苏州工业园区工业技术学校,江苏 苏州 215000)

在路径规划领域中,传统方法和强化学习各有优缺点。因此,该文将传统学习中的人工势能场算法与强化学习中的DQN算法相结合,构建了一种APF-DQN算法,该算法可以在减少迭代次数的同时不影响最终效果。基于APF算法和DQN算法,该文构建了APF-DQN算法,最终的试验结果表明,该算法在路径规划领域具有良好的效果。传统的APF算法存在一些局限,该文对这些局限进行分析和改进。将DQN算法与APF算法相结合,APF-DQN算法克服了传统APF算法的一些缺点,可以提高在路径规划任务中的性能。

1 相关工作

随着人工智能和机器人等技术迅速发展,路径规划广泛应用于各个领域,例如服务机器人、船舶以及无人机等领域[1-3]。针对路径规划的研究可以分为3种方法,即传统方法、深度学习方法和强化学习方法。

在传统的路径规划方法中,研究人员将路径规划分为3个步骤,即构建环境模型、搜索路径和路径处理。这3个步骤在不同的算法中有不同的处理方式,由于任务的关注点不同,因此传统方法中存在多种不同的算法。例如Dijkstra算法使用广度优先和贪婪搜索策略搜索完整的图路径,A*算法在Dijkstra算法的基础上增加了启发式函数和估计函数来限制搜索,以获得更好的结果。除了这些算法,还有一些仿生算法被应用于路径规划,例如蚁群算法通过模拟蚂蚁在寻找食物过程中传递给彼此的信息素来进行路径规划;遗传算法通过模拟自然繁殖过程中的遗传和变异来规划更好的路径;粒子群算法通过模拟鸟类觅食过程中信息的相互作用来规划路径。此外,当地图信息不足时,一些研究人员更注重研究规划路径的方法,因此衍生了一系列局部路径规划算法,例如人工势场算法,它将物理学中的“场”概念引入路径规划领域中,假设智能体在一个力场中运动,障碍物产生斥力,目标产生引力,在斥力和引力的综合作用下找到最优路径。

传统路径规划方法存在先验知识过多、在复杂环境中规划效率和结果下降的问题[4-5]。因此,深度学习逐渐应用于路径规划中。例如Wu K Y等[6]提出了一种基于DNN网络的混沌环境实时路径规划算法;Huang F R等[7]将深度学习引入旅行路线规划问题中。除此之外,深度学习还被引入基于无人机网络的多目标路径优化和城市中的车辆网络进行细粒度路径规划。

虽然深度学习在路径规划方面颇有成效,但是与强化学习相比,它在规划效果上仍存在一些不足,其根本原因是2种学习方法不同。深度学习是基于样本的静态学习,而强化学习是与环境交互的交互学习。在强化学习的训练过程中,智能体会探索各种策略,以达到更好的效果。标准的强化学习框架通常由3个模块组成,即输入模块、强化模块和策略模块。输入模块读取外部输入;强化模块确定代理要实现的目标,一般是使其获得最大的最终奖励;策略模块根据当前状态和强化目标选择代理要采取的行动。

2 改进人工势场与强化学习融合算法

2.1 改进的人工势场算法

人工势场算法(APF)是一种标准的路径规划算法,其基本思想是将路径规划中的环境模型与混合引力场和斥力场的人工势能场算法进行比较,在人工势能场中,目标点对机器人具有吸引效应,周围的障碍物对机器人具有排斥效应,机器人在二者的共同影响下进行路径规划。概率路网算法通过在相容空间中采样来对采样点进行碰撞检测,并测试相邻采样点是否可以连接(表示路径图的连通性)。模拟退火算法基于路径规划过程中连续变化的概率最终趋于0的原则,算法在当前解附近随机寻找可能的全局最优解,以实现全局优化的目的。

如图1所示,APF算法涉及斥力和引力,该文介绍的APF算法中涉及的引力场函数如公式(1)所示。

式中:ξ为引力增益;d(q,qgoai)为目标点间的欧氏距离。

根据公式(1)可以推导引力力的公式,如公式(2)所示。

式中:Uatt为引力势场函数;qgoal为目标点位置;q为当前点位置。

该文涉及的APF算法中的斥力场函数如公式(3)所示。

式中:η为斥力增益;D(q)为当前点q与最近障碍物点间的欧氏距离;Q*为障碍物受到斥力影响的距离阈值。可以根据公式(3)推导斥力的公式,如公式(4)所示。

最终,结合公式(1)~公式(4)可以得到人工势场的最终表达式,如公式(5)、公式(6)所示。

式中:U(q)为最终人工势场函数;Uatt(q)为引力势场函数;F(q)为合力。

由公式(1)~公式(6)可知,人工势场算法存在2个问题:1) 由于引力过小,因此难以捕捉目标。2) 当引力和斥力的合力为0时,容易陷入局部最优解。为了解决这些问题,该文设置相关区域和无关区域,以减少无关区域中斥力的影响。

原始的人工势场算法通过全局考虑所有障碍物和目标来计算斥力和引力。然而,这并不合理,因为一定距离之外的障碍物不会对智能体的路径规划产生影响,所以该文围绕智能体设置了一个相关区域,在相关区域半径R内仅考虑障碍物产生的斥力。经过对比可知,不考虑相关区域外障碍物产生的斥力,可以降低出现斥力和引力合力合理为0的情况的概率。相关区域的示意图如图2、图3所示。

图3 改进的人工势能场算法的效果

2.2 DQN算法

深度学习算法与强化学习算法在路径规划任务中有不同的优势,将深度学习与强化学习结合,执行路径规划任务也取得了显著的成果。DQN算法是典型的深度强化学习算法,其优点是可以处理高维度的状态空间,而且可以在没有干预的情况下自主学习,从而实现自适应不同地图和场景。DQN算法可以利用深度学习的感知能力与强化学习的决策能力,实现端到端学习。即使在复杂的动态环境下,DQN算法也能通过调整神经网络的结构和参数来提高路径规划的准确性,在网络收敛速度较快的前提下,具有良好的路径规划能力。因此,该文对改进人工势场算法和DQN算法进行融合。

DQN算法的核心概念是用一个神经网络q(s,a:ω)来代替Q表,其具体的原理如公式(7)所示。

式中:Q*(s,a)为价值函数近似。

在公式(7)中,f值可以是任意类型的函数,而s表示输入的状态。

DQN算法中的损失函数如公式(8)所示。

式中:E为期望值;r为实际观察得到的值;γ为回报的折扣率;Q(st+1,at+1,ω-)为目标网络;Q(st,at,ω)为评估网络。

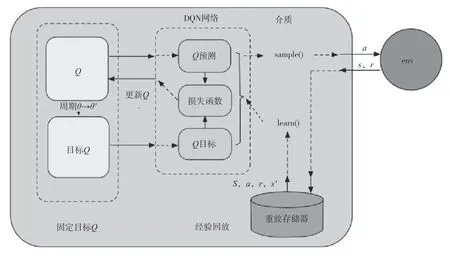

DQN网络的结构如图4所示。原始的DQN算法在路径规划领域需要大量的迭代次数,其原因是它没有先验知识。基于DQN算法的APF-DQN算法将APF算法作为先验知识添加到DQN算法中,最终减少了迭代次数。

图4 DQN网络结构图

3 试验结果与分析

为了验证该文提出的方法的有效性,对APF-DQN算法进行试验和分析,APF与DQN融合后可以减少迭代次数、提高算法效率。通过大量试验验证,该文提出的方法能够缩短50%的迭代时间。APF-DQN算法的实施效果如图5所示,在复杂场景中,该算法仍然具有较高的性能。

图5 APF-DQN算法实施效果图

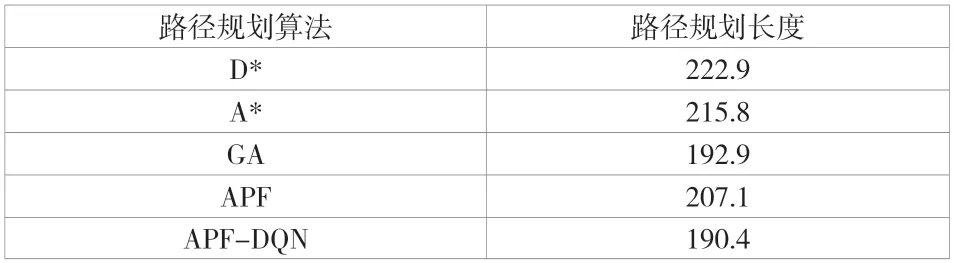

为了验证APF-DQN算法的先进性,在相同的栅格地图上对APF-DQN算法和其他先进的算法进行多次对比试验。由于单次路径规划可能存在一定的随机性,因此该文选择10个点进行路径规划,分别求取10个点的试验结果的平均值,并将其作为最终的试验结果。具体的试验结果见表1,将该文提出的APF-DQN算法与D*、A*、GA以及APF等先进算法进行对比。

表1 路径规划算法对比试验结果

由表1可知,APF-DQN路径规划长度最短,与其他常见的先进路径规划算法相比,APF-DQN具有更好的结果,在复杂路径规划场景中具有较高的性能。

4 结语

该文提出了一种基于DQN算法的APF-DQN算法。与DQN算法相比,该文提出的算法可以更快地迭代最终结果,其规划效果比其他标准算法更好。但是,当前的APFDQN算法仍然有需要改进的地方,在复杂环境中,APFDQN算法很难获得最优解,因此如何在复杂环境中仍然具有良好效果是一个亟待解决的问题;与其他标准传统算法相比,APF-DQN算法的运行速度仍然太慢,提高APFDQN算法的速度也是未来的重要研究方向之一。