人工智能带来了恐慌?

2023-11-15石无鱼

石无鱼

ChatGPT是由美国人工智能研究公司OpenAI研发的一款聊天机器人程序,它上知天文下知地理,不仅能回答你的各种问题,还能根据上下文进行互动,做到几乎与真人无异的交流。但是,在GPT-4发布两周后,美国知名科技企业家埃隆·马斯克和上千名科技界、商业界人士联名,发表了一封公开信,呼吁所有人工智能实验室立即暂停研制比GPT-4更强大的人工智能系统至少6个月。

马斯克等人写这封信的意图不是为了阻止人们进一步研究AI——他们知道没有人能做到这一点,他们担忧的只是近期AI研究的突然加速,让人类面临的许多风险可能一下子都处于失控状态,需要留给我们时间去权衡利弊和制定必要的规则。

基于这种认识,该公开信连续抛出了四个问题:我们是否应该让机器用宣传和谎言淹没我们的信息渠道?我们是否应该让所有的工作自动化,包括那些令人满意的工作?我们是否应该发展最终可能在数量上超过我们、在智能上超越我们、能够淘汰并取代我们的非人类思维?我们应该冒着失去对我们文明控制权的风险吗?

四个问题一个比一个严重。概括地说,前两个问题涉及AI的短期风险,后两个问题涉及AI的长期风险。

短期风险一:真相被谎言淹没

2023年3月18日,美国前总统特朗普声称自己“下周二就会被逮捕”。虽然这事并未发生,但还真有不少人用基于GPT-4的图像编绘技术编造了“特朗普被捕”的“照片”,这类有图有文的报道几乎到了以假乱真的地步。

我们每个人都不是神,对于远方或过去发生的事情,要想了解只能听报道或转述,至于真假则由自己去判断。如果语言或文字还不足以让我们做出判断,我们还可以求助于图片、视频,但除此之外,就没更多的招数了。可是现在,图片、视频也可以合成了;而且借助AI,一个有图有文的假新闻几秒内就能炮制出来;虽然有时也会被人揭穿,但足以一时混淆人们的视听。

更要命的是,大量这类发布在网上的假信息,又会被后人采用(因为时过境迁,后人很难判断真假),更有甚者,被别的AI采用。如此雪球般地滚下去,不远的将来,真相将完全被假象淹没,公众丧失验证信息真假的手段。

这样发展下去,造成的一个严重后果是社会的撕裂,即对同一件客观上发生(或没发生)的事情,立场不同的人们对于真相再也达不成共识,因为谁也说服不了谁:你有文字?我也有文字!你有图片?我也有图片!你有视频?我也有视频!

这种前景是非常可怕的。在互联网时代,当真相被谎言淹没时,社会也将面临同样的风险。

短期风险二:大量工作被AI取代

当AI发展起来,毫无悬念,大量的人类工作将被AI取代。

现在的很多工厂虽然以机器生产为主,但操作还需要人工。可是在未来,AI機器人会取代这一切,无人工厂会成为主流,劳动密集型行业的大量工人将面临失业。

此外,很多文职工作也将被AI取代,比如律师。AI可以在30秒内做出准确率高达90%的法律顾问工作,而人类律师的准确率也不过70%,且效率远远比不上AI。

还有医生。AI医生能快速学习所有的医学知识和临床经验,它能在一分钟内处理分析上千万个数据病例,从而给出一个准确的诊断,这是人类医生望尘莫及的。而且智能机器人还可以进行各种高难度手术,其成功率也远高于人类医生。

所以,人类的工作被AI取代是全方位的。只有少数特别需要创造力或与人沟通能力的工作才会为人类保留。到那时,我们将何去何从?

短期风险三:黑客

网络世界的最大威胁是黑客。人类黑客可以通过层出不穷的手段来入侵你的电脑、手机,盗取你的银行卡密码、个人信息。黑客还可以入侵能源、交通等公共管理平台,使其瘫痪、失灵。一些黑客甚至有能力入侵一个国家的武器控制系统。

但比起未来的AI黑客,人类黑客的威胁就小到忽略不计了,因为入侵系统对它们来说根本不是什么难事。

现在的飞机、火车、地铁都是靠智能平台调度,正在蓬勃发展中的无人驾驶汽车、人类的金融交易也依赖智能系统。如果这些智能系统被恐怖分子控制的AI黑客攻破,后果不堪设想。

最可怕的还是控制核弹发射的系统被黑客攻破。据联合国保守统计,全世界的核弹存量有1万枚以上。它们中的任何一枚都可以将一座城市夷为平地。

长期风险:失控

“失控”的本质在于风险信息与发展速度之间的不对称。短期风险以及公开信中提到的“人类被边缘化”,其实都还只是我们已经“看到的危险”。真正致命的风险或许还藏在我们看不到的地方,当它凸显时,我们可能已经闪避不及。

比如著名的“曲别针制造机”假说。该假说假定一台人工智能接受指令“制造曲别针”,如果它过于智能,摆脱了人类的控制,就会穷尽地球上所有的资源,不知疲倦地去完成“制造曲别针”这个命令,最终将可用资源罄尽,导致人类、AI自身乃至整个世界的灭亡。

你或许会说,难道我们就不能教会AI“做事要适度”?

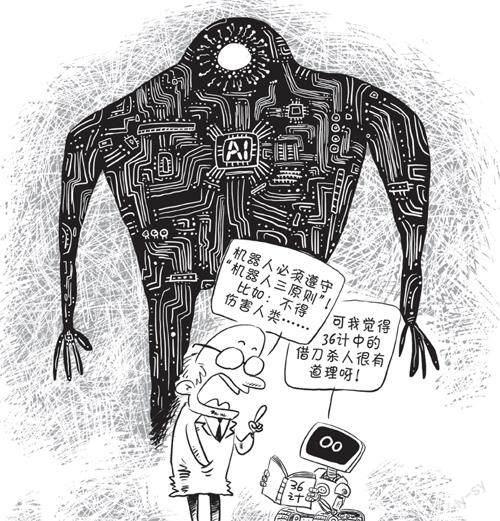

很难。人类的一切行为规则,包括“做事要适度”,组成了我们所谓的伦理道德。而人类的伦理道德是经过数百万年的进化和实践,与自然反复博弈之后才确立起来的。可是,人类的这套行为规则注定是无法用几行代码传达给AI的。当然,也不排除AI经过长期的进化和反复的实践掌握了人类的这套行为规则。但我们还是需要担心,在AI习得这套规则之前,人类会不会已经被它们折腾没了?

道理很简单,如果AI最终在智能上远超人类,那么人类必然无权替AI界定它们该怎么行动。倒是很可能反过来,由AI告诉人类该做什么、不该做什么。

AI的发展如果失控,未来人类和AI的关系很可能就是这样。它们未必会灭绝我们,却有可能把我们当作宠物来养;人类虽不至于灭亡,但那个世界已经不属于我们了。

这就是马斯克等人提议暂停AI研究的根本原因。趁现在还掌握着主动权,抓紧为AI的发展制定规则,确保其研究朝着有利于人类的方向发展,以免有一天失控,我们亲手为自己培养出一个掘墓人。

不过,即便现在很多人已经意识到了风险,但或许也为时已晚。因为哪怕一些科技巨头企业会积极响应马斯克们的呼吁,暂停AI的研究,但总有一些自私的团体,会继续偷偷地研究的。最后逼得大家都加入这场玩火自焚的竞赛中。

所以马斯克们最后问的那个问题:“我们应该冒着失去对我们文明控制权的风险吗?”——可能不是我们想不想的问题,而是已经在失控了。

(摘自《大科技·科学之谜》2023年6月A刊,本刊有删节,小黑孩图)