融合图神经网络和注意力机制的异质图嵌入研究

2023-11-10陈天超

陈天超

(兰州职业技术学院 信息工程学院, 甘肃兰州730070)

随着信息技术的广泛应用,真实世界的许多应用场景都可使用网络进行建模,网络表示学习随之成为网络研究的热点之一。异构信息网络比同构网络具有更加丰富的信息,能够灵活地建立各个领域的异构数据,直观清晰地描述节点类型及其关系的多样性。缘于以上优势,异质图分析也迅速成为机器学习、信息检索等领域的研究热点。随之,如何挖掘异质图中所蕴含的丰富的异构信息亦成为一项新的挑战。

为了捕获存在于异构图中丰富的语义信息,实现网络节点的精确表示,学者们提出了很多经典的方法,代表性模型如DeepWalk[1]。其中,有些方法利用网络模式的元路径来分析、理解异质图中对象和关系的语义。有文献提出使用元路径指导的随机游走和异构Skip-Gram来学习异构信息网络的语义信息[2]。有文献指出利用元路径信息将异质图转换为同质网络,并应用 DeepWalk来学习节点表示[3]。有文献提出一种基于对抗解耦器的异质图表示框架,使用元路径解耦器将每个元路径下的节点表示分别映射至固有和特有空间中[4]。以上各种方法的元路径均为预先指定,不能保证穷尽所有可能的元路径,会造成信息损失。因此,有研究人员提出了一种基于多视角嵌入融合的推荐模型,分别从同质关联和异质关联来挖掘异构信息网络的深层潜在特征并加以融合[5]。为了能够更好地捕捉非线性关系,有些行业和领域开始利用深度模型来对异质图进行建模。有文献指出使用一个自动编码器结构来同时优化一阶和二阶相似度,学习得到的向量表示能够保留局部和全局结构,并且对稀疏网络具有鲁棒性[6]。有文献借助对抗生成网络或者对抗生成网络加注意力机制的方式实现了异构信息网络的嵌入学习[7-8]。然而这些方法没有充分考虑邻域信息,或者没有将邻域信息与元路径信息聚合获取更丰富的语义特征。

针对以上问题,笔者提出一种基于图神经网络和注意力机制的异质图嵌入模型,分别从同质和异质两种视角挖掘异质图的深层特征,学习节点嵌入。具体将从以下两点做起:从同质关联出发,挖掘有用的元路径模式,并生成节点序列,过滤与初始节点类型不同的节点,学习节点基于元路径的嵌入;从异质关联出发,构建二部图,提取节点的多阶邻域,使用图神经网络聚合节点的多阶领域信息,获得节点基于领域的表征。最后,有效整合上述两种嵌入得到最终的网络表示。

一、知识准备

(一)符号说明与问题定义

输入:异质图G=(V,E)。

输出:(1)元路径集合{P1,P2,…PM};(2)映射函数,将每个节点投影到Rd中的一个低维向量,其中d表示向量的维度,满足d≪|v|。

(二)基于GNN和注意力的异质图嵌入模型

HeteRep模型的框架图如图1所示,该模型分为三个步骤,在下面将进行详细描述。

图1 HeteRep模型框架

二、HeteRep模型

给定异质图G=(V,E),目标是为每个节点v∈V学习一个低维表示u,使得u能够高度总结异质图中节点所蕴含的信息特征。

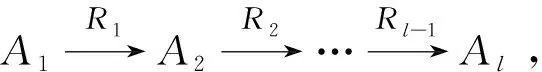

(一)基于元路径的嵌入

(1)

由于异质图图中存在大量跨多个节点类型的语义关系,它们携带的语义也存在差异,故不同的元路径包含了不同的语义信息。另外,注意力机制用于自动学习和计算输入数据对输出数据的贡献程度,因此,在上述模型中引入注意力机制,让模型学习并感知有用元路径序列中哪些是更重要的,哪些是不那么重要的,从而有选择地学习到更有价值的语义信息。

设第i条元路径Pi指导下的向量表示u(pi)的注意力得分∂i,其计算方式如公式(2)所示:

ai=qTtanh(V×u(pi)+v)

(2)

(3)

其中V和v为注意力网络中的投影参数,q为注意力查询向量,m元路径的条数。基于元路径的最终嵌入qp为各条元路径向量表示的加权和。

(4)

优化过程如公式(5)所示

(5)

其中logPr表示对数概率,f(v)是将顶点映射为嵌入向量的映射函数,对于图中每个顶点v,定义Ns(v)为通过采样策略采样出的顶点v的近邻顶点集合。如此便可以学习到节点在不同元路径下的向量表示集合E={u(p1),u(p2),…,u(pm)}。

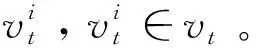

(二)基于邻域的嵌入

基于元路径的随机游走生成节点序列,然后过滤掉与起始节点不同类型的节点,会导致信息缺失,因此本节考虑添加节点的二阶邻居表示。

在推荐场景中,“用户—项目交互”可以很容易地表示为具有两种类型节点的二部图。从异质图中提取出“用户—项目”二部图,根据“用户—项目”二部图找到节点的一阶邻居和二阶邻居,应用二部图卷积神经网络学习表示。

以用户类型的节点u为例,二部图卷积神经网络对第一层到二层的邻居进行采样后,通过图卷积迭代聚合两跳邻域信息,对用户节点和项目节点进行编码。每个用户u和项目m都学习了初始嵌入eu和em。目标用户u的第一层嵌入的表示如公式(6)所示:

(6)

其中eu是初始用户嵌入,Con表示拼接操作,σ(.)是tanh的激活函数,是跨所有用户节点共享的第k层转换权重矩阵。学习到的邻域嵌入,其计算过程如公式(7)所示:

(7)

其中em是初始项目嵌入AGG表示聚合器,一般采用均值聚合器,N(u)表示用户u邻居。

以上操作便可以聚合到用户的一阶邻居,下面以迭代的方式聚合二阶邻居,如公式(8)和(9)所示:

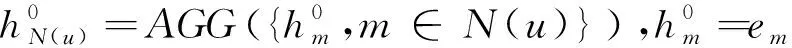

(8)

(9)

(三)信息整合

至此,我们得到了目标节点在两个视角下的节点表示qp和qn,这两部分信息对于节点的深层特征表示都尤为重要,将其拼接得到节点最终的向量表示向量u。

u=[qp,qn]

(10)

项目节点的向量表示,其过程与上述用户节点的向量表示生成过程完全相同。

三、实验和结果分析

本文将通过大量实验来验证HeteRep模型的性能。

(一)数据集

我们使用两个广泛使用的公测数据AMiner和DBIS构建异构的协作网络。其中,AMiner数据集包括1,693,531名作者,来自3883个计算机科学场所的3,194,405篇论文;DBIS数据集涵盖了464个场所,前5000名作者,以及相应的72,902份出版物。

(二)评价指标

实验选取广泛使用的受试者工作特征曲线下的面积(Area Under Curve, AUC)、平均倒数排名(Mean Reciprocal Rank, MRR)和归一化累积增益(Normalized Discounted Cumulative Gain, NDCG)作为异质图嵌入表示任务的评价指标。

(三)基线方法

为评估本文方法的性能,选取以下五种方法作为基线方法,具体描述如下:

DeepWalk:该模型使用截断随机游走获得局部信息,通过将游走序列视为句子的等价物来学习潜在表示[1]。

HIN2Vec:该框架利用节点之间不同类型的关系来捕获嵌入在HINs中的丰富语义,学习HIN中节点和元路径的潜在向量[3]。

HetGNN:该方法采用图神经网络结构,保持了一阶和二阶接近性[10]。

MAGNN: 该模型设计候选编码器函数从集合实例中提取信息,提出新的元路径聚合方法用于异质图的嵌入学习[11];

HEAD:该模型提出基于对抗解耦器的异质图嵌入框架,使用元路径解耦器将每个元路径下的节点表示分别映射至固有和特有空间中[6]。

(四)实验结果与分析

1.与基线方法的性能对比

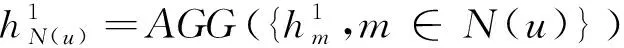

表1和表2列出了在AMiner数据集和DBIS数据集上分类结果的实验。从实验结果可以看出,本文的HeteRep方法在Macro-F1和Micro-F1两个指标下的表现明显优于其他四个对比方法。为会议节点预测类别信息,当给定较小规模的训练数据集时,HeteRep方法的优势十分明显。例如,当给定30%的节点作为训练数据集时,HeteRep方法与DeepWalk、HIN2Vec、GraphSAGE、HetGNN、MAGNN、HEAD相比较,可得在Macro-F1指标下有了0.01-0.63的提高,而在Micro-F1指标下有了0.01-0.59的提高。总的来说,HeteRep方法能够更好地学习异构节点嵌入,原因在于它不仅通过元路径学习了节点的语义信息,而且聚合了二阶邻居信息,这样便可以全面地学习到节点的向量表示。此外,本文所提出的HeteRep方法结果均高于其他方法。

表1 在AMiner数据集上多类别会议节点分类结果

表2 在DBIS数据集上多类别会议节点分类结果

2.消融实验

为了说明HeteRep方法各个组成部分的重要性,构建了HeteRep方法的两种变体:

(1) HeteRep-m:仅考虑通过元路径信息学习网络表示;

(2) HeteRep-n:仅考虑领域信息学习网络表示;

(3) HeteRep:考虑元路径信息和领域信息。

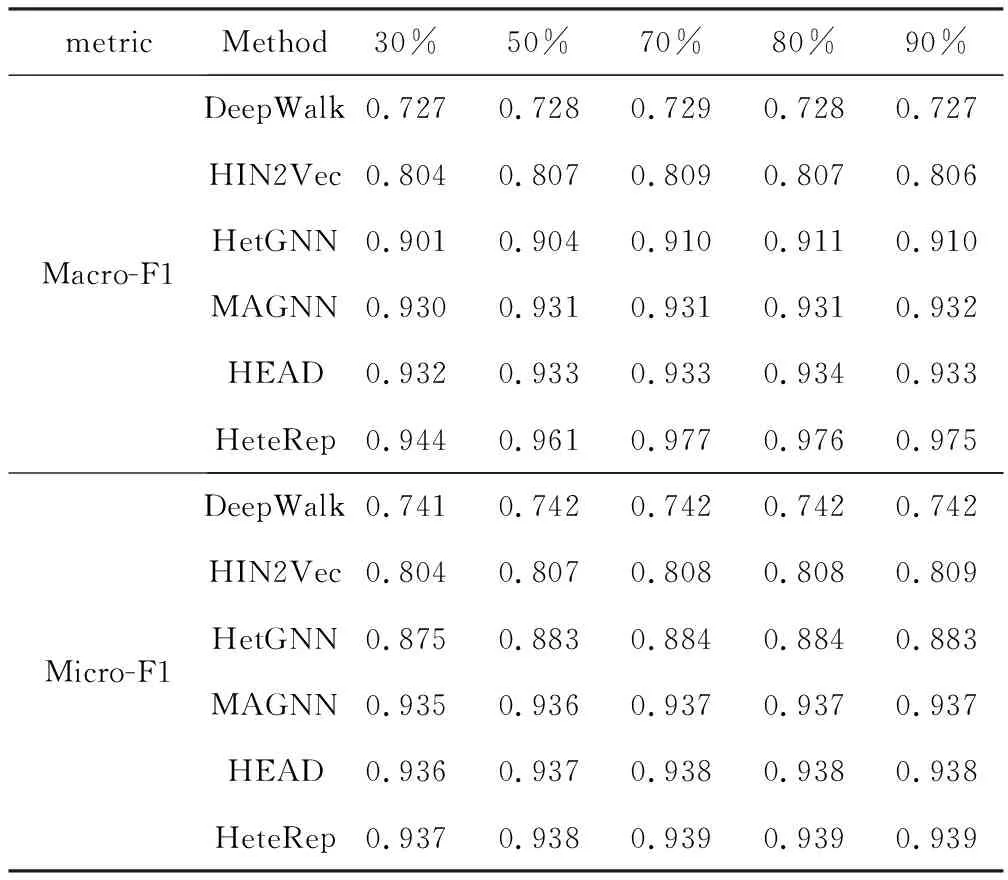

从图2和图3可以看出,完整的HeteRep方法始终优于其他几种去除任意一个组件的变体。HeteRep-m和HeteRep-n的性能比较差,说明仅考虑通过元路径生成路径序列或者仅考虑聚合邻居信息不能提供足够的信息,无法得到高质量的向量表示。与HeteRep-m和HeteRep-n相比,HeteRep方法的性能有显著提升。

图2 AMiner 数据集上的消融实验

图3 DBIS数据集上的消融实验

3.超参数敏感度实验

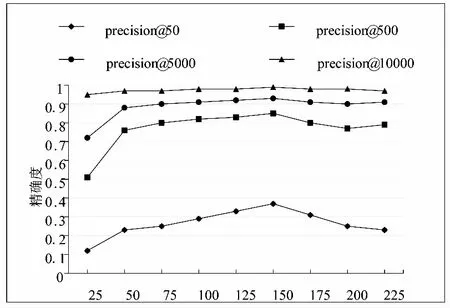

本实验主要针对HeteRep模型的超参数进行敏感性分析,图4的曲线图显示了实验结果。

图4 向量维度d性能的影响

如图所示,通过评估维度对向量表示的影响,d(向量维度)分别取25,50,75,100,125,150,175,200,225。通过精确度对向量表示进行评估,可以看出d取150时,表示学习效果最好。

四、结语

本文基于现有方法提出了基于图神经网络和注意力机制的异质图嵌入模型。该方法分别从同质关联视角和异质关联视角将基于元路径的邻居信息和基于邻域信息的节点特征进行整合,有效地学习了节点表征。在真实数据集上的实验结果表明,本文所提出的方法可以有效地改善节点表示。