基于模糊核判别分析的静态面部表情情绪识别方法

2023-11-02杨婷婷

杨婷婷

(安徽文达信息工程学院 计算机工程学院,安徽 合肥 231201)

引言

人脸面部表情是一个人最重要的面部特征,人脸表情中包含了丰富的行为信息,是个人情感表达的重要载体,人们可以通过面部表情表达自己的情感,并对外界信息作为反馈[1-2]。随着人工智能技术以及自动识别技术的发展,人们对于人机交互过程提出了更高的要求,如何使用计算机技术对于人脸面部表情进行识别成为人工智能领域研究的热点问题。通过文献分析可以看出,表情情绪识别是一门涉及计算机技术、社会学、生物学、情感识别的交叉型学科,其具有广泛的应用前景与发展潜力[3]。

在人脸表情情绪识别的过程中,存在大量难点。一方面人脸之间具备着明显的差异性,另一方面每个人的情绪表达特点不同。如何解决上述问题,完成高质量的人脸情绪识别一直是此领域中学者研究的重点问题。当前,大量的学者提出了静态面部表情情绪识别方法,但此部分方法在应用过程中无法对识别精度进行控制,导致识别结果可靠性不足[4-5]。针对此问题,在此次研究中提出了基于模糊核判别分析的静态面部表情情绪识别方法,采用模糊核判别分析技术优化表情类别划分环节,以此获取到可靠性更高的识别结果,提升表情情绪识别结果的应用性。

1 原始人脸图像采集

通过文献分析可知,使用相机获取人脸静态表情时,设备与拍摄对象会发生相对的位移,导致图像模糊[6]。在此情况下,假设表示人脸图像在曝光时间 的积分,则没有运动模糊与噪声干扰的图像可表示为:

根据此公式,得到逆滤波退化公式,则有:

在此次研究中,不计入噪声对图像的影响,取值结果为0,则有:

对上述计算内容进行整理,得到修复后的清晰图像:

由于在图像处理的过程中,需要克服信噪比[9]对图像的影响,因此在处理过程中增加一个计算常数,将其设定为,则公式(6)可以优化为:

使用上述公式,完成原始人脸图像的预处理工作,并将其作为后续图像处理分析的基础。

2 人脸表情情绪特征提取

当前人脸特征提取技术较多,针对此次研究目标,在此次研究中选择奇异值分解技术[10-11]完成表情情绪特征提取工作。

3 人脸表情情绪模糊核判别分析

在上文设计内容的基础上,使用模糊核判别分析技术,完成面部人脸表情情绪识别。文献研究结果发现,传统的模糊核判别分析技术不能反映真实的样本属性[13-14],因此,对传统的模糊核判别分析技术进行优化,弥补当前应用过程中的不足。

将处理后的图像整合到训练图像数据库中,并将此数据库设定为n维。假设图像库中的人脸表情可以划分为类,样本个数为,核映射处理完成后,核空间的样本形式为样本的第类情绪属性值为。此时,在此空间内情绪样本的类均值可表示为:

与此同时,根据当前图像处理要求,将表情情绪判别准则[15]设定为:

通过上述公式,根据提取到的人脸表情情绪特征,完成人脸表情情绪模糊核判别分析,实现人脸情绪识别过程。对上文设计内容进行整合,至此,基于模糊核判别分析的静态面部表情情绪识别方法设计完成。

4 实验论证分析

4.1 实验图像采集处理

本次实验中采用以往研究中使用的JAFFE表情图像库为此次方法应用实验提供图像来源,此图像库中包含由10 个对象构成的6 个基础表情以及部分派生表情共计500 张。采集到的原始图像大小统一为512*512 像素。此图像库完全开放,且表情标定较为合理,因此大部分实验均采用此图像库完成。在此次实验过程中,为降低实验难度,将图像中人物表情的眼睛作为原始图像的剪裁点,将图像按照均匀的尺寸调整为可直接分析的格式。在图像处理的过程中,不对图像的五官结构以及光照进行处理。裁剪后图像如图1 所示。

图1 实验图像数据集部分图像

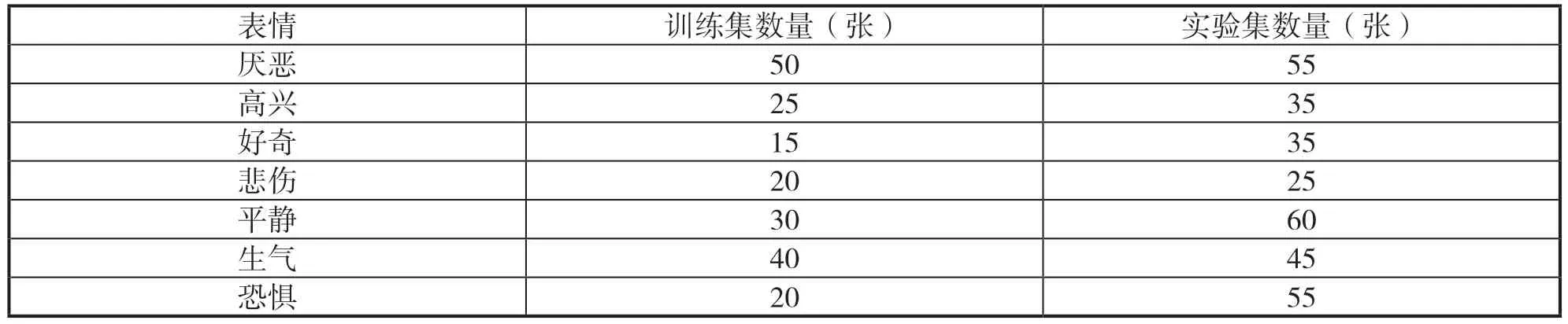

对实验图像集中的图像进行划分,随机选取200 张图像作为训练样本,剩余300 张图像作为测试图像。与此同时,对图像数据集中不同表情类型的图像个数进行划分,所得统计结果如表1 所示。

表1 实验图像集各类表情数量统计结果

对上述图像以及相关图像信息进行整理,将其作为此次研究中的基础,使用文中方法对图像中的情绪进行识别,确定文中方法的应用效果。为了更好地完成文中方法的实验与分析过程,选取局部特征表情情绪识别方法以及特征融合表情情绪识别方法与文中方法进行对比分析,以此全面分析文中方法与当前方法在应用过程中的差异。

4.2 五官结构关键信息提取结果

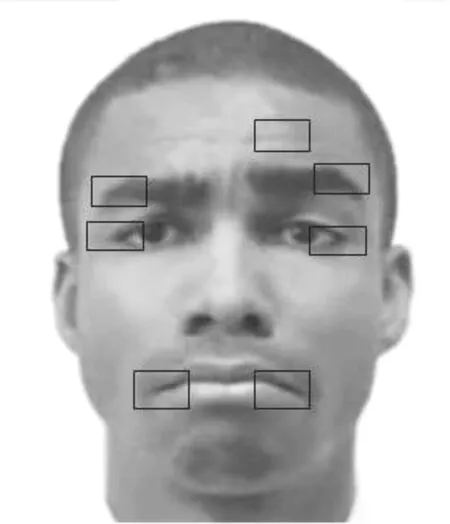

在表情情绪识别的训练与实验过程中,需要构建相应的图像分类器,以此完成图像表情的初始划分。分析大量实验案例后发现,在以往的研究中多采用五官结构关键信息提取结果作为图像分类器的基础,通过表情匹配的形式,构建表情标签,作为后续情绪识别的载体。为此,在此次实验过程中,将首先完成五官结构关键信息提取工作,对比不同方法的五官结构信息提取能力。由于实验图像库中的图像较多,选取一张较为复杂的图像作为目标图像,并对其进行提取。

如图2 所示,图像中的方框表示五官结构的关键信息。在此次实验中,使用标注点对目标图像中的五官信息进行提取,所得结果如图3 所示。

图2 目标图像

对图3 中标注点位置进行分析后可以看出,文中方法可以对图像中的五官关键信息进行准确地定位,同时还可确定人脸表情的中心位置。其他两种方法的五官信息定位提取能力相对较差,局部特征表情情绪识别方法对人脸表情的中心位置无法精准识别,特征融合表情情绪识别方法在对表情结构信息进行提取的过程中出现缺失,此两种方法的应用效果均不如文中方法,还需进行相应的改进。

4.3 表情信息匹配精度实验结果分析

获取五官结构关键信息后,将其与预设的表情特征进行匹配比对,完成初次表情划分。为了更好对比实验中三种方法表情信息匹配能力,使用特征信息之间的偏移值作为此能力的衡量标准,当偏移值取值结果越小时,说明此方法的表情信息匹配能力越好。偏移值计算公式设定如下:

图4 表情信息匹配精度实验结果

分析图4 可知,256 像素时,本文方法的表情信息匹配精度为97.0%,局部特征识别方法的表情信息匹配精度为93.6%,特征融合识别方法的表情信息匹配精度为92.8%;512 像素时,本文方法的表情信息匹配精度为96.1%,局部特征识别方法的表情信息匹配精度为94.9%,特征融合识别方法的表情信息匹配精度为91.5%;1080 像素时,本文方法的表情信息匹配精度为96.1%,局部特征识别方法的表情信息匹配精度为96.0%,特征融合识别方法的表情信息匹配精度为94.9%;对上图中内容进行分析可以看出,在不同的像素环境下,文中方法应用后的偏移值最低,且并没有出现波动,可见此方法应用效果较为稳定。与文中方法相比,其他两种方法的偏移值计算结果相对较大,且在不同的实验环境中波动较大。根据上述实验结果可以确定,文中方法的表情情绪提取与匹配精度优于其他两种方法。此结果也充分证实了,文中方法或者获取到更加优越的静态面部表情情绪识别结果。

4.4 静态面部表情情绪识别精度实验结果分析

根据预设实验方案以及上述两部分实验结果,得到最终静态面部表情情绪识别精度实验结果,具体数据如表2 所示。

表2 静态面部表情情绪识别精度

对表2 中数据进行分析可以看出,文中方法对于不同类型的情绪识别精度均优于其他两种方法。局部特征表情情绪识别方法与特征融合表情情绪识别方法对表情类型的依赖性相对较高,无法对全部类型的表情情绪进行识别,且两种方法的表情情绪识别精度并不能达到文中方法的识别精度。因此,整合上述实验结果可以确定文中方法的静态面部表情识别能力较高,在日后的研究中可将其作为情绪识别的核心方法。

5 结束语

本次研究在当前静态面部表情情绪识别方法的基础上,提出了更为先进的识别方法,并证实了此方法具有较好的应用效果。针对当前识别方法在应用过程中的不足,对表情情绪划分环节进行了优化与完善。在后续的研究中,还需对此方法中的其他环节进行完善,以此推动静态人脸研究领域的发展。