数据中心采用冷却塔间接自然冷却技术的能耗分析

2023-10-08陈艳超胡永亮

黄 英,梁 珍,陈艳超,李 洋,胡永亮

(1.东华大学 a.环境科学与工程学院,b.暖通空调研究所,上海 201620;2.中建一局集团安装工程有限公司,北京 102600)

随着互联网的兴起,作为海量数据的承载实体,数据中心的规模也随之高速增长,其能耗问题也随其规模的扩大而被广泛关注。2018年全球数据中心的耗电规模为205 TW·h,达全球用电总量的1%[1],预计至2024年,该数值将上升至5%~8%[2]。2019年我国数据中心用电量占全社会用电总量的0.8%~1.0%,预计到2030年,数据中心能源消耗量将占全社会用电量的1.5%~2.0%[3]。

国外数据中心平均电能利用效率(power usage effectiveness, PUE)已小于1.2[4],例如:雅虎的洛克波特镇鸡窝式数据中心的平均PUE值为1.08;Google的比利时数据中心的平均PUE值为1.16;Facebook瑞典数据中心的平均PUE值为1.15。至2019年底,我国超大型数据中心的平均PUE值为1.46,总体上较以前有较大提升,但仍低于相关政策要求的平均PUE值[5],节能问题亟待解决。

数据中心能耗问题涉及多方面,主要有IT设备、空调制冷系统、新风系统、照明系统、供配电系统等。其中空调制冷系统的能耗占数据中心的总电量的1/3左右,仅次于IT设备的能耗,对数据中心机房的能耗影响较大[6]。自然冷却技术利用室外冷空气或水对数据机房进行冷却,可大大降低机房能耗,节能效果明显[7]。

以中国移动某数据中心为研究对象,利用冷却塔间接自然冷却技术建立冷却塔间接自然冷却系统,采用TRNSYS软件对该系统进行模拟,比较分析北京、西安、杭州、昆明、广州5个城市的各类指标,如冷却系统在不同模式(完全自然冷却模式、混合制冷模式以及机械制冷模式)下的运行时长、能耗、平均PUE值、碳排放量等。

1 数据中心简介

1.1 建筑概况

所研究的数据中心的机房主体共2层,总建筑面积为22 233.46 m2,第一层建筑面积为12 349.74 m2,第二层建筑面积为9 756.64 m2,建筑高度为12.85 m。主要功能房间为IT设备区、空调设备区、电力电池区、高低压配电室等(见图1)。

1.2 负荷模型

数据中心机房冷负荷Q机房由围护结构冷负荷Q围护结构、照明负荷Q照明、IT设备热负荷QIT、人员冷负荷以及渗透负荷组成,根据数据中心的IT设备需全年不间断运行的特征,忽略人员冷负荷以及渗透负荷,即

Q机房=Q围护结构+Q照明+QIT

(1)

围护结构传入的热量较小,其冷负荷按式(2)计算。

Q围护结构=KF(tw-tn)

(2)

式中:K为围护结构传热系数[8],W/(m2·℃);F为围护结构计算面积,m2;tw为机房室外平均温度,℃;tn为机房室内计算温度,℃。

数据中心的IT设备部件,如服务器、配电单元(power distribution unit, PDU)、不间断电源(uninterruptible power supply, UPS)等都会产生大量热量,并消耗大量电力。服务器是数据中心热量的主要来源,其功耗取决于服务器工作时的负载率和精密空调的送风温度[8],并且周末服务器的负载率为平时的80%[9-10],考虑单个服务器在最不利的情况(即数据中心所有服务器满载运行)下工作,机房内服务器机架取选取4U型。服务器的发热量Pserver主要由服务器组件CPU产热P1以及冷却模块功耗P2组成[8],可以写为

Pserver=P1+P2

(3)

P1=a0+a1u+a2ea3td

(4)

P2=Psfan

(5)

P2=a7n+a8n2+a9n3

(6)

(7)

(8)

式中:a0~a9为拟合常数;R为CPU硅片的导热热阻;td为CPU的核心温度,℃;tin为服务器进口温度,℃;Psfan为服务器冷却风扇功耗,kW;u为服务器负载率,取1;n为冷却模块风扇转速,r/min。

不间断电源(UPS)和配电单元(PDU)产生的热损失主要包括空载下的消耗和部分负荷下的消耗,如式(9)~(12)所示。

PUPSLOSS=PUPSidle+πUPS∑PPDU

(9)

PUPSidle=5%PUPS

(10)

PPDULOSS=PPDUidle+πPDU(∑Pserver)2

(11)

PPDUidle=1.5%PPDU

(12)

式中:PUPSLOSS为UPS产生的热损失,kW;PUPSidle为UPS在空载运行下的功率损失,kW;πUPS为UPS的损耗系数,取0.05;PPDULOSS为PDU产生的热损失,kW;PPDUidle为PDU在空载运行下的功率损失,kW;πPDU为PDU的损耗系数,取0.000 075;PPDU为PDU在满载运行下的功率损失,kW,PUPS为UPS在满载运行下的功率损失,kW。

服务器机柜内组件(如服务器)的功率绝大部分转化为热,其热量计算如式(13)~(15)所示。

Q机柜=h1η1∑Pserver+PPDULoss

(13)

QUPS=h2PUPSLOSS

(14)

Q照明=q·A

(15)

式中:Q机柜为机柜服务器发热量,kW;QUPS为UPS发热量,kW;Q照明为照明设备发热量,kW;h1为负载均匀系数,取0.8;η1为发热效率,取0.99;h2为典型系数,取1;q为照明设备功率密度,W/m2,取30 W/m2;A为机房面积,m2。

机房内IT设备发热量QIT[11]为

QIT=h3(Q机柜+QUPS+Q照明)

(16)

式中:h3为综合保险系数,取1.2.

由式(1)计算得出机房总负荷为8 511 kW。由于服务器全年运行且是数据中心热量的主要来源,因此数据中心负荷基本稳定,不随外界温度变化而变化。

1.3 冷却系统简介

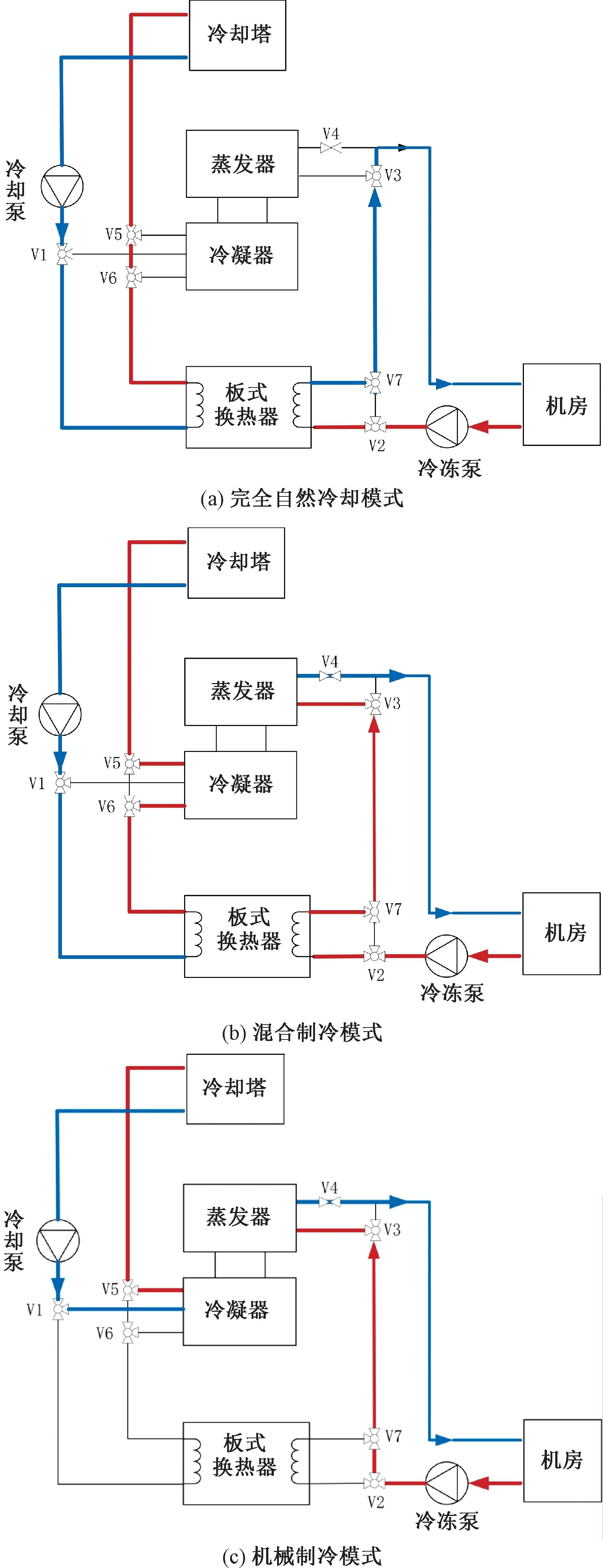

该数据中心冷却系统主要由冷却塔、冷水机组、板式换热器及水泵组成,如图2所示,其中,红线表示高温冷冻水或冷却水,蓝线表示低温冷冻水或冷却水。根据室外温度的变化情况,该系统设置3种模式,即完全自然冷却模式(冷量完全由冷却塔提供)、混合制冷模式(冷量由冷却塔与冷水机组共同提供)以及机械制冷模式(冷量完全由冷水机组提供)。本文采用的TRNSYS仿真软件是一种瞬时系统计算程序,其可根据不同的系统灵活组件模块建立连接,形成仿真平台。模拟气象数据由METEONORM软件提供。设定冷冻水供水温度、回水温度分别为7和12 ℃,系统模式的切换由切换温度决定,参照文献[4,12-14]中的切换温度,设定系统切换温度tset1、tset2分别为3和8 ℃。

图2 冷却系统原理图Fig.2 Schematic diagram of the cooling system

当室外湿球温度低于tset1时,系统启动完全自然冷却模式:阀门V1、V2、V3、V5、V6开启直通,关闭侧通;V7开启侧通,关闭直通;V4关闭。在该模式下,冷水机组关闭,板式换热器开启。高温的冷冻水经板式换热器换热降温后返回机房。热量经板式换热器送至冷却塔,最后散到室外。

当室外湿球温度高于tset1且小于tset2时,系统启动混合制冷模式:阀门V1、V2开启直通,关闭侧通;V3、V5、V6、V7开启侧通,关闭直通;V4开启。在该模式下,冷水机组与板式换热器均开启,高温冷冻水先经冷却塔预冷,再经冷水机组冷却,最后变成低温冷冻水送至机房。

当室外湿球温度大于tset2时,系统启动机械制冷模式:阀门V1、V2、V3、V5、V7开启侧通,关闭直通;V4开启。在该模式下,冷水机组开启,板式换热器关闭。高温的冷冻水经冷水机组换热降温,最后变成低温冷冻水返回机房。

2 模拟结果及讨论

2.1 运行时长分析

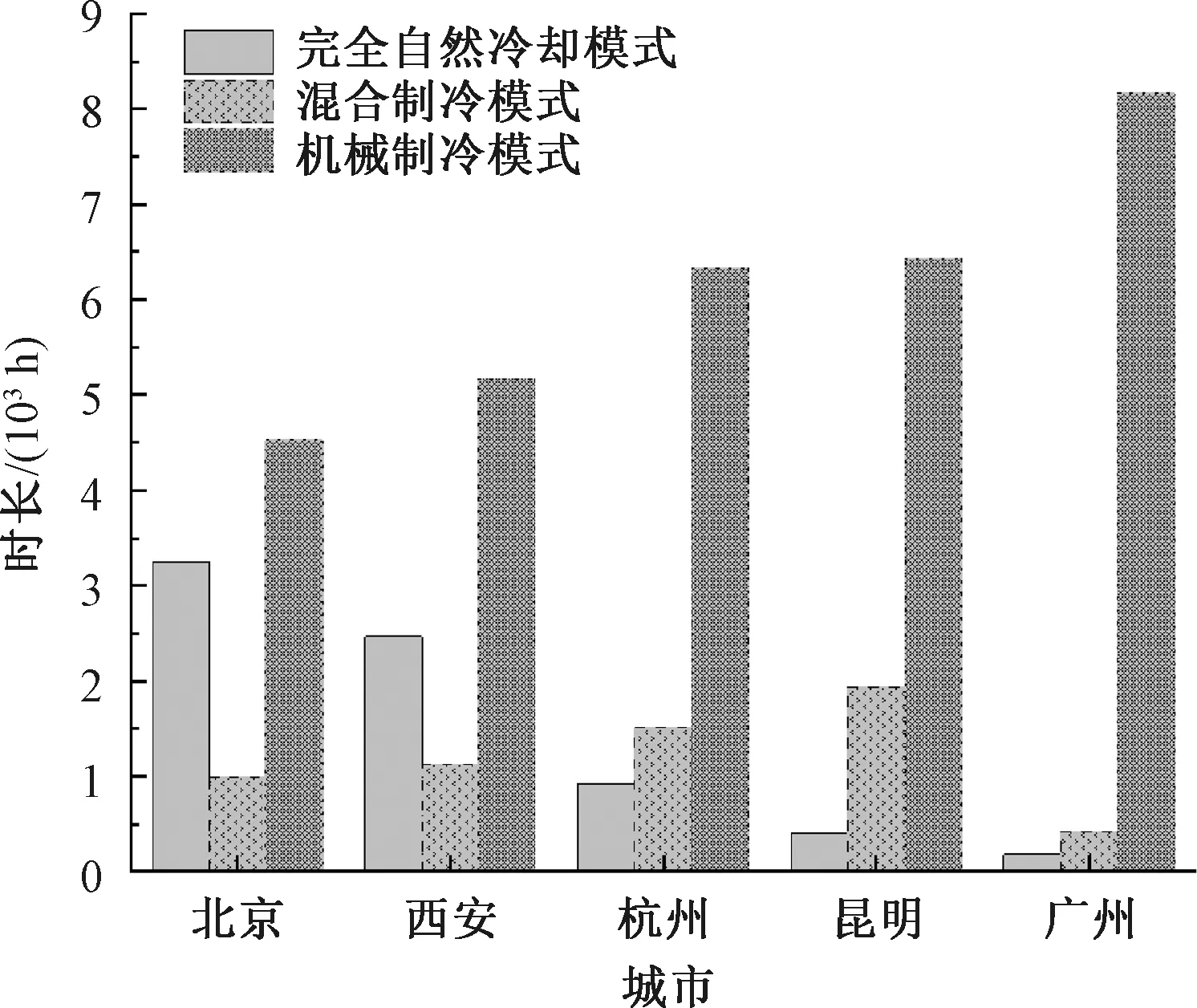

系统在不同模式下的运行时长会影响系统的能耗。完全自然冷却模式的运行时长越长,系统能耗越小;机械制冷模式的运行时长越长,系统能耗越大。以中国移动某数据中心为研究对象,结合北京、西安、杭州、昆明、广州5个城市室外湿球温度变化情况与该冷却系统切换温度,统计各地3种模式下的运行时长,探讨不同城市气候环境对数据中心系统的影响,结果如图3所示。

图3 不同城市冷却系统模式运行时长统计图Fig.3 Statistical chart of running time of each mode in different cities

由图3可以看出:完全自然冷却模式下,5个城市冷却系统的运行时长排序为北京>西安>杭州>昆明>广州;混合制冷模式下系统的运行时长排序为昆明>杭州>西安>北京>广州;机械制冷模式下系统的运行时长排序为广州>昆明>杭州>西安>北京。其中:北京在完全自然冷却模式下的运行时长为3 252 h,占全年时长的37.12%;昆明在混合制冷模式下的运行时长为1 930 h,占全年时长的22.03%;广州在机械制冷模式下的运行时长为8 162 h,占全年时长的93.17%。

2.2 能耗分析

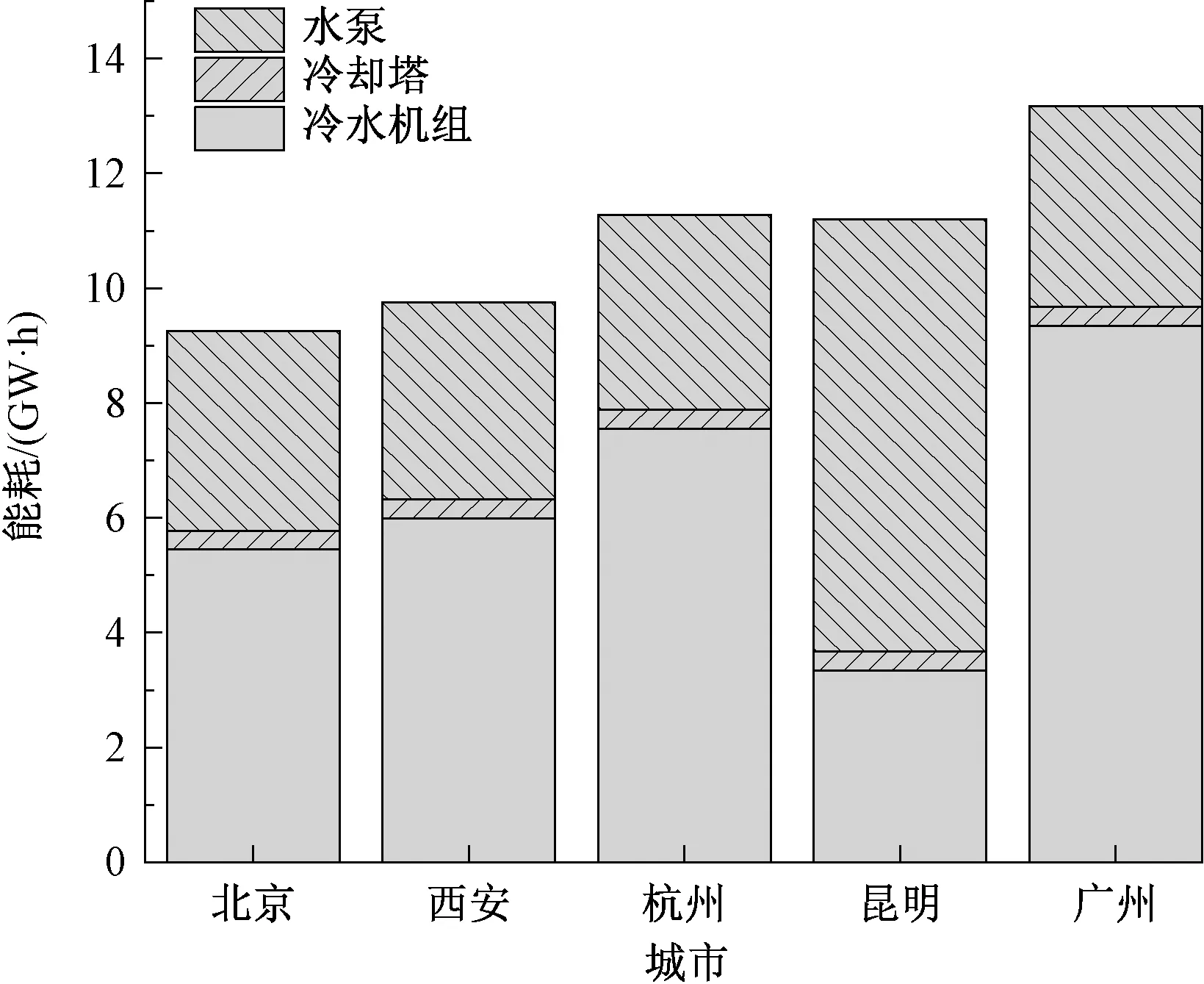

北京、西安、杭州、昆明、广州5大城市在该冷却系统下的能耗结果及系统组件能耗分布如图4所示。

图4 不同城市能耗结果及组件耗能分布Fig.4 Energy consumption results and component energy distribution in different cities

由图4可知,广州的能耗最大,北京的能耗最小。结合上文供冷时长可知:广州可提供冷却塔自然冷却的时长最少,机械制冷的时长最多,因此能耗最大,其中冷水机组能耗占冷却系统的70.95%;反之,北京处于寒冷地区,可提供冷却塔自然冷却的时长最多,因此能耗最小,其中冷水机组能耗占58.90%。此外,由图4还可以看出,5大城市的冷却系统的主要部件(水泵、冷却塔、冷水机组)的耗能也有所不同。北京、西安、杭州、广州的冷水机组能耗占比超过系统总能耗的一半,冷水机组为这4大城市冷却系统的主要耗能部件。而在昆明,水泵的能耗占67.26%,超过冷水机组(29.84%)。究其原因,在混合制冷模式下,昆明的供冷时长远大于其他城市,冷却水先经冷却塔冷却,再送入冷水机组,最后被送至机房,这显著减少了冷水机组的能耗,因此昆明的水泵能耗大于其冷水机组的能耗。

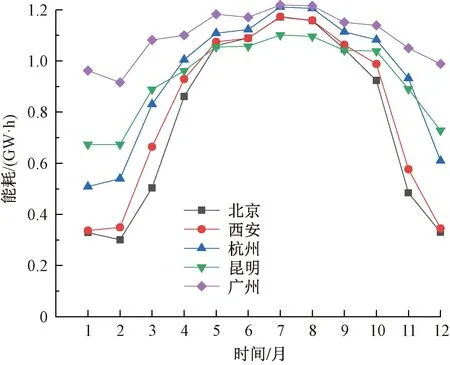

不同地区全年能耗变化如图5所示。由图5可知,北京、西安、杭州、昆明及广州的能耗变化趋势基本一致。能耗最低点出现在冬季(12月—次年2月),此时系统处于完全自然冷却模式或混合制冷模式,冷水机组耗能较小;能耗最高点出现在夏季(7—8月),此时系统处于机械制冷模式。

图5 不同城市全年能耗变化Fig.5 Annual energy consumption changes in different cities

平均PUE值即数据中心能源利用效率,为数据中心总能耗与IT设备总能耗的比值,即

(17)

式中:ηPUE为数据中心能源利用效率;Ptotal为数据中心总能耗,kW·h;PIT为IT设备能耗,kW·h。

由式(17)可知,PUE值越接近1,该数据中心越节能。目前,为了推动数据中心向绿色、低碳发展,多地政府发布PUE限值[15-16],如:北京市要求新建的云数据中心的PUE值不高于1.36,上海市要求新建互联网数据中心PUE值严格控制在1.3以下,等等。

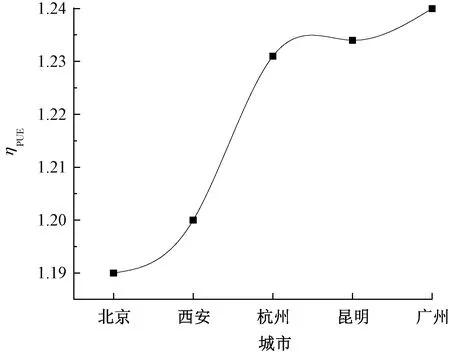

不同地区冷却系统平均PUE值如图6所示。由图6可知:北京的平均PUE值最低,为1.19;西安次之,为1.20;广州最高,为1.24。由此可见,该系统在北京最为节能,西安次之,广州节能性最差。结合上文可知,在完全自然冷却模式下,北京的运行时长远大于广州。因此,尽可能使用冷却塔间接自然冷却技术可使平均PUE值下降,从而使数据中心更加节能。

图6 不同城市系统平均PUE值Fig.6 System average PUE values in different cities

2.3 碳排放分析

2020年全国数据中心碳排放量达9 485万t[17],且机房机架规模持续增长,因此,高能耗建筑的数据中心是节能减排的关键。温室气体(CO2)是碳排放的主体,以温室气体排放量为依据进行碳排放分析。根据《上海市温室气体排放核算与报告技术文件》,温室气体排放总量由直接排放量与间接排放量组成,其中直接排放量包括燃烧排放和过程排放。由于本研究系统中无燃烧等过程,因此温室气体直接排放量为0。间接排放主要包括电力和热力排放,其计算如式(18)所示。

G=∑(s×κ)

(18)

式中:G为温室气体排放量,t;s为活动水平数据,指电力和热力等的消耗量,104kW·h;κ为排放因子,t/(104kW·h),取7.88 t/(104kW·h)。

不同地区温室气体排放量如图7所示。由图7可知,北京的温室气体排放量最低(16 207.10 t),其次为西安,杭州与昆明的温室气体排放量相近,广州最高(19 294.43 t)。相比之下,北京的温室气体排放量比广州低16%。综上所述可知,北京的碳排放量最低,广州最高。

3 结 论

利用TRNSYS软件建立数据中心的冷却系统,设计了3种模式(完全自然冷却、混合制冷及机械制冷),并对北京、西安、杭州、昆明及广州的能耗进行模拟、分析,比较这5大城市在不同冷却模式下冷却系统的运行时长、能耗、PUE值、碳排放量等差异。在该冷却塔间接自然冷却系统下:北京在完全自然冷却模式下的运行时长最长,广州最短,因此广州的能耗最大,北京最小;广州和北京的冷水机组耗能占比分别为70.95%、58.90%,冷水机组为这两大城市冷却系统的主要耗能部件;北京的平均PUE值最低(1.19),广州的平均PUE值最高(1.24);在碳排放方面,北京的碳排放量最低(温室气体排放量为16 207.10 t),广州的碳排放量最高(温室气体排放量为19 294.43 t),北京的温室气体排放量比广州低16%,该冷却塔间接自然冷却系统在北京的节能效果显著。

综上所述,建议数据中心选址地尽量避免夏热冬暖地区,尽可能延长完全自然冷却模式时间,利用室外免费冷却降低数据中心能耗及PUE值,从而减少碳排量,提高数据中心的节能效率。