跨文化传播中的人工智能:应用场景、伦理风险与治理路径

2023-09-16颜静曾道建

颜静 曾道建

摘 要:当前,人工智能技术在各大新闻和社交媒体中广泛应用,为信息传播带来了极大的便利,但也催生了交互过程中的支配、隐私、歧视等伦理问题。文章从传播过程出发,梳理了人工智能应用下跨文化传播内容的采集、生产、投放和管理的应用场景,分析其在技术实现和技术应用中,可能产生虚假信息和谣言的采集及传播、失业、算法歧视和偏见、隐私泄露、信息茧房、意识形态侵害等伦理风险,提出应加强内容筛选和审查机制、提高算法的透明度和可解释性,完善用户反馈和政府监管机制以及推进职工转岗和企业转型等建议。

关键词:跨文化传播;人工智能;新兴媒体;伦理风险;伦理治理

中图分类号:TP18;G206 文献标识码:A DOI:10.19881/j.cnki.1006-3676.2023.08.09

一、引言

人工智能(Artificial Intelligence,简称“AI”)是技術不断发展进步的成果,公认其起源于1956年,由约翰·麦卡锡(John McCarthy)等科学家在达特茅斯会议上提出。但时至今日,人工智能的定义仍没有统一界定。斯坦福大学人工智能研究中心N.J.尼尔逊教授认为,“人工智能是关于知识的科学”,所谓“知识的科学”就是研究知识的表示、知识的获取和知识的运用。[1]自1956年以来,人工智能的发展经历了3次浪潮,从快速发展到初步产业化,到如今信息时代催生下迎来的大规模爆发。大量的资金和人力投入到了人工智能的研发和应用中,人工智能的发展范围不断拓宽。

跨文化传播是指各种文化信息在时间和空间范围内流动、共享和互动的过程[2],其研究内容不仅包括不同文化背景中的个人、群体、组织和国家之间交往的特点和规律,也涉及文化冲突与解决的途径、技术发展对文化的影响等诸多方面。[3]在互联网时代背景下,当今文化信息的传播逐渐从大众传播演变为个体传播,由于技术的发展,传播媒介从过去单一的广播、电视、报纸的大众传媒发展到传统媒体与互联网新媒体共存的局面。相比于传统媒体,新媒体在主流外宣旗舰媒体、海外主流媒体和自媒体方面都充分发挥了传播优势,可以更好地实现系统性和网络化传播模式下人际传播和群体传播的互动性。[4]

根据拉斯韦尔提出的5W线性传播模式,传播的五项基本要素分别为“谁—说什么—通过什么渠道—对谁说—取得什么效果”,即传播主体、传播内容、传播渠道、传播受众和传播效果。[5]目前,人工智能技术在依据此五项传播要素划分的采集、生产、投放和管理场景下均有应用,大大提高了传播效率和精准性,但由于技术自身的缺陷和技术应用过程中的问题,也导致了支配、隐私、歧视等一系列伦理风险。笔者将从应用场景、伦理风险、治理路径3个方面对跨文化传播中的人工智能技术进行剖析和探讨,以期为人工智能技术助力跨文化传播研究提供参考借鉴。

二、人工智能在跨文化传播中的应用场景

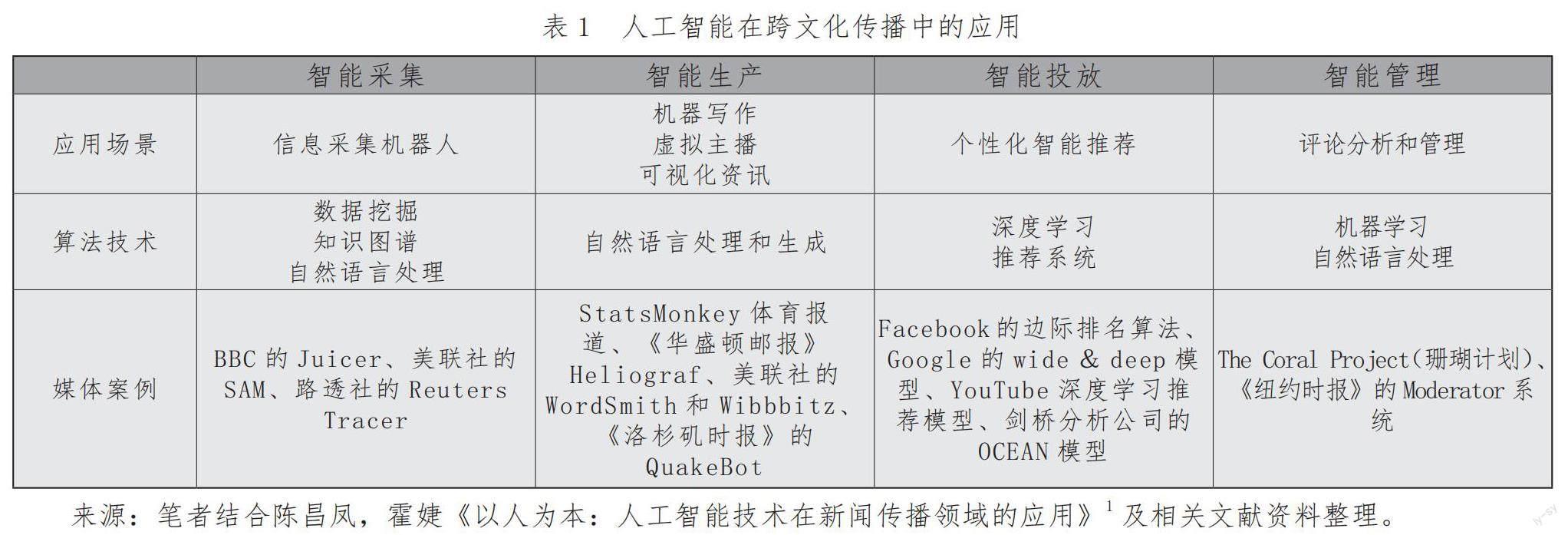

从传播的五要素和传播过程出发,可将人工智能在跨文化传播中的应用分为4个方面:对文化信息的智能采集、智能生产、智能投放以及智能管理。其中,智能采集和智能生产能有效解决传播主体的代表性和传播内容的真实性问题,而智能投放则保证传播渠道和传播受众的精准性,最后,智能管理再根据受体的反馈进一步对传播内容、传播渠道和传播受众进行提升和优化。其具体的应用场景、算法技术和媒体案例经梳理总结后,如表1所示。

(一)智能采集

在智能传播时代,信息采集告别了传统的人工统计方法而走向了借助人工智能和大数据的自动化方法。基于此,社交媒体和各个平台的新闻数据可以被快速高效地挖掘定位,得到智能化的采集后精准地用于媒体内容的生产和传播中。

以英国广播公司BBC为例,作为世界最大的新闻媒体之一,BBC运用人工智能建立了一个可以用于新闻聚合和内容提取的智能信息采集机器人Juicer,以监控国际、国内和地方新闻媒体的850个新闻源。在对新闻的原始文本和元数据进行抓取后,BBC Juicer应用命名实体识别技术对文本中提到的概念进行识别并标记,为媒体工作者提供信源、地点、人物和事件的智能检索以及国际传播上的趋势分析。[6]美联社也配置了相应的信息监控工具SAM。在SAM上,美联社的采编人员可以实时搜索和追踪原Twitter和其他社交媒体平台上的新闻线索,相对于人工手动来监控社交媒体的新闻而言,有效提高了采编的效率和水准。[7]路透社采用路透社追踪器(Reuters Tracer),吸收原Twitter的数据流来追踪新闻事件的发生,使用各种类型的数据挖掘技术,首先用聚类算法来寻找对话,再通过分类和排序来确定主题和优先级,准确获取新闻的标题和摘要。[8]

(二)智能生产

目前,在新闻媒体中,已出现大量机器写作、可视化新闻和虚拟主播等一系列利用人工智能手段进行新闻创作和生产的案例。其中,机器写作最先被提出并得到广泛应用。

机器写作运用人工智能算法将智能采集阶段收集的数据进行加工处理后自动生成稿件,其应用最早可以追溯到2009年,美国职业棒球赛上首次用StatsMonkey的人工软件完成了一篇体育报道。[9]随后的几年里,其他媒体也有如《华盛顿邮报》的写作机器人Heliograf,美联社的Wordsmith以及《洛杉矶时报》的QuakeBot等。以美联社所使用的Wordsmith为例,Wordsmith首先获取和分析需报道的对象的相关数据,将数据放到历时性的演变中来进行解读,再利用自然语言生成技术生成稿件。除此之外,美联社还有一大智能生产工具Wibbitz。Wibbitz是一个主打自动化视频创作的平台,即将文本转换为视频。无需任何人工帮助,Wibbitz能将一段纯文字文本自动转化成一段视频短片,短片的内容包括照片、旁白、图表等各种多媒体元素,转化步骤也是在分析用户上传的文本数据后,先生成简短的视频脚本,再根据脚本在短短几秒内自动将一系列照片或视频片段拼接起来,加上音效后形成一个内容完整且丰富的短视频。[10]

(三)智能投放

在媒体内容得到采集和生产后,基于人工智能算法的推荐系统可通过分析用户和其浏览的项目属性信息、浏览行为数据和用户社交网络信息等数据,实现个性化的内容推荐和投放。[11]

以Facebook为例,Facebook最初采用紧扣用户社交关系的边际排名算法(Edge Rank Algorithm)进行社交分发,算法涉及的核心要素分别是用户与内容发布者之间的亲密度分数,用户反馈动作以及内容发布时间的权重。从中可以看出,亲密度和用户反馈动作的引入优化了用户的社交体验,对于用户来说实现了更为精准地推荐。而在之后,Facebook也借助机器学习方法改进了排序算法,除了最初的3个Edge Rank因素之外,追加了如Story Bumping(对错过的信息进行二次判断)、Last Actor(根据最近频繁互动进行信息排序的调权)等新的特征和排序方式。[12]

2016年,Google将深度学习应用于推荐业务中,发表了wide&deep模型[13],YouTube也同样推出了深度学习推荐模型。在YouTube深度学习推荐模型中,整个流程被分成了两步,即候选集生成和候选集排序。生成阶段基于YouTube用户的使用行为和兴趣偏好,为用户生成几百个候选视频集,候选视频集进而在排序阶段通过更多的特征维度得到评分和排序,最后选出推荐结果。[14]另一个典型的智能投放案例,是剑桥分析公司的OCEAN模型。剑桥分析运用经典的五大人格分类法推导出一个量型工具,来探知人们潜在的心理特征和个性。通过“经验开放性”“尽责性”“外向性”“亲和性”以及“情绪不稳定性”五个维度精确地为一个人建立心理学轮廓档案[15],定量描绘其性格,进而推断其政治倾向,从而找到价值观相似的国际受众,并利用大数据技术,实现目标用户的精准定位投放。

(四)智能管理

智能管理作为智能化传播的最后一个环节,常通过对用户的反馈进行挖掘分析,以调整采集、生产和投放,提高传播效率,同时也为舆情管理和虚假信息治理提供依据。

一般来说,用户评论是用户反馈最直接的体现,因此智能管理一般从评论分析入手。美国《纽约时报》就率先应用了智能技术来管理评论。2015年,《纽约时报》与谷歌公司旗下的Jigsaw合作创建了The Coral Project(珊瑚计划),该计划依靠人工智能算法对用户进行分级画像,并以此决定哪些用户的评论不必通过审查就可以发布和置顶显示。2017年,《纽约时报》为了对其新闻的评论区进行进一步的管理,使用了Google开发的人工智能系统Moderator。通过对《纽约时报》10年内评论区里人工管理的超千万条评论进行学习,Moderator建立起了能够优化管理评论区的算法,该算法可以识别和筛除恶意评论,保证了评论区内容的友好性。[16]

三、跨文化传播场景下人工智能的伦理风险

伦理指的是处理人与人、人与社会以及人与自然的关系时应遵循的行为准则,是法律制度等具体规范的制定依据,也是与之并列的社会规范。[17]在人工智能领域,涉及的伦理风险分为两个方面,一是在人工智能的主体性上,二是在其技术实现和应用上。人工智能主体性的伦理风险在于其是否拥有自由意志,和根据伦理准则做出决策的能力。当前学者普遍认为,人工智能仍处于弱人工智能阶段,其视觉识别、智能语音、自然语言处理、机器学习等功能只限于单纯对外界信息进行输入与反馈,尚不具备人类情感与自主意识,也不能够根据情境作出像人一样的智能反应。[18-19]因此,对于人工智能主体性的伦理风险,只能对其进行预防,伦理风险的重点在于人工智能技术的实现和应用上。

(一)成因分析

当前背景下,人工智能的伦理风险主要体现在技术实现和技术应用上。在技术实现方面,由于人工智能技术尚未发展完善,本身具有一定的局限性,因此导致事故频发。[20]2022年4月,中国信息通信研究院发布的《人工智能白皮书(2022)》指出:“以深度学习为核心的人工智能技术正在不断暴露出由其自身特性引发的风险隐患。”[21]人工智能技术由于以深度学习模型为核心,存在着脆弱性、复杂性以及过度依赖训练数据的缺陷。脆弱性在于人工算法容易存在安全漏洞,导致拥有被攻击和恶意利用的风险。复杂性是指深度学习模型作为黑盒模型,缺乏可解释性,导致人类的主体地位和知情利益受到损害。而训练数据作为模型的学习样本,具有偏见的数据集将直接导致模型产生歧视性的决策结果。因而,技术的本身实现导致其拥有不可信、不透明以及歧视这3种风险。

技术应用方面引发的人工智能伦理问题,主要是人工智能算法的滥用和误用导致的支配、隐私和失业问题。首先,人工智能的数据挖掘和分析可以揭示用户的潜在需求和行為模式,从而给出相应的意见或建议,但如果这些信息未经审查被滥用或误用,就可能产生支配问题。例如,一些算法可能被用于操纵用户的意见和行为,从而塑造用户的决策,这在政治或商业竞争中可能带来风险。其次,大数据背景下,人工智能系统通过跟踪用户的行为、兴趣和偏好,可以收集到大量个人信息数据。并且,对个人的数据采集过程往往不会被监控的对象所知晓,个人隐私信息在人工智能数据挖掘过程中无所遁形。[22-23]虽然这些数据在一定程度上用于提供个性化服务和增强用户体验,但同时也引发了隐私泄露的担忧。再次,大规模的自动化和智能化生产,也可能导致传统工作岗位被人工智能所取代,引发失业问题。人工智能技术的广泛应用提高了工作效率,但同时也带来了失业等不利后果。[24]由此可见,人工智能不仅在技术实现上引发伦理风险,也在技术应用上冲击传统的社会秩序。

(二)伦理风险

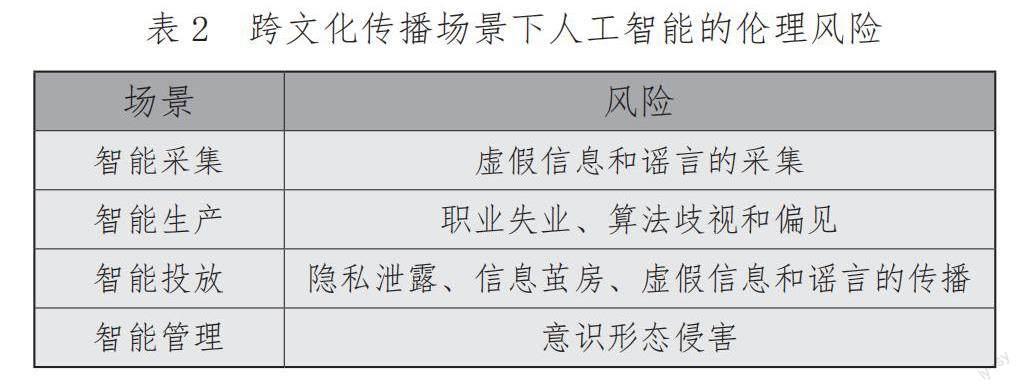

根据伦理风险的形成原因,并结合具体的跨文化传播场景来看,人工智能技术导致的传播过程中,主要存在虚假信息和谣言的采集及传播、职业失业、算法歧视和偏见、隐私泄露、信息茧房以及意识形态侵害等伦理风险。

如表2所示,智能采集和智能投放技术可能会导致虚假信息和谣言的采集以及大规模传播,不仅会影响公共舆论,还可能会对个人和社会造成实质性的伤害。智能生产依赖模型的训练语料,在学习充满歧视和偏见的语料时,生产内容也会产生歧视和偏见。同时,生产环节在一定程度上可以取代人工创作,导致创作者失业。为实现精准推荐,智能投放需对用户的历史数据进行深入挖掘,可能导致对个人数据的过度收集和隐私泄露的风险。而推送内容的同质化,也易形成“信息茧房”,限制了用户的主观能动性。智能管理技术可能会对用户的言论自由和表达自由进行限制和干预,对社会和文化多样性造成负面影响。

四、跨文化传播中人工智能伦理的治理路径

在跨文化传播场景下,由于人工智能尚未发展成“强人工智能”,人工智能的伦理风险仍主要体现在人工智能技术的实现与运用上,包括传播内容采集阶段的虚假信息和谣言的采集,内容生产导致的职业失业、算法歧视和偏见,内容投放带来的隐私泄露、信息茧房和虚假信息和谣言的进一步传播,以及内容管理对意识形态的侵害与威胁。在此背景下,加强内容筛选和审查机制,提高算法的透明度和可解释性,完善用户反馈和政府监管机制,以及推进职工转岗和企业转型,是治理人工智能伦理风险的可行路径。

(一)加强内容筛选和审查机制

首先,提高智能采集系统对虚假信息和谣言的辨别能力。在启用人工智能技术来检测虚假信息和谣言的同时,增加人工审核的环节,确保采集的内容准确可靠。可通过与权威机构的合作,共同对虚假信息和谣言进行辟谣和警示。其次,在构建智能生产系统的训练数据集时,关注其中可能存在的偏差。在跨文化传播场景下,数据样本可能来自不同国家、地区和文化背景。因此,应验证数据的多样性和公正性,并通过采用多种数据源以及公平原则等方式解决训练数据的偏差和歧视问题。最后,对于智能管理应用,应建立公正、透明和权威的内容审查和管理机构,并采用多方参与的决策模式,确保不偏袒某一特定观点或政治势力。

(二)提高算法的透明度和可解释性

欧盟在2019年4月发布的《可信赖人工智能伦理准则》指出,要确保人工智能系统在研发、部署和使用时符合可信赖人工智能的7个关键要求,即人类的能动性和人类监督、技术的稳健性和安全性、隐私保护和数据管理、透明性、多样性以及非歧视和公平、有利于环境和社会福祉、可问责性。[25]可见,保障个人隐私和算法的透明性是治理人工智能风险的重要方面。提高模型算法的透明度和可解释性,使其能够解释其决策和预测的依据,有助于发现和纠正模型中的偏见,并增加用户对模型的信任度。对于个人隐私数据,应明确收集、使用和共享个人数据的权限和规范,并提供更多的用户个性化隐私设置,让用户有更大的控制权。

(三)完善用户反馈和政府监管机制

为治理智能投放构建的信息茧房以及智能管理可能导致的意识形态侵害问题,网站平台还应提倡用户参与,鼓励用户提交推送意见和对于评论区建设的建议,确保平台的多元化和开放性。同时,政府、组织和行业应建立相应的监管和监督机制,以国家层面的伦理准则为基础,明确人工智能技术在传播过程中需要遵循的道德规范和价值观,对算法模型的训练和应用过程进行监督和管理,确保模型的正当性和公平性,保障用户的权益,引导各大平台系统营造有序竞争的良好氛围。

(四)推进职工转岗和企业转型

针对智能生产引发的失业问题,政府和企业应共同采取解决措施。政府方面应制定和执行相关政策和法规,以创造就业机会和解决失业问题。同时,提供经济支持和资源,用于转岗培训、职业咨询和创业支持等,并出台相关政策以更新教育体系,培养适应新技术和就业需求的人才。企业可积极参与转型和技能培训,为受影响的员工提供转岗机会和培训计划,并可通过技术创新,探索新的商业模式和就业机会。

五、结语

总的来说,人工智能技术的发展为媒体应用创新和跨文化传播注入了活力,为传播内容的采集、生产、投放和管理提供了新的动能,但也引发了虚假信息和谣言的采集及传播、职业失业、算法歧视和偏见、隐私泄露、信息茧房、意识形态侵害等伦理风险。根据伦理风险在技术实现和技术应用上的形成原因,并结合跨文化传播场景,可以从加强内容筛选和审查机制,提高算法的透明度和可解释性,完善用户反馈和政府监管机制以及推进职工转岗和企业转型这四个方面,实现对人工智能伦理风险的治理,完善智能化的传播过程,使跨文化传播的内容得到更具代表性的采集、更优质的生产、更精确的投放和更人性化的管理。

注释:

1. 数据来源:陈昌凤,霍婕《以人为本:人工智能技术在新闻传播领域的应用》将“人工智能技术在新闻传统流程中的应用”分为新闻采写、新闻编辑、新闻分发和评论管理,并從应用、技术、案例3个方面阐述。

参考文献:

[1] 李德毅,于剑.中国人工智能学会.人工智能导论[M].北京:中国科学技术出版社,2018:2.

[2] 段龙江.我国跨文化传播的困境与优化路径[J].人民论坛,2021(14):98-100.

[3] 孙英春.跨文化传播学导论[M].北京:北京大学出版社,2008:1.

[4] 王绚.新时代中国文化和谐价值观的跨文化传播[J].新闻爱好者,2023(04):62-64.

[5] 郭庆光.传播学教程(第二版)[M].北京:中国人民大学出版社,2011:54-55.

[6] BBC NEWS LABS.The Juicer[EB/OL].(2012-03-02)[2023-05-16].https://bbcnewslabs.co.uk/projects/juicer/.

[7] 邱凌.加速与重塑:国际新闻业对人工智能的创新应用及未来趋势[J].中国出版,2021(05):51-55.

[8] 36氪.用AI追熱点,自动化编辑新闻,路透社已经这么做了[EB/OL].(2017-12-13)[2023-05-16].https://www.36kr.com/p/1722057900033.

[9] 耿磊.机器人写稿的现状与前景[J].新闻战线,2018(01):43-46.

[10] 搜狐网.美联社:AI深度嵌入新闻生产各个环节[EB/OL].(2018-11-27)[2023-05-16].https://www.sohu.com/a/278112906_644338.

[11] 刘华真,王巍,谷壬倩,等.基于用户浏览行为的个性化推荐研究综述[J].计算机应用研究,2021(08):2268-2277.

[12] 闫泽华.内容算法:把内容变成价值的效率系统[M].北京:中信出版社,2018:118-119.

[13] Cheng H T,Koc L,Harmsen J,et al.Wide&Deep Learning for Recommender Systems[C]//Proceedings of the 1st Workshop on Deep Learning for Recommender Systems(DLRS 2016).New York:Association for Computing Machinery,2016:7-10.

[14] Covington P,Adams J,Sargin E.Deep Neural Networks for YouTube Recommendations[C]//Proceedings of the 10th ACM Conference on Recommender Systems(RecSys16).New York:Association for Computing Machinery,2016:191-198.

[15] 邵国松.心理绘图与用户画像:剑桥分析的兴亡启示录[J].传媒观察,2021(11):45-49.

[16] 陈昌凤,霍婕.以人为本:人工智能技术在新闻传播领域的应用[J].新闻与写作,2018(08):54-59.

[17] 陈磊,王柏村,黄思翰,等.人工智能伦理准则与治理体系:发展现状和战略建议[J].科技管理研究,2021(06):193-200.

[18] 莫宏伟.强人工智能与弱人工智能的伦理问题思考[J].科学与社会,2018(01):14-24.

[19] 李雨青.人工智能风险治理政策比较[D].广州:华南理工大学,2021.

[20] 董子涵,任凤琴.困境与超越:人工智能的伦理审视[J].科技智囊,2023(06):65-70.

[21] 中国信息通信研究院.人工智能白皮书(2022年)[R].北京:中国信息通信研究院,2022.

[22] 戴春勤,贾文琪.数字化发展存在的伦理问题及应对策略[J].科技智囊,2023(03):70-76.

[23] 潘恩荣,孙宗岭.人工智能“以人为本”伦理准则反思—一种马克思主义哲学的分析思路[J].云南社会科学,2022(06):30-39.

[24] 张媛媛.人工智能对人类智能影响的伦理反思[D].大连:大连理工大学,2020.

[25] 谷兆阳,刘秀丽,钱春雁.可信赖人工智能的伦理准则[J].人工智能法学研究,2021(01):160-210.

Artificial Intelligence in Cross-cultural Communication:Application Scenarios, Ethical Risks, and Governance Paths

Yan Jing1 Zeng Daojian2,3

(1.Foreign Studies College of Hunan Normal University,Hunan,Changsha,410081;2.College of Information Science and Engineering,Hunan Normal University,Hunan,Changsha,410081;3.Research Institute of Languages and Cultures,Hunan Normal University,Hunan,Changsha,410081)

Abstract:At present,artificial intelligence technology is widely used in major news and social media,which brings great convenience for information dissemination,but also gives rise to ethical issues such as dominance,privacy and discrimination problem in the process of interaction. Starting from the process of communication,the article sorts out the application scenarios of the collection,production,delivery and management of cross-cultural communication content under the application of artificial intelligence,and analyzes the ethical risks such as the collection and dissemination of false information and rumors,job unemployment,algorithm discrimination and prejudice,privacy leakage,information cocoon,ideological infringement and other ethical risks that may be generated in the process of technology implementation and technology application,and proposes to strengthen content screening and review mechanisms,improve the transparency and interpretability of algorithms,consummate user feedback and government regulatory mechanisms,and promote employee transfer and enterprise transformation.

Key words:Cross-cultural communication;Artificial intelligence;New media;Ethical risks;Ethical governance