南京航空航天大学算力服务模式探索

2023-08-15刘佳王兴虎张玉

文 / 刘佳 王兴虎 张玉

科学计算已成为与理论分析和科学实验并列的第三种科学研究方法,是促进重大科学发现和社会经济发展的战略性支撑技术。高性能计算中心是利用高性能计算平台和技术开展科学计算、支撑科技创新的基地,对于推动科学研究、工程应用和经济发展具有不可或缺的作用。

2020年,南京航空航天大学(简称“南航”)正式成立校级高性能计算中心,以“服务科研应用,兼顾教学实验”为工作导向,结合校情完成一期建设并投入运行,并且在运维管理、科研服务、课程开发等方面开展了一系列有益的实践与探索。

建设背景

南京航空航天大学作为一所以工为主、理工结合、多学科协调发展、具有航空航天民航特色的研究型大学,对高性能计算有着天然且旺盛的应用需求,但却长期为以下问题所困扰:

1.建设和管理的主体不明确,缺乏统一规划;

2.整体计算资源匮乏,只有少量院系或课题组建设了计算集群,且以自用为主,算力有限,地点分散,配置差异大,难以共享;

3.经费少的院系无力独自承担计算集群的建设、使用和维护工作;

4.计算集群多由非专业人员管理,应用水平低,安全风险高;

5.计算集群多由教师和研究生使用,本科生基本无缘接触此类设备。

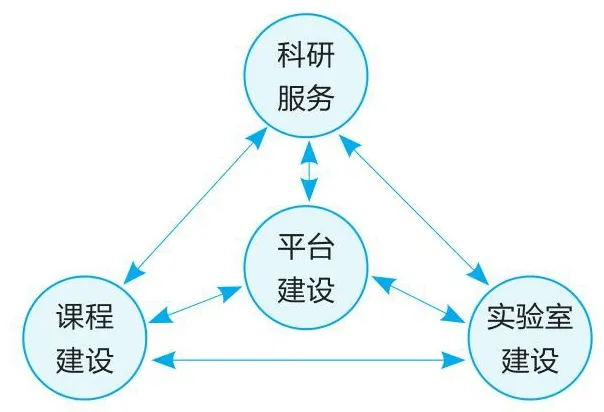

为推动学科发展,促进创新研究,满足师生对高性能计算资源和服务的迫切需求,南航以“服务科研应用,兼顾教学实验”为工作导向,由信息化处负责,从平台建设、科研服务、课程建设和实验室建设4个方面打造校级高性能计算中心(简称“中心”)。中心建设构架见图1,其中:

图1 高性能计算中心建设构架

1.平台建设重点在于建立校级高性能计算平台,合理购置和部署相关软硬件,开展人员培训,是中心建设的根基和载体;

2.科研服务重点在于根据学校学科建设的要求和特点,为科研项目和工程应用提供计算资源、部署计算软件,以及其他相关的技术支持和服务;

3.课程建设重点在于沿着高性能计算的行业应用和技术发展两条主线,由浅入深开设课程,推动高性能计算在学校的教学发展;

4.实验室建设重点在于一方面辅助课程建设,开设相应的实验课程;另一方面为师生提供高性能计算环境和培训,推动自主创新活动。

平台建设

平台架构

高性能计算平台是整个高性能计算中心的核心,是融合了计算、网络、存储和软件的综合体系。南航高性能计算平台(下文简称“平台”)一期采用浪潮天梭TS10000集群,整体架构见图2。

图2 高性能计算平台架构

师生用户通过网络远程登录到平台的管理节点上提交计算作业;作业调度系统根据计算作业的请求分配计算资源,执行和管理计算作业;计算结果保存在存储系统中,供用户取回和处理。

计算资源

平台的计算资源包括:

1.CPU节点62个,每个节点配置2颗Intel Xeon 6248 20核2.5GHz处理器;其中33个节点配置192GB内存,29个节点配置384G内存。

2.GPU节点31个,其中29个为4卡节点,每个节点配置2颗Intel Xeon 4210 10核2.4GHz处理器、192GB内存、4块NVIDIA Tesla V100 32GB GPU卡;2个为8卡节点,每个节点配置2颗Intel Xeon 6248 20核2.5GHz处理器、192GB内存、8块NVIDIA Tesla V100 32GB GPU卡。

平台的理论双精度峰值浮点计算能力达到1173.3Tflops,其中CPU部分249.3Tflops,GPU部分924Tflops。

网络系统

平台的网络系统包括100G计算网、万兆带内管理网和千兆带外IPMI网3套网络。

1.100G计算网以1台Mellanox QM8790 InfiniBand交换机为核心,配备HDR 200G/s端口,采用Splitter Cables连接HDR100 100G/s端口,实现所有计算节点和存储节点之间100G高速互联。

2.万兆带内管理网采用3台48口万兆接入交换机,实现所有节点10G接入,并通过40G端口上连至1台汇聚交换机实现集群互通。在计算网出现故障时,万兆带内管理网可以作为临时的计算网络,保障计算作业正常运行。

3.IPMI网采用3台48口千兆接入交换机,下连至各节点BMC独立管理端口,并通过10G端口上连至汇聚交换机,实现集群IPMI管理互通。

存储系统

平台的存储系统采用联想DSS-G220存储系统,包含2台SR650 IO节点及4台磁盘扩展柜,裸容量达1PB。通过GPFS文件系统实现高性能IO,读写带宽均可达20GB/s。

软件资源

平台选用CentOS 7.6 64位版操作系统,使用Slurm作业调度系统管理计算作业,将用户请求的计算作业分配到合适的计算节点上运行。

平台部署了高性能计算必需的集群并行环境、编译调试环境和开发软件包,安装了学校各学科领域常用的开源或商用软件,并对常用软件配置了modulefile以方便加载应用软件所需的环境变量。

平台管理系统(见图3)提供用户管理、计费管理、作业管理、资产管理等模块,实时监控计算资源的分配占用、计算作业的运行调度、计算设备的工作情况等数据。

图3 高性能计算平台管理系统

机房环境监控系统负责监控机房的温湿度、用电量、水浸、烟火、电力配送、UPS、精密空调、备用电池等数据或设备,是保障安全和实现高性能计算平台高可用的重要系统。其提供的数据还是平台系统调优、节能降耗的重要依据。

运维管理

制度建设

为保障平台安全、平稳、有效运行,信息化处发布和实施了一系列规章制度,主要包括《高性能计算平台服务管理办法》《高性能计算中心机房安全管理规定》《高性能计算室管理条例》等,从不同层次、不同角度规范了平台的服务和管理。

运维模式

鉴于中心成立时间短且事项繁杂,专职人员少且较难招募,运维管理采用了“校内专人+服务外包”的模式。

校内专人:由学校在职人员专职从事中心和平台的管理工作,包括:设备现场巡检;用户的开户激活、协议签订、费用结算、技术支持;学校相关政策和制度的制定、执行和解答等。校内专人具有航空航天学科背景和学术能力,同时具备高性能计算的使用经验,既可以从专业角度帮助指导用户开展计算工作,又可以在师生用户和运维团队之间起到沟通桥梁的作用。

服务外包:由专业的高性能计算服务厂商承担平台的运维工作,包括:设备远程和现场巡检;平台管理、作业调度等系统的维护与开发;计算软件的安装与维护;用户技术支持与培训,如作业脚本纠错、失败作业分析、计算软件测试运行等。

用户管理

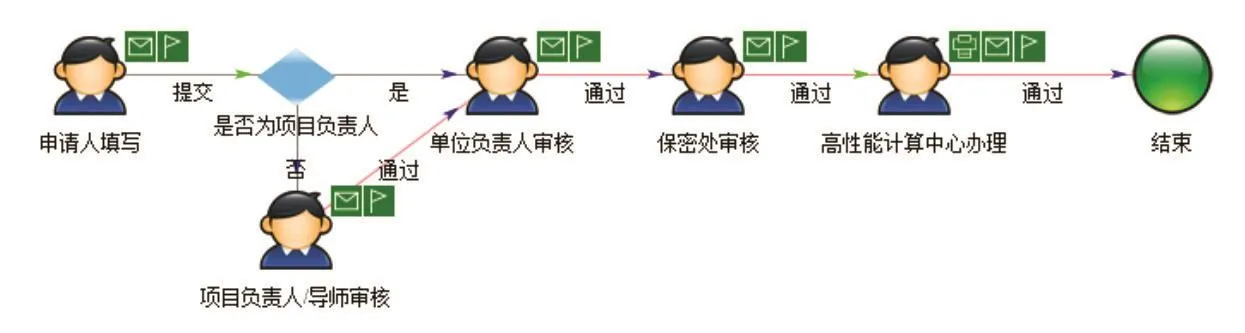

用户通过学校网上办事大厅“高性能计算平台用户申请”流程申请开户,登记项目信息和软硬件需求,并与中心签订使用协议,以获得平台使用权。开户流程见图4。

图4 高性能计算平台用户申请流程

平台将为用户建立独立的访问目录,用户之间相互隔离,不能访问他人的目录和作业内容。用户可以在自己的目录中上传、下载数据文件,提交计算作业,也可以安装计算所需要的软件,而不使用平台提供的软件版本。用户必须通过作业管理系统提交作业、查询计算队列和计算结果,严禁绕过作业管理系统使用计算资源。

服务模式

科研服务

中心提供的科研服务包括科学计算和仿真计算,覆盖学校所有理工科学院、科研技术部门和部分文科学院。服务内容主要包括:

1.一对一技术支持:中心为每个签订使用协议的老师设立用户组(老师及其学生各自拥有独立的平台账号,但归于同一个用户组之下),单独建立微信群,在微信群里配置学校专职人员和运维厂商技术人员,指导用户正确合理地使用平台,帮助用户解决计算中出现的各类问题,提高技术支持的针对性和时效性。

2.定期提醒:定期检查运行中的计算作业,根据各个用户组的计算作业特点对超时的长任务(如计算时常超过1个月)或者出现错误的计算作业,及时提醒用户检查作业情况,终止错误作业,节约计算经费。

3.用户培训:通过多种形式培训用户,包括在中心官网发布和及时修订平台资源信息和用户手册,定期开展线下用户培训等活动。

4.图形化节点:针对多数仿真计算用户使用图形化软件进行仿真建模和结果数据处理等工作的习惯,平台单独配置1个图形化节点,与存储系统打通,安装带GUI的CentOS系统以及常用仿真软件的图形化版本,使用体验与Windows版本一致。用户远程登录此节点,便可以直接在平台上处理模型和计算数据,取回处理后的结果数据或图形图像,既符合用户的操作习惯,又节省了下载和处理数据的时间,解决了数据量过大时用户难以下载到本地处理等问题。

5.计算室建设:配合南航“一校两地四区”的办学格局,为各学院建设了20个高性能计算室,通过独立光纤与平台直接连接,实现高速稳定的网络接入,解决通过校园网等公共网络访问平台时用户多、网速慢的问题。

教学服务

除了为《云计算》《人工智能》《分布与并行计算》等课程提供教学和实验平台,中心还积极探索新工科背景下的新型教学思路,推进本科生高性能计算相关课程实践,与公共实验教学部协同,面向学校长空学院开展“高性能计算平台探索”教学活动。

活动包括参观高性能计算中心、高性能计算宣讲、计算作业操作演示等环节,每次安排本科生70人,时间1.5小时,共有800多人参加,通过体验科学计算和工程应用案例,提高了本科生对高性能计算的认知水平。中心还为100多名本科生安排了1.5小时的上机操作课程,让学生亲自执行计算作业,体会平台的计算能力和使用的难易程度,破除学生眼中高性能计算的神秘感,推广平台应用。

大型仪器共享

中心本着“坚持共享原则,打通共享渠道,实现共享结算,降低使用成本”的原则,在平台建设伊始就积极参与学校大型仪器设备共享工作。与国资处协调制定了平台收费标准、使用与结算流程(见图5),并与学校大型仪器设备共享平台(简称“大仪平台”)同期建设,完成了“高性能计算平台->大仪平台->财务平台”的无缝对接,成为最早落地大仪平台,落实大仪共享的校级平台。

图5 高性能计算平台使用及结算流程

通过向大仪平台定时推送计算日志数据等技术手段,实现了:1.计算作业查询与统计、账单制作与结算、服务协议管理等功能;2.基于用户组的多种使用模式的作业计费;3.“高性能计算平台使用->大仪平台结算->财务平台缴费”全流程管理。通过开放共享,平台实际使用机时、经费结算等指标在学校大型仪器设备中遥遥领先。

运营情况分析

申请使用情况

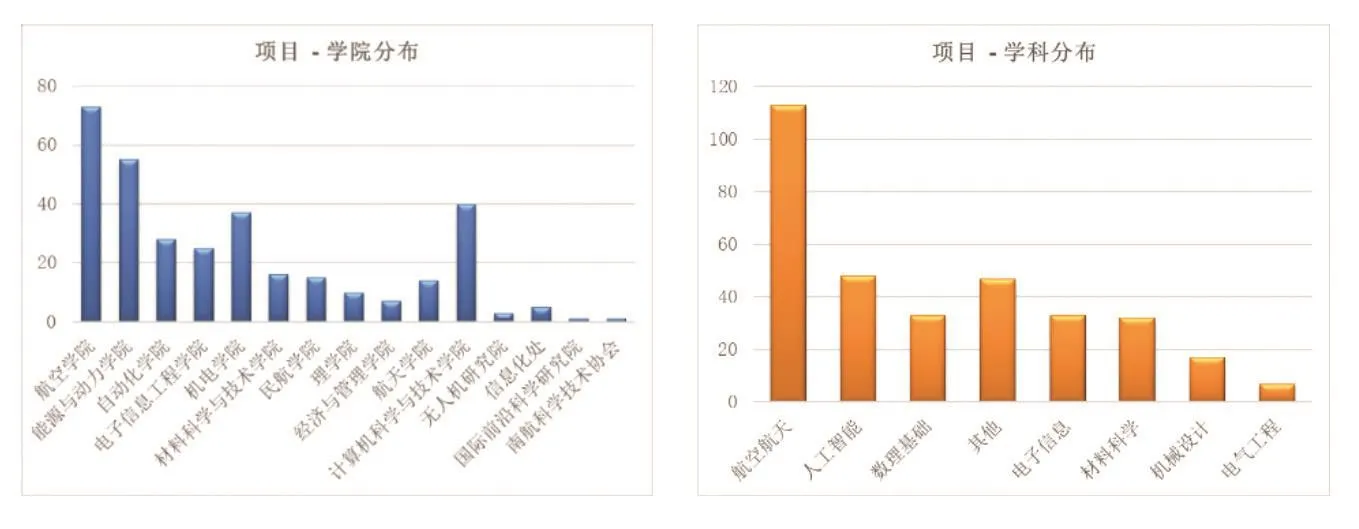

平台于2020年6月上线运行,全校师生广泛参与,注册用户超过540人,覆盖学校所有理工科学院和专业技术部门。承载科研项目400余项,基本覆盖学校全部理工类学科,有效满足了航空航天、机械设计、电气工程、电子信息、材料科学、人工智能、数理基础等学科的计算需求,对航空航天相关学科的支撑尤为明显。项目的学院和学科分布见图6。

图6 项目的学院分布和学科分布

学校立项建设高性能计算平台后,已不再批准各单位自行建设高性能计算的相关采购。经初步估算,累计节约建设经费约500万元,累计节约计算费近80万元。

作业统计分析

平台上线以来,累计完成计算作业近190万个(图7),累计完成计算量超过2090万核时,每个作业平均计算量在10核时左右。其中最长的作业占用CPU资源40核,运行2229小时,计算量达89189核时,充分验证了平台的稳定性和可靠性。

图7 计算作业数量统计

将计算队列的作业数和核时数饼图(图8)对比可发现:1.计算作业主要由CPU完成,占比达96%,针对这种情况,中心已启动二期建设,扩充CPU节点。2.虽然GPU作业数量只占3.56%,但核时数占比达18.8%,说明每个GPU作业的计算量都非常大。

图8 计算队列的作业数和核时数对比

从作业状态的作业数和核时数饼图(图9)对比可见,95%以上的作业能够正常完成(COMPLETED)。但取消(CANCELLED)的作业所占的核时达到了43%,说明存在不少试算、程序错误、计算不收敛且耗时长的作业,中心针对这种情况提供了定期提醒服务。

从作业核数-作业数、作业核数-核时数(图10)的对比中发现,虽然使用10核以下计算资源完成的作业数占比达94.6%,但核时数只占4.6%。而40核以上的多核计算贡献了绝大部分的计算量,占比达86.2%,是平台应用的主力和中心关注的重点。

图10 核数-作业、核数-核时对比

通过两年的探索和实践,南京航空航天大学高性能计算中心围绕平台建设、运维管理、科研服务和课程建设,建立了稳定高效的工作模式,形成了校级平台应有的服务保障能力,推动了学校高性能计算的应用和发展。通过运营数据分析,证明了优秀的计算资源、创新的服务模式、专业的技术支持是吸引用户,提高平台利用率,促进高性能计算中心发展的关键因素。