中国科学技术大学超算中心建设与实践

2023-08-15李会民

文 / 李会民

随着计算技术的发展,计算逐步成为了与实验、理论并驾齐驱的第三种科学技术研究方式,不仅覆盖了越来越多的领域,影响也愈发深远,而高校对超级计算的需求也更加急切。

中国科学技术大学(简称“中国科大”)是中国科学院所属的以前沿科学和高新技术为主、兼有医学和特色文科的综合性重点大学。2002年底,学校多个学科申请211、985工程经费建设自己的超算系统。考虑到需求众多,分散建设存在场地、人员、规模太小而无法满足重大科研需求等问题,学校决定集中资金筹建第五公共服务平台,即科学计算平台。平台于2003年10月投资800万元建成,逐步建设成为现在的超级计算中心(简称“中心”),是国内最早的校级超算中心之一。

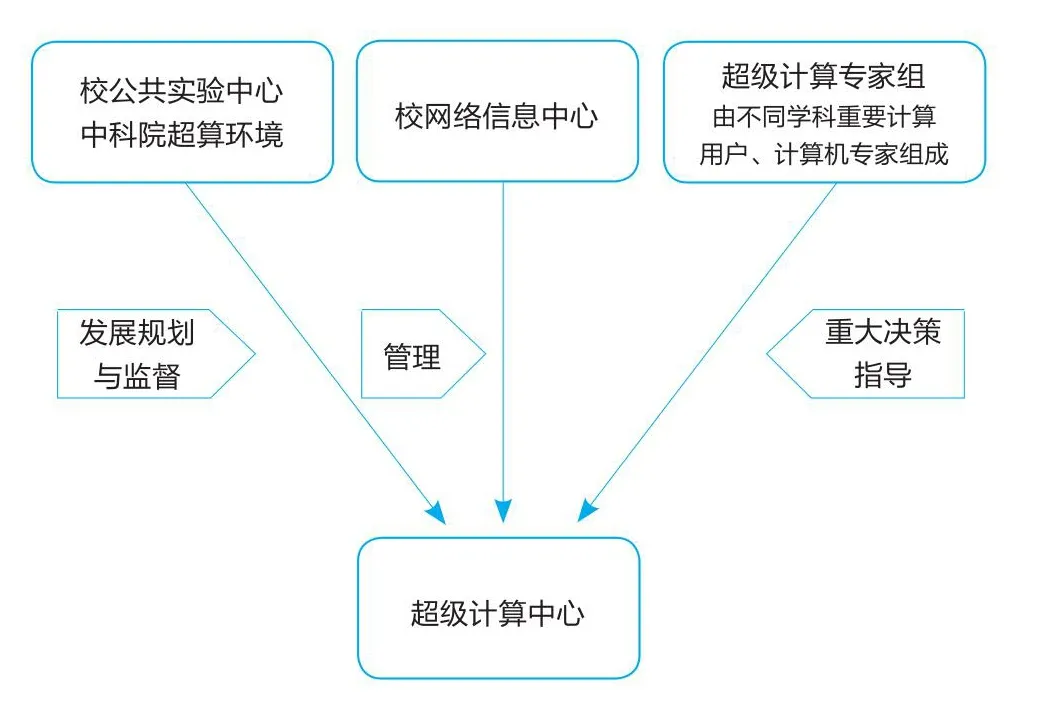

组织架构与职能

中心是学校六大公共实验中心之一,归属于学校网络信息中心而不是某一学院,这样做的主要原因在于:网络信息中心是IT技术支撑部门,具备相关IT技术人才,具有良好的服务意识;不隶属于某学科,对各学科公平;非科研单位,员工的评价体系主要与建好平台、服务好用户相关,而不以发表论文的数量和级别为标准。由此,中心人员可以安心做好技术支持服务,更好地建设和运行维护超算平台。

为确保持续性发展,中心设有专家组。专家组由从事计算机科研方面的知名专家(主要确保计算硬件等方面的前瞻性)及不同学科的典型超算用户(主要确保具体需求及行业前瞻性)组成,主要负责对中心的建设、运行、管理和发展等重大决策提出指导和咨询意见,并为中心争取学校认可及相应投入。中心组织架构如图1所示。

图1 超级计算中心组织架构

本着推动科学计算、促进人才培养的建设方针,中心为校内有高性能计算需求的所有院系、实验室、师生提供算力资源服务、用户超算设备托管及运维服务、用户技术支持服务,并与用户合作进行超算方面的研发等;同时,中心力所能及向校外提供一定的资源服务及技术支持,回馈社会;最后,中心建设了“研究生超级计算实验训练中心”,培训超算相关人才。

中国国家网格(CNGrid)合肥中心(2005年)和中国国家网格(CNGrid)合肥运行中心(2016年);images/BZ_27_1548_2257_1570_2279.png中国科学院超级计算环境GPU分中心(2010年)和合肥中心(中科大)(2014年);images/BZ_27_1548_2373_1570_2396.png超级计算创新联盟理事单位(2014年);images/BZ_27_1548_2432_1570_2454.png安徽省高校科研协作高性能计算公共平台(2014年):对安徽省教育和科研计算机网高校用户提供高性能计算服务;images/BZ_27_1548_2607_1570_2629.png高通量量子材料基因库计算平台,与合肥微尺度物质科学国家研究中心材料基因团队共建(2016年);images/BZ_27_1548_2723_1570_2746.png超级计算中心苏州分中心,与中国科大苏州高等研究院共建,提供基于寒武纪智能芯片的超级计算资源等(2018年);images/BZ_27_1548_2898_1570_2921.png超级计算中心生命科学学院分中心,与生命科学学院共建(2021年)。中国科大超级计算中心积极争取资源与合作

建设理念

三层架构

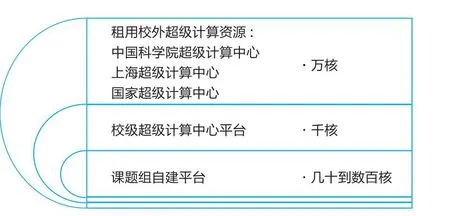

在高校超算服务中,面对不同规模的算力需求和不同类型的算力平台,一个不可避免又至关重要的问题是:应如何更合理、更有效地分配资源?

一方面,作为研究型大学,中国科大有很多重大科研和工程课题,对计算资源的需求很大。有些大规模并行的需求是间断性而不是持续性的,如果完全依赖于校超算资源,投资规模会很大,并导致很大浪费。对于此类应用,通常建议用户使用校外公共算力资源。而使用校外资源面临的挑战是:有些应用存在计算前和/或计算后大量数据的传输问题,如没有足够快的网络,数据传输时间会很长,只能携带存储设备等乘坐交通工具去现场处理;同时,校外算力的实际性能有高有低,技术支持也有好有坏,未必能及时为用户提供良好服务;此外,有些应用因为安全问题不适合使用校外算力。

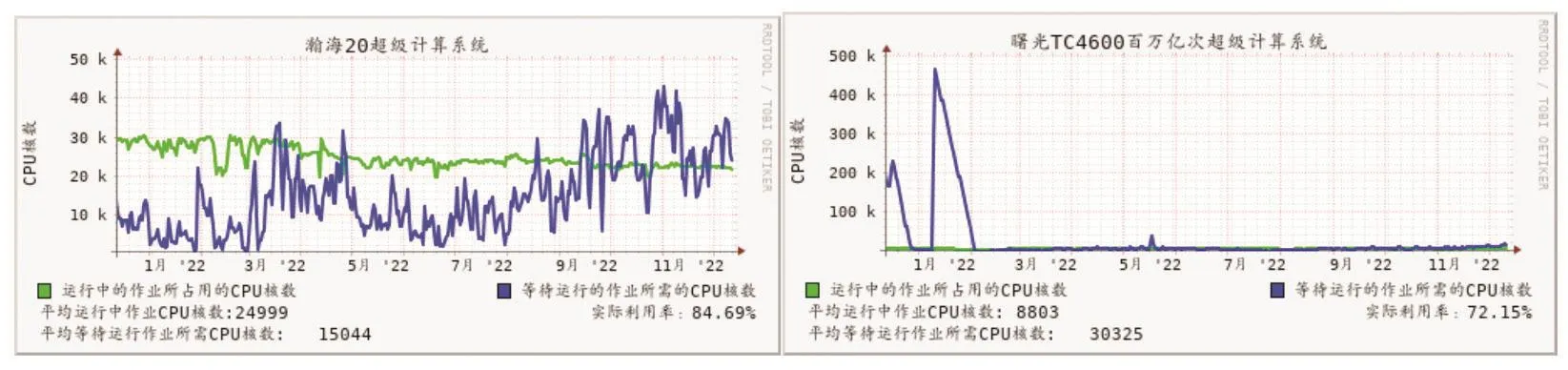

另一方面,由于用户数多、需求旺盛,中心超算系统受限于建设经费和场地,规模有限,利用率非常高(常年超过80%),导致用户作业排队时间较长,有些并行规模较大的任务甚至需要等待多天。图2显示了2022年度中心部分超算系统的实际利用率,瀚海20超算系统平均利用率为84.69%,TC4600超算系统则为72.15%。

图2 超级计算系统2022年度实际利用率

此外,不少课题组或学院建有或大或小的自建超算系统,投入从几千万元到几万元不等,多用于调试程序、小规模测算、运行一些非重要计算等,一般可以满足数十到数百核并行的需求。然而,用户自建的系统通常面临着场地、运行维护人员、安全等各方面挑战,建设水平参差不齐,实际价值发挥有高有低。

为此,中心制定了三层架构(用户自建算力、中心建设算力、利用校外算力)的建设方针(如图3所示),根据实际需求及经费情况,建设了中等适度规模的平台(当前最大能支撑数万核并行),尽量为用户提供更多算力资源,促进科研进展,同时尽量充分发挥价值,减少浪费。由此,平台既保证了具备一定规模,作业排队时间适度,可以运行相对大规模并行作业,满足大多数用户需求;又避免了因规模过大利用率低而导致的资源浪费。

图3 三层架构模式

规模及选型

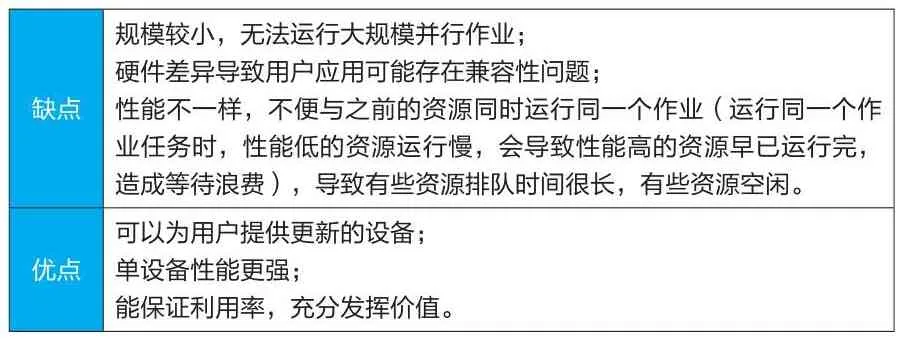

中心按需建设,每年都会更新系统,每三到五年更新一套大系统,其余时间在该大系统上扩建。如表1所示,按需建设的方法虽然有缺点,但这些缺点能够通过管理和调度策略弱化,因此仍非常适合中国科大。

表1 优缺点对比

在建设时,中心按照当前系统使用情况,对用户反馈、产品发展、其他高校情况等做调研,对典型应用进行实际测试,决定具体的CPU或GPU、内存、计算网络、存储等不同类型的配置数量等,形成可行性论证报告,并通过专家论证。

计算资源与机房基础

超算系统

2019年起,中心超算系统以“瀚海+年份”的规则命名,其含义为:“承瀚海之辽阔,比星云之光华”,“瀚海”极具中国科大特色,在国内高校与科研单位具有很高的辨识度;同时,“瀚海”也代表了超算系统计算能力强大,有力支持了教学及科研工作,帮助师生探索科学奥秘,勇攀科研高峰。

中心目前运行系统的总理论双精度峰值浮点计算能力达5.72PFlops(千万亿次/秒,CPU:3.50PFlops、GPU:2.22PFlops、MIC:21.28TFlops),位居国内高校前列。表2是中心目前运行中的超算系统相关数据。

表2 运行中的超算系统

超算专用机房

就功耗来说,超算设备(一般10~30kW/机柜)比普通信息化设备(一般4~6kW/机柜)高很多,对制冷要求高。因此,建设时不能仅考虑初期成本,还需要考虑后期运维成本等。由于功耗高,我们选用节能、PUE(电源使用效率)低的机柜级制冷方式(图4),机柜与行间空调封在一起,前面玻璃门(方便不开柜门查看设备状态),后面钢板门。冷风从空调横向送到设备前,被设备吸进内部,热风从后部出来,被空调吸到换热片换热。冷热风全部封闭在机柜内部,制冷效率高,PUE能低至1.2。除了功耗低,该方式还防尘,运行更可靠、性能更高、寿命更长;机房工作环境约为24℃,只有打开柜门时才会感受到冷热风,其他时间很少受强风、高热、高噪音折磨,舒适度相对较高。

图4 机柜级制冷(左右2台机柜+中间1台行间空调)示意

在供电方面,如果机房所有设备都接UPS(不间断电源),需要容量很大的UPS主机及电池,不仅建设费用很高(电池需要3~5年更换一次),而且电池占地面积大,对承重要求高,UPS电力转换也存在电力损耗的问题。而目前学校服务器等IT设备对电压波动等要求不算太高,多数设备都支持电源N+N冗余。学校的电力有两路市电且相对可靠,为此中心的超算机房仅配置小型UPS系统,主要支撑非常重要的监控、网络、存储、管理登录节点等,而大量计算节点则采用双路市电,无需经UPS直接供电。十多年的运行证明,该方法行之有效,节省了大量经费。

2013年9月,位于校东区新图书馆一楼的超算中心机房建成。机房共有54个机柜级制冷机柜,每两个机柜之间有一台55kW制冷量的行间空调,可支持单机柜IT峰值功耗近30kW,平均功耗约15kW,2014年获由中国数据中心工作组颁发的优秀教育数据中心奖。

2022年底建成的超算中心机房(西区)级别更高,其20个机柜分成两组,每组10个机柜级制冷机柜和11个机柜级制冷空调间隔排布,每台空调30kW制冷量,每个机柜两个64A三相五线PDU(电源分配单元)分别接不同的两路市电。对于N+N电源冗余的设备,能够实现每个机柜30kW负载时,任何一路电断电时,设备运行均不受影响;任何一台行间空调出现故障时,散热均不受影响。不仅单机柜容量非常大(2023年新购置的2900万元设备,放不满10个机柜,单机柜实际功耗为25~29kW),而且可靠性很高。

服务体系

管理及收费政策

用户对算力的需求是无止境的。例如,稍微修改一下计算参数,计算量就有可能上百倍增加。如果采用免费政策,再多算力都可能耗尽,不仅会造成很大的资源浪费,而且会导致真正有需要的用户无法及时获得算力资源;但如果收费标准太高,则会严重降低用户使用的意愿,不利于科学研究进展。

为此,中心为了调节资源,保障学校重大科研项目的计算需求使用,研究制定了《中国科学技术大学超级计算中心收费标准(试行)》。该标准采取不以盈利为目的、用户用得起的原则,部分免费,部分收费,与调度优先级挂钩。

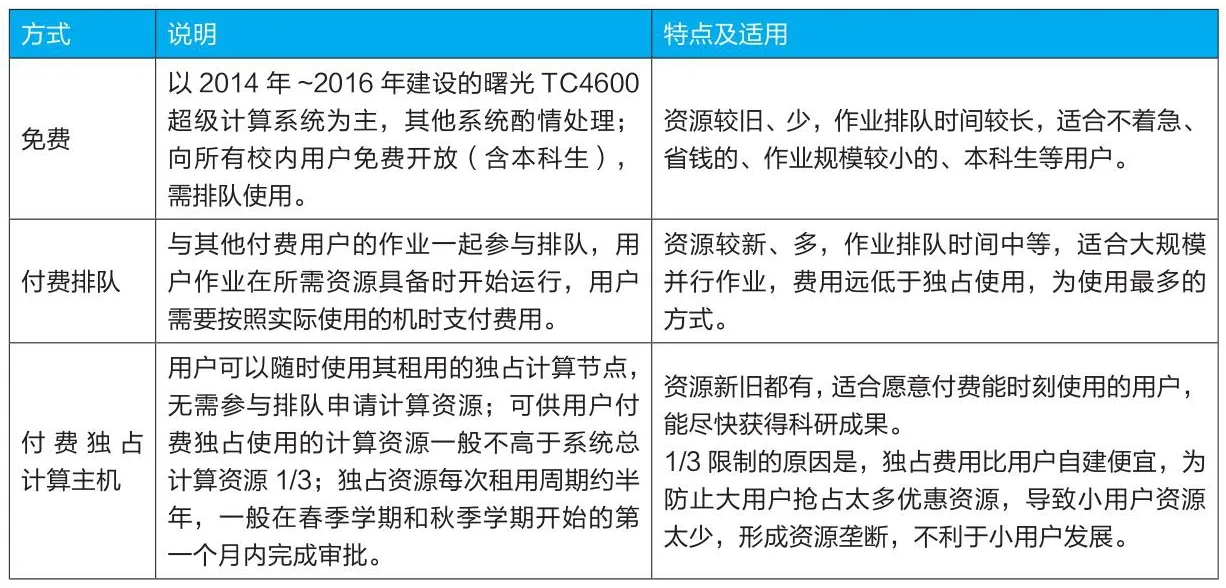

中心收费标准(表3)基本按照算力设备购置价(不含场地、人员、电力等费用)折旧(一般为五年)来核算,目前提供三种方式:免费、普通付费排队(费用远低于购置成本)、付费独占计算主机(费用约与购置成本一致)。

表3 当前收费标准

用户服务

作为一所研究型大学,虽然中国科大用户对自己本专业的知识掌握得很好,但不少人对计算机、Linux系统、编译环境、作业调度系统、软件编译安装等方面的知识了解并不深,甚至不清楚内存与存储的区别等。

因此,对中心来说,仅仅投资软硬件,做好超算系统的建设、运行、维护是不够的,还要做好用户支持服务,帮助用户方便高效地使用超算系统,更好地发挥系统价值。

为此,中心采取了多项行动服务用户:部署了很多编译环境、工具及应用软件,并采用module environment软件包对其做了封装,用户在使用时采用命令调用设置即可,操作非常简单;设置了中文登录提示并开发了引导式命令faq,用户登录后会看到,运行faq命令即可一步步查看所需信息;编写了大量的用户手册、应用安装使用文档等,经常举办培训,充分引导用户学会自己查看手册、搜索解决办法;采用QQ用户技术支持群提供即时服务,由此,解决问题的方法其他用户也可以看到,降低重复回答工作的比率(QQ群有1578人,有可能是最大的超算用户技术支持群)。

用户支持成果

在二十年的建设历程中,中心为学校科研、人才培养等做出了显著贡献,得到了校内外的广泛认可(图5)。据不完全统计,2022年在超算中心用户发表的论文中,致谢中心的SCI论文高达464篇(含Nature系列、Science系列、PRL、JACS、Cell等顶级期刊论文38篇),学校主页新闻报道的22篇重要科研成果论文致谢了校超算中心。

人才队伍

二十一世纪什么最重要?人才!对于学校超算中心来说更是如此。在人才队伍建设方面,中心现有专职人员8名,其中正副主任为兼职,分别是网络安全博士和计算物理博士;其余6名专职人员包括计算物理博士2名、计算化学博士1名、高性能计算博士1名、计算机学士1名;人事、行政、财务、网络、信息等其他工作则由网络信息中心同事协助处理。

受大环境所限,高校科研岗比技术支撑岗待遇高很多;而比起高校,IT人才在企业的待遇往往也更高。这导致中心在招聘合适人才时面临挑战,人才结构有待优化。

为提升服务学校、支撑学校高水平科研工作和人才培养的能力,进一步激发技术支撑工作者的积极性、主动性和创造性,打造一支同一流大学建设相匹配的高水平公共技术支撑队伍,学校公共实验中心出台了技术支撑绩效管理办法。绩效以技术支撑学校科研的质量、贡献和影响以及人才培养成效为导向,综合考虑技术支撑工作者年度工作情况,建立了科学合理的评价标准。其中,绩效额度总量的80%用于综合绩效奖励,主要奖励在岗技术员在支撑科研创新、攻关技术难题、提升仪器性能、获得知识产权、实施成果转化、参与人才培养、拓展仪器共享以及开展公共服务等方面的贡献,绩效额度总量的20%用于人才绩效奖励。

同时,在科研工作方面,作为研究型大学的超级计算中心,中国科大超算中心在开展科研工作时“不忘初心”,坚持以做好本职工作为前提,适度参与本职工作相关的科研,掌握行业进展,以更好地促进本职工作及协助用户为目的进行科研攻关。在此前提下,中心员工积极参加相关的重点研发项目、横向项目等,其中既有独自承担的,也有参与用户项目的,都取得了不错的成果。

展望未来,随着GPU等协处理器技术、大数据、人工智能技术的发展,高校将越来越依赖于算力,算力平台的建设也将越来越重要。下一步,中国科大超算中心将在学生培养、学科建设、AI等平台的建设上加大力度,并加强与用户的合作开发,进一步助力学校双一流建设。