基于考情分析的大学计算机基础考评系统设计

2023-07-16周海芳周竞文宁伟勋

张 军,吴 荻,周海芳,周竞文,贾 楠,宁伟勋

(国防科技大学 计算机学院,湖南 长沙 410073)

0 引言

大学计算机基础课程(本文中简称“大基”)在诸多高校课程体系中是面向全校学生的基础课程,对其教学质量进行便捷、有效的量化评价是大基教学的重要环节。在以“能力为导向”的教育趋势下[1],教师对学生考评的关注点已经不仅仅浮于考试的分数高低、及格率、优秀率等指标,而是希望通过考评结果数据客观地量化分析,纵向比较,以便能用客观数据判断学生能力是否达到教学大纲的要求、教学效果是否有提高、教育改革是否有成效。然而,在实际教学过程中,教师需要根据目前学生情况从数量庞大的教学资源中选取或设计合适的题目形成一份学生能力考察试卷,这具有一定难度;另一方面,由于学生人数众多,计算机知识水平差异大,为客观评价教学效果以便指导后续教学工作,教师需要对大量成绩数据进行多方位、多层次整理与分析。传统考评系统仅提供考试环境和原始考试成绩,在考前考卷组建方式和考后考情分析等方面均十分薄弱。例如,传统考评系统中教师凭借个人经验确定试题难易度、知识点等考题属性,在分析过程中主观因素占比多,易产生疏漏和偏颇。因此,在当前教学要求下,需要设计科学、全面分析学生能力并依据分析结果选择考题等的考评系统。

目前有考评系统摒弃了传统考评系统组卷方式,采用自适应方式,其具体实施方式主要是真分数模型与难度相结合。例如,文献[2]从认知层次、知识点数量、知识跨度、信息干扰4个因素展开分析,结合布卢姆目标分析理论,构建出了试题难度的分级方法和试卷生成策略,并对考试系统的开发进行需求分析和设计,但未对考试结果进行分析;文献[3]认为Rasch模型可最大限度地减少额外因素对真实测量目的的影响和干扰,从而保证测量的客观性和准确性,但缺乏在计算机教育中的实际应用研究。目前已有一些研究将Rasch模型应用于计算思维能力的测量,但存在测试样本不足的缺陷,例如样本中测试题目较少[4]、参与测评学生数目较少[5]、参与测试学生专业不属于理工科方向[6]、参与测试学生的学生不属于本科教育范围[7]。

Rasch模型又称为一维难度模型,是一种用于评估考试或测验题目质量或难易程度的统计模型,是IRT(Item Response Theory)中最基础的模型。该模型基于概率分布函数,假设考生的能力和试题的难度可以用单个参数来描述,从而建立起考试成绩与题目难度之间的联系,适用于各种类型的教育评估,包括学术考试和职业认证等。该模型还可以评估测试的信度和效度,对受试者、项目和整个测试的属性进行分析和比较。为弥补以上研究不足,本文以大学计算机基础这门公共课程作为研究对象,将Rasch模型应用于其基础教学测评中,以期拓宽Rasch模型在能力测评中的应用范围,也为大学计算机基础课程的发展与完善提供理论与数据支撑。

1 考评系统分析与设计

1.1 考评系统分析

考评是教学闭环中的重要环节,通过精准的考情分析可以及时把握学生学习情况,有效督促教学改进。在很多院校中,大基属于全校公共基础课程,考生人数多。为评估考生能力,教师需要花费大量时间和精力对每一题的答题情况进行统计分析,如答题正确率、班级平均分与整体平均分数的比较等。对答题情况进行分析一方面有助于教师有针对性地增强薄弱知识点讲解,另一方面可剔除或修改不合适的题目,完善试题库。

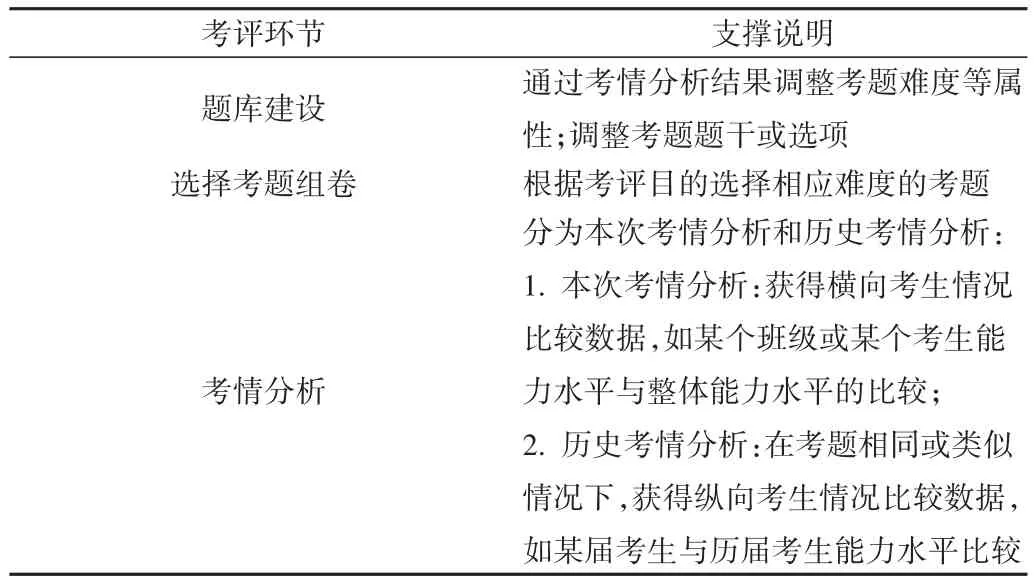

考评系统结构如图1所示,系统中各个考评环节的支撑说明见表1。目前无论是采用简单随机式还是先进的人工智能考评系统,其主要关注点在于组卷方式,但均必须基于试题可以客观反映学生能力的基础上才能达到预期考核目的。因此,考评系统除需支持考试组卷等外,还需提供考情分析功能,帮助教师完成考核闭环的迭代改进过程。

Table 1 Supporting description of evaluation sector表1 考评环节支撑说明

Fig.1 Evalutation system structure图1 考评系统结构

1.2 功能模块

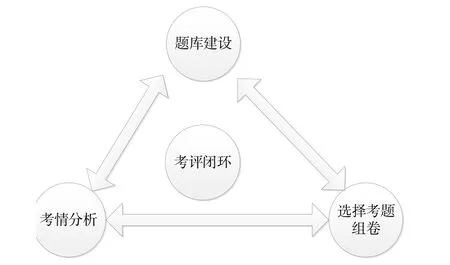

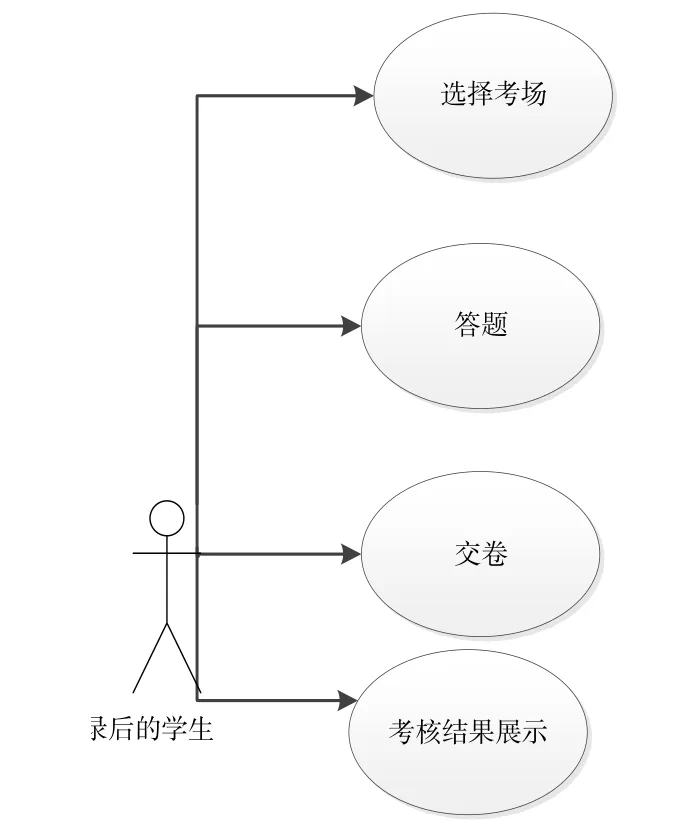

依据用户类型,考评系统功能模块分为面向教师和考生两个部分,面向教师模块主要提供考题设置、考核结果分析、考生能力评估等功能;面向考生模块根据考核目的、考场设置提供不同考核界面,具体如图2和图3所示。为方便学生平时自测和正式考试,减少对客户端软硬件的需求,该系统采用WEB模式,教师和考生可通过浏览器访问考评系统。该模式受客户端操作系统、设备性能等因素限制少,扩展了考评系统用户规模和层次。

Fig.2 Teacher module图2 教师模块

Fig.3 Student module图3 考生模块

根据考评系统主要分为面向教师和考生两个模块,其顶层设计如图2和图3所示。

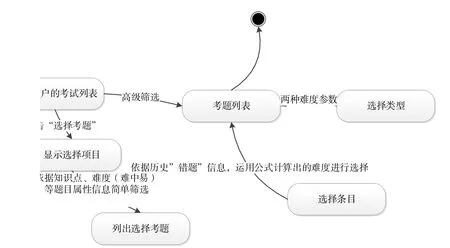

1.3 考题选择模块

在考题选择模块,系统在传统选题模式的基础上提供高级筛选功能中的相对难度和绝对难度作为选题参考[2],具体如图4所示。

Fig.4 Module design of "selecting questions"图4 考题选择模块设计

1.3.1 相对难度

相对难度的计算公式为:

式中,H表示难度系数,M表示答错该题的人数,N表示参加测试的总人数,答错的人越多,难度系数越高。

随着历史数据量的增长,N和M均产生变化,H也随之改变,根据相对难度选择考题可以通过考评结果横向比较学生能力。

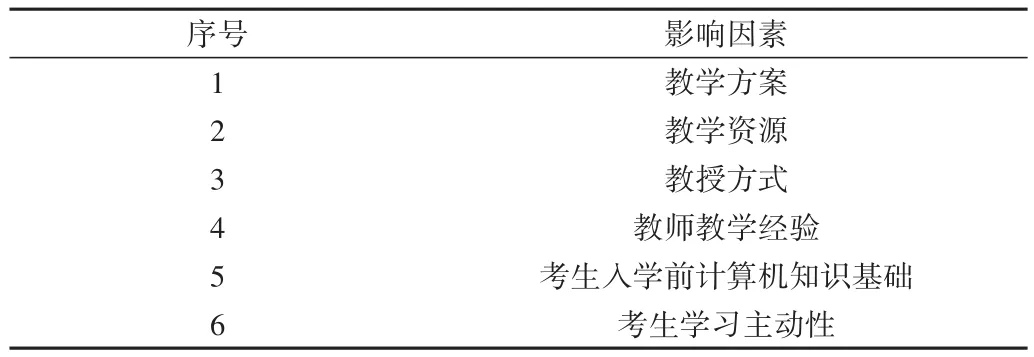

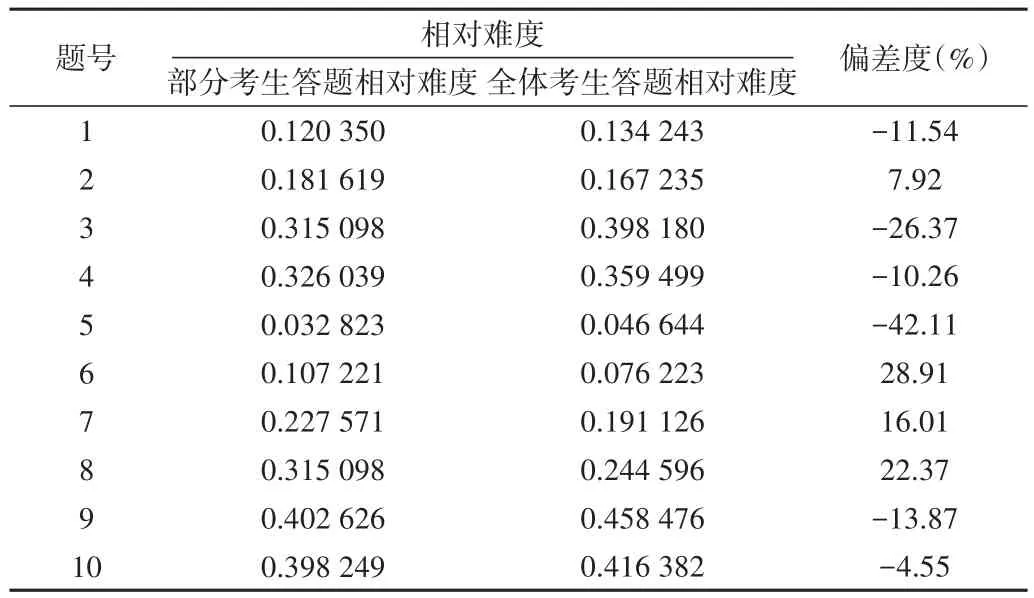

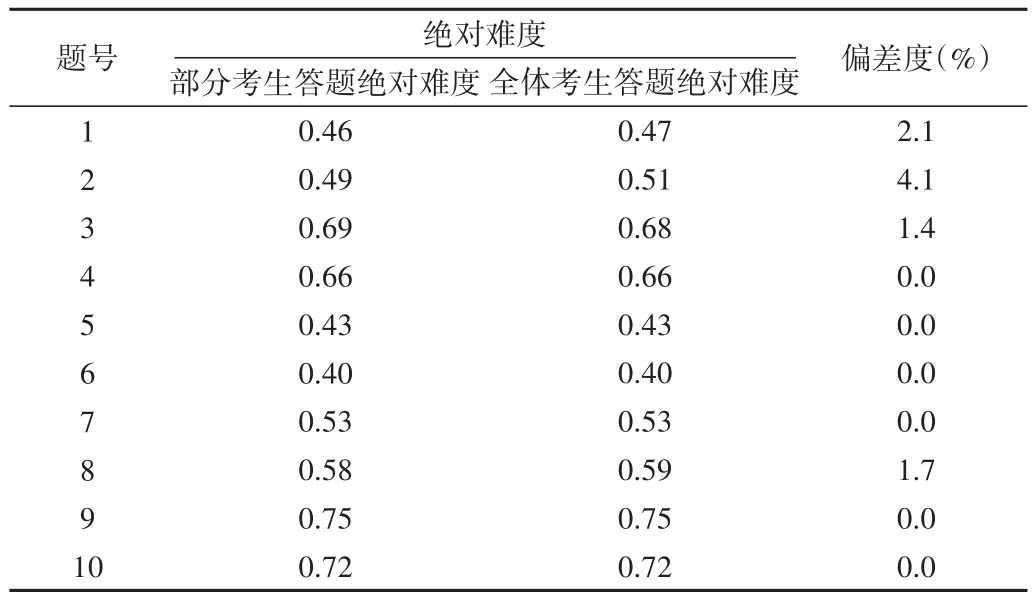

影响相对难度的因素见表2,在同一学期中,因素1、2、3、4等外部客观因素相对稳定,此时相对难度可侧面反映同一批次的学生能力情况。以2018年期末考试为例,抽取一部分班级答题情况,将其与全体考生答题情况进行比较。根据式(1)计算前10道题目的相对难度,结果见表3。采用式(2)表示相对难度偏差度,以考察不同样本量下同一题目相对难度的不一致程度,其中D表示相对难度偏差度,b1表示Rasch模型中依据部分样本统计得到的统计出的难度,b2表示Rasch模型中依据全体样本统计出的难度。

Table 2 Factors affecting "relative difficulty"表2 影响相对难度的因素

Table 3 Relative difficulty deviation of 10 questions between some candidates and all candidates表3 部分考生与全体考生10道题目的相对难度偏差度

可以看出,抽取的部分考生与全体考生10道题目的相对难度偏差度范围为[ -42.11%,28.91% ],跨度高达70%,说明相对难度值高度依赖选取的样本,抽取出来的学生在部分知识点的应用能力上低于平均水平,如第5题。

1.3.2 绝对难度

相对难度存在极大变化幅度,不适合作为不同年度、不同考生群体的能力考评参数。由于难度是题目本身的属性,客观上不因抽取样本的不同而改变,因此考评系统同时提供了绝对难度参数,以纵向比较学生能力,该参数可通过测量考生能力的IRT模型获得[8]。IRT模型以概率解释学生答题情况与能力素养之间的关系[9]。IRT模型有3条基本假设:①能力单维性假设,其含义是组成某个测验的所有项目均为测量同一潜在特质;②局部独立性假设,其含义是对某个被试者而言,不同测试题目不存在相关性;③项目特征曲线假设,其含义是对被试者对某项目的正确反映概率与被试者能力之间的函数关系所作的模型[10]。为使绝对难度符合IRT模型,考评系统需要满足以上3个假设前提[11]。为考察学生解决问题能力水平而不是知识点记忆情况,课题组采用开卷考试形式,重点考察学生运用知识点解决实际问题的能力,题目特征曲线严格单调上升。考评系统提供按IP地址发放A/B试卷、切换窗口控制等措施,可以做到作答真实可信,学生之间互不影响。考题中判断题、选择题占80%以上,保证学生有充足时间作答。基于以上前提实现对考生能力和试卷、试题质量的测评,可以达到使用同一尺度比较不同年度试卷、试题、考生水平和教学水平的目的[12]。

式中,Pi(θ)表示能力值为θ时的学生正确回答题目i的概率,一般为[ -3,+3 ];bi表示题目i的难度系数,一般为 [ -3,+3 ]。

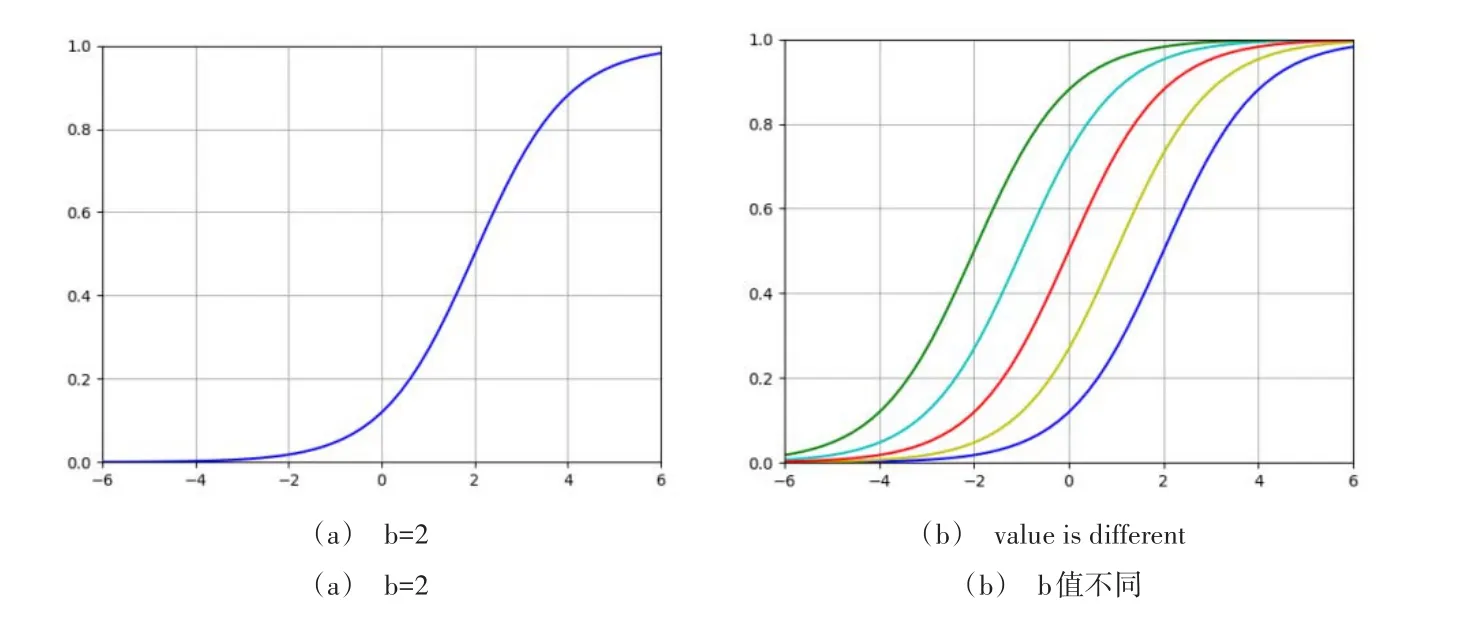

IRT模型测量某个考题的特征曲线如图5所示,其中横坐标为θ,纵坐标为考生答题的正确率,函数是单调上升的。由图5(a)可以看出,能力值(θ)越大,考生能力越强;由图5(b)可以看出,当θ值一定时,曲线从左至右,b分别为[-2,-1,0,1,2],即能力值一定时,b值越小,答题正确率越高。当题目难度过小或过大时,在曲线顶部或底部的Pi(θ)值趋向于水平变化不明显,说明考生基本均能答题正确或错误,无法区分考生能力。

Fig.5 IRT model measuring the characteristic curve of a certain exam question图5 IRT模型测量某个考题的特征曲线

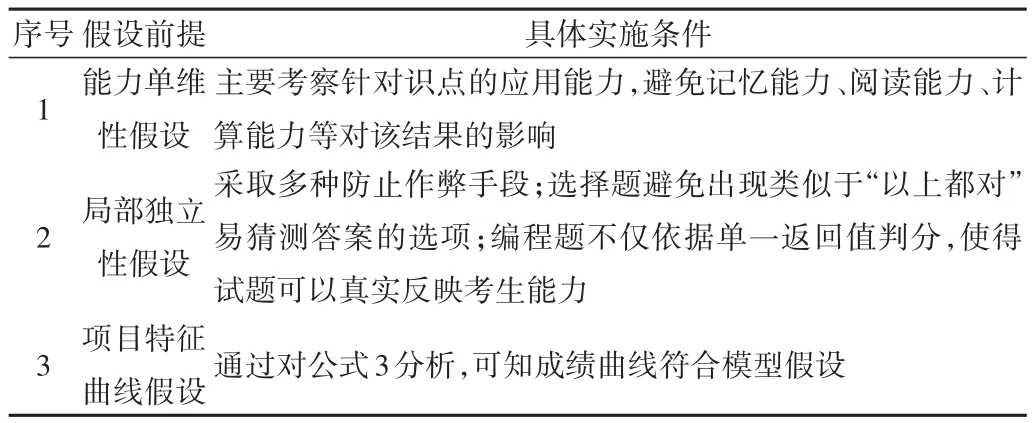

为使考试系统更符合Rasch模型,依据IRT模型的假设前提采取如表4所示的多项措施,以支撑绝对难度作为选题指标。

Table 4 IRT assumptions and implementation conditions表4 IRT假设前提与实施条件

本文系统采用Winsteps软件根据Rasch 模型[13]计算得到的题目绝对难度符合教学规律,由此在相对难度相同的两组考生答题情况下计算获得绝对难度值,结果见表5。可以看出,表5中的偏差度较表3明显稳定。

Table 5 Absolute difficulty and deviation of samples表5 绝对难度值及其偏差度

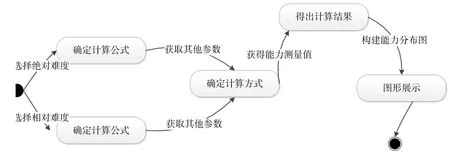

1.4 考生能力分析模块

在以能力为导向的教育环境下,教师更关注学生们解决问题的过程,为此考评系统记录考生解决问题的时长,尝试次数等过程信息,将其作为参数,结合题目正确率,根据式(3)计算并生成学生能力分布图和效率分布图。该模块设计见图6,用户根据实际评估需求选择相对难度或绝对难度,例如若需评估某个班级能力水平在全年级中所处的排名,可以采用样本为全体考生的相对难度作为参数,若比较不同年度考生能力水平则使用绝对难度作为参数。

Fig.6 Candidate ability analysis module图6 考生能力分析模块

1.5 考核结果分析模块

大基课程参考人数多、考察知识范围广,考评系统提供多角度、多层次的考核结果反馈考生能力和教学效果,具体如表6所示。

Table 6 Assessment result analysis表6 考核结果分析

考评系统同时支持线上和线下考核结果的整理、展示,具体如图7所示,教师可直观地对学生能力和教学效果进行整体评估。

Fig.7 Organization and display of assessment results图7 考核结果整理、展示

1.6 考场设置模块

为针对考评目标合理构建考题,需尽量减少非考题因素对考生的影响,以得到真实考生数据并据此调整考题,因此考评系统设计了模拟考试和正式考试两种模式,具体见表7。

Table 7 Module of examination hall settings表7 考场设置模块

2 考评系统实现

2.1 考题选择

为方便教师选择考题并对已选考题进行操作,考评系统建立一个考题篮,将待选考题加入考题篮,考题确认后可形成一套试卷。界面如图8所示。

Fig.8 Test question selection interface图8 考题选择界面

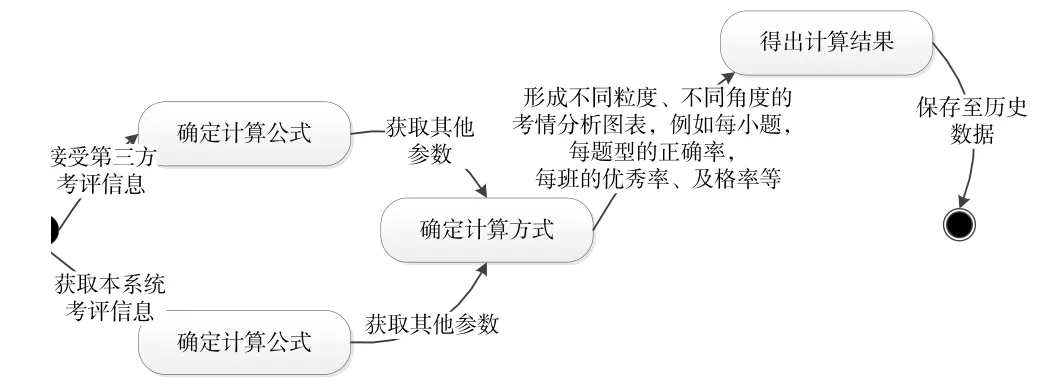

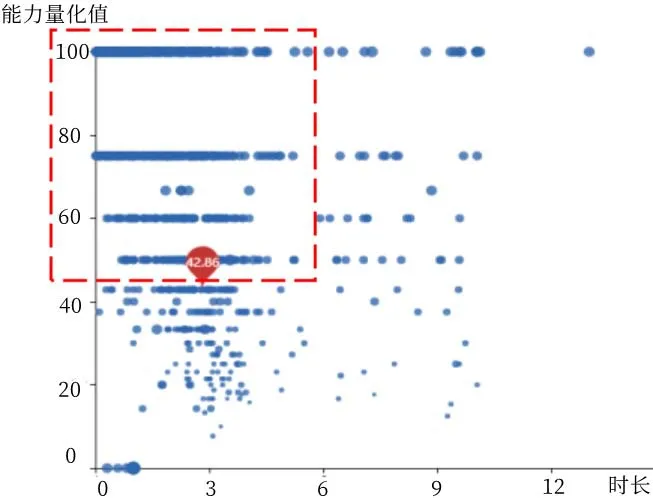

2.2 考情分析

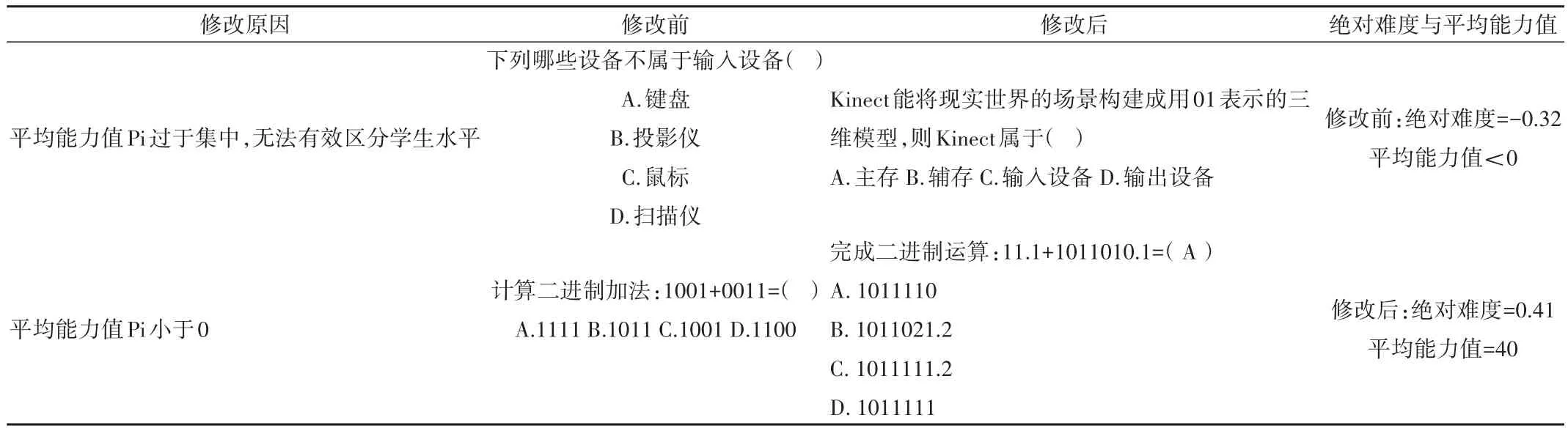

为直观展示学生能力,考评系统对其能力值进行百分制量化,并采用散点图表示。如图9所示,纵坐标表示学生能力量化值,横坐标表示做对该题目所用时长,每个小蓝色圆点代表一个学生。若考生使用该功能,则有红色水滴形标签标出其排名。以图9考情分析结果对该考题进行改进,首先学生在该题能力值集中于左上部,如图9中方框线所示,平均能力值偏大,且用时较小;其次该题的绝对难度平均能力值为-,小于0,表明需要修正该题目。

Fig.9 Distribution of candidates' ability values图9 考生能力值分布

修改考题示例如表8所示,对题目调整后再次测试,发现其参数值均在合理范围内。

Table 8 Example of modifying examination questions表8 修改考题示例

3 结语

采用难度量化后的考卷能在满足考核所需的同时提高考情分析的科学性和全面性,将考核结果多层次直观地展示给教师,可便捷准确地定位教学短板。本文基于Rasch模型分解难度维度,为计算思维能力提供了客观的测量方式。但在使用Rasch模型对学生编程能力评估时并不理想,这是由于样本的编程题评分方式不同,例如即使没有编写正确的功能代码,但只要编译通过了也可以获得部分分数,这种设置无法准确反映学生的计算机思维能力。下一步将随着样本的数量增加针对编程题样本数据进一步整理和挖掘,以期可以使用量化方式客观评价考生能力,为考察教学效果提供客观依据。