基于机器视觉的运载火箭支架自动装配方法研究

2023-07-13马庆丰

摘 要:为解决运载火箭内部支架人工装配所面临的工作环境嘈杂和劳动强度大等问题,设计了基于协作机器人的辅助自动装配系统,并对其装配路径进行规划。协作机器人在抓取支架实现自动装配过程中,受限于支架自身误差、特征尺寸及位置姿态的随机等特点,抓取和定位极为困难。为解决支架自动装配过程中的难点,首先规划了支架自动装配的工艺流程,设计了支架抓取机构、自动装配机构,并配合对应的视觉算法完成支架的抓取、自动装配;其次,结合YOLOv5深度学习算法对定位目标进行识别,和装配孔位进行位置補偿,实现对装配孔找正;最后,通过实验验证该自动装配系统中抓取机构、自动装配机构的稳定性,视觉定位算法的有效性及精度,实验结果表明,装配孔定位精度小于0.06 mm。

关键词:火箭支架;自动装配;YOLOv5;目标识别;位置补偿

中图分类号:TP29 文献标志码:A 文章编号:1671-0797(2023)13-0001-06

DOI:10.19514/j.cnki.cn32-1628/tm.2023.13.001

0 引言

运载火箭铆接舱体内支架型号种类多,几何尺寸和特征差距大,支架安装到箭体舱体内部时,需要与托板螺母提前铆接。目前的生产方式是手工锤铆,工作环境噪声达110 dB,劳动强度大。支架类零件实现自动装配的难点有三个:1)支架种类较多,无法采用机器人示教的方式完成支架的抓取;2)托板螺母与支架连接孔精度在±0.1 mm,以往手眼标定方法不能解决支架装配问题[1];3)支架属于钣金类零件,夹持变形大,与理论模型无法适配。

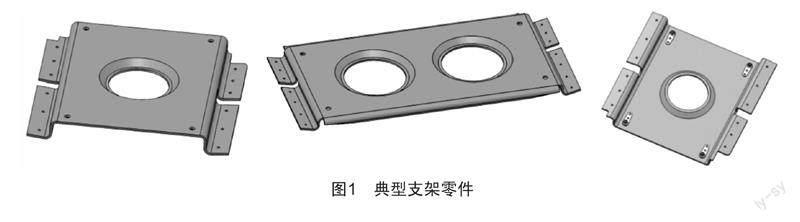

国内外的定位技术主要有三类:基于灰度模板匹配的识别定位技术[2]、基于特征目标匹配的识别定位技术以及基于深度学习的识别定位技术[3]。利用上述三种方法,田清廉等人[4]提出了散乱点云的铆钉孔自动识别方法,该方法仅限提取铆钉孔位置,并处理局部特征,针对全局特征会造成点云质量差而方法失效;浙江大学刘华[5]针对飞机壁板装配过程中的插铆钉问题设计了自适应滑模控制器,结合视觉系统解决了自动插钉中末端执行器法向位姿的调整精确控制问题,主要面向曲面类需调整法向的零件;针对运载火箭支架(图1)装配问题,目前仅有方舟等人[6]搭建了双目视觉系统,实现视觉引导抓取和位姿调整及基于边缘特征对支架位姿的估计,仅限于对支架的抓取,没有结合抓取和定位装配孔识别,不能解决支架自动装配的全流程问题。

综上,目前针对火箭支架自动装配问题,大多采用模板匹配的抓取方法,并未针对运载火箭支架自动装配流程中的难点开展工作。本文针对尚需解决的问题,重新规划了支架实现自动装配的工艺流程,搭建了一套自动装配系统。针对自动装配过程中的三个难点,设计了两套视觉系统分别解决问题:1)结构光相机用于支架识别和抓取,采用支架位姿估计与夹爪位姿调整的方法,降低支架自身误差和夹持变形对位姿估计的影响,试验表明该方法抓取支架的平均误差小于0.8 mm;2)利用协作机器人重复定位精度小的特点,将单目视觉相机用于引导连接孔定位的视觉系统,采用YOLOv5深度学习算法对装配孔进行目标检测,结合卡尺工具检测装配目标孔边缘特征。最后,通过实验验证了该方法识别装配孔与调整位姿的可行性。

1 支架零件的抓取与定位

1.1 支架自动装配工艺流程

为实现支架的自动装配,将原有手工操作工艺流程重新规划成适合自动装配的自动化工艺流程:人工放置支架至传送带→结构光相机扫描支架获取点云匹配支架的外形及图号→协作机器人根据识别结果调整姿态抓取支架→视觉识别托板螺母在料盘中的位置→协作机器人抓取托板螺母并将其放入对应的工装→视觉引导机器人抓取的支架与托板螺母中心对齐→自动拧紧枪送施工螺钉并拧紧,实现托板螺母与支架的连接→协作机器人将支架送到钻孔工位→视觉引导协作机器人实现托板螺母的铆钉孔与主轴对齐→制孔→协作机器人运送支架至插钉工位→视觉引导铆钉孔与插钉机构对齐→插入铆钉→协作机器人运送支架至铆接工位铆接→返回人工操作台检查并拆除施工螺钉。

为实现上述装配过程,在自动装配系统中需要精确定位的关键工步上设置了不同的视觉相机(图2):支架抓取识别视觉相机、装配孔对准视觉相机和铆钉孔对准视觉相机。

1.2 支架抓取视觉识别

支架放置在物料传输模块上,将零件自动传输到适合机器人抓取的区域(图3),在抓取区域上方设计结构光相机用于检测支架和引导机器人抓取。

工件最大尺寸是400 mm×400 mm,视场范围要大于400 mm,在抓取识别上选用Mech-Eye-PRO-M结构光相机,其参数如表1所示。

支架抓取涵盖支架的边缘识别、模板匹配与定位、协作机器人末端抓取机构的初始位置估计和抓取位置估计,支架抓取的工艺流程图如图4所示。

支架位置估算中,利用结构光相机得到的点云进行平面拟合,分割出支架点云,再提取支架边缘,在夹爪末端设置4个视觉标记点(图5),用结构光相机获得4个标记点在相机坐标系下的位置,根据标记点的相对位置关系计算出夹爪在相机坐标系下的位姿,最终可以求出夹爪末端位姿在基座坐标系中的位置,控制协作机器人移动至目标点位。

支架零件采用视觉引导抓取的方式,在夹爪上设置标记点,夹爪位姿反馈机器人调姿,该方法不用对协作机器人和视觉系统标定,对精确抓取工件有 一定柔性。

1.3 装配孔对准和铆钉孔对准

在托板螺母拧紧工位、制孔工位、插铆钉工位需要检测支架上预制孔的位置[7],且孔销配合精度为0.1 mm,需要检测精度约在0.03 mm,因此需要小视场高精度的相机,由于功能近似,均选用海康威视MV-CE060-11GC单目相机+海康威视MVL-MT-2-

110C-MY23相机。小视场的相机检测精度高,但是会放大识别图像里的噪点,为满足使用要求,采用YOLOv5深度学习[8]的目标算法对预制孔第一次定位,根据结果再采用卡尺工具拟合精确定位的方法。MV-CE060-

11GC单目相机参数如表2所示。

采用SiLU作为激活函数:

式中:B为训练的标准边界;Bgt为检测轮廓边界;C为B和Bgt边界交集的最小轮廓边界;β为衡量纵横比重叠面积损失的平衡因子;v为长宽边界比一致性参数;d为计算中心点的距离。

对于托板螺母的装配孔,采用各种拍摄位置、不同光照、不同规格的托板螺母等手工拍摄图像,采用labelme工具进行标注,得到数据集共计350张。

使用上述数据集训练YOLOv5模型,初始学习率为0.01,训练批次(batch)设置为4,图像尺寸设置为600×600,其他使用预设值。训练结果如图6所示。

使用训练完成的YOLOv5模型对运行中采集的图片进行检测(图7),支架安装孔的目标检测区域能满足使用需求。

检测目标孔位置后,对目标进行定位,需要检测出圆的边缘,然后对圆拟合,使用卡尺工具进行边缘提取,卡尺边缘提取涉及图像投影处理、高通滤波计算、边缘阈值处理和边缘像素处理。

图像投影处理为沿着目标检测的边缘垂直扫描图像,获得离散投影线的强度值,用于均化目标检测区域的噪点,提高检测成功率,经过投影处理后可得到离散点的数组。

使用高通滤波器对图像投影的数据进行滤波处理,使目标检测边缘突出,增强图像对比度,使用Prewitt算子对图像两个方向模板与图像进行邻域卷积,用于抑制噪声和均化。

在滤波输出中设置阈值,可以排除噪声点,超过设置阈值认为是真实边界。对于提取出真实边界几个邻近的像素点进行插值计算拟合,可获得目标检测的精确位置。

利用YOLOv5模型生成目标孔位置圆心位置,使用一组卡尺工具检测出边缘点,圆心位置坐标直接用最小二乘法对目标孔边缘圆拟合(图8)。

使用卷积神经网络YOLOv5模型生成目标孔区域,后使用卡尺工具拟合目标孔边缘,最后根据孔边缘拟合出圆心。

2 实验验证

通过对运载火箭上实物支架进行全流程工艺验证测试,包含支架运输、支架抓取、托板螺母抓取、支架与托板螺母拧紧、支架托板螺母钻孔、铆钉插钉,来验证支架自动装配的全流程应用工况。

基于实际运行流程,验证分为支架识别和抓取、支架与托板螺母拧紧、制孔划窝和插钉铆接三个部分。

2.1 支架识别和抓取

支架型号的识别是后续所有工序的基础,对应型号在工艺数据库里面有对应的自动加工程序。识别支架型号,先使用支架种类数据集对YOLOv5模型进行训练,然后使用训练过的模型检测支架目标,设置0.8为识别阈值,测试其中10种支架检测结果,如表3、图9所示。

支架型号识别完成后对支架进行抓取(图10),支架的稳定抓取是后续支架自动装配的基础。在抓取过程中采用结构光相机拍摄四次:第一次拍摄预估工件位置,记作初始偏差;第二次拍摄预估工件与协作机器人末端位置,记作粗调偏差,并引导机器人到靠近工件位置;第三次拍摄为精定位,记作精调偏差,引导机器人抓取工件;第四次拍摄为抓取后拍摄,测试装配孔与夹具标记点偏差,用于后续自动装配定位。

统计支架3的20次抓取数据,人工随机将支架3放置在输送带上。从表4可见,支架抓取的粗调定位偏差较大,平均定位误差为2.24 mm。机器人绝对定位精度和标定误差导致初次支架抓取定位有较大误差,粗调定位可以认为是一次开环定位,定位精度难以控制。利用支架视觉引导抓取再次测量并调整定位夹爪,精调平均偏差为0.67 mm,远低于粗调定位偏差,满足支架抓取的精度要求。经过一次视觉伺服补偿后,抓取定位偏差降低了1.57 mm,验证了支架视觉伺服抓取策略可以有效提高支架抓取精度。

2.2 支架与托板螺母拧紧

首先设定支架装配孔目标点的像素坐标为(1 536,1 024),此为M4托板螺母装配孔中心位置,控制协作机器人使支架装配孔在视场范围內,使用卷积神经网络YOLOv5模型对托板螺母上的装配螺纹孔进行目标检测(图11),并使用孔定位误差测量与补偿算法实时引导机器人调整支架姿态,实现支架装配孔与托板螺母螺纹孔对中。

从表5数据可以看出,通过视觉引导可将装配孔从具有9 mm误差的位置引导至目标点,定位误差为0.061 mm,远低于拧紧装配要求的0.2 mm精度,满足拧紧装配使用要求。

2.3 制孔划窝和插钉铆接

在支架与托板螺母拧紧后,需对支架托板螺母的铆接孔位置完成支架表面的钻孔和锪孔,并在铆接孔插入铆钉,此过程均需视觉引导(图12)。

实验完成的支架零件如图13所示。图13(a)展示了支架零件施工螺钉拧紧与钻锪孔效果;图13(b)(c)展示了铆接孔加工质量满足要求,验证了支架托板螺母铆钉孔定位误差测量与补偿技术的可实施性,且满足钻孔±0.1 mm的精度要求。

3 结论

本文通过研究运载火箭支架零件自动装配技术,研制出一套利用协作机器人对运载火箭支架进行自动抓取和装配的可实施工艺和设备,在自动识别抓取的环节采用卷积神经网络、支架位姿估计和夹具位姿估计的方法,最终抓取精度小于0.7 mm;在自动拧紧、制孔划窝、自动插钉环节,通过视觉引导装配孔定位误差检测和补偿,精度可达0.061 mm,突破了支架自动装配中的难点;采用实物加工验证了支架自动装配的可行性和可靠性,解决了支架零件手工操作产品质量不可靠、生产效率低、劳动环境差及强度大等问题,为运载火箭中支架类多品种、小批量零件的自动化装配应用奠定了一定的基础。

[参考文献]

[1] 郑健红.面向机器人精确拾取的散乱金属零件识别与定位方法研究[D].杭州:浙江工业大学,2020.

[2] 方舟,程筱胜,崔海华,等.基于GAPSO-SVM的钣金零件图像识别方法[J].机械制造与自动化,2020,49(5):116-118.

[3] 范荻,金守峰,陈蓉,等.面向装配机器人的零件视觉识别与定位方法[J].西安工程大学学报,2018,32(1):114-120.

[4] 田清廉,熊天辰,黄翔,等.一种基于散乱点云的铆钉孔孔位提取方法[J].航空制造技术,2022,65(7):83-89.

[5] 刘华.视觉定位关键技术及其在飞机装配中的应用研究[D].杭州:浙江大学,2019.

[6] 方舟.面向机器人装配的机器视觉工件识别与定位技术研究[D].南京:南京航空航天大学,2020.

[7] LU C S,XIA S Y,SHAO M,et al.Arc-support line segments revisited:an efficient high-quality ellipse detection[J].IEEE Transactions on Image Processing,2019,29:768-781.

[8] WANG C,ZHANG Y C,ZHOU Y F,et al.Automatic detection of indoor occupancy based on improved YOLOv5 model[J].Neural Computing and Applications,2022,35(3):2575-2599.

收稿日期:2023-03-01

作者简介:马庆丰(1983—),男,河南安阳人,工程师,研究方向:航天自动钻铆及非标自动化产品开发。