基于深度学习的细粒度皮肤癌图像分类研究

2023-07-07蔡立志陈敏刚王乃琪

蔡立志 章 伟 陈敏刚 王乃琪

1(上海计算机软件技术开发中心上海市计算机软件评测重点实验室 上海 201112) 2(华东理工大学信息科学与工程学院 上海 200237)

0 引 言

皮肤癌是恶性皮肤肿瘤的统称,是由于癌细胞的失控生长引起的,并感染转移到身体其他部位,包括恶性黑色素瘤、基底细胞癌、鳞状细胞癌等。在过去几十年里,皮肤癌特别是黑色素瘤的发病率一直呈现出逐渐上升的趋势[1]。2012年,美国有76 250例新发黑色素瘤病例,估计因此而死亡的病例高达9 180例[2],2018年美国癌症协会最新发布的癌症统计报告数据显示[1],2018年美国新增91 270例黑色素瘤病例,相较于2012年增加了19.70%,新增死亡病例9 320例,较于2012年增长1.53%。在国际上,皮肤肿瘤的威胁也不容小觑,全世界每年发生132 000种黑色素瘤皮肤癌[3],并且在过去30年中,在大多数发达国家中,其发病率和死亡率都在增加[4]。我国的皮肤癌发病率处于较低水平,但近年来皮肤肿瘤的发病率也急剧上升,每年都在以3%~5%的比例逐渐上升,年新增病例约两万人[5]。

预防和及早发现对于逆转这一趋势至关重要[6]。研究表明,在早期发现和诊断皮肤癌,可以通过简单的切除治愈,患者5年内的存活率提高到95%以上,而等到晚期则面临高于80%的死亡风险[7-8]。因此,临床中准确区分恶性皮肤癌变与良性痣等良性病变至关重要。

利用深度神经网络分类识别皮肤癌图像是当前的研究热点,但是这些方法要么仅仅采用精调预训练通用图像分类模型,而没有充分考虑任务图像的自身特征,要么利用简单的特征融合,不能很好地应对皮肤癌多病症细粒度类别分类的挑战。本文结合通用图像分类模型和图像分类子领域中细粒度图像分类问题深入研究皮肤癌图像分类,并结合源数据集ISIC中病症图像对应的元数据特征分析验证分类模型结合元数据的分类效果。本文的贡献包括:

梳理计算机辅助皮肤癌诊断的各类方法,对深度神经网络在皮肤癌图像分类的应用进行实验研究,使用迁移学习对比当前各卷积神经网络模型分类能力,并以此作为基准实验。

研究皮肤癌病损图像类别类间相似性特征,将图像细粒度分类引入医疗图像分类诊断,结合细粒度分类模型NTS-Net作为诊断模型,提供端到端的模型训练,对比上述基准实验,分类结果显著提升。

结合原始数据集ISIC的图像元数据特征,将诊断模型特征与元数据(metadata)特征融合探索元数据特征对于分类的影响。

1 相关工作

当前皮肤癌诊断方式包括医生肉眼诊断、活体病理分析、皮肤镜检测、传统计算机辅助诊断、基于深度学习的计算机辅助诊断。一般临床实践诊断是直接依靠皮肤科医生的肉眼来进行判断的,但这种临床诊断极易受到医生临床经验的主观因素以及实际诊断环境等客观因素的影响。同时,活体病理分析方法又过于费时费力[9]。相比而言,基于皮肤镜的临床检查则具有更好的实际效果,相应诊断结果的灵敏度增加了10%~30%[10]。皮肤镜[11]是一种无创性的皮肤成像技术,它可以通过可视化增强病变区域肉眼无法辨别的颜色、形态、纹理等特征来表征图像。将临床上的皮肤病学和皮肤病理学规则联系起来,为皮肤科的医生提供了一种额外的诊断途径,是早期诊断、筛查、计算机辅助检测的主要载体[12]。常见的对于诊断皮肤镜图像的方法有ABCD准则[13]、模式分析法[14]、孟氏法[15]和七点特征法[16]。这些规则主要对应皮损区域各种形态学特征。但是,皮肤镜检查仍有一些不足,例如无法自动识别皮损区和非皮损区、难以区分高度视觉特征相似病变等[17]。

于是研究人员提出基于皮肤镜检查规则的计算机辅助诊断系统,原理是先对病变区进行分割,然后从病变区域及其边界提取手工特征,最后进行分类识别。在传统计算机辅助诊断系统中的主要挑战是病变区域分割和从原始数据中选择有效的特征。具体来说,任务难度是准确地检测病变的边界,因为有不同的环境因素,如毛发、光照效应、低的病变对比度、不对称和不规则的边界、切口边缘等。在特征提取步骤中,提取了形状、颜色、纹理、梯度等多种类型的特征。但是,对分类的显著特征并没有明确的认识。获取到特征数据后,将所选特征与相应标签一起用于训练分类器,例如,支持向量机、随机森林或者多层感知器[18-19]。之后可以将训练后的模型用于对新的皮肤病变图像进行分类。这类方法的不足是由于皮肤镜图像的高度变化、伪影和训练数据不足而导致缺乏泛化能力。

目前,深度神经网络(DNN),尤其是卷积神经网络(CNN)[20-21]在对象检测和自然图像分类等任务方面优于传统特征工程方法,其分类、检测和分割的能力已经在许多医学图像分析任务中取得突破。Kawahara等[22]提出了一种基于AlexNet[20]的全卷积神经网络,对原始数据图像进行多尺度特征提取,并对10个类别的皮肤疾病图像进行诊断分类。文中并未对皮肤图像做病损区域的分割以及其他复杂的预处理,但结果相较于之前的方法有了明显的提升。Pomponiu等[23]提出了一种基于知识迁移思想的模型Deepmole,该模型首先利用自然图片来训练深度神经网络,然后把该网络当作特征提取器直接在皮肤镜图像上提取相关的特征,并最后进行分类操作。实验结果证明,Deepmole对于皮肤病变的类别诊断上的准确率要明显优于其他常规方法。2017年2月,斯坦福大学Sebastian Thrun研究团队采用深度学习方法对皮肤镜和临床皮损图像进行自动分类,并在Nature上发表了相关研究成果[7]。但是这些方法要么仅仅依靠从自然图像数据集(例如ImageNet[24])训练特征提取器,而没有充分考虑皮肤癌图像的自身特征,要么仅利用通用卷积神经网络模型,不能很好地应对医疗图像识别任务的挑战。所以,卷积神经网络仍有很大潜力空间来进一步提高皮肤癌图像识别的精度。

2 细粒度图像分类

2.1 细粒度图像

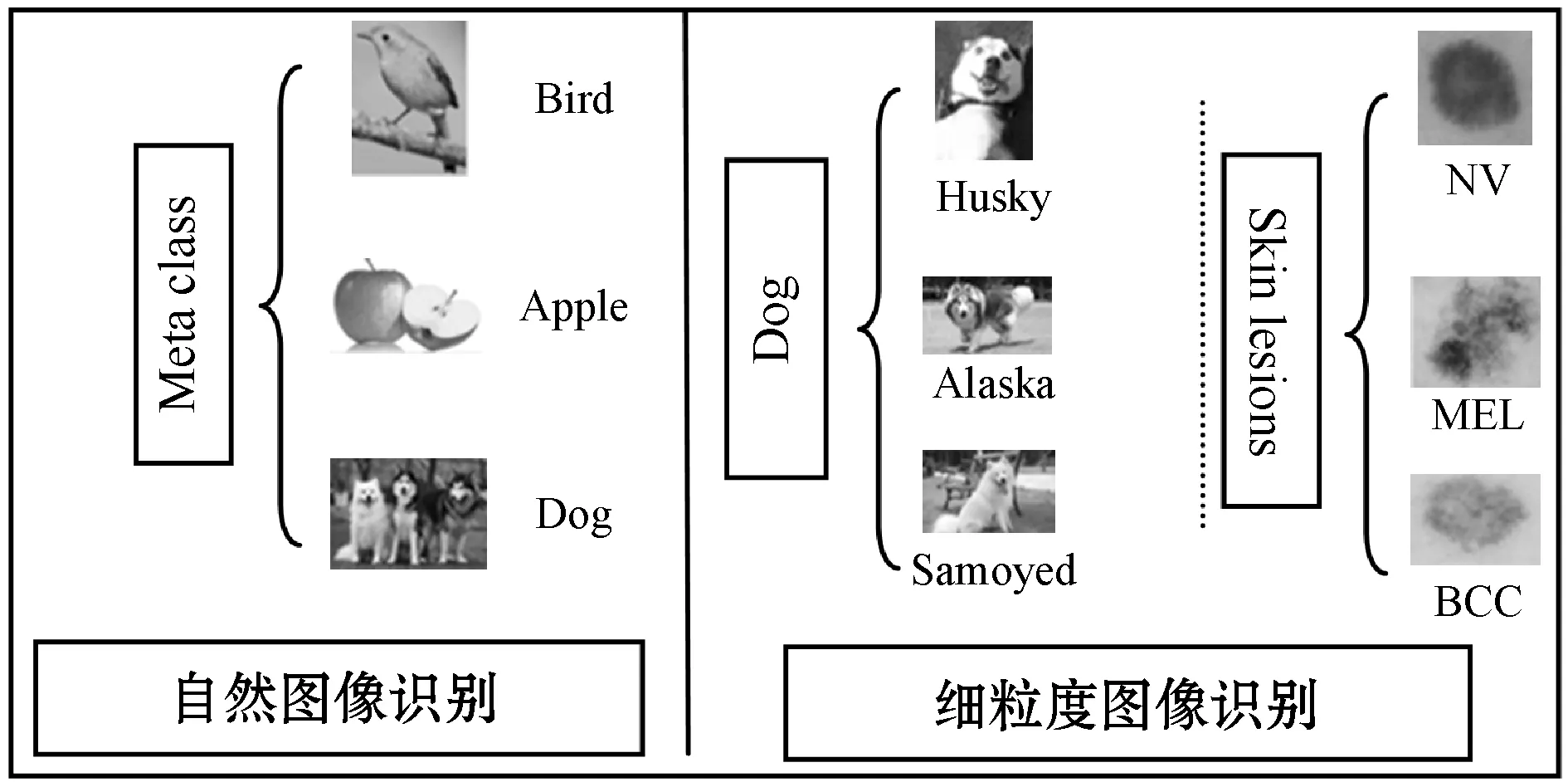

细粒度图像分类,又被称作子类别图像分类,是近年来计算机视觉、模式识别等领域一个非常热门的研究课题。其目的是对属于同一基础类别的图像(汽车、狗、花、鸟等)进行更加细致的子类划分,但由于子类别间细微的类间差异,较之普通的图像分类任务,细粒度图像分类难度更大。因此,要想顺利地对两个极为相似的对象进行细粒度分类,最重要的是在图像中找到能够区分这两个对象的区分性的区域块,并能够对这些有区分性的区域块的特征进行较好的表示,如图1所示。

图1 自然图像、细粒度图像、皮肤癌图像分类识别

在真实的现实场景应用中,有非常多的细粒度图像识别和细粒度图像检索的任务。2016年,美国大自然保护协会在kaggle[25]上发布的比赛要求对甲板上的6种鱼类进行识别和分类,很显然这就是一个细粒度图像识别任务。2018年、2019年,kaggle上发布根据鲸鱼露出来的尾巴进行个体级别的分类任务,相对于子类的分类来说,个体级别的分类是更细粒度的分类问题。此外在新零售的场景中,我们也会有非常多的细粒度图像的识别需求,例如对货架或者购物车中不同商品的分类检测就是一种图像细粒度识别任务。

对于医疗AI领域而言,需要关注的是医疗图片与自然图片的区别,自然图像分类检测所面临的问题是更深的网络以提高网络的特征表示能力,更快的检测速度达到较好的实时性以及更好的检测效果;而医疗图像的分类检测,基本是针对某一个特定特征(如结核、肿瘤)的检测识别,本身就具有很强的类间相似性,更偏向于细粒度图像分类的方向。

在皮肤癌图像分类检测任务中,多数是直接采用通用的卷积网络进行医疗图像分类,或者是采用迁移学习的思想进行模型的微调。这些分类网络具有较强的特征表示能力,因此在常规图像分类中能取得较好的效果。然而在细粒度分类中,不同类别之间的差异其实十分细微,因而整体的分类效果并不理想。在本文中,我们将细粒度特征结合到皮肤癌图像分类中,使用名为NTS-Net[26]的细粒度模型,最后结合皮肤癌图像的metadata特征优化模型。

2.2 模型分析

在本文中,我们将图像细粒度分类引入皮肤癌图像分类中,结合自监督分类模型NTS-Net,采用多代理合作学习方法来解决准确识别图像中信息区域的问题,训练出一个端到端的分类检测模型。

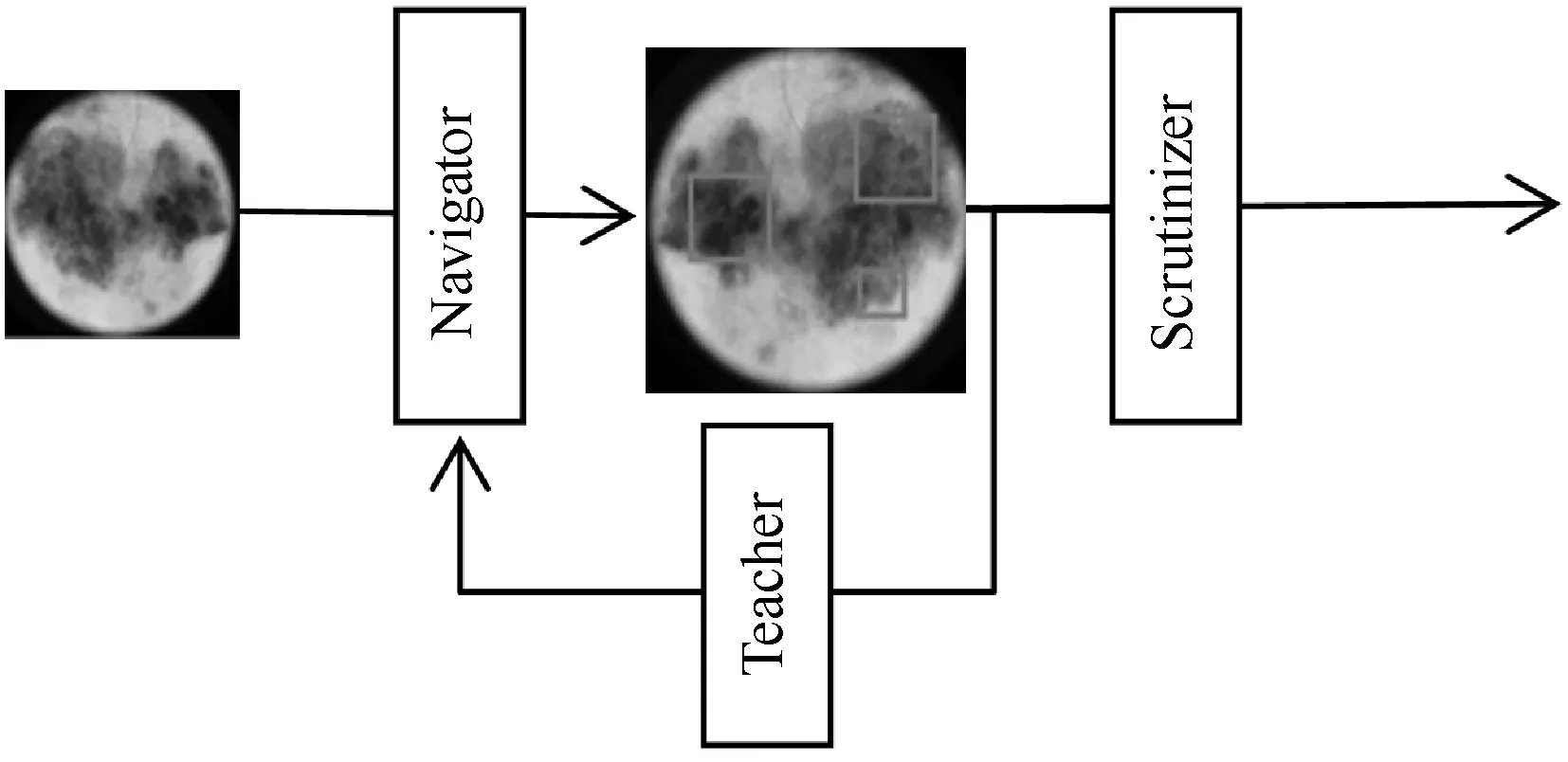

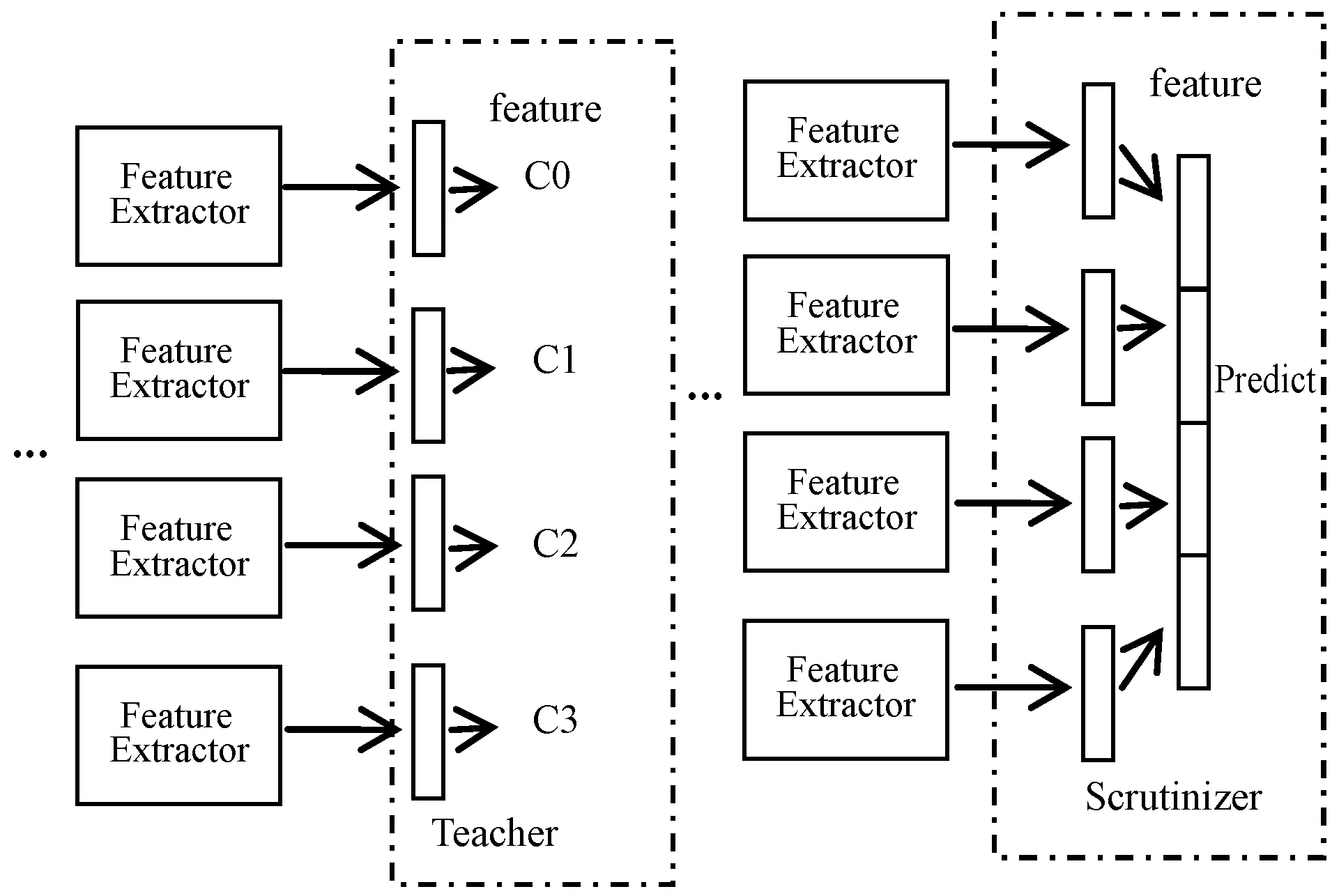

Navigator-Teacher-Scrutinizer Network模型结构如图2所示。

图2 Navigator-Teacher-Scrutinizer Network模型结构

Navigator部分作用是向后续的Scrutinizer部分提出图像中的建议区域,Navigator采用信息量标识图像中的区域,并从中挑选出最大信息值对应的区域,称为建议区域(Proposed region)。

Teacher评估Navigator的建议区域并提供反馈,对于每个建议区域,Teacher评估其属于真实类别标签(Ground-truth class)的概率,使用置信度反馈回Navigator部分,使得Navigator能获取较大信息值的区域。

Scrutinizer起到最终的分类作用,该部分会结合原图像和经过Teacher评估后Navigator提出的建议区域两个来源获取分类特征,将两部分特征作为最后输入分类器中的分类特征。

NTS-Net模型依赖于一个假设条件:对于细粒度图像分类任务,图像A中的信息丰富区Ri域对应类别高置信度,符号表示为:

R1,R2∈A,

C(R1)>C(R2),I(R1)>I(R2)

(1)

式中:I代表信息量度量函数;C代表置信度评价函数。

I(R1)≥I(R2)≥…≥I(Ri)≥…≥I(RA)

(2)

式中:A表示anchors个数。

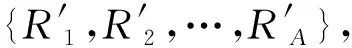

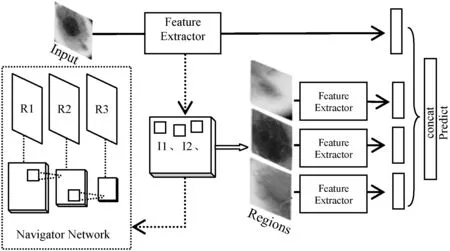

为了减少Navigator生成区域的冗余,模型采用非极大性抑制算法(NMS)。接着采取前M个信息区域{R1,R2,…,RM}并将它们输入Teacher network以获得每个区域R的分类置信列表{C(R1),C(R2),…,C(RM)}。最后优化Navigator network使得{I(R1),I(R2),…,I(RM)}和{C(R1),C(R2),…,C(RM)}具有相同的顺序。每个建议区域通过最小化真实标签和预测值之间的交叉熵损失来优化Teacher网络。Navigator结构如图3所示。

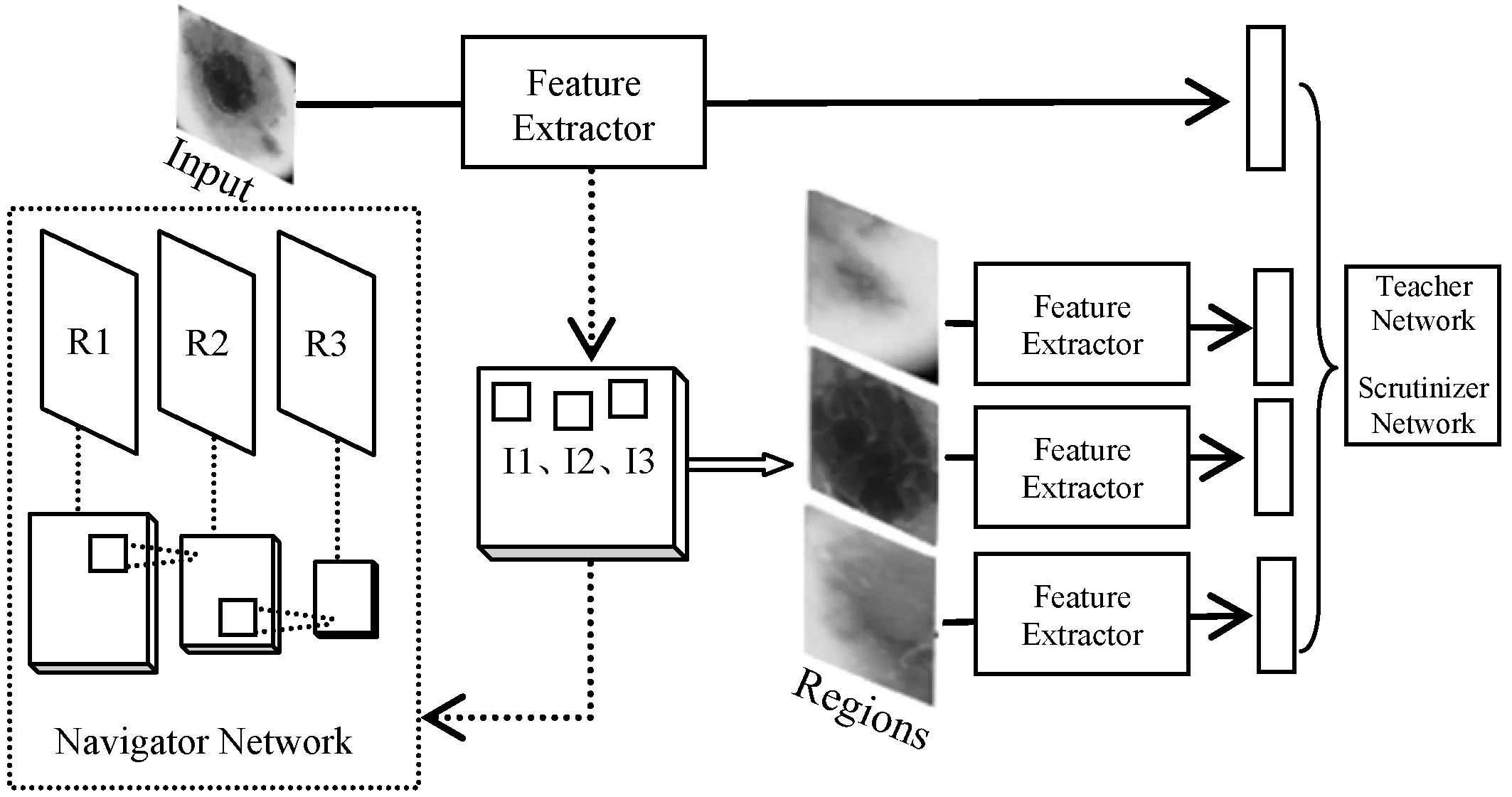

图3 Navigator网络结构

图4 Navigator和Teacher网络结构

使用Teacher网络代表Conf(Ri),网络结构类似于在特征向量连接全连接层以及Softmax分类预测。判断输入区域属于目标标签的概率。

Navigator网络的Loss为:

(3)

Teacher网络的Loss为:

(4)

Scrutinizer是最终的分类预测网络,Scrutinizer网络进行结果预测时会结合经过Teacher网络评估的由Navigator网络提交的信息建议区域特征和原图特征一起输入分类器中。实际上,这样的分类方式可以在不需要图像中位置信息标签的基础上自动识别图像中细粒度识别关键区域并提取特征用于分类。Scrutinizer结构如图5所示。

图5 Scrutinizer网络结构

Scrutinizer网络的Loss为:

Ls=-logS(X,R1,R2,…)

(5)

在模型具体结构上,特征提取使用的是ResNet50网络主体,即图5中的Feature Extractor部分。原图经过ResNet50后得到特征映射图,在此基础上添加两层卷积层,新添加卷积层参数Wi代表Navigator网络参数,输出为多尺度的建议区域图像的区域信息I。Teacher网络同样是在ResNet模型卷积基的基础上添加Softmax层分类,该部分模型参数为Wc。同时,输入Teacher网络的图像并非原图,而是将上一个Navigator网络生成的建议区域上采样到原图大小后输入。网络根据分类置信度C反馈回Navigator中各建议区域的信息量I。Scrutinizer网络的作用是分类,与Teacher的分类不同在于它会融合全图信息和建议区域信息,该部分模型参数为分类器Softmax参数Ws。

2.3 Metadata特征融合

上述方法是基于CNN模型,从中输出/提取深层特征用于分类。尽管此类方法在分类准确率上已取得较大提升,但是仍有空间可以进一步提高分类精度。研究CNN自动学习的特征与其他特征融合后的分类能力是一个重要的方向,即基于特征融合的思想。

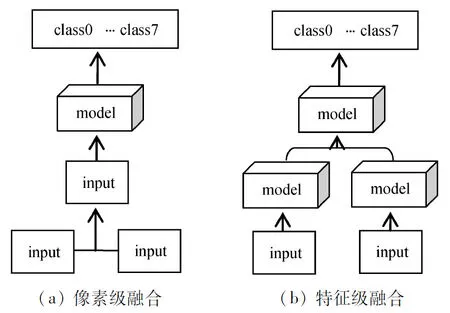

我们将特征融合的方式分为两类,即像素级融合、特征级融合,如图6所示。

图6 像素级和特征级融合

(1) 像素级融合:如图6(a)所示。图像融合的这种配置是最低级别的技术,通常是将来自不同来源的多个图像以像素方式组合为一个图像,然后将其输入到对象检测系统中以生成最终结果。像素级融合的主要优势之一是其计算复杂度低且易于实现。

(2) 特征级融合:如图6(b)所示,是相比于图6(a)更高级的融合系统。将不同特征提取器获取的特征输送到一个下游系统中,以产生最终结果。这里的特征提取器可以是传统特征工程提取的特征或者基于CNN模型学习的特征。

在本文中我们采用第二种基于特征融合的方式,这里将用到数据集标签中的3个维度的特征:位置、年龄、性别。

提取数据集中的除类别外的其他标签信息作为元数据特征,融合NTS-Net特征和元数据特征。图7展示在细粒度图像分类的基础上,融合元数据特征构建的分类网络。

图7 元数据特征融合网络结构

3 实 验

3.1 数据集

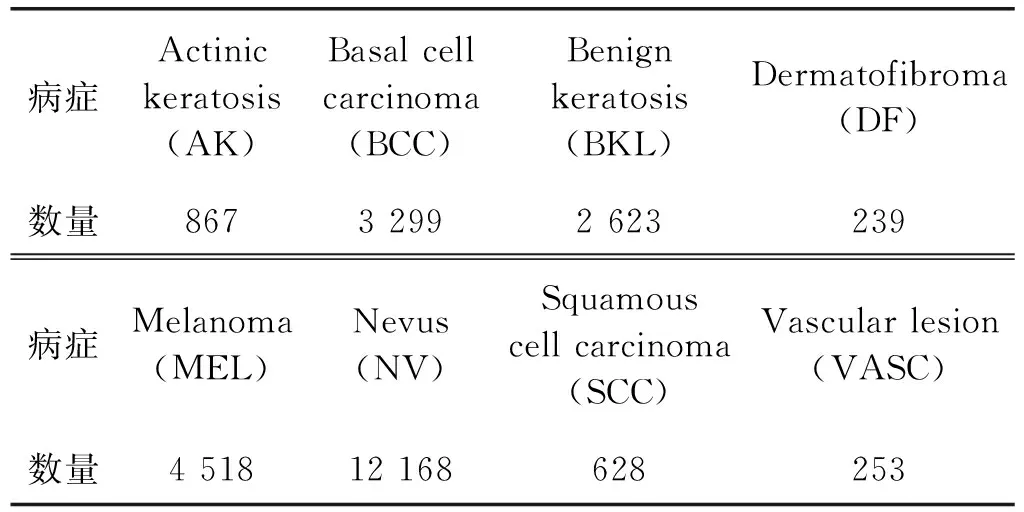

本文研究是针对ISIC 2019数据集中的8种不同类型病症的皮肤镜图像自动诊断类别,分别是:光化性角化病(Actinic keratosis)、基底细胞癌(Basal cell carcinoma)、良性角化病(Benign keratosis)、皮肤纤维瘤(Dermatofibroma)、黑色素瘤(Melanoma)、黑色素细胞痣/痣(Nevus)、鳞状细胞癌(Squamous cell carcinoma)和血管病变(Vascular lesionC)。如表1所示。

表1 实验数据集

3.2 实验结果

本文实验分为三组,基于ImageNet迁移学习模型(Exp 1)、NTS-Net细粒度分类模型(Exp 2)、基于Metadata特征融合模型(Exp 3)。

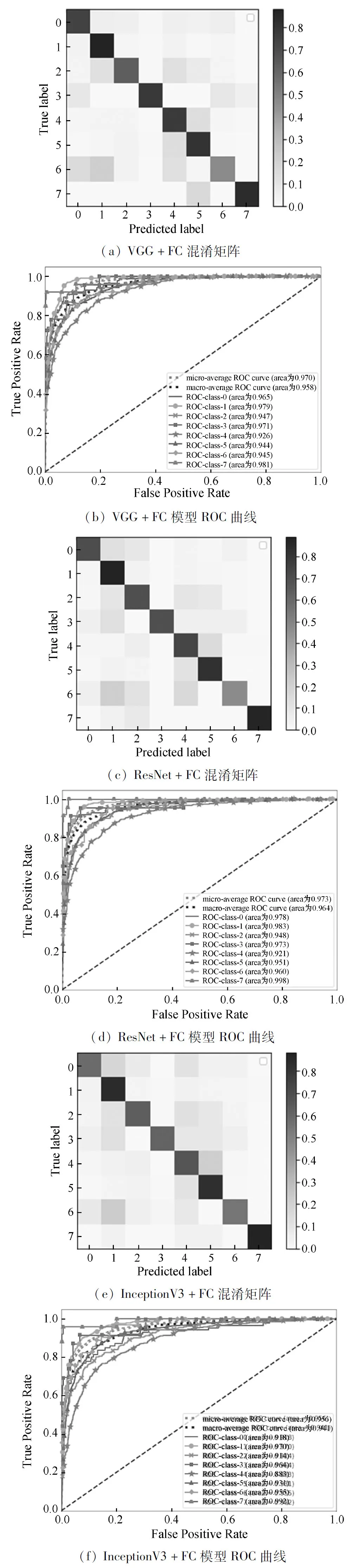

Exp 1为基于ImageNet预训练网络模型迁移学习皮肤癌图像分类。包括基于VGG[Exp 1-1]、ResNet[Exp 1-2]、InceptionV3[Exp 1-3]。对预训练模型的结构调整,首先去掉预训练模型的原始分类器(通常为最后一个FC层和所有输出层)。然后选择一个合适的分类器,本文构建新的全连接层接在卷积层后,并在其后面输出Softmax分类预测值,实验结果如图8所示。

图8 基于迁移学习模型混淆矩阵和ROC曲线

Exp 2为NTS-Net细粒度模型应用于皮肤癌图像分类实验。模型optimizer使用SGD,initial learning rate设为0.001,weight_decay设为1E-4;momentum设为0.9;区域建议数量M设置为6,使用的前K个信息区域K个数设为4;batch-size为16。

实验结果如图9和表2所示。

表2 NTS模型和ResNet模型实验结果对比

图9 NTS-Net模型混淆矩阵和ROC曲线

Exp 3为NTS-Net细粒度模型融合metadata特征分类实验。表3展示三组实验模型评价指标。

表3 NTS模型和元数据特征融合模型实验结果对比

4 结 语

以卷积神经网络为代表的深度学习方法在医疗图像分类识别领域有着广阔的前景,以迁移学习为基础针对特定类别图像的分类任务需要进一步探究。本文所提出的将图像细粒度分类方法应用于医疗图像分类任务中取得了较好的结果,但是仍有不足的地方,后续提升分类精度的方式将关注于细粒度图像特征的提取和分类。