注意力融合双流特征的局部GAN生成人脸检测算法

2023-06-25陈北京喻乐延舒华忠

陈北京 王 鹏 喻乐延 舒华忠

(1南京信息工程大学计算机学院, 南京 210044)

(2南京信息工程大学雷丁学院, 南京 210044)

(3东南大学影像科学与技术实验室, 南京 210096)

随着基于生成式对抗网络(GAN)的人脸生成技术的出现与发展,许多人脸处理工具被相继提出,使得人脸身份认证技术变得不再安全[1].人脸伪造检测也成为数字图像盲取证领域的热点研究方向之一[2-3].近年来,人们提出了许多检测方法[4-12]来识别恶意的GAN生成人脸.这些方法大致可以分为2类:基于内在统计特征的方法[4-7]和基于深度学习的方法[8-12].前者利用自然图像和GAN生成图像之间某一类型属性的不一致进行辨别,如人脸属性[4-5]、全局对称性[6]和颜色信息[7]等.然而,由于这些基于内在统计特征的方法大都以手工方式提取特征,其检测性能受到限制.而基于深度学习的方法则通过网络自动学习来提取所需的特征,通常比前者更有效.Liu等[8]通过结合Gram矩阵和ResNet网络来提取全局纹理特征以提高检测网络的鲁棒性.He等[9]利用浅卷积神经网络提取多个颜色空间的色度分量来提高检测网络的鲁棒性. Chen等[10]进一步研究发现,亮度分量和色度分量对GAN生成人脸检测网络的鲁棒性都起着重要作用,并且在YCbCr、RGB、HSV和Lab四种颜色空间中,使用YCbCr颜色空间和RGB颜色空间更有利于提高网络对不同后处理图像的检测性能,因此采用双流网络从YCbCr颜色空间和RGB颜色空间提取特征来检测GAN生成人脸.Chen等[11]提出结合全局特征和局部特征来检测GAN生成人脸,并取得了较好的泛化性.

上述生成人脸检测算法的提出均基于整张人脸都是生成的,即均为全局GAN生成人脸检测算法.但在一些实际情况中,只有小部分甚至极小部分的区域是生成的,且随机出现在人脸中的某个位置,导致特征更难提取和分辨.以上全局GAN生成人脸检测方法在局部GAN生成人脸检测任务中可能效果受限.为此,Chen等[12]首次针对局部GAN生成人脸检测任务开展了研究,利用空洞卷积技术和特征金字塔改进Xception网络以用于检测,并取得了较好的检测效果.然而,在实际场景中,生成的人脸常常伴随着一些后处理操作,如JPEG压缩、噪声和模糊等.而该工作在检测经过后处理的人脸图像时,检测性能大大降低.

本文提出了一种注意力融合双流特征的局部GAN生成人脸检测算法.利用GAN生成图像的伪影痕迹在RGB和YCbCr颜色空间中更稳定的特性,设计了一个双流网络从这2种颜色空间中提取鲁棒特征,并采用注意力特征融合模块融合双颜色空间特征,以增强关键特征信息,获得更鲁棒的特征表示.同时,设计多层次特征融合决策以有效提升网络对局部生成区域特征的提取能力和辨别能力.实验表明,本文算法针对多种后处理操作的鲁棒性优于现有算法.

1 注意力融合双流特征算法

本文提出的注意力融合双流特征算法总体架构如图1所示.首先,采用双流网络从RGB和YCbCr颜色空间中提取特征,并利用注意力特征融合模块在浅、中、深3个网络层上自适应地融合2个颜色空间特征;然后将融合后的浅、中、深层特征图分别经过全局平均池化和全连接层映射得到3个具有判别信息的特征向量;最后,将它们相加融合得到最终的特征向量来进行分类决策.

图1 注意力融合双流特征算法总体架构图

1.1 颜色空间转换

Chen等[10]比较了YCbCr、RGB、HSV和Lab四种颜色空间对不同后处理人脸图像检测性能的影响,发现使用YCbCr颜色空间和RGB颜色空间取得了更好的性能,尤其对于JPEG压缩,使用YCbCr颜色空间时检测性能最佳,并且这2种颜色空间对不同的后处理操作有不一样的影响.因此,本文同时从YCbCr和RGB颜色空间中提取鲁棒特征.

YCbCr颜色空间已经广泛应用于图像和视频压缩标准,如JPEG压缩和MPEG压缩等.YCbCr颜色空间和RGB颜色空间之间的转换关系如下:

(1)

式中,Y、Cb和Cr分别为YCbCr颜色空间中的亮度分量、蓝色色度分量和红色色度分量;R、G和B分别为RGB颜色空间中的红色色度分量、绿色色度分量和蓝色色度分量.待检测RGB人脸图像通过式(1)可转换得到YCbCr颜色空间图像,随后将2种不同颜色空间的待检测人脸图像分别输入到对应的RGB流和YCbCr流特征提取网络.

1.2 特征提取网络

Xception[13]是卷积神经网络Inception-V3[14]的改进版.文献[13]认为通道之间的相关性和空间之间的相关性需要分开处理,因此将Inception-V3中的普通卷积改为深度可分离卷积.不同于普通卷积,深度可分离卷积将卷积操作分成2步:① 在输入特征的每个通道上,分别使用空间卷积进行卷积操作;② 使用1×1卷积将上一步得到的特征在通道上进行加权组合.深度可分离卷积的这种操作方式不仅可以降低网络的参数数量,同时也可以减少运算量.文献[1]和文献[15]分别在GAN生成人脸检测任务和伪造人脸视频检测任务中对一些经典网络的检测性能进行了对比,发现Xception网络均展现了最好的性能.因此,本文采用Xception作为2个分支的特征提取网络.

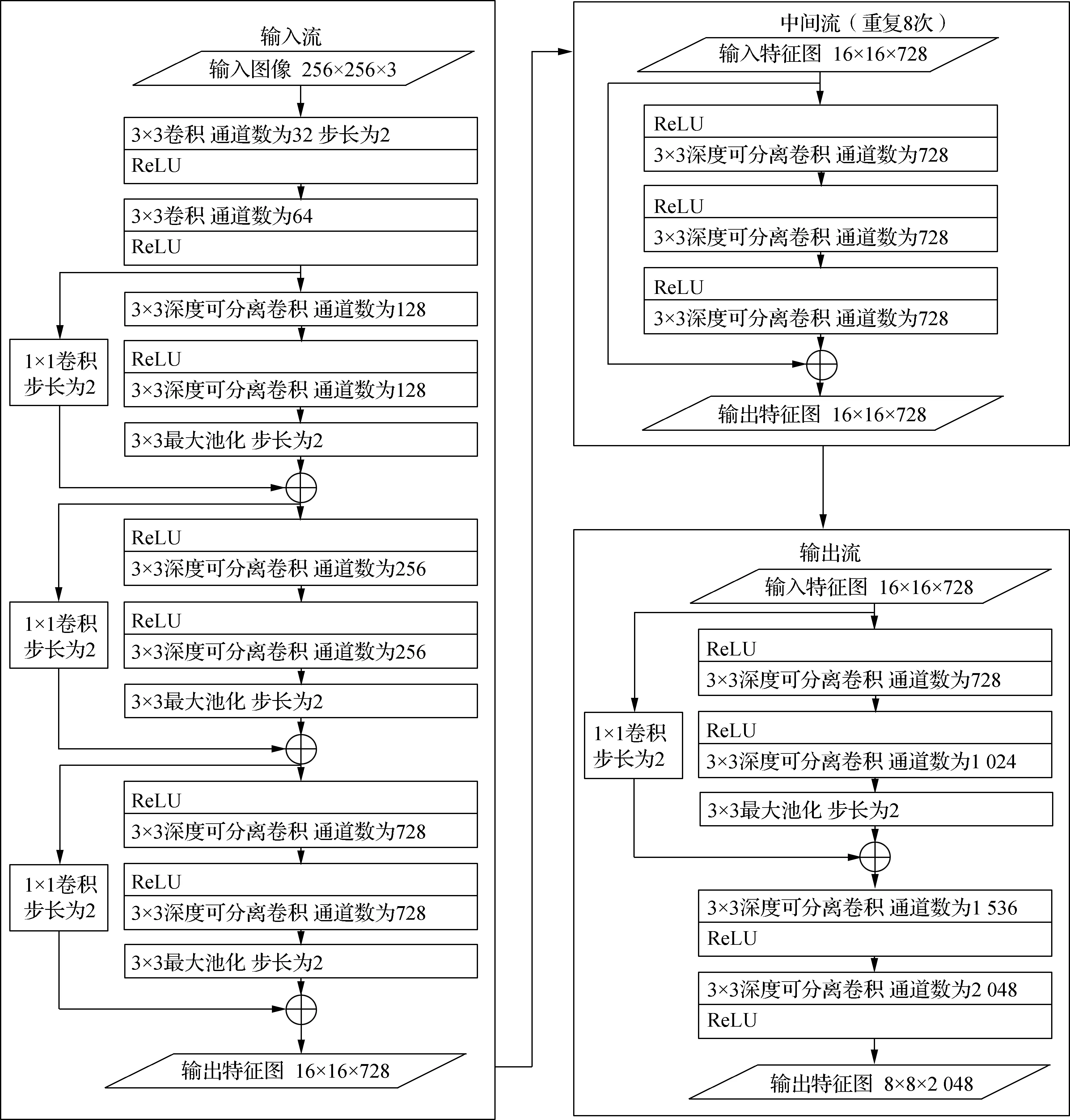

Xception特征提取网络的结构如图2所示,可分为输入流、中间流、输出流3个部分.其中输入流为特征提取网络中的浅层网络,中间流为中层网络,输出流为深层网络.由于后续多层次特征融合决策的设计,本文省去了输出流中的全局平均池化层和全连接层.

图2 Xception特征提取网络结构图

1.3 注意力特征融合模块

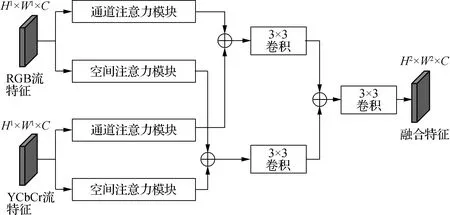

特征融合是指将多个特征组合成一个比其中任一输入特征更具鉴别性的新特征.在图像取证任务中,融合2种或更多类型的特征可以有效提高网络的检测精度和鲁棒性[16].如前所述,YCbCr颜色空间和RGB颜色空间在抵抗不同后处理操作的影响上各有优势[10].显然,融合2种颜色空间的特征可以获得更好的检测效果.此外,由于局部GAN生成人脸中的生成区域较小,伪影痕迹难以捕获,有必要引导网络学习更重要的特征.因此,本文引入包含通道注意力和空间注意力的注意力特征融合模块[17],通过2种注意力机制来增强RGB流和YCbCr流特征,再将增强后的特征相加融合.

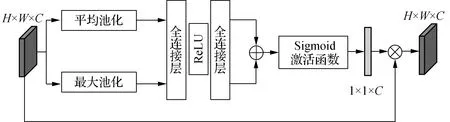

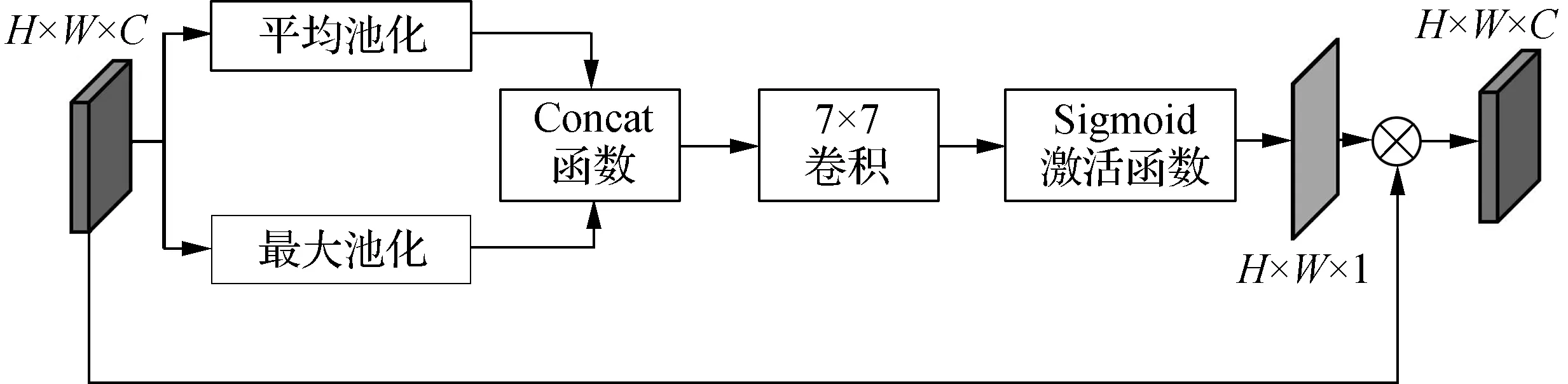

注意力特征融合模块的结构如图3所示,主要由通道注意力模块和空间注意力模块组成.通道注意力模块和空间注意力模块的结构分别如图4和图5所示.在通道注意力模块中,首先根据尺寸为H×W×C的输入特征构造尺寸为1×1×C的通道加权向量,然后将输入特征与通道加权向量相乘得到尺寸为H×W×C的输出特征,目的是使网络更关注含有重要信息的特征通道.在空间注意力模块中,首先根据尺寸为H×W×C的输入特征构造尺寸为H×W×1的空间加权矩阵,然后将输入特征与加权矩阵相乘得到尺寸为H×W×C的输出特征,目的是使网络更关注含有重要信息的位置.

图3 注意力特征融合模块结构

图4 通道注意力模块结构

图5 空间注意力模块结构

如图3所示,在注意力特征融合模块中,首先将尺寸均为H1×W1×C的RGB颜色空间特征FR和YCbCr颜色空间特征FY分别用2个注意力模块进行增强.然后将相同类型的注意力增强特征相加后进行卷积操作,得到通道注意力增强特征Fc和空间注意力增强特征Fs,其计算公式如下:

Fc=C(Ac(FR)+Ac(FY))

(2)

Fs=C(As(FR)+As(FY))

(3)

式中,C(·)为步长为1的3×3卷积操作;Ac(·)和As(·)分别为通道注意力模块和空间注意力模块中的操作.最后,将通道注意力增强特征Fc和空间注意力增强特征Fs相加后进行卷积操作,得到尺寸为H2×W2×C的融合特征F, 即

F=C(Fc+Fs)

(4)

1.4 多层次特征融合决策

由于局部GAN生成人脸中的生成区域通常较小,这些局部生成区域经过包含多个卷积层的深度网络传播后,在最终输出的特征图中可能会缩小至一个点,甚至完全消失,从而导致最终的特征向量无法进行有效的分类决策.因此,本文采用多层次特征融合决策,首先利用注意力特征融合模块分别在特征提取网络的浅、中、深3个网络层上融合RGB颜色空间和YCbCr颜色空间特征,得到尺寸依次为12×12×728、12×12×728和4×4×2 048的浅层特征图、中层特征图和深层特征图;然后分别将这3个特征图经过全局平均池化和全连接层映射得到3个具有判别信息的特征向量,多层次特征融合决策中的全连接层均含有2个神经元;最后将3个特征向量相加融合,得到最终的特征向量并进行Softmax分类决策.

整个网络的损失函数采用交叉熵函数表达,即

(5)

式中,L为交叉熵函数;i为第i个样本;yi为真实标签;pi为预测结果对应标签的概率.

2 实验

2.1 实验数据集

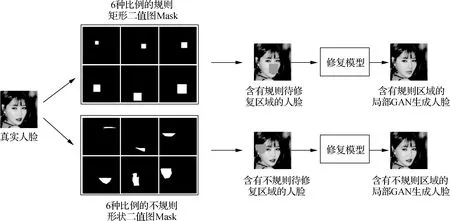

本文使用FFHQ数据集[18]和LGGF数据集[12]作为实验数据集.其中,FFHQ数据集为真实人脸图像数据库,包含7×104幅不同年龄、种族、性别的高质量自然人脸图像.LGGF数据集是Chen等[12]在FFHQ数据集基础上创建的局部GAN生成人脸数据集,LGGF数据集制作流程如图6所示.图中,局部生成区域对应于二值图Mask中的白色区域,包括规则矩形和不规则形状2种类型,每种类型均考虑了0.5%、1.5%、2.5%、3.5%、4.5%、5.5%六种不同的整张图像生成区域比例,且每种比例的二值图Mask数量均为7×104幅.首先,将FFHQ数据集中所有图像分辨率调整为256×256像素,并将调整后的FFHQ数据集与这2种类型的6种不同比例的二值图Mask组合,得到12种含有待生成区域的人脸图像数据集.然后使用Zheng等[19]提出的多元修复算法修复这12种含有待生成区域的人脸图像数据集,得到的LGGF数据集共有8.4×105幅图像,图像分辨率为256×256像素.本文从LGGF数据集中选取图像,根据图像中的生成区域是否规则将选取的图像分为规则子集和不规则子集,每个子集均有7×104幅图像,并分别与调整分辨率后的FFHQ数据集组合成FFHQ+规则子集和FFHQ+不规则子集2个数据集用于实验.

图6 LGGF数据集制作流程

实验中,本文采用和文献[12]同样的数据集划分方式,将上述2个数据集分别按5∶1∶4的比例分为训练集、验证集和测试集,且训练集、验证集和测试集中6种生成区域比例的图像数量相等.其中,验证集用于调整模型训练过程中设置的超参数,如学习率、批处理大小等.此外,为了测试本文算法的鲁棒性,分别对2个测试集进行5种常见的后处理操作,包括JPEG压缩(压缩质量因子为90、85、80),中值滤波(卷积核大小为3×3、5×5、7×7),椒盐噪声(噪声比为0.6%、0.8%、1.0%),高斯滤波(卷积核大小为3×3、5×5、7×7),双边滤波(卷积核大小固定为3×3,sigma参数分别为(25,25)、(50,50)、(75,75)).

2.2 实验设置

所有实验均在PyTorch框架上进行,并在11 GB GeForce GTX1080Ti、3.2 GHz i7-6900K CPU、64 GB RAM的环境下训练模型.在训练阶段使用Adam优化算法[20],并采用学习率固定为1.0×10-4的学习率策略.本文使用二分类任务中常用的标准度量准确率作为算法性能的评价指标.

2.3 消融实验

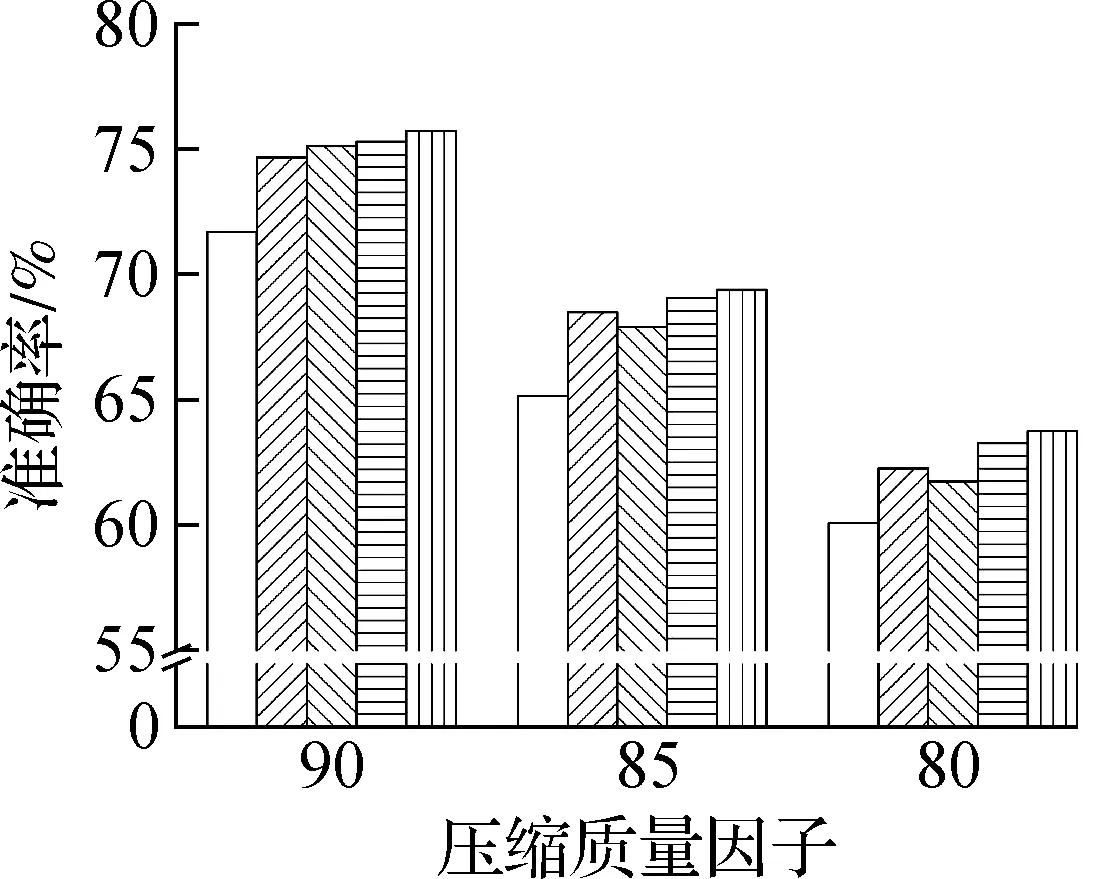

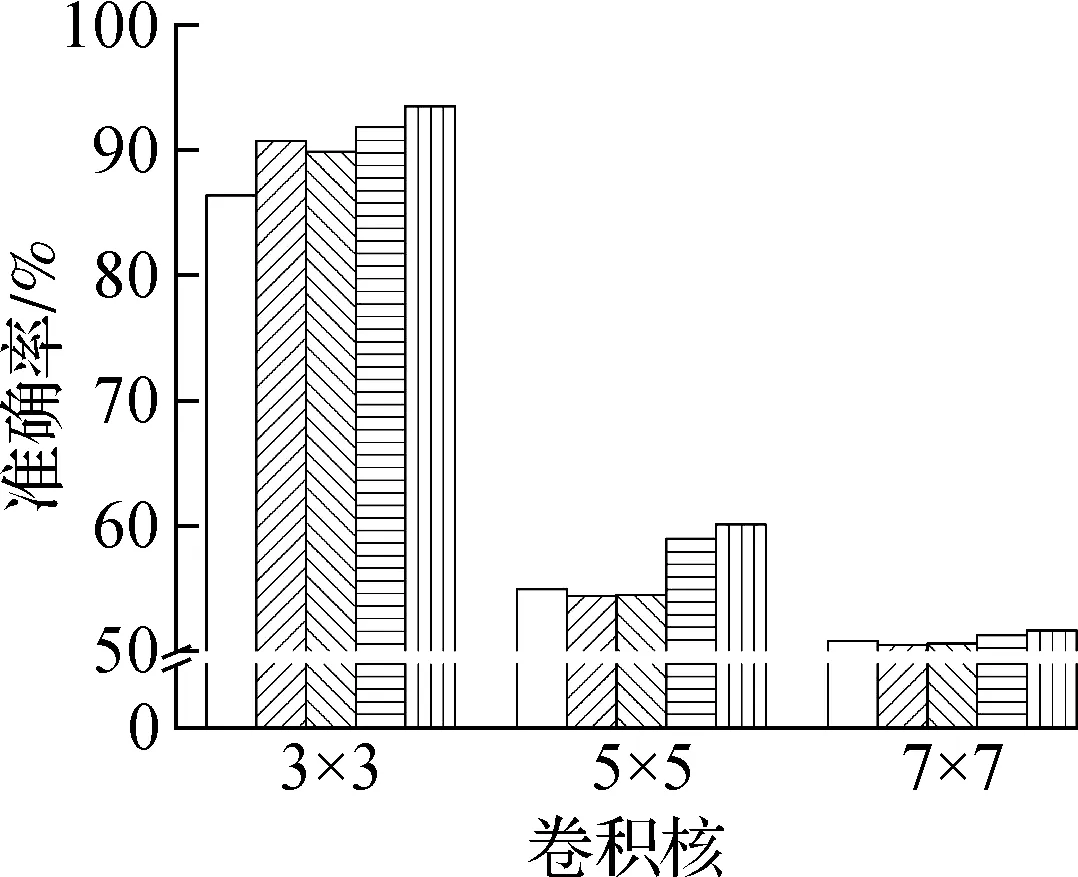

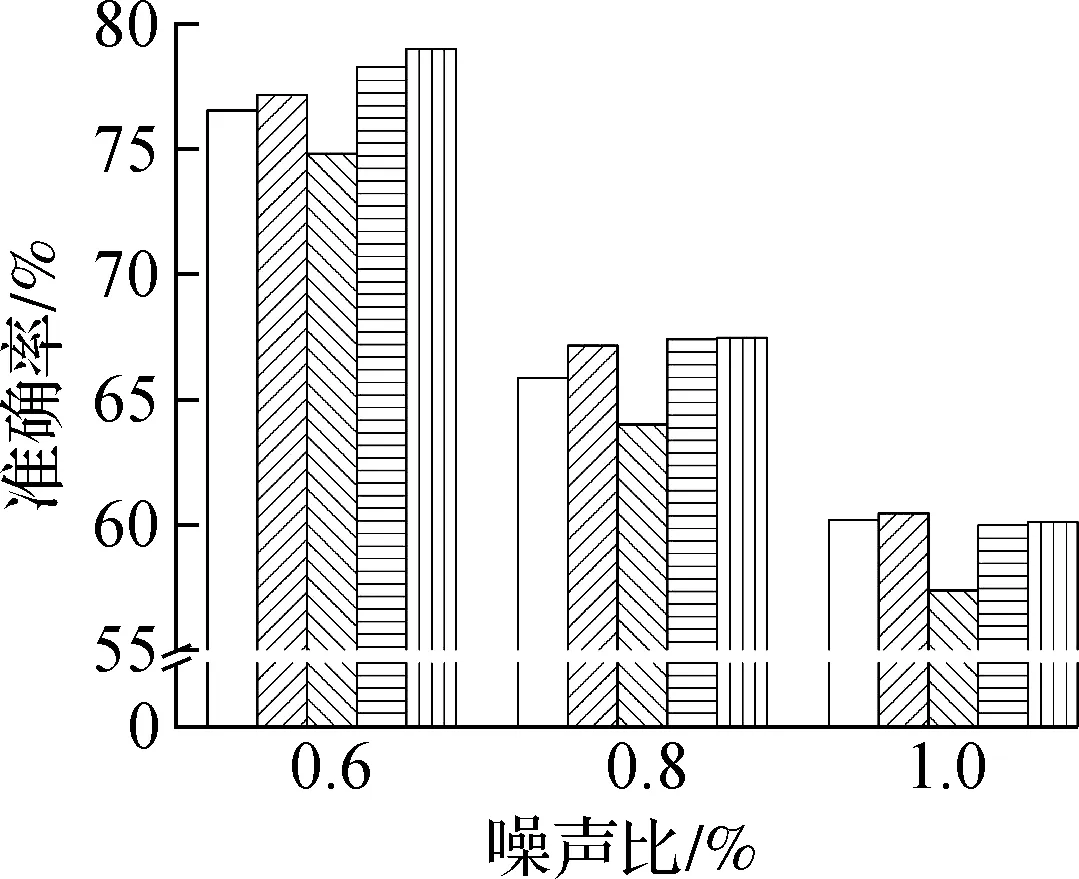

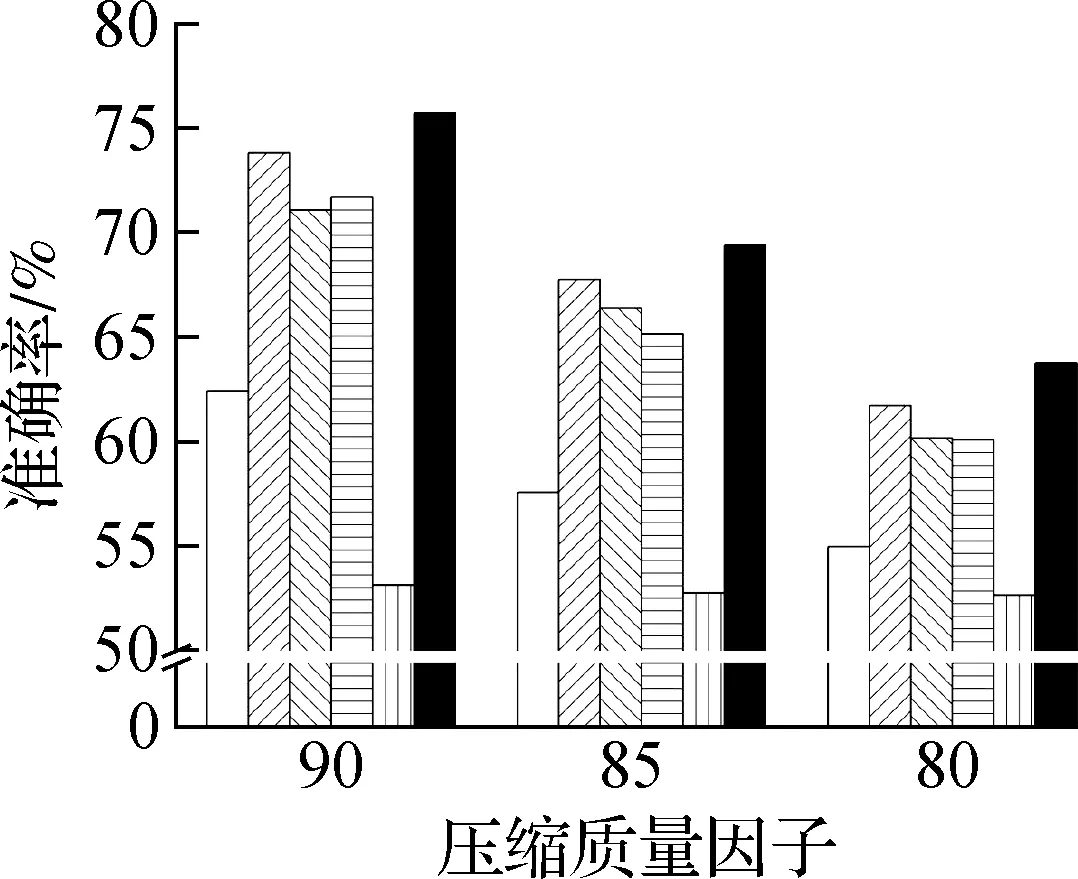

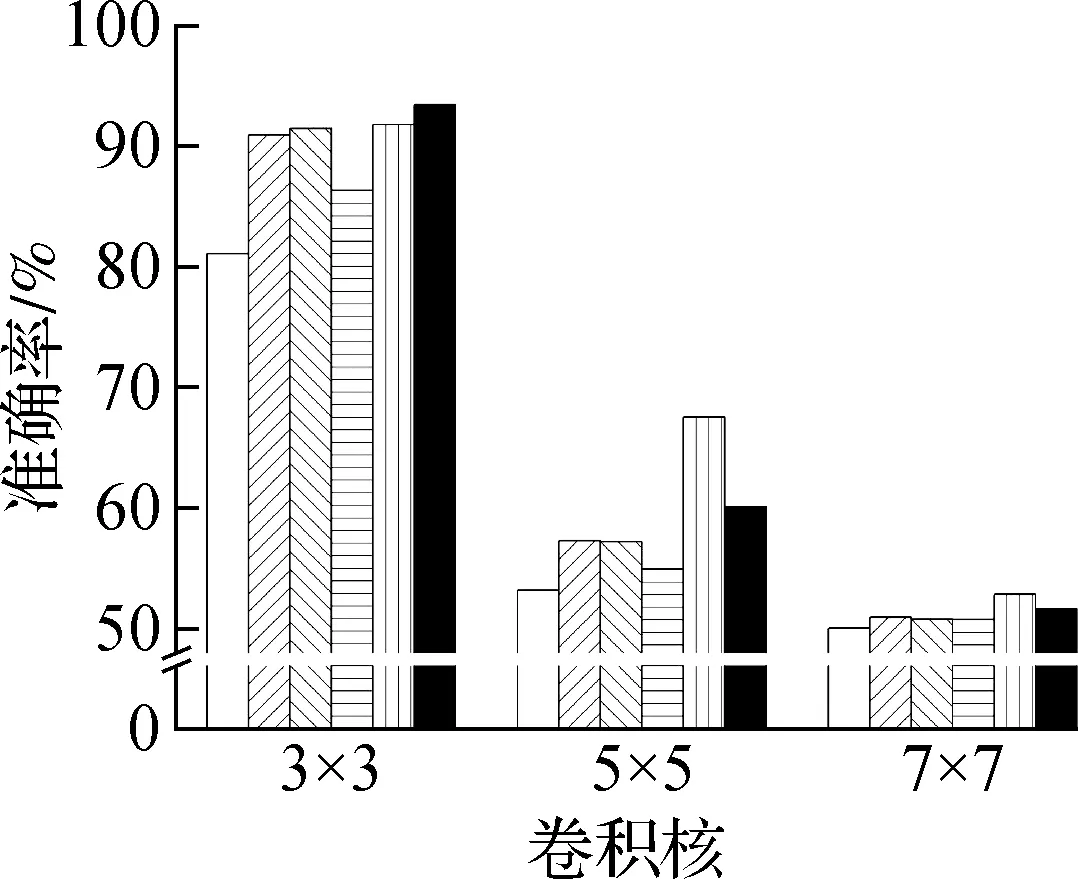

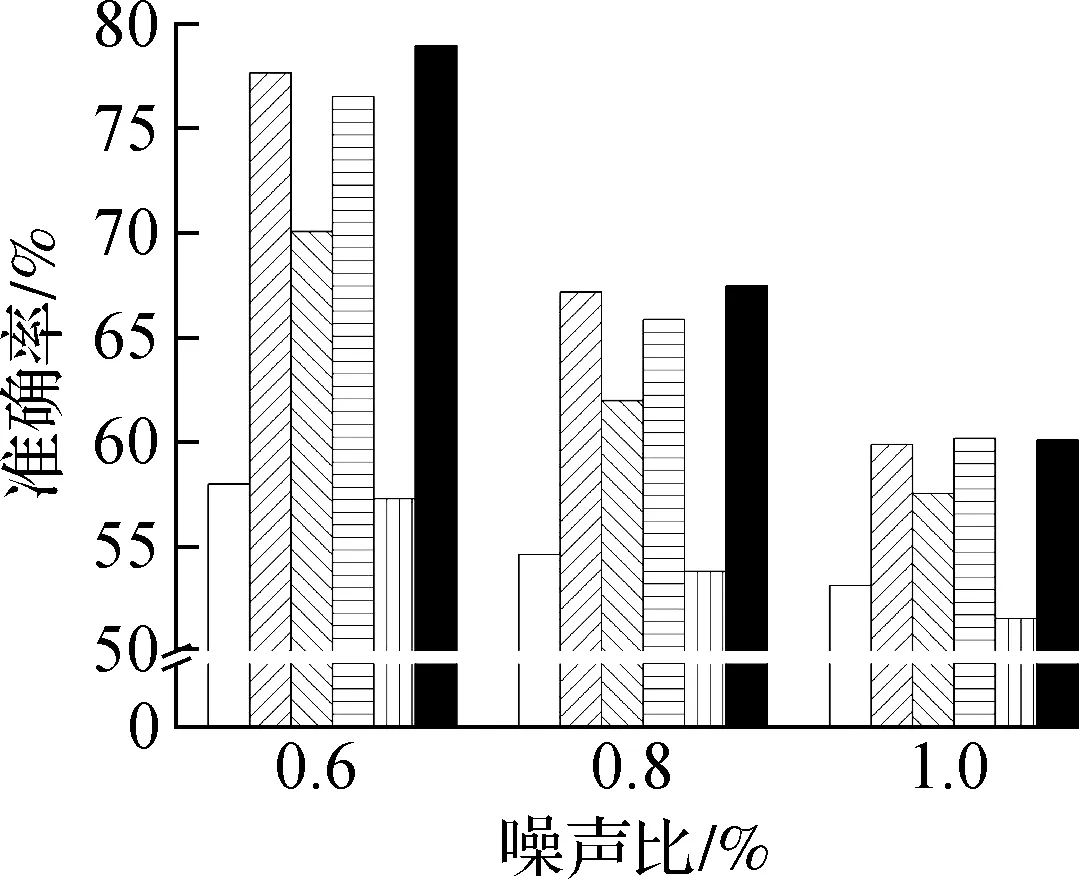

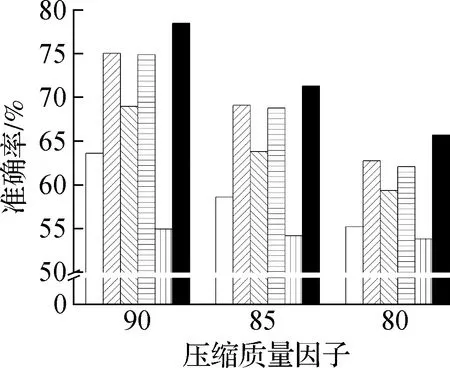

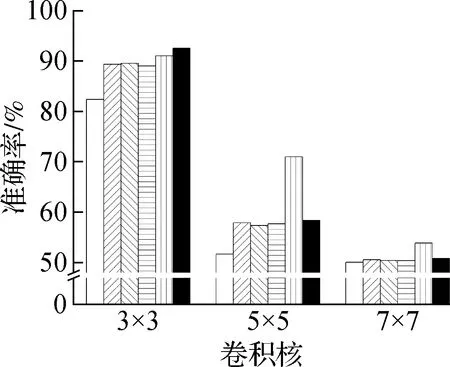

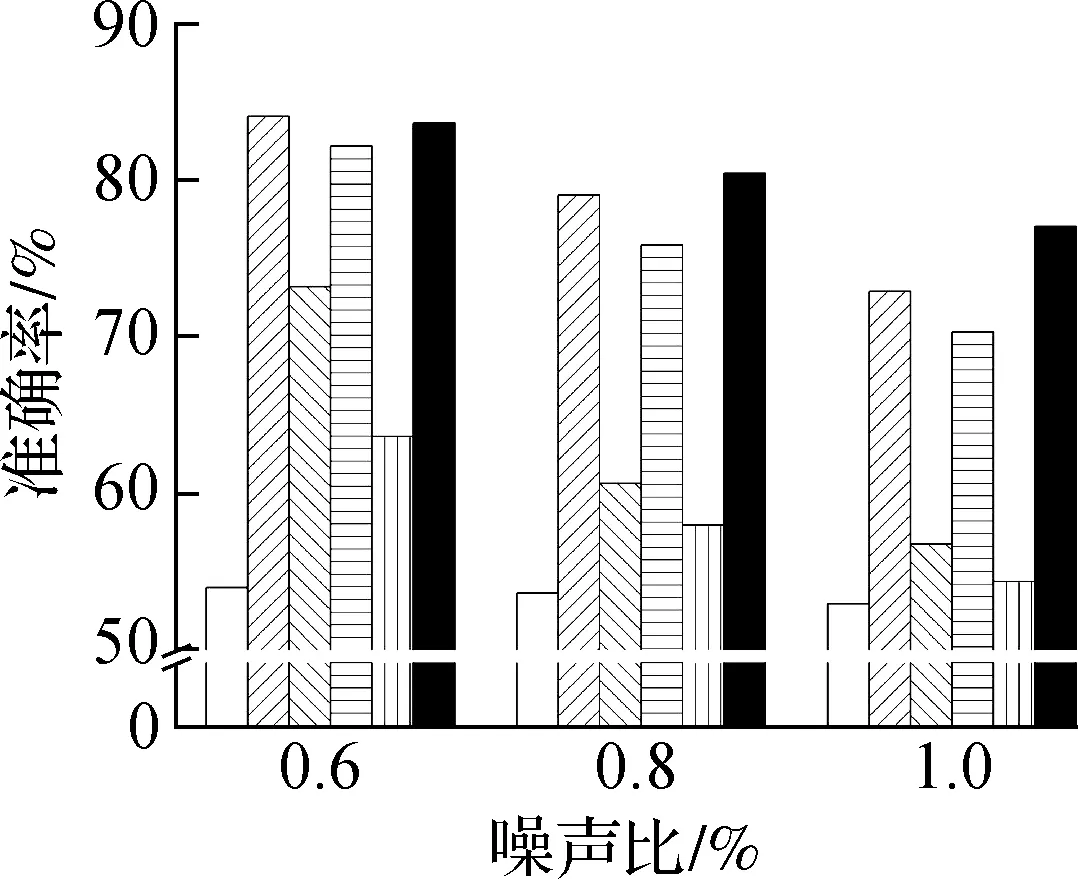

为了验证所提出的双流特征提取、注意力特征融合和多层次特征融合决策这3个改进方法的有效性,本节对5种不同算法的消融实验结果进行了对比:① 仅将RGB图像输入Xception网络进行分类的RGB算法;② 将RGB图像转换到YCbCr颜色空间后输入Xception网络进行分类的YCbCr算法;③ 首先将双流特征提取网络最终的输出特征相加融合,然后利用融合后的特征进行决策的RGB+YCbCr算法;④ 首先利用注意力特征融合模块(M1)融合双流特征提取网络的最终输出特征,然后利用融合后的特征进行决策的RGB+YCbCr+M1算法;⑤ 首先在双流特征提取网络的浅、中、深3个网络层上,分别利用M1融合双流特征,然后利用多层次特征融合决策(M2)的RGB+YCbCr+M1+M2算法.5种不同算法在FFHQ+规则子集和FFHQ+不规则子集上的消融实验结果分别如图7和图8所示.从图中可知,RGB颜色空间和YCbCr颜色空间对不同后处理操作有着不同的影响.因此,RGB+YCbCr算法同时使用这2种颜色空间作为输入是有意义的.相较于将特征简单地相加融合,RGB+YCbCr+M1算法利用注意力特征融合模块获得了更好的检测性能,且RGB+YCbCr+M1+M2算法利用多层次特征融合决策有效提高了网络的检测性能.在FFHQ+规则子集上,相较于最初的RGB算法,本文算法RGB+YCbCr+M1+M2在JPEG压缩、中值滤波、椒盐噪声、高斯滤波和双边滤波上的平均检测准确率分别提高了3.98%、4.37%、1.32%、7.48%和3.87%.在FFHQ+不规则子集上,相较于最初的RGB算法,本文算法RGB+YCbCr+M1+M2在上述5种后处理上的平均检测准确率分别提高了3.24%、1.57%、4.25%、4.16%和2.77%.消融实验准确率结果不但充分验证了双流特征提取、注意力特征融合和多层次特征融合决策单个改进方法的有效性,而且证明了这3个方法融合后可以获得最佳的检测效果.

(a) JPEG压缩

(b) 中值滤波

(c) 椒盐噪声

图7 在FFHQ+规则子集上的消融实验结果

2.4 性能测试

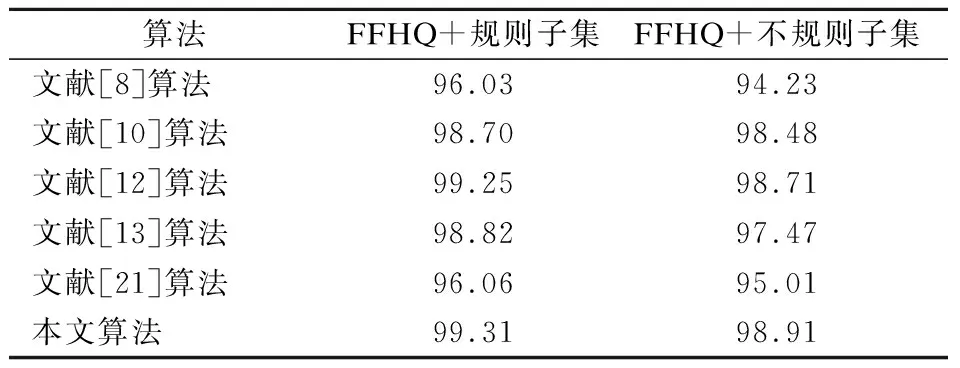

为了评估本文算法的有效性,将提出算法与文献[8,10,12-13,21]中的现有算法进行对比.其中,文献[21]算法采用的是Efficientnet_b0版本,由于该版本适用的分辨率为224×224像素,因此,将该算法的输入图像分辨率调整为对应大小.本文算法在未经后处理的FFHQ+规则子集和FFHQ+不规则子集上与其他算法的准确率对比结果如表1所示.从表中可以看出,在检测未经后处理的图像时,所有算法都表现良好,并且本文提出的算法优于其他算法.本文算法在FFHQ+规则子集和FFHQ+不规则子集上的准确率分别比次优算法提高了0.06%和0.2%.

(a) JPEG压缩

(b) 中值滤波

(c) 椒盐噪声

表1 本文算法与其他算法的准确率对比 %

本文算法在经不同后处理操作的FFHQ+规则子集和FFHQ+不规则子集上与其他算法的鲁棒性能比较分别如图9和图10所示.从图中可以看出,各算法的检测准确率都随着后处理操作强度的加强而降低.由于本文算法采用了RGB 和YCbCr两种颜色空间,同时利用注意力特征融合模块对双流特征进行了增强融合,并利用多层次特征融合决策提高了网络对局部生成区域特征的提取和辨别能力,因此本文算法的检测性能总体上优于相关对比算法.尤其是针对JPEG压缩和双边滤波后处理,在FFHQ+规则子集和FFHQ+不规则子集上,本文算法在3种强度的JPEG压缩和双边滤波上的检测性能均为最优.在FFHQ+规则子集上与次优算法相比,该算法在3种强度的JPEG压缩和双边滤波上的平均准确率分别提高了1.88%和2.64%.在FFHQ+不规则子集上与次优算法相比,该算法在3种强度的JPEG压缩和双边滤波上的平均准确率分别提高了2.85%和1.60%.

(a) JPEG压缩

(b) 中值滤波

(c) 椒盐噪声

(a) JPEG压缩

(b) 中值滤波

(c) 椒盐噪声

3 结论

1) 针对局部GAN生成人脸检测算法鲁棒性不足的问题,采用双流网络从RGB和YCbCr两种颜色空间中提取鲁棒特征,通过引入注意力特征融合模块在不同网络层融合双流特征以获得更鲁棒的特征,并设计了多层次特征融合决策提高网络对局部生成区域特征的提取和辨别能力.

2) 在FFHQ+规则子集和FFHQ+不规则子集上进行消融实验.结果表明,同时采用RGB颜色空间和YCbCr颜色空间,引入注意力特征融合模块以及设计多层次特征融合决策均有助于提升本文局部GAN生成人脸图像检测算法的鲁棒性.

3) 性能测试实验结果表明,本文算法的鲁棒性总体上优于现有算法,尤其是针对JPEG压缩和双边滤波这2种后处理操作,本文算法的检测性能均为最优.在FFHQ+规则子集上,与次优算法相比,本文算法在3种强度的JPEG压缩和双边滤波上的平均准确率分别提高了1.88%和2.64%.在FFHQ+不规则子集上,与次优算法相比,本文算法在3种强度的JPEG压缩和双边滤波上的平均准确率分别提高了2.85%和1.60%.