融合CoT Block的人物图像生成算法

2023-06-25姚星月

摘 要:目前,学者们对人物图像生成技术的研究主要集中在对人物姿势的编辑方面,忽略了身体的外观特征,导致所生成人物图像的质量不够理想。鉴于此,提出一种融合CoT Block的人物图像生成方法,即在已有PG2模型的基础上,将改进后的CoT Block引入到生成对抗网络中,通过对上下文语义信息的挖掘以及结合自注意力学习机制,更好地捕获人体姿态特征;然后利用PGGAN中的鉴别器进一步增强对图像真伪的鉴别能力。实验结果表明,改进后的算法有效提高了人物图像的生成质量。

关键词:图像生成;生成网络;CoT Block;PGGAN

中图分类号:TP391 文献标识码:A 文章编号:2096-4706(2023)07-0090-04

Abstract: At present, scholars' research on the generation technology of character image mainly focuses on the editing of character posture, ignoring the appearance characteristics of the body, resulting in the quality of the generated character image is not ideal. In view of this, a character image generation method fused with CoT Block is proposed, that is, based on the existing PG2 model, the improved CoT Block is introduced into the generative adversarial network, and the human posture features are better captured through the mining of context semantic information and the combination of self-attention learning mechanism; Then the discriminator in PGGAN is used to further enhance the ability to identify the authenticity of the image. Experimental results show that the improved algorithm can effectively improve the generation quality of character image.

Keywords: image generation; generative network; CoT Block; PGGAN

0 引 言

人物图像生成的目的是在保留源图像外观细节的同时,传输具有任意姿势的人物图像。这项任务现如今已成为计算机视觉中的一个新兴热门话题。它在许多任务中都有巨大的潜在应用,如视频生成、虚拟服装试衣、个人相关视觉人物的数据增强等。

深度学习在人物姿势转换方面取得了显著成果,其中生成对抗网络[1]是比较常用的方法。早期研究直接采用全局预测策略并通过U-Net结构传播低级特征,然而基于U-Net结构的全局方法往往无法解决源姿势与目标姿势之间的空间错位问题,这导致生成的图像存在各方面的细节缺陷。文献[2]提出两阶段姿势引导图像合成的方法(PG2),能够达到任意姿势的转换效果,并且首次提出了掩码损失,但是在生成图像的细节处理方面还存在不足。文献[3]将变分自动编码器(VAE)和U-Net相结合对人体姿态展开研究,通过跳跃连接和最近邻损失来优化GAN模型,但是U-Net中的跳跃连接容易引起空间位置上的特征错位,从而影响生成图像结果。文献[4]为了解决U-Net中跳跃连接所产生的特征错位现象,将其改为变形的跳跃连接,但可变形的跳跃连接需要提前进行预处理工作,在许多方面存在一定的局限性。文献[5]使用姿势注意力转换模块,将源姿势和目标姿势进行深度连接,然后再经过一系列级联更新操作,使网络能够关注这些姿态特征,之后在无监督的情况下生成带有姿态特征的人物图像。但是该方法仅仅关注了人体姿态,忽略了人物的外观、衣服的纹理细节等方面。文献[6]为了提供对各个区域中样式的详细控制,提出联合全局和局部的區域编码,空间感知规范化,达到解耦样式和形状,以及保留空间上下文信息,并且使用门控卷积,将源解析图重组,动态选择学习每个空间位置。但是所提出的门控卷积生成的目标解析图效果往往不稳定,这就会影响最终生成的图像质量。虽然上述的方法在一定情况下都取得了不错的效果,但在生成图像属性,包括纹理和风格方面仍然存在一系列的困难。

基于以上的讨论,在已有的两阶段姿势引导图像合成方法PG2模型上提出了一种融合上下文转换模块(CoT Block)[7]的人物图像生成算法。通过在Market-1501数据集和DeepFashion数据集上进行实验验证,并与之前存在的方法相比较,进一步验证了提出的方法在图像生成方面有较高的鲁棒性和较低的耦合性。

1 模型分析

模型在已有的两阶段姿势引导图像合成方法PG2的基础上,将改进后的CoT模块引入生成对抗网络中,提出了一种融合CoT Block的人物图像生成算法。

1.1 两阶段姿势引导图像生成模型

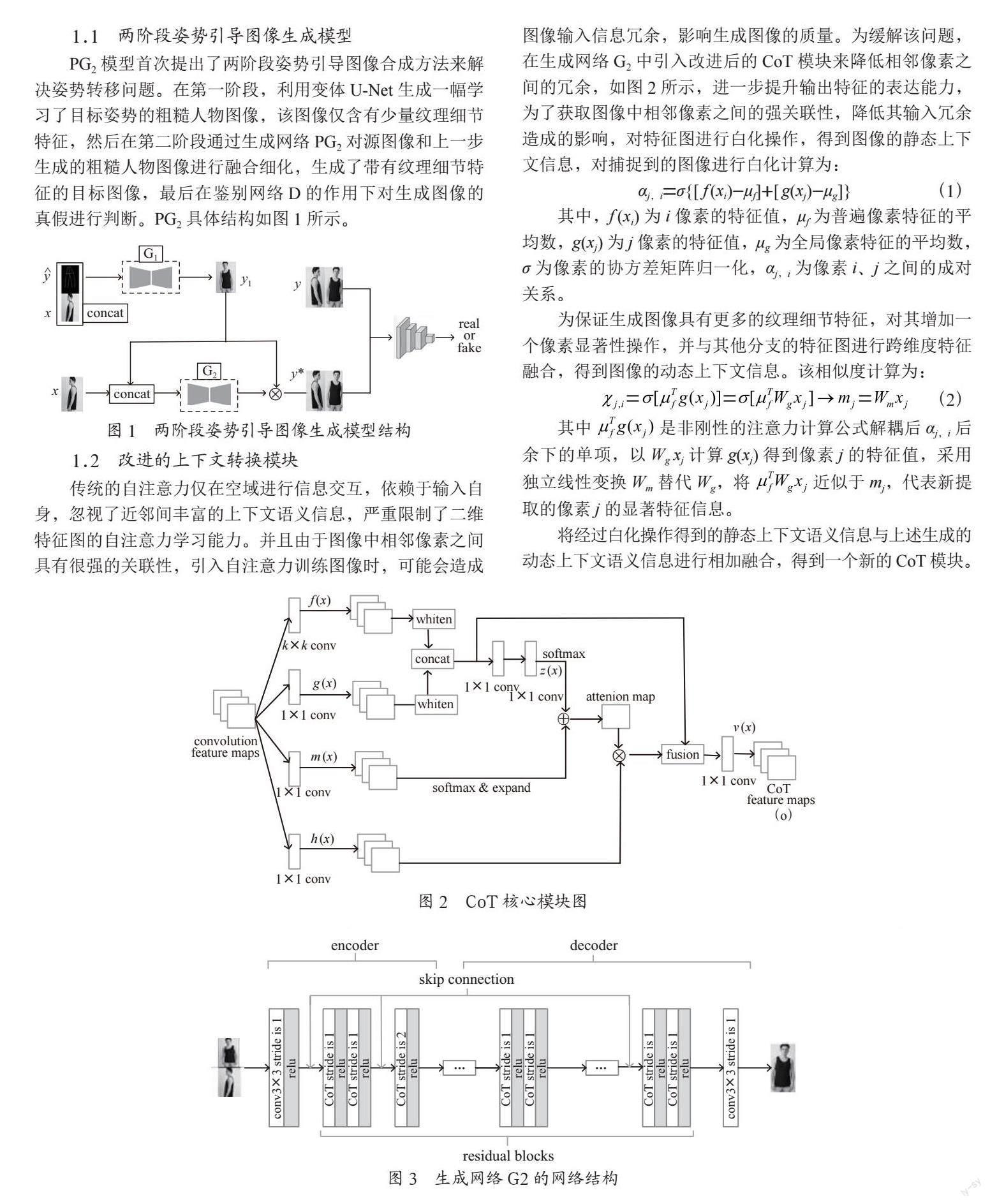

PG2模型首次提出了两阶段姿势引导图像合成方法来解决姿势转移问题。在第一阶段,利用变体U-Net生成一幅学习了目标姿势的粗糙人物图像,该图像仅含有少量纹理细节特征,然后在第二阶段通过生成网络PG2对源图像和上一步生成的粗糙人物图像进行融合细化,生成了带有纹理细节特征的目标图像,最后在鉴别网络D的作用下对生成图像的真假进行判断。PG2具体结构如图1所示。

1.2 改进的上下文转换模块

传统的自注意力仅在空域进行信息交互,依赖于输入自身,忽视了近邻间丰富的上下文语义信息,严重限制了二维特征图的自注意力学习能力。并且由于图像中相邻像素之间具有很强的关联性,引入自注意力训练图像时,可能会造成图像输入信息冗余,影响生成图像的质量。为缓解该问题,在生成网络G2中引入改进后的CoT模块来降低相邻像素之间的冗余,如图2所示,进一步提升输出特征的表达能力,为了获取图像中相邻像素之间的强关联性,降低其输入冗余造成的影响,对特征图进行白化操作,得到图像的静态上下文信息,对捕捉到的图像进行白化计算为:

其中,f (xi)为i像素的特征值,μf为普遍像素特征的平均数,g(xj)为j像素的特征值,μg为全局像素特征的平均数,σ为像素的协方差矩阵归一化,αj,i为像素i、j之间的成对关系。

为保证生成图像具有更多的纹理细节特征,对其增加一个像素显著性操作,并与其他分支的特征图进行跨维度特征融合,得到图像的动态上下文信息。该相似度计算为:

其中 是非刚性的注意力计算公式解耦后αj,i后余下的单项,以Wg xj计算g(xj)得到像素j的特征值,采用独立线性变换Wm替代Wg,将 近似于mj,代表新提取的像素j的显著特征信息。

将经过白化操作得到的静态上下文语义信息与上述生成的动态上下文语义信息进行相加融合,得到一个新的CoT模块。

1.3 引入上下文转换模块的生成对抗网络

1.3.1 生成网络G2

G1生成的图像中包含了目标图像的大量姿态信息,但在人物姿态方面的特征信息学习不足,因此要进一步加强对源图像的细节特征提取。与PG2方法相比,第二阶段的生成网络仍采取U-Net结构,但是将网络中3×3的卷积替换成1.2中改进的CoT Block,可以降低模型复杂度,减少计算量。为了将源图像的更多纹理细节特征保留下来,去掉U-Net的全连接层,在上下采样层之间通过跳跃连接的空间位置增加感受野。具体结构如图3所示。

1.3.2 鉴别网络D

为更好地增强生成图像的外观、纹理等细节特征,鉴别器结构采取了PGGAN设计,加快训练网络的收敛性,确保模型的稳定性。PGGAN鉴别器是将传统鉴别器和PatchGAN鉴别器相结合,一个分支用于判断生成图像是真图还是假图,另一个用来确定图像局部纹理特征的相似度,这样就可以让鉴别器在区分生成图像和真实图像的同时更加关注图像的全局和局部特征信息。

1.4 损失函数

为了比较生成图像y*和目标图像y,采用L1距离作为第一阶段G1的生成损失。L1原始的图像重建损失为:

为了降低条件图像背景不同造成的损失,在L1损失中添加了姿势掩码My,所以生成器G1阶段的损失函数为:

其中,G2(x, y1)为第二阶段生成的图像,D(x, y)为源图像和目标图像经过真假判断的结果,D(x,G2(x, y1)为源图像和生成器G2生成的图像经过真假判断的结果,Lbce为二元交叉熵损失。

其中是损失的权重,它控制生成在低频下与目标图像的相似程度。

2 实验分析

实验模型框架采用PyTorch编写,GPU为NVIDIA Quadro P4800。实验在DeepFashion和Market-1501数据集上均采用了Adam优化器,设置β1为0.5,β2为0.999,初始学习率均为2exp(-5)。

2.1 数据集

实验在DeepFashion数据集和Market-1501数据集上进行验证。DeepFashion包含52 712张分辨率为256×256的高清图片,其中含有大量带有各种姿势和外观的服装图像特征;Market-1501数据集包含32 668张分辨率为128×64的图像,其中有丰富的背景、姿势、视角和照明的变化。实验在预训练中使用人体姿态估计器来获取每张图像的人体关键点数据,并且为了更好地表征网络通用化能力,对训练集和测试集进行了身份识别不重叠。

2.2 评价指标

实验采用Inception Score(IS)和Structural Similarity(SSIM)对生成图像的性能和生成图像的质量进行评估。值得注意的是,在Market-1501数据集中,由于源图像和生成图像的背景可能存在差异,所以采用另一组mask-SSIM和mask-IS掩码评价指标来减少Market-1501数据集对背景的影響,掩码评价指标是在计算SSIM和IS之前,将姿势掩码添加到源图像和目标图像中,进一步对生成图像的质量进行评估。

2.3 消融实验

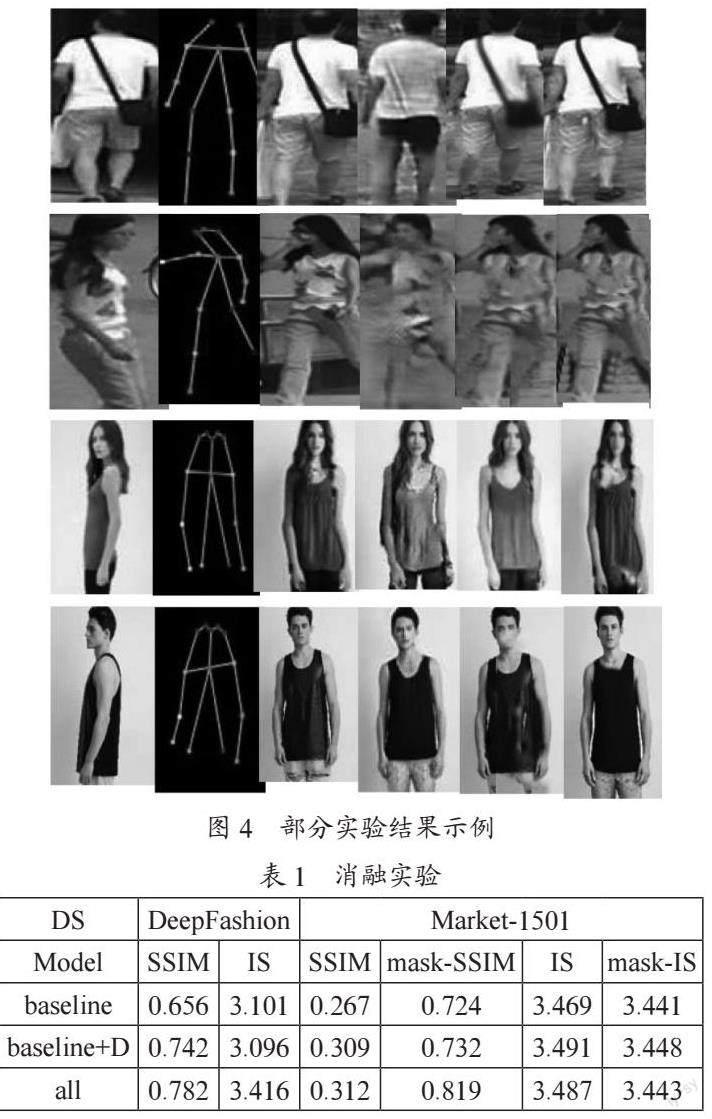

为了验证提出模型的有效性,分别使用基础模型(baseline:PG2)、改进鉴别器模型(baseline+D)、融入CoT Block的完整模型(all)在Market-1501数据集和DeepFashion数据集上进行定性和定量测试。定性测试结果如图4所示,定量测试结果如表1所示。

从图4可以看出,虽然基础模型生成了较完整的图像,但是在图像的清晰度和细节特征方面存在很多不足,而在改进判别器的模型中,生成的图像明显比基础模型的轮廓更清晰,但是在外观、衣服纹理方面仍然不完整,而引入改进CoT Block的完整模型,生成了较为真实的服装结构,在局部和全局特征都表现出较好的效果,证明了改进后模型的可行性。

从表1中可以看出,改进鉴别器D和融入CoT模块的完整模型在性能上都有了明显提升,各项评价指标均优于基础模型PG2,从另一角度证明了改进模型在图像生成方面的鲁棒性。DeepFashion数据集上图像的SSIM和IS取得了最好的结果,证明了(all)模型在图像生成方面更优越,而Market-1501数据集上图像的SSIM和mask-SSIM的值较PG2模型分别有了0.043和0.095的提升,虽然在IS和mask-IS上却没有取得最佳效果,但相比较基础模型PG2也有了0.018和0.002的提升。

3 结 论

在两阶段姿势引导人物图像合成PG2的基础上,提出了一种融合CoT Block的人物图像生成算法。在生成网络G2中引入改进后的CoT模块,通过把上下文信息挖掘与自注意力学习集成到统一架构中,使得近邻间的上下文信息以一种高效方式提升自注意力学习,最终提升输出特征的表达能力;同时,在判别网络中使用PGGAN判别器,使得圖像真假判断的准确性得到提升。在两个数据集上的实验表明,该模型较PG2方法在定性和定量结果上都有了明显的提升。

参考文献:

[1] GOODFELLOW I J,POUGET-ABADIE J,MIRZA M,et al. Generative Adversarial Nets [EB/OL].[2022-10-29].https://arxiv.org/pdf/1406.2661v1.pdf.

[2] MA L Q,JIA X,SUN Q R,et al. Pose guided person image generation [J/OL].arXiv:1705.09368 [cs.CV].[2022-10-29].https://arxiv.org/abs/1705.09368v3.

[3] ESSER P,SUTTER E. A Variational U-Net for Conditional Appearance and Shape Generation [C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake City:IEEE,2018:8857-8866.

[4] SIAROHIN A,SANGINETO E,LATHUILIERE S,et al. Deformable GANs for Pose- Based Human Image Generation [C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake City:IEEE,2018:3408-3416.

[5] ZHU Z,HUANG T T,SHI B G,et al. Progressive pose attention transfer for person image generation [C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Long Beach:IEEE,2019:2342-2351.

[6] ZHANG J S,LI K,LAI Y K,et al. PISE: Person Image Synthesis and Editing with Decoupled GAN [C]//2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Nashville:IEEE,2021:7978-7986.

[7] LI Y H,YAO T,PAN Y W,et al. Contextual Transformer Networks for Visual Recognition [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2023,45(2):1489-1500.

作者简介:姚星月(1998—),女,汉族,安徽蚌埠人,硕士在读,研究方向:图像处理。