大模型技术的网络安全治理和应对研究

2023-06-10高亚楠

高亚楠

(国家信息中心信息与网络安全部 北京 100045)

自然语言处理(NLP)[1]技术作为一项人工智能技术,旨在使计算机能够理解、分析、处理和生成自然语言.NLP技术可以用于语言生成、语音识别、问答、文本分类、情感分析、机器翻译等领域.NLP技术的发展使得计算机能够更好地与人类进行交互,提高了人机交互的效率和便利性,也极大地提高了信息处理效率、跨语言交流效率和机器的推理分析能力.

大模型技术[2]作为NLP的典型应用,为NLP的发展注入了新的动力,由于其具有海量数据供给、大型机器承载以及大规模算力支撑,可以解决小模型或者小型NLP应用无法解决和理解的问题,可以将NLP的推理能力、理解能力和分析能力以指数级速度提升.因此,基于大模型技术的ChatGPT4.0、PaLM-E和文心一言等产品一经发布,便到广泛应用,并服务于日常生活的方方面面.

然而,随着大模型技术的不断发展,其面临和引发的网络安全风险也越来越多.首先,可能对个人或组织权益造成损害,发生大量个人信息的泄露、个人画像的关联生成、算力的恶意利用等.其次,可能对社会和国家的秩序和利益造成损害,发生攻击的自动化生成和实施、漏洞的批量化发掘和恶意利用等[3].此外,大模型设施或算力还可能被反动武装等利用,作为战争和国际争端的工具和武器,对科技、和平、环境和文明的进步造成恶劣影响.

当前国内的大模型技术尚处在起步阶段,其网络安全研究工作存在空白,缺乏体系化的分析和应对措施的探讨,本文将探讨大模型技术面临的风险和网络安全治理框架,并给出应对步骤(见第3节).

1 大模型技术定义、特点和基础

1.1 定 义

大模型技术一般是指人工智能预训练大模型,即模型在大规模数据集上,采用海量算力完成预训练后,仅需少量数据微调,可直接支撑各类应用.大模型具有高准确率和泛化能力,通常在大型计算机集群上完成.

1.2 特 点

大模型技术的特点主要包括以下几个方面:

1) 涌现.当模型规模超过临界值后,展现出较小的模型不具备的较强能力,包括思维、抽象、推理、归纳、匹配等几十项能力.

2) 自适应力强.大模型的适应力随着发展不断延伸,不仅仅局限于文本,也包括图片、语音、视频等多领域、多形式.

3) 迭代速度快.由于大模型在海量的数据训练下不断地更新完善,所以其迭代和更新速度也十分迅速.

4) 自监督学习.大量数据的训练可以不断改进大模型的智能性,并进行自身的不断优化[4].

5) 准确率高.大模型的训练可以得到很高的准确率和泛化能力.

6) 数据量和计算量大.大模型需要大量的数据进行训练,通常需要数百万到数千万的数据,同时需要大量的计算资源支撑.

1.3 基 础

大模型技术的基础是人工智能领域的众多模型,主要包括语言生成模型、语言理解模型和多模态大模型.涉及自然语言处理、图像识别、语音识别等各个方面.

语言生成模型[5]的典型应用是GPT3.0模型.而GPT3.0模型基于GPT1.0模型和GPT2.0模型发展而来.其中GPT1.0主要解决特定目标的特定语言生成任务.GPT2.0在此基础上可以识别任务,然后针对性地开展模型微调,并发执行多任务.GPT3.0则是基于海量参数进行自监督式语言生成和分析.

语言理解模型[6]可以对自然语言进行理解.该模型可以通过学习大量的语言数据识别语言中的语法、语义和上下文信息,从而实现自然语言的理解.语言理解模型的典型模型是BERT.

多模态大模型[7]是包含多个模态(如文本、图像、语音等)的大型深度学习模型,旨在实现多模态数据的联合建模和整合,从而增强模型的表达能力和泛化能力.因此需要采用深度学习中的一些优化技术和算法,如分布式训练、网络压缩和剪枝等.

多模态大模型基于相关模型衍生出许多应用,最典型的便是OpenAI公司发布的ChatGPT产品,该产品是基于GPT3.5模型开发的应用程序.此外,还包括百度公司发布的大语言模型产品文心一言,该产品是基于ERNIE及PLATO系列模型研发的[8].

2 网络安全风险分析

2.1 威胁、脆弱性和风险

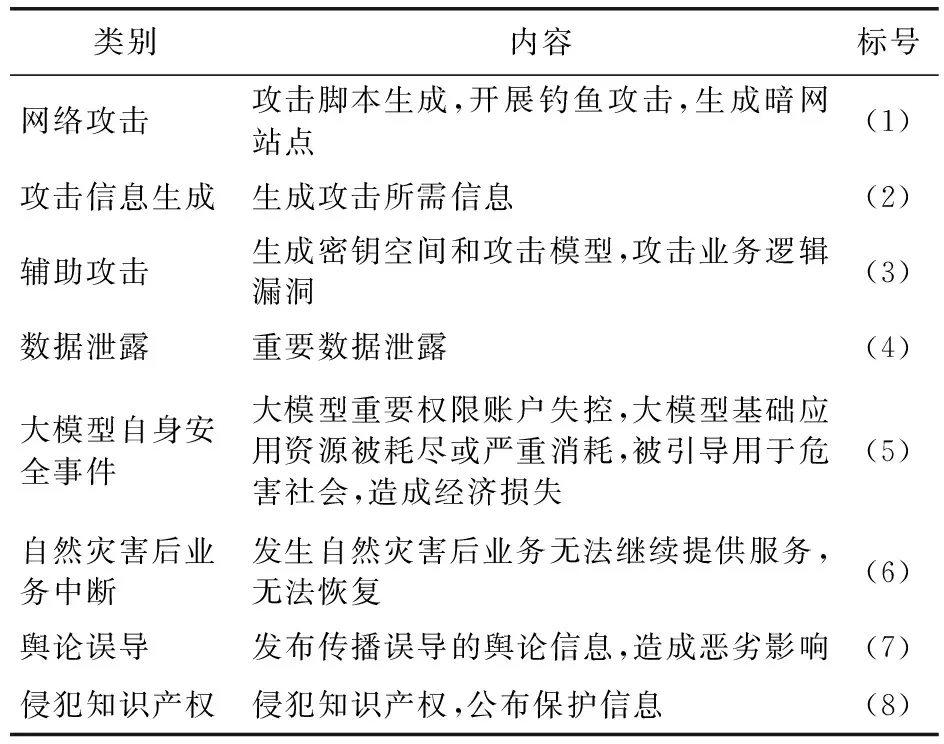

大模型技术面临的网络安全威胁[9]如表1所示:

表1 大模型技术网络安全威胁

大模型技术应用存在的网络安全脆弱性如表2所示:

大模型技术应用可能发生的安全事件如表3所示:

表3 大模型技术网络安全事件

2.2 风险分析

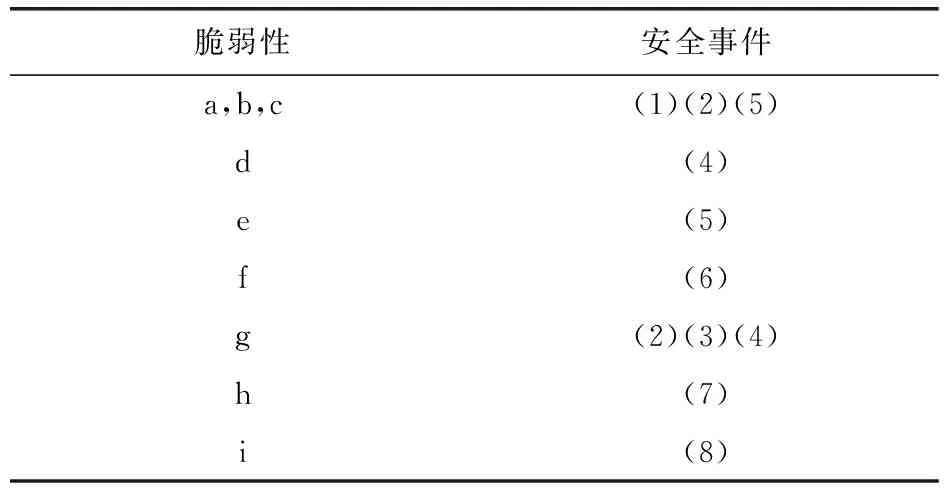

大模型技术网络安全风险分析需要对威胁利用脆弱性发生安全事件的可能性进行分析,其威胁、脆弱性对应关系如表4所示:

表4 威胁和脆弱性对应关系

脆弱性和安全事件对应关系如表5所示:

表5 脆弱性和安全事件对应关系

2.3 原因分析

出现上述安全风险的深层次原因是缺乏相关方的协同努力,未形成法律法规、政策要求和行业自律的体系化安全要求等.其次,还有安全防御相较大模型技术发展的滞后性,算法安全、数据安全、个人信息安全等方面安全防护措施部署未体系化搭建.开展大模型网络安全治理并不能杜绝以上风险,但是可以极大地降低相关安全事件发生的可能性,保障大模型网络安全.

3 网络安全治理框架

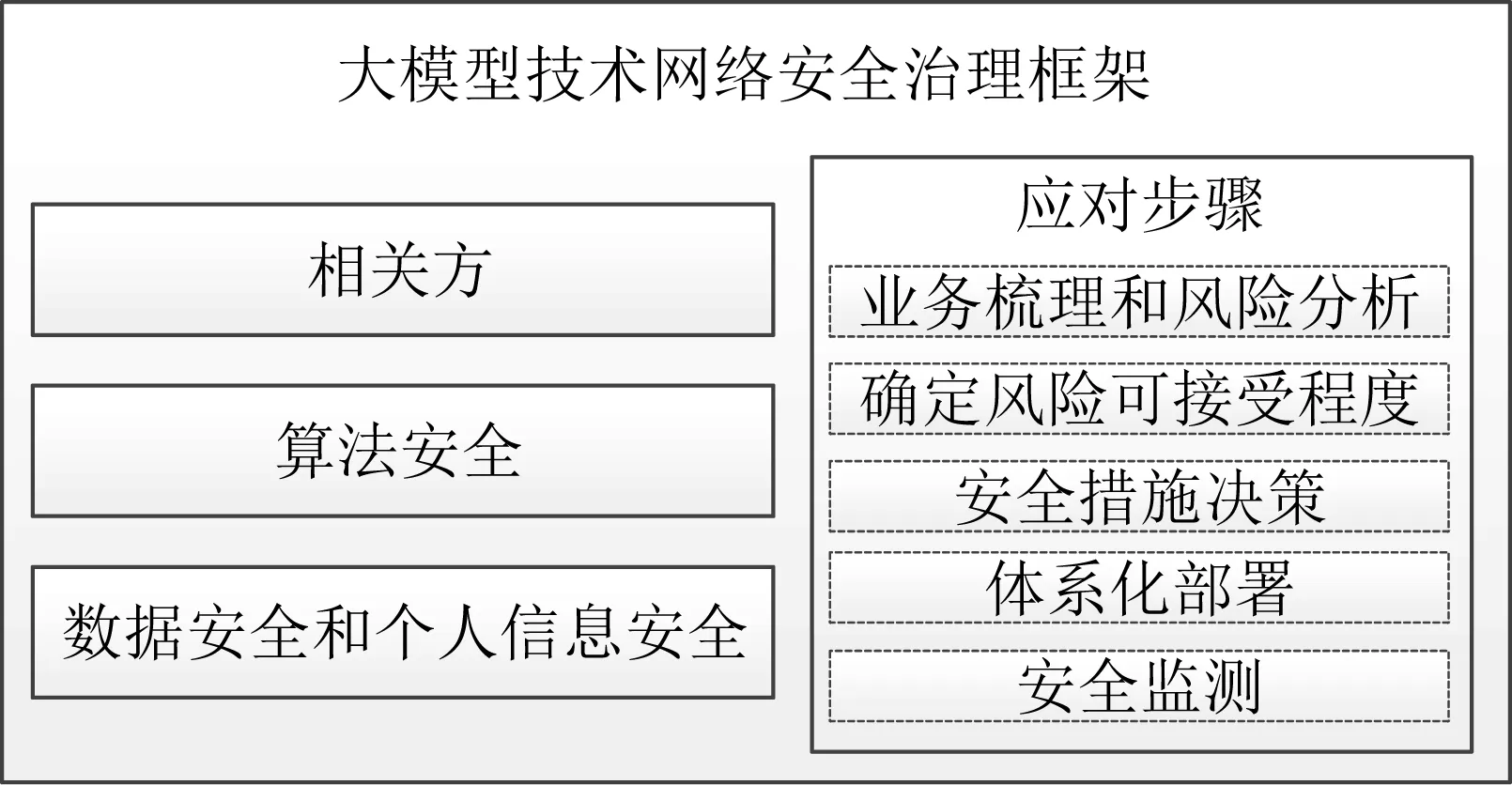

本文在对大模型技术网络安全风险进行分析的基础上,提出了一种大模型技术网络安全治理框架,如图1所示.

图1 大模型技术网络安全治理框架

大模型技术网络安全治理可以划分为3个层面,分别是确定利益相关方,开展算法安全治理,开展数据安全和个人信息安全治理.

可通过5个步骤开展大模型技术网络安全应对工作,包括:梳理业务和服务的逻辑及关系,对业务风险进行分析和识别;确定组织机构的风险可接受程度;确定所识别的风险的处置方式,开展安全措施的决策;对相关决策进行体系化部署;对开展安全防护工作后的业务风险进行监测.完成大模型技术网络安全应对的闭环管理.

3.1 相关方

大模型技术相关方主要包括外部环境、内部管理和外部人员3个方面,如图2所示:

图2 大模型技术相关方

外部环境方面,相关方包括:

1) 监管方.随着大模型技术的推广和广泛应用,将面临政府或相关组织的监督管理.

2) 制约方.随着产业的发展,将会产生一定的利益和发展制约方.

3) 执法方.和其他新技术应用一样,执法方将是不可或缺的一种角色.

4) 舆论方.推动或阻碍大模型技术应用发展的重要力量,直接影响其流量、关注度、群体等.

内部管理方面,相关方包括:

1) 运营者.大模型技术应用的运行管理机构或盈利机构,承担应用的主体责任.

2) 运维方.大模型技术应用的运行维护方承担一定的业务连续性和安全性责任,为运营者提供技术服务.

3) 投资方.大模型技术应用投资规模通常较大,且投资方对应用的发展有举足轻重的影响力.

4) 供应链.对于大模型技术应用的基础设施及计算资源,供应商链条层级较深且复杂,供应链是重要角色之一.

外部人员方面,相关方包括:

1) 使用者.大模型技术应用的服务对象,包括个人或组织.大模型技术应用为其提供语言服务、图片服务、语音服务或视频服务等.

2) 攻击者.对大模型技术应用和基础设施等进行攻击的恶意人员.或利用大模型技术生成恶意代码、攻击脚本等辅助攻击材料的,对其他业务应用有攻击行为的人员或组织.

3) 研究者.推动大模型技术、自然语言处理技术和人工智能技术发展的前瞻性研究人员.在高校、实验室或产业中不断探索新路径的探路者.

4) 促进者.推动大模型技术应用推广和使用,促进行业及领域产业化、标准化、高质量发展.

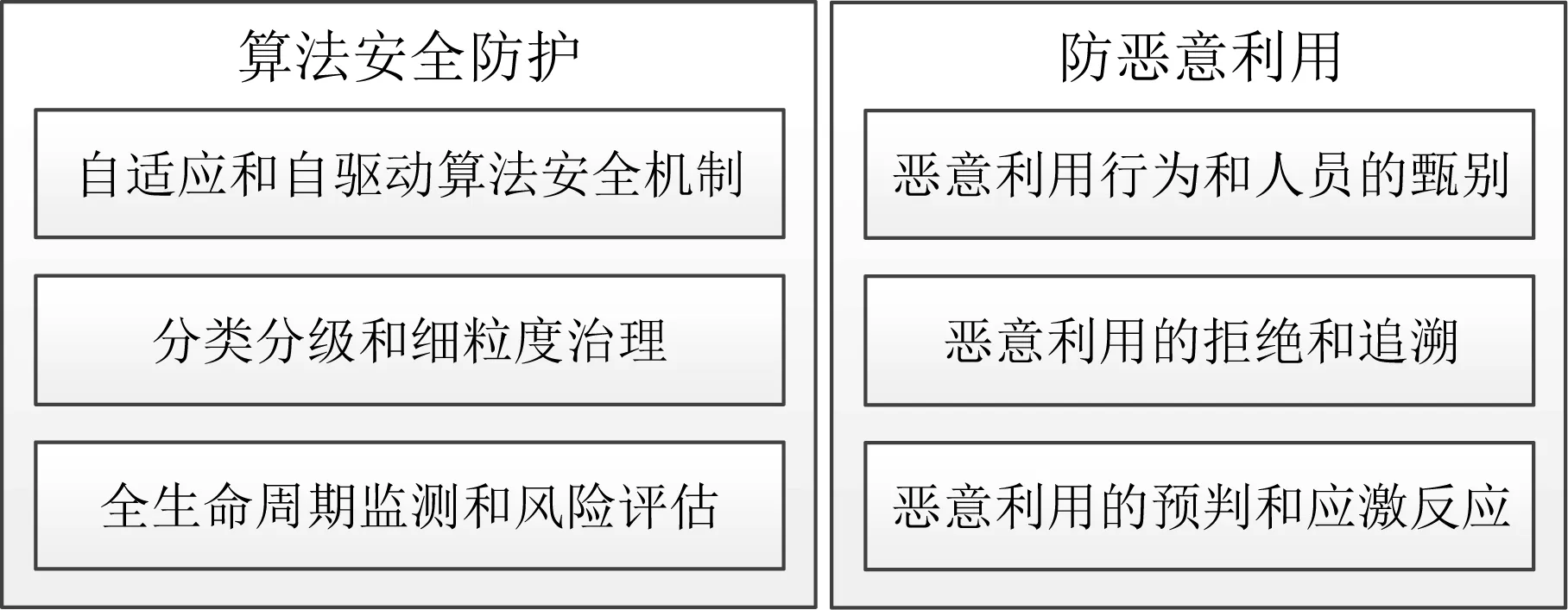

3.2 算法安全

算法安全治理主要针对2个方面:首先是大模型技术应用自身算法安全防护;其次是算法防恶意利用.如图3所示:

图3 算法安全治理

大模型技术应用自身算法安全防护包括以下3个方面内容:

1) 自适应和自驱动算法安全机制.

大模型技术作为人工智能领域的典型应用,安全自适应和自驱动是其发展的必经之路.可根据环境和内部情况,自动调整安全处理方法、顺序、参数、边界条件或约束条件,实现算法安全防范机制[10].

2) 分类分级和细粒度治理.

针对大模型技术应用使用的算法进行分类分级,并根据具体的类别和级别开展细粒度的安全防护和治理.深入分析算法的理论机制和代码实现机制,分析算法中的安全风险,并针对风险,根据类别级别开展安全治理[11].

3) 全生命周期监测和风险评估.

对算法应用的全生命周期开展安全监测,并针对算法和大模型技术应用面临的风险开展安全风险评估和风险处置等工作.重点关注算法理论定义、算法技术实现、算法应用研发、算法部署实施、算法运行和维护、技术应用废弃6个阶段的算法安全风险监测和风险评估.

大模型技术应用算法防恶意利用包括以下3个方面内容:

1) 恶意利用行为和人员的甄别.

恶意利用行为和人员的甄别是大模型技术应用运行的基础.恶意行为的甄别不仅对使用规则进行匹配,还需要对行为的连续性和关联性进行分析.恶意人员的甄别,需要对人员的既往性和预测性进行统筹,还需要根据误判可能导致的后果进行决策调整.

2) 恶意利用的拒绝和追溯.

在对恶意人员和行为进行甄别后,需要对相关人员或行为进行拒绝,对于未识别的恶意人员和行为,需要及时发现并进行追溯.

3) 恶意利用的预判和应激反应.

开展恶意利用的预判时,由于大模型技术应用会拒绝明显的恶意行为,所以部分攻击者会将恶意行为进行拆分,从而隐藏自己的攻击意图.或者仅生成恶意行为的基础动作,减少攻击行为的工作量.这就需要对相关行为进行整体性的分析判断,从而理解其意图、情绪和价值观.

在识别出恶意利用后,需要大模型技术应用激发自身的应激反应,尽可能地降低恶意利用造成的影响,但同时避免恶意利用误判后造成的服务满意度下降.

3.3 数据安全和个人信息安全

大模型技术应用数据安全和个人信息安全防护主要针对以下5个方面:

1) 安全保护对象全覆盖.开展数据安全和个人信息安全防护时,保护对象需要覆盖全面,如图4所示.安全保护对象类别包括基础设施/计算资源安全、基础系统/固件安全、组件/插件/中间件安全、大模型技术/逻辑安全;安全保护内容包括接口安全、身份安全、行为审计、入侵和病毒防范.

图4 安全防护保护对象

2) 构建数据安全和个人信息安全动态防护免疫力.大模型技术应用安全防护工作需要具有动态特点,并建立自身的免疫系统,对数据和个人信息的泄露、篡改、非授权使用进行自动拦截和处理[12].

3) 体系化层层防护.数据和个人信息安全防护工作是体系化工作,需要从内到外各个层面层层开展防护,而不仅仅是在最外层防御外部攻击行为,内部的边界防范和安全隔离也同样重要[13].

4) 数据安全责任不落空.安全责任的不落空是保障大模型技术应用数据和个人信息安全的基础,需要做到数据安全责任边界清晰、数据使用者与提供者间责任不落空、个人信息所有者与使用者间责任不落空、供应链间责任不落空、数据和个人信息处理的业务人员与安全管理人员间责任不落空等.

5) 法律政策等风险规避.风险规避主要包括法律法规、政治政策和道德伦理等.大模型技术处理数据和个人信息首先要遵循法律法规规定.由于大模型技术应用可能存在跨国家、跨地域等情况,所以需要重点关注法律的地缘性特点.此外,大模型技术应用要尊重道德伦理,并对其存有敬畏之心.由于各国政治政策会对数据和个人信息安全防护提出不同的要求,所以还应根据政治政策要求防范数据和个人信息安全风险.

3.4 大模型技术下网络安全应对步骤

大模型技术下网络安全应对可划分为以下5个步骤,并以闭环方式管理.

1) 业务梳理和风险分析.首先需要梳理使用的算法、业务应用、安全保护对象、数据类别级别、个人信息使用情况和技术应用面临的安全风险[14].

2) 确定风险可接受程度.在识别风险后,需要进行风险可接受程度的确定,从而判断哪些风险需要降低其发生的可能性,哪些风险在可接受范围内[15].

3) 安全措施决策.对于不可接受的风险需要采取安全措施进行弥补,而安全措施的采取需要投入人力、物力或财力,进行购买、开发或部署.

4) 体系化部署.安全措施的部署需要体系化开展,东拼西凑的方式极易导致出现木桶原理中的短板.

5) 安全监测.安全措施部署后需要对风险进行持续控制,对安全状况进行监测,以便在内外部环境发生变化时,开展进一步的网络安全应对.

4 结 语

大模型技术的发展带来新的网络安全挑战,但是通过大模型技术网络安全治理可以有效地保护大模型的安全.未来,随着人工智能技术的不断发展,大模型技术应用将会越来越广泛,网络安全问题也将越来越复杂.因此需要不断地研究和探索,以应对未来的网络安全挑战.