基于膨胀卷积残差网络的服装图像检索

2023-06-07何儒汉

陈 佳 张 毅 彭 涛* 何儒汉

1(武汉纺织大学数学与计算机学院 湖北 武汉 430000) 2(湖北省服装信息化工程技术研究中心 湖北 武汉 430000)

0 引 言

随着互联网技术的飞速发展,网上购衣已成一种趋势。这种服装电子商务推动了服装图像检索技术的发展。图像检索主要分为基于文本的图像检索(Text-based Image Ret2rieval,TBIR)[1]和基于内容的图像检索(Content-based Image Retrieval,CBIR)[2]。服装图像检索是图像检索的一个重要分支,已被广泛地应用于电商领域。当前,大多数电商主要采用TBIR,但TBIR高度依赖文本标注,存在加注信息低效、文本描述主观等缺点。

针对TBIR的缺点,CBIR方案得到广泛的关注。CBIR的关键是图像特征的描述和特征的索引机制。CBIR的索引方法主要依赖于提取服装图像的特征向量和计算该特征向量的空间距离。传统的特征提取方法,如SIFT[3-4]等,虽然能提取服装的纹理和颜色等浅层细节信息,但不能有效描述图像深层语义信息,且不适合光照变换的背景。不同于传统的描述符,深度学习不仅可以提取浅层特征,而且可以提取深层特征,例如图像的语义信息。服装是一种包含时尚、品位、个性的多属性复合载体,服装图像既包括领型、褶皱、花边、颜色等浅层信息,也包含类别、风格、样式、款式等深层次信息。服装也是典型的柔性物体,具有高度可变性,对光照、视角、尺度都很敏感。因此,基于深度学习的特征提取非常适合提取服装特征。

受深度学习和度量学习的启发,本文提出一种基于残差网络的服装图像特征提取模型和检索算法。在服装图像数据集DeepFashion[5]上,该方法首先利用膨胀卷积[5]较大感受野的优势以及残差网络提取深层语义特征的优势,将膨胀卷积和残差网络相融合,有效提取服装图像特征;随后,通过计算余弦距离和马氏距离之和,提出一种混合距离度量算法(MD)来计算所提取的特征之间的距离。由于余弦距离能稳定地计算向量间的空间距离,同时马氏距离的度量学习在不同类型样本中拥有很强的泛化能力,因此,本文所提出的MD利用余弦距离和马氏距离进行度量学习的互补优势来稳定、高效地对特征向量进行距离计算从而进行服装检索。综合来看,本文方法有效地利用了膨胀卷积强大的表现力、残差网络良好的特征提取能力、度量学习的距离学习能力,提高了服装特征提取的效率和检索的精度。

1 相关研究

1.1 服装图像的特征提取

在服装检索系统中,服装的特征抽取是非常重要的一环,特征提取的准确度影响到服装检索的最终结果。在传统的特征提取中,吴传彬等[6]使用方向梯度的直方图(HOG)提取了服装图像的边缘特征,但该方法对服装的形状等其他浅层信息考虑不足。Weng等[7]在颜色特征中加入位置信息形成颜色矩。然后,通过级联颜色矩得到级联颜色矩特征,该算法改善了传统颜色矩算法精度低的问题,但是运算效率低。李松等[8]通过判别条件提取局部二值的阈值,然后,计算差分幅值和领域的二值模式,从而得到图像的纹理特征。虽然该方法提升了模型在椒盐噪声下的分类性能,但是其他背景下鲁棒性还是有待提高。

在传统的特征提取发展的同时,基于深度神经网络(DNN)的特征提取方法也取得了丰硕的成果。而其中的卷积神经网络(CNN)是一种高效的深度学习框架。在众多的特征提取应用中,CNN都取得了很好的效果。Krizhersky等[9]的开创性工作之后,基于CNN的方法开始逐渐占据主导地位。王振等[10]利用可变卷积实现服装特征提取,该方法的优势在于精度高,但其泛化能力较差。王志伟等[11]通过YOLOv3模型提取服装的全局、主体和部件的特征,然后,通过稠密网络叠加这三种服装特征,有效提高了特征提取准确度,但也大幅度地增加了时间消耗。Schuster等[12]利用膨胀卷积获取较大的接收野,然后通过叠加卷积融合多层次的图像特征,该方法有效地提升了特征提取的准确率,但在网络深度上还有待提高。

针对以上的问题,本文提出基于膨胀卷积残差网络(Dilated Convolutional Residual Networks,DCRN)模型的服装图像特征提取方法,该网络融合膨胀卷积较大感受野的优势以及残差网络提取深层语义特征的优势。实验充分证明,DCRN模型提升了特征提取的准确度和鲁棒性。

1.2 特征向量的距离计算

在服装图像检索中,特征向量的距离计算同样非常重要。陈倩等[13]利用颜色直方图中的特征值表示向量的空间距离,该方法提升了图像检索的准确率,但复杂背景下图像检索的鲁棒性较低。Huang等[14]使用融合服装类型、颜色、外观等特征的稀疏编码框架的方法实现了服装检索。该方法提升了检索的准确度,但耗时过长。吴传彬等[6]采用距离相关系数的方法计算向量的空间距离,提高了服装检索的鲁棒性和泛化能力,但对于复杂的服装图像检索准确率不高。Zhou等[15]使用了一种基于颜色、纹理、形状的混合模型来度量特征向量的空间距离。Chang等[16]提出了一种新的基于图遍历的图像检索方法,通过交替使用Exploit和Explore算法,更好地捕获底层流形,并检索视觉上不同的语义强相关图像,然而该方法过于注重收敛的效率,探索可能就终止了,影响最终的检索精度。Wang等[17]通过类中心表示全局信息,然后通过约束数据点与类中心之间的距离来生成有区别的二进制代码同约束数据,最后,峰度损失(KT loss)使实值特征更接近二进制,该方法对于复杂背景图像,难以产生好的效果。由于使用传统距离度量方法,对于背景复杂的图像,该方法泛化性能较差。在样本的种类改变时,传统的距离函数,需要重新训练参数。马氏距离的泛化能力较强,但计算效率低,即在计算过程中,由于协方差矩阵可能不存在,单纯马氏距离的度量学习存在一定的局限性。

针对以上问题,本文提出混合距离度量算法(MD)。余弦距离擅长稳定的距离计算,同时马氏距离的度量学习在不同类型样本中拥有很强的泛化能力。因此,本文所提出的MD能利用余弦距离和马氏距离度量学习的互补优势来稳定、高效地对特征向量进行排序。

2 方法设计

2.1 服装图像检索框架

本文基于膨胀卷积模型和残差网络,提出一种新的服装图像检索方法,如图1所示。该方法通过并联不同膨胀率的膨胀卷积。即利用低膨胀率卷积对细节提取的优势和高膨胀率对语义理解的特点,多层次提取服装图像的特征从而进行服装图像的检索。具体步骤如下:

Step1输入一幅待检索的服装图像,对其进行预处理,包括:图像降噪、切割和增广处理。

Step2通过Stem模块提取服装细节信息,例如服装的纹理、颜色等底层信息。

Step3将这些细节信息通过膨胀卷积残差网络模块(DCRN)得到相应的深层次语义特征,例如服装部件的形状和图像中的相对位置。

Step4对上步所获得的特征经过二值检索向量模块生成高维向量。

Step5采用PCA(Principal Components Analysis)将高维向量进行降维。通过混合距离度量算法(MD)计算特征向量的空间距离,然后进行相似性排序。在triple损失函数中,通过反向传播学习MD中的度量矩阵。

图1 服装图像检索框架

2.2 Stem模块

Stem模块主要提取服装的边缘、转角、颜色等信息。如图2所示,将229×229的待检索服装图像输入Stem模块,该模块从第1层卷积Conv1到第7层池化MaxPool_2是多个小尺寸的卷积串联,从而起到了中等感受野的效果,同时前7层池化层填充padding设置为“valid”,目的是为了逐步提取细节图。第8层卷积组是并行提取多个感受野,其中第1水平层采用最大池化层MaxPool_3进行特征融合,从而更多地保留了服装图像的背景信息;第2、3、4水平层是分别提取尺寸为1、5、3的感受野的特征图,其中第3水平层中,采用1×5的非对称卷积Conv8和5×1的非对称卷积Conv9,从而减小了参数个数和计算耗时。通过第8层这种同层堆叠concat,提高了对不同像素尺寸特征的识别率,例如服装转角、领口和袖口。

图2 Stem模块结构

2.3 膨胀卷积残差网络(DCRN)模块

CNN能高效提取服装图像的浅层信息。然而,对于服装的深层语义信息,CNN只能逐步增大卷积核尺寸提高感受野。该方法的弊端在于参数量急剧增加、训练时间增长和过拟合问题。本文通过膨胀卷积寻找新的方法,增大感受野。

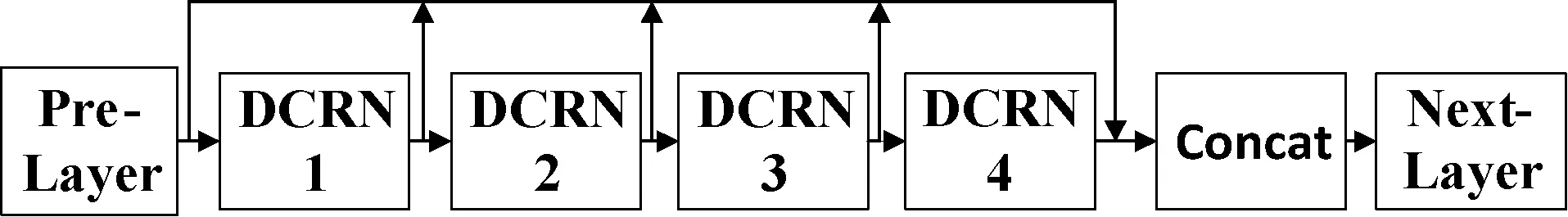

该膨胀卷积残差网络模块,由4个串联的膨胀卷积残差网络单层DCRN1、DCRN2、DCRN3、DCRN4构成,如图3所示。本文在不同层级的膨胀卷积残差网络层引入跳线结构,该结构能够让反向传播的信号到底层,从而优化了梯度消失问题,同时也增加了不同层级的特征图的复用性。为了保证跳线的可行性,膨胀卷积残差网络单层都使用“padding=same”模式。在膨胀卷积残差网络层内,通过两个1×1卷积的瓶颈结构从而提高计算效率、减少参数数目。

图3 膨胀卷积残差网络(DCRN)模块结构

本文提出的膨胀卷积残差网络抛弃了传统残差单元中的普通卷积模块,使用膨胀卷积残差网络单层进行构建,如图4所示。通过Bottleneck结构降低了输入维度,简化了计算。首先将上个模块的输出通过1×1的卷积,然后再通过4个并联的膨胀卷积Conv1、Conv3、Conv5、Conv7。4层膨胀卷积组合的优点是,在计算量不变的前提下,获得大尺寸的感受野且不易过拟合。为了保证卷积核的连续性,设计遵循了混合膨胀卷积框架的设计原则(Hybrid Dilated Convolution),膨胀率设计为r=1,2,3,4。由式(1)可知,通过运用膨胀卷积,大幅度地提高了感受野,从而提高了空间信息利用率。最后,对结果进行叠加concat,并经过1×1卷积Single-Conv8,该卷积是bottleneck结构一部分,通过1×1卷积,使得维度升高到与输入维度相同。其结果和shortcut短接的特征图相加进入下个模块。

outputSize=dilationRate×(inputSize-1)+1

(1)

式中:outputSize为输出卷积核尺寸;inputSize为输入卷积核尺寸;dilationRate为膨胀率。

图4 膨胀卷积残差网络(DCRN)单层结构

2.4 二值检索向量模块

该模块最终输出是服装图像的高维特征。模块中,全局平均池化层(Global Average Pooling,GAP)[18]的优势是更好地保留原始特征的空间信息,如图5所示。由于提取全局特征,DCRN模块对服装的风格和款式更加敏感。

图5 二值检索向量模块结构

2.5 相似度排序

本文开创性地提出混合距离度量算法(MD),使用MD方法实现特征向量的距离计算,然后使用LP范数查询感知的局部敏感哈希算法(Query-aware locality-sensitive hashing scheme for LPnorm)[19]进行相似度排序。

距离函数是定义集合中的元素距离。经典的距离函数仅仅适合单一类型的样本,而不适用混合类型样本,即根据不同任务构造不同的距离函数。针对这种问题,本文提出混合距离度量算法(MD),公式如下:

dist(x,y)=distC(x,y)+distM(x,y)

(2)

式中:distC为余弦距离公式;distM为马氏距离公式。马氏距离的度量矩阵M是监督学习要训练的对象。

(3)

式中:x、y表示2个n维向量;M是度量矩阵,通过监督学习训练度量矩阵M。

余弦距离是计算两个向量之间夹角的余弦值,用余弦值度量二者之间的距离远近,进而评价二者相似度,余弦距离公式如下:

(4)

式中:x、y表示2个n维向量。

本文模型首先对于训练集的样本信息建立优化函数,计算出能够反映样本空间特性的度量矩阵,然后利用算法进行训练。马氏距离考虑到了各种属性的相关性和尺度的无关性,弥补了余弦距离泛化能力差的缺点。余弦距离也弥补马氏距离计算过程中协方差矩阵可能无解的缺点。

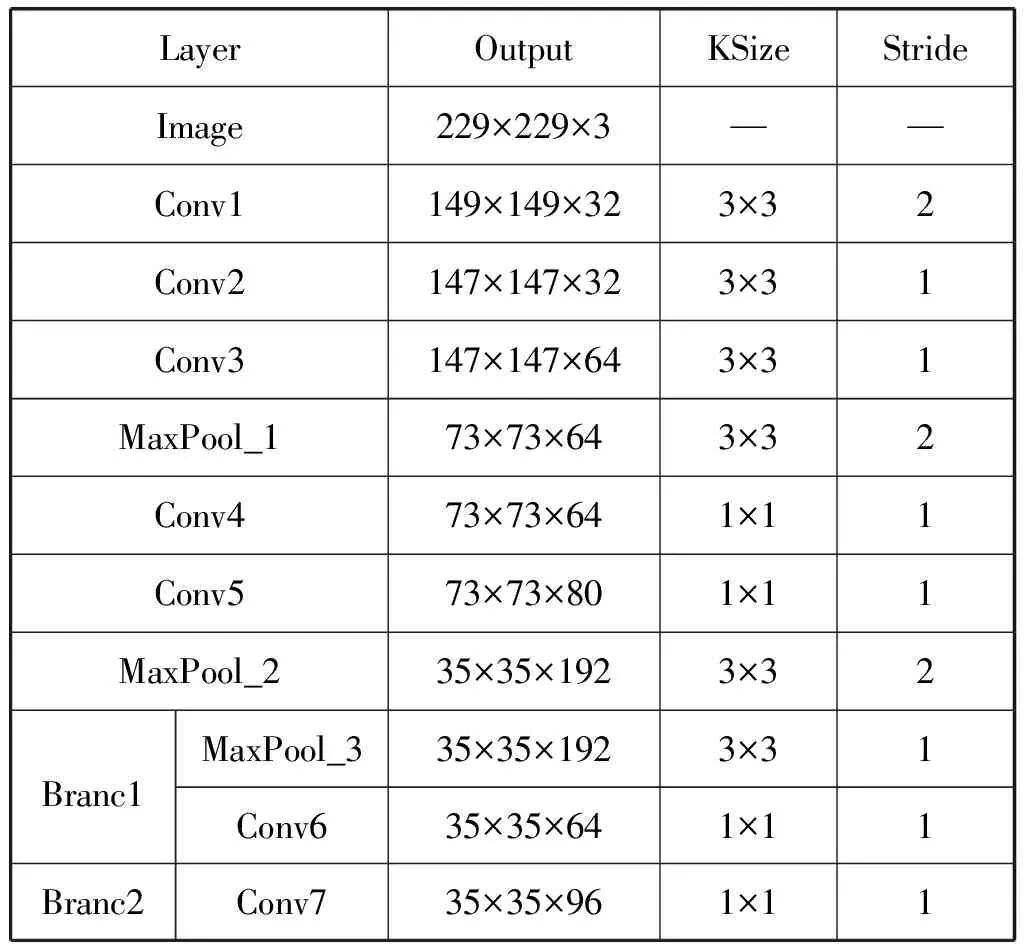

2.6 损失函数

在反向传播的训练中,triple损失函数是:

(5)

3 实 验

3.1 数据集与实验设置

为了验证本文方法的效果,本文选用了DeepFashion的跨域服装检索数据集。该数据集包含30万组不同场景和姿态下的服装图像,涵盖了21个常用服装类别,例如卫衣、连体裤、连衣裙等。其中每幅图片都附带1个类别标签、1 000个属性标签、boundingbox边框和landmarks。

实验环境设置:基于Ubuntu 16.04.6-LTS的64位操作系统,采用TensorFlow 2.0深度学习框架,CPU为3.70 GHz Intel(R) Core(TM) i7-8700k,GPU为NVIDIA GeForce GTX 1080Ti。

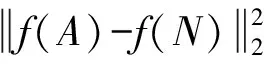

实验参数设置:图像特征提取模块的参数设置如表1至表4所示,本文选择ADAM作为优化器,以32个批量进行训练,开始学习率为0.01,每105次迭代以0.7的幂次递减。训练106次迭代后,模型收敛。

表1 Stem模块的结构参数设置

续表1

表2 DCRN模块的结构参数设置

表3 DCRN单层的结构参数设置

表4 二值向量检索模块的结构参数设置

3.2 评价指标

为了评估本文模型的效果,本文采用标准如下。

3.2.1Top-k分类精度(precision)

结合待检索服装图像q和一个相似性度量,本文为每个数据图像分配一个等级。通过分类精度(precision)函数,评估前k个图像的排名:

(6)

式中:R(i)是待检索服装图像q与第i个最近邻图像之间的相关性。检索结果R(i)∈{0,1}。在前k个最近邻图像的标签中,只要有一个标签与检索图像标签相同,则R(i)=1。反之,则R(i)=0。本文实验中,只考虑用类别标签来度量相关性。

3.2.2查全率、查准率和准确率

在图像检索系统中,性能指标要考虑所检索系统的数量和排序。我们使用查全率(recall)、查准率(precision)和准确率(accuracy),如下:

(7)

(8)

(9)

其中,式(7)到式(9)中对应参数如表5所示。

表5 混淆矩阵

在查准率(precision)的基础上,平均查准率均值(Mean Average Precision,mAP)增加了对位置信息的评价。mAP公式如下:

(10)

3.3 总体实验结果和方法对比

3.3.1实验结果

在DeepFashion数据集中,本文的膨胀卷积残差网络(DCRN)的特征提取模块+混合度量(MD)方法取得了良好的效果。图6是DCRN+MD方法的Top-5检索效果。可以看出,本文DCRN特征提取模块不仅能提取服装的细节信息,还能提取语义信息;MD模块能有效地计算特征距离并排序。

图6 本文DCRN+MD的Top-5检索效果

3.3.2基于mAP指标的横向比较

本文将该方法与WTBI、DARN、FashionNet和FushionCNN+Kmeans[20]检索算法进行实验对比。

这里用mAP指标验证DCRN+MD模型的有效性。如表6所示,在重要的mAP评价指标上,本文DCRN+MD方法较其他方法有明显优势,较WTBI、DARN、FashionNet和FushionCNN+Kmeans方法分别提高了0.746、0.607、0.246、0.153。WTBI通过Alex网络提取服装的图像特征,然后通过余弦距离进行相似性排序。DARN则是通过NIN网络(Network in Network)提取服装的图像特征,然后使用triple方法进行相似性排序。FushionCNN+Kmeans通过提取服装图片的浅层细节信息和深层语义信息,然后将二者融合后作为特征表示,最后利用K-means对特征进行聚类检索。由于DARN使用了NIN网络做特征提取,DARN检索结果的mAP高于WTBI的对应值。由于WTBI、DARN和FashionNet三者仅仅只注重纹理等细节特征,相比之下,FushionCNN+Kmeans和DCRN+MD方法额外地加入了对位置信息的描述,所以利用了位置信息的FushionCNN+Kmeans和DCRN+MD的mAP值远远高于WTBI和DARN方法的对应值。这证明WTBI、DARN和FashionNet只能提取局部和具体的服装图像特征,不能有效提取总体和抽象的特征,例如袖长属性。而加入位置信息的特征向量具有更好的区分度和良好的表达能力。

表6 Top-10幅图片mAP的比较

3.3.3基于top-k准确率指标的横向比较

top-10、top-20准确率是工程上广泛应用和重要的评价指标。如表7所示,在top-10、top-20准确率评价指标上,DCRN+MD方法较其他方法有明显优势。DCRN+MD方法的top-20准确率比第二名高出0.088,top-10准确率比第二名领先0.067。实验结果表明,在服装检索中,本文方法优于其他方法。

表7 不同方法的准确率比较

图7中,折线图展示了不同方法下的检索准确率。该实验充分说明:在不同k值下,DCRN+MD方法均保持优势。

图7 不同检索算法top-k准确率的对比

3.3.4检索效率指标的横向比较

为了验证本文算法在时间复杂度上的优越性,设计时间对比实验。在DeepFashion数据集上,本文DCRN+MD方法较其他方法有明显优势,较WTBI、DARN、FashionNet、FushionCNN+Kmeans方法分别降低了12.682、3.433、1.094、24.678 s。

表8 不同方法的检索效率比较

3.4 消融实验

3.4.1特征提取模块(DCRN)的消融实验

为了验证DCRN模块的有效性,在使用相同的带余弦值的混合距离度量算法MD模块的前提下,本文比较5种主流的特征提取模块。如图8所示,DCRN+MD模块的检索结果最优,最优准确率为0.860;而ResNet50+MD模块的检索准确率为0.276。当k=20时候,DCRN+MD模块组合具有最大的优势,其准确率比第二名多出0.08。这证明传统卷积构成的残差网络ResNet50和InceptionV3不能有效地提取服装深层次的语义信息,而DCRN+MD模块能够有效提取服装的语义特征。

图8 特征提取模块消融实验的对比

为了进一步分析DCRN模块语义提取的优势,本文从袖长、领型、颜色、衣长的角度进行对比实验。在众多的对比实验中,我们随机地截取一段实验的效果,如图9所示。实验表明:DCRN模块对于袖长属性的特征提取明显优于其他方法。在图9中,检索服装是一件Blouses Shirt款式长袖服装。待检索结果中,YOLOv3[21]和EfficientDet7[22]排第5位的白色中袖服装,在本文方法排序中上升到第2位,而ResNet50和InceptionV3未能提取该语义特征。结果表明,DCRN网络对于服装的袖长属性这一语义的特征提取性能明显地优于其他方法。进一步分析,得知在DCRN单层部分中,并行多膨胀率的膨胀卷积对服装语义特征有良好的提取效果。

图9 特征提取模块消融实验的检索效果

3.4.2混合距离度量模块(MD)的消融实验

为了验证带余弦值的混合距离度量MD模块将马氏距离和余弦距离结合的有效性。在使用相同的DCRN特征提取模块前提下,实验使用下列不同的相似度排序的模块,设计如下实验。

从图10中可以看出基于MD方法将马氏距离与余弦距离融合的策略取得了不错的效果,用MD方法提高检索效果的设想,从top-10准确率(accuracy)这个评价指标看来,基于马氏距离的度量学习方法拥有较好检索效果,而加入余弦距离的方法后,进一步增加了排序的准确率。另外,新方法MD优化了特征距离,增大了类间的距离,减小了类内距离,一定程度上减小了语义漂移,增强了模型的稳定性。

图10 混合距离度量模块top-k准确率的对比

4 结 语

本文提出基于膨胀卷积残差网络(DCRN)的服装检索方法,通过融合膨胀卷积和残差网络提取特征,并采用混合距离度量算法(MD)对图像进行检索。实验充分证明本文方法对于服装语义方面提取和排序精确度优于现有其他方法。后续优化中,可以加入Web页面让系统能在线广泛地应用。