面向开放场景的交通标志识别方法

2023-05-31曹伟朋吴宇豪李大川明仲陈贞儒叶璇

曹伟朋,吴宇豪,李大川,明仲,陈贞儒,叶璇

1)人工智能与数字经济广东省实验室(深圳),广东 深圳 518107;2)南方科技大学斯发基斯可信自主系统研究院,广东 深圳 518055

在自动驾驶系统中,及时并正确识别道路交通标志对安全性和可靠性至关重要.传统的交通标志识别方法多是基于模板匹配,需要领域专家提前手动构造特征与类别之间的模板库.该方法对专家经验的依赖度较高,且鲁棒性较差[1-2].

将机器学习技术应用于自动驾驶领域是当前的研究热点[3-5],又因该技术(尤其深度学习)具有强大的特征提取能力,在道路交通标志的检测和识别领域展现出巨大潜力[6-9].ZENG等[10]提出一种卷积神经网络(convolutional neural network,CNN)与极限学习机[11]的混合模型,并获得比传统深度CNN 更高的训练效率.HU等[12]将基于CNN的预训练模型改为多分支结构,并通过实验证明了利用浅层模型对部分简单特征进行提取,可提高系统整体的识别效率.ZHANG 等[13]采用知识蒸馏技术压缩基于深度CNN 的交通标志识别模型,在保持模型识别准确率可接受的前提下使其能够被部署于移动设备中.SONG 等[14]设计了一个二值化多尺度神经网络,并用于构建交通标志识别模型,将模型的权值限制为1和-1,有利于模型的加速和硬件实现.尽管以上改进模型均能取得一定效果,但由于深度学习相关方法属于在独立同分布假设下训练,因此模型并不具备分布外的推理能力[15].此外,一些公开数据集还存在长尾分布问题,某些类别的样本极少甚至完全缺失.综上,目前基于深度学习的道路标志识别系统在开放环境中存在稳定性差的问题.

知识与数据的有效融合是一个难点问题.上述研究都是基于深度神经网络所实现,且大多属于数据驱动的“端到端”模式,较少涉及先验知识的融入以及对模型预测结果可解释性的研究.通常,各国的道路交通标志在设计时均遵循所在国的设计标准.如何有效利用“交通标志对应属性描述”这一先验知识,将有助于提升模型的广义泛化能力.目前相关研究成果仍然较少[16-18].文献[17]基于贝叶斯网络和视觉属性提出了一个“从粗到细”的学习框架,从形状、内容和颜色3个维度定义了交通标志的语义属性,通过“一对全”分类器来区分交通标志的属性特征,再利用贝叶斯网络进行分类.文献[18]在文献[17]的基础上,增加了两个维度,从更细粒度的层面对交通标志进行描述,并通过模型输出的语义属性向量来计算模型对预测结果的置信度分数.但是,该研究缺少了更具区分度的大类语义信息,且细致的属性导致属性矩阵更为稀疏,模型整体运行效率较低.

此外,各个国家对于道路交通标志的制定标准并不完全一致.图1分别展示了中国交通标志数据库(Chinese traffic sign database,CTSDB,http://www.nlpr.ia.ac.cn/pal/trafficdata/recognition.html)和德国交通标志识别基准数据集(German traffic sign recognition benchmark,GTSRB,http://benchmark.ini.rub.cle)[19]独有的形状设计.因此,应因地制宜设计交通标志的语义属性,充分考虑如何对先验知识进行编码并融入于数据驱动模型的训练过程中,这有利于模型性能的提升.

图1 (a)CTSDB中的矩形和(b)GTSRB数据集中的菱形设计Fig.1 (a) Rectangle design in CTSDB and (b) diamond design in GTSRB datasets.

针对上述问题,本研究提出一种基于国家道路交通标志设计标准的语义数据集构建方法,并基于零样本学习(zero-shot learning,ZSL)技术[20]设计了一个具备推理和解释能力的通用交通标志识别框架,与本研究团队早期工作[21]相比更注重通用框架的设计而非对ZSL技术的改进.该框架主要创新性贡献包括以下3方面:① 所提方法具有良好的可扩展性,可有效应对实践中面临的道路交通标志动态更新及部分类别样本难以获取等挑战;② 采用ZSL机制进行设计,可解决实践中数据类别标签不全和数据采集成本高所导致的识别系统广义泛化能力差的问题,且训练得到的模型可根据类别的语义属性信息对其决策结果进行解释,有效提升了模型的可解释性;③ 在GTSRB 和CTSDB 两个基准数据集进行实验,验证了所提框架的可行性和有效性.

1 面向开放场景的道路交通标志数据集的构建方法及使用

1.1 基本定义

开放场景指真实世界的应用场景,即模型测试不局限于采集训练数据的环境;与之相对的是封闭场景,指模型的测试环境与模型的训练数据采集环境相似或完全相同[22].在封闭场景中应用机器学习模型时,通常会假定测试样本所属的类别集合包含于训练样本的类别集合.然而,在真实世界中,封闭场景测试存在很大的局限性.例如,在道路交通标志识别问题上,容易采集到的训练数据往往都是城区内的交通标志,如限速标识和人行道警示等,而对于野外场景中会出现的交通标志如注意野生动物等,因采集难度大,相关样本匮乏甚至缺失,导致用于模型训练的数据存在严重的类别不均衡或类别缺失问题.基于这样的数据集训练得到的模型也很难被应用到真实世界的开放环境中.近年来面向开放场景的机器学习研究备受关注,代表性工作包括零样本学习[20]、稳定学习[23]和迁移学习[24]等.受此启发,本研究提出一种“知识+数据”共同驱动的解决方案来应对开放场景中的道路交通标志识别问题.

1.2 语义交通标志数据集的构建方法

现有公开的道路交通数据集,如CTSDB 和GTSRB,一般只包含有交通标志的图片和对应的类别标签(图2).这类数据集可作为传统深度学习算法的训练数据,按照“端到端”模式训练得到一个预测模型.测试时只需输入一张待预测的交通标志图像,模型便能输出预测的类别.这种模式很难解释模型的决策依据,因此即便预测出错,一般也很难分析出模型误判的原因,这为相关模型的落地应用带来了很大障碍.此外,这类模型的性能严重依赖于训练数据的类别完整性和样本充足性,一旦无法提前采集到足够丰富的训练数据,模型性能在开放场景中将面临极大的不确定性.

图2 CTSDB的样本示例(类别编号:003)Fig.2 A sample in CTSDB (label No.003)

事实上,每种交通标志的设计都具有很强的规范性,若能将这些先验知识融入智能模型的训练过程中,不仅能为模型训练提供更多的辅助信息,还能有效解决训练样本中部分类别缺失的问题.

基于上述考虑,本研究提出一种构建语义交通标志数据集的新方法.具体地,根据各个交通标志数据集的采集地域不同,以及各自对应的道路交通标志设计标准,抽象出若干种能够区分各个交通标志的语义属性描述信息,然后利用独热编码(onehot encoding)技术对各个类别进行属性表征.语义交通标志数据集的构建过程如图3.

图3 语义交通标志数据集的构建过程Fig.3 Construction pipeline of semantic traffic sign dataset.

以CTSDB 为例,依据GB 5768.2—2009,从形状、颜色、图标、字符和功能5个维度来区分数据集中的交通标志,在这5个维度下又细分为多个语义子属性.据此规则,将每个道路交通标志表达为1条向量.此时,原始数据集中每条样本包含的信息从{交通标志图,类别}拓展为{交通标志图,语义属性向量,类别},从而完成语义交通标志数据集的构建.该数据集将道路交通标志的设计规范作为先验知识编码融入训练数据集中,后续将为模型训练提供更丰富的语义信息,并为模型的决策结果提供人类可理解的解释路径.

1.3 基于零样本学习的道路交通标志识别方法

在构建语义交通标志数据集后,便可以基于零样本学习技术来预测未知类别,并对模型预测结果进行解释.

与目前基于传统深度学习的“端到端”训练模式(直接训练模型构建从原始图像到最终类别的映射关系)不同,本研究先训练一个模型来学习原始图像到类别语义属性信息之间的关系映射,再根据类别语义属性向量来匹配最可能的类别,从而实现结果预测,此识别过程如图4.

图4 基于零样本学习机制的道路交通标志识别过程Fig.4 Learning pipeline for road traffic sign recognition based on zero-shot learning mechanism.

在图4 中,类别{Y1,Y2,…,Yk}既包括可见类也包括未见类.训练时,先利用骨干网络(如常用的深度学习架构ResNet[25])对原始的交通标志进行视觉特征提取,然后构建视觉特征与本研究自定义的类别语义属性特征之间的映射关系,经过迭代地调整模型的参数,最终令模型学会如何将原始的交通标志图像映射为类别属性向量.

在测试阶段,使用该模型将测试样本的图像映射作为对应的类别属性向量,再与预设的各个类别对应的属性向量进行相似度比较,便可确认其最终类别.如图5,输入一幅待识别的交通标志图像,特征抽取模块(ResNet-101)将对该图像的原始视觉特征进行抽象和提取,再经过编码器转化为对应的语义嵌入向量.模型中的分类模块将通过计算这些语义嵌入向量与预设的类别语义向量之间的相似度(如余弦相似度),实现对该样本的类别作出预测.

图5 所提方法在道路交通标志识别场景中的个案示例Fig.5 Case example of the proposed method in road traffic sign recognition scenario.

上述建模与推理过程流程如图6.基于ZSL 机制的训练模式具有3个优点:① 关于道路交通标志的设计规范作为先验知识被自然地融合进了模型的训练过程中,令模型能够从更细粒度上挖掘交通标志图像的内在含义.② 所有交通标志都有对应的语义属性信息,因此,即便训练数据集中不存在某个类别的图像样本,只要模型能够预测出该类别测试样本对应的语义属性信息,便能够正确预测出其类别标签,这为在实际场景中难以获取的交通标志的预测提供了可行的解决方案.③ 由于模型能够将测试图像映射为对应的语义属性向量,因此根据该向量各个维度的属性定义可揭示出模型决策的依据.换言之,若模型的预测结果与实际类别不符,可根据对应的语义属性信息,分析出具体哪个子属性出现误判,进而通过加大该维度的权重等方式对模型调优.

图6 基于零样本学习的道路交通标志识别方法流程Fig.6 Process of traffic sign recognition based on zero-shot learning.

2 实验仿真和结果分析

2.1 数据集

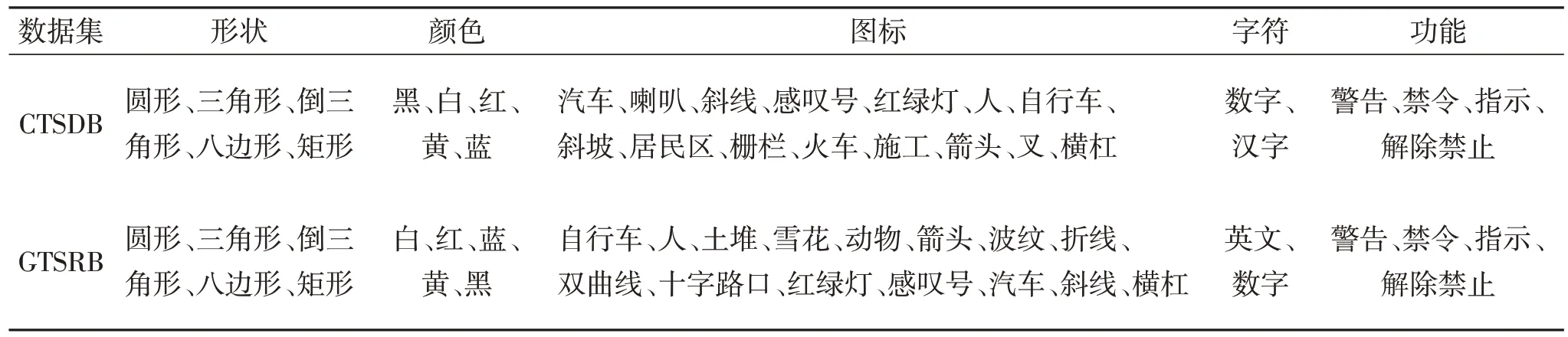

本研究在CTSDB 和GTSRB 数据集上验证所提方法的可行性和有效性.GTSRB 数据集包括43 类交通标志,共39 209 条样本,CTSDB 包括58 类交通标志,共4 170 条样本.中国和德国的道路交通标志设计标准不完全一致,为让所设计的属性特征更具有普适性,综合考虑两国的设计标准,从形状、颜色、图标、字符和功能5个维度对两数据集中的交通标志进行划分,结果如表1所示.

表1 CTSDB和GTSRB数据集的类别语义属性设计明细Table 1 The details of attributes design for CTSDB and GTSRB datasets

为得到具有语义属性信息的交通标志识别数据集,数据需做以下预处理:① 根据CTSDB 和GTSRB数据集中的命名注解等信息提取所有样本原始图像中的交通标志区域,即感兴趣区域(region of interest,ROI);② 提取ROI的过程中将图像类别标签与样本序号的对应关系生成表;③ 通过预设的“类别-属性”向量,对所有样本对应的类别进行语义属性标注;④ 将原始数据集中每条样本包含的信息从{原始道路交通标志图像,交通标志类别}拓展为{关键道路交通标志图像,语义属性向量,交通标志类别}.

2.2 实验设定和实验结果

采用ResNet-101预训练模型来提取道路交通标志图像的视觉特征,抽取后的特征为2 048 维.选用ZSL 领域经典的语义自编码(semantic autoencoder,SAE)模型[26]来建模.同时选用本研究团队前期提出的带L2 范式约束的语义自编码(SAE with L2-norm constraint,SAE-L2)模型[27]来验证所提建模框架的可行性.实验验证分两部分进行:①传统ZSL设定,即测试样本中只包含未见类;② 广义零样本学习(generalized zero-shot learning,GZSL)设定,即测试样本同时包含未见类和可见类.

实验硬件条件为Intel Core-i7-10750H 和NIVDIA RTX3060,软件包括Matlab 和Python,编程框架采用Tensorflow2.1.SAE 模型中存在超参数λ,在SAE-L2 模型中因加入了L2 正则化约束,除原有的λ外,还有正则化参数β.表2 给出了在传统ZSL和GZSL设定下SAE和SAE-L2模型在GTSRB和CTSDB数据集上的最优超参数.

表2 传统零样本学习和广义零样本学习设定下SAE和SAE-L2的超参数取值Table 2 The values of the hyperparameters for SAE and SAE-L2 under traditional ZSL setting and GZSL setting

2.2.1 传统ZSL的测试设定

按照7∶3 的比例对CTSDB 和GTSRB 数据集的可见类和未见类进行随机划分(表3),得到对应的道路交通标志识别实验结果见表4.其中,SAE 和SAE(WT)分别表示模型在推理时采用的两种计算方式:① 从测试样本的视觉特征映射到语义特征向量,然后通过比较其语义特征向量与预设的类别语义向量之间的相似度确定所属类别;② 从测试样本的语义特征重构其视觉特征,然后比较其视觉特征与预设的类别标准视觉特征之间的相似度确定所属类别.SAE-L2 和SAE-L2(WT)同理.从表4 的实验结果可以观察到:

表3 传统零样本学习设定下GTSRB和CTSDB数据集的类别划分明细Table 3 The details of traditional ZSL setting for GTSRB and CTSDB datasets

表4 SAE和SAE-L2模型在传统零样本学习设定下对GTSRB和CTSDB数据集的top-1识别结果Table 4 The experimental results of SAE and SAE-L2 with traditional ZSL setting on GTSRB and CTSDB datasets (top-1)%

1)基于所提训练框架,无论采用SAE 还是SAE-L2 方法,经过模型训练,均能以超过31%的准确率识别出未见过的交通标志,一定程度上反映出该建模框架是可行且有效的.

2)本研究方法能够一定程度上缓解传统深度学习模型完全无法准确预测未知类别的缺陷.

3)目前基于SAE和SAE-L2的模型在准确率方面仍未达到实际可用的水准,后续仍需改进相关模型或采用更先进的零样本学习技术来提高模型的预测准确率.

2.2.2 GZSL的测试设定

在传统零样本学习中,研究者关注于如何提升模型对未见类样本的识别准确率,但在真实应用场景中,待测试的样本可能属于可见类别(训练阶段模型已见过的类别),也可能属于未见类别(训练阶段模型未见过的类别).为评估所提框架在真实环境中的可行性,本研究根据GZSL 的测试设定,在测试集中加入部分可见类样本,保持训练集中仅有可见类样本,并在测试时分别记录模型在可见类和未见类测试样本上的识别准确率.同时,采用式(1)计算每组实验结果的调和平均值[28].

其中,As和Au分别为模型在可见类测试样本和未见类测试样本上的预测准确率.

根据GZSL 的测试规范,重新划分GTSRB 和CTSDB 的训练集和测试集(表5),得到对应的实验结果分别如表6.

表5 GZSL设定下GTSRB和CTSDB数据集的类别划分Table 5 The details of GZSL setting for GTSRB and CTSDB datasets

表6 SAE和SAE-L2模型在GZSL设定下对GTSRB和CTSDB数据集的top-1识别结果Table 6 The experimental results of SAE and SAE-L2 with GZSL setting on GTSRB and CTSDB datasets %

由表6可见:

1)在GZSL 的测试设定下,采用SAE-L2 模型的预测准确率比SAE模型更高,再次验证了对SAE的优化目标加入L2 正则化约束是必要且有效的,该模型能够较好地提高模型的泛化能力,反映出所提建模框架具备一定的有效性.

2)若随机预测GZSL 测试设定下的GTSRB 和CTSDB数据集,测试准确率将分别为1/43 ≈ 2.33%和1/58 ≈ 1.72%.由SAE-L2 模型的实验结果可知,采用所提建模框架训练得到的模型的预测结果,比随机结果更好,反映出所提建模框架具备一定的可行性.

3)若采用ZSL模型在此设定下进行模型预测,理论上这些模型将会把所有的未见类预测为可见类,因此,这类模型无法在开放场景中对未见类进行准确预测,但本研究框架则能在一定程度上解决此问题.

4)无论SAE还是SAE-L2模型,在两个数据集上的预测准确率都远未达到实际可用水准,未来仍需采用更先进的零样本学习技术进一步优化所提框架模型的泛化能力.

结 语

为解决道路交通标志识别场景中由于训练数据中部分类别的样本过少或缺失导致的识别系统无法有效工作的问题,本研究提出了一种新颖的基于道路交通标志设计标准的语义数据集构建方法,并利用零样本学习机制设计了一套完整的道路交通标志识别方案.利用交通标志的语义属性信息能够为模型训练提供更精准的方向指引,而且有助于增强对模型决策的可解释性.例如,若模型对某个道路交通标志的预测结果出错,可通过分析模型输出的语义属性向量来判断哪些语义子属性导致的误判,比如形状和颜色的逻辑冲突等,进而对模型进行靶向修复,比如增强相关子属性的权重等.本研究的主要贡献是为开放场景道路交通标志识别提出了一套“数据+知识”共同驱动的普适性解决方案,并非强调比较不同算法之间的优劣.因此,各算法对应实验结果之间的统计差异比较,并不适用于本研究.

采用SAE 和SAE-L2 对所提框架进行可行性实验验证,结果表明,该框架具备一定的可行性,相比随机预测和传统深度学习方法,利用SAE 和SAE-L2 并基于所提框架训练得到的模型能够取得更高的预测准确率,模型具备一定的有效性.本研究重点在于提出基于零样本学习机制的道路交通标志识别框架,并证明其有效性.未来将在此基础上,设计更先进的零样本学习算法进行建模,有望进一步提升该系统的可用性.

参考文献 / References:

[1]倪钰婷,梁宇峰,郝博闻,等.交通标志识别研究综述[J].软件工程,2016,19(7):1-5.NI Yuting, LIANG Yufeng, HAO Bowen, et al.A review of the research on trafifc sign recognition [J].Software Engineering, 2016, 19(7): 1-5.(in Chinese)

[2]伍晓晖,田启川.交通标志识别方法综述[J].计算机工程与应用,2020,56(10):20-26.WU Xiaohui, TIAN Qichuan.Survey of traffic sign recognition [J].Computer Engineering and Applications, 2020,56: 20-26.(in Chinese)

[3]KUUTTI S, BOWDEN R, JIN Yaochu, et al.A survey of deep learning applications to autonomous vehicle control[J].IEEE Transactions on Intelligent Transportation Systems, 2021, 22(2): 712-733.

[4]DU Xinxin, ANG M H, RUS D.Car detection for autonomous vehicle: LIDAR and vision fusion approach through deep learning framework [C]// IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS).Piscataway, USA: IEEE, 2017: 749-754.

[5]MOZAFFARI S, AL-JARRAH O Y, DIANATI M, et al.Deep learning-based vehicle behavior prediction for autonomous driving applications: a review [J].IEEE Transactions on Intelligent Transportation Systems, 2022,23(1): 33-47.

[6]MIN Weidong, LIU Ruikang, HE Daojing, et al.Traffic sign recognition based on semantic scene understanding and structural traffic sign location [J].IEEE Transactions on Intelligent Transportation Systems, 2022, 23(9): 15794-15807.

[7]XIE Kan, ZHANG Zhe, LI Bo, et al.Efficient federated learning with spike neural networks for traffic sign recognition [J].IEEE Transactions on Vehicular Technology,2022, 71(9): 9980-9992.

[8]NATARAJAN S, ANNAMRAJU A K, BARADKAR C S.Traffic sign recognition using weighted multiconvolutional neural network [J].IET Intelligent Transport Systems, 2018, 12(10): 1396-1405.

[9]汪贵平,盛广峰,黄鹤,等.基于改进LeNet-5 网络的交通标志识别方法[J].科学技术与工程,2018,18(34):78-84.WANG Guiping, SHENG Guangfeng, HUANG He, et al.Traffic sign recognition method based on improved LeNet-5 network [J].Science Technology and Engineering, 2018,18(34): 78-84.(in Chinese)

[10]ZENG Yujun, XU Xin, SHEN Dayong, et al.Traffic sign recognition using kernel extreme learning machines with deep perceptual features [J].IEEE Transactions on Intelligent Transportation Systems, 2017, 18(6): 1647-1653.

[11]CAO Weipeng, WANG Xizhao, MING Zhong, et al.A review on neural networks with random weights [J].Neurocomputing, 2018, 275: 278-287.

[12]HU Wenzheng, ZHUO Qing, ZHANG Changshui, et al.Fast branch convolutional neural network for traffic sign recognition [J].IEEE Intelligent Transportation Systems Magazine, 2017, 9(3): 114-126.

[13]ZHANG Jianming, WANG Wei, LU Chaoquan, et al.Lightweight deep network for traffic sign classification [J].Annals of Telecommunications, 2020, 75(7): 369-379.

[14]SONG Xin, YOU Haitao, ZHOU Shengqun, et al.Traffic sign recognition with binarized multi-scale neural networks [C]// The 35th Youth Academic Annual Conference of Chinese Association of Automation (YAC).Piscataway,USA: IEEE, 2020: 116-121.

[15]冯耀功,于剑,桑基韬,等.基于知识的零样本视觉识别综述[J].软件学报,2021,32(2):370-405.FENG Yaogong, YU Jian, SANG Jitao, et al.Survey on knowledge-based zero-shot visual recognition [J].Journal of Software, 2021, 32(2): 370-405.(in Chinese)

[16]JETLEY S, ROMERA-PAREDES B, JAYASUMANA S, et al.Prototypical priors: from improving classification to zero-shot learning [C]// Proceedings of the British Machine Vision Conference (BMVC).Durham, UK: BMVA Press,2015: 120.1-120.12.

[17]AGHDAM H H, HERAVI E J, PUIG D.A unified framework for coarse-to-fine recognition of traffic signs using Bayesian network and visual attributes [C]// Proceedings of the 10th International Conference on Computer Vision Theory and Applications-Volume 3: VISAPP,(VISIGRAPP 2015).Setúbal, Portugal: SciTePress, 2015:87-96.

[18]BRUNNER T, DIEHL F, LE M T, et al.Leveraging semantic embeddings for safety-critical applications [C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops (CVPRW).Piscataway, USA:IEEE, 2019: 1389-1394.

[19]HOUBEN S, STALLKAMP J, SALMEN J, et al.Detection of traffic signs in real-world images: the German traffic sign detection benchmark [C]// International Joint Conference on Neural Networks (IJCNN).Piscataway, USA:IEEE, 2013: 1-8.

[20]CAO Weipeng, ZHOU Cong, WU Yuhao, et al.Research progress of zero-shot learning beyond computer vision [C]//Algorithms and Architectures for Parallel Processing.Cham: Springer International Publishing, 2020: 538-551.

[21]CAO Weipeng, WU Yuhao, CHAKRABORTY C, et al.Sustainable and transferable traffic sign recognition for intelligent transportation systems [J/OL].IEEE Transactions on Intelligent Transportation Systems.(2022-10-27)2023-01-04.https://doi.org/10.1109/TITS.2022.3215572.

[22]GENG Chuanxing, HUANG Shengjun, CHEN Songcan.Recent advances in open set recognition: a survey [J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 2021, 43(10): 3614-3631.

[23]CUI Peng, ATHEY S.Stable learning establishes some common ground between causal inference and machine learning [J].Nature Machine Intelligence, 2022, 4(2):110-115.

[24]ZHAO Ying, LI Shuang, ZHANG Rui, et al.Semantic correlation transfer for heterogeneous domain adaptation[J/OL].IEEE Transactions on Neural Networks and Learning Systems.(2022-08-25) 2023-01-04.https://doi.org/10.1109/TNNLS.2022.3199619.

[25]HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al.Deep residual learning for image recognition [C]// IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Piscataway, USA: IEEE, 2016: 770-778.

[26]KODIROV E, XIANG Tao, GONG Shaogang.Semantic autoencoder for zero-shot learning [C]// IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway, USA: IEEE, 2017: 4447-4456.

[27]WU Yuhao, CAO Weipeng, LIU Ye, et al.Semantic autoencoder with L2-norm constraint for zero-shot learning[C]// The 13th International Conference on Machine Learning and Computing.New York, USA: Association for Computing Machinery, 2021: 101-105.

[28]XIAN Yongqin, SCHIELE B, AKATA Z.Zero-shot learning: the good, the bad and the ugly [C]// IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Piscataway, USA: IEEE, 2017: 3077-3086.