面向智能博弈的决策Transformer方法综述

2023-04-24罗俊仁张万鹏苏炯铭

罗俊仁 张万鹏 苏炯铭 王 尧 陈 璟

1.国防科技大学智能科学学院 湖南 长沙 410073

博弈一词的英文单词为Game,英文直译为游戏,早年国内译为对策、赛局. 博弈问题的研究本质是通过将除己方外其他参与方的行为策略考虑在内制定己方对策过程. 未来军事对抗具有环境高复杂、信息不完整、博弈强对抗、响应高实时、自主无人化等突出特征,无人集群自主协同、作战仿真推演和智能任务规划等挑战课题都亟需智能博弈相关技术的支撑.协作与竞争是双生体,广泛存在于认知决策博弈领域. 博弈智能是认知智能的高阶表现形式. 近年来,借助各类计算机博弈平台,面向智能博弈(intelligent gaming)的相关人工智能技术得到迅猛发展. 智能博弈本质是指协作、竞争或对抗场景下,利用博弈理论分析问题、智能方法求解应对策略的过程. 人机对抗(human computer gaming)作为图灵测试的典型范式,是测试人工智能(artificial intelligence,AI)技术程序的主要手段和基准[1],是智能博弈的重要表现形式. 智能博弈作为智能指挥与控制领域研究决策智能的基准挑战,是当前研究决策大模型的试验场和果蝇. 当前围绕智能博弈问题的求解,已然传统的“知识与搜索”、“博弈学习”范式过渡到“模型与适应”范式,其中,包括面向小模型的“预训练+微调”和面向大模型的“基石模型+情境学习”.

围绕人类认知能力的认知建模技术已然成为AI领域的前沿课题. 近年来,随着AI 技术的发展和GPU 性能的逐年翻倍,AI 大模型/基石模型[2]在视觉与语言智能计算、智能博弈领域取得了快速发展. 基于大模型的AI 生成内容(AI-generated context,AIGC)技术未来将成为一种基础设施,AI 生成行动(AIgenerated action,AIGA)相关技术(行为生成、模型生成)为决策问题求解提供了可行方案. 伴随着2022年年末ChatGPT 的出现,各类基石的出现已然引发了AI 各赛道里的“军备竞赛”,但一般的语言能力无法完全匹配决策需要的推理能力,如何构建“决策基石模型”已然成为当前AI 与智能决策领域的前沿问题.

Transformer 作为一种利用注意力机制来完成序列到序列变换的表示学习模型,利用此类模型构建智能博弈问题的决策策略求解方法是热门研究方向.基于Transformer 的表示学习方法[3]和序列建模方法[4]及多模态融合学习方法[5]引发了各大领域(自然语言处理、计算机视觉、语音与视频、智能博弈决策)的持续关注. LI 等[6]从表示学习、模型学习、序贯决策和通才智能体4 个角度对基于Transformer 的强化学习方法进行了综述分析. HU 等[7]从架构增强(特征表示、环境表示),轨迹优化(条件行为克隆、经典强化学习、预训练、泛化性)和典型应用(机器人操控、文字游戏、导航、自动驾驶)共3 大类对基于Transformer 的强化学习方法进行了总结对比分析. 当前围绕决策Transformer 的方法可分为3 大类:直接利用大语言模型类(百科、视频、互联网知识)、基于框架变换的表示及模型学习类(表示学习、环境学习)、基于决策问题重构的条件生成类(序列建模、行为生成、世界模型生成).

如何为规划与决策领域的智能博弈问题设计新型求解框架仍充满挑战. 本文围绕智能博弈问题展开,梳理各类问题的博弈模型,创新性构建智能博弈认知模型,探索性给出智能博弈问题的求解范式;重点梳理面向智能博弈问题求解的决策Transformer 方法.

1 智能博弈与规划决策

1.1 智能博弈简述

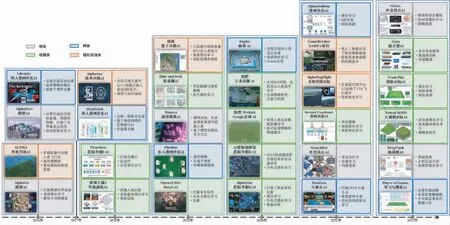

伴随着AI 近70年的发展,计算机博弈(computer games)作为博弈论与人工智能的桥梁,逐渐在人机对抗比赛中被一大批高水平AI 克服. 近年来,伴随着AI 的第三次浪潮,智能博弈技术取得了飞速发展,博弈对抗场景从棋类、牌类、视频类陆续过渡到仿真推演类,博弈对抗技术从单一学习方法、分布式学习方法向大规模、通用学习方法演进. 从2016年至2022年,AlphaX 系列智能体(AlphaGo[8]、AlphaZero[9]、AlphaHoldem[10]、Alphastar[11])的相关研究为各类型博弈问题的求解提供了新基准,智能博弈技术研究从计算机博弈扩展至军事任务规划与决策领域.智能博弈领域的一些标志性突破如图1 所示.

图1 智能博弈标志性突破Fig.1 Remarkable breakthroughs of intelligent gaming

1.2 军事智能博弈

从早前的空战Alpha AI[12]至AlphaDogfight[13],美军在军事智能博弈领域展开了相当多的项目. 2016年,美国辛辛那提大学与空军研究实验室合作开发了一个叫“Alpha AI”的机器飞行员,控制虚拟环境中的无人作战飞机完成飞行和打击等空战任务. 2018年,美空军下一代自主无人战斗机智能平台Skyborg,计划2023年末之前实现自主无人战斗机的早期自主决策和作战能力;2019年5月宣布启动“空战演进”(air combat evolution,ACE)项目,ACE 项目旨在以人机协同“Dogfight”为挑战问题,进而开发可信、可扩展、人类水平、AI 驱动的空战自主能力.

此外,2018年美国国防部高级研究计划局(Defense Advanced Research Projects Agency,DARPA)发起“面向复杂军事决策的非完美信息博弈序贯交互”项目,旨在自动化地利用呈指数增长的数据信息,将复杂系统的建模与推理相结合,从而辅助国防部快速认识、理解甚至是预测复杂国际和军事环境中的重要事件;2020年,DARPA 通过其官网宣布为“打破游戏规则的人工智能探索”(Gamebreaker)项目,开发人工智能并将其应用于现有的即时策略海空战兵棋《指挥:现代作战》之中,以打破复杂的模型所造成的不平衡,旨在推动人工智能嵌入兵棋系统融合. 2021年9月,由美国家安全创新网络办公室(National Security Innovation Network,NSIN)和美空军研究实验室(Air Force Research Laboratory,AFRL)合作举办的人工智能指挥决策公开挑战赛落下帷幕,参赛选手们基于兵棋开发AI 方法,实现各类指挥决策作战筹划快速生成.

1.3 智能规划与决策

近5年来,美军在智能指挥决策技术领域进行了深入探索,个别项目得到实际应用,如表1 所示.2018年,美陆军指挥控制软件集成了行动方案(course of action,COA)分析决策支持工具,即聚焦作战的仿真(OpSim)[14];2019年,美空军为多源异构无人自主平台行动规划设计了“情景式”体系结构,自主系统会根据可用资产进行推理,生成可推荐的“情景”计划[15];自2020年起,美陆军在会聚工程(Convergence)演习中,利用智能辅助决策系统——火力风暴(FireStorm)推荐战术端的武器目标分配方案[16];2021年,兰德公司围绕空中自主攻击计划生成进行研究,美空军发布了“今夜就战”(fight tonight)项目[17],尝试利用仿真环境与人类指导生成大量备选行动计划,这是一项重大变革,旨在利用人工智能技术构建、演练和评估空中作战计划. 2022年,美空军开展研发“面向计划、战术、实验和弹性的战略混合引擎”权杖项目[18],旨在依托计算机生成作战行动层面的作战行动方案,利用高保真可信模拟器对筛选出的最佳方案进行验证,并最终交由人工审查;第一阶段注重开发能够发现相关和可解释的行动方案的非脚本且具目标导向的智能体,实现大规模军事场景的快速探索.

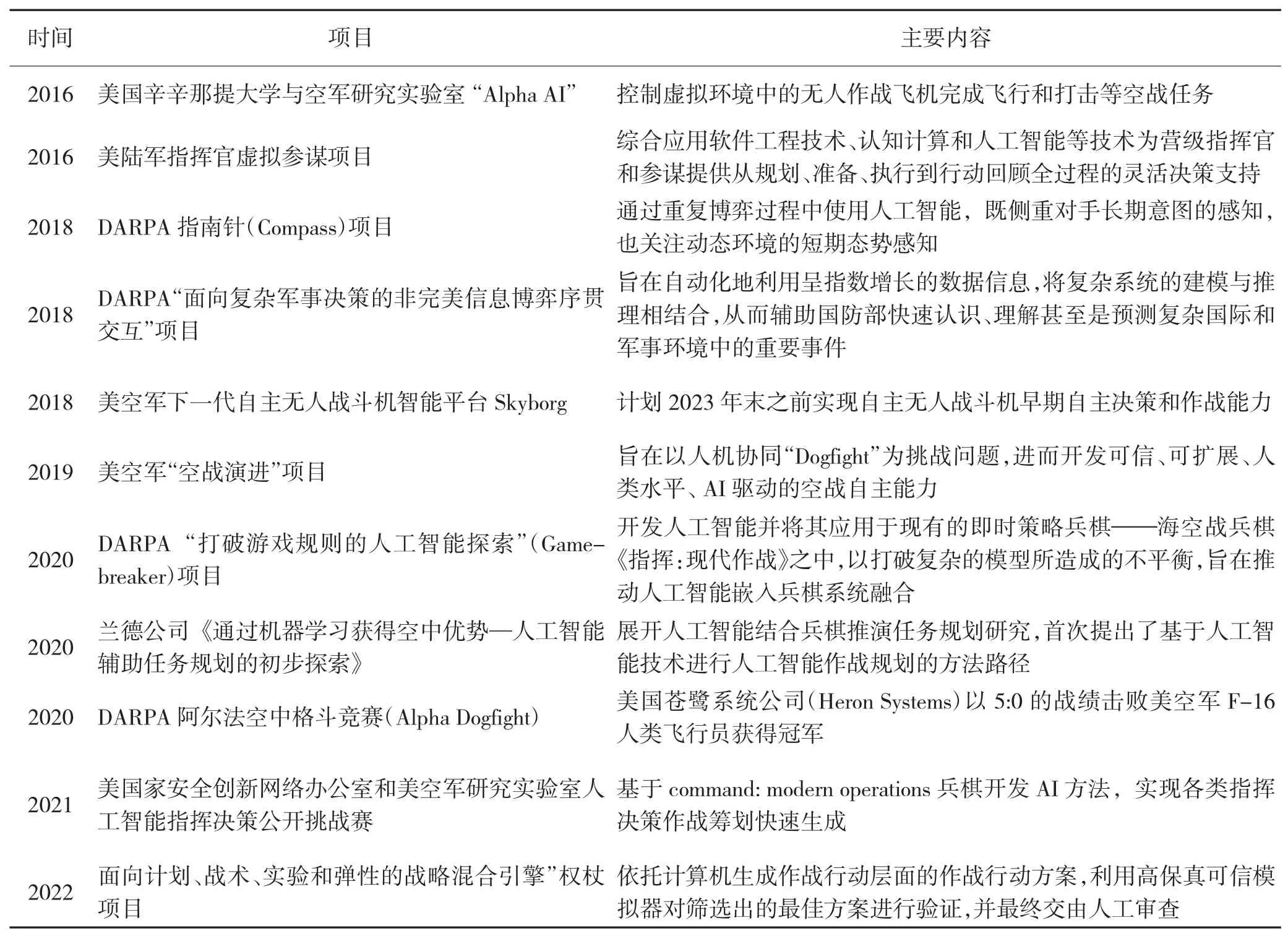

表1 军事智能博弈相关项目情况Table 1 Related projects of military intelligent gaming

2 智能博弈问题求解

2.1 智能博弈问题模型

智能博弈问题通常可以采用多智能体问题模型来建模. 根据智能体之间的关系,智能博弈问题可分为:协作式团队博弈、竞争式零和博弈和混合式一般和博弈. 其中,协作式博弈追求最大化团队收益、通过协同合作来实现目标;竞争式零和博弈追求最大化自身收益、通常采用纳什均衡策略;混合式一般和博弈既有合作又有竞争,即组内协作、组间对抗. 相关典型博弈场景如图2 所示.

图2 智能博弈问题分类Fig.2 Classification of intelligent gaming problems

2.1.1 协作式团队博弈

协作式团队博弈中,智能体共享博弈目标,但由于自私性的存在,各智能体可以从不同的利益角度出发选择行动,故协作式团队博弈根据目标收益划分方法不同,可区分为三大类[16].

1)完全协作式博弈:完全协作式博弈可以用多智能体马尔可夫决策过程建模,假设智能体是同质的,收益是可交换的. 通常假设目标是共享一致的,即.

2)团队平均收益博弈:团队平均收益博弈可以用网联(networked)多智能体马尔可夫决策过程建模,假设智能体有不同的收益函数,但共享目标,即.

3)随机势博弈:随机势博弈中假设智能体有不同的收益函数,但所有智能体的共同利益可以采用一个势函数进行描述. 这种类型的博弈通常有纯策略纳什均衡[17].

2.1.2 竞争式零和博弈

竞争式零和博弈中,智能体之间利益有冲突,行动表现出对抗性,可区分为3 大类.

1)两人零和与常和博弈:两人零和(zero-sum)博弈主要是指两个智能体的收益之和为零,即. 两人常和(constant-sum)博弈主要是指两个智能体的收益之和为固定的常数值,即,其中,c 为常数.

2)两队零和博弈:两支队伍目标相反,每支队伍内部目标一致共享,但两支队收益之和为零,

3)调和(哈尔密顿)博弈:正如“石头—剪刀—布”博弈,调和博弈,也称哈密尔顿博弈,可以看作是一类广义的零和博弈.

2.1.3 混合式一般和博弈

混合式一般和博弈是一类混合型场景,其中,既可能包含合作也可能包含竞争,每个智能体都是自利的,其收益可能与其他智能体有冲突,智能体之间在目标上没有约束关系,这类模型的求解通常比较困难,当前大多数多智能体学习方法无法提供收敛性保证[18]. 当前围绕着这类博弈模型的研究主要聚焦于纳什均衡、相关均衡和斯坦伯格均衡的求解和基于元博弈的策略学习.

2.2 智能博弈认知建模

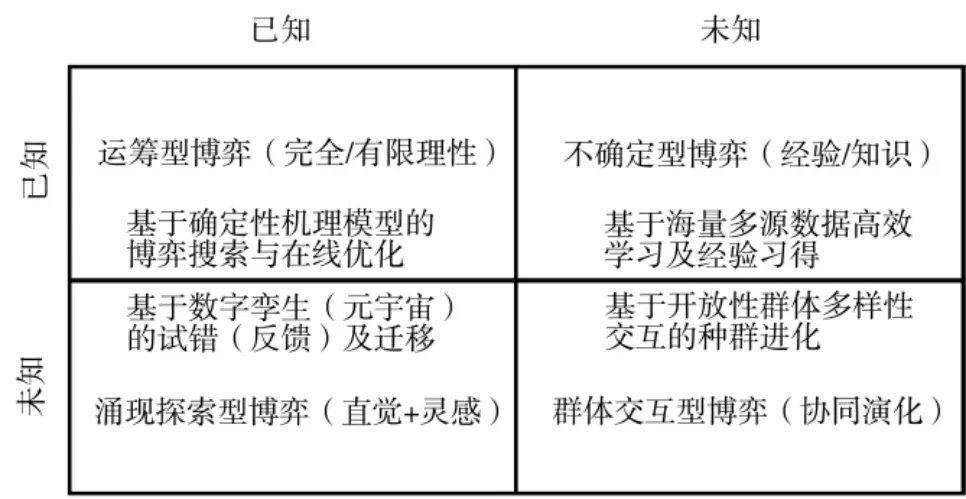

从认知的角度分析,当前围绕智能博弈问题可建模成4 类,如图3 所示.

图3 智能博弈认知建模模型Fig.3 Cognitive modeling models for intelligent gaming

1)基于完全/有限理性考虑的运筹型博弈模型:主要采用基于确定性机理模型的博弈搜索与在线优化方式提供智能.

2)面向经验匮乏的不确定性博弈模型:主要采用基于海量多源数据的高效学习与未知经验/知识习得.

3)挑战直觉和灵感的探索型博弈模型:主要采用基于平行数字孪生环境或元宇宙的试错(反馈)及迁移获得智能.

4)考量种群协同演化的群体交互型博弈模型:主要采用基于开放性群体多样性交互的种群演化.

2.3 智能博弈求解方案

2.3.1 智能博弈问题可信任解

围绕博弈问题的求解方法主要区分为离线与在线(训练与测试)两个阶段. 对于多方博弈问题,由于环境(对手)的非平稳性、多解选择等问题使得博弈问题求解表现出“离线耦合、在线解耦”的状态. 离线训练主要采用仿真环境模拟与对手的交互,获得离线采样数据,利用大规模计算方式得到蓝图策略或利用分布式强化学习方法得到预训练模型;在线博弈过程中,由于仅能控制己方策略,应对策略的生成处于解耦合状态,需要采用适应对手的反制策略.

从解概念的角度看,博弈问题的求解本质是设计高效的样本利用方法对问题的解空间进行探索,获得问题的可信任解,其中包括应对约束的安全解、应对不确定性扰动的鲁棒解、应对分布漂移考量泛化性的多样解,应对突发及意外情景的适变解,以及可解释解、公平解等.

2.3.2 智能博弈策略训练平台

围绕如何将方法求解与分布式计算融合是学术界与工业界的共同聚焦点. 受Alphastar 启发,腾讯团队设计了基于启发式联赛训练的竞争式自对弈Tleague[24],上海交通大学团队设计了基于策略评估的MALib[25],这两类开源的分布式学习平台为求解大规模博弈问题提供了可参考的通用解决方案. 随着智能体个数的增加,多样化的智能体种群表现出协同演化的性质. 从种群视角看,分布式学习为种群的智能演进提供了超实时支持.

2.3.3 智能博弈问题求解范式

1)基于知识与搜索

从绝对理性假设出发,充分利用专家知识、打分,设计启发式,外部知识等方式引导博弈树搜索,从早期的极小-极大搜索、蒙特卡洛树搜索(Monte carlo tree search,MCTS)、信息集MCTS、分层任务网络MCTS 等.

2)基于博弈理论学习

从交互的角度分析博弈多方策略之间的合作与竞争关系,通过构建考虑对手的策略迭代式学习、策略优化式学习等方法,利用模拟或在线交互场景样本数据优化策略.

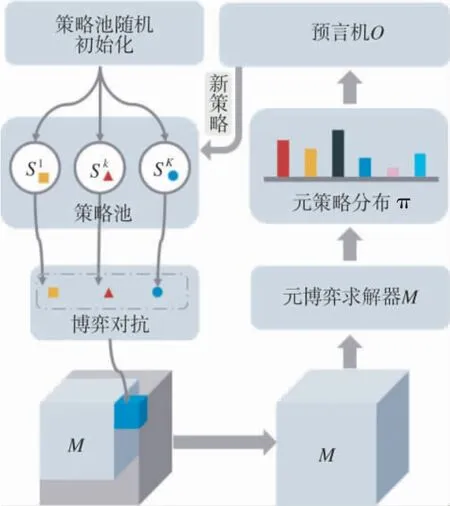

围绕博弈问题的基准学习方法主要分为三大类:基于反事实后悔值最小化(counterfactual regret minimization,CFR)类方法[19],基于虚拟自对弈(fictitious self play,FSP)类方法[20],基于元博弈的策略空间响应预言机(policy space response oracle,PSRO)类方法[21].作为一类利用仿真器模拟的博弈策略学习方法,PSRO 类方法将经验博弈论分析(empirical game theoretic analysis,EGTA)方法[22]扩展成迭代式自动化方法,已然成为当前的研究基准方法范式,其本质上是一类基于种群的增量迭代式训练方法,其求解流程如图4 所示[23]. 此外,基于优先级的虚拟自对弈方法是当前工程实践过程中经常被采用的一种启发式范式[8].

图4 策略空间响应预言机方法Fig.4 Policy space response oracle methods

3)基于模型与适变

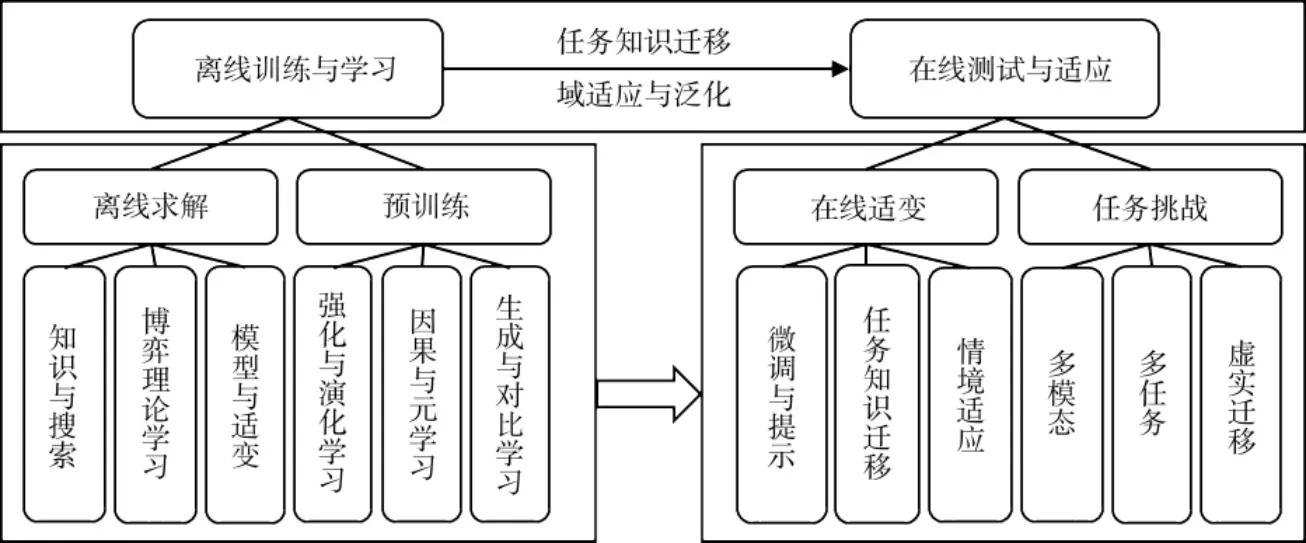

由于真实博弈过程中,局中人策略通常处于非耦合状态,策略的学习展现出两阶段特点,训练(离线)—测试(在线)各阶段的聚焦点亦有所区别. 从“预训练与微调”到“基石模型与情境学习”,基于模型与适变的求解范式为当前博弈问题的求解提供了全新范式. 如图5 所示,离线训练与学习和在线测试与适应框架.

图5 离线训练与学习和在线测试与适应Fig.5 Offline training&learning and online test&adaptation

3 决策Transformer 方法

本章主要从智能博弈问题求解的第3 种范式切入,介绍决策Transformer 的两种实现途径,重点对比分析架构增强类决策Transformer 和序列建模类决策Transformer 方法,分析面临的挑战并进行前沿展望.

3.1 决策Transformer 基础

3.1.1 Transformer 模型

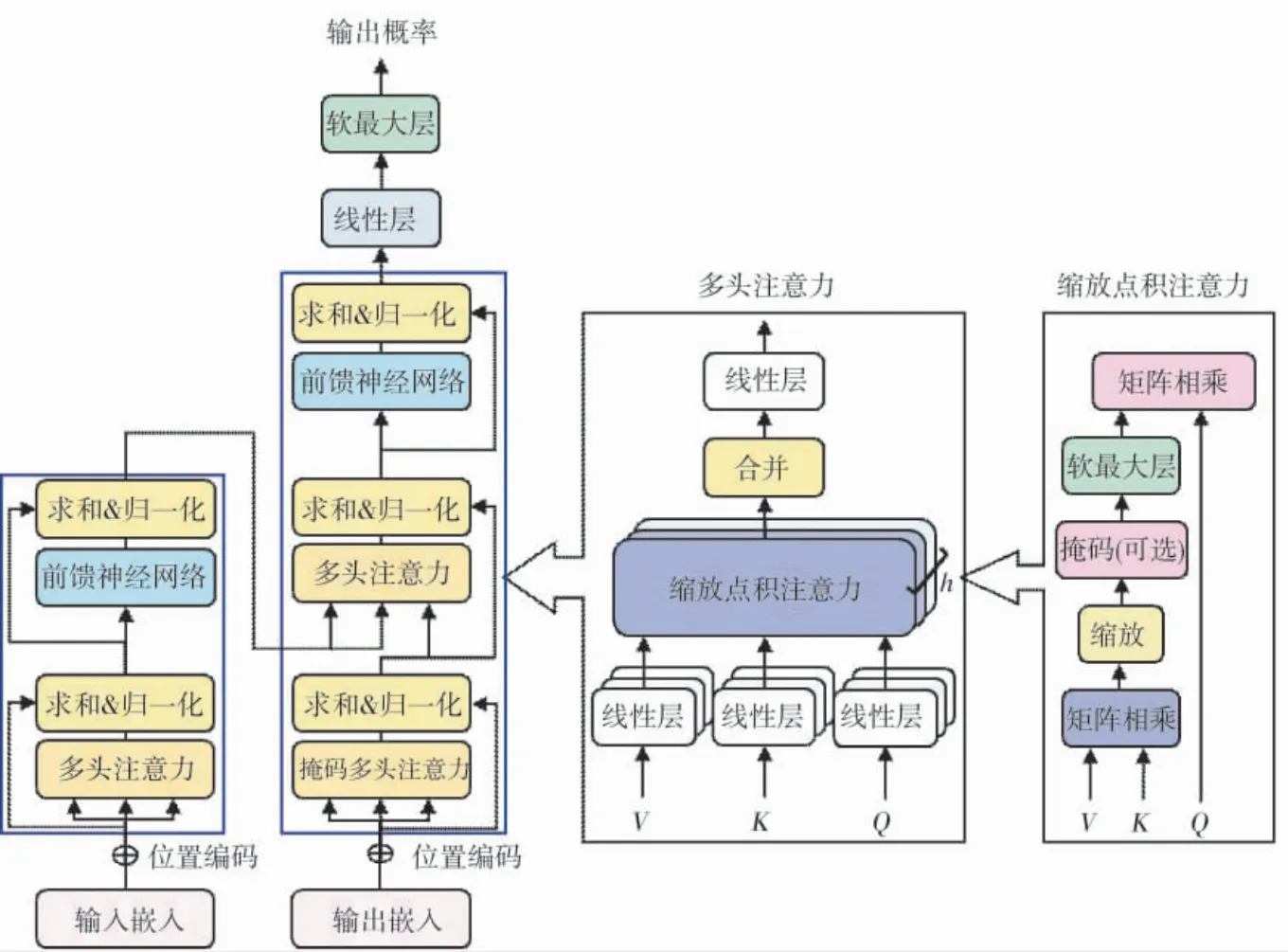

Transformer 采用了“编码-解码”结构,利用词嵌入与位置嵌入的方式将序列信息进行编码用于网络输入,内部利用多头注意力网络,其网络架构如图6所示.

图6 Transformer 网络架构Fig.6 Network architecture for Transformer

由于采用了一次性输入一个序列的方式,仅用注意力而非卷积来做特征抽取,Transformer 的出现在自然语言处理领域率先引发了变革,而后扩展至计算机视觉、智能博弈等领域.

3.1.2 典型博弈Transformer 方法

文本类:由于Transformer 在自然语言领域取得了重大成就,一些研究尝试在文本类游戏中运用Transformer. XU 等针对文字冒险类游戏,设计了基于Transformer 的深度强化学习方法[29]. ADHIKARI 等针对文字类游戏,设计了一种基于Transformer 的动态信念图表示策略学习方法[30]. FURMAN 等针对文字游戏中的问答问题,设计了基于GPT-2 因果Transformer 的序列建模方法[31].

棋牌类:NOEVER 等设计了掌握国际象棋玩法的生成语言模型[32];面向围棋,CIOLINO 等设计了基于Transformer 的自然语言建模方法[33].

视频类:BAKE 等围绕Minecraft 设计了基于视频的预训练模型,可以通过观看未标注在线视频来做动作[34]. WEI 等围绕MPE 环境设计了基于RNN 与Transformer 的层次MADDPG 混合合作竞争策略学习方法[35]. REED 等提出具身智能通才智能体Gato,嵌入多类标记化信息,具有同样权重的同样网络可以完成多类仿真控制、视觉与语言、机器人搭积木等任务[36].

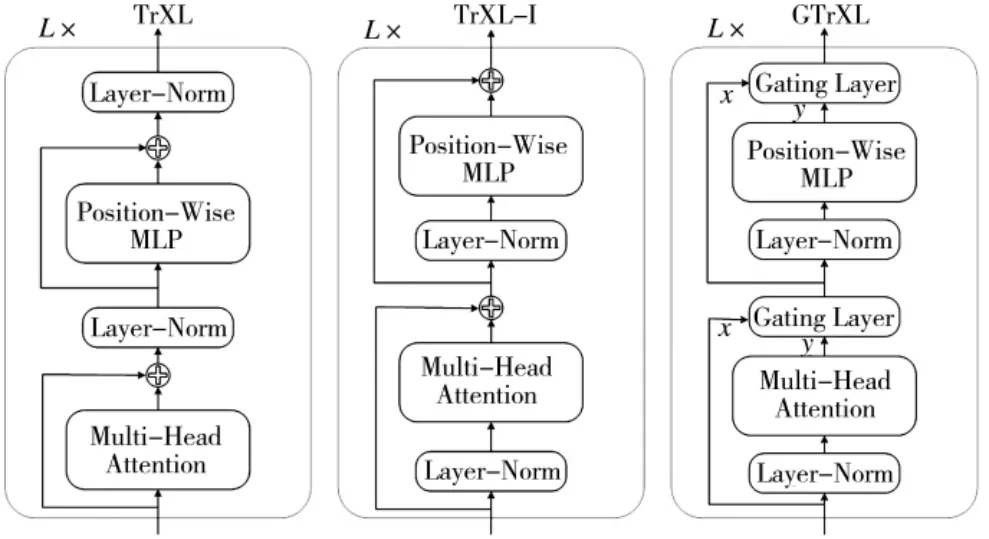

3.1.3 Transformer 架构变换

围绕Transformer 的典型架构变换方法[37]如图7所示,与左侧标准Transformer 架构不一样的是,中间TrXL-I 架构将层正则化作为子模块的输入流,再加上剩余的连接,就有一个从输出流到输入的梯度路径,无需任何转换,右侧GTrXL 架构,额外增加了一个门控层,以取代TrXL-I 的残差连接.

图7 Transformer 变体网络架构Fig.7 Network architecture for Transformer variants

3.1.4 离线强化学习与轨迹优化

利用离线强化学习方法获得预训练模型是一类样本利用率高的策略学习方法. 与在线强化学习与异策强化学习方法不同,离线强化学习得到的离线策略可通过微调的方式用于在线与异策强化学习,如图8所示. 当前主要的离线强化学习方法可分为策略约束类、重要性采样类、正则化学习类、不确定性估计类、基于模型的方法、单步方法、模仿学习类和轨迹优化类[38].

图8 三类强化学习方法Fig.8 Three kinds of reinforcement learning methods

作为轨迹优化类方法,采用同自然语言处理、计算机视觉领域一样的架构,与颠倒强化学习(upsidedown reinforcement learning,UDRL)[39]采用监督学习方法不同,在离线轨迹数据集上训练序列模型,将过去状态、动作和未来回报(state,action,return-to-go)作为数据模态相关神经网络的输入,提取线性嵌入,添加位置时间步编码;然后将编码后的Tokens 输入至因果Transformer 网络中,使用因果自注意和掩码自回归的方式预测未来动作. 作为一类典型的生成式模型,与隐变量变分自编码、扩散模型、能量模型不同,其主要采用基于Transformer 的自回归序列模型,可利用离线带标签数据进行监督式训练与学习.

3.2 架构增强决策Transformer

架构增强决策Transformer 方法是面向决策基石模型的表示学习类方法.

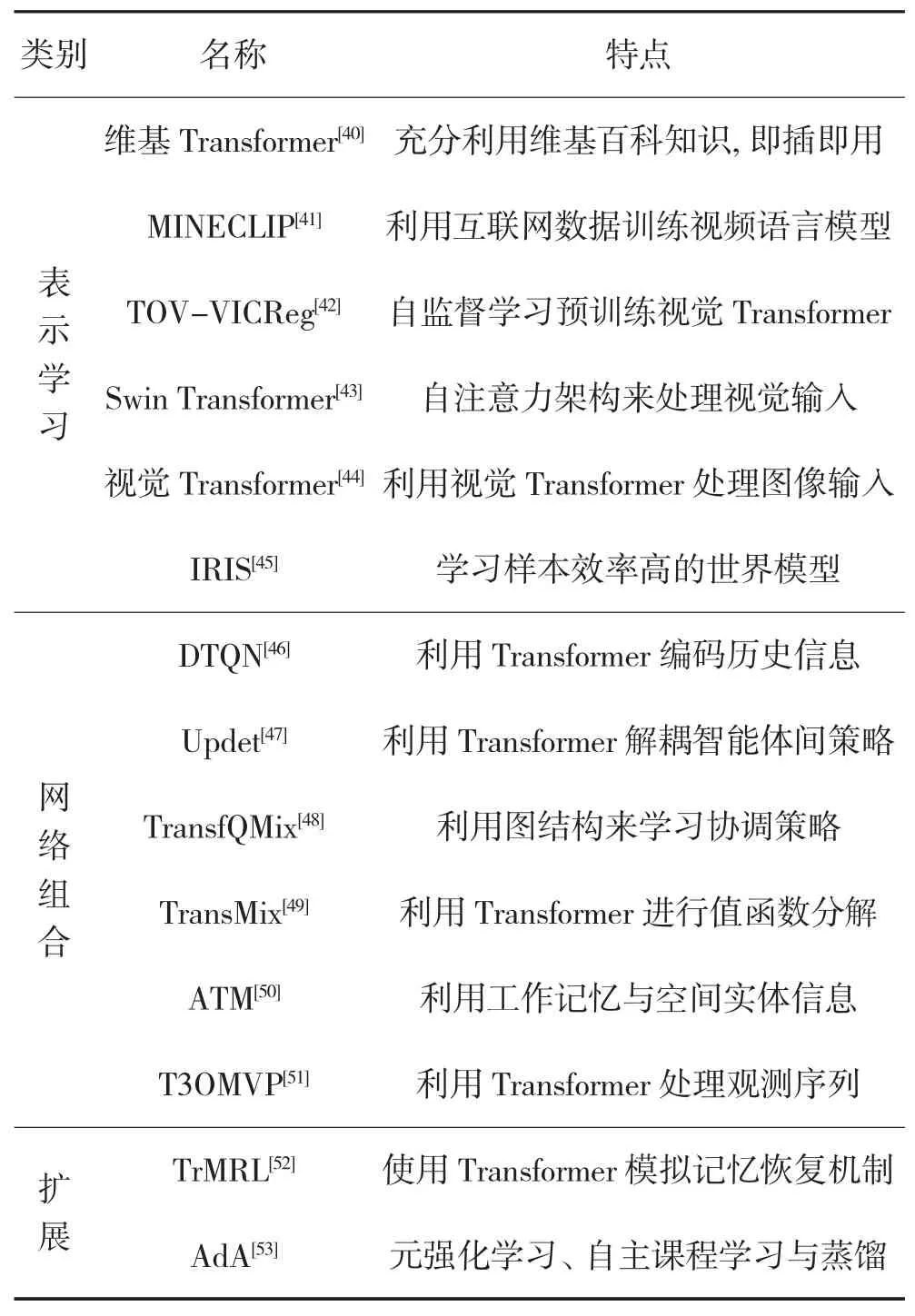

3.2.1 表示学习

维基Transformer:REID 等提出利用大规模现成的维基百科知识来辅助训练离线强化学习[40].MINECLIP:FAN 等提出利用大规模的互联网知识来构建开放式具身智能体[41]. TOV-VICReg:GOULAO 等提出利用自监督学习来预训练视觉Transformer,可以捕捉连续帧之间的时序关系[42].Swin Transformer:MENG等提出利用Swin Transformer 的强化学习方法,尝试将智能体在环境中的规划输入改成视图输入[43]. 视觉Transformer:TAO 等提出利用视觉Transformer 来处理图像(像素)输入和自监督学习方法来训练强化学习策略[44]. IRIS:MICHELI 等提出利用Transformer 来学习样本效率高的世界模型[45].

3.2.2 网络组合

DTQN:ESSLINGER 等利用Transformer 和自注意力来编码智能体的历史信息来求解部分可观强化学习问题[46]. Updet:HU 等基于Transformer 的模型,通过使用自注意力机制确定的重要性权重,将策略分布与交织的观测输入解耦,生成灵活的策略[47].TransfQMix:GALLICI 等利用Transformer 来学习潜在图结构,可以从包含智能体内部和外部状态的大图中学习单调混合函数,具备团队规模扩展性[48].TransMix:KHAN 等提出基于Transformer 的值函数分解方法,学习多个智能体的联合动作混合策略,具备可扩展性[49]. ATM:YANG 等提出智能体Transformer记忆网络,可同时处理顺序工作记忆和其他空间实体信息,通过动作语义归纳偏差将实体嵌入与动作一一绑定[50]. T3OMVP:YUAN 等引入Transformer 处理观测序列来实现多车协同,无需策略解耦[51].

3.2.3 模型扩展

TrMRL:MELO 提出基于Transformer 的元强化学习方法,使用元强化学习智能体模拟记忆恢复机制,将最近的工作记忆联系起来,通过Transformer 层递归地建立一个情景记忆[52]. AdA:DEEPMIND 的适变智能体组提出利用自主课程学习,基于模型的Transformer 强化学习、和蒸馏来实现强化学习基石模型[53].

围绕架构增强决策Transformer 的3 类方法的相关特点如表2 所示.

表2 架构增强决策Transformer 各类方法及特点Table 2 Methods and features of decision Transformer with architecture enhancement

3.3 序列建模决策Transformer

序列建模决策Transformer 方法是面向决策基石模型的条件生成类方法.

3.3.1 离线预训练

决策Transformer:CHEN 等通过将交互序列进行重构,构造了第1 个基于轨迹优化离线强化学习的决策Transformer(decision transofmer,DT)方法[4]. DT 是一种条件生成行为的方法,试图将序贯决策问题建模成可用Transformer 来完成序列生成任务,从而避免了显式决策过程建模问题和交互数据分布偏离导致的Q 值过估计问题. 轨迹Transformer:围绕“轨迹优化”类离线强化学习,与决策Transformer 类似,JANNER等提出轨迹Transformer(trajectory transformer,TT)方法[54]. TT 是一种条件生成模型的方法,由于没有采用基于奖励条件的学习方式,取而代之的是基于集束搜索(Beam Search)的规划方法,对于长序列建模的准确率有所提高. 自助Transformer:由于离线数据集无法做到充分的分布覆盖,WANG 等提出自启动Transformer[55]. 该方法结合了自助(bootstrapping)的思想,利用学习到的模型来自我生成更多的离线数据,以进一步提高序列模型的训练. 双向Transformer:由于无向模型通常被用来训练根据左测条件信息预测下一个动作,而双向模型可以同时预测左侧和右侧. CARROLL 等提出利用双向Transformer 的方法,可以通过微调更好的适应下游任务[56]. 广义决策Transformer:由于DT 方法本质上是在利用“事后信息匹配”(hindsight information matching,HIM)的方式来训练策略,输出符合未来状态信息对应某种分布的最优轨迹.FURUTA 等提出了广义决策Transformer,可以求解任意HIM 问题,通过选择不同的特征函数和反因果聚合网络,可以将决策Transformer 变成该模型的一个特例[57]. 对比决策Transformer:在多任务学习中通过围绕不同任务,分离输入数据的表示可以提高性能.KONAN 等提出对比DT 方法,创建了一个子空间变换层,可以利用增强对比损失来训练输入嵌入的回报依赖变换[58]. 技能Transformer:由于利用信息统计形式的未来轨迹信息可以从离线轨迹数据中提取更多信息,SUDHAKARAN 等提出了技能Transformer 方法,采用事后重标注和技能发掘来发现多样基元动作或技能,可以实现离线状态边际匹配(state-marginalmatching,SMM),发掘更便采样的描述性动作[59]. 分离潜轨迹Transformer:如何在需要考虑安全因素的场景中做长线规划,CORREIA 等提出了分离潜轨迹Transformer 方法,通过引入两个独立的Transformer结构网络来表征世界模型与策略模型,采用类似minmax 搜索的方式,规划过程中搜索潜变量空间来最小化世界模型、最大化策略模型[60]. 安全Transformer:离线强化学习如何部署至现实世界应用中需要获取一些满足一定约束的策略. 当在线安全需求变化时,固定参数的预训练模型可能无法满足要求. ZHANG 等提出了安全Transformer 方法,利用代价相关的Token来限制动作空间,并采用后验安全验证来显式地执行约束,以最大剩余代价为条件,执行两阶段自回归来生成可行的候选方案,然后过滤掉不安全的、执行具有最高预期回报的最佳操作[61]. Q 学习决策Transformer:由于离线数据集中可能包含次优轨迹,可能导致学习算法的不稳定性,YAMGATA 等提出了基于Q学习决策Transformer 方法,可以利用动态规划结果对训练数据中的“未来回报”进行重标注,然后用重新标注的数据对决策Transformer 进行训练[62].

3.3.2 在线适变

在线微调:由于决策Transformer 没有在线自适应模块,泛化性比较差. ZHENG 等提出了在线Transformer 方法,可以针对任务指定的环境,采用在线微调,将离线预训练与在线微调合成为一个统一的框架,利用序列层的熵正则化与自回归建模目标来获得样本利率率高的探索与微调效果[63]. 在线提示:围绕在线快速适应,利用架构归纳偏差对应的少样本学习能力,XU 等提出基于提示的决策Transformer 方法,利用Transformer 结构的序列建模能力和提示框架实现离线强化学习的少样本自适应,设计轨迹提示,包含几个样本的演示片段,并对特定于任务的信息进行编码,以指导策略生[64]. 在线迁移:为了适应变化环境,将此前已经掌握的知识应用至未见结构属性的环境中可以提高策略的弹性和效率. BOUSTATI 等提出在决策Transformer 中应用基于因果反事实推理的迁移学习方法,采用基于决策Transformer 架构的蒸馏方法为适应新环境生成策略[65]. 超决策Transformer:为了适应新的任务,获取“数据-参数”高效的泛化能力,XU 等提出了超决策Transformer 方法,利用超网络设计自适应模块,针对未知任务只需微调自适应模块即可[66]. 情境适应:为了提高应对不同情境的适应性能力,LIN 等提出了情境Transformer,将情境向量序列与原本输入进行级联来引导条件策略生成,其次利用元强化学习方法来利用不同任务间的情境,提升应对未知任务的泛化能力[67].

3.3.3 模型扩展

多智能体协同:围绕多智能体协同,MENG 等提出多智能体决策Transformer 方法,将多智能体离线预训练建模成一个大型序列模型,可以同时利用离线与在线数据进行训练[68]. WEN 等提出多智能体Transformer,利用编码器-解码器框架与多智能体优势函数值分解,将联合策略搜索问题变换成序列决策问题,从而保证单调性能提升[69]. LIN 等提出的情境元Transformer,充分利用场景信息来提高泛化能力[67]. 多任务泛化:围绕多类任务,瞄准提高泛化性,LEE 等提出多游戏决策Transformer 方法,基于多类任务场景专家级经典回放数据进行离线学习,利用专家动作推理的方式持续生成高价值回报行为[70]. 为了提高TT 方法的泛化性,LIN 等提出基于开关(Switch)的轨迹Transformer. 利用稀疏激活模型来降低多任务离线模型学习中的计算成本,采用分布轨迹值估计器来提高稀疏奖励场景下的策略性能[71]. 多模态协同:围绕多种模态信息输入,SHAFIULLAH 等提出行为Transformer模型,可以建模非标注的多模态演示数据,利用多模态建模能力来预测动作[72]. 虚实迁移探索:围绕如何将虚拟仿真器中学习到的优化策略迁移应用于具体的实物中一直以来是值得探索的大挑战. SHANG 等提出基于“状态-动作-奖励”的StARformer 方法,引入类似马可夫的归纳偏差来改进长程建模[73]. 围绕自动驾驶,SUN 等提出控制Transformer,运用自监督学习的方式训练以控制为中心的目标,具备应对预训练与微调之间分布偏移的韧性[74]. 围绕真实世界机器人控制问题,BROHAN 等提出了RT-1 模型[75]. 当前,机器人操控、导航、任务分配和自动驾驶等探索虚实迁移(sim-to-real)问题的关键研究领域.

围绕序列建模决策Transformer 的3 类方法的相关特点如表3 所示.

3.4 挑战及展望

3.4.1 面临的挑战

环境模型:由于预训练与微调所对应的场景不同,分布偏移导致直接利用离线学习策略可能输出次优动作. 如何应对随机环境[76]、最优偏差[77]、不确定[78]等都是当前面临的挑战.

博弈预训练:当前多类方法均从是决策理论、优化单方目标的角度设计的,多方(智能体)的连续(序贯)对抗场景均可采用基于交互的博弈理论建模,如何设计面向均衡解的离线博弈学习方法,考虑离线均衡搜寻[79]、离线博弈对抗数据分布[80]、分析离线博弈策略的可学习性[81]等仍是当前面临的挑战.

情境学习:从一般的小型预训练模型到大型的基石模型,如何提高模型的适应性仍是当前面临的挑战,利用情境学习方法[82],可以逐渐提高算法应对新场景新任务的能力.

3.4.2 前沿发展

Transformer 结构:随着各类基础模型的迭代更新,分布Transformer 结构的重要性[83],改进Transformer 的结构模型是值得研究的方向.

人工智能生成基石模型:与判别式人工智能不同,生成式人工智能模型探索未知策略空间提供了方法途径,条件生成建模[84]等生成式人工智能方向值得研究.

多模态交互决策:多种模态信息流转为交互式决策提出了挑战,如何利用好Transformer 等架构,输入自然语言指令[85]和其他不同模态[86]信息值得探索. 此外,多种模态的基石模型可用作“即插即用”(plugand-play)模块,辅助智能决策.

4 结论

博弈强对抗环境下,如何响应高动态性、不确定性、高复杂性对抗,给出自适应可信任应对策略,均是智能博弈问题求解的重要课题. 方法的集成本质是为了提高问题求解的样本效率、策略的泛化性、鲁棒性、安全性、可信任性等,但如何自洽融合、模块适配求解智能博弈问题仍是一个开放性问题. 人工智能算法与GPU 算力的完美结合为各研究领域带了范式革命,基于云原生基础设施的决策基石模型已然到来.

本文介绍了智能博弈问题的3 类博弈模型、分析了4 类博弈认知模型、给出了智能博弈求解方案,着力设计了智能博弈问题求解的集成框架,深入分析了决策Transformer 方法. 可以为智能兵棋推演、智能战略博弈、智能蓝军、智能决策辅助等项目提供综合式策略集成学习解决方案. 决策基石模型的生成与服务化是一种可行方案,可为分布式对抗场景下的智能指挥决策提供支撑.