风冷精密空调数据中心的能耗分析研究

2023-04-17刘宏伟黄国瑞白聚莹赵耀代彦军

刘宏伟,黄国瑞,白聚莹,赵耀,代彦军

(上海交通大学制冷与低温研究所,上海 200240)

0 引言

随着互联网存储和通信需求的增长,全国数据中心规模不断扩大,服务器功率密度也不断增加[1],使得数据中心的能耗不断增加,从而导致高昂的运营成本和环境污染问题[2]。高纬环球预测到2025年,数据中心电力消耗将占全球用电的4.5%。故在数据中心进行节能改造和应用可再生能源技术对于实现“二氧化碳排放力争于2030 年前达到峰值,努力争取2060 年前实现碳中和”的目标有着重要意义。

体现互联网数据中心绿色节能的关键指标是能源利用效率(Power Usage Effectiveness,PUE),PUE 指数据中心总用电量与数据中心(Information Technology,IT)设备消耗电量的比值,PUE 值越大,表示制冷和供电等配套基础设施所消耗的电能越多,节能效果越差。上海地区现有数据中心的运行PUE 普遍偏高,在1.5~2.0 之间,亟待改善[3]。上海市经信委在新发布的文件中要求:推动数据中心节能技改和结构调整,存量改造数据中心PUE不高于1.4,新建数据中心PUE 限制在1.3 以下[4]。

可再生能源技术的应用对降低PUE 和减少二氧化碳排放有积极作用[5],已被国外多个著名数据中心用于电力供应,国内也出台了相关政策鼓励数据中心应用可再生能源[6]。利用低温环境的自然冷却技术在国内外也有多个典型工程案例,被证明能有效减少数据中心的能耗[7]。目前,上海市存量数据中心部分利用风冷精密空调制冷系统进行散热,其PUE 高达1.7~1.9,能效有较大的提升空间。而目前无针对此类数据中心系统性改造分析。因此,结合上海地区环境气候和特点,对数据中心机房进行节能设计和优化对碳减排有重大意义[8]。

1 数据中心概况

1.1 数据中心介绍

研究的风冷精密空调数据中心共有五层,为租赁型数据中心,现已基本满载。该数据中心由两路3 600 kVA 容量的市电分别从不同电站接入进行供电;2N 配置的不间断电源(Uninterruptible Power Supply,UPS)组合互相隔离,电池支持UPS 满负荷运转30 min;并且配有室外柴油发电机组,埋地式储油罐可供发电机带负荷运转不低于12 h。

本文以该数据中心的第4 层机房作为研究对象。机房建筑面积586.8 m2,机房内共有80 个机柜,每个机柜满负载功率2.5 kW。机房使用5 台风冷精密空调对房间冷却,单台制冷量为54 kW,其中4台常开,1 台备用。机房无人值守,内部布局如图1 所示。这些风冷精密空调运行已经超过10 年,机组老旧严重、性能下降和能耗较高。

图1 机房内布局

机房送风形式为地板下送风上回风,机柜之间未设置冷热通道分离,混风严重,如图2 所示。

图2 机房送风形式

1.2 上海气候条件

根据海拔7 m,位于北纬31.2°东经121.4°的上海市气象站的数据,上海市全年8 760 h 的干湿球温度变化如图3 所示。冬季最低湿球温度可达-5 ℃以下,如果合理利用冬季低温环境进行自然冷却,可有效减少数据中心制冷系统的耗能,降低PUE。

图3 上海市干湿球温度

2 仿真模型的建立

2.1 冷负荷模型

数据中心冷负荷包括IT 设备、维护结构、人员、灯光和渗透等[9-10]。该机房为无人值守机房,相比于IT 设备产生的发热量,人员流动产生的冷负荷很小,可以忽略不计。数据中心的总冷负荷可以通过下列计算公式计算:

式中,Qload(i)为数据中心冷负荷,kW;Qenvelop(i)为围护结构冷负荷,kW;Qlighting(i)为灯光冷负荷,kW;QIT(i)为IT 设备冷负荷,kW。

2.2 制冷系统模型

图4 所示为风冷精密空调数据中心模型。模型中制冷系统主要设备包括机房建筑模型、风冷型精密空调和机柜等。根据设备的性能参数对设备模型参数进行调整,采用瞬态逐时计算,全面分析系统运行情况。

图4 风冷精密空调数据中心模型

通过TRNSYS模型8 760 h 的冷负荷模拟计算,得到的冷负荷分布规律图5 所示。由图5 可知:该数据中心机房的冷负荷在190~210 kW 波动,且呈现出冬季冷负荷小,夏季冷负荷大的特点。

图5 冷负荷分布规律

2.3 能效指标

一般计算基准PUE 时需考虑数据中心的总能源消耗量,对于没有外供冷的数据中心,基准PUE计算公式为:

式中,Es为数据中心基准PUE,kW·h;Ptotal为数据中心总用电量,包括IT 用电、制冷系统用电、电力损耗和照明用电等,kWh;Poffice为办公用电量,kW·h;PIT为IT 设备用电量,kW·h。

综合考虑若干及技术对数据中心自身及城市整体能效提升的作用,上海市经信委在基准PUE指标基础上计算综合PUE 指标,并以综合PUE 指标作为对各数据中心的约束条件。

综合PUE 的计算[11]:

式中,Ec为数据中心综合PUE;γi为各项技术对应的调节因子。

各项技术包括:太阳能等可再生能源利用、峰谷蓄电、错峰蓄冷、利用周边企业的余热废冷、液冷技术、能耗计量细致化, 调节因子γi的取值根据不同技术的应用程度来决定。

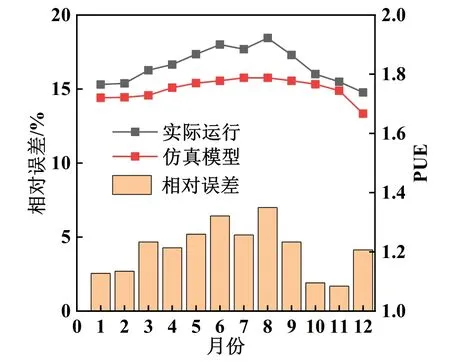

2.4 模型误差分析

首先对改造前的数据中心机房能耗进行模拟,通过与实际运行数据的比对,不断调整优化模型,使其误差达到可接受范围之内。图6 所示为实际运行PUE 与仿真模型PUE 对比。由图6 可知:实际运行PUE 受上海市环境温度的影响,在1.74~1.92变化,且呈现出夏季高、冬季低的变化规律;仿真模型PUE 在1.67~1.79 变化,其随温度变化规律与实际运行PUE 一致,且相对误差在7%以内,说明模型较为准确,具备一定可靠性。

图6 实际运行PUE 与仿真模型PUE 对比

3 节能改造措施

3.1 精密空调改造

当前该数据中心机房使用的是单台总制冷量54 kW 的风冷型精密空调,将其更换制冷量相近的氟泵精密空调。在过渡季节时,氟泵精密空调能够使用氟泵增压,使机组能效比提升;在低温季节时,氟泵精密空调可以关闭压缩机,仅使用氟泵驱动制冷循环,充分利用自然冷却,从而减少制冷系统的耗能[12-13]。表1 所示为改造前后精密空调参数对比。根据国标GB40879—2021《数据中心能效限定值及能效等级》[14]中全国部分城市温度分布系数表,氟泵精密空调的性能参数如表2 所示。

表1 风冷精密空调与氟泵精密空调技术参数对比

表2 上海市温度分布及氟泵精密空调能效

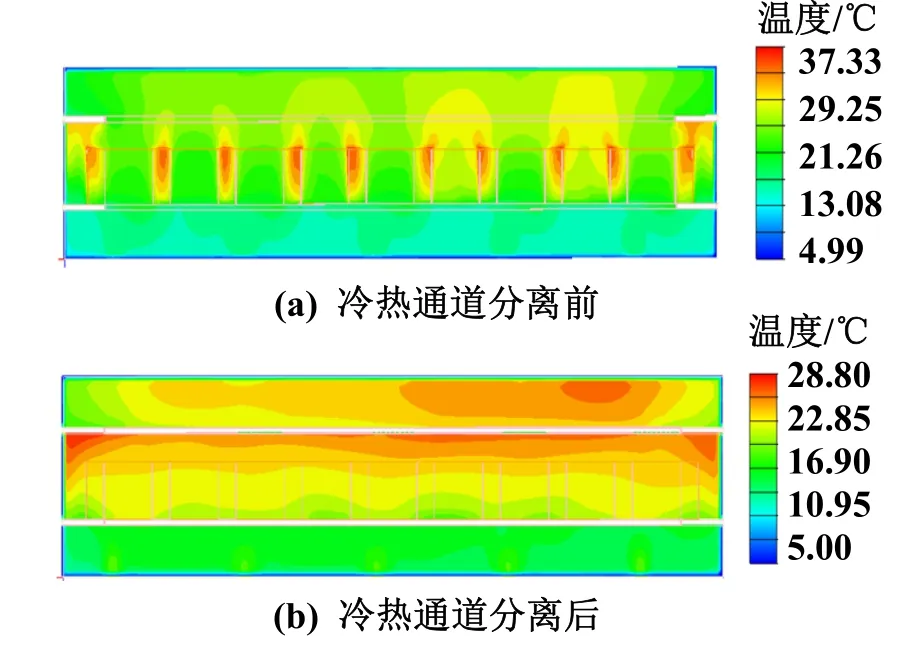

3.2 冷热通道分离改造

改造前该数据中心机房采用地板下送风上回风的气流组织方式,机柜侧冷热气流掺混严重,导致服务器的散热效果不佳[15-17]。改善机房气流组织的方式之一是冷热通道隔离[18-19],考虑施工限制,针对此机房采用冷通道封闭来实现冷热通道隔离,机房气流组织参数如表3 所示。冷风从开口地板进入两排机柜中间的冷通道,经过负载设备后,再进入热通道,从而减少冷热气流的掺混[20-21]。

表3 机房气流组织参数

3.3 太阳能光伏和储能技术应用

本文研究对象为数据中心第4 层的一间机房,而光伏系统和储能系统的规划应当按照整个数据中心的能耗进行设计,故本小节提及的能耗数据为整个数据中心的能耗数据。本数据中心屋顶及车棚平整,可利用空闲面积安装光伏系统。屋顶及车棚共可安装434 块300 W 的单晶硅光伏组件,年发电量可达145 000 kW·h。据能耗计量统计,此数据中心年用电量为23 511 900 kW·h。光伏系统全年发电量大于数据中心年总用电量的0.01%,可使其综合PUE 降低0.02[11]。

本数据中心园区有空闲地面可放置储能设备。设计储能系统容量430 kW·h,按照90%充放电深度,两充两放,充放电效率为90.9%。该峰谷蓄电储能系统全年蓄能发电量可达257 084 kW·h,大于数据中心总用电量的1%,可使综合PUE 降低0.015[11]。照明设备是长为1.2 m、管径为16 mm 的圆管灯,其额功率为28 W;在保证照明要求的同时,可使用8 W 的LED 灯实现节能。在实施以上改造的同时细化数据中心能耗计量,可再使综合PUE下降0.01[11]。

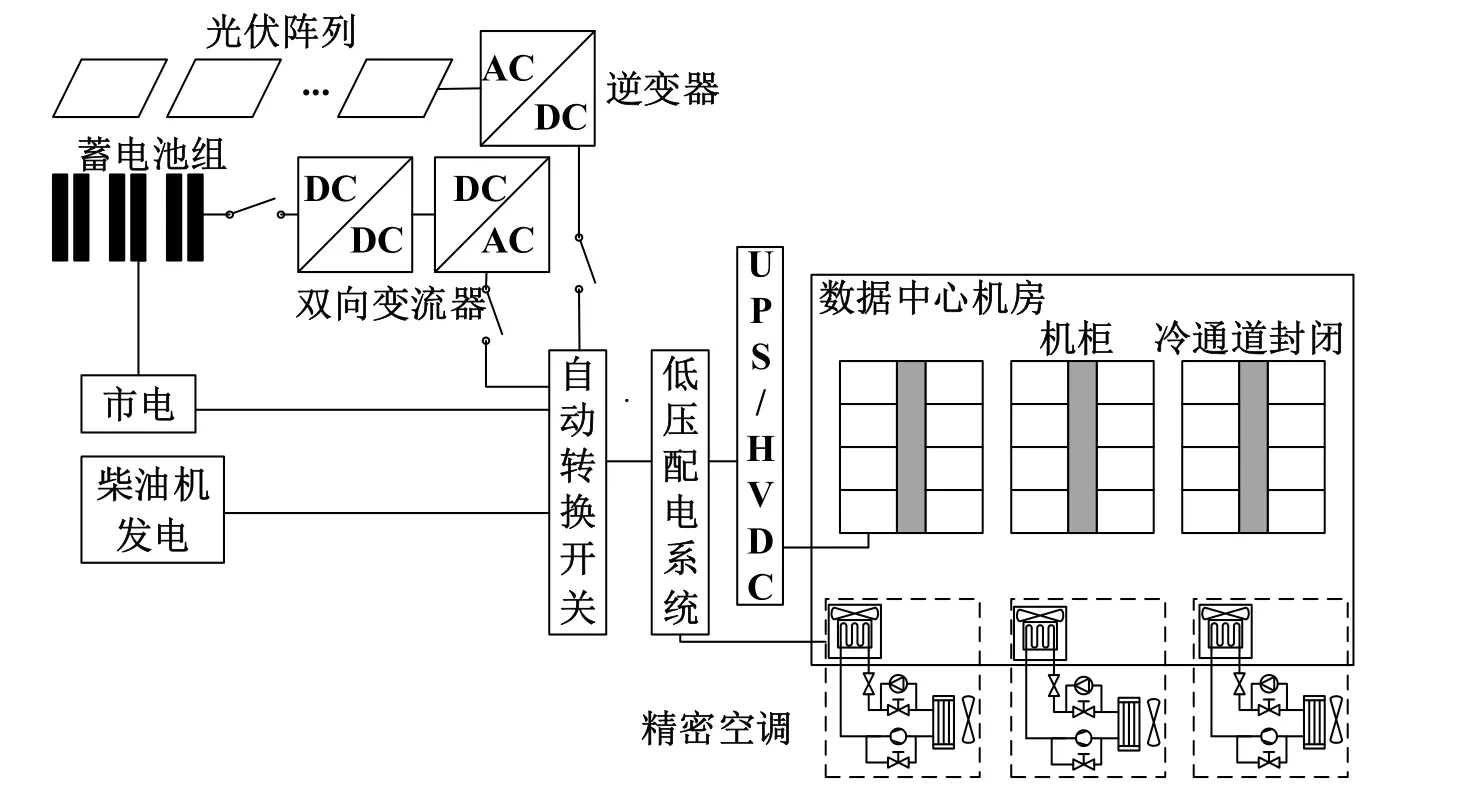

3.4 改造后的能源系统

改造后,该数据中心机房能源系统原理如图7所示。由图7 可知:数据中心能源系统分为两部分,一部分是是包括市电、柴油发电机、储能蓄电池组、光伏发电模块、自动转换开关、低压配电系统、UPS或高压直流的电力系统;另一部分是机房内部的制冷系统,由5 台氟泵精密空调及机柜组成,机柜之间采用冷通道隔离,起到分离冷热气流的作用。

图7 数据中心能源系统原理

4 改造措施的效果分析

4.1 冷热通道分离分析

利用AIRPAK 软件对机房气流组织进行仿真计算,如图8 所示为冷热通道分离前后的温度分布。当送风温度设置为20 ℃时,改造前冷通道平均温度为23.43 ℃,且冷通道内温度分布极不均匀,机柜内聚集有大量热。冷热通道分离后冷通道平均温度为21.45 ℃,且通道内温度分布较为均匀,不易出现热点[22]。由此可见,冷热通道分离可以有效优化机房气流组织,减少制冷量的损耗。在满足机房温度条件的情况下,实施冷热通道分离后可以适当提高送风温度,从而降低制冷系统能耗[23-24]。

图8 冷热通道分离前后温度分布

4.2 能耗对比分析

图9 所示为该数据中心改造前后能耗构成对比。改造前总能耗为2 457 782 kW·h,改造后总能耗为2 002 829 kW·h(光伏系统的发电量未计入其中,因光伏发电不稳定且发电量较少,一般用数据中心办公区,不用于机房),其中,IT 设备、精密空调、UPS 等损耗、照明和其他耗能分别占57.03%、30.00%、7.98%和4.99%;改造后其对应占比分别为69.98%、16.72%、9.80%和3.50%。

图9 改造前后能耗构成对比

可知IT 设备能耗占比有较大提升,能源利用率得到提高;自然冷源的利用使精密空调能耗占比大大减少;UPS 等电力损耗变化不大,因为储能系统的峰谷蓄电调节不能减少数据中心用电量,而是用于调整改善城市整体能效,所以此次改造未对电力系统产生太大影响;照明及其他用电有所降低但不明显,说明照明改造有节能效果,但灯具功率较低,对总能耗影响较小。

4.3 PUE 分析

图10 所示为改造前后基准PUE 与综合PUE 对比。由图10 可知:改造前该数据中心的PUE 为1.75,远远高于上海市要求的存量改造数据中心PUE 不高于1.4 的目标。通过氟泵精密空调改造、气流组织优化以及照明改造,该数据中心的基准PUE 降低至1.43。相较于改造前,PUE 减小了18.3%,但仍未达到改造目标。由于场地条件限制,很难从降低非IT 设备能耗方向上着手进一步降低PUE。因此,利用园区屋顶及空地增设光伏、储能系统,并完善对数据中心的能耗计量,既响应国家对新能源技术应用的政策,又能进一步降低PUE,最终可使综合PUE 降低至1.385,达到改造目标。

图10 改造前后基准PUE 与综合PUE 的对比

5 结论

本文以上海某典型风冷精密空调数据中心机房为对象,利用TRNSYS 平台搭建了该数据中心全年动态能耗模型以及能源系统模型,对其能耗进行仿真模拟,研究了应用氟泵自然冷却技术、气流组织改善优化、光伏发电技术、峰谷蓄电储能技术和照明改造等各项节能措施对该数据中心能耗的影响,分析了不同节能技术对数据中心能源利用效率的影响,得出如下结论:

1)采取文中分析的措施进行改造后,该风冷精密空调数据中心的基准PUE 从1.75 降低至1.43,综合PUE 从1.75 降低至1.385,满足上海市存量改造数据中心PUE 不高于1.4 的要求;

2)制冷系统优化(包括精密空调改造、气流组织优化和照明改造)使基准PUE 降低了0.32;光伏储能系统改造虽然对降低能耗帮助不大,但能够使综合PUE 降低0.035;

3)对于类似的使用风冷精密空调作为制冷系统的数据中心改造,由于场地等条件的限制,可以优先考虑使用氟泵精密空调,利用自然冷却技术降低制冷系统能耗;其次考虑冷热通道分离技术,提升机房制冷效率;再利用光伏技术和储能技术,降低综合PUE。