心理学家:算法必将改变我们的生活

2023-04-11李铮

李铮

算法这个词被广泛使用,你怎么看待?

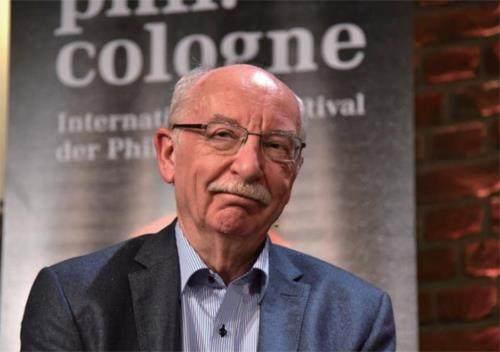

在ChatGPT时代,计算机算法和人工智能越来越多地融入我们的生活,近日大家不断地参与机器对话,不亦乐乎。对此德国波茨坦大学心理学家和行为科学家格尔德·吉仁泽认为:“这些算法可能正在以我们不完全理解的方式,改变我们的世界和行为。”格尔德·吉仁泽曾任某个人类发展研究所适应行为和认知中心主任,在他的最新著作《如何在智能世界中保持智能》中,他讲述了许多关于算法如何塑造我们的未来的一些观点。

如果你有一个定义明确的目的,且需要计算机来分析,那么深度神经网络等复杂算法肯定比人类表现更好。例如游戏中的国际象棋和围棋,它们的出子效率和步骤成熟和稳定,且还在不断进化,已经有先例证明,人类目前已经在这两个项目中落败。

但是,如果你有一个不稳定的问题——例如,你想预测一种病毒何时被清除,比如冠状病毒,那么就不要寄望于算法可以帮我们解决这个问题。人类思维的方式相对比较简单,识别一两个重要的线索而忽略其余的,但机器不是,机器可以并行计算,但机器对于生物医学的复杂性发展也是无能为力的。在定义不明确的问题中,算法数据沉积过多,不一定能带来好的结果。

算法越来越复杂,是否更安全稳定?

深度神经网络有“很多层”,但归根到底它们仍然是计算机器。在ChatGPT技术的帮助下,它们可以做的比以往任何时候都多,比如绘画,生成以假乱真的图片,撰写论文,但这并不意味着它们能像人类那样理解文本,甚至也会涉及隐私泄露,比如我们用于生成图片的素材可能会让我们的自拍照被他人窥探。随着系统复杂度的增长,机器也会暴露一些弱点,即便如同微软这种老牌软件公司,数据泄露的事件也屡见不鲜,攻击者在其庞大的代码库中找寻严重的漏洞,这些都是短时间内无法消除的。

技术是否容易向制度倾斜?

虽然现在人类工程师为人工智能的行为做出了很多框架,但我觉得人工智能工作的透明度依然非常重要,程序员可以对算法技术进行修改,并引导它们具有“自己思考”的能力,但人类还没到过度依赖它们的程度,我个人认为目前还没有比一群低薪工人更好的算法。

比如神经网络算法最常见的“黑盒算法”中,因为人们无法从外部得知神经网络模型究竟是如何完成训练的,使用了一个预测准确率为97%的猫脸识别模型,结果这个算法有时会将小狗的脸部照片归纳到小猫中。由于神经网络算法的这一不确定的特性,导致一些场景并不适合使用神经网络算法,比如银行不会使用神经网络算法来评判用户是否具备信用,因为一旦出现预测错误,银行根本无法溯源找到评判错误的原因,也无法向客户做出合理的解释。

所以就人工智能的技术该如何管理,把它限制在我们认为靠谱的范围内,现在还言之尚早。目前,互联网大公司的算法皆为商业诉求所主导,互联网产品以“使人上瘾”为诉求,推送信息以“投其所好”为标准,伦理道德与社会责任几乎完全缺席。

要想改变现状,不再让医疗搜索占坑、脸书泄密等事件再度发生,必须推动立法,对这些互联网大公司的产品背后的算法进行“审计”和监督——关于数据挖掘的算法,可以规定可供挖掘的数据类别和限度;关于个性化定制推荐的算法,可以规定要求“事实检查”或者明确提醒用户信息的真实性有待核实;关于过滤算法,可以规定特定行业(如醫疗)的企业在使用社交媒体广告服务时的资格检查。

关注对算法的“审计”和监管,而非对内容的审核,才有利于在未来逐步建立一套有例可循的“算法法律”。

算法会不会影响我们的日常生活?

如果你的楼下有一家提供免费咖啡的咖啡馆,每个人都去那里,其他咖啡馆都破产了,其实是很悲哀的事情,你缺少了与人交流的机会。我们现在生活的任何公共场所,墙上有摄像机和麦克风,记录你所说的每一个字,就像电影《全民公敌》里面,后台有超算对你说的话和行为举止进行分析,看你是否具有犯罪意图,我相信大部分人对此感到反感。

我们已经看到有过多基础设施被互联网所“裹挟”,但并非好事,事实上有些对我们的正常生活已经构成了困扰甚至威胁。就像电动车,主机厂在辅助驾驶还在完善的阶段,就大吹特吹其为自动驾驶,自动二字让相当部分的驾驶员放松了警惕,造成马路上的一些车祸。

总的来说,我更希望人们意识到,将数据和自己的安全交给科技公司的算法并不是一个好主意,科技公司利用它从广告商那里赚钱,但付出惨痛代价的却是普通老百姓。