基于分量分割与YOLOv8s的红火蚁蚁巢识别

2023-02-28张泽骏李健钊吴武林钟洁凤吴亚榕林钦永

张泽骏 李健钊 吴武林 钟洁凤 吴亚榕 林钦永

摘 要:提出一种基于分量分割与YOLOv8s的红火蚁蚁巢识别模型,为无人化灭蚁等相关研究提供参考。利用红火蚁蚁巢土壤与周围环境色相差异较大的特征将蚁巢初步分割出来并进行二值化,将色相分割二值图与明度分量二值图融合以消除杂草的遮挡干扰,利用图像形态学算法对得到的图像进行优化,使用YOLOv8s作为基础网络,添加SK注意力机制,构建红火蚁蚁巢检测网络模型。模型研究环境下对红火蚁蚁巢样本图像进行预测的精度为93.3%,召回率为89.7%,有效AP值达83.1%,网络前向时间为15.7 ms,F1综合评价指标为92.0%,模型GFLOPs为41.0。研究还进一步精确了红火蚁蚁巢土的H值范围(不被阳光照射的情况下为342~27,阳光照射情况下为25.9~35.8),并比较了不同光照条件对红火蚁蚁巢土的H值的影响。

关键词:红火蚁;YOLOv8;Varifocal Loss;HSV空间

中图分类号:TP391.4;S433 文献标识码:A 文章编号:2096-4706(2023)20-0066-09

Red Fire Ant Nest Recognition Based on Component Segmentation and YOLOv8s

ZHANG Zejun, LI Jianzhao, WU Wulin, ZHONG Jiefeng, WU Yarong, LIN Qinyong

(College of Automation, Zhongkai University of Agriculture and Engineering, Guangzhou 510225, China)

Abstract: This paper proposes a red fire ant nest recognition model based on component segmentation and YOLOv8s, providing reference for related research such as unmanned ant extermination. By utilizing the significant color difference between the red fire ant nest soil and surrounding environment, the nest is preliminarily segmented and binarized. The color segmentation binary map and brightness component binary map are fused to eliminate weed occlusion interference. Image morphology algorithms is used to optimize the resulting image. YOLOv8s is used as the basic network, and SK attention mechanism is added to construct a red fire ant nest detection network model. The prediction accuracy of red fire ant nest sample images in the model research environment is 93.3%, the recall rate is 89.7%, the effective AP value is 83.1%, the network forward time is 15.7 ms, the F1 comprehensive evaluation index is 92.0%, and the model GFLOPs is 41.0. The study further refines the H value range of red fire ant nest soil (342~27 without sunlight and 25.9~35.8 with sunlight), and compares the effects of different lighting conditions on the H value of red fire ant nest soil.

Keywords: red fire ant; YOLOv8; Varifocal Loss; HSV space

0 引 言

紅火蚁(Solenopsis invicta Buren)原分布于南美洲,是全球最具危险性的100种入侵生物之一。目前,红火蚁已经扩散至我国10余个省区,对农业生产和群众的健康生活造成了严重的损害[1-3]。而防治蚁患入侵的手段主要以人工作业为主。但传统的人工踏查方式存在着肉眼识别错误率高、工作效率低、易被叮蛰等难点[4]。

随着农业智能化的提高,无人机逐渐被应用于农业生产中,而运用无人机在空中扫描图片,结合图像处理算法定位红火蚁蚁巢可以较好地解决上述问题。近些年来,我国专家学者就此问题提出多种算法。吴伟斌等[5]仅用色相差异分离红火蚁蚁巢土和普通土,经实际运用后发现,如果蚁巢土被阳光照射,其色相将变为25.9~35.8,与普通土色相相似。同时,有相当一部分的枯草、沙土的色相与其重叠,但该算法并未将这些干扰消除,故其局限性较大。朱立学等[6]采用超绿灰度图分离杂草,并利用明度差异区分蚁巢和草坪,是一种行之有效的红火蚁蚁巢识别算法。但该算法未考虑蚁巢土和普通土的分离,在草覆盖率低的区域容易产生误判,其适用场景有限。

在提取目标方面,常见的边缘检测算法有Sobel[7]、Canny算子、二维Otsu算法[8]、FCM算法[9]。夏亚飞[10]基于K均值聚类和Otsu算法对棉花HSV图像进行分割;张国权等[11]利用Sobel算子对彩色图像进行边缘化处理。但随着农业机械化和信息化的高速发展对于病虫害的识别已经由传统的识别算法发展为基于深度学习的目标检测。张海波等[12]使用BP神经网络来进行图像的识别,识别率可以达到95.7%;王业等[13]利用Faster-RCNN算法来进行对设备安全的自动巡视,实现了二次设备巡视工作的无人化或少人化;魏甫豫等[14]利用卷积神经网络与迁学习进行昆虫种类的识别,经过训练后的识别率可以达到96.5%。

上述基于深度学习的目标识别,为深度学习技术应用于红火蚁窝的识别提供了参考。YOLO算法采用单个神经网络直接对整个图像进行前向传递,并输出每个目标的类别概率和边界框坐标。相比于传统的目标检测算法,如基于区域提取的R-CNN系列,YOLO算法具有更快的检测速度和更高的实时性。谢椿辉

等[15]提出了一种基于改进的YOLOv5模型,通过融合多尺度、多层次的信息与设计多尺度通道注意力模块使得在无人机上对小目标检测的精度达到了60.24%,且检测时间仅为16 ms。雷荣智等[16]提出了一种基于改进的YOLOv3算法,通过引入SPP层和PAN结构使得在无人机上对房屋和农田的平均识别率达到了72.6%。马宏兴等[17]提出了一种基于改进YOLOv5的蝗虫识别方法,平均识别准确率为96.8%。YOLOv8是Ultralytics公司于2023年初公布的目标检测模型,是YOLO系列网络的最新模型,它在以前成功的YOLO版本基础上引入了新的功能和改进,进一步提升了其性能和灵活性。因此,YOLO系列模型被广泛应用于目标检测、图像分割和图像分类任务中。

由于自然环境下拍摄的蚁窝图像相对较为复杂,蚁窝的形状和颜色与普通土堆相似,容易导致目标识别的误判或漏检。为提高识别准确性,可以结合传统算法和YOLOv8模型的优点,将两个模型进行级联。传统算法可用于增强蚁窝图像特征,神经网络模型可用于学习特征并进行目标检测。

1 图像获取及预处理

研究于2022年12月中旬在广东省中山市南朗镇红火蚁疫情荒地,使用vivo X50手机,在距离红火蚁蚁巢60~70 cm的高度,与地面成60°~90°夹角进行拍摄。由于红火蚁筑巢环境多变,因此分别选择了3种背景下的蚁巢类型进行图像采集,图像数据分辨率为4 000×3 000,共采集到1 300张红火蚁蚁巢图像与100张地表图像,如图1所示。将图像分辨率压缩为480×640,加快算法遍历。使用Labelimg软件对图像进行标注,并将构建的蚁巢数据集按照8:1:1的比例分为训练集、验证集和测试集。

2 基于分量分割与YOLOv8的红火蚁蚁巢识别

2.1 红火蚁蚁巢的提取与除杂

HSV颜色模型的3个参数是:色相、饱和度、明度[18]。式(1)为RGB色彩空间转化到HSV色彩空间的转化公式,提取H分量后获得的图像中目标的凸显性较好[19]。经过研究蚁巢图像的各个分量图(图2)总结得出,蚁巢和背景在H分量上差别较大,因此选用蚁巢HSV图像的H通道进行目标的分割研究。

色相分割算法,是从H分量中提取阈值内像素点。设Hi为图像所对应的H分量,由式(2)可求得蚁巢区域H分量的平均分布 ,由此确定阈值Sh。设f (x,y)为图像像素对应的H分量的值,当 f (x,y) ∈ Sh时,将其灰度赋为255;当f (x,y) ? Sh时,将其灰度赋为0,如式(3):

式中,n为样本总数。

由蚁巢区域H分量的平均分布,可知其集中分布于342~27之间,如图3(a)所示。有针对性地将阈值设为338.8~15.5可取得较为理想的分离效果如图3(b)所示。此外,图像中不可避免地会存在阈值内的干擾像素,具有明显的噪声,直接影响图像分割的准确性。采用中值滤波的方法[20]对图像外围干扰像素进行剔除,消除图像在分割过程中的噪声,为后续的图像增强做好准备。

2.2 图像的增强

从空中检测蚁巢,不可避免地会在杂草遮挡的情况下获取图像,在色相分割二值图表现为蚁巢区存在线形黑色区域。需要对图像进行增强,减少杂草的遮挡影响。由于图像中某一区域的明度通常不会有较大变化[21],因此选用明度分割算法以消除杂草遮挡造成的区域缺失。

2.2.1 利用明度分割对图像进行增强

明度分割算法,是从V分量中提取阈值内像素点。设Vi为图像所对应的V分量,由式(4)可求得蚁巢区域V分量的平均分布 ,由此确定阈值Sv。为了将从图像中提取蚁巢,首先需要确定蚁巢区域的V值范围,由式(3)可求得测定组中所有蚁巢图像V分量的平均分布,如图4(a)所示。设 f (x,y)为图像像素对应的V分量的值,当 f (x,y) ∈ Sv时,将其灰度映射到[0,1];当 f (x,y) ? Sv时,将其灰度赋为0,如式(5):

式中,n为样本总数,ni为第i个灰度等级的像素总数,Ri为图像中所有像素点。

由图4(a)蚁巢区域V分量的平均分布可以发现,其V分量集中分布于0.55~0.84之间。有针对性地将阈值设为0.65~0.84可取得较为理想的分离效果,将明度分割二值图和色相分割二值图进行融合可以得到融合二值图,如图4(b)所示。

2.2.2 利用均值加权算法对图像进行增强

由于明度分割二值图蚁巢区域灰度等级较低,对蚁巢区域中线形黑色区域的填充效果不明显,需要继续对图像进行增强。李文娟等[22]提出了一种改进的加权均值算法。将其改进后可以取得较好的增强效果,其流程如下:

1)取相邻矩阵中所有像素的灰度中值。以图像的每一像素为中心,选取3×3大小的矩阵w,剔除矩阵内的最大灰度值和最小灰度值像素点,将剩余像素的集合记为H,即式(6),计算权值,先求出H内像素的均值Mean (H [ f (x,y)]),然后采用式(7)的方法计算H内各像素的对应权值:

式中,H为像素集合, 为各像素点的权值,k为像素点个数。

2)H内各像素点灰度值与其内像素点均值Mean (H [ f (x,y)])差的绝对值为Dk,即式(8):

3)将所有Dk的平均值,表示一个阙值T,采用阈值优化原则计算权值。即如果H内某像素的Dk大于阈值T,则权值由Dk决定,如果Dk小于值T,则权值由T决定,即式(9):

4)将H集合中的全部像素点与其相对应的权值进行加权运算,其结果作为矩阵W中心点的灰度值,有式(10):

有针对性地将权值设为 时增强效果最佳。此时蚁巢区域内部由杂草遮挡引起的缺失部分已被基本填满(图5)。

2.3 图像形态学处理

2.3.1 利用开运算进行去噪

原始图像在经过分割和增强后,图像细节得到了增强,蚁巢区域趋于完整。但是,由于存在干扰像素,图像仍然存在噪声。运用图像形态学运算进行图像去噪,并对图像进行进一步优化,增强图像细节。

腐蚀与膨胀运算为图像数学形态学处理的两个基本运算。腐蚀运算是一种消除边界点,使边界点向内部收缩的过程。常用于消除图像中一些小且意义不大的物体[23,24]。其定义如式(11):

式中,A为输入图像,B为结构元素。

膨胀运算就是将与物体接触所有背景合并到该物体中,使边界向外扩张的过程。因此,膨胀运算常用来填补物体中的空洞及消除目标物体中的小颗粒噪声。其定义如式(12):

对图像先腐蚀再膨胀称为开运算。由于干扰部分的像素较为分散,进行腐蚀处理即可消除大部分干扰像素。处理完毕后再进行膨胀使目标恢复之前的大小。开运算需要选定适当的阈值。如果阈值过小则无法消除泥土的干扰,如图6(d~f)所示;如果阈值过大会使蚁巢区域缩小严重,如图6(a~c)所示,导致无法识别面积较小的蚁巢。经过多次测试,把开运算阈值设定为30时,可将干扰面积降低。

2.3.2 利用闭运算进行复原

图像经过开运算处理后,蚁巢区域出现了部分缺失,且没有构成一个完整地连通域,对之后的识别存在干扰。对二值图像先膨胀再腐蚀为闭运算。闭运算可以去除目标内部的小孔或缺失。首闭运算也需要选定适当的阈值。如果阈值过小则缺失区域填充效果差,如图7(a~c)所示,如果阈值过大会使干扰对照组出现大面积连通域造成误判,如图7(d~f)。经过多次测试,把闭运算阈值设定为80时,可相对完整地复原蚁巢区域并构成连通域,同时不会在干扰对照组内形成大面积的连通域。

2.4 YOLOv8s模型

2.4.1 YOLOv8网络架构概述

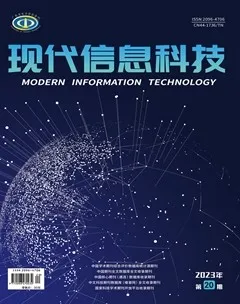

YOLOv8是YOLO系列最新的模型,如圖8所示。该网络模型主要包括4部分:输入(Input)、主干特征提取网络(Backbone)、头部(Head)和预测(Predict)。

Input由mosaic(数据加强)、图像自动裁剪拼接和自适应锚框组成,会对图像进行预处理,保证图像大小统一。

Backbone采用了CSPDarknet架构,由CBS(标准卷积层)、C2f模块和SPPF(金字塔池化)组成。通过5次标准卷积层和C2f模块逐步提取图像特征,并在网络末尾添加SPPF模块,将任意大小的输入图像转换成固定大小的特征向量。分别取P3、P4、P5层的特征提取结果,向Head输出80×80、40×40、20×20三个尺度的特征层。

C2f模块借鉴了残差网络(ResNet)以及ELAN[25]的思想,其结构分为两个分支,主干部分利用Bottleneckm[26]模块逐步加深网络,分支部分保留输入层通道并与主干部分特征进行融合,如图9所示。通过标准卷积层提取新的特征层,相比于YOLOv5使用的C3模块,C2f模块可以在卷积层和全连接层之间建立一个平滑的转换,从而实现了参数的共享,提高了模型的效率和泛化能力。

Head采用了PAN-FPN结构,将Backbone输入的3个特征层进行多尺度融合,进行自顶向下(FAN)和自底向上(PAN)的特征传递,对金字塔进行增强,使不同尺寸的特征图都包含强目标语义信息和强目标特征信息,保证了对不同尺寸样本的准确预测。

Detect借鉴了Decoupled-Head思想,用一个解耦检测头将输入的不同尺寸特征层分成2个分支进行检测。第1个分支在进行3次卷积后使进行回归任务,输出预测框。第2个分支在进行3次卷积后进行分类任务,输出类别的概率。采用Varifocal_Loss[27]作为损失函数,其式为:

式中,p为预测的IACS得分,q为目标IoU分数。α为样本权重,β为平衡因子,γ为一个可调节的参数。当γ = 0时,Varifocal_Loss等价于Focal_Loss损失函数;当γ>0时,会减小简单样本的权重,增加困难样本的权重,使得模型更加关注难以区分的样本。

YOLOv8使用Task_Aligned Assigner[28]匹配算法代替传统的IoU匹配算法。其使用Task_aligned head(T-head)和Task Alignment Learning(TAL)来解决分类和定位对不齐的问题。其中T-head由一个简单的特征提取器(式(15))和2个Task_aligned Predictors(TAP)构成。通过一个特征提取器来从卷积层中学习task_interactive特征以加强2个任务的交互。之后会把计算得到的task_interactive feature送入2个TAP来对齐分类和定位。

式中,convk和δ分别为第K个conv层和一个ReLU函数。

在TAP中,因为2个任务的注意点是不同的,因此会不可避免的引入2个任务的特征冲突,因此引入一个layer attention(式(16))机制来解决,通过动态计算task_specific的特征来进行任务的分解。最终,分类或定位的结果从每个xtask中得到。

式中,wk为学习层注意的第k个元素,fc2、fc1为2个全连接层、σ为一个sigmod函数,xinter为对Xinter使用平均池化得到的、ztask将会通过sigmod函数转换为得分。

最后TAL中使用分类得分和IoU的高阶组合来衡量task_alignment的程度,如式(17)。选取m个前t大的value作为正样本。为了精准的提升分类得分并减少误差,通过规范选取t并用一种简单的实例级规范化调整 的尺度,如式(18)。与此同时,使用Focal Loss损失函数缓解正负样本不平衡问题。因此,最终的损失函数如式(19):

式中,S、u分别为分类得分和IoU值,α和β分别为权重。

2.4.2 基于SK注意力的注意力机制替换

YOLOv8在目标检测中具有较快的速度和较高的精度,研究仅对红火蚁蚁巢的二值图像进行识别,无须对图像中黑色区域进行检测。另外,无人机搭载的嵌入式单片机还需要部署路径规划、数据回传等任务。对此,采用YOLOv8模型中最简单的YOLOv8s模型进行注意力机制的替换。

SK-Nets(Selective Kernel Networks)是Li Xiang[29]提出的一种通道注意力模块,旨在提高特征表示的表达能力,适用于图像分类和目标检测等任务。其核心思想是通过自适应选择卷积核大小和数量,从而实现空间维度和通道维度上的特征选择。SK注意力模块首先对特征图进行多组卷积,每组卷积使用不同大小的卷积核,但使其的卷积后的大小相同,得到不同的感受野。然后,对于每组卷积后的特征图,采用自适应门控机制对其进行选择,通过学习生成不同大小的通道注意力权重。这种权重能够自适应地选择不同的卷积核大小,并加权融合不同大小的特征响应,得到最终的特征表示。相较于其他的注意力机制,SK注意力模块具有计算量小、效果好,以及具有较强的自适应能力等优点。改进后的YOLOv8s网络结构如图10所示,训练该网络作为红火蚁蚁巢的识别模型。

图10中,kemel为对输入进行3×3、5×5的卷积,⊕为将2个特征图按元素求和,S和Z为特征图分别在H和W维度求平均值得到C×1×1的一维向量,a和b为对一维向量分别使用2次线性变换得到的C维信息,?是将得到权重应用到特征图上,component segmentation表示进行分量分割算法,CBS为Conv+BN+Silu激活函数组成的模块,用以对通道进行缩放和增加以增强通道的信息交互的模块,SPPF为空间金字塔池化。

3 结果与分析

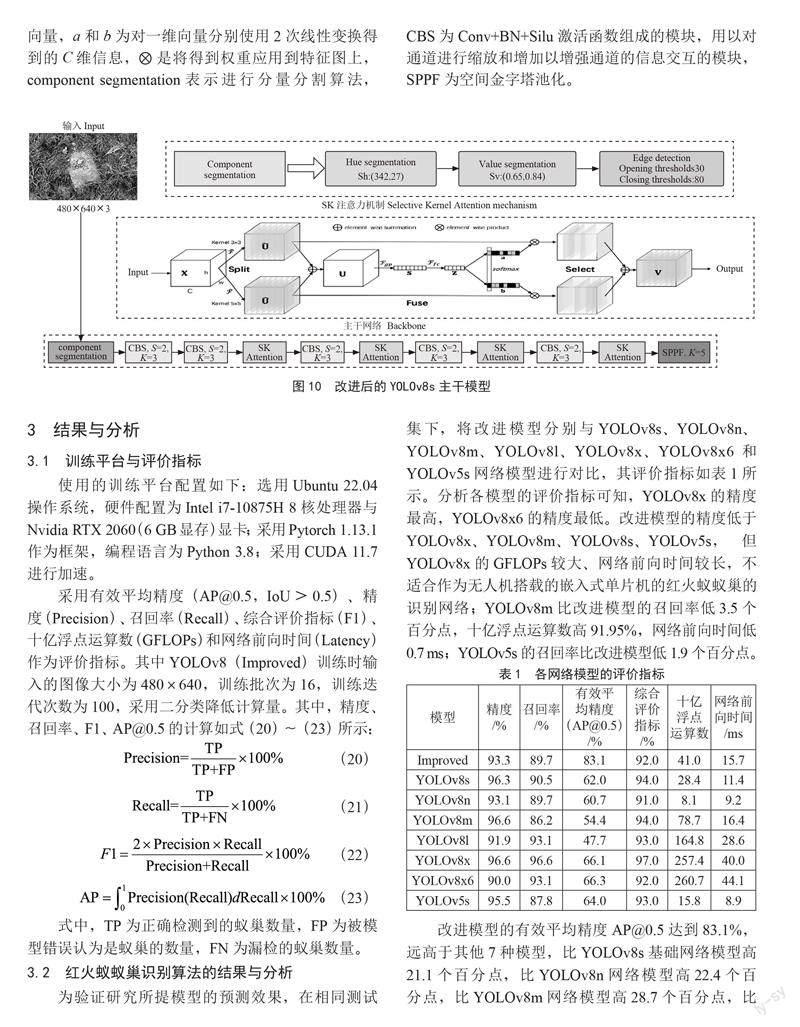

3.1 训练平台与评价指标

使用的训练平台配置如下:选用Ubuntu 22.04操作系统,硬件配置为Intel i7-10875H 8核处理器与Nvidia RTX 2060(6 GB显存)显卡;采用Pytorch 1.13.1作为框架,编程语言为Python 3.8;采用CUDA 11.7进行加速。

采用有效平均精度(AP@0.5,IoU>0.5)、精度(Precision)、召回率(Recall)、综合评价指标(F1)、十亿浮点运算数(GFLOPs)和网络前向时间(Latency)作为评价指标。其中YOLOv8(Improved)训练时输入的图像大小为480×640,训练批次为16,训练迭代次数为100,采用二分类降低计算量。其中,精度、召回率、F1、AP@0.5的计算如式(20)~(23)所示:

式中,TP为正确检测到的蚁巢数量,FP为被模型错误认为是蚁巢的数量,FN为漏检的蚁巢数量。

3.2 红火蚁蚁巢识别算法的结果与分析

为验证研究所提模型的预测效果,在相同测试集下,将改进模型分别与YOLOv8s、YOLOv8n、YOLOv8m、YOLOv8l、YOLOv8x、YOLOv8x6和YOLOv5s网络模型进行对比,其评价指标如表1所示。分析各模型的评价指标可知,YOLOv8x的精度最高,YOLOv8x6的精度最低。改进模型的精度低于YOLOv8x、YOLOv8m、YOLOv8s、YOLOv5s,但YOLOv8x的GFLOPs较大、网络前向时间较长,不适合作为无人机搭载的嵌入式单片机的红火蚁蚁巢的识别网络;YOLOv8m比改进模型的召回率低3.5个百分点,十亿浮点运算数高91.95%,网络前向时间低0.7 ms;YOLOv5s的召回率比改进模型低1.9个百分点。

改进模型的有效平均精度AP@0.5达到83.1%,远高于其他7种模型,比YOLOv8s基础网络模型高21.1个百分点,比YOLOv8n网络模型高22.4个百分点,比YOLOv8m网络模型高28.7个百分点,比YOLOv8l网络模型高35.4個百分点,比YOLOv8x网络模型高17.0个百分点,比YOLOv8x6网络模型高16.8个百分点,比YOLOv5s网络模型高19.1个百分点。改进模型的十亿浮点运算数和网络前向时间分别为41.0 GFLOPs和15.7 ms,可以在无人机搭载的嵌入式单片机中以较快的识别速度对红火蚁蚁巢进行精确识别。

此外,将改进模型与YOLOv8s基础网络模型的部分预测结果进行对比,如图11所示。若蚁巢区域内存在杂草干扰,YOLOv8s基础网络模型易对单个蚁巢产生重复预测,且存在置信度与IoU值较低等问题。改进模型在杂草干扰的场景中仍保持了较高的置信度和IoU值,且不会对产生重复预测。可见,改进的模型具有强鲁棒性。

3.3 光照条件下算法结果与分析

对被阳光照射的蚁巢区域进行色相分析,发现其色相平均分布集中于25.9~35.8。将色相分割阈值设置为338.8~35.8即可正常识别光照条件下的蚁巢。但泥土受到阳光照射后其色相平均分布于26.28~39.60,与蚁巢色相重叠度高。因此改进的模型在光照条件下误判率会提高。

3.4 草坪环境下算法结果与分析

为验证改进的模型在草坪环境下的适用性,研究于2023年1月中旬,在中山市石岐区大信海岸家园附近草坪,以同样的采集方式,对区域中共58个红火蚁蚁巢样本依次进行拍摄,草坪的地表特征基本一致,拍摄50张草坪地表图像。共拍摄224张图片。对草坪环境下的图像执行改进的模型,预测精度为97.5%,召回率为100%,有效平均精度为87.5%,网络前向时间为15.0 ms。证明其可以在草坪环境下预测。草坪蚁巢会因阳光照射导致其色相的改变,但改变后的色相不与杂草色相重合。因此,在保证草坪内没有泥土干扰的情况下,可以将色相阈值设置为338.8~35.8进行识别。

4 结 论

研究针对无人机在空中对蚁巢的场景,提出了一种基于分量分割与YOLOv8s的红火蚁蚁巢识别模型,经过多种应用场景的验证,结论如下:

1)提出的改进YOLOv8s模型预测精度为93.3%,召回率为89.7%,有效平均精度为83.1%,综合评价指标为92.0%,网络前向时间为15.7 ms,模型十亿浮点运算数为41.0 GFLOPs,可以在有较多干扰的场景中以较快的速度准确识别红火蚁蚁巢。

2)相较朱立学等提出的利用超绿模型进行分割的算法只能识别草坪蚁巢的局限性,改进的模型利用分量分割消除了杂草、泥土等干扰,适用范围广。

3)相较于吴伟斌等提出的利用H = 30作为阈值区分普通土和蚁巢土方法,研究精确了多种情况下蚁巢土的色相范围:不被阳光照射的情况下为:342~27;受到阳光照射的情况下为:25.9~35.8;同时发现阳光照射会将泥土的色相范围为26.28~39.60。为后人的研究提供了数据参考。

4)研究存在一定局限性,对红火蚁蚁巢数据集的采集仍需人工踏查,存在潜在危险。对数据集的标注也需要大量时间。今后将尝试用无人机搭载改进的模型,实现蚁巢定位无人化,保障群众的健康生活与农业的安全生产。

参考文献:

[1] 王磊,陈科伟,冯晓东,等.我国大陆红火蚁入侵扩张趋势长期预测 [J].环境昆虫学报,2022,44(2):339-344.

[2] 陆永跃,曾玲,许益镌,等.外来物种红火蚁入侵生物学与防控研究进展 [J].华南农业大学学报,2019,40(5):149-160.

[3] 陈浩涛.我国红火蚁主要行为特征、抗寒能力及发生风险分析的研究 [D].北京:中国农业科学院,2010.

[4] 陈晓娟,余德才,边露.外来入侵物种红火蚁的危害及防控技术 [J].四川农业科技,2022(9):44-46.

[5] 吴伟斌,游展辉,洪添胜,等.基于计算机视觉技术的红火蚁蚁巢探测 [J].河南农业大学学报,2017,51(2):184-188.

[6] 朱立学,黄培峰,黄伟锋,等.基于图像处理技术的红火蚁检测识别 [J].农业工程学报,2022,38(11):344-350.

[7] 刘源,夏春蕾.一种基于Sobel算子的带钢表面缺陷图像边缘检测算法 [J].电子测量技术,2021,44(3):138-143.

[8] 孙少林,马志强,汤伟.灰度图像二值化算法研究 [J].价值工程,2010,29(5):142-143.

[9] 丁震,胡钟山,杨静宇,唐振民.FCM算法用于灰度图象分割的研究 [J].电子学报,1997(5).

[10] 夏亚飞.基于K均值聚类和二维Otsu的棉花HSV图像分割 [J].软件,2020,41(7):170-173.

[11] 张国权,李战明,李向伟,等.HSV空间中彩色图像分割研究 [J].计算机工程与应用,2010,46(26):179-181.

[12] 张海波,董槐林,龙飞,等.基于BP神经网络的图像识别研究 [J].计算机与现代化,2008(5):17-19.

[13] 王业,崔玉,陆兆沿,等.基于CNN图像识别算法的保护装置智能巡视技术 [J].电力工程技术,2022,41(6):252-257.

[14] 魏甫豫,张振宇,梁桂珍.基于卷积神经网络下昆虫种类图像识别应用研究 [J].河南师范大学学报:自然科学版,2022,50(6):96-105.

[15] 谢椿辉,吴金明,徐怀宇.改进YOLOv5的无人机影像小目标检测算法 [J].计算机工程与应用,2023,59(9):198-206.

[16] 雷荣智,杨维芳,苏小宁.基于改进YOLO-v3的无人机遥感图像农村地物分类 [J].电子设计工程,2023,31(3):178-184.

[17] 馬宏兴,张淼,董凯兵,等.基于改进YOLO v5的宁夏草原蝗虫识别模型研究 [J].农业机械学报,2022,53(11):270-279.

[18] 刘鹏宇.基于内容的图像特征提取算法的研究 [D].长春:吉林大学,2004.

[19] 许雪梅,黄征宇,李丽娴,等.一种基于HSV颜色分割和模糊级联分类器的人脸检测技术 [J].计算机应用与软件,2014,31(4):197-200+238.

[20] 杨雷,唐瑞尹,王兴朝.中值滤波在噪声图像匹配中的应用 [J].现代计算机,2021(17):135-139.

[21] 姚凯凯.不同光照环境下图像融合及图像转换算法的研究 [D].重庆:重庆邮电大学,2020.

[22] 李文娟,陈军,张永刚,等.基于改进加权均值滤波的医学影像图像除噪研究 [J].辽宁大学学报:自然科学版,2022,49(1):30-35.

[23] 高薪,胡月,杜威,等.腐蚀膨胀算法对灰度图像去噪的应用 [J].北京印刷学院学报,2014,22(4):63-65.

[24] 秦志新.计算机技术在图像形态学处理中的应用探讨 [J].普洱学院学报,2019,35(6):24-26.

[25] ZHANG X D,ZENG H,GUO S,et al. Efficient Long-Range Attention Network for Image Super-Resolution [C]//Computer Vision–ECCV 2022.Tel Aviv:Springer,2022:649-667.

[26] MUHAMMAD S,GU Z Q. Deep Residual Learning for Image Recognition: A Survey [J/OL].Applied Sciences,2022,12(18):[2023-02-10].https://doi.org/10.3390/app12188972.

[27] ZHANG H Y,WANG Y,DAYOUB F,et al. VarifocalNet: An IoU-aware Dense Object Detector [C]//2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Nashville:IEEE,2021:8510-8519.

[28] FENG C J,ZHONG Y J,GAO Y,et al. TOOD: Task-aligned One-stage Object Detection [C]//2021 IEEE/CVF International Conference on Computer Vision(ICCV).Montreal:IEEE,2021:3490-3499.

[29] LI X,WANG W H,HU X L. Selective Kernel Networks [C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Long Beach:IEEE,2019:510-519.

作者簡介:张泽骏(2002—),男,汉族,广东中山人,本科在读,主要研究方向:图像处理与机器人;通讯作者:林钦永(1987—),男,汉族,广东陆丰人,副教授,博士,主要研究方向:图像处理、人工智能与机器人研究。

收稿日期:2023-03-20

基金项目:国家自然科学基金(62003379);广东省高等教育教学研究和改革项目(2020-296);广东省普通高校重点领域专项项目(2021ZDZX4061);广州市基础与应用基础研究项目(202201011274);广东省本科高校在线开放课程项目(2022ZXKC237);兴宁市肉鸽产业园技术研发项目(2021102418)