算力时代数据中心新型末端弹性扩容解决方案研究与实践

2023-01-31韩冰

韩 冰

(吉林吉大通信设计院股份有限公司,吉林 长春 130012)

0 引 言

算力网络(Computing Force Network,CFN)是以算为中心、网为根基,通过网、云、数、智、安、边、端、链等深度融合提供一体化服务的新型信息基础设施[1]。算力网络提出后,对新基建的要求越来越高,其中对数据中心的基础设施从单机柜功率密度、安全可靠性、绿色低碳等方面提出了更高的要求。算力网络发展的业务需求对于已建成并启用的数据中心来讲,迫切需要制定不同场景下有效且合理的弹性扩容方案,既要满足超出规划的更高单机柜功率密度的需求,又需要满足装机数量需求,确保安全可靠运行,同时实现绿色低碳运营,为提升算力算效贡献一份力量[2]。

1 算力网络背景下的建设需求

算力网络时代,随着新型数据中心算力布局优化、网络提升等,提出了更高的功率密度、网络安全、绿色低碳等要求。单机柜功耗激增,对于已建设好的数据中心来讲,在制冷系统管路容量、新型空调末端的制冷能力以及装机率等方面面临着极大的挑战[3]。

随着云业务的持续发展,人们建设了越来越多的高功耗机柜,实施适合高功耗机柜发展的制冷方案十分必要。以某云在A数据中心的高功耗大规模机柜建设为案,阐述不同场景下的弹性扩容研究及实践方案。具体建设中,满足某云7 kW单机柜的制冷需求,资源池机柜数量不少于700个,同时新型空调末端电源使用效率(Power Usage Effectiveness,PUE)满足0.045~ 0.1。

2 已建数据中心机房现状

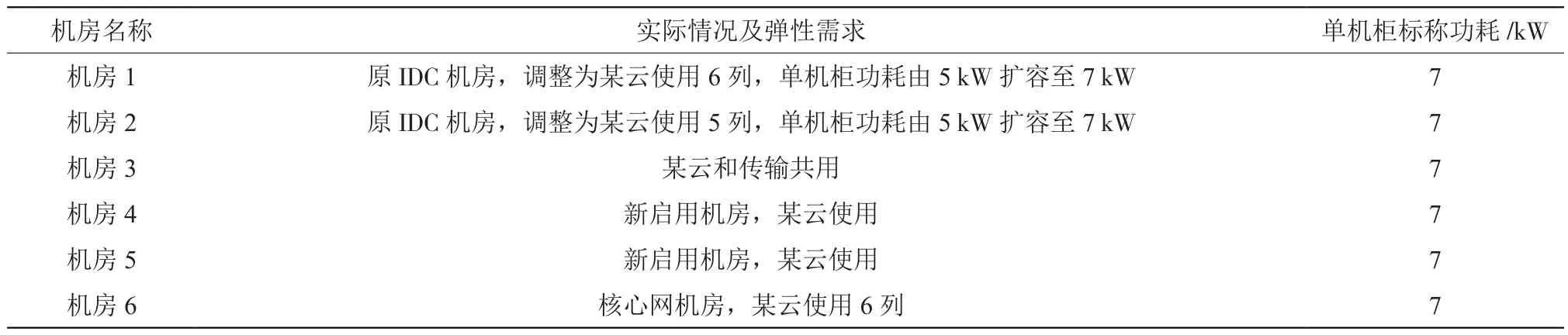

A数据中心仅6个机房可供工程使用,按5 kW机柜建成两个机房(机房1、机房2)、按7 kW机柜建成1个机房(机房6)直接使用。其他3个机房为未建设机房,本次新启用。由于A数据中心传输机房机柜资源不足,其中1个未建设机房需有一半划给传输专业使用,作为某云与传输共用的综合机房(机房3)。另外两个可以作为某云专用机房(机房4、机房5),按7 kW机柜建设。实际情况及弹性需求如表1所示。

表1 已建数据中心机房现状

3 新型末端可选形式

3.1 热管背板空调

热管背板末端中的液态制冷剂吸收了热空气的热量后,沸腾并转化成蒸汽状态,其在自身压差的作用下被输送至机房外的水冷冷凝器中,并在水冷冷凝器中重新被冷却成液态制冷剂,然后回流至热管背板末端中[4]。借助工质相变直接吸收机架中服务器设备发出的热量,提高制冷效率。热管末端工作原理如图1所示。

图1 热管末端工作原理

该方式为机架级制冷,根据机柜数量及功耗配置,适合逐步启用的场景。水不进入机房,安全性高。在机柜内服务器风机和热管背板末端风机产生的吸引力作用下,机房内的循环空气通过机柜的开孔前门进入机柜并流经服务器设备,循环空气被正在运行的服务器设备加热后温度升高成为热空气排出[5]。热空气从服务器设备排出后,被吸入热管背板末端。热空气在流经热管背板末端时,热量被末端中的液态制冷剂吸收,成为冷空气后进入机房环境,降低机房温度。热管背板现场应用案例如图2所示。

图2 热管背板现场应用案例

3.2 冷冻水列间空调+封闭通道

列间空调和机柜间隔布置,空调前部出风,水平吹向两侧机柜,经过机柜前门并对设备制冷后,经机柜后门再回风到空调后部。气体输送距离短,风机功率小。采用封闭冷通道措施,优化气流组织,减少混风损失。机柜冷通道封闭,由于冷热通道的气流互相分隔,因此冷量得到有效管理,避免了气流短路,提高机房系统的制冷效率,温度场分布均匀。水进入列间,通过防水围堰和泄水槽解决防水、漏水问题。此外,冷冻水列间新型末端空调PUE为0.04。

3.3 热管列间空调+封闭通道

列间空调和机柜间隔布置,空调前部出风,水平吹向两侧机柜。实施过程中水不进入机房,机房空调末端仅作为冷媒管连接至走廊侧水冷冷凝器,适用于现网改造扩容,对机房现网的影响最小。

3.4 冷冻水房间级空调

采用架空地板下送风、上回风的气流组织形式,机房内机柜按照冷热通道分隔的方式布置。结合封闭冷通道,冷冻水型空调PUE为0.1,适用于单机柜功耗小于5 kW、特殊气流组织或非标机柜机房使用。

4 新型末端弹力扩容方案

根据各机房的不同现状,综合考虑各种新型空调末端的适用场景及特点,分别选择适宜的新型空调末端建设方式。

4.1 已启用机房弹性扩容方案

机房1和机房2为已启用机房,已建冷冻水列间空调保留,均按照单机柜5 kW设计的制冷管路及空调末端。如果改为某云使用的机柜,需要弹性扩容为单机柜7 kW,并补充冷量。考虑到若按原形式扩容冷冻水列间空调,需要在现有管路上进行增开支管、焊接、增设阀门等操作,且原管路承载冷量有限。综合考虑对现网的施工影响最小化,增容的空调选择热管列间,为某云高密度服务器提供超大散热量的冷量补充,提高单机柜运行功耗。

4.2 多专业共用机房弹性扩容方案

机房3功能定位为某云及传输共用机房,由于传输设备为特殊气流组织的非标机柜,暂时无法选用新型末端空调,因此为该机房定制了分区域的制冷方案。受走廊空间等因素的限制无法选用热管背板,选择冷冻水列间空调+封闭通道的形式,传输区域采用房间级空调架空地板下送风形式。为了避免气流组织紊乱,设置光纤配线架(Optical Distribution Frame,ODF)无源设备作为两类设备区域的分隔。

4.3 新启用机房弹性扩容方案

本着机柜数即装机率最大的原则,对机房4进行冷冻水列间空调及热管背板两种方案详细的配置及比选。选择热管背板方案时,需要255个机柜和13个列头柜,PUE为0.037。选择冷冻水列间方案时,需要212个机柜和13个列头柜,PUE为0.04。综合考虑各方面因素,结合机房4的走廊侧空间及管道资源条件,某云选用7 kW定制冷量热管背板空调。

对于机房5,由于机房外侧走廊空间及管道条件受限,无法实施热管背板空调系统,因此选择冷冻水列间空调+封闭热通道方案。

4.4 最佳方案实践

3类典型机房场景均通过方案比选,选择适宜各自情况的最优弹性扩容方案。

已启用机房弹性扩容方案:机房1、机房2现网扩容空调采用热管列间空调。

多专业共用机房弹性扩容方案:机房3选择列间空调方案,传输区域采用房间级空调架空地板下送风形式,要求地板架空净高700~800 mm。

新启用机房弹性扩容方案:对于机房走廊侧能够满足热管空调水冷冷凝器安装空间和条件的机房4,为提升装机率,满足未来装机需求,选择热管背板空调。对于机房走廊侧不能满足热管空调水冷冷凝器安装空间和条件的机房5,采用冷冻水列间空调+封闭热通道。

5 实施效果

通过方案实施,满足某云不少于700个机柜的高装机率要求和机柜服务器散热原则。选取满足安装条件的新建机房,通过详细的方案对比后选择热管背板空调末端形式,较列间空调形式多装机1/5,共计节省机柜建设造价约680万元。

某云与传输共用机房采用房间级空调与列间空调共存形式,兼顾传输装机要求,增设架空地板挡风措施,避免气流组织紊乱。冷冻水列间与热管列间同机房改造,将现网已建成的5 kW机柜弹性扩容为7 kW。为降低现网施工影响,增容的空调选择热管列间形式,提高现网管路及空调的制冷效果,作为某云高密度服务器超大散热量的冷量补充,提高机房使用弹性。此外,新型空调末端实现机架级、行级就近制冷,制冷效率高,PUE达到0.037,真正实现节能降碳。

6 结 论

数据中心大型水冷系统中,冷源容量及配置可采用近远期相结合的方式建设,初期可建设大容量、少数量,预留远期扩容空间。走廊内主干管路需要留出足够安装水冷冷凝器的空间,避免成为选用热管背板空调提升装机率的阻碍。对于管道井、走廊或机房内的主干管以及空调末端分支管路,均采用放大规格设计,避免成为扩容的瓶颈。由于空调末端建设为一步到位,无法像供电系统设备一样轻松扩容,因此通常不考虑同时系数和需要系数。在不断完善和深化算力能力布局优化的同时,对制冷系统提出了高可靠性、高弹性的要求。既有数据中心由已建设的低功率密度布局转向高功率密度布局优化,更好地应对算力时代下单机柜功耗及装机量的变化。