一种无人机地理视频影像实时拼接方法

2022-12-30王鹏生刘排英贺少帅

王鹏生 ,刘排英 ,贺少帅 ,孙 亮

(1.石家庄铁路职业技术学院,河北 石家庄 050041;2.航天空气动力技术研究院,北京 100074)

0 引言

无人机(Unmanned Aerial Vehicle,UAV)地理视频(GeoVideo)是一种融合有时间、位置和姿态等信息的新型视频数据,其概念最早由韩国学者Kim等[1]提出,地理视频的重要特征就是每一视频帧都包含该帧获取时刻的传感器位置、姿态和时间等信息,与常规视频相比,其不仅能够真实表达地理空间场景,还能实现视频的空间定位分析,在应急测绘、城市监控等领域更能发挥应用价值[2]。由于视频帧幅较小、分辨率低(1 080P,1 920 pixel×1 080 pixel),在实际应用中需要进行拼接处理,目前无人机遥感影像拼接技术较为成熟,基于Structure from Motion(SfM)的国外开源算法OpenMVG[3],OpenDroneMap,VisualSFM[4]以及商业软件PhotoScan,Pix4DMapper等,针对小像幅、非量测相机数据均有较好的拼接效果;Zhang等[5]开源的大尺度运动恢复系统ENFT-SfM可对整个场景的三维结构和相机参数进行全局优化,快速获取视频帧位姿信息及三维稀疏点云,为整体拼接提供精确外方位元素;国产摄影测量软件如DPGrid,PixelGrid,GodWork等也能达到很好的拼接效果。然而上述算法或软件均采用全局拼接策略,需要获取全部影像一次性输入进行处理,并不能满足实时性要求较高的应用需求。得益于无线传输技术的发展,大数据量的无人机视频实时回传已不再是难题,这就为无人机视频数据的实时拼接提供了可能,不少学者对无人机遥感影像的实时拼接进行了研究,并取得了一定的成果。文献[6]提出了一种近实时的视频影像拼接方法,用改进的Oriented FAST and Rotated BRIEF(ORB)算法完成了视频影像特征提取与匹配,但并未实现多航带的拼接;文献[7]提出了一种无需地面控制点的遥感图像实时几何校正方法,但文中并未给出采用SIFT特征匹配算法的耗时说明,其实时性有待验证;文献[8]首先利用方向快速旋转特征描述具有重叠区域的全局图像,接着采用基于网格的运动统计方法获取鲁棒性较好的匹配关系,进而得到变换矩阵而后开展实时拼接,但只是利用计算机仿真实验验证了该算法的性能,并未实际应用;文献[9]采用延时性更低的基于滑动窗口的光束平差方法来优化相机的外方位元素,再用优化后的外方位元素对视频帧进行正射纠正处理,最后对正射影像进行拼接融合,该方法虽然提高了拼接的时效性,但拼接效果较为一般。随着计算机视觉技术的发展,同时定位与建图(Simultaneous Localization and Mapping,SLAM)技术在实时三维重建与自动驾驶领域被广泛关注,与SfM相比,实时性是其最大特点,不少研究者已将SLAM技术应用于实时全景图的生成[10],但通过试验发现,在无人机视频影像实时拼接过程中很容易出现特征跟踪失败导致定位丢失的问题,虽然视觉-惯性导航融合的SLAM方案可以有效解决定位丢失问题,但其系统和算法也更为复杂,在无人机遥感影像实时拼接应用中并不常见。

为了满足应急测绘、动态监测等领域对无人机视频数据快速处理的需求,提出了一种无人机地理视频影像实时拼接方法。首先,采用基于时间标识索引的线性拟合方法对实时下传的地理视频进行处理,建立每帧视频影像与地理信息的映射关系;接着,依据视频帧坐标信息实时提取满足航向重叠度要求的视频关键帧,并结合外方位元素及高程信息对关键帧进行正射纠正处理,实现关键帧粗略地理编码;通过地理编码后视频帧坐标在卫星或航空正射影像图上查找相同范围,采用ORB算法开展特征匹配获取原始视频帧与基准影像的空间变换关系,利用多项式几何纠正方法实现视频帧坐标变换,从而实现以卫星或航空正射影像图为基准的视频帧实时几何纠正,最后采用加权平均融合法消除视频帧拼接缝,形成一整幅影像。

1 地理视频影像实时拼接

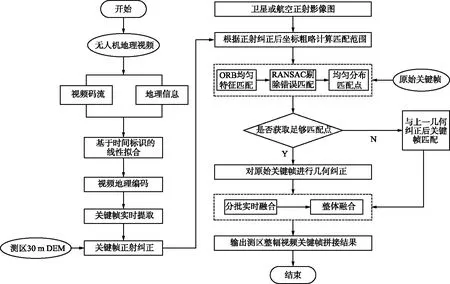

无人机采集的视频数据与遥控遥测数据通过通信链路系统实时回传地面,地面接收装置通过数据包帧头标识符以及帧长度分别提取视频码流与遥控遥测数据,并记录其时间标识,接着便可对地理视频进行实时拼接处理,具体流程如图1所示。

图1 地理视频影像实时拼接流程Fig.1 Flow chart of real-time mosaic for geographic video frames

首先在地理视频数据实时解析过程中,将每条定位定姿(Position and Orientation System,POS)数据两两建立以时间为变量的插值函数,视频帧依据时间标识索引对应的插值函数进行内插获取其对应的POS数据,完成视频地理编码;同时依据视频帧POS数据实时计算相邻视频帧重叠度,进而筛选出满足重叠度要求的视频关键帧并借助测区30 m DEM对关键帧进行正射纠正,获取关键帧粗略地理坐标;根据关键帧地理坐标计算基准影像匹配范围以减少无效特征点提取,接着原始关键帧与基准影像进行ORB均匀特征匹配,并采用RANSAC(Random Sample Consensus)算法剔除错误匹配,获取均匀分布的匹配点,若匹配点足够多,则对原始关键帧进行几何纠正,否则与上一关键帧匹配后再进行几何纠正;最后采用分批实时融合再整体融合的策略,实现整幅视频关键帧的拼接。

1.1 视频地理编码

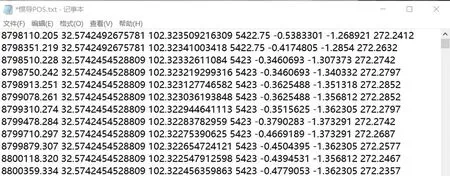

视频是由一系列连续的帧图像组成,常见的视频传感器帧率为30,50,60帧/秒等,本文实验所用视频帧率为30帧/秒,即一秒视频有30帧图像,而惯性导航设备的频率一般为2~10 Hz,虽然视频流与POS数据同一时刻实时回传,但由于频率不同而造成视频帧很难找到对应的POS数据[11]。为了解决上述问题,本文采用基于时间标识索引的线性拟合方法实现视频帧与POS数据一一对应。POS数据主要包括时间(以ms为单位)、纬度、经度、海拔高、滚转角、俯仰角和航向角,如图2所示,分别以时间为自变量,纬度、经度、海拔高、滚转角、俯仰角和航向角为因变量建立线性拟合方程,由于惯导姿态角具有取值范围,在插值过程中需根据实际范围进行取值。

图2 惯导POS数据示例Fig.2 Example of inertial navigation POS data

视频流在解码过程中每帧影像均有时间标识,依据该标识索引拟合方程,带入方程求出视频帧对应的POS数据,实现视频帧与POS数据的一一映射。由于只涉及简单的数学运算,在地理视频数据实时下传解析过程即可同步完成视频地理编码。

1.2 关键帧实时提取

视频流包含大量的冗余数据,在拼接过程中并不需要所有的视频帧都参与,快速挑选出满足重叠度要求的关键帧是实现实时拼接的关键点之一。无人机航空摄影测量一般要求航向重叠度为70%~85%,旁向重叠度为35%~55%,逐帧计算重叠度的方法虽然可以精确获取满足重叠度要求的关键帧,但不适用于实时性要求较高的场景[12]。本文提出了一种基于视频地理编码数据的关键帧实时提取方法,该方法依据设计航高、视频传感器参数和视频帧POS数据实时计算视频帧重叠度,筛选满足要求的视频帧作为关键帧。算法如下:

首先将视频帧经纬度坐标转换为高斯投影坐标,假设初始关键帧与待求关键帧之间的地面距离L为:

(1)

再根据摄影比例尺公式求出地面分辨率GSD:

(2)

视频帧航向方向地面距离S为:

S=GSD×W,

(3)

则航向重叠度p为:

(4)

式中,X1,Y1为初始关键帧坐标;Xi,Yi为待求关键帧坐标;f为传感器焦距;H为设计航高;μ为传感器像元物理尺寸;W为视频帧航向方向像素个数。由上述公式可知,初始关键帧与待求关键帧之间的距离L可由预设航向重叠度与视频帧航向地面距离计算得出,即视频帧i在满足L的一定阈值范围内可作为关键帧。

在实际应用中实时计算视频帧间的地面距离,挑选出距离阈值范围内的视频帧作为下一关键帧,依次完成所有关键帧的提取。

1.3 关键帧正射纠正

通过正射纠正处理可以获取关键帧粗略的地面覆盖范围,便于确定与基准影像的匹配区域,缩短匹配时间。在正射纠正前需将关键帧POS数据姿态信息转换为外方位角元素,转换方法采用文献[13]提出的公式:

(5)

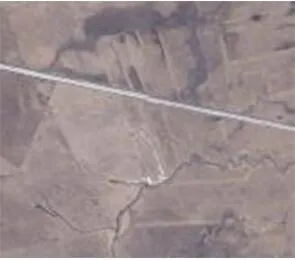

正射纠正采用间接法数字微分纠正算法实现,地形数据来源于全国30 m高程数据,纠正效果如图3所示。

(a) 原图

(b) 正射纠正图图3 视频帧正射纠正效果Fig.3 Effect of video frame orthorectification

1.4 基于ORB的图像特征匹配

1.4.1 ORB特征提取与匹配

图像特征匹配算法常用的有尺度不变特征转换(Scale-Invariant Feature Transform,SIFT),加速稳健特征(Speeded-Up Robust Features,SURF)和ORB等。其中SIFT最为经典,它充分考虑了图像变换过程中的尺度、光照和旋转等影响,但其计算量也极大,而ORB特征匹配改进了FAST检测子不具方向性的问题,并采用计算速度极快的二进制描述子BRIEF,适当降低了精度和鲁棒性以提升计算速度,是性能与质量之间较好的折中。由于考虑了旋转和缩放,ORB在平移、缩放和旋转的场景下仍有很好的表现[14],因此针对视频帧实时拼接需求,ORB特征匹配算法是目前最好的选择,文献[15]在同一运算环境下提取同一幅图像1 000个特征点,ORB耗时15.3 ms,SURF耗时217.3 ms,SIFT则耗时5 228.7 ms。虽然ORB特征匹配算法能满足实时拼接需求,但其提取的特征点存在分布不均匀、重叠较多等问题,这将会直接影响视频帧纠正精度。为了改善上述问题,采用基于四叉树的FAST角点均匀提取策略[16]优化提取效果,其思想如下:

① 首先对原始图像进行边缘补齐,使其能够满足整数划分正方形格网;

② 将补齐后的图像进行30 pixel×30 pixel的网格划分;

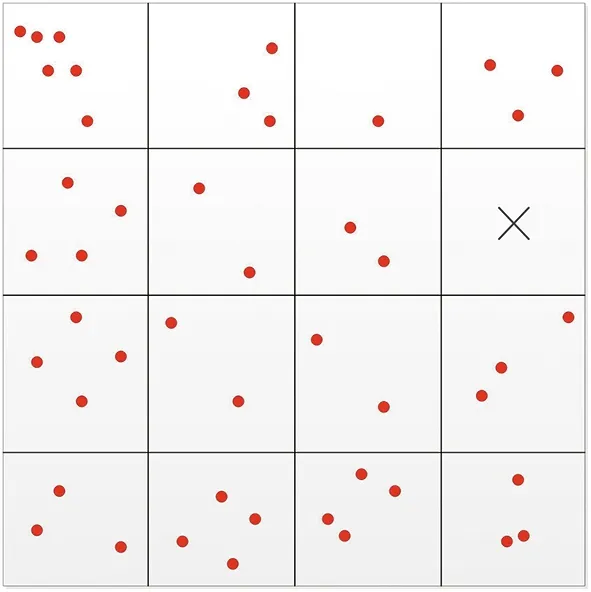

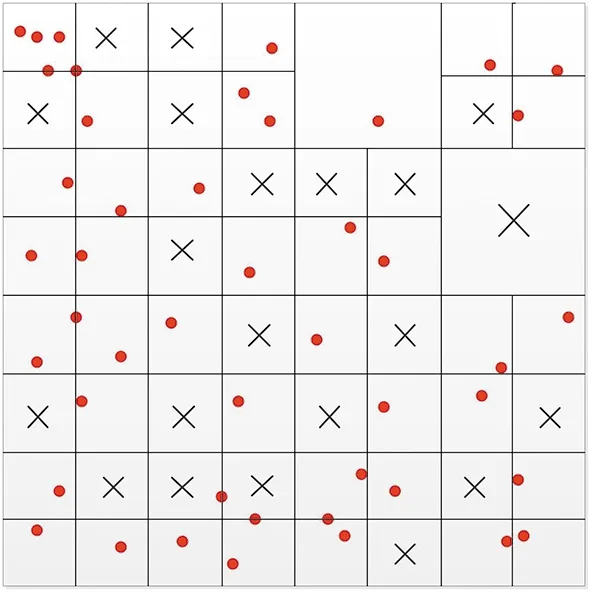

③ 每个网格中利用原始阈值和最小阈值提取满足阈值的FAST特征点,如果采用最小阈值也提取不到角点,则放弃该网格以避免提取到质量特别差的角点,示例图如图4所示。

图4 提取图像每个格网内的FAST特征点Fig.4 FAST feature points extracted within each grid of the image

④ 在网格中再使用四叉树均匀选取FAST角点,即每个网格先均匀分裂为4个节点,根据角点数目,再将每个节点继续4分裂,直到每个小节点中只有一个质量最好的角点,示例图如图5所示。

图5 FAST特征点在四叉树节点中的分布Fig.5 Distribution of FAST feature points in quadtree nodes

1.4.2 基于RANSAC的误匹配点剔除

在特征匹配过程中往往会存在误匹配信息,为了消除误匹配点,通常采用随机采样一致性RANSAC算法[17],其核心思想是从一组包含错点的观测数据集中,通过不断迭代方式寻找最优数学模型的参数。航空影像可以近似看作平面场景,因此可以使用单应矩阵H描述2幅影像之间的变换关系,那么2幅影像同名特征点(x,y)与(x′,y′)的对应关系为:

(6)

要想求出单应矩阵H的8个元素,至少需要8个方程,即4对匹配点,RANSAC的计算过程为:首先从匹配点集合P中随机选取4对匹配点计算单应矩阵H,再计算P中剩余点与H矩阵运算后的投影差,超出阈值的定义为局外点,不超出的定义为局内点,记录该矩阵对应的所有局内点数目m,反复迭代选择m最大的那个单应矩阵作为最优模型,并剔除对应的局外点。在编程实现时为了减少运算量并不是所有集合内的点全部迭代,而是只需保证至少有一次选取的4个匹配点都是局内点的概率足够高即可,本文将此概率设置为0.95。为了降低误匹配的可能性,视频帧在与基准影像匹配前,需要根据传感器畸变参数对视频帧进行畸变差改正处理。

在获取较好的匹配结果后,即可根据同名匹配点建立视频帧与基准影像之间的空间变换关系,本文采用几何多项式模型描述这种变换关系,多项式次数T与同名点数量n的关系为n=(T+1)×(T+2)/2,因此采用二次多项式模型至少需要6对匹配点,若关键帧与基准影像匹配点小于6个,则该帧关键帧会与上一关键帧进行匹配。几何纠正后的关键帧将带有精确的地理坐标,可用于后续的拼接处理。

1.4.3 异源光学遥感影像匹配

本文所用基准影像为卫星或航空正射影像图,虽然都是光学遥感影像,但异源遥感影像的匹配相对于同源遥感影像来说更加复杂,主要是二者成像机理不同、时相或分辨率存在较大差异,导致自动匹配难以实现[18]。本文并未对异源光学遥感影像匹配算法做深入研究,而是通过相关实验总结视频帧实时拼接所用基准影像规律,进而对本文算法的实际应用提供参考借鉴。通过视频关键帧与不同分辨率的航空、卫星正射影像图匹配,分析异源遥感影像匹配与分辨率之间的关系,如表1所示,其中实验所用无人机视频为2018年3月获取,分辨率为0.5 m,卫星影像为2017年4月天地图数据,分辨率为0.59 m,航空影像为2019年11月获取的0.01 m分辨率的正射影像。

从表1可以看出,视频帧与航空正射影像图的匹配效果整体优于卫星正射影像图,主要原因是视频传感器与相机成像机理较为接近。无论是卫星或航空正射影像,其分辨率与视频帧分辨率相差不多时,匹配效果较好,卫星影像在分辨率倍数相差20倍时效果较差,航空影像在分辨率倍数相差20倍以上时效果较差,因此本文推荐基准影像采用时相接近且分辨率相差10倍以内的航空正射影像或分辨率相差4倍以内的卫星正射影像图。

表1 无人机视频影像与卫星、航空正射影像匹配实验结果Tab.1 Matching experiment results of UAV video frames with satellite and aerial orthophotos

1.5 视频帧实时融合

在完成视频关键帧的几何多项式纠正后,即可基于地理坐标对关键帧进行融合处理,生成一整幅影像。常用的图像融合方法包括加权平均法、渐入渐出法、小波变换法和金字塔分解法等,由于视频帧覆盖范围较小且色彩均匀,为了满足实时融合需求,采用运算速度较快的加权平均融合方法对关键帧进行融合:

(7)

式中,f(x,y)为融合后关键帧像素值;f1(x,y),f2(x,y)分别为左右2帧待融合关键帧像素值;w1,w2为加权值,w1∈(0,1),w2∈(0,1),且w1+w2=1,本文加权值均取0.5。实验效果如图6所示。从图6中可以看出,加权平均融合方法可以很好地消除拼接缝,实现视频帧间的平滑过度。

(a) 直接叠加效果

(b) 融合效果图6 视频帧融合效果Fig.6 Effect of video frames fusion

关键帧实时融合的常规思路是每处理一帧就与前面所有已经融合后的影像融合,但随着影像的增多,这种方法运算速度会越来越慢,为了满足实时融合的需求,采取分批融合策略,每次只融合10帧,接着以新的一帧作为起始帧继续融合,分批融合后的影像在新的线程中再次融合,2个线程同时进行保证关键帧融合的时效性。

2 试验与分析

2.1 试验数据与环境

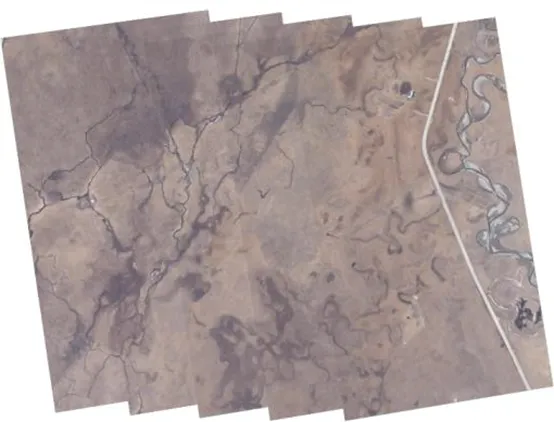

本文采用2019年11月在四川红原县附近获取的无人机视频数据作为试验数据,视频数据由彩虹4型无人机搭载光电吊舱获取,分辨率为1 920 pixel×1 080 pixel,地面分辨率为0.62 m,分为3条航带,面积约为12 km2;卫星正射影像图采用天地图Level_18级影像,数据获取时间为2016年,分辨率为0.59 m;航空正射影像图为2018年10月获取,分辨率为0.5 m。

试验环境是Windows10 64位系统,硬件配置为Intel Xeon CPU E5-1643 v4@3.40 GHz,内存为32 GB。

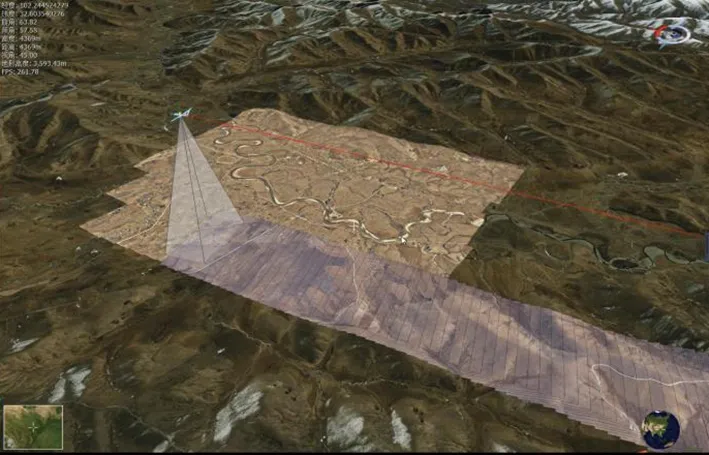

2.2 试验结果与分析

在试验过程中,将上述算法与三维地理信息场景进行集成,试验结果如图7所示。图7中,飞机为彩虹4型无人机模型,大场景底图为天地图影像,矩形底图为航空正射影像图,条带状为无人机视频实时处理结果。

图7 无人机地理视频影像实时拼接界面Fig.7 Real-time mosaic interface of UAV geographic video frames

(1) 基于卫星正射影像图的视频帧拼接

采用上述方法实现的基于卫星正射影像图的视频帧拼接效果如图8所示。从图8中可以看出,整体拼接效果较好,但存在多处局部细节拼接错位的问题(图中红色圆圈标识处),主要是因为视频帧与卫星影像时相相差较多,造成匹配的特征点效果较差。

(a) 整体拼接效果

(b) 细节1

(c) 细节2

(d) 细节3图8 基于卫星正射影像图的视频帧拼接效果Fig.8 Effect of video frame mosaic based on satellite orthophoto

(2) 基于航空正射影像图的视频帧拼接

基于航空正射影像图的视频帧拼接效果如图9所示。

从图9中可以看出,整体拼接效果较好,且局部细节拼接效果也较好,除了图中红色圆圈标识外,其他部分很少有错位问题。拼接效果明显优于基于卫星正射影像图的拼接结果,主要原因是航空正射影像成像与视频成像机制较为接近且试验所用数据时相较为接近,匹配效果较好,这也与1.4.3节实验结果一致。

(a) 整体拼接效果

(b) 细节1

(c) 细节2

(d) 细节3图9 基于航空正射影像图的视频帧拼接效果Fig.9 Effect of video frame mosaic based on aerial orthophoto

通过统计拼接成果中关键目标的拼接完整度,可更加客观地分析2个实时拼接方法的优劣,试验区域内具有明显特征的地物包括房屋、道路、河流和桥梁等,由于单帧影像的地面覆盖范围为1 190.4 m×669.6 m,房屋、桥梁等小地物一般都在一帧影像上,因此本文选用道路和河流作为关键目标统计,以航空正射影像底图中的道路和河流作为参考,分别统计出现错位地物的视频关键帧帧数,其中基于卫星正射影像图的视频帧拼接方法的错位视频关键帧43帧,基于航空正射影像图的视频帧拼接方法的错位视频关键帧9帧,本次试验共处理162帧视频关键帧,因此基于卫星正射影像图的视频帧拼接方法准确率为73.5%,基于航空正射影像图的视频帧拼接方法准确率为94.4%。

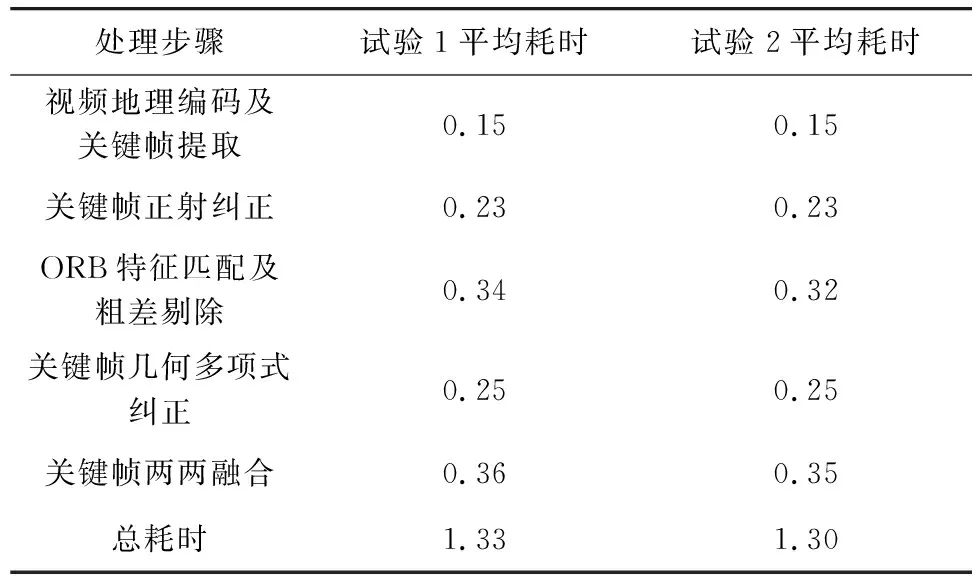

在试验过程中,统计各个处理步骤耗时情况,如表2所示。从表2可以看出,2次试验从视频关键帧提取到关键帧两两融合平均总耗时1.315秒/帧,本文彩虹4型无人机巡航速度为120 km/h,依据1.2节公式按75%重叠度估算相邻关键帧时间间隔为5.02 s,即视频帧拼接的处理时间小于关键帧的提取时间,因此在实时处理过程中不会造成阻塞,保证了拼接的实时性。

表2 实时拼接各处理步骤耗时统计表Tab.2 Time consumption of each processing step of real-time mosaic 单位:秒/帧

3 结束语

本文提出了一种无人机地理视频影像实时拼接的整体流程和方法,通过开展基于卫星和航空正射影像图的视频帧实时拼接试验,验证了该方法的可行性。首先,提出了一种基于视频地理编码数据的关键帧实时提取方法,该方法可快速实时提取满足重叠度要求的视频关键帧,减少拼接算法冗余度。采用ORB特征提取与匹配算法,保证了该方法的实时性,同时基于四叉树的FAST角点均匀提取策略,从很大程度上解决了特征点分布不均匀、重叠较多的问题,提高了多项式几何纠正的精度。通过异源光学遥感影像匹配实验,分析了视频帧实时拼接所用基准影像的分辨率、时相要求,为本文算法的实际应用提供借鉴。最后,在实时拼接试验过程中,通过统计各个处理步骤耗时情况,进一步验证了本文方法的时效性。随着高分辨率卫星遥感技术的发展,高清地图数据将快速更新,这也为本文方法在应急测绘、动态监测等领域的应用提供支撑。目前本文方法已在国家应急测绘保障能力建设项目中应用,在红原飞行测试中取得了较好效果。