基于图模型和注意力模型的会话推荐方法

2022-11-30党伟超姚志宇白尚旺高改梅刘春霞

党伟超,姚志宇,白尚旺,高改梅,刘春霞

基于图模型和注意力模型的会话推荐方法

党伟超,姚志宇*,白尚旺,高改梅,刘春霞

(太原科技大学 计算机科学与技术学院,太原 030024)(∗通信作者电子邮箱S20190660@stu.tyust.edu.cn)

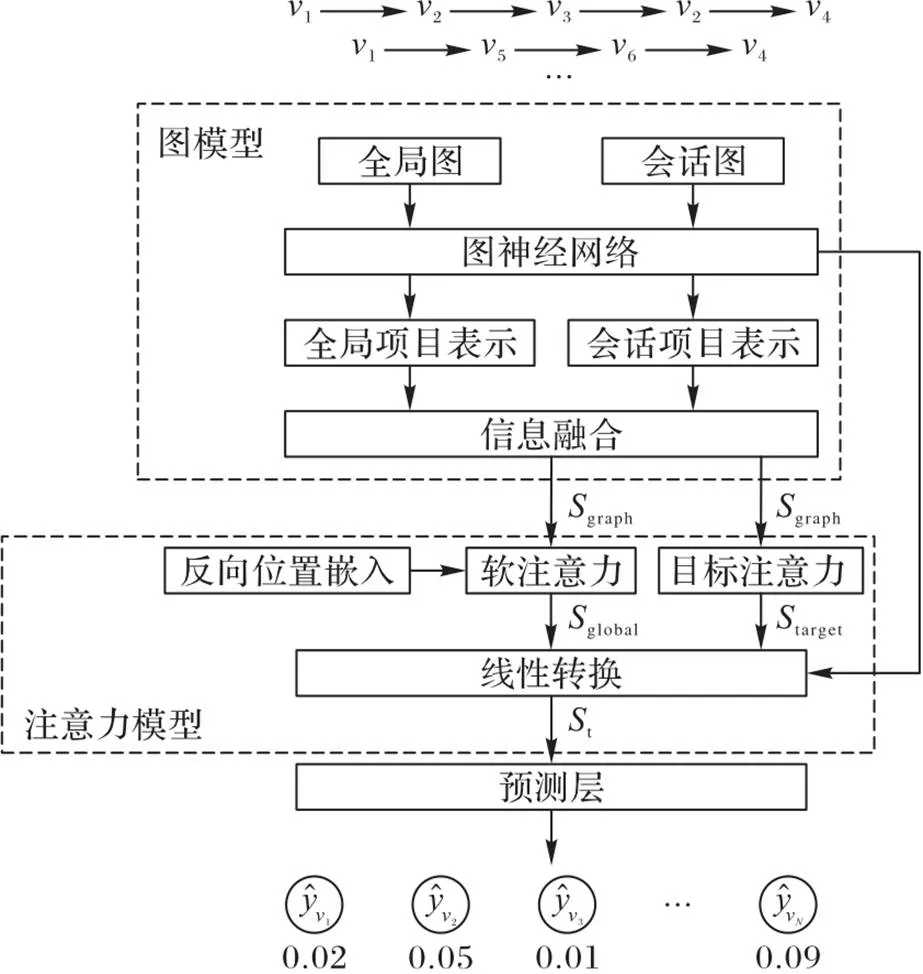

为解决基于循环神经网络(RNN)会话推荐方法的兴趣偏好表示不全面、不准确问题,提出基于图模型和注意力模型的会话推荐(SR‑GM‑AM)方法。首先,图模型利用全局图和会话图分别获取邻域信息和会话信息,并且利用图神经网络(GNN)提取项目图特征,项目图特征经过全局项目表示层和会话项目表示层得到全局级嵌入和会话级嵌入,两种级别嵌入结合生成图嵌入;然后,注意力模型使用软注意力进行图嵌入和反向位置嵌入融合,目标注意力激活目标项目相关性,注意力模型通过线性转换生成会话嵌入;最后,SR‑GM‑AM经过预测层,输出下次点击的项推荐列表。在两个真实的公共电子商务数据集Yoochoose和Diginetica上对比了SR‑GM‑AM方法与基于无损边缘保留聚合和快捷图注意力的推荐(LESSR)方法,结果显示,SR‑GM‑AM方法的P20最高达到了72.41%,MRR20最高达到了35.34%,验证了SR‑GM‑AM的有效性。

会话推荐;全局图;会话图;图神经网络;邻域信息

0 引言

推荐系统在各种在线平台中发挥着关键作用,对用户进行个性化推荐,可以解决信息过载问题。传统的推荐方法(如协同过滤等)过度依赖用户的长期交互信息,而会话推荐[1-2]可以根据用户正在进行会话中的行为信息预测用户的下一次点击。

会话推荐的早期研究分为两类,分别是基于协同过滤和基于马尔可夫链的会话推荐,学者提出了许多基于深度学习的方法,取得了较好的效果,但也存在一些问题:基于图神经网络(Graph Neural Network, GNN)[3-4]的方法结合用户的长期兴趣和短期兴趣进行会话表示从而完成推荐,但这些方法都基于当前会话信息,忽略了其他会话中的信息;神经注意力推荐机制(Neural Attentive Recommendation Mechanism, NARM)[5]和短时注意力优先(Short‑Term Attention/Memory Priority, STAMP)方法[6]则只对连续项目间转移关系建模,不能捕获项目间复杂的依赖关系。上述方法获取的用户兴趣偏好表示并不准确,因此推荐精度低。

针对上述问题,本文提出了基于图模型和注意力模型的会话推荐(Session Recommendation based on Graph Model and Attention Model, SR‑GM‑AM)方法。该方法首先利用全局图和会话图挖掘用户的多种兴趣信息;其次,利用GNN捕捉项目间复杂的转移关系,提取图特征;最后,使用软注意力和目标注意力,准确获取用户兴趣偏好表示。

1 相关工作

传统的会话推荐方法包括基于协同过滤和基于马尔可夫链的会话推荐。基于协同过滤的方法根据项目相似度做出推荐;基于马尔可夫链的方法则将当前会话映射成马尔可夫链,根据前一次点击预测用户的下一次点击。

循环神经网络(Recurrent Neural Network, RNN)可以处理包含时间顺序的会话信息,也被用于会话推荐。Tan等[7]对会话序列进行处理时,引入数据增强的方法,提高了训练模型的鲁棒性。Li等[5]提出的NARM利用注意力机制获取准确的项目转移信息。Liu等[6]提出了一种基于注意力机制的短时记忆网络(STAMP)捕捉用户的当前兴趣。NARM和STAMP都使用注意力机制,强调了最后一次点击项目的重要性。之前的研究利用注意力机制[8-9],在会话推荐中引起了广泛关注,基于自注意力的序列推荐[10],利用自注意力机制提高了推荐性能。基于兴趣转移和潜在因素的会话推荐(Interest Shift and Latent Factors, ISLF)[11]考虑了用户兴趣转移,并采用可变自动编码器和RNN捕捉用户的序列行为信息。基于混合通道目的路由网络的会话推荐MCPRN(Mixture‑Channel Purpose Routing Network)[12]使用混合通道模型对给定会话进行建模。

GNN广泛应用于推荐系统[13-14]、行人重识别[15]、分辨率重建[16]等领域,基于GNN的方法可以对会话图进行操作,更好地捕捉项目之间的复杂转移关系。Wu等[3]提出基于GNN的会话推荐方法(Session‑based Recommendation with GNN, SR‑GNN),结合当前会话信息和长期会话信息完成推荐。之后Qiu等[17]提出了变种方法,利用邻域嵌入和多头注意力生成会话表示。

上述方法只对当前会话中的项目转移关系进行建模,忽略了其他会话中的信息,并且用户兴趣偏好表示不准确。为此,本文提出基于图模型和注意力模型的会话推荐方法,在文献[18]中方法的基础上考虑了邻域信息,能够有效解决会话推荐问题。

2 基于图模型和注意力模型的会话推荐

2.1 总体框架

基于图模型和注意力模型的会话推荐模型如图1所示。首先,会话序列经过预处理分别转换成全局图和会话图,利用GNN得到项目嵌入;之后经过全局项目表示层和会话项目表示层分别生成全局级项目嵌入和会话级项目嵌入,图模型经过信息融合生成图嵌入;其次,注意力模型通过软注意力进行图嵌入和反向位置嵌入融合,得到全局嵌入,并且目标注意力生成目标嵌入,注意力模型经过线性转换得到会话嵌入;最后,基于图模型和注意力模型的会话推荐模型经过预测层,输出下一次点击的项推荐列表。

图1 SR‑GM‑AM的总体框架

2.2 符号定义

2.3 图模型

全局图和会话图分别利用GNN得到项目嵌入,项目嵌入经过全局项目表示层生成全局级嵌入,经过会话项目表示层生成会话级嵌入,最后图模型经信息融合得到图嵌入。

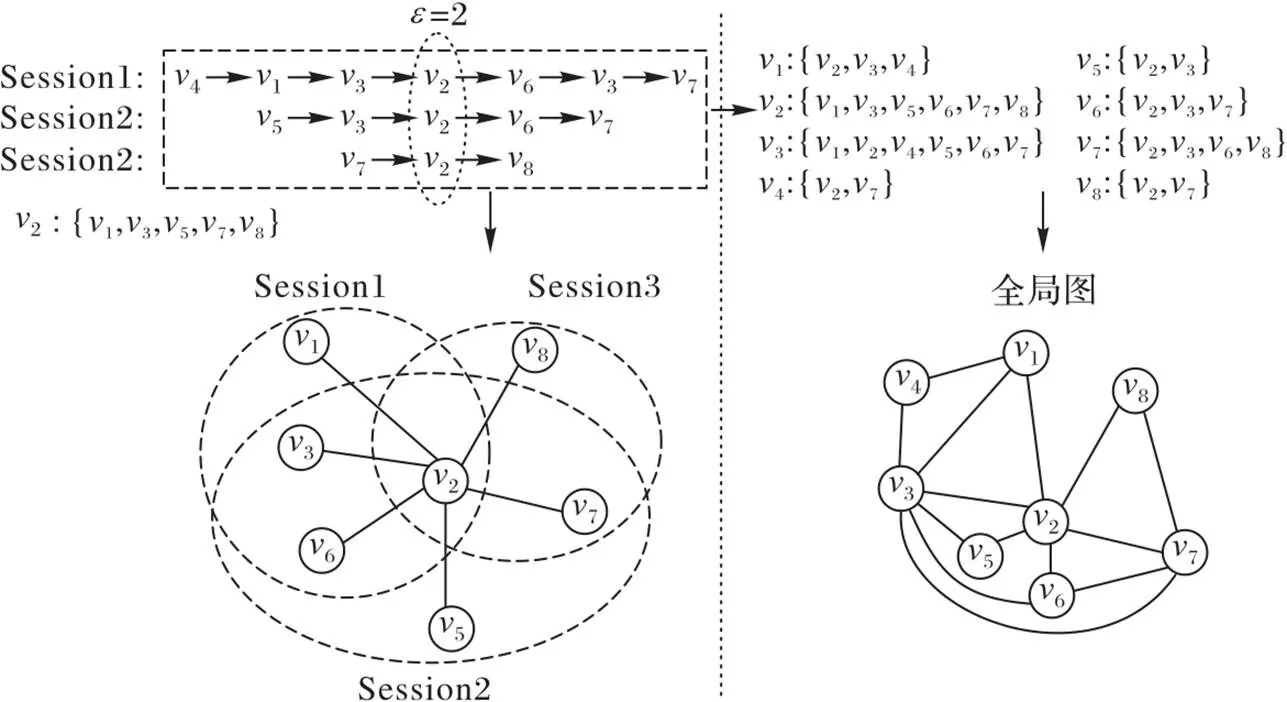

2.3.1全局图

全局图可以从其他会话信息中捕获项目转移信息,称为全局项目转移,是在邻域的基础上进行定义。

图2 全局图示例

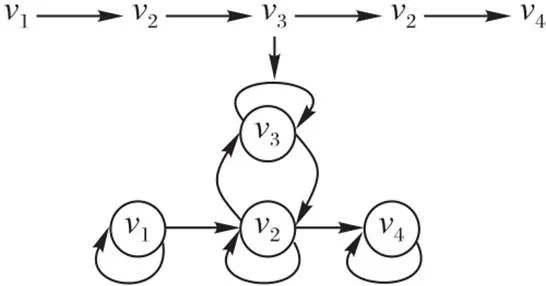

2.3.2会话图

图3 会话图

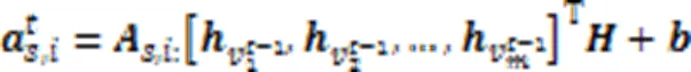

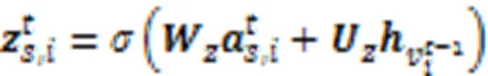

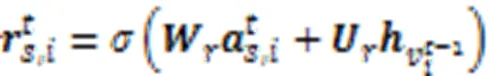

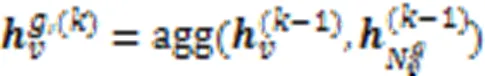

2.3.3图神经网络

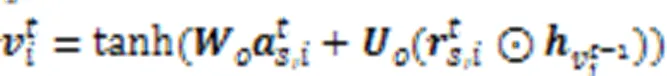

式(1)表示不同节点之间的信息传播,提取潜在向量,并将它们作为GNN的输入;式(2)、(3)分别表示更新门和重置门,分别决定要保留和丢弃信息;式(4)表示候选状态,通过前一个时间步的状态、当前状态和重置门来构建候选状态;式(5)表示在更新门的控制下,最终状态是前一个时间步状态和候选状态的组合。通过不断更新,获得最终的节点向量。

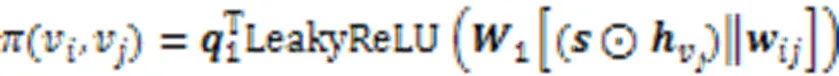

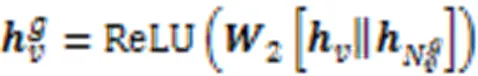

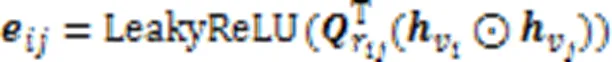

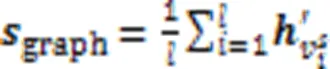

2.3.4全局项目表示

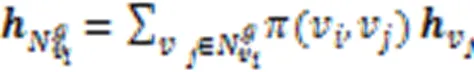

全局项目表示由信息传播和信息聚合两部分组成。一个项目包含在多个会话中,获取有用的项目转移信息,可以有效地提高预测精度。之前的方法是使用平均池化方法获取项目的邻域特征信息,但是并非邻域集合中的所有项目都与当前会话的用户偏好有关,因此之前的方法不适合获取邻域特征信息。本文方法利用会话感知注意力,区分邻域集合中各个项目的重要性。

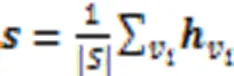

之后使用softmax函数进行归一化:

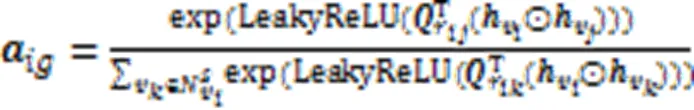

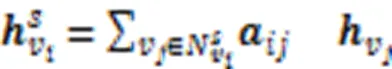

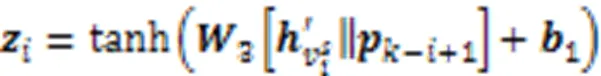

2.3.5会话项目表示

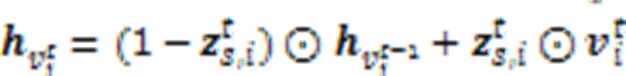

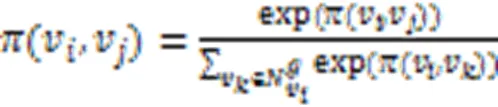

会话图中自身项目与其邻域中各个项目之间转移关系的权重是不同的,利用注意力机制表示不同节点之间的权重。注意力权重的公式为:

利用softmax激活函数对注意力权重进行正则化:

会话级嵌入表示为:

会话级项目嵌入由当前会话中项目本身及其邻域的特征聚合而成,通过注意力机制,降低了噪声对会话项目表示的影响。

2.3.6信息融合

图嵌入向量则通过式(16)计算嵌入的平均值得到:

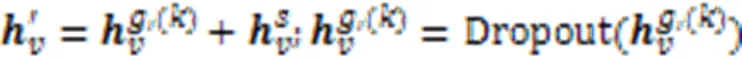

2.4 注意力模型

注意力模型通过软注意力进行图嵌入和反向位置嵌入融合得到全局嵌入,并且目标注意力生成目标嵌入,注意力模型经过线性转换得到会话嵌入。

2.4.1反向位置嵌入

2.4.2软注意力

注意力模型利用软注意力机制融合反向位置嵌入向量和图嵌入向量(式(18)),生成全局嵌入向量(式(19))。

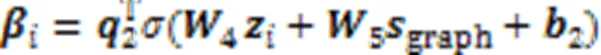

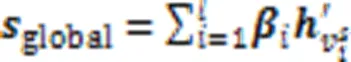

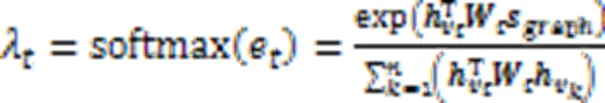

2.4.3目标注意力

2.4.4线性转换

目标嵌入向量和全局嵌入向量经过线性转换生成会话嵌入向量:

2.5 生成推荐

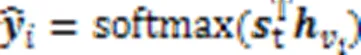

项目嵌入向量和会话嵌入向量进行内积,使用softmax函数对所有目标项目推荐分数进行归一化,其公式为:

3 实验与结果分析

3.1 数据集处理

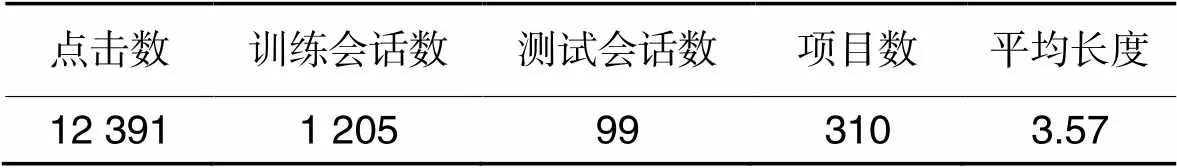

本实验分别在两个真实的公共电子商务数据集Yoochoose和Diginetica上进行验证。Yoochoose数据集的数据信息来源于RecSys Challenge 2015,它包含用户在电子商务网站上6个月内的点击信息;Diginetica数据集的数据信息来自CIKM Cup 2016的交易数据。为公平比较,本实验严格遵循与Wu等[3]相同的数据集处理规则,在公共数据集中,删除点击次数不到5的项目和会话长度为1的会话。最终,Yoochoose数据集包含7 981 580条会话和37 483个项目,Diginetica数据集包含204 771条会话和43 097个项目。

表1 数据集信息统计

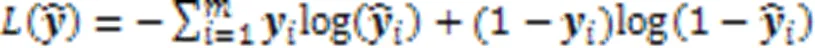

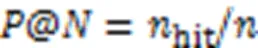

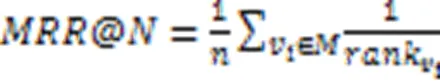

3.2 评价指标

本实验采用与Wu等[3]相同的评估指标,分别是精度(Precision, P)和平均倒数排名(Mean Reciprocal Rank, MRR)。

3.3 基准方法

实验选择了以下五种对比方法:

NARM[5]:在传统的RNN基础上增加了注意力机制,改进了会话推荐的精度。

STAMP[6]:利用注意力取代RNN的编码器,依赖用户点击的最后一次项目捕捉用户兴趣。

SR‑GNN[3]:使用门控图神经网络获得项目嵌入,应用注意力机制获取用户短期与长期兴趣偏好。

基于无损边缘保留聚合和快捷图注意力的会话推荐(Lossless Edge‑order preserving aggregation and Shortcut graph attention for Session‑based Recommendation, LESSR)[19]:采用边缘保留聚合层解决基于GNN的顺序信息丢失问题,并且提出捷径图注意力层,该层通过沿捷径连接传播信息有效捕获远程依赖关系,通过将两种类型的层组合在一起,完成推荐。

基于会话的多粒度图神经网络推荐(Session‑based Recommendation model of Multi‑granular GNN, SRMGNN)[20]: GNN分别学习项目信息和项目类别信息,提取更多的特征信息,然后使用注意力网络,经过融合层,得到最终的会话表示,完成推荐。

3.4 参数设置

3.5 实验结果与分析

3.5.1相关方法比较与分析

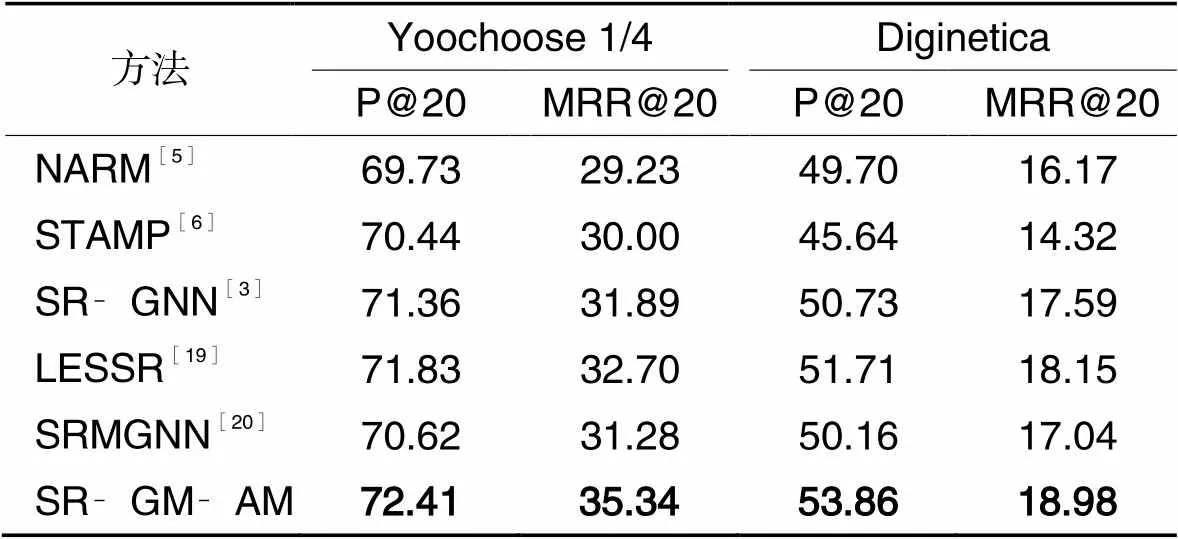

表2是几种对比方法的P@20和MRR@20结果,最好结果加粗表示。由表2可以看出,SR‑GM‑AM在公共数据集上的P@20和MRR@20都有良好表现,验证了所提出方法的有效性。基于神经网络类方法具有更强捕捉复杂用户行为的能力,NARM应用循环单元捕捉用户整体兴趣,STAMP利用最后一次点击的项目改善短期记忆能力,这些方法获得了优于传统方法的性能;但是这些方法只考虑连续项目之间的单向转移关系,它们的性能仍然不如SR‑GNN。

SR‑GNN进一步考虑了会话中项目之间的复杂依赖关系,该方法将每个会话建模为一个有向会话图,该图能捕捉用户点击项目之间的复杂联系。该方法采用软注意力机制生成全局会话表示,可以自动选择相对重要的项目,并且忽略当前会话中的无效用户行为。当用户的行为是无目的的,或者用户的兴趣在当前会话中快速漂移时,传统模型无法有效处理这种类型会话信息。LESSR和SRMGNN仍然不如本文方法SR‑GM‑AM。

SR‑GM‑AM利用全局图和会话图提取更多的特征信息,GNN获取了复杂项目转移关系。经过全局项目表示和会话项目表示,融合全局级嵌入和会话级嵌入,生成图嵌入向量。之后经过注意力模型,利用软注意力,生成全局嵌入向量,结合目标注意力生成的目标嵌入,得到会话嵌入,完成推荐。

表2 实验结果比较 单位: %

3.5.2全局图对模型的影响

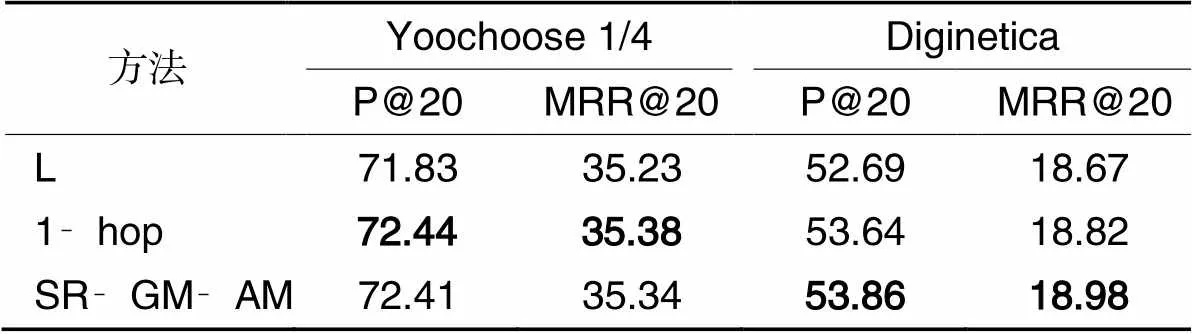

为比较图模型中的全局图对实验结果表现的影响程度,本实验将与以下两种嵌入方法进行比较:1)没有全局级嵌入,只有会话级嵌入(记为L);2)具有全局级嵌入和会话级嵌入,跳数设置为1(记为1‑hop);3)具有全局级嵌入和会话级嵌入,跳数设置为2(即本文的SR‑GM‑AM)。比较结果如表3所示,最好结果加粗表示。由表3可知,SR‑GM‑AM实现了更好的性能。通过实验数据可以看出,SR‑GM‑AM以及1‑hop都可以从其他会话中获取项目转移信息,提取更多的特征信息,做出准确预测,验证了全局图的有效性。还可以看出,在Diginetica数据集上,具有2跳的SR‑GM‑AM比具有1跳的SR‑GM‑AM表现更好,这表明跳数越高,可能从全局图中获取更多的有效信息,提高推荐的准确性。但是在Yoochoose 1/4上,具有1跳的SR‑GM‑AM比具有2跳的SR‑GM‑AM表现更好,这表明跳数如果设置太高,可能会引入噪声,降低推荐的准确度。

表3 全局图对模型的影响 单位: %

3.5.3注意力对模型的影响

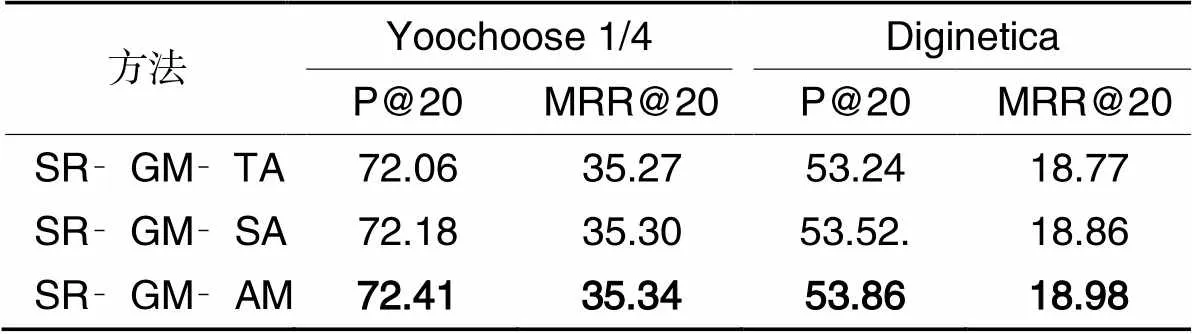

本文方法在注意力模型中引入软注意力机制和目标注意力机制,会话嵌入向量包括:全局嵌入向量、目标嵌入向量和项目嵌入向量。为比较注意力机制对实验结果的影响,本实验中与以下两种方法进行比较:

1)基于图模型和目标注意力的会话推荐(Session Recommendation based on Graph Model and Target Attention, SR‑GM‑TA),注意力模型中只有目标注意力机制,其会话嵌入向量包括目标嵌入向量和项目嵌入向量;

2)基于图模型和软注意力的会话推荐(Session Recommendation based on Graph Model and Soft Attention, SR‑GM‑SA),注意力模型中只有软注意力机制,其会话嵌入向量包括全局嵌入向量和项目嵌入向量。

比较结果如表4所示,最好结果仍加粗表示。从表4可以看出,SR‑GM‑AM优于其他方法,验证了该方法的有效性。SR‑GM‑SA在各项指标上优于SR‑GM‑TA,SR‑GM‑AM在性能上优于SR‑GM‑SA,表明利用软注意力提取全局兴趣偏好对于会话推荐的重要性,并且反向位置嵌入获取离候选项目越近的项目信息,可以更好地提高推荐的准确度。SR‑GM‑AM在各项指标上都优于SR‑GM‑SA,验证了融合目标嵌入的重要性,目标注意力进一步考虑了用户兴趣和目标兴趣之间的关系,在给定不同目标项目的情况下,针对目标项目完成相关性推荐。实验结果表明,本方法通过利用软注意力和目标注意力,可以更好地完成个性化推荐。

表4 注意力对模型的影响 单位: %

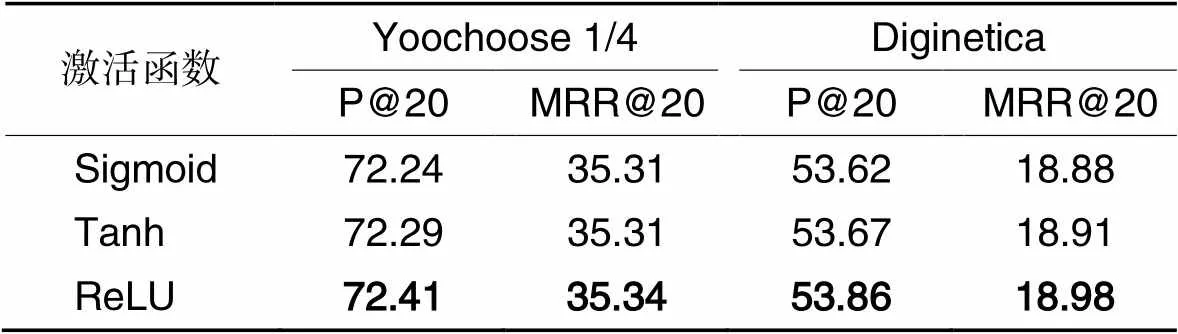

3.5.4非线性激活函数对模型的影响

为比较不同激活函数对全局项目表示中信息聚合的影响程度,本实验分别使用Sigmoid、Tanh和ReLU三种激活函数进行比较,结果如表5所示,最好结果仍加粗表示。由表5可以看出,在各项指标上,ReLU的整体表现最好,验证了ReLU的有效性。

表5 激活函数对模型的影响 单位: %

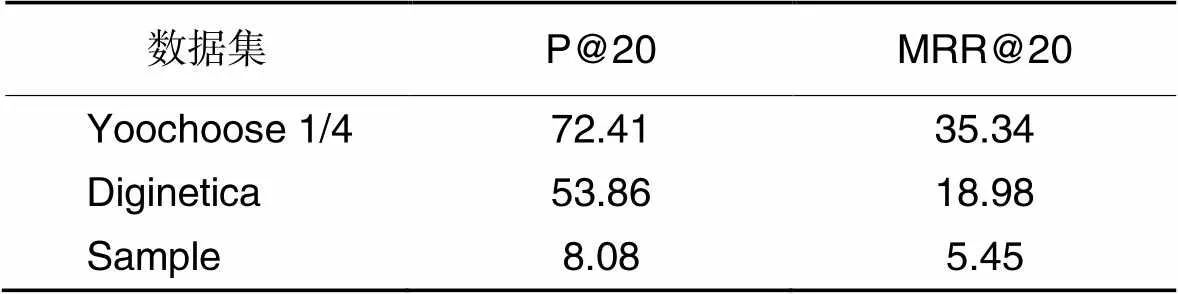

3.5.5稀疏数据集对模型的影响

本实验采用的两个公共电子商务数据集Yoochoose和Diginetica都为稠密数据集,Sample数据集为稀疏数据集,表6为Sample数据集的详细信息。

表6 Sample数据集统计

为比较稀疏数据集对模型的影响程度,本实验分别在Yoochoose1/4、Difinetica和Sample三个数据集上进行实验,结果如表7所示。由表7可以看出,在稀疏数据集上,模型的整体表现不好,表明模型训练依赖于大量数据才可以得到更高的精度。

表7 稀疏数据集对模型的影响 单位: %

4 结语

本文提出基于图模型和注意力模型的会话推荐方法。全局图和会话图分别获取会话中的邻域信息和会话信息,利用GNN捕捉项目间复杂转移关系得到项目嵌入,项目嵌入经过全局项目表示层和会话项目表示层分别得到全局级项目嵌入和会话级项目嵌入,两个级别嵌入融合生成图嵌入。注意力模型引入反向位置嵌入、软注意力和目标注意力,提高会话嵌入的准确性,从而完成推荐。实验结果表明,该方法在各项指标上均优于基准方法,另外通过消融实验证明了本方法各组成部分之间的有效性。但是,由实验结果可见,会话推荐的各项指标还存在很大的提升空间,在接下来的工作研究中,将考虑挖掘更多用户的行为信息以及结合知识图谱,以得到更高的推荐精度。

[1] 赵海燕,赵佳斌,陈庆奎,等.会话推荐系统[J].小型微型计算机系统,2019,40(9):63-69.(ZHAO H Y, ZHAO J B, CHEN Q K, et al. Session‑based recommendation system[J]. Journal of Chinese Computer Systems, 2019, 40(9): 63-69.)

[2] 桂越.基于会话的推荐算法研究[D].北京:北京邮电大学,2019:7-16.(GUI Y. Research on session‑based recommendation algorithm[D]. Beijing: Beijing University of Posts and Telecommunications, 2019: 7-16.)

[3] WU S, TANG Y, ZHU Y, et al. Session‑based recommendation with graph neural networks [C]// Proceedings of the 33rd AAAI Conference on Artificial Intelligence. Menlo Park, CA: AAAI Press, 2019: 346-353.

[4] XU C, ZHAO P, LIU Y, et al. Graph contextualized self‑attention network for session‑based recommendation [C]// Proceedings of the 28th International Joint Conference on Artificial Intelligence. Menlo Park, CA: AAAI Press, 2019: 3940-3946.

[5] LI J, REN P, CHEN Z, et al. Neural attentive session‑based recommendation [C]// Proceedings of the 2017 ACM on Conference on Information and Knowledge Management. New York: ACM, 2017: 1419-1428.

[6] LIU Q, ZENG Y, MOKHOSI R, et al. Short‑term attention/memory priority model for session‑based recommendation [C]// Proceedings of the 24th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining. New York: ACM,2018: 1831-1839.

[7] TAN Y K, XU X, LIU Y. Improved recurrent neural networks for session‑based recommendations [C]// Proceedings of the 1st Workshop on Deep Learning for Recommender Systems. New York: ACM, 2016: 17-22.

[8] VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need [C]// Proceedings of the 31st International Conference on Neural Information Processing Systems. Red Hook, NY: Curran Associates Inc., 2017: 6000-6010.

[9] WANG H, LIU G, LIU A, et al. DMRAN: a hierarchical fine‑ grained attention‑based network for recommendation [C]// Proceedings of the 28th International Joint Conference on Artificial Intelligence. Menlo Park: AAAI Press, 2019: 3698-3704.

[10] KANG W‑C, MCAULEY J. Self‑attentive sequential recommendation [C]// Proceedings of the 2018 IEEE International Conference on Data Mining. Piscataway: IEEE, 2018: 197-206.

[11] SONG J, SHEN H, OU Z, et al. ISLF: interest shift and latent factors combination model for session‑based recommendation [C]// Proceedings of the Twenty‑Eighth International Joint Conference on Artificial Intelligence. California: IJCAI, 2019: 5765‑5771.

[12] WANG S, HU L, WANG Y, et al. Modeling multi‑purpose sessions for next‑item recommendations via mixture‑channel purpose routing networks [C]// Proceedings of the 28th International Joint Conference on Artificial Intelligence. California: IJCAI, 2019: 3771-3777.

[13] 南宁,杨程屹,武志昊.基于多图神经网络的会话感知推荐模型[J].计算机应用,2021,41(2):330-336.(NAN N, YANG C Y, WU Z H. Multi‑graph neural network‑based session perception recommendation model[J]. Journal of Computer Applications, 2021, 41(2): 330-336.)

[14] 孙鑫,刘学军,李斌,等.基于图神经网络和时间注意力的会话序列推荐[J].计算机工程与设计,2020,41(10):2913-2920.(SUN X, LIU X J, LI B, et al. Graph neural networks with time attention mechanism for session‑based recommendations[J]. Computer Engineering and Design, 2020, 41(10): 2913-2920.)

[15] SHEN Y, LI H, YI S, et al. Person re‑identification with deep similarity‑guided graph neural network [C]// Proceedings of the 2018 European Conference on Computer Vision, LNIP 11219. Cham: Springer, 2018: 508-526.

[16] 呼延康,樊鑫,余乐天,等.图神经网络回归的人脸超分辨率重建[J].软件学报,2018,29(4):914-925.(HU Y K, FAN X, YU L T, et al. Graph based neural network regression strategy for facial image super‑resolution[J]. Journal of Software, 2018, 29(4): 914-925.)

[17] QIU R, LI J, HUANG Z, et al. Rethinking the item order in session‑based recommendation with graph neural networks [C]// Proceedings of the 28th ACM International Conference on Information and Knowledge Management. New York: ACM, 2019: 579-588.

[18] 党伟超,姚志宇,白尚旺,等.基于图神经网络和注意力机制的会话推荐[J]. 计算机工程与设计, 2022, 43(10): 2953-2958. (DANG W C, YAO Z Y, BAI S W, et al. Session recommendation based on graph neural network and attention mechanism [J]. Computer Engineering and Design, 2022,43(10): 2953-2958).

[19] CHEN T, WONG R C‑W. Handling information loss of graph neural networks for session‑based recommendation [C]// Proceedings of the 26th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining. New York: ACM, 2020: 1172-1180.

[20] 任俊伟,曾诚,肖丝雨,等.基于会话的多粒度图神经网络推荐模型[J].计算机应用,2021,41(11):3164-3170.(REN J W, ZENG C, XIAO S Y, et al. Session‑based recommendation model of multi‑granular graph neural network[J]. Journal of Computer Applications, 2021, 41(11): 3164-3170.)

Session recommendation method based on graph model and attention model

DANG Weichao, YAO Zhiyu*, BAI Shangwang, GAO Gaimei, LIU Chunxia

(,,030024,)

To solve the problem that representation of interest preferences based on the Recurrent Neural Network (RNN) is incomplete and inaccurate in session recommendation, a Session Recommendation method based on Graph Model and Attention Model (SR‑GM‑AM) was proposed. Firstly, the graph model used global graph and session graph to obtain neighborhood information and session information respectively, and used Graph Neural Network (GNN) to extract item graph features, which were passed through the global item representation layer and session item representation layer to obtain the global‑ level embedding and the session‑level embedding, and the two levels of embedding were combined into graph embedding. Then, attention model used soft attention to fuse graph embedding and reverse position embedding, target attention activated the relevance of the target items, as well as attention model generated session embedding through linear transformation. Finally, SR‑GM‑AM outputted the recommended list of theitems for the next click through the prediction layer. Comparative experiments of SR‑GM‑AM and Lossless Edge‑order preserving aggregation and Shortcut graph attention for Session‑based Recommendation (LESSR) were conducted on two real public e‑commerce datasets Yoochoose and Diginetica, and the results showed that SR‑GM‑AM had the highest P20 of 72.41% and MRR20 of 35.34%, verifying the effectiveness of it.

session recommendation; global graph; session graph; Graph Neural Network (GNN); neighborhood information

This work is partially supported by Natural Science Foundation of Shanxi Province (201901D111266, 201901D111252).

DANG Weichao, born in 1974, Ph. D., associate professor. His research interests include intelligent computing, software reliability.

YAO Zhiyu, born in 1995, M. S. candidate. His research interests include session recommendation.

BAI Shangwang, born in 1964, M. S., professor. His research interests include digital intelligent software system.

GAO Gaimei, born in 1978, Ph. D., lecturer. Her research interests include network security, cryptography.

LIU Chunxia, born in 1977, M. S., associate professor. Her research interests include software engineering, database.

TP391.4

A

1001-9081(2022)11-3610-07

10.11772/j.issn.1001-9081.2021091696

2021⁃09⁃26;

2022⁃03⁃07;

2022⁃03⁃21。

山西省自然科学基金资助项目(201901D111266, 201901D111252)。

党伟超(1974—),男,山西运城人,副教授,博士,CCF会员,主要研究方向:智能计算、软件可靠性;姚志宇(1995—),男,山西朔州人,硕士研究生,主要研究方向:会话推荐;白尚旺(1964—),男,山西吕梁人,教授,硕士,主要研究方向:智能软件系统;高改梅(1978—),女,山西吕梁人,副教授,博士,CCF会员,主要研究方向:网络安全、密码学;刘春霞(1977—),女,山西大同人,副教授,硕士,CCF会员,主要研究方向:软件工程、数据库。