基于深度语义分割的无人机遥感影像水体提取研究

2022-10-11江沛原

江沛原

(西南民族大学电子信息学院,成都 610041)

0 引言

语义分割任务也可以看作是特殊的分类任务,密集像素级分类任务。深度学习方法在场景复杂的遥感影像中,能够自适应地提取浅层的低级特征和深层的高级特征,经过特征融合高效挖掘丰富的语义信息。并且无人机遥感具有机动性好、环境影响小、空间分辨率高等优点。因此,高分辨率的遥感影像与深度学习技术的结合在遥感影像语义分割领域具有重要的现实意义,为无人机遥感影像的水体提取提供了新手段。地球表面由各种复杂类型的水和非水地貌组成,具体而言,地表水类型包括河流、湖泊、水库和海洋,它们具有不同的形状和光谱;非水类型包括阴影、柏油路和建筑物,它们具有相似的光谱和空间特征,容易与地表水混淆。因此,地表水测绘通常在精度上受到限制。通过地表水面积的大小和水的深浅程度可以监测遥感影像中的水体信息,为了充分地了解水体的变化情况,最行之有效的方法是对遥感影像中的水体信息进行提取。与提取遥感影像中的森林植被、城市道路、建筑物等其他类型地物相比,从遥感影像上提取水体的研究更为常见。随着空间探测技术的发展,基于遥感卫星的对地观测遥感数据为大范围水体提取提供了新的数据基础,同时也对现有的遥感数据分析方法提出了极大的挑战。

随着深度学习在图像分类、目标检测、语义分割等图像处理任务中展现出来的优异性能,近些年,使用深度学习方法进行水体提取的研究 越 来 越 多。Yang等利 用 传 统 的NDWI、NDVI、NDBI等指数人工构建特征作为网络的输入,然后使用稀疏自动编码器进行水体检测,能够在有限标签样本的情况下学习水体特征;Isikdogan等采用基于深度学习的方法,提出了从数据中学习水体特征的Deep Water Map模型,可有效区分水与土地、雪、冰、云和及阴影区。Li等利用FCN从高分辨率遥感影像中提取城市水体,并对比分析了输入特征、训练数据、迁移学习和数据增广四个因素对实验结果的影响,利用最优模型获得了较高的提取准确率。Wang等将深度学习方法应用到高分辨率遥感影像的水体识别与提取中,通过构建深度神经网络模型来提高遥感影像水体识别的精度,研究结果表明,所选用的深度卷积神经网络模型的识别效果都显著优于传统的水体指数法,验证了神经网络应用于遥感影像水体提取的可行性。Li等提出了一种基于无人机高分辨率遥感影像的复杂环境下水体识别的快速准确方法。与现有方法相比,该方法在准确率上取得了显著提高,可获得城市区域内明显的水边界,为城市水矢量制图提供数据。

针对水体提取的研究,如何减少遥感影像的噪声干扰仍是水体信息提取的难点,且水体流动反光,建筑物和阴影的遮盖等因素也会增加提取的难度。另外,现有研究多是针对卫星遥感影像的水体提取,识别精度较低。卫星遥感观测的信息不但宏观、综合,还可以长期连续观测,形成时序信息。由于无人机近地面的缘故,总体上分辨率高、时效性好,数据处理也比卫星遥感复杂。因此,本研究构建无人机遥感影像数据集,旨在提高其水体识别精度,采用基于OCRNet语义分割模型结合HRNet的方法进行水体提取。实验结果表明,该网络在分割准确率上效果较优,得到不错的结果,验证了该方法的可靠性。

1 无人机遥感影像数据集

1.1 数据集介绍

无人驾驶飞机(UAV)通常被称为无人机,无人机平台可搭载多种微传感器来获取不同质量的无人机遥感影像,从而构成无人机遥感系统。无人机遥感由遥感探测技术、导航定位技术、无线通信技术及飞行技术于一体,是一个系统而复杂的工程,在管理地理空间信息方面高效且方便。在深度学习的神经网络语义分割任务中,数据集由训练数据集(train dataset)、验证数据集(validation dataset)和测试数据集(test dataset)三部分组成。其中,训练集用于模型构建,计算训练误差的梯度和更新训练的权重参数;验证集用于调整模型的超参数和避免训练过程出现过拟合现象,用于辅助模型构建;测试集用于提高模型训练的准确度和最终模型的泛化能力,用于评估模型的准确率。

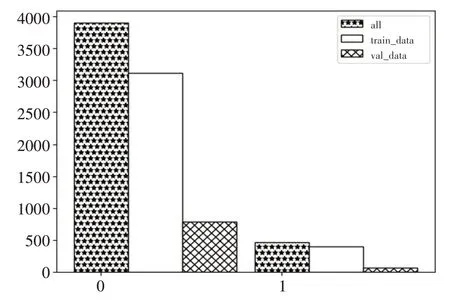

图1所示为初始无人机影像分布(共200张,像素6000×4000,格式为.JPG),通过ENVI 5.3软件对数据进行预处理裁剪,制作得到水体提取数据集(共4800张,像素512×512,格式为.PNG)。UAV_DATASET数据集包含三个文件夹:Annotation、JPEGImages和val_big_img。其中,Annotations文件夹保存的是各原图的像素级别的二值图真值信息;JPEGImages文件夹包含无人机影像的原图,命名方式相同;val_big_img文件夹包含随机选取的二十张大图,用于放入验证集中,此外还包含两个文本:val_list和train_list,分别记录训练数据集(3888张,占81%,格式为.PNG)和验证数据集(912张,占19%,格式为.PNG)。val_list文本存储的信息是val_big_img中的大图图片名构成验证集,而train_list则是剩下的图片构成训练集。

图1 数据集类别分布图

数据集的部分样本原图如图2所示,考虑到构建数据集的多样性,分别选取了无水体原图、不规则形状水体原图、包含水体范围较广等具有代表性的图片,增加了数据集的鲁棒性。在构建数据集的过程中,由于无人机影像原图为三通道RGB图像,而输入到Annotations文件夹内,只需要原图对应的二值图,因此还需要将RGB图像灰度化的操作,使之位深度由24降为8。

图2 数据集的部分样本原图

与图2对应的数据集的部分样本真值如图3所示,数据预处理后得到的二值图呈黑白图像,包含非水体(0)与水体(1),非水体表现为黑色,水体表现为白色。类别数为2,因此无人机影像的水体提取任务可以看作是一个二分类问题。

图3 数据集的部分样本真值

1.2 数据集图像裁剪制作

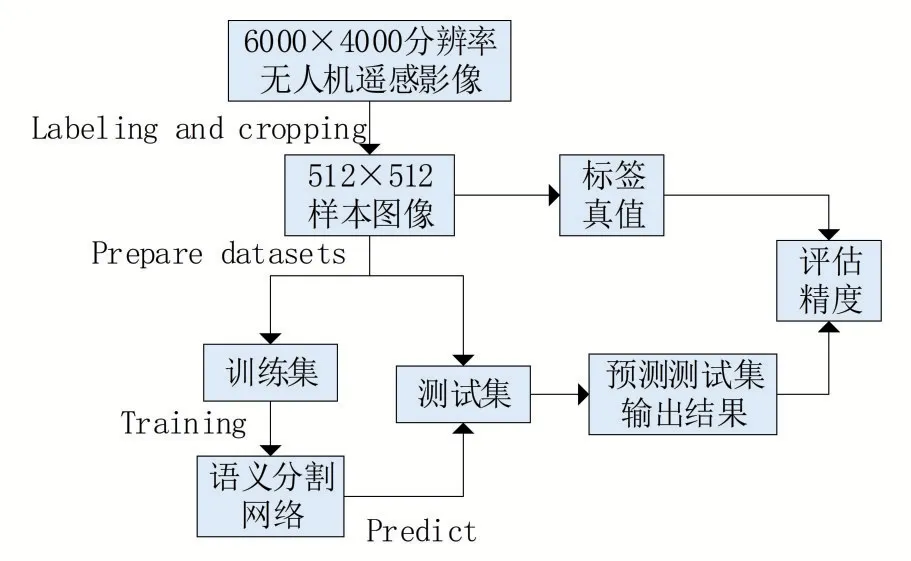

将遥感影像根据感兴趣区域(region of interest,ROI)范围大小对被裁剪影像进行裁剪,采用ROI方法裁剪无人机遥感影像得到数据集。数据集制作技术方案如图4所示,包括以下三个主要步骤:

图4 数据集制作技术方案图

(1)收集研究区无人机遥感影像,标记(水体与非水体)和裁剪无人机影像以获得512×512像素的样本图像,用于生成训练数据集和验证数据集;

(2)构建语义分割网络,并使用训练数据集训练网络;

(3)最后通过使用测试区域的真实标签和分类结果来评估分割结果,分类结果由测试数据集的预测结果拼接而成,评估模型精度。

数据集的裁剪采用滑动窗口预测方法,并将关联预测结果拼接,确定渔网(256×256)左上角和右下角中心像素坐标,据此确定需要填充的四至距离,预测图在填充图坐标系下的位置,并抠取需要预测的小图,将预测图有效区域添加到全0填充图上。

2 实验方法

2.1 语义分割模型OCRNet

语义分割是一项密集像素预测任务,研究重点在于解决逐渐衰减的特征图尺寸和需要原图尺寸的预测之间的矛盾,因此图像中每个像素的上下文信息是极其重要的。物体的上下文信息旨在显式增强物体信息,通过计算一组物体的区域特征表示,并根据物体区域特征表示与像素特征表示之间的相似度将这些物体区域特征表示传播给每一个像素。将像素的标签看作是像素所在物体的标签,通过对应的物体区域来表示以此加强像素的表征,于是OCRNet语义分割模型被提出,其主要思想是像素的类别标签由其所在目标决定,使用目标区域表示来增强其像素表示。

2.2 骨干网HRNet

HRNet能够全程保持高分辨率的特征图,得到更为精准的空间信息,其多尺度融合策略可以得到更为丰富的高分辨率表征,使预测的热点图(heatmap)更为准确。HRNet总体结构按照顺序可分为三部分:stem net、HRNet stages和segment head。stem net从图像到1/4大小的feature map,得到此尺寸的特征图后HRNet始终保持此尺寸的图片;HRNet stages是由HighResolutionModule组成的模型,其中,每个蓝色底色为1个阶段,每个stage产生的multiscale特征图的具体配置见表1(以hrnet_48为例)。stage的连接处有transition结构,用于不同stage之间的连接,完成channels及feature map大小对应;segment head将stages输出的4种scale特 征concat到 一 起,加 上num_channels到num_classes层,得到分割结果。

表1 多尺度特征图的具体配置

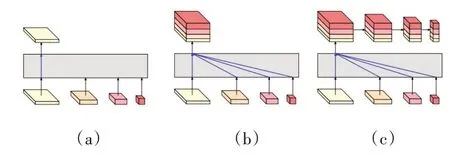

HRNet的head头多样化,支持不同的输出模式,对应V1,V2,V3三种版本,如图5所示,分别为a,b,c三种形式。

图5 HRNet的head输出形式

(a)输出内容仅包含最后输出的高分辨率特征;

(b)输出内容在最后也进行了跨分辨率融合,再输出高分辨率特征;

(c)语义信息较丰富,先进行融合后输出高分辨的特征,再进行下采样得到多个sacle的输出,并且(b)和(c)的特征融合是通过沿通道方向拼接的方式拼接融合的。

2.3 语义分割网络OCRNet结合HRNet骨干网

来自于NVIDIA的研究团队采用OCRNet+HRNet作为主干网络结构并且设计了一种更高效的多尺度融合方法,取得了更好的精度效果。本文结合OCRNet模型设置三种不同轮次、两种不同实验方法:HRNet_w18和HRNet_w48分别在10 epoch、30 epoch、60 epoch运行。其中,HRNet_w18方法中的18代表模型最后三级高分辨率子网络的宽度。OCRNet利用物体信息增强像素的上下文信息,HRNet保持主干网的高分辨率并且提供强语义信息与精准位置信息,它们的组合具有有效性,能够较好地对无人机影像中的水体信息进行提取。

2.4 网络模型的参数设置

常规优化器是单一的,在本研究的训练过程中,在优化器的基础上添加动量,使用随机梯度下降(stochastic gradient descent,SGD)算法进行优化,SGD算法的动量参数(momentum)和权重衰减参数(weight_decay)分别设置为0.9和4.0e-05,使用权重衰减的目的是防止过拟合。根据GPU的计算能力、显存大小、图像像素大小和样本数,将实验数据批量大小设置为8,batch_size的值为迭代一次送入网络的图片数量,一般显卡显存越大,批量值就可以越大。学习率是指模型训练的权重参数在逆梯度方向上调节的步长,为了保证训练过程顺利进行,采用了变化学习率策略,通过多项式衰减的策略将学习率值从初始设置为0.01的learning_rate,逐步衰减到end_lr为0的最终学习率,power即衰减率这一参数设置为0.9,类型为PolynomialDecay。

水体像素级别分类任务通过Softmax函数将每一个像素点值映射为一个概率值,来确定每一个像素值是否属于水体类,达到像素级别的预测损失函数的选择也是非常关键的,它是BP算法的核心部分,用来衡量预测值和标签值之间的差异。损失函数包括常规损失函数和多损失函数,前者单一且固定,本文采用的是通过coef连接CrossEntropyLoss和LovasSoftmaxLoss的多损失函数,该混合损失函数可用来监督像素和对象级别的训练过程。其中,Lovasz-Softmax loss是一种针对mIoU优化功能的损失,它基于子模损失的凸Lovasz扩展。在图像分割任务中,经常出现类别分布不均匀的情况,因此本文引入LSLoss以提高OCRNet中对象区域表示的准确性,并在对象级别优化最终分割结果。语义分割只关注像素级分类,缺乏对象级分类的优化。通过计算误差,将得到的误差进行反向传播。网络模型在训练过程中使用交叉熵作为损失函数,它可有效地对模型进行预测。

3 实验结果与分析

3.1 实验环境

本研究基于Ubuntu 18.04操作系统,使用的开发环境、编程语言和深度学习框架依次为Anaconda3、Python3.7.4和Pytorch,编 译 器 为PyCharm。模型训练、验证和测试均在一个NVIDIA GTX 1080Ti GPU上进行。

3.2 评价指标

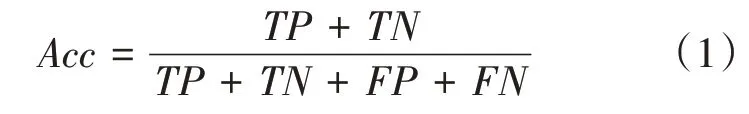

评价指标用来评估不同算法在某一方面的效果是否最佳,可对算法进行不同程度的优化。为定量分析图像语义分割精度,在图像分割领域中,评估模型质量主要是通过准确率(Acc)、Kappa系数以及语义分割评价指标均交并比(mean intersection over union,mIOU)这三个指标对4800幅影像的水体提取模型进行评定。

准确率是最常见的评价指标,表示被正确分类的数量在所有预测该类的数量中的占比,准确率越高表明模型质量越高。准确率由该类所有被正确分类的样本数除以模型预测中属于该类的总数得到。准确率的计算如式(1)所示:

式中:表示的是预测结果为正例,标签为正例的像素数量;表示的是预测的结果为负例,标签的结果为负例的像素数量;表示的是预测结果为正例,标签为负例的像素数量;表示的是预测结果为负例,标签为正例的像素数量。

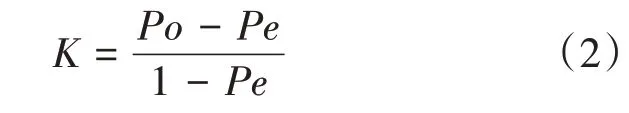

Kappa系数是用于一致性检验的指标,可用来衡量分类的结果。取值范围是[-1,1],通常大于0,将其分为五组来表示不同级别的一致性:0.0~0.2极低的一致性(slight);0.21~0.40一般的一致性(fair);0.41~0.60中等的一致性(moderate);0.61~0.80高度的一致性(substantial);0.81~1几乎完全一致(almost perfect)。基于混淆矩阵的Kappa系数计算如式(2)所示:

式中:代表每一类中正确分类像元素,即;代表所有类别对应的实际与预测数量的成绩的总和除以样本总数的平方,如式(3)所示:

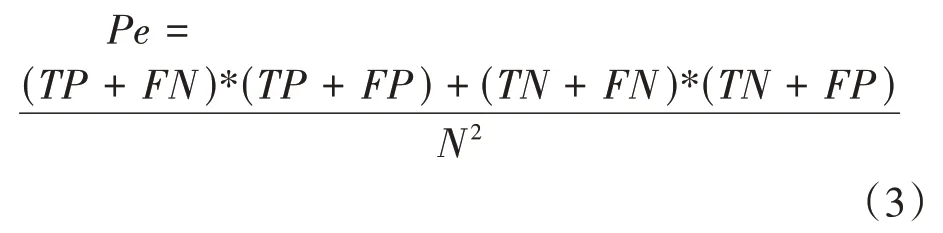

mIOU为语义分割的标准度量对每个类别数据集单独进行推理计算,计算出的预测区域和实际区域交集除以预测区域和实际区域的并集,然后将所有类别得到的结果取平均。在图像分割中,就是真实值(ground truth)和预测值两个集合。先计算每个类别的交并比,然后计算均值,如式(4)所示:

3.3 结果分析

表2列出了OCRNet网络结合HRNet_w18骨干网在不同轮次下在训练集上的评价指标。从实验分析可得,10 epoch和60 epoch训练轮次数下的各评价指标效果不及30 epoch训练轮次,后者的评价效果最佳:Acc可达99.30%,Kappa系数(KC)为0.9231,mIoU为0.9281。此时最佳验证迭代数为13122。

表2 OCRNet+HRNet_w18不同轮次的评价指标

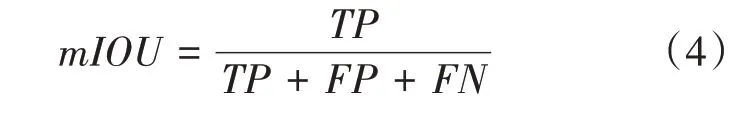

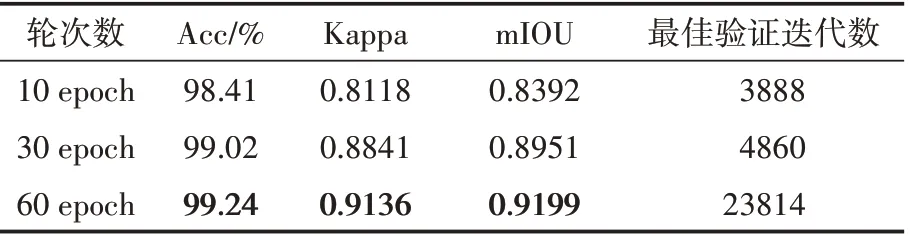

表3列出了OCRNet网络结合HRNet_w48骨干网在不同轮次下在训练集上的评价指标,从实验分析可得,随着训练轮次的增加,各项评价指标也有一定的提高,在60 epoch时达到最佳:Acc可达99.24%,Kappa系数(KC)为0.9136,mIoU为0.9199。此时最佳验证迭代数为23814。

表3 OCRNet+HRNet_w48不同轮次的评价指标

值得一提的是,当OCRNet网络结合HRNet_w18骨干网的轮次达到60 epoch时,各精度却有一定程度的下降,可见并不是训练轮次越多精度越高。迭代轮数过少可能欠拟合,而过多则可能过拟合,需要在训练中不断摸索找到大致合适的范围,或者可采用提前终止策略等。总体来看,语义分割模型OCRNet结合HRNet_w18骨干网在30 epoch轮次时,效果最好。

3.4 预测效果

在语义分割模型中输入6000×4000分辨率的遥感影像(水平分辨率和垂直分辨率均为350 dpi),预测其水体提取效果。如图6所示,左侧为原图,右侧为伪彩色预测结果图片,可直接查看各个类别的预测效果。对无人机遥感影像水体提取这一任务来说,总体精度较高,但对于图中误检测以及由于阴影遮挡等原因未识别到的水体部分,后续的工作仍需调整超参数来改进模型。

图6 水体的预测效果图

4 结语

语义分割任务旨在获取输入图像中每个像素的类标签,而无人机遥感影像水体提取任务旨在获取输入图像中的每个像素,这两个任务概念上有一定的一致性,因此可以将遥感影像提取任务转化为语义分割任务。本研究根据无人机遥感影像在复杂环境下采用OCRNet语义分割模型结合HRNet骨干网进行水体提取,扩充后的数据集涵盖水体信息更为丰富,也进一步提高了其鲁棒性,通过设置不同的实验,选取最优模型的神经网络完成水体数据集的提取。