一种任意分布下的隐变量因果结构学习算法

2022-09-15郝志峰陈正鸣蔡瑞初

郝志峰,陈正鸣,谢 峰,陈 薇,蔡瑞初

(1.广东工业大学 计算机学院,广州 510006;2.汕头大学 理学院,广东 汕头 515063;3.北京大学 数学科学学院,北京 100871)

0 概述

因果关系刻画了变量间的生成机制,这有助于解释数据,并进行有效的干预及回答“为什么”的问题[1-2]。因此,因果关系的研究在生物信息学[3]、气象学[4]、社会科学[5-6]等领域中备受关注和应用。

因果发现旨在通过观测数据挖掘变量间的因果关系[7]。常见的基于观测数据学习因果结构的方法有基于约束[8]和基于得分[9]两类方法。这两类方法主要利用条件独立性检验或评分搜索的方法来确定变量间的因果关系,但存在马尔可夫等价类问题,即部分因果结构的方向无法确定。SHIMIZU 等[10-11]基于数据产生机制提出了线性非高斯无环模型(Linear Non-Gaussan Acyclic Model,LiNGAM)。该模型采用噪声非高斯的假设,能识别出完整的因果结构。然而上述方法及相关的变体[12-13]仅关注估计观测变量之间的因果结构,并没有关注隐变量间的因果结构,而在实际应用中,往往还需要考虑隐变量之间的因果结构,如在医生问诊中,更需要关注所观测到的症状背后病因之间的关系。

针对隐变量间的因果结构学习问题,SILVA等[14]提出了线性隐变量模型假设和经典隐变量学习两阶段框架。在判断隐变量间因果关系方面,现有方法主要基于线性隐变量模型的假设,利用隐变量的直接孩子变量(也称为测量变量)的协方差信息或引入非高斯假设等方法来解决。利用协方差信息的方法,典型的代表是四分体(Tetrad)约束,其通过利用测量变量的二阶信息来恢复隐变量,如学习测量变量的聚类来定位隐变量。此类方法的局限性在于:在学习隐变量之间的因果方向时,存在等价类问题,换言之,基于协方差矩阵秩的信息不足以恢复完整的因果结构。CAI 等[15]引入非高斯假设,利用高阶统计信息提出了三分体(Traid)约束,该方法可识别隐变量完整的因果结构。但是基于三分体约束的方法需要假设真实的因果结构中每个变量的噪声都服从非高斯分布,而如果在真实的隐变量因果结构中存在超过一个含高斯噪声的隐变量时,基于三分体约束的结构学习算法就无法学到正确的隐变量结构。此外,在实际应用中,由于无法得到隐变量的分布信息,通常无法确定数据是否完全满足此假设。因此,研究任意分布下的隐变量间因果结构学习很有必要且具有一定的挑战性。

由上述分析可知,四分体方法无需分布假设,但可以为基于三分体约束的方法提供部分隐变量结构信息来避免四分体方法存在的局限性。然而,直接对两者进行结合是不可行的,因为基于三分体约束的算法无法确定可识别的边,在任意分布下不能可靠地学习整个网络结构。

本文证明任意分布下隐变量的可识别性理论,分析指出对于两个直接相连且没有混淆因子影响的隐变量,最小可识别条件是其中一个隐变量的噪声是非高斯的。基于这个性质以及四分体方法所提供隐变量的部分结构信息,提出一种在任意分布下学习隐变量之间因果结构的算法。

1 相关工作

常见的一些因果发现算法往往假设所有变量都是可观测的,但也有一些方法考虑了隐变量存在的情况,典型的有基于独立性约束的方法(如FCI[16]、RFCI[17]等)和基于LiNGAM 模型的一些变体(如ParceLingam[18]、RCD[19]等)。这些研究主要关注隐变量存在时观测变量间的因果发现。而在现实世界中,如何把隐变量的因果关系也考虑到因果结构学习中备受人们的关注。PATRIK 等[20]提出基于完备ICA 的LvLingam 方法学习观测变量的结构及部分隐变量信息。然而,此方法只能适用于变量较少的情况,容易在高维数据下陷入局部极值,并且其假设隐变量之间是互相独立的,无法得到隐变量之间的结构信息。

类似于线性无环函数因果模型的假设,SILVA等[14]提出了线性隐变量模型。该模型包含线性隐变量模型假设和经典隐变量学习两个阶段:第一阶段学习观测变量的聚类,定位出隐变量,得到属于同一个隐变量的观测变量;第二阶段根据得到的聚类学习隐变量之间的结构。线性隐变量模型示意图如图1 所示,其中:L代表隐变量;X代表观测变量。首先学习观测聚类,如得到(X1,X2,X3)是同一个聚类,定位出隐变量,即它们是隐变量L1的测量变量;然后根据得到的聚类学习隐变量之间的因果关系,如L1→L2。

图1 线性隐变量模型示意图Fig.1 Schematic diagram of linear latent variable model

基于线性隐变量模型,各种学习隐变量因果结构的方法应运而生,其中一类是基于四分体约束的方法(如BPC[14]、FOFC[21]、MIMBuild[14]等),此类方法主要利用受隐变量影响的测量变量的协方差信息来学习隐变量。如图1 所示,如果X1~X4满足Cov(X1,X3)Cov(X2,X4)-Cov(X1,X4)Cov(X2,X3)=0,则称X1~X4满足一个四分体约束。然而基于四分体约束的方法不能很好地识别隐变量的因果方向,如在图1 中,基于四分体约束无法区分L1和L2之间的方向。另一类方法主要通过假设变量的噪声都服从非高斯分布来解决隐变量因果结构学习问题(如Traid[15]、GIN[22]等方法),此类方法通过引入非高斯假设,可以利用高阶信息使隐变量的因果结构完全可识别。然而在实际应用中,无法事先得到隐变量噪声的分布信息,且实际场景的数据往往无法完全满足基于三分体约束方法的非高斯假设,从而导致此类方法在很多实际应用中失效。因此,研究任意分布下隐变量间的因果结构学习是很有必要的。

当前隐变量因果结构学习方法的研究仍处于初始阶段,较少有方法可解决任意分布下隐变量的结构学习问题。为弥补这一方面的不足,本文提出一种在任意分布下学习隐变量结构的方法,为相关领域研究提供参考。

2 问题定义

本文主要关注无环线性结构因果模型[23]。令X=(X1,X2,…,Xm)为观测变量集,L={L1,L2,…,LN}为隐变量集,V为两者的并集,V={X∪L}。不失一般性,假设V的均值为0,则数据Vi产生方式如下:

其中:i=1,2,…,m+n;k(i)是有向无环图中变量Vi的因果次序,也即后面的变量不是前面变量的原因或祖先节点;bij指Vi与其父亲节点Vj的连接强度,也即Vj对Vi的因果效应;噪声εVi是互相统计独立的。遵从SILVA[14]定义方式给出本文研究的具体模型。

定义1(线性隐变量模型)一个模型如果满足以下约束,则为线性隐变量模型:

1)因果马尔科夫假设:任意节点在给定其父母集为条件集时都独立于其非后裔节点。

2)因果忠诚性假设:在模型对应的因果图中,不存在非条件独立性的约束。

3)线性假设:数据产生的关系是线性关系。

4)测量假设:不存在观测变量是隐变量祖先(父母)节点的情况。

5)纯度假设:每个隐变量至少有3 个纯的观测变量。观测变量满足纯度假设意味着观测变量之间没有直接的因果关系,即不存在非隐变量的父亲节点。本文引入纯度假设,是考虑到如果没有任何额外的假设或者先验知识,则无法恢复隐变量之间的因果关系,换言之,隐变量的因果结构不具有可识别性[14]。纯度假设在经典的隐变量结构发现研究中是普遍存在的,且满足很多实际场景需求[14-15]。

定义2(测量模型)[14]给定线性隐变量模型G及其顶点集V,对于一个包含所有顶点集V的子图,子图中有且仅有包含与观测变量集O的有向边,则称此子图对应的模型为G的测量模型。

定义3(结构模型)[14]给定线性隐变量模型G,其子图有且仅有包含隐变量节点及隐变量之间的边,则称此子图对应的模型为G的结构模型。

定义2 和定义3描述了SILVA[14]所提出的经典框架中学习隐变量结构的两个步骤对应的模型。该框架在学习隐变量结构时首先学习测量变量的聚类,定位出隐变量,得到测量模型。在已知测量模型的基础上,才能利用隐变量的测量变量信息学习隐变量的结构,即结构模型。图2(a)所示的测量模型刻画了隐变量和观测(测量)变量之间的关系,其主要考虑受同一个隐变量影响的观测变量。学习测量模型学习观测变量的聚类定位出隐变量,其为学习隐变量结构的前提。在已知测量模型的基础上,利用受隐变量影响的测量变量信息学习隐变量的结构,即结构模型。如图2(b)所示,结构模型刻画的是隐变量之间的结构,这也是本文研究的内容。

图2 测量模型与结构模型示意图Fig.2 Schematic diagram of measurement model and structural model

本文研究的问题是:在线性隐变量模型和纯度假设成立的情况下,如何从任意分布的测量数据中学习隐变量间的因果结构,即如何学习结构模型。图1 是该模型的一个示例,其中L1~L3为变量,代表每个隐变量影响的观测变量,且数据的产生服从线性隐变量模型的假设。本文目标即是根据观察变量{X1,X2,…,X9}恢复出如图2(b)所示的隐变量间因果关系。

3 任意分布下的隐变量结构学习

针对上文提出的问题,同时确保在任意分布下隐变量结构学习是可靠的,本节先给出任意分布下隐变量结构的识别性证明,再基于此理论提出一种融合四分体和三分体约束的算法,学习任意分布下隐变量的因果结构。

3.1 任意分布下隐变量的识别性理论

关于隐变量间的识别性理论,虽然SILVA 等[14]证明了高斯分布下的识别性,CAI 等[15]证明了非高斯分布下的识别性,但是当数据是任意分布时,隐变量间的识别性仍然未知。因此,本文需要先验证任意分布下隐变量因果结构的可识别性,以及确认恢复其结构的最小信息。在给出识别性结论之前,首先给出三分体约束的定义。

定义4(三分体约束[15])在线性结构因果模型中,假设Xi、Xj和Xk是相关的且噪声变量服从非高斯分布,令Cov(Vi,Vj)表示Vi和Vj的协方差,(Xi,Xj)相对于Xk的伪残为如果E(i,j|k)与Xk统计独立,则(Xi,Xj)和Xk满足三分体约束。换言之,如果E(i,j|k)与Xk不统计独立,则(Xi,Xj)和Xk违背三分体约束。

如果变量噪声都服从非高斯分布,那么基于三分体约束,隐变量之间的因果方向是可识别的。如图2 所示,假设所有的噪声都服从非高斯分布,基于三分体约束,对于正向构造三分体约束,如E(X1,X4|X5)与X5互相独立,也即满足三分体约束。对于反向构造三分体约束,如E(X4,X1|X2)与X2互相依赖,则违背三分体约束。因此,在噪声服从非高斯分布的情况下,根据独立性的不对称性可识别隐变量的结构。

从上述例子可知,基于三分体约束的可识别性依赖于非高斯信息所带来的不对称性。而任意分布不一定是非高斯的,以致无法满足基于三分体约束的隐变量间因果发现方法的可识别性。因此,需要确定满足任意分布下的识别性所需的最小信息。在提出可识别性定理之前,先引出D-S 定理:

定理1(D-S 定理[24])定义两个随机变量X1和X2由独立的随机变量εi(i=1,2,…,q)组合而成,即:

如果X1与X2统计独立,那么对于αj βj≠0 的εi是高斯分布。换言之,如果存在非高斯的εi满足αj βj≠0,那么X1与X2统计依赖。下面给出任意分布下隐变量之间的可识别性理论及证明。

定理2假设X={X1,X2,…,Xn}满足线性隐变量模型且纯度假设成立,对于其中任意两个直接相连的隐变量Lx和Ly,如果Lx和Ly之间不存在混淆因子且其中至少一个隐噪声是服从非高斯分布的,那么Lx和Ly的因果方向是可识别的。

证明不失一般性,在Lx和Ly中,假设Ly是非高斯的且Ly指向Lx,正向模型如图3(a)所示。其中:Xi是Lx的测量变量;(Xj,Xk)是Ly的测量变量;方形中的变量代表噪声服从非高斯分布,圆形中的变量代表噪声服从高斯分布,如Ly的噪声服从非高斯分布,Lx的噪声服从高斯分布;变量之间的因果强度不为0。

首先证明对于正向三分体约束独立性成立。此处允许隐变量Ly存在直接的隐变量父亲节点,因为来自父亲节点的因果效应可以合并在Ly的噪声中。

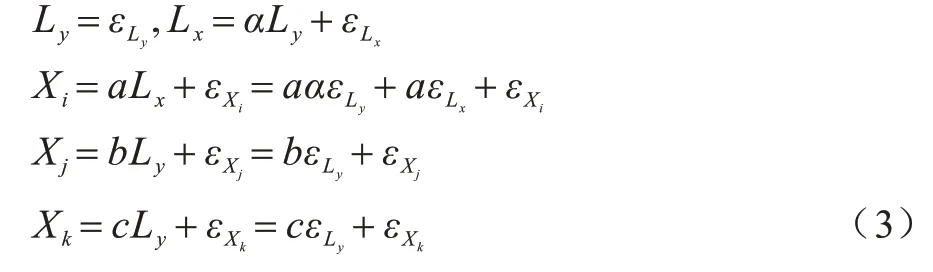

由于变量服从线性无环加性噪声假设,因此有:

其三分体残差为:

由式(4)可知,残差E(i,j|k)包含Lx的噪声及Xi和Xj的噪声。由于Xk包含Ly的噪声和Xk的噪声,而它们没有共同的噪声,因此统计独立,三分体约束成立。

相似地,反向模型如图3(b)所示,可以表示为:

图3 正反向模型示意图Fig.3 Schematic diagram of forward model and backward model

残差E(i,j|k)包含的噪声项有Lx、Ly、Xi和Xj,而Xk包含的噪声项有Lx、Ly和Xk。由于因果强度不为0,因此残差包含Ly的噪声。根据假设,Ly的噪声是非高斯的。由D-S 定理可知,它们包含共同的非高斯噪声Ly,因此,三分体独立性不成立。

根据正反向模型中三分体独立性的不对称性,其因果方向可识别,定理得证。

定理2 提供了任意分布下两个隐变量之间的识别性条件。本质上,定理2 是三分体约束的拓展。笔者通过研究发现,隐变量的识别性只依赖于隐变量噪声的非高斯性,而不依赖于观测变量的分布性质。此外,对于两个隐变量的可识别问题,最少只需要其中一个隐变量的噪声是非高斯的,也即只要其中一个噪声分布是非高斯的,则对于隐变量三分体约束的不对称性亦可成立。此处需要假设没有混淆因子的影响是因为存在混淆因子时伪回归的残差估计不准,从而使得正向定向的三分体残差与辅助变量不独立,也即独立性的不对称性被破坏。换言之,当存在混淆因子且有充足的非高斯信息时,正向三分体约束和反向三分体约束都不成立。

3.2 任意分布下隐变量因果结构学习算法

基于任意分布下隐变量因果结构可识别性理论,本文提出一种融合四分体和三分体约束的适用于任意分布的隐变量因果结构学习算法。

三分体类方法在任意分布下失效的主要原因是其在学习隐变量因果结构的第一个步骤中就学到了错误的隐变量,在学习测量变量聚类以定位隐变量时,三分体约束在高斯分布下不再具备不对称性。而对于四分体类方法,当每个隐变量都有至少3 个纯的测量变量时,只需要利用测量变量的协方差信息便可学习到隐变量的部分结构信息,如定位出隐变量、学习隐变量的骨架图等。四分体类方法可以学习到隐变量,并且进一步得到隐变量之间的d 分离等价模式。隐变量间的d 分离等价模式是刻画隐变量d 分离等价类的一种图表示方法,隐变量的d 分离等价类指一些包含同样的条件独立性约束的隐变量的图,隐变量的d 分离等价模式则是这些等价图合并后的一个部分有向图。在一个关于隐变量的d 分离等价模型中,每一种可能的边的定向都是一个d 分离等价类。

虽然四分体类方法不需要非高斯假设,能够为三分体类方法提供部分隐变量结构信息,但是直接将两者结合是不可行的,主要原因在于:即使已知隐变量的部分结构信息,仍然无法区分哪些边是可识别的,特别是无法区分三分体约束成立是由于正确定向还是由于缺少非高斯信息,这将会导致错误定向(因为在没有非高斯信息时,反向的三分体约束也成立)。笔者发现,通过四分体提供的部分结构信息(如隐变量结构d 分离等价类)并结合定理2,能够有效利用四分体类方法得到的结构信息,因此,给出以下推论:

推论1对于隐变量结构d 分离等价类,如果其中某个局部结构中因果边的三分体约束不成立,那么该等价类与真实结构图不一致。

推论1 实际上是定理2 的拓展。在任意分布下,对于两个隐变量之间的三分体约束,虽然对于两个隐变量噪声都服从高斯分布的情况,正反向模型的三分体约束都成立,但是如果存在非高斯信息,由D-S 定理可知,其非因果方向的三分体约束是一定会出现冲突的。根据此性质,推论1 成立。同时这也说明:如果假设本局部结构与真实局部结构相同,那么三分体约束在非高斯噪声下会成立;如果本局部结构与真实局部结构不同,那么三分体约束在非高斯下必然冲突。而在噪声是高斯分布的情况下,三分体约束无法拒接本局部结构,由于缺乏非高斯信息,因此三分体约束无法帮助识别隐变量之间的因果方向。

基于上述分析,本文提出一种改进算法,实现在任意分布下正确学习隐变量的因果结构,算法伪代码如算法1 所示。本文算法主要在现有算法(如BPC、MIMBuild[14])学到的隐变量的骨架基础上,推断可识别的边的方向。通过枚举所有d 分离等价类,基于推论1 检测每一个等价类中蕴含的三分体约束。在本文算法中,剔除先序节点影响的方法与文献[15]三分体相关研究中所提出的方法一致。当隐变量的结构图中每一条边都有足够的非高斯信息时,本文算法输出的是唯一的结构图,也即隐变量的结构是完全可识别的。

为便于表示,首先进行符号定义。令Lx和Ly代表任意两个隐变量,(X1,X2) 为Lx的测量变量,(Y1,Y2)为Ly的测量变量。特别地,对于Lx→Ly,如果E(X1,Y1|X2)⊥X2,那么称其满足三分体约束。

算法1任意分布下的隐变量结构学习算法

如算法1 所示,本文首先利用现有的方法学习测量模型和隐变量的骨架,然后在给定的隐变量骨架基础上进一步确定隐变量的因果方向。需要注意的是,由于无法得到隐变量的分布信息,因此需要枚举等价类进行判断。如算法第3 行~第14 行所示,对于每一个等价类,从根节点出发,依次判断与根节点直接相连的因果方向的三分体条件。由于根节点与其他节点之间不存在混淆因子,因此根据定理2 和推论1,如果三分体条件冲突,那么本局部结构与真实结构不一致,从而拒绝本等价类,否则对本等价类中其余节点移除来自根节点的影响,更新等价类,找到新的根节点,重复以上步骤。最后,对于未被拒绝的等价类(主要是因为对于不存在非高斯信息的局部结构,基于三分体约束无法拒绝错误的因果方向)进行冲突边合并,将在不同等价类中因果方向不一致的边置为无向边,避免错误定向。

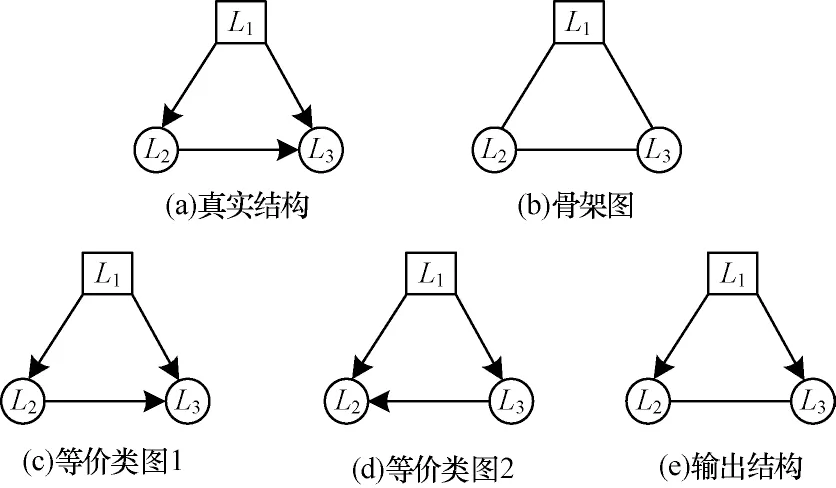

以图4 为例说明本文算法。为了方便起见,忽略每个隐变量下面的观测变量,默认假设每个隐变量下面都有至少3个纯的观测变量。图4(a)代表真实的隐变量结构。在算法的第一步骤中(算法第1 行~第2 行),通过基于四分体的算法先得到隐变量的骨架图,如图4(b)所示,其中包含了隐变量的d分离等价模型。在算法的第二步骤中(算法第3 行~第12 行),枚举隐变量等价图并判断每一个图中的三分体约束。若存在三分体约束冲突,则拒绝,否则保留。图4(c)、图4(d)代表本文算法未能拒绝的隐变量等价类图。其中,由于L2和L3的噪声是高斯的,因此边L2和L3的因果方向无法识别。算法的最后一步(算法第12 行~第14 行)对剩余的无法拒绝的等价图进行合并,图4(e)代表本文算法最终的输出结果。通过合并图4(c)和图4(d),将L2和L3的冲突边置为无向边,代表这条边是不可识别的。

图4 算法示例Fig.4 An example of the proposed algorithm

对本文算法进行复杂度分析:算法主体部分,复杂度受隐变量个数和隐变量骨架图边数约束。令N为隐变量的个数,P为隐变量骨架图的最大边数,那么在最坏的情况下,算法的复杂度最高为N!×P+N!。由于这是在最坏情况下的上界,其假设在N和P最糟糕的情况下整个隐变量的结构中都是服从高斯分布的,不存在等价类的局部结构能被三分体约束拒绝,因此需要测试所有的等价图(等价图个数本质上是关于隐变量个数的全排列)及每个等价图中边的约束。而在实际情况下,由于存在局部非高斯信息,多数的等价类并不需要测试P条边的三分体约束即被拒绝。

4 实验

为了验证本文算法的有效性,分别使用仿真数据集和真实数据集对算法进行评估。将本文算法和MIMBuild[14]、LSTC[15](基于三分体约束的学习隐变量结构的算法)这2 种经典的隐变量结构学习算法进行对比。

4.1 仿真数据集实验

在仿真数据集实验中,设置以下控制变量:隐变量数为{4,5,6},相应的观测变量的维度为{12,15,18};同时设置非高斯分布占比为{20%,35%,50%,65%,80%},对比的样本数量为{1 000,2 000,3 000,4 000,5 000}。每次实验都根据线性隐变量模型随机生成不同的隐变量的因果结构,且每个隐变量下有3 个纯的测量变量,变量之间的因果强度系数在[-2,-0.5]∪[0.5,2]中随机产生。在相同的参数设置下进行50 次实验。

评价指标选择为传统的准确率、召回率和F1 值,计算公式分别如下:

其中:TP代表在学到的邻接矩阵信息中预测正确的定向的数量;FN代表将正向预测为反向或无向的数量;TN代表将反向预测为正向的数量。

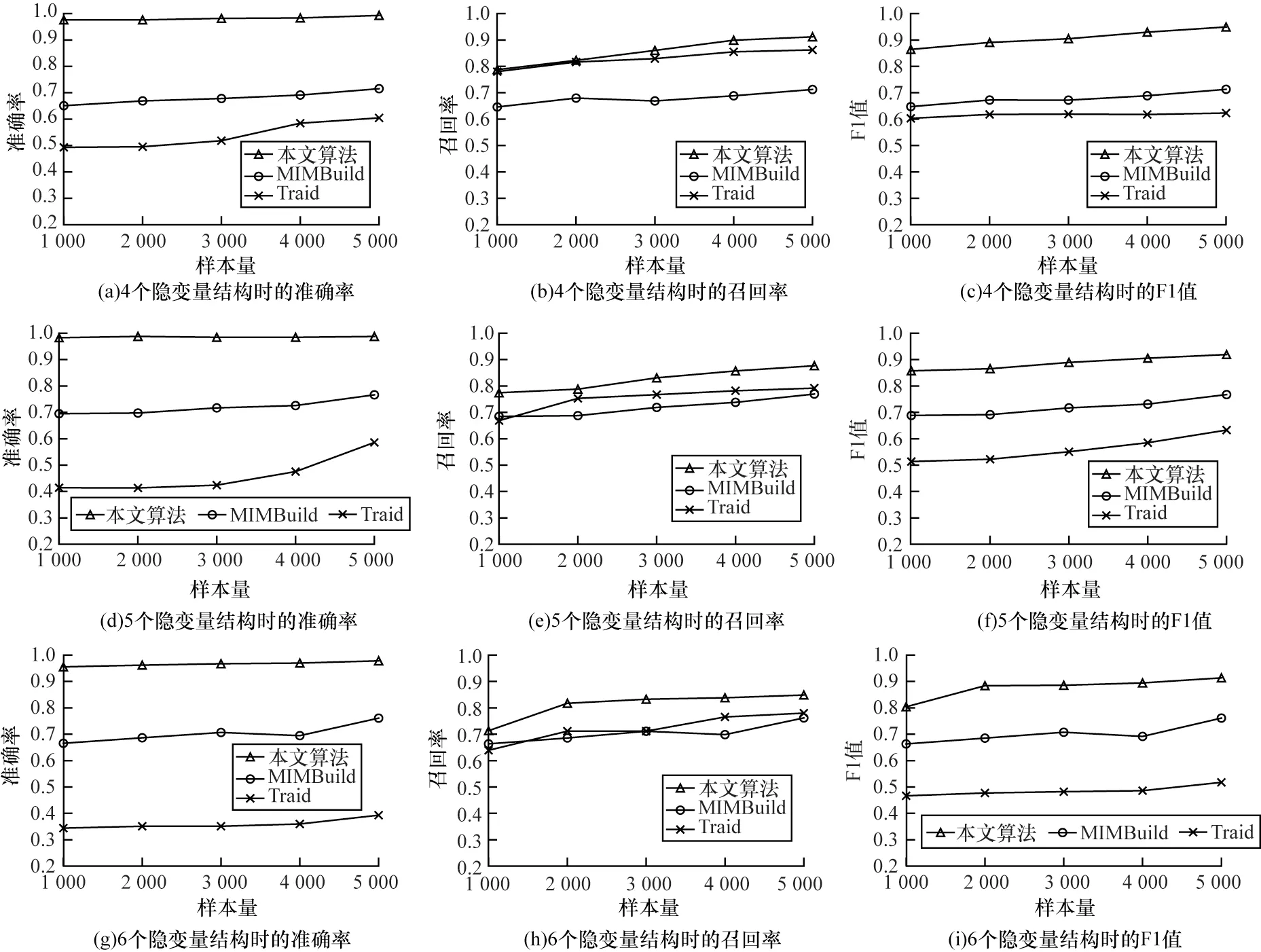

1)验证本文算法在任意分布不同隐变量维度下对隐变量结构的学习能力。设置非高斯占比为80%,因果图的平均入度为2,实验结果如图5 所示。可以看出:在不同的隐变量维度和样本量中,本文算法取得了最优的结果;同时,随着样本增加,算法性能逐步提升,这表明本文算法在任意分布中具有较好的恢复隐变量结构的能力;而当隐变量数量增加时,网络结构也变得复杂,算法性能逐渐降低,这是因为因果结构越复杂,其中测量变量中的混合成分越多,独立性测试工具的性能也随之下降,随着样本量的继续增大,其效果也会继续上升至理想的状态。

图5 不同隐变量时的性能评价指标Fig.5 Performance evaluation indexes with different latent variables

2)验证本文算法在任意分布不同非高斯占比下对隐变量结构的学习能力。设置隐变量的个数为5,每个隐变量下有至少3 个测量变量,平均入度为2,且固定样本量为3 000,实验结果如图6 所示。可以看出:随着非高斯占比的增加,本文算法的F1 值在不断增加,也即学习到的边越多,这是由于非高斯占比的增加可以为隐变量的因果关系发现提供更多的信息,从而使得可识别的边随之增加;相比之下,MIMBuild 方法并没有利用非高斯性去识别隐变量的因果方向,因此其性能随非高斯占比的变化并没有出现太大的波动;此外,本文算法的准确率较为稳定且优势明显,这也验证了算法较强的鲁棒性。

图6 不同非高斯占比时的性能评价指标Fig.6 Performance evaluation indexes with different non-gaussian occupancy ratio

3)设置关于CPU 时间耗度的对比实验。为更有效地体现出本文算法学习隐变量因果方向的时间耗度,在本部分实验中给定隐变量的测量模型和骨架(也即基于BPC 学习测量模型和基于MIMBuild学习骨架图的时间耗度不算入本文算法的时间消耗)。设置隐变量个数为{4,5,6},每个隐变量下有至少3 个测量变量,平均入度为2,且固定样本量为500,实验结果如图7 所示。可以看出:相较于对比方法,本文算法并不是最快的方法,这是因为本文算法是解决任意分布的情况,由于另外两种对比方法有分布的先验信息,而本文算法是在没有分布先验的情况下进行实验的,因此需要去枚举这些结构,以避免没有非高斯信息时的错误定向。此过程可保证算法的正确性,虽然带来复杂度的上升,但是本文算法具有更好的泛化性能,也即能够在任意分布下学习到正确的因果结构;三分体约束方法(Traid)运行的时间最久,一个主要的原因是该方法在调用独立性测试方法(如HSIC)时所需次数大于本文算法。

图7 时间复杂度对比Fig.7 Time complexity comparison

4.2 真实因果结构数据集实验

选择3 个真实的数据集进行测试。数据来源于公开的真实数据集,分别为efficay[25]、depress[25-26]和Yahoo stock[27-28]。数据集详细信息如表1 所示。

表1 真实数据集结构信息Table 1 Structure information of real data set

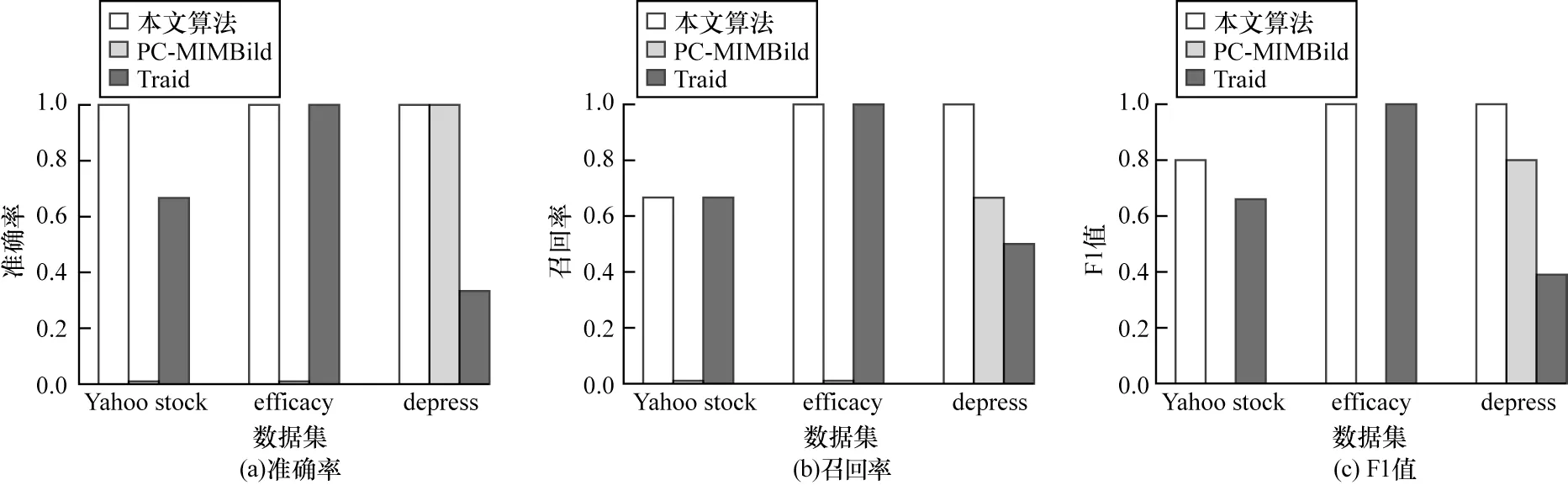

在真实数据集实验中,使用与仿真数据集实验相同的设置,实验结果如图8 所示。可以看出:在不同的真实数据集中,本文算法都取得了较优的效果,相比MIMBuild,本文算法可以学习到更多结构信息,这是因为本文算法利用了高阶信息去学习更多的因果结构,而对于三分体方法,本文算法能够利用结构信息,保证学习到可识别的因果结构;三分体方法在隐变量节点较多时会错误学习到一些结构信息,这是因为三分体方法只能学习到隐变量的因果序列,从而导致引入一些冗余的边及错误确定了一些没有直接因果关系的边的方向;对于比较简单的隐变量结构(如efficay 数据集),由于只有两个隐变量,因此本文算法和三分体方法性能接近,这是因为结构越简单,三分体方法在任意分布下错误会相应减少。总体而言,应用在真实数据集中的实验结果验证了本文算法的有效性。

图8 在真实数据集上的实验结果Fig.8 Experiemental results in real data set

5 结束语

本文分析三分体约束隐变量结构学习的不足和优势,将其拓展到任意分布的情况,提出一种面向任意分布学习隐变量间因果结构的算法。基于四分体约束方法提供的信息,有效融合三分体约束,从而实现在任意分布下学习隐变量的结构。该算法一方面能够解决四分体约束方法无法学习隐变量结构中方向信息的问题,另一方面能够突破三分体约束方法中非高斯过强约束及其只能学习因果序列的瓶颈。实验结果表明,与MIMBuild 和三分体约束方法相比,本文算法能够在保证正确性的同时学习到更多的结构信息。未来将在任意分布且没有结构信息的情况下,研究任意两个隐变量之间的识别性理论,并对算法的应用范围做进一步拓展。