融合转置卷积与深度残差图像语义分割方法

2022-09-15刘腊梅王晓娜刘万军曲海成

刘腊梅,王晓娜,刘万军,曲海成

辽宁工程技术大学 软件学院,辽宁 葫芦岛 125105

图像语义分割将图像分为具有语义信息的区域,其原理是把原始数据作为输入,通过一系列技术操作将它们转换为具有感兴趣区域的掩膜。语义分割是处理典型计算机视觉和模式识别领域的关键技术。计算机视觉中场景理解和行为识别的关键任务是通过语义分割为图像的每个像素标注所属的类别信息。语义分割依据网络训练方式的不同可分为全监督学习和半监督学习图像语义分割,当前主要应用于机器人感知、自动驾驶、人脸分割、医疗影像分析、地表地质检测、精准农业、遥感图像处理等领域。

早期图像语义分割主要使用的是聚类算法,为了使图像语义分割在深度学习领域快速发展,Long 等人提出一种端到端的全卷积网络(fully convolutional networks,FCN),FCN 以CNN 为基本架构将最后一层的全连接层替换为卷积层,FCN 解决了传统模型重复存储和卷积计算的问题,提高了语义分割的精度。但FCN 中池化操作会降低特征图的分辨率,Ronneberger等人基于FCN 模型提出了一种网络模型U-net。针对自动驾驶中场景理解存在的图像语义分割精度低问题提出了一种Encoder-Decoder 的卷积神经网络SegNet,SegNet在FCN 的基础上增加了池化层。近几年,图像语义分割较为常用的算法是由Google 公司提出的DeepLab 系列方法。DeepLabv1利用DCNN 和FCCR(fully connected conditional random field)提高了深度网络定位的准确性;DeepLabv2利用扩张卷积和ASPP(atrous spatial pyramid pooling)解决了图像语义分割存在分辨率低的问题,进一步改善了语义分割的效果。在DeepLabv1与DeepLabv2的思想基础上提出了DeepLabv3,主要应用于超声图像分割,ASPP 可以捕获多尺度的图像信息,但缺乏浅层图像精细的位置信息,因此DeepLabv3+对网络继续优化,将DeepLabv3 作为解码器,增加了编码器结构,恢复了边界细节且提高网络的运行速率,平衡了语义分割的精度和速度。DeepLab 系列有效扩大网络的感受野,多个尺度捕获图像的上下文信息,提高了语义分割的空间精度。

迄今为止,深度卷积神经网络在分割精度上取得了很大的进展,其中一个研究方向是通过增加网络的深度、增大复杂度来提升分割精度,但随着智能设备的发展,对网络模型、算法复杂度、效率提出了更高的要求,因此通过降低算法复杂度、减少参数以提升网络的效率,Zhao 等人提出了图像级联网络(image cascade network,ICNet),限制图片输入的尺寸,减小计算量,以提高网络的推理速度,但由于边界处空间细节的丢失,导致分割精度下降。除此之外,Paszke 等人提出了ENet,通过剪切通道来减少网络的参数,提高模型的分割速度,由于下采样提取的信息缺乏细节特征,导致这些方法在损失精度的前提下才能实现提高速度。为了获取更丰富的细节特征,使用U 型结构提高空间分辨率,补充了细节信息,U-net 在医学图像分割和其他图像语义分割领域都得到了专家学者的广泛应用。近年来,较为成功的是将U-net 模型应用于Kaggle Carvana 图像语义分割竞赛对KITTI 数据集中背景和车两种类别的分割问题上,在处理二分类问题时语义分割精度达到了98.9%,损失率降低到0.02。利用U-net 解决了模型对大量样本和计算资源的需求,但是处理多分类问题却只能达到76.8%,损失率只达到1.43,且分割物体存在混淆。当前,针对缺乏空间细节特征,导致精度低的问题,Zhang 等人在U-net 框架的基础上设计了深度残差模块,提出DResUnet对遥感图像进行语义分割取得了好的分割效果。改进的U-net++通过叠加不同层次的特征,缩减了网络参数量,提升了分割精度。综上,以U-net网络模型为基准,融合深度残差网络学习模块、转置卷积、Dropout提出了一种处理图像语义分割多分类问题算法,命名为TDDResUnet。算法获得了高的语义分割精度、低的损失率,对比原U-net 图像语义分割网络模型,多分类效果得到了明显的提升,有效提升了算法的鲁棒性。

1 基本原理

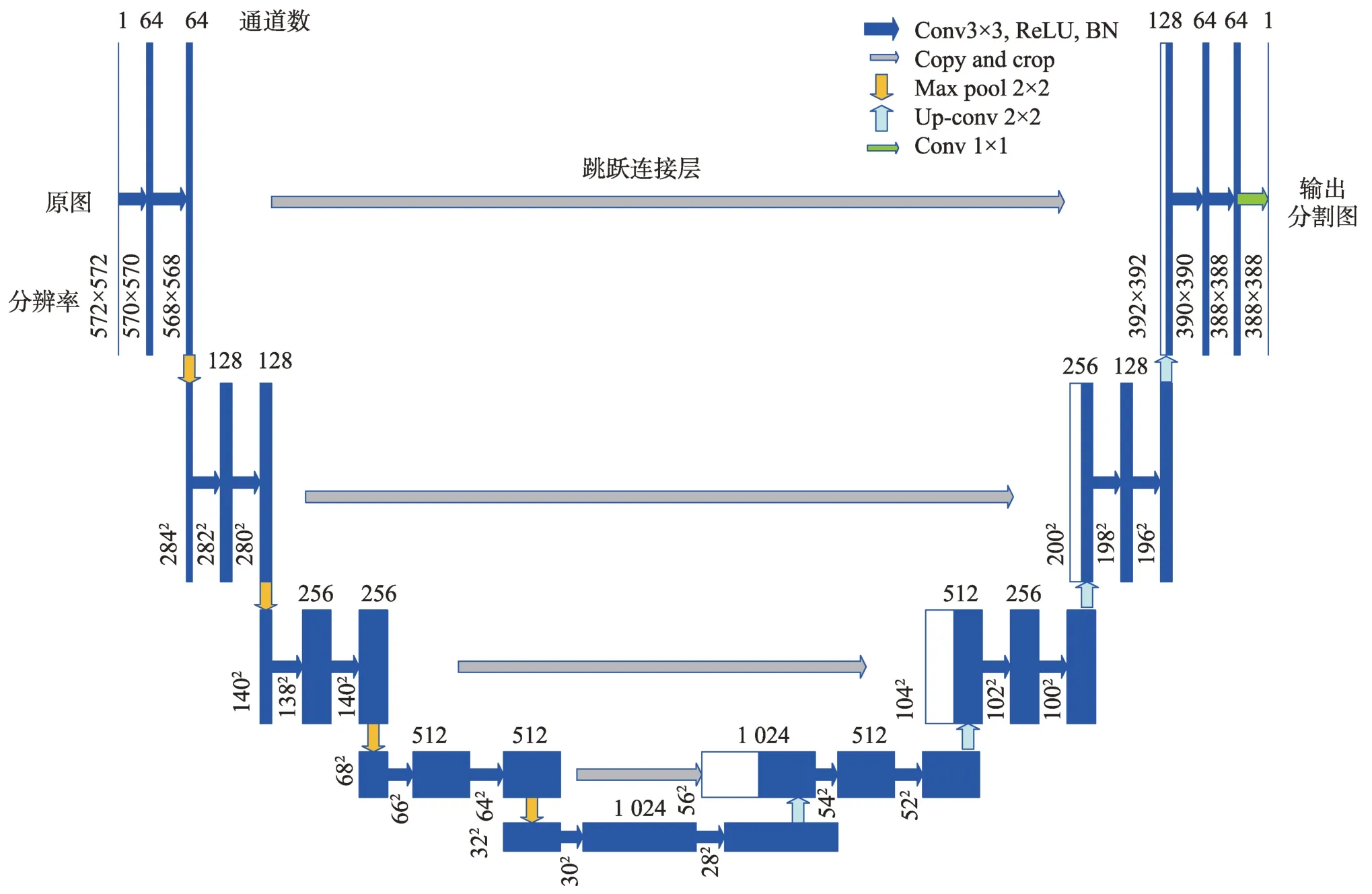

1.1 U-net算法原理

图像语义分割为了获得更好的分割效果,将基于编码-解码器的U 型网络模型U-net 应用到语义分割领域,在保留低层特征信息的同时,也保留高层语义信息。U-net 由收缩路径和扩展路径两部分组成,U-net 是FCN 模型的一种变形,主要有编码器、跳跃连接和解码器,U-net网络模型结构如图1 所示。

图1 U-net模型结构Fig.1 U-net model structure

编码器位于模型左侧用于提取图像的空间特征,包含四个子模块的编码器,每个输入模块图像分辨率为572×572、284×284、140×140、68×68 与32×32,卷积块包含两个3×3 卷积,然后进行最大池化,通过下采样操作捕捉上下文信息逐层提取图像中目标特征。解码器位于模型右侧,解码器对编码器的特征构造分割图,包含四个子模块的解码器,通过反卷积进行上采样操作恢复物体的细节和图像分辨率,反卷积操作先通过UpSampling2D 将图片尺寸扩大两倍,执行2×2 卷积将通道数缩小为一半,然后执行3×3 卷积运算,最后执行1×1 卷积逐个对图像的每个像素点进行运算生成最终的分割图。U-net网络主要特点是跳跃连接层,跳跃连接层将编码器中的输出传输到解码器,它将上采样的结果与编码器中具有相同分辨率的子模块的输出进行串联,将级联后特征图作为下一个子模块的输入,尽可能保留更多的细节,提高分割的分辨率和边缘的准确度,Unet解决了语义分割对样本量和计算资源的需求。

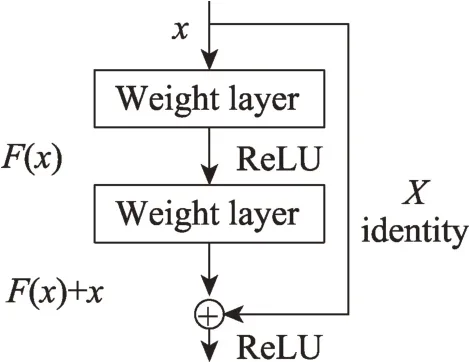

1.2 深度残差网络

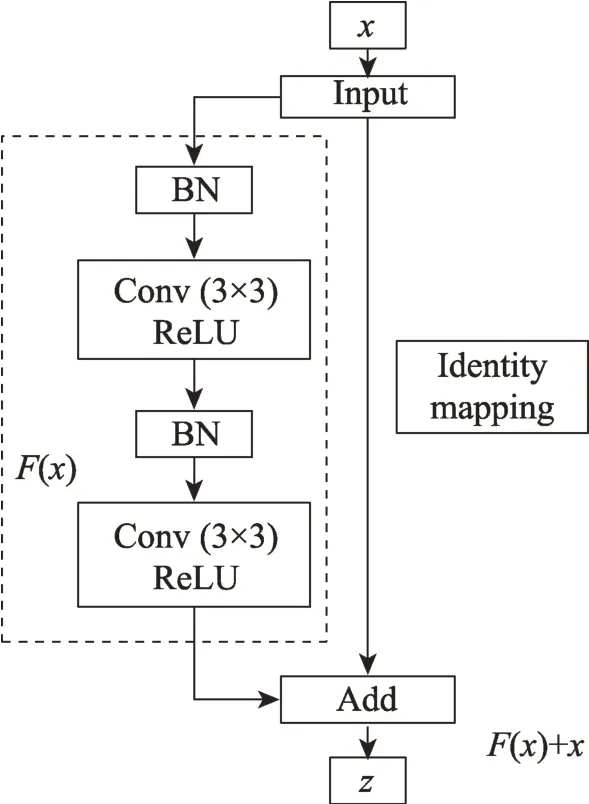

深度学习中,深度残差网络(deep residual network,Deep-Resnet)是为了解决随神经网络深度增加出现网络性能退化的问题。这种退化问题体现在准确率先持续上升然后达到饱和,当网络深度持续增加时,准确率会下降。深度残差网络利用简洁的残差学习模块训练深层网络,解决了随着网络深度的加深造成的学习率低、准确率无法提升的问题。残差学习模块如图2 所示。

图2 深度残差学习模块Fig.2 Deep residual learning module

Deep-Resnet 的思想继承了残差网络中增加直连通道的思想,延续了Highway Network。它也由两种mapping 形式构成,一种是identity mapping,另一种为residual mapping,最后的输出为:

前一种指本身,即公式中的。而后一种指残差,表示为(-),新增加的层仅需在原输入的基础上学习新特性,即学习残差()。残差特征学习比原始学习更容易,当残差为0 时,堆积层只做恒等映射,输出在不增加任何参数的条件下跳过本层直接输给下一层网络。在实际操作时()不会为0,这使得堆积层学习到新的特征获得了更好的性能。

1.3 转置卷积

转置卷积(transposed convolution,TC)与反卷积相似,但不是真正意义上的反卷积,反卷积可以通过卷积输出信号完全还原为输入信号。而转置卷积原理是将输入的尺寸放大,只能还原到原输入大小,但信号值有所变化。图像处理中上采样的方法有多种,如最近邻插值、双线性插值、转置卷积等,其中,转置卷积是一种较优上采样方法。转置卷积在语义分割或超分辨率的任务中常用于对CNN 中特征图进行上采样,当前在语义分割领域应用较为广泛。转置卷积是将普通卷积操作中的卷积核转置,转置卷积形式上相当于一个卷积层的反向梯度计算,在计算过程中相比卷积先将权重矩阵转置,然后左乘输入。转置卷积有两个重要的特性:首先是转置的卷积核变为普通卷积核的转置,其次如果把输入到输出特征图的计算过程画成一个计算图,输入输出的连接关系是不变的。

设一个卷积核为,输入维列向量,卷积过程与转置卷积可以表示为:

转置卷积与普通卷积的本质建立于值之间的映射关系,输入与输出的关系被反向处理。转置卷积不会增加感受野的大小,它仅是学习一个特征点的内容,然后映射到卷积核,因此卷积核上所有点的感受野保持不变,在其后面加入多层的卷积,会扩大感受野的范围。因此在上采样中使用转置卷积可以通过学习方式得到更高的精度。

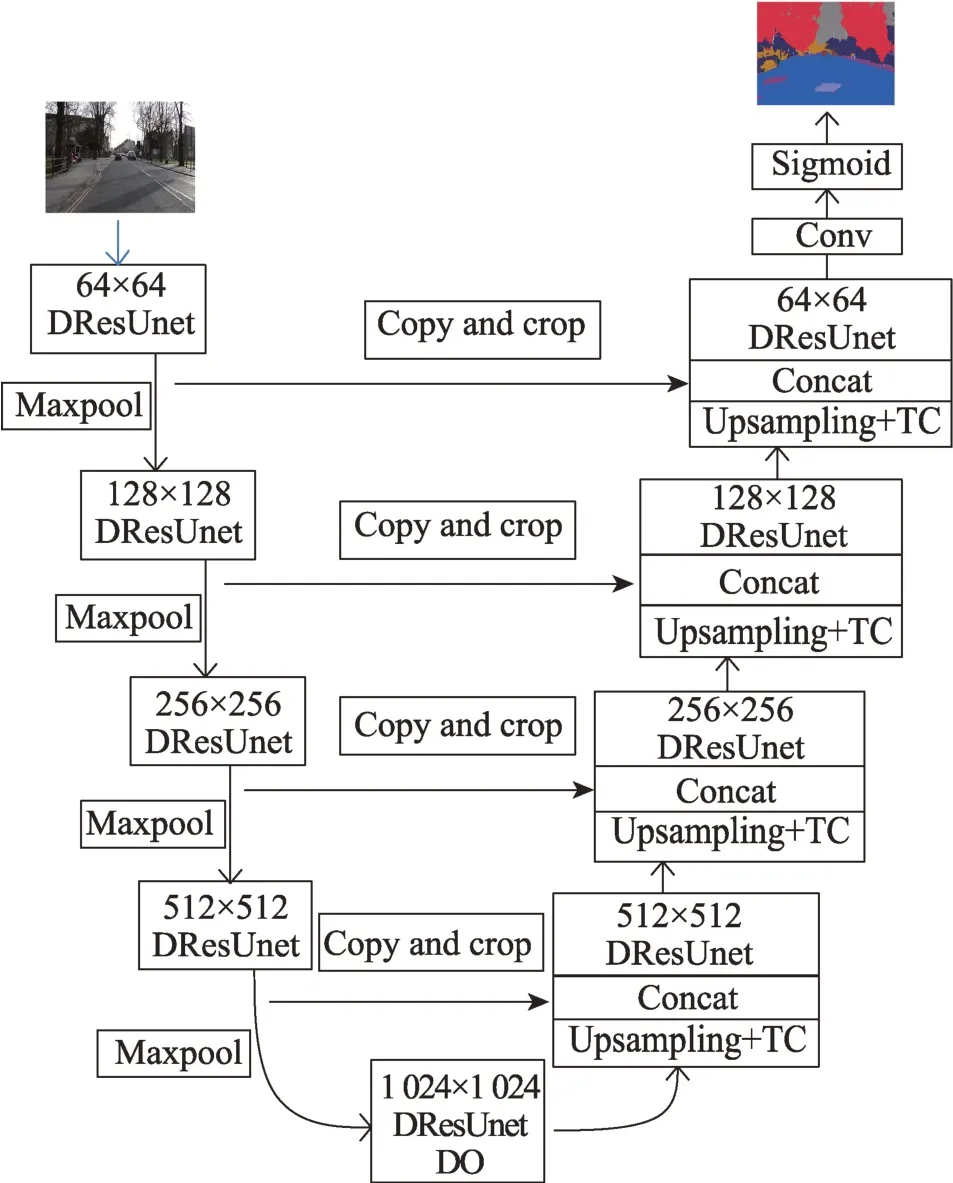

2 TD-DResUnet算法原理

U-net 模型将FCN 的全连接层替换为卷积层进行上采样,使上下文信息向更高分辨率传播,网络呈U 型对称结构。U-net 模型对于图像语义分割二分类问题上取得了较好的分割效果,但是对于图像语义分割多分类问题上却存在语义分割精度低、损失率大、分割效果差的问题,相比二分类语义分割精度提升了22.1 个百分点,损失率降低了1.41。针对上述问题,对U-net模型进行三方面的改进:

(1)在U-net模型上融合了深度残差学习模块;

(2)将深度残差U-net 模型中UpSampling2D 和转置卷积两种上采样方式拼接,形成新的上采样模块;

(3)在模型的跳跃连接层融合Dropout(DO)。

改进的U-net整体框架如图3 所示。

图3 改进的U-net整体框架Fig.3 Improved overall framework of U-net

2.1 Deep-ResUnet(DResUnet)

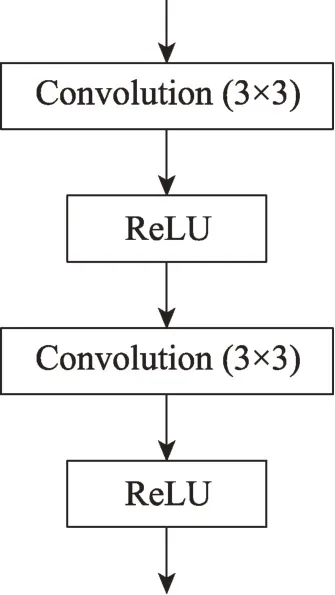

本文模型在U-net 模型上进行设计,保留其编码再解码的结构,U-net 原始模块如图4 所示。在图像的语义分割中,神经网络的深度对于分割结果存在很大的影响,因此传统的方法将网络设计得较深,但网络加深会带来梯度消失问题,降低网络的学习率。为了解决这一问题,He等人提出了残差网络。在Unet 的原始模块的基础上引入深度残差学习模块,残差学习模块不仅结构简单且容易学习,残差学习模块的引入解决了随着网络深度增加,学习率低、准确率无法提升、模型计算复杂度高的问题。Deep-ResUnet 模块如图5 所示。Deep-ResUnet 模块第一层残差单元模块先进行卷积操作,再进行BN(batchnormalization)提高算法收敛性。

图4 U-net原始模块Fig.4 U-net original module

图5 Deep-ResUnet模块Fig.5 Deep-ResUnet module

Deep-ResUnet模块表达为:

式中,表示残差网络单元的输入,表示残差单元的输出,(·)表示残差机制,()层提取特征之后得到新特征,此时已结合了浅层的信息,获得的特征会更加丰富且有利于分割。引入残差Add 运算不仅不会增加计算量和额外的参数,而且大大提高模型的训练速度,提升训练效果。当模型的层数加深时,这个简单的结构使训练难度降低,解决网络退化问题,也使得优化网络的同时有效提升了它的准确率,提高了学习率,降低算法计算的复杂度。

2.2 TC-DResUnet

以U-net模型框架为基础进行设计,U-net模型先经过下采样提取图像的特征,然后使用上采样操作还原图像的分辨率,从而提高低分辨率图像的分辨率。U-net 模型将上采样过程定义为Up-Conv,先用UpSampling2D 将图片扩大到需要的尺寸,然后进行卷积操作。FCN 在上采样过程中使用转置卷积不仅将特征图放大到原图的尺寸,还能得到更加精细的分割效果,转置卷积优点在于它的权值是可以学习的,没有使用预先定义好的下插值方法。转置卷积将卷积核转置后与矩阵相乘,通过卷积运算来实现分辨率的还原,它能够学习到较优的特征提取方法,从而实现对每个像素的分类。

U-net模型上采样与下采样特征提取后对应通道数相同尺度特征图拼接,由于在下采样过程每一个特征提取阶段会损失掉一部分特征信息,需通过上采样过程还原图像的分辨率。为了达到好的还原效果,以U-net 框架为基础,将U 型网络解码器模块中UpSampling2D 和转置卷积进行拼接,形成新的上采样模块,命名为Up-Tconv。该模块利用UpSampling-2D 将图片尺寸扩大两倍,然后将卷积核转置后与矩阵相乘,通过卷积运算来实现分辨率还原的操作,使粗略图像的分辨率得到较好的恢复,从而使得上采样过程与特征提取过程中特征图融合的精度更高,损失率更低且提升网络的鲁棒性。

2.3 Dropout

为了防止网络模型在训练过程中权值过度拟合,增强网络的学习能力。在DResUnet 的第五层跳跃连接中引入Dropout,Dropout 服从的是二项分布。Dropout 原理是在网络训练阶段,网络的残差模块需要按照一定的概率将其暂时从网络中丢弃,由于是随机丢弃,故在训练不同的网络模块时都存在一个mini-batch,使得迭代的前向和后向传播只有部分权值学习。本文设置隐含节点的Dropout 率为0.5,即一半神经元在工作。这是由于当Dropout 率为0.5时,模型随机生成的网络节点最多,实验取得效果也是相对较好的。

3 实验结果与分析

3.1 实验数据及参数配置

本文网络模型是在Windows10 平台上使用深度学习Keras 框架实现的。实验使用计算机的主要配置 是64 GB 内 存、64 位OS,IntelCorei7-8700 CPU@3.20 GHz 3.19 GHz 的x64 处理器。本文使用的数据集是剑桥自动驾驶视频数据库(Cambridgedriving labeled video database,CamVid),该数据集包含701 张带注释的图像,32 个ground truth 语义标签,数据集的分辨率为960×720。CamVid 是第一个带有对象类语义标签和元数据视频的集合。CamVid解决对实验数据的需求,以定量评估新兴算法,从视频序列中提取著名街景数据集,增加了观察对象类的数量和异质性。

网络模型在训练或预测之前,先对图片进行预处理,将大小为(480,360)图片归一化处理为(512,512)。当进行训练模型时把数据分为训练集、验证集和测试集3 个类别,其中367 张图片用于训练,101张图片用于验证,233 张图片用于测试。实验选取图像中的12 个类别进行分类,其中包含天空、建筑物、圆杆、道路、树、行人、自行车等12 类物体。实验将输入图像的尺寸设置为(512,512,3),在深度残差网络模块算法中使用的激活函数为ReLU。Steps_per_epoch表示每次迭代包含的步数,validation_steps 表示验证集上的step 总数,epoch 表示所有样本训练的次数,在网络模型训练时,实验参数设置为Steps_per_epoch=200,validation_steps=10,epochs=30。

3.2 算法指标及优化函数

实验中损失函数的选取直接影响到网络的训练结果,损失函数有助于优化网络的参数,训练深度卷积神经网络的目的就是寻找损失函数的最优解。目前,语义分割网络模型中较为常用的损失函数是交叉熵函数,表达为:

交叉熵函数是(x)和(x)差异性概率分布,交叉熵函数会随着目标像素标签预测结果概率的降低而增加,交叉熵越大,表示与实际标签差异越大,交叉熵越小,表示预测的结果越理想。当语义分割任务为二元时,使用二元交叉熵(binary cross entropy,BCE)函数,只需一个输出就可将数据分为两个类别。当语义分割任务为多分类时,这时选择使用分类交叉熵(categorical cross entropy,CCE)函数,输出节点必须与类的数量保持一致。无论是二元还是多元语义分割,为了保持最后一层卷积输出值控制在(0,1)之间使用Sigmoid 激活函数。实验针对图像语义分割的多分类问题,采用的损失函数是CCE 函数。

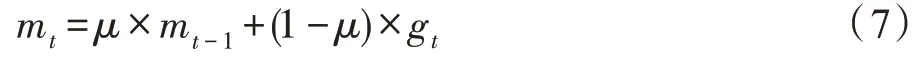

优化算法也影响着网络模型结果,当前深度学习中最常用优化算法是梯度下降算法。其中经典的算法是SGD。随着深度学习知识的不断拓展,SGD算法也不断优化、更新。其中典型算法有:动量梯度下降(Momentum)、自适应梯度算法(AdaGrad)、均方根支柱(RMSProp)、自适应动量优化(Adam)、Nadam等。动量梯度下降与随机梯度算法应用了全局学习率,AdaGrad 能针对于每个参数自适应学习率,但随着网络训练周期的增长,学习率降低得很快。而RMSProp 虽加速了对最小值方向的搜索,但阻碍了在震荡方向的搜索。Nadam 在Adam 基础上融合NAG,但不适用于本实验算法,算法验证集的精度只能达到84.08%,损失率达到了0.378 5。通过验证可以发现,本文算法适宜的优化函数是Adam,优化的参数是1E-4。它的优点主要在于经过偏执矫正后,每次迭代学习率都有个确定范围,使得参数比较平稳。使用Adam 更新规则,先计算时间步的梯度g,计算梯度指数移动的平均数,初始化为0,表示指数衰减率,通常的取值接近于1,默认为0.9,控制权重分配,表达式为:

计算梯度平方的指数移动的平均数,初始化为0,表示指数衰减率,控制梯度平方的影响,默认为0.999,表达式为:

最后一步进行参数更新,初始化学习率,默认为0.001,=10。

3.3 实验结果分析

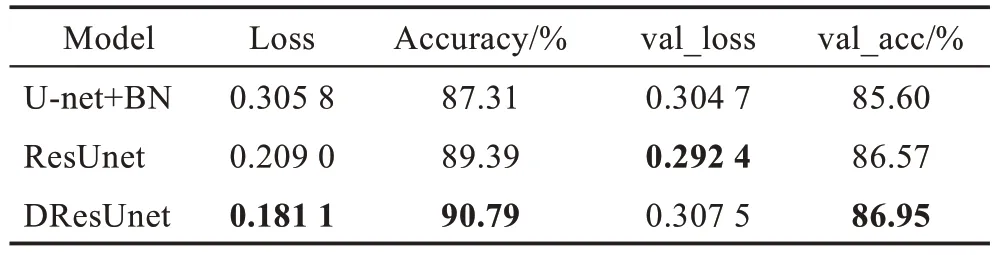

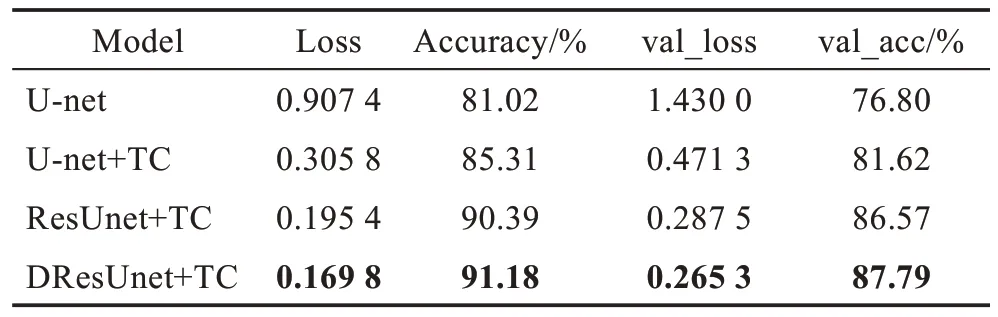

为了验证不同改进模块算法的有效性作了3 组比较,改进的残差模块算法比较见表1。通过分析表中实验数据可以发现,在U-net 模型基础上使用BN简化了参数搜索问题,提升了算法的收敛速度,在Unet 模型卷积块上加入直连通道形成残差U-net(ResUnet)模型,对比效果明显优于U-net模型,在Unet引入深度残差学习模块(DResUnet),深度残差学习模块中使用BN 简化了参数搜索问题,深度残差模块的使用不仅提升了网络训练的效率,而且提高了算法的准确性。

表1 改进的残差模块算法比较Table 1 Comparison of improved residual module algorithm

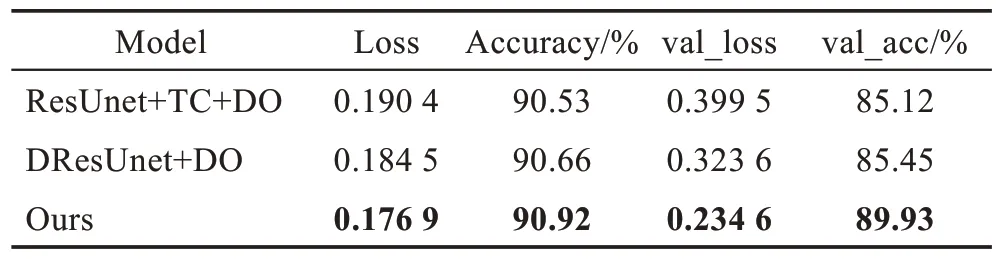

为了验证融合转置卷积模块的有效性,融合转置卷积模块算法比较见表2。本文对U-net 原模型的Up-Conv 模型进行改进,实验将转置卷积(TC)和UpSampling 两种上采样方式进行拼接,通过表中数据可以发现,上采样过程和特征提取之后特征图融合拼接的精度更高,损失率更低,而且提高了算法的准确性。相较于U-net 模型、ResUnet、DResUnet 进行上采样,融合转置卷积使得算法模型的精度和损失率都有明显的提升。

表2 融合转置卷积模块算法比较Table 2 Module algorithm comparison with transpose convolution

在表2 中不加Dropout 率训练集精度能达到91.18%,损失率降低为0.169 8,但是验证集精度和损失率却不太理想,存在过拟合问题。为了验证Dropout有效性,Dropout 模块算法的比较见表3。如果在特征提取之后的每一层引入Dropout,实验精度和损失率整体结果呈发散状态且效果较差。表中第三组在模型第四层和第五层引入Dropout,实验精度才得到较好的改善却没有达到理想状态,这是由于在下采样的第四层中使用Dropout 之后神经元节点之间的联合适应性减弱,从而影响了实验的精度和损失率。但在实验的跳跃连接层引入Dropout 的效果要优于其他的实验结果,验证集精度达到了89.93%,分类效果也很好。

表3 Dropout模块算法比较Table 3 Algorithm comparison of Dropout module

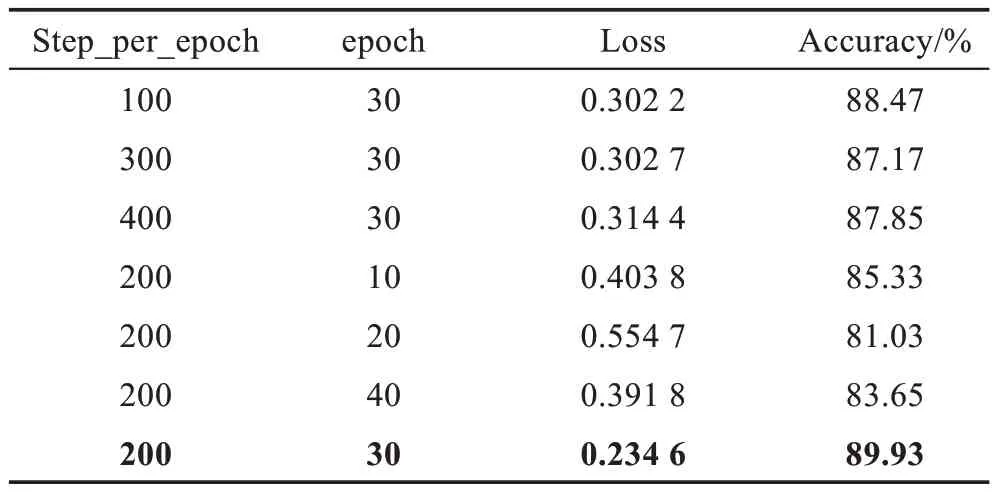

为了使本文算法在相对较优的迭代条件下进行,依据Steps_per_epoch 和epoch 的不同分别作了7类比较,对Steps_per_epoch 为100、200、300、400,epoch 为10、20、30、40 进行了对比,不同迭代次数下损失率与精度对比见表4。分析表中的数据可以发现,相比其他迭代次数,当Steps_per_epoch=200,epoch=30 时,本文算法精度是较高的,损失也降到了最小值,能够达到较好的语义分割效果。

表4 不同迭代次数下损失率与精度对比Table 4 Comparison of loss and accuracy of different iterations

实验统计本文算法迭代30 次过程中,本文算法损失率和精度变化趋势如图6 所示。分析图中数据的变化趋势可以看出,随着迭代次数的增加,训练集的精度和损失率的变化趋势相对比较稳定,Loss 逐渐下降到平缓状态趋于稳定的区间,而Accuracy 逐渐上升至平缓状态。然而测试集随着迭代次数的增加,Loss 与Accuracy 变化趋势存在明显的波动。Unet 损失率和精度变化趋势如图7 所示,从图中可以发现,U-net 模型在训练时,验证集数据波动性较大,稳定性较差。在相同条件下迭代达到30 次时,本文实验算法较U-net 模型精度和损失率得到明显的提升,本文算法具有较强的稳定性。

图6 本文算法损失率和精度变化趋势Fig.6 Loss and accuracy trend of proposed model

图7 U-net损失率和精度变化趋势Fig.7 Loss and accuracy trend of U-net

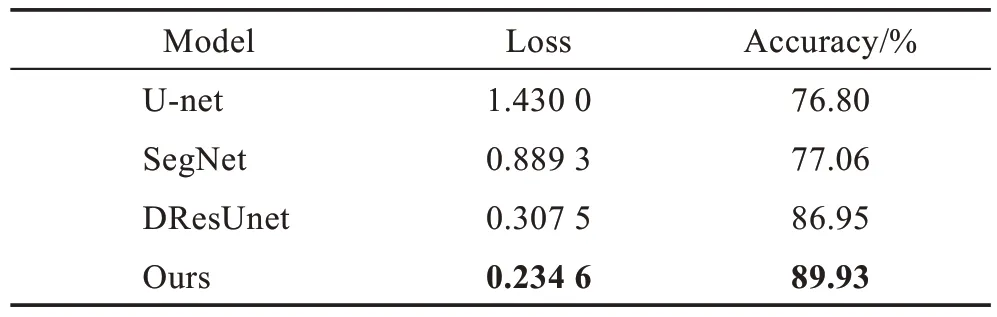

为了验证本文算法对于基于编码-解码器框架图像语义分割方法中的优越性,选取U-net、SegNet、DResUnet与本文算法进行了比较。原U-net 模型是在Steps_per_epoch=300 的条件下进行实验,由表4中实验结果可知,当Steps_per_epoch 为200 时,损失率和精度优于Steps_per_epoch 为300 的损失率和精度。因此,对比实验是在Steps_per_epoch=200 下进行的。定量地分析不同主流模型在相同条件下对于图像语义分割多分类精度的影响,相同条件下不同算法语义分割分类精度和损失率对比见表5。

表5 相同条件下不同算法语义分割精度和损失率Table 5 Accuracy and loss of different algorithms for semantic segmentation under same conditions

分析表中数据可以得出,SegNet 网络依据先验概率计算各个像素点的分类,下采样通过全卷积网络实现,上采样通过反卷积与编码器传输索引融合实现,SegNet 网络的基准分值没有满足实际使用时的需求,在本文算法的实验环境下,SegNet 精度相比U-net 只提升了0.26 个百分点,损失率降低了0.54,性能没有达到较好的提升。DResUnet 精度、损失率变化不大,训练集精度都达到了90%,但是相比U-net验证集精度提升约10 个百分点,损失率降低了1.1。本文算法较原U-net 模型实验精度提升了13.13 个百分点,损失率下降了1.195,解决了网络模型层数加深引起的退化问题。本文算法相较于主流SegNet 与深度学习中DResUnet在损失率和精度方面有较为明显的提升,有效提升了算法的鲁棒性。

基于图像语义分割Camvid 数据集不同场景模式下,网络模型实验效果对比如图8所示。依据上述表5数据可以发现,本文算法在精度和损失率上明显优于其他算法,实验效果图算法模型选取U-net、SegNet、DResUnet 及真值图与本文算法进行了对比。通过实验效果图可以发现,在不同场景模式下,本文算法分割效果比其他三类语义分割算法分割物体的效果更明确,分类的效果更好。

图8 网络模型实验效果对比Fig.8 Experiment effect comparison of network models

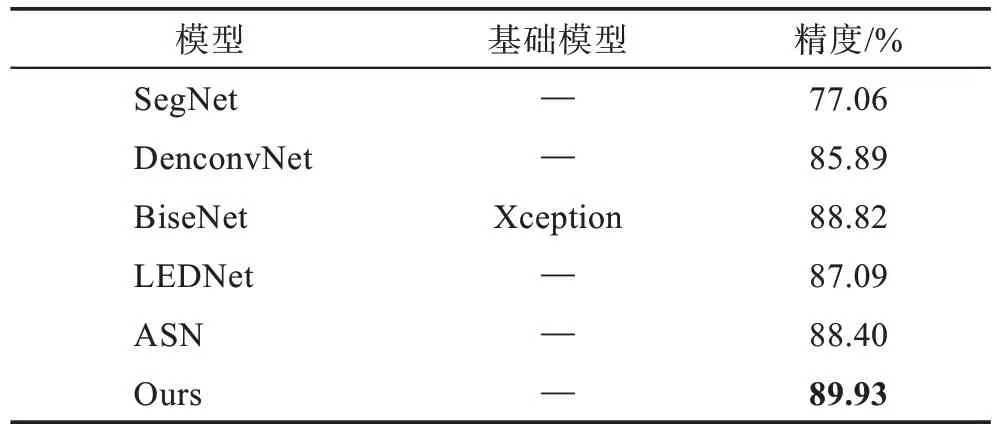

为了验证同一数据集下本文算法精度优于较优图像语义分割算法精度,本文选取SegNet、DenconvNet、BiseNet、LEDNet、ASN五 类 最 新 的算法与本文提出的语义分割算法进行性能上的比较。基于CamVid 数据集语义分割算法对比结果见表6。

表6 CamVid 数据集下最新语义分割算法对比Table 6 Comparison of latest semantic segmentation algorithms based on CamVid dataset

DenconvNet 网络训练时,先预训练简单的数据,再使用复杂的数据进行微调,DenconvNet 将CamVid数据集类别转换为11 类进行图像语义分割,得到语义分割精度为85.89%,DenconvNet相比U-net提升了9.10 个百分点,但是这种训练方式造成目标位置与尺寸信息与原始数据集出现差别,从而达不到好的实验效果。BiseNet 可以整合图像的全局语义信息,降低计算成本,提高了分割速度,BiseNet 是以Xception为基本模型,得到的语义分割精度为88.82%,BiseNet相比U-net 提升了11.09 个百分点,BiseNet 网络实现了实时语义分割。LEDNet 使用了不对称的编码-解码器机制实现实时语义分割,LEDNet 语义分割精度为87.09%,LEDNet 相比U-net 提升了10.29 个百分点,但网络结构较为复杂。ASN 模型以ResNet-34 为基础网络进行了两次融合实验,通过特征提取阶段的优化解决了尺度变化的问题,使用注意力机制为特征图的不同通道分配权重,提升网络的分割精度,ASN 相比U-net 提升了11.60 个百分点,但ASN 对细小物体分割效果不佳,模型比较复杂。

在相同数据集的条件下,本文算法相比U-net 模型,精度提升了13.13 个百分点,损失率降到0.23,继承了编解码器方法的优势,避免了特征提取造成分辨率低的问题,精确地还原了像素的位置信息以及空间维度信息。通过表中数据和分析发现,本文提出的图像语义分割多分类算法在语义分割精度上明显优于其他几类模型算法。

4 结束语

本文模型针对常规深度学习中的图像语义分割多分类精度低、损失率高的问题,提出了一种融合转置卷积与深度残差图像语义分割方法多分类方法。在U-net 框架基础上引入深度残差学习模块,融合深度残差模块解决了深度网络模型学习率低、准确率无法提升的问题,提升了网络的训练效率和收敛速度;改进深度残差U-net 网络中上采样方式是原上采样UpSampling2D 和转置卷积的结合,新形成的上采样模块使网络模型便于计算,解决了上采样与特征提取过程对应通道相同尺度特征融合拼接的精度低、损失率高的问题,同时提升了网络的鲁棒性;最后在网络的跳跃连接层引入Dropout,解决了网络模型训练过程中权值过度拟合的问题,增强了模型算法的泛化能力。但是Dropout 存在消除减弱了神经元节点间的联合适应性的缺点。虽然本文算法相较于U-net 多分类有很大的提升,但是,它训练的时间没有得到很好的改善,没能达到实时性语义分割。在此后的实验中可以重点从算法的实时性入手,同时,精度、损失率方面仍还存在提升的空间。