基于图像配准的无人飞行器视觉定位

2022-08-20毛明洋韩松臣梁斌斌

毛明洋,韩松臣,梁斌斌,2

(1.四川大学空天科学与工程学院,成都 610065;2.四川川大智胜软件股份有限公司,成都 610045)

0 引言

无人飞行器的定位导航中,卫星导航一直占据主导地位。但卫星导航的定位精度和范围受到卫星覆盖精度范围影响。当卫星信号受到电子干扰或多路径效应时,导航精度下降甚至可能会失效。高度依赖卫星导航的无人飞行器定位导航面临着挑战。最近,卷积神经网络已成功应用于图像分类和视觉位置识别领域。用于几何匹配的卷积神经网络也被提出,使用神经网络实现无人飞行器视觉定位成为可能。

基于视觉的无人飞行器导航定位一直被广泛研究。一些研究通过图像匹配方式进行导航定位。Xue等采用一个孪生神经网络,输入无人飞行器俯视图和附近卫星地图,通过相似性判断无人飞行器在卫星地图中的位置;Choi等使用无人飞行器俯视图像和参考图像进行分割建筑物,得到建筑物比率来进行定位,在未知位置和方向的情况下估计位置;Kim等提出了跨视角的地空图像匹配方法,使用卫星图像作为先验知识来对地面进行姿态和定位;Yang等提出了一种基于深度神经网络的回归方法,并结合了基于3D结构的计算机视觉方法,通过单个训练模型成功地估计了各种城市场景中的相对相机姿势。这些方法能够完成搜索匹配问题,但对于视觉导航来看,拓扑定位方法着重于为查询图像提供带有有限且离散化位置信息的标签,并不能提供连续且准确的位姿估计。

得益于卫星地图的广泛使用且易于获取,通过使用无人飞行器视角图像与卫星基准地图进行配准,通过图像关系映射出空间位置关系,从而获得无人飞行器的绝对定位(经纬度、高度、偏航角度等)成为一种新的可能。Shetty等考虑到卫星图与无人飞行器视角图是不同视角拍摄,所以采用基于图像的多视图定位,输入无人飞行器视角图片与卫星地图,通过卷积神经网络回归输出无人飞行器位姿,提供了一个很好的思路。Patel等和Goforth等也做了相关研究,Patel等使用互信息图像配准技术,Goforth等通过卷积神经网络提取特征,使用相似性最小损失方式配准图片,都是比较成功的使用预先存在的卫星图像与无人飞行器实时图像对比定位的方法例子。一些传统步骤是基于特 征 点 的 传 统 稀 疏 特 征(SURF、SIFT、ASIFT等)检测提取,剔除不正确匹配,再对全局几何变换进行稳健估计。但这些方法的主要挑战在于卫星地图与真实图像之间的巨大差异:环境结构的变化,成像方式不同,卫星图高于地平面的结构产生的更大的透视效果,不同光照条件和季节变化等,都给图像配准带来了困难,常常匹配失败。

Rocco等首次提出了一种用于几何匹配的深度网络体系结构,在差异较大图像中也获得了较好的效果,证明了深度学习在图像配准中的优势。Park等在Rocco等的基础上通过将双向估计应用在航空影像的匹配问题上,证明了其对于处理航空影像问题的可能性。Goforth与我们的方法相似,采用几何配准网络,找到最优的平移、旋转、缩放来确定无人飞行器的全局位置和航向,但他没有探讨0-360°偏航角度和一定范围的俯仰角的倾斜情况。

1 研究方法

基于前人研究,本文提出了一种基于图像配准的无人飞行器定位方法,在室外环境中实现跨场景无人飞行器视觉定位导航。整体来说,该方法包括两个步骤。首先,在基准卫星地图中截取初始估计位置对应卫星图片,通过深度学习配准网络将当前无人飞行器图像与存储在飞行器中的基准卫星地图进行图像配准,得到图像的几何变换关系Rt;然后通过得到的Rt以及基准地图信息,得到当前无人飞行器的经纬度、高度、偏航角度,并通过对无人飞行器的连续运动图像配准实现无人飞行器的连续视觉定位。

1.1 配准网络

通过无人飞行器底部摄像头,在飞行过程中进行连续图像拍摄,我们认为拍摄真实图像与卫星地图成仿射变换关系。本文先通过一个网络分别提取两幅图像的图像特征,由于图像成像和季节等变化导致特征存在着较多差异,对于这种情况,需要先对两幅特征图进行相关特征的重分布,减少不相似特征;再进行特征图关联,最后通过一个回归网络,回归这两者仿射变换参数。

具体图像配准网络由三阶段组成:①分别输入卫星图像和无人飞行器视角图像,通过由卷积层组成的孪生网络架构,提取特征图F和F;②将两幅特征图进行特征重分配,并通过计算余弦相似度特征生成一个关联对应特征图C;③通过卷积网络和全连接网络组成几何变换参数回归网络,直接输出几何模型的参数,输出用于仿射变换的6D向量[,,t,,,t]。图1显示了配准网络的总体结构图。

图1 配准网络结构图

本文使用ResNeXt101作为特征提取网络提取特征,输入图像大小为3×256×256。为了获得更好的特征图,考虑提取layer2与layer3的特征图,将layer2特征图从512×32×32下采样为512×16×16,与layer3同一大小,进行通道连接。这样融合不同卷积层的特征,使网络同时关注不同类型特征。

通过融合不同卷积层的特征图得到两个F和F。由于卫星地图与真实地图存在差异,为了降低差异,关注相似特征,对F和F分别进行特征重分布,分别得到F和F特征图。最后计算余弦相似度特征图C:

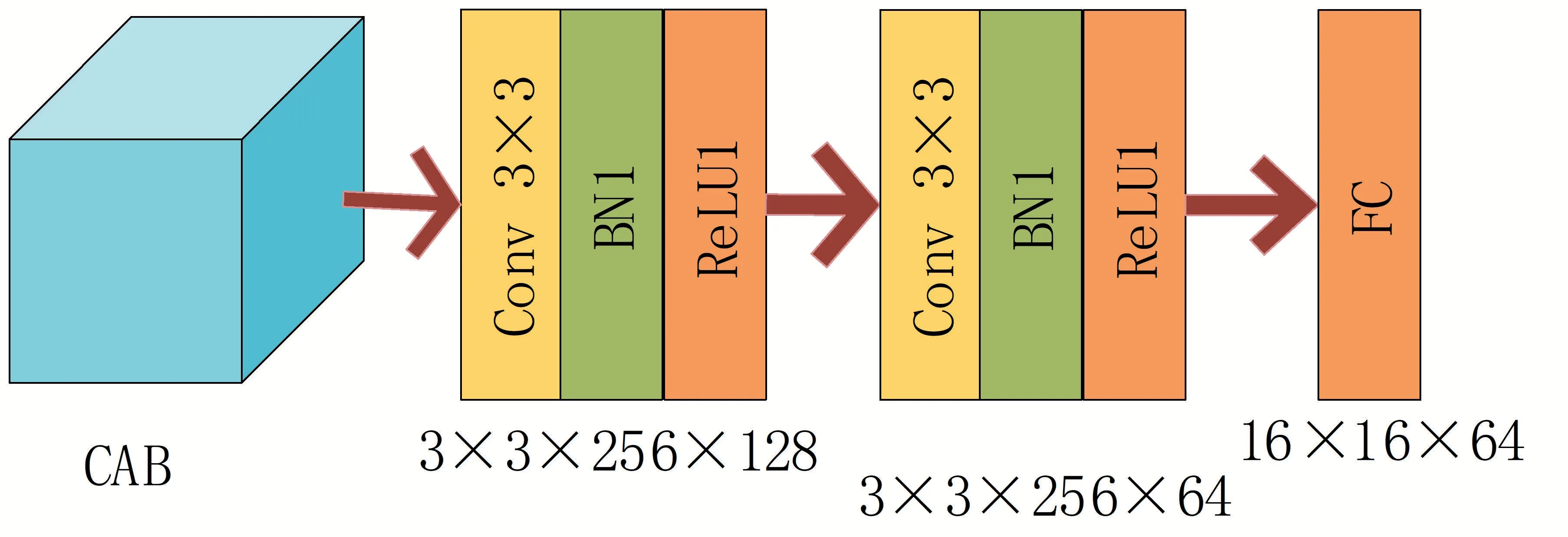

为了减少全连接层的参数量,先使用卷积+批归一化+ReLU激活函数,使用三个这样的模块逐渐降低参数量,最后接上一个全连接层,回归仿射变换的6D向量=[,,t,,,t],参数回归网络模块如图2所示。

图2 参数回归图

本文使用预测值与真值的均方误差作为网络的损失函数,为网络预测值,^为真值。

1.2 视觉定位

转换参数的回归,由于本文采用仿射变换,它有6dof以及保留直线的能力。对于航拍图像匹配领域,它不会产生较大的直线失真(如道路和建筑物的边界)。

其中=·cos,=-·sin,=·sin,=·cos,s为缩放比例,为偏航角度,t为方向平移系数,t为方向平移系数。

把无人飞行器视角图像与卫星地图之间的关系看成仿射变换矩阵[,,t,,,t],由仿射变换得到仿射变换参数,其中代表的缩放比例是在高度方向上,旋转角度为视角图像相对于初始位置的航片角度,t、t对应相对于基准图像中点位置偏移长度。通过得到的仿射变换参数计算无人飞行器视角图像相对于选取的基准卫星地图的物理空间4dof位置与航向角度[、、、],再获取基准图像像素点256×256,对应物理长度为:

其中p,p,p,p为初始点参数,即在已知初始位置通过图像的配准对齐得到无人飞行器在基准卫星地图中位置。得到配准位置,即得到无人飞行器在地图中的绝对位置和航向角度,完成单次视觉定位。将无人飞行器此刻位置对应参考卫星地图位置的图像和下一时刻无人飞行器视角图像作为下一次配准输入,完成无人飞行器的连续视觉定位,如图3所示。

图3 视觉定位图

2 数据准备

本文建立了12组共12×2000张的无人飞行器视角图片和12张对应飞行范围的基准数字地图。输入无人飞行器视角图片与基准卫星地图中对应位置截取的小卫星地图实现。本文数据来自谷歌地球中三维运动图像和谷歌地图二维卫星地图图像制作,训练集、验证集、测试集的比例为6∶2∶4。同时,为了增加对于真实环境情况的效果,本文也测试了真实环境视频,使用DJIMatrice 600 Pro多旋翼无人飞行器和一个朝下的相机以20FPS的速度提供图像,RTKGPS系统和IMU的值作为真实值,和对应卫星地图来测试真实环境效果。

本文对视觉里程计和配准网络分别进行了训练,训练环境为Ubuntu18.04,Python3.6,Pytorch0.4,使用GTX1080Ti作为实验训练平台。网络使用训练集训练,采用Adam优化方法,批量大小为16,学习率=0.0001,200次迭代训练。

在图像配准实验中,为了更好地评估本文的网络,使用Park等的数据集进行评估。在定位测试中,一共使用4条三维虚拟路径和1条实拍路径进行测试。这些测试路径包括不同城市、不同高度情况来评估视觉定位能力。虚拟路径中包含1条长达15公里的路径,能够很好地评估方法在长距离导航的能力,验证长距离飞行定位的鲁棒性。在每段路程平均2 km左右的飞行航程,一张卫星基准地图平均只占不到40 Mb的大小,可以轻松存储在无人飞行器上。

3 算例及分析

3.1 配准网络

本文测试了配准网络的同源图像配准性能,也测试了无人飞行器视角图像与卫星图像的配准性能。

使用PCK作为评价指标:

~是预测输出点,p是对应的真值,是两者之间的距离。在对谷歌地球数据集的实验中,对PCK采用了τ=0.01、τ=0.03、τ=0.05这三种设置,τ越低表示评估越严格,PCK评估值越高效果越好。本文使用谷歌地图数据集训练并测试,进行定量评估测试PCK。

由表1可知,本文提出的方法在=0.01、=0.03和=0.05上均达到了很有竞争力的结果,说明本文提出的网络对于图像配准具有较好的性能。

表1 配准网络PCK标准评价表

为了说明网络在无人飞行器图像与卫星图像之间的配准效果,在本文的数据集上训练网络并测试性能。对于无人飞行器拍摄图像与对应卫星地图,本文分别对无人飞行器拍摄图像、卫星地图图像进行单独测试,和使用无人飞行器拍摄图像配准卫星地图进行测试,验证本文网络的性能,对于同源图像与非同源图像,本文分别测试了配准网络对于两者的性能,结果见表2。

表2 配准网络不同图片PCK评价表

由配准网络不同图片PCK评价表可知,配准网络的同源图像配准具有较高的性能,=0.05与=0.03对应值均超过了95%,其中无人飞行器与图像卫星地图在=0.05与=0.03的配准效果也达到了85%,在=0.01的精度上为40.12%,这主要是由于无人飞行器视角图像拍摄存在着倾斜角度,在仿射变换下无法进行像素级的对齐,因此存在偏差,但具有一定稳定性。网络对于同源图像,配准方法能够很精确地配准,而对于非同源图像也有很强的鲁棒性。

3.2 定位测试

为了验证本文方法在视觉导航中的性能,对测试数据集做了定量测试,测试了经度、维度和高度方向的性能,统一使用长度标准计量单位米作为比较;同时也测试了偏航角(取值±180°)。其中包含3条短距离测试路径,平均长度2公里,这条路径具有±180°的偏航角度,以及包含着±10°的俯仰角度和滚转角度,用于验证飞行抖动较大时的性能;1条15公里的长距离测试路径,用于长距离飞行下方法的稳定性;1条1公里真实飞行路径,是真实无人飞行器拍摄路径,用于验证方法在真实条件下的定位性能。测试结果如表3所示。

表3的结果显示,针对这3条短距离路径,四个评价指标中有三个取得了最差的性能,符合我们的预期,说明飞行抖动对网络性能有较大影响。但在经纬度方向误差均未超过10米,且偏航角度偏差不到5°的情况下,已经能够满足一般通用无人飞行器飞行的定位要求。

表3 不同路径下的视觉定位性能评价表

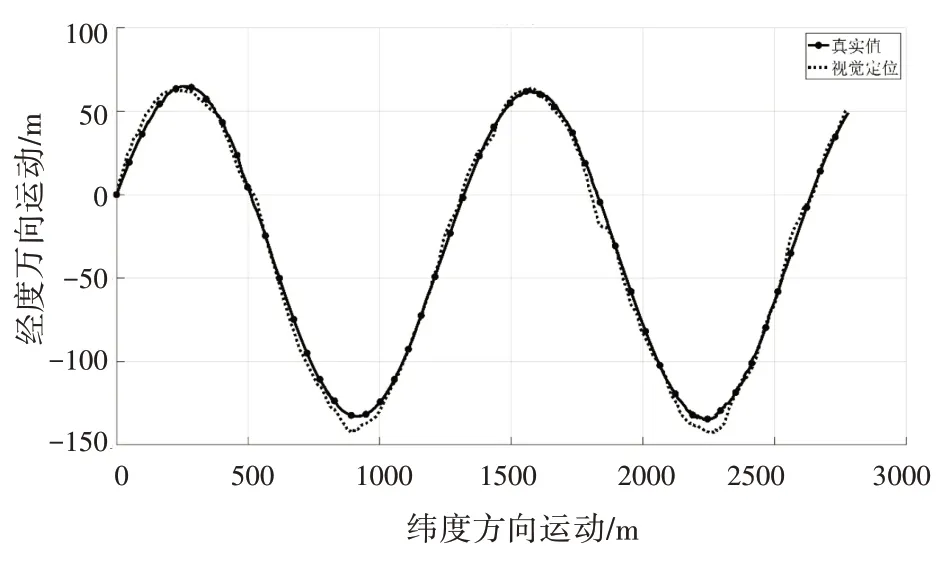

图4为其中一条路径视觉定位对比图。在15公里长距离路径测试中,无人飞行器正确运行完全程,验证了网络对于长时间定位的鲁棒性,具有较高的绝对定位性能。网络并没有在真实路径中进行训练,但在测试中,我们却得到了最好的经纬度和高度方向上的性能,一个是真实稳定飞行,稳定飞行时俯仰角度和滚转角度一般不会超过±10°,这个结果也是和长距离飞行较为接近;另一方面也说明网络对于未见过的真实图像也具有很好的定位导航效果。根据表3可以得出,本文提出的方法在不同路径下的视觉定位均具有较好的性能,即使在长距离长时间定位也不会存在漂移,在没有训练过的真实环境中也能很好地进行视觉定位。

图4 视觉定位对比图

4 结语

如今多数无人飞行器飞行定位高度依赖于卫星导航,当卫星导航出现故障或被干扰,可能会导致导航失败。本文提出了一种基于图像配准的无人飞行器定位方法,借助卫星地图来估计无人飞行器的位置和姿态,在出现噪声或不可靠的卫星导航系统信号时,帮助无人飞行器进行定位导航。

(1)基于视觉定位方法,不依赖外部信号,使用单目普通摄像头,在卫星导航出现故障时可以获取无人飞行器定位信息。

(2)采用卫星地图作为基准地图,相比于通过与已有图像进行匹配导航,只需要获取一定区域的卫星图像,卫星地图获取方便,对无人飞行器飞行进行定位导航,更具有普遍性和现实意义。

(3)本方法在0~360°偏航角度和一定范围的俯仰角的倾斜情况下也能够稳定定位。对于长距离飞行没有累计误差,并在真实环境中具有良好的定位性能。