基于半监督对抗学习的图像语义分割

2022-07-15李志欣张佳吴璟莉马慧芳

李志欣,张佳,吴璟莉,马慧芳

1.广西师范大学广西多源信息挖掘与安全重点实验室,桂林 541004;2.西北师范大学计算机科学与工程学院,兰州 730070

0 引 言

图像语义分割是图像处理和计算机视觉领域的一项重要工作,像素级的分割任务通常称为图像语义分割。随着卷积神经网络(convolutional neural network,CNN)的发展,图像语义分割取得了显著进展(Chen等,2018;Long等,2015;Oliver等,2019;Yu和Koltun,2016),广泛应用于自动驾驶(Geiger等,2012)、图像编辑(Tsai等,2017)等领域。然而在实际的图像语义分割应用中,在进行全监督CNN训练时,通常需要大量像素级标注的真实标记(ground truth,GT)传达对象边界及其组成部分之间的关系,这些数据通常是人工获取的,需要付出巨大代价。为了减少训练过程中使用人工生成标记的数量,最常见的是在图像语义分割中采用半监督或弱监督的训练方法。

半监督学习方法的关键是其使用的弱标记数据仅表示某个对象类的存在,不提供对象位置或边界的GT信息。显然,这些注释比像素级的标记弱,且在大量的可视数据中很容易获得,或者说能以相对较低的成本手工获得。因此,半监督学习为训练具有有限标记数据和大量未标记数据的图像语义分割模型提供了一种有吸引力的方法。针对图像语义分割,目前提出了多种半监督训练方法。Kalluri等人(2019)将半监督学习和无监督域适应结合起来。Stekovic等人(2019)实现了3维场景的多个视图之间的几何约束。一致性正则化(Oliver等,2019)代表了一类用于训练深度神经网络分类器的半监督学习算法,它也被开发用于产生最先进的半监督分类结果,这些结果在概念上很简单,而且通常容易实现。Kingma和Ba(2017)注意到在图像语义分割中使用图像级标注依赖于分类网络获得的位置图来拟合图像级标注和像素级标注之间的差距。然而,这些特征图只关注物体的一小部分,没有精确的边界表示。因此,目前已有的采用半监督学习的图像分割方法与全监督网络训练方法相比效果较差。

在卷积过程中的优化算法可能无法适当地协调多个卷积层以捕获这些依赖性的参数值,因此可能会妨碍远程依赖性的学习。虽然增大卷积核的大小可以提高网络的表达能力,但这样做也会失去使用局部卷积结构获得的计算效率。上下文依赖关系已经在许多方面得到解决,例如,学习上下文已经被证明依赖于局部特征,并且有助于特征表示。Shuai等人(2018)使用递归神经网络(recursive neural network,RNN)创建有向无环图模型,以捕获丰富的上下文依赖关系。Zhao等人(2018)提出PSANet(point-wise spatial attention network),通过卷积和空间维的相对位置信息捕获像素级关系。此外,Zhang等人(2018)提出的EncNet(context encoding network)引入了一个通道注意机制来捕获全局上下文。注意模块对远程依赖关系的建模能力已经得到了证明,也已经在许多任务中得到了广泛的应用。同时,自注意力机制在计算机视觉领域的应用也越来越广泛。Vaswani等人(2017)利用一种自注意机制训练更好的分类生成器。然而,这些工作目前并没有有效地应用于半监督图像语义分割。因此,本文尝试将自注意机制应用于半监督图像语义分割任务中,并获得了很好的效果。

生成对抗网络(generative adversarial network,GAN)(Goodfellow等,2014)的发展使得半监督和弱监督学习在图像语义分割中的应用取得了显著进展。判别器的性能控制是提出的半监督对抗学习图像语义分割在训练过程中面临的另一个挑战。在这里,高维空间中判别器的密度比估计在训练中往往是不准确且不稳定的。优化的目的是获得一个能够很好地区分生成分布和目标分布(Arjovsky和Bottou,2017)的判别器。然而一旦获得这样一个判别器,生成器的训练就完全停止了。为了提高GAN训练的稳定性,众多研究者做了各种努力。Radford等人(2016)为了从体系结构设计的角度寻找一套更好的网络架构设置,开发了DCGAN(deep convolutional GAN)模型,在图像生成领域进行了广泛的实验验证。Wasserstein GAN模型(Arjovsky等,2017)通过引入Wasserstein距离的概念,从理论角度解决了GAN训练不稳定问题。在Wasserstein GAN模型中,判别器的参数矩阵必须满足Lipschitz约束。但是采用的约束方法相对简单粗暴,直接约束参数矩阵中的元素,使其不大于给定值。尽管此方法可以保证Lipschitz约束,但也破坏了参数之间的比例关系。本文使用的谱归一化是一种既满足Lipschitz条件,又不破坏矩阵结构的方法,仅需使每层网络的网络参数除以该层参数矩阵的谱范数即可满足Lipschitz等于1的约束,因此实现起来也较为简单。

本文提出一种稳定的自注意半监督对抗性学习方法,使用的基础分割网络是基于DeepLabv2框架(Chen等,2018)和在MSCOCO(Microsoft common objects in context)(Lin等,2014)数据集上预训练的ResNet-101(residual neural network)模型。其中利用一个全卷积的判别器,产生一个像素级的置信度图以区分生成器生成的数据和GT分割图。置信图中的每个像素可以用一个简单的阈值分割成0或1,1表示可信预测结果,0表示结果不可信。将置信图作为掩膜,将分割预测看做假标记,用于训练分割网络。分割网络可以不断学习不同的不可见模式,以寻求和改进优化,然后在不可见的类别中识别新的模式。本文的贡献主要有:1)在GAN的分割网络中引入一种自注意机制,在基于像素级GT数据的半监督对抗训练中,通过计算特征图中任意两个位置之间的相互作用,直接捕获其远程依赖关系;2)采用谱归一化(Miyato等,2018)稳定判别器网络的训练,不需要对超参数进行大范围的调整即可达到较好的判别器训练效果,与其他常用方法相比,这种归一化技术计算量更小,更容易集成到当前的实现方法中;3)在数据集PASCAL VOC 2012(pattern analysis,statistical modeling and computational learning visual object classes)(Everingham等,2010)和Cityscapes(Cordts等,2016)上进行实验评估,与当前先进的半监督和全监督图像语义分割方法相比,本文方法具有更好的性能。实验以Hung等人(2018)提出的AdvSemiSeg方法作为半监督基线模型,以DeepLabv2网络为全监督方法基线模型。此外,本文给出了在不应用谱归一化的情况下(即仅应用自注意模块)获得的性能。

1 相关工作

深度学习在图像分类中的一些突破性方法已用于图像语义分割任务,但图像语义分割任务的核心是如何将分割与分类两项任务结合起来。很多分割方法都采用迁移学习,通常以ResNet(He等,2016)和VGG(Visual Geometry Group)(Simonyan和Zisserman,2015)分类网络的卷积层作为骨干。Long等人(2015)提出的将卷积21路分类器与VGG-16骨干网相连接的全卷积网络(fully convolutional network,FCN)的应用,证明了深度神经网络在图像语义分割中的有效性。Chen等人(2018)将空洞卷积应用于VGG-16网络的后几层,在保持接收域的同时提高预测的空间分辨率。编解码器架构(Ding等,2018)在图像语义分割中也得到了应用。编码器是一种特殊的神经网络,用于特征提取和数据降维,生成具有语义信息的特征图像。解码器网络的作用是将编码器网络输出的低分辨率特征图像映射回输入图像的大小,进行逐像素分类。U-Nets(Ronneberger等,2015)使用置换卷积层增加分辨率,其跳跃连接带有完整的特征图。

以上方法都表现出了非常优越的性能,但在训练过程中都需要大量的标记数据,通常要在有像素级注释的大型数据集上进行训练,例如数据集PASCAL VOC 2012和Cityscapes等,获取这些标记数据非常耗时且昂贵。一些研究采用半监督方法,即只使用部分标记数据的训练处理这个问题。在本文工作中考虑的半监督方法,可以分为仅使用图像级标记和仅使用边界框(Sun和Li,2019)的弱注释数据的方法,或者只是对部分数据进行标记而另外部分数据完全未标记的方法。Luc等人(2016)首先将对抗学习引入图像语义分割,Souly等人(2017)为其在半监督学习中的应用开辟了道路。Liu等人(2019)在基于对抗学习的方法中采用全卷积判别器,试图在像素级区分预测概率图和GT分割分布。这些工作都是只标记部分数据集,另外未标记的数据来自相同的数据集,并且与标记的数据共享相同的域数据分布。

Goodfellow等人(2014)重新引入图像生成任务的对抗性学习的概念,并使用GAN成功地从随机噪声中生成了手写数字和人脸等图像。然而,随机噪声和有意义的图像显然来自不同的数据域,且分布不一致。因此,GAN模型可以解决不同数据域间分布不一致的问题。大多数生成器从噪声矢量生成图像。Liu等人(2019)提出使用GAN生成低显示类别的真实图像以增强数据,从而平衡标记分布。Hung等人(2018)提出使用对抗网络促进小规模数据集中的语义分割,当给定一个特定图像时,判别器用来输出语义标记的置信度图,经过这样调整可以强制分割预测,使参数在空间上更接近GT,之后该生成器可以在半监督设置下提高分割精度。

自注意(Vaswani等,2017)最初的目的是为了解决机器翻译问题,在随后的工作中进一步提出了非局部神经网络(Wang等,2018),用于视频分类、目标检测和实例分割等一系列任务。Hu等人(2018)还应用自注意机制对对象之间的关系进行建模,以实现更好的对象检测。最近的一些工作(Zhang等,2019)将类似的机制应用于语义分割并取得了良好的分割性能。本文的工作与上述工作密切相关,处理高分辨率输入,通过关注所有输入位置,计算每个输出位置的上下文信息,对远程依赖关系进行建模,通过配备自注意机制的单层模型模拟输入特征图中任何位置之间的依赖关系。

尽管GAN在改善数据驱动的生成模型的样本质量方面非常成功(Brock等,2019;Karras等,2018),但对抗训练也导致了GAN的不稳定性,已有的工作(Arjovsky等,2017)表明,GAN的这种不稳定性是由于梯度爆炸和梯度消失导致的。一个标准的抗扰训练方案涉及使用抗扰样本拟合判别器(Szegedy等,2014),目的是产生一个训练有素的判别器,该判别器对测试样本的攻击具有更好的鲁棒性。为了提高GAN的稳定性,学者提出许多方法,包括利用不同的体系机构(Radford等,2016)、采用正则化技术(Salimans和Kingma,2016)和梯度惩罚(Gulrajani等,2017)等。谱归一化技术(Miyato等,2018)是最好的方法之一,本文通过在GAN结构的判别器中引入谱归一化,达到了控制判别器的Lipschitz常数的效果,缓解了梯度消失问题,提高了GAN训练的稳定性。

2 模型概述

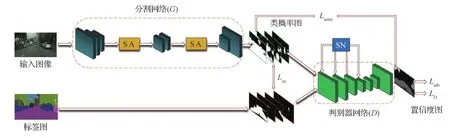

提出的半监督图像语义分割的方法框架主要由两个子网络构成,包括分割网络G和判别器D,如图1所示。其中分割网络G输出类别概率图,SA(self-attention)表示自注意力模块,SN(spectral normalization)表示应用谱归一化技术,判别器网络D输出置信度图,Lce是基于GT图像的标准交叉熵损失,Ladv是D的对抗损失,Lsemi是掩膜交叉熵损失。分割网络中输入第n个图像Xn的尺寸为H×W×3。G中的特征图通过引入的两层自注意模块,首先应用卷积层获取降维特征,然后将输入自注意模块的特征生成一个空间注意矩阵,对特征图的任意两个像素之间的空间关系进行建模。接下来,在自注意矩阵和原始特征之间执行矩阵乘法。最后,对上面相乘的结果和原始特征进行逐元素的求和运算,获得远程上下文的表示。这使生成器可以基于局部特征对丰富的上下文关系进行建模,从而在生成图像时可以很好地协调每个位置和远端的细节。输出是维度H×W×C的类概率图,其中C为语义类的个数。

图1 半监督语义分割方法框架图Fig.1 Framework of semi-supervised semantic segmentation method

通过使用空间交叉熵损失LD训练基于全卷积的判别器网络。判别器D可以接受不同大小的输入,其由G输出的类概率图(G(Xn))或一个独热编码的标记图In作为输入,最终输出一个尺寸为H×W×1的置信度图。这里,对于置信度图的每个像素i,如果来自分割网络G,则设为0;如果来自标记图,则设为1。因此,置信图表示G的概率预测输出更接近GT分布的区域。同时在D内应用谱归一化,保证其映射函数满足Lipschitz约束。

使用未标记图像和标记图像进行半监督训练。在整个训练过程中,将未标记的数据应用于训练G,而附加的自注意模块则有效地解决了输入图像中广泛分离的空间区域之间的关系。当使用标记数据时,G的训练将同时根据基于In的标准交叉熵损失Lce和从D获得的对抗损失Ladv进行监督。然后,根据置信度图给出的可信预测,以自学习的方式将置信度图和掩膜交叉熵损失Lsemi一起用做训练G的监督信号。

3 半监督损失

3.1 损失函数

训练分割网络通过最小化多任务损失函数实现,具体为

LG=Lce+λadvLadv+λsemiLsemi

(1)

式中,λadv和λsemi是权重,用于最小化多任务损失函数。对于式(1)中的第1个损失分量,标准交叉熵损失定义为

(2)

(3)

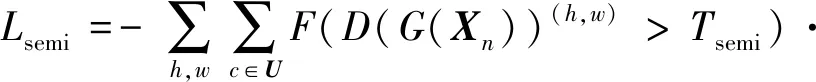

式中,D(G(Xn))(h,w)是Xn在位置(h,w)处的置信度图。因为未标记的数据不包含GT,所以未标记的数据不会产生与Lce相关的损失,此时只需要判别器网络,即此时对抗损失Ladv仍然适用。最后,使用指标函数F(·)和阈值Tsemi定义式(1)中的第3个损失分量,以对置信度图进行二值化,更好地显示可信区域。第3个损失分量,掩膜交叉熵损失可表示为

(4)

通过最小化空间交叉损失函数LD训练判别器网络,具体为

(5)

式中,如果判别器输入为G(Xn),则yn=0;如果判别器输入为In,则yn=1,而D(In)(h,w)是In在位置(h,w)处的置信度图。

3.2 自注意模块

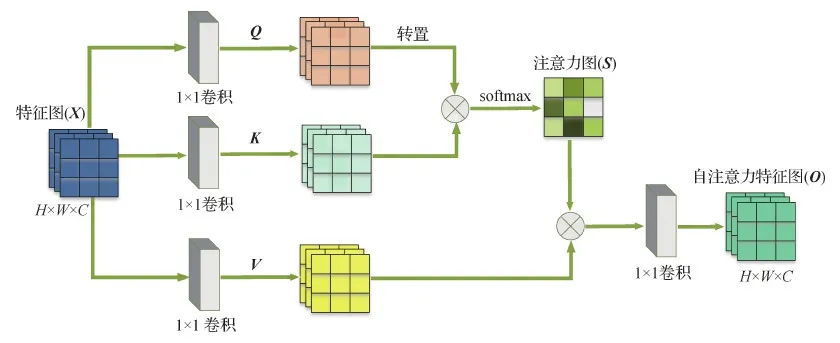

传统的GAN网络使用小的卷积核很难发现图像中的依赖关系,但使用大的卷积核就丧失了卷积网络参数与计算的效率。尤其在语义分割这种多类别的数据集上训练时,卷积GAN网络对某些图像类的建模比其他图像类的建模更困难。在本文提出的半监督图像语义分割框架的分割网络G中,每个卷积核的尺寸均有限,每次卷积操作只能覆盖像素点周围很小一块邻域,对距离较远的特征不容易捕获,因为多层的卷积和池化操作使得特征图的宽和高变得越来越小,越靠后的卷积层,卷积核覆盖区域映射回原图时对应的面积也就越大。自注意通过直接计算图像中任意两个像素点之间的关系,获取图像的全局几何特征,通过关注特征图所有位置,并在嵌入空间中取其加权平均值表示特征图中某位置处的响应。简单来说就是在前一层的特征图上加入注意力机制,使得GAN在生成时能够区别不同的特征图。

给定一个像素点,为了计算特征图上所有像素点对这个点的影响,需要用一个函数,针对特征图Q中的某一个位置,计算特征图K中所有位置对它的影响。这个函数可以通过学习得到,因此考虑对这两个特征图分别做卷积核为1×1的卷积,且卷积核的权重可以学习得到。

本文提出的两层自注意模块的框架如图2所示,此处符号⊗表示矩阵对应元素相乘。该自注意模块以上一层的特征图X∈RH×W×C作为输入,并生成两个特征图Q、K∈RH×W×C,在对Q和K进行转置后执行矩阵乘法,并使用softmax层计算注意力图S∈RN×N,其中N=H×W是像素数。这里,特征图S的元素表达了第i个像素对第j个像素的依赖性度量,即

图2 自注意力模块框架图Fig.2 Framework of self-attention module

(6)

式中,Qi和Kj分别表示特征图Q的第i个位置的像素和特征图K中的第j个位置的像素所对应的C维向量。为了学习更多的参数,在原始特征图X中加入卷积映射,以获得新的特征图V∈RH×W×C,并将S和V进行转置以及矩阵乘法。V可以看成对原特征图多加了一层卷积映射,这样可以学习到的参数更多,否则Q和K的参数太少。然后将其乘以比例参数α。最后,自注意模块逐渐学习将注意加权特征图添加到原始特征图X中,即

(7)

式中,Oj表示第j个位置上的C维结果特征向量。Vi和Xj分别表示特征图V的第i个位置的像素和原始特征图X的第j个位置的像素所对应的C维向量。α初始化为0,并且α通过自学习方式为非局部特征分配更多权重。最终特征图O是所有位置的特征与原始特征的加权总和。因此,对特征图之间的远程语义依赖性进行建模,有助于提高特征的可分辨性。

3.3 谱归一化

原始GAN网络的目标函数是为了优化真实数据分布与生成数据分布之间的JS(Jensen-Shannon)散度。但存在的问题是判别器训练得越好,生成器的梯度消失得越严重。即当近似得到最优判别器时,最小化生成器的损失等价于最小化生成数据分布与真实数据分布之间的JS散度。可生成数据分布和真实数据分布几乎不可能有不可忽略的重叠,因此无论生成数据分布与真实数据分布相距多远,JS散度都是常数,这也导致生成器的梯度最终会近似为0,即梯度消失。

本文提出的半监督对抗学习图像语义分割方法存在的训练困难是如何控制判别器网络D的稳定性,因为在目标分布和生成分布分开的情况下,可以存在一个判别器能够完美地将生成数据和真实数据完全区分开。如果输入的真实图像没有归一化到[-1,1],而生成的数据均在[-1,1]区间,那么在训练过程中,将会导致生成器G的梯度消失近似为0。接下来再训练G时,生成的图像质量就很难提升。因为这两个分布差异很大,D很容易区分,所以达到了最优化。

相对常规的GAN,谱归一化后的GAN引入了新的正则项,该正则项防止权重矩阵的列空间在训练中只关心一个特定的方向,同时其防止D中每层的转换对某一个方向敏感。与Wasserstein GAN模型只对判别器的参数矩阵中的元素直接限制不同,谱归一化方法以一种温和的方式使判别器满足Lipschitz连续性,限制了判别器函数的变化剧烈程度,使模型更稳定。

对于标准GAN,判别器D的最佳形式为

(8)

式中,qdata是数据x的分布,pG是对应的x的生成模型的分布,该模型是通过对抗性最小最大优化过程学习的,且f*(x)=logqdata(x)-logpG(x),其导数为

(9)

然而,这一导数项是无界的,甚至是不可计算的,在实践中必须加上常规的限制。因此,需要一种机制来定义f*(x)的导数。由此注意到,如果忽略D的每一层的偏置,则可以确定f*(x)的上限,具体为

(10)

(11)

然后,在式(10)的不等式中,将每个W代入式(11)。若对判别器D的各层权值W进行如上所示的谱归一化处理,则判别器D可视为隐式f的函数,其Lipschitz范数可约束为小于1。这达到了限制判别器D的Lipschitz范数的效果。

谱归一化的简单表述是每层的权重W在更新后都除以W的最大奇异值。但是奇异值的分解计算是很耗时的,因而采用幂迭代的方式获得近似的最大奇异值的解。

4 实验结果分析

4.1 数据集与实验设置

PASCAL VOC 2012数据集包含21个对象类,利用分割边界数据集(Hariharan等,2011)的额外注释图像,共得到10 582幅图像用于训练,测试集包括1 449幅图像。Cityscapes数据集包含19个类,其中训练集、验证集和测试集分别包含2 975、500和1525幅图像。将平均交并比(mean intersection-over-union,mIoU)作为评估指标。随机抽取1/8、1/4、1/2等不同比例的标记数据,其余为未标记数据进行训练,并对模型的图像分割性能进行评估。在训练过程中未标记数据和标记数据均随机抽取,对所有基线使用相同的数据分割。

在PASCAL VOC 2012数据集的训练过程中,采用尺寸为321 × 321像素的随机缩放和裁剪操作。批处理大小为8。对于Cityscapes数据集,将输入图像尺寸调整为512 × 1 024像素,没有随机裁剪/缩放,批处理大小为2。在半监督训练中,随机抽取无标记和有标记的数据。对判别器网络和分割网络进行联合训练。在每次迭代中,只使用包含GT的数据训练判别器。

本文使用PyTorch框架在一个具有11 GB内存的NVIDIA 1080TI GPU上训练的模型,采用随机梯度下降(stochastic gradient descent,SGD)优化器,动量为0.9,权值衰减为10-4。初始学习速率为2.5×10-4,并随着多项式衰减以0.9次方减小。判别器的训练采用Adam优化器,学习率设置为10-4。使用未标记和标记数据进行训练时,设置λadv为0.001,λsemi为0.1,Tsemi为0.2。

4.2 在Cityscapes数据集上的实验结果

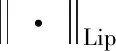

为了验证本文方法的性能,在Cityscapes数据集上使用不同比例标记数据进行实验,并将本文方法与当前具有代表性的半监督和全监督方法进行分割性能对比。对比方法包括FCN-8s(Long等,2015)、Dilation10(Yu和Koltun,2016)、CowMix(French等,2020a)、DST-CBC(dynamic self-training and class-balanced curriculum)(Feng等,2021)、Sawatzky等人(2021)、CutMix(French等,2020b)、Mittal 等人(2021)、DeepLabv2(Chen等,2018)和AdvSemiSeg(Hung等,2018)。表1给出了Cityscapes数据集的半监督和全监督评估结果。

表1 在Cityscapes数据集上随机抽取不同比例的标记数据进行训练的图像分割性能结果(mIoU)Table 1 Image segmentation performance with randomly selected different proportions of labeled data for training on the Cityscapes dataset(mIoU) /%

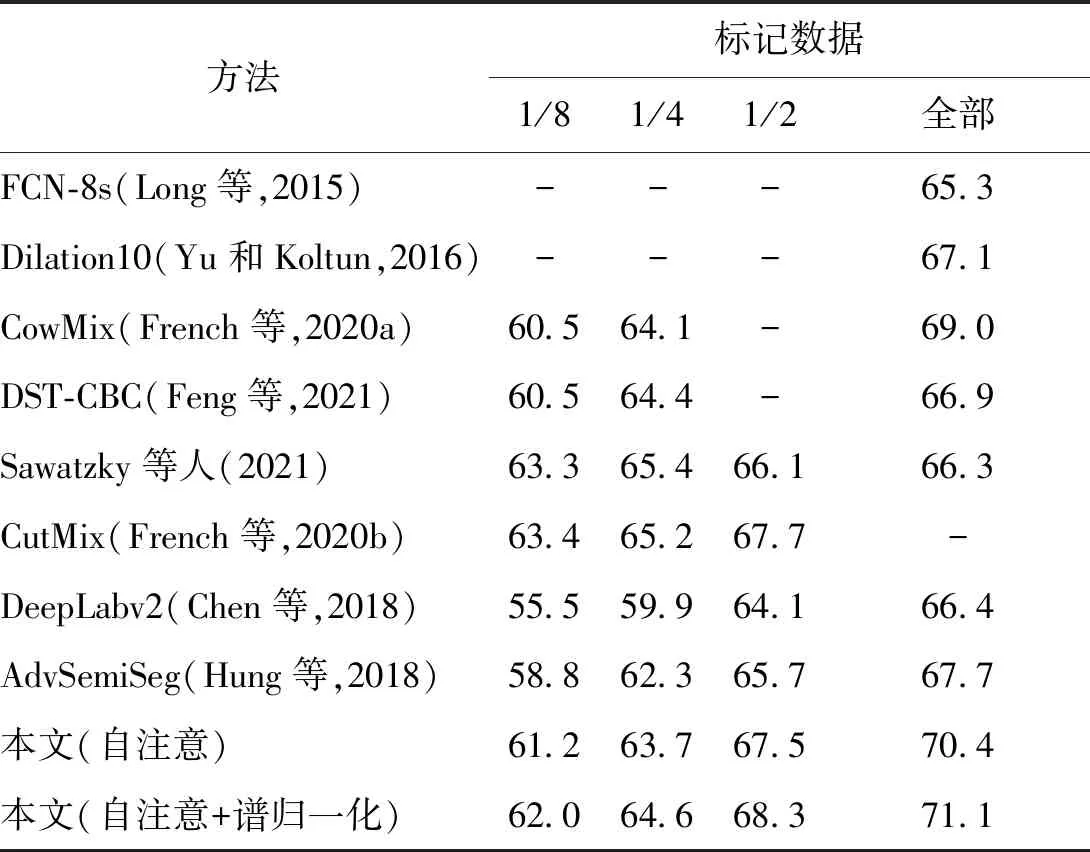

4.3 在PASCAL VOC 2012数据集上的实验结果

表2 在PASCAL VOC 2012数据集上随机抽取不同比例的标记数据进行训练的图像分割性能结果(mIoU)Table 2 The image segmentation performance with randomly extracting different proportions of labeled data for training on the PASCAL VOC 2012 dataset(mIoU) /%

图3给出了GT图像与本文方法在训练期间以不同比例的标记数据获得的分割结果的比较。可以看出,当使用随机选取1/2的标记数据进行训练时,本文方法具有很好的分割效果。

图3 在PASCAL VOC 2012数据集上随机抽取不同比例标记数据获得的分割结果比较Fig.3 Comparison of segmentation results obtained by randomly extracting different proportions of labeled data on the PASCAL VOC 2012 dataset((a)original images;(b)ground truth;(c)ours (1/8);(d)ours (1/4);(e)ours (1/2);(f)full)

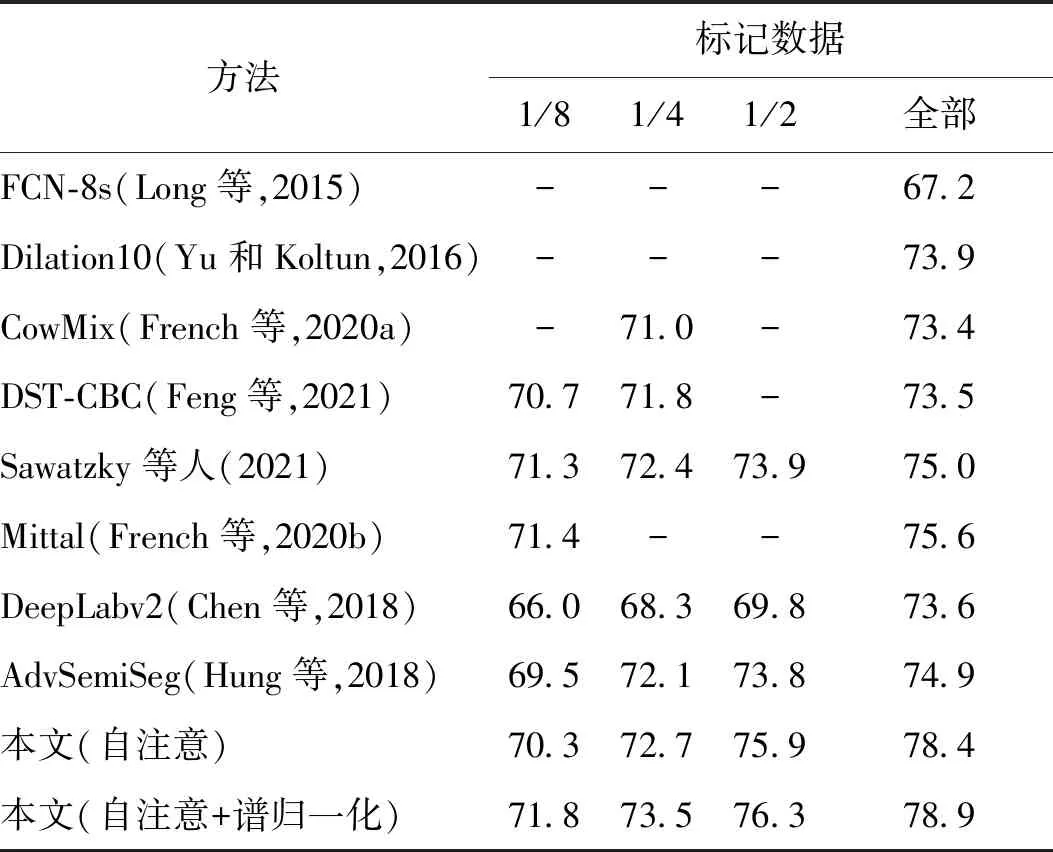

表3列出了PASCAL VOC 2012数据集中具有不同比例的标记数据的每个类别的半监督和全监督训练的平均mIoU性能结果。其中,Adv是基线AdvSemiSeg模型,SA是本文方法只使用自注意模型,SA+SN是本文方法同时使用自注意和谱归一化(模型)。此外,表2中最初报告的所有类的平均mIoU值都包含在最后一行中。从结果中注意到,提出的自注意模块和谱归一化显著提高了PASCAL VOC 2012数据集包含的21类图像的分割性能。在分割网络中加入自注意模块可以很好地捕捉到特征图中任意两个像素之间的远程上下文信息,提高模型的特征表示。

表3 在PASCAL VOC 2012数据集上逐类分割性能结果(mIoU)Table 3 Performance results of class-by-class segmentation on the PASCAL VOC 2012 dataset (mIoU)

此外,在判别器中加入谱归一化处理,有利于进一步训练GAN网络。图4所示的图像分割结果进一步说明了这一点,将GT数据与基线AdvSemiSeg模型和本文模型在训练中使用1/2标记数据时的分割结果进行对比,该模型在引入自注意和谱归一化后的分割结果在质量上均优于AdvSemiSeg模型,尤其是同时引入自注意和谱归一化后的分割结果。由此可以看出,自注意模块在捕获输入图像的全局依赖关系和谱归一化稳定GAN方面的有效性。

图4 在PASCAL VOC 2012数据集上使用1/2标记数据时本文方法获得的定性结果Fig.4 Qualitative results obtained by our method when using 1/2 labeled data on the PASCAL VOC 2012 dataset((a)original images;(b)ground truth;(c)AdvSemiSeg;(d)ours(SN);(e)ours(SA);(f)ours(SN + SA))

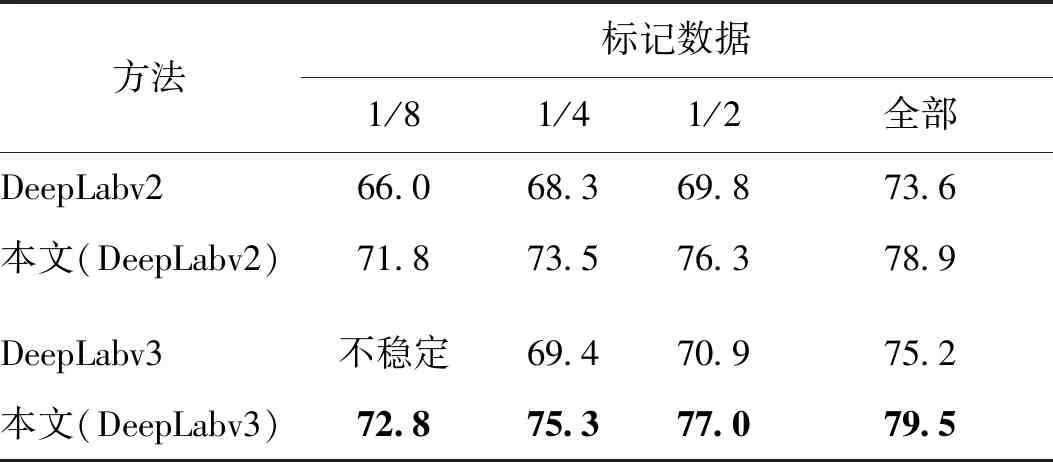

以上图像分割结果是基于DeepLabv2框架和在MSCOCO数据集上预先训练的ResNet-101模型。表4是在PASCAL VOC 2012数据集上使用不同主干架构和不同比例的标记数据获得的图像分割性能结果。

表4 在PASCAL VOC 2012数据集上使用不同主干架构和不同比例的标记数据获得的图像分割性能结果(mIoU)Table 4 Image segmentation performance results using different backbone architectures and different proportions of labeled data on the PASCAL VOC 2012 dataset(mIoU) /%

从表4可以看出,当使用DeepLabv3框架时,训练过程在较大比例的标记数据下是相对稳定的,在1/8比例的标记数据下是不稳定的。然而在使用大比例标记数据训练时,图像分割性能总比使用Deep-Labv2框架得到的效果好。而且通过谱归一化的应用可以很好地缓解DeepLabv3框架在使用1/8比例标记数据观察到的训练不稳定性。同时,使用DeepLabv3主干网络时,本文提出的半监督模型的表现更好。由此认为,基于AdvSemiSeg模型的方法对于少量标记样本无效的原因是其判别器网络所要施加的要求。少量的GT缺乏有效训练判别器从预测的分割图上区分GT所必需的变化,从而阻止了它有效地指导分割网络。相比之下,谱归一化可以最大程度地减少保留类扰动的预测差异,从而有效地在未标记样本之间传播标记。因此,它不会对标记的数据集的大小施加类似的要求。

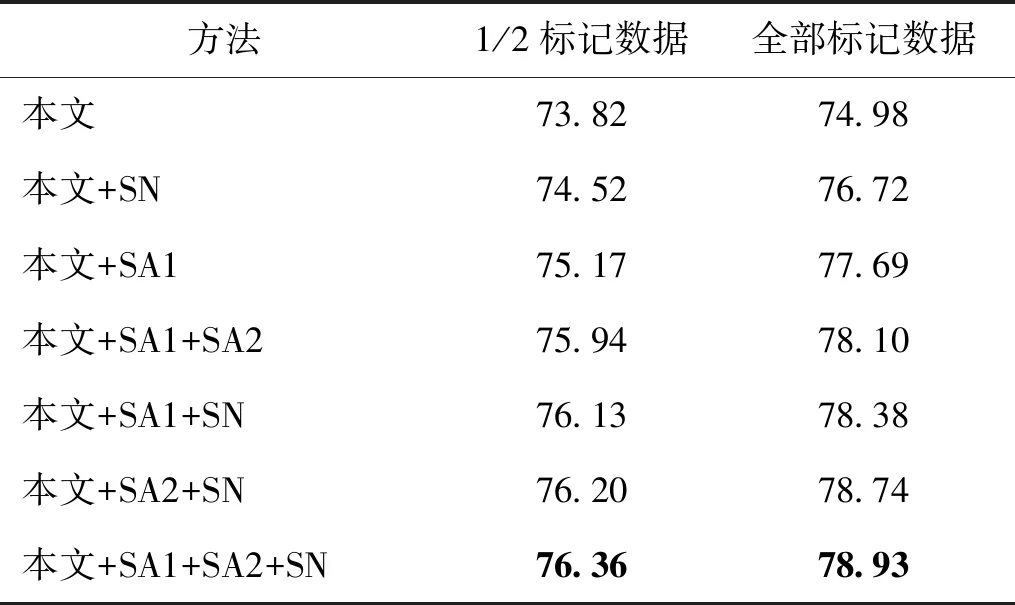

为验证训练框架中包含不同组件的效果,使用1/2标记数据和全部标记数据对本文方法进行消融研究,评估结果如表5所示。

从表5可以看出,在训练中加入谱归一化可以明显提高模型的图像语义分割性能。此外,加入第2个自注意模块(SA2)似乎比第1个自注意模块(SA1)对分割性能有更好的结果,尽管这两个模块都确实提高了分割性能。总体而言,本文方法对改善半监督GAN网络的图像语义分割性能非常有效。

表5 本文方法在PASCAL VOC 2012数据集上的消融研究(mIoU)Table 5 Ablation study of the proposed method on the PASCAL VOC 2012 dataset(mIoU) /%

另外,本文还考虑了在使用1/2标记数据时,超参数λadv、λsemi和Tsemi对性能的影响。式(1)中的参数λadv和λsemi是两个权重用于最小化多任务损失函数。式(4)中的参数Tsemi是用于判断像素的预测是否可信的阈值。表6显示了将这些参数设置为不同值的效果。按照Hung等人(2018)方法将Tsemi的值设置为0.2,并设置不同的λadv和λsemi,以此评估所提出方法的性能。可以看出,在(0.001,0.1)下获得最佳的mIoU。同时,为了分析Tsemi的作用,总结了将Tsemi分别设置为0.15、0.20和0.25时的 mIoU,当Tsemi= 0.20时,可以达到最佳的mIoU。

表6 在不同的超参数下PASCAL VOC 2012数据集上的分割性能Table 6 Segmentation performance on the PASCAL VOC 2012 dataset under different hyperparameters

综上所述,通过在Cityscapes数据集和PASCAL VOC 2012数据集上的实验结果表明,本文在分割网络中利用自注意成功地捕获半监督图像语义分割中的远程上下文依赖关系。该自注意和卷积是互补的,对图像区域之间远程全局依赖进行建模,从而更好地近似原始图像分布。并且该自注意模型在中高层特征图上比在低层特征具有更好的性能。在实验中可以看出,在判别器中引入谱归一化对稳定GAN网络的重要性。尤其是当使用少量标记数据时,对于GAN网络的性能控制则更为重要。该谱归一化对标识符施加了全局正则化,应用于GAN网络时,生成的示例比常规的权重归一化更加多样化。相对于先前的方法获得了更好的可比较的初始分数。因此本文方法比基线模型有较大的优势,并且比其他先进的半监督语义分割方法都有更好的性能。

5 结 论

提出了一种改进的GAN框架半监督图像语义分割方法。首先,在分割网络中引入了自注意模块,以有效地考虑输入图像的广泛分离的空间区域之间的关系,从而捕获远程上下文信息。相比于传统方法通过增加卷积核大小或通过多个卷积层捕获这些依赖关系,更加平衡了特征图上各像素之间远程依赖性的建模能力和计算效率。其次,在判别器网络中应用了谱归一化,以增强GAN在训练过程中的稳定性,使得生成的样本比传统的权值归一化得到的样本更加多样化。这种方法以更细致的方式使得判别器的参数矩阵满足Lipschitz约束。从而使得GAN对输入图像的扰动不会有太大的敏感性。在cityscapes和PASCAL VOC 2012两个数据集上,与当前半监督图像语义分割方法的结果相比,提出的稳定的自注意半监督对抗性学习图像语义分割方法具有更好的性能。另外,通过实验发现,在进行半监督训练时,即使逐渐提高抽取标签数据的比例,对桌子、椅子和沙发的分割效果也没有明显提高。经过分析得出,造成此结果的原因可能是数据集中样本类别的不平衡所致。在PASCAL VOC 2012数据集中,针对桌子、椅子和沙发的类样本较少,这使得对这些类的训练更加困难。因此,即使添加标签数据,也很难提高这些类的分割精度。今后的工作将寻求一种比较有效的方法对易训练样本进行限制,对难训练样本进行加权,以此达到难易样本训练的平衡。