基于深度学习的睑板腺腺体分割方法研究

2022-07-12林嘉雯林智明赖泰辰郭林灵

林嘉雯,林智明,赖泰辰,郭林灵,邹 璟,李 笠

0 引言

睑板腺是位于上、下眼睑睑板上的大型皮脂腺,它通过分泌多种脂质成分,形成脂质层,能防止泪液过度蒸发,在维持眼表健康和完整方面起着至关重要的作用[1]。然而炎症、导管阻塞、环境变化等多种原因均会引起睑板腺数量和形态的改变以及分泌物质与量的变化,发生睑板腺功能障碍(meibomian gland disease,MGD)[1]。干眼是除屈光不正外最为常见的眼科疾病。流行病学数据调查显示,我国干眼患病率达21%~30%,且近年来呈现增长态势和年轻化趋势[2],其中超过65%的干眼患者具有MGD的临床表现[3]。2020年发布的《国人干眼多中心大数据报告》中指出,合并有MGD的临床确诊干眼患者数量占调查总数的92.8%,进一步证实MGD是干眼的主要致病原因之一。严重、慢性的MGD症状会使角膜和结膜出现继发性改变,大大降低了患者的视觉质量和生活质量[4]。

睑板腺的功能与其形态密切相关。通过直接观察睑板腺的形态,可以评价其结构和缺失情况[5],为干眼的分型诊断提供依据。利用红外成像技术透视睑板腺的形态,形成的图像便于保存,更有利于监测腺体随时间或治疗的形态变化。因此,红外睑板腺图像已被公认为是临床上观察和评估患者睑板腺形态变化的有效工具[5],在干眼患者的分型诊断、管理与个性化治疗中具有重要作用。单纯的人工诊断在大规模筛查情况下存在主观性强、可重复性低、缺乏客观量化指标和效率低等局限性,且现阶段我国基层医师的MGD诊断水平还十分有限[5],因此引入人工智能技术实现红外睑板腺图像的自动分析能在一定程度上克服人工诊断存在的问题,实现客观、可重复、高效的分析与评估,辅助形成准确的临床诊断与分级。红外睑板腺图像的智能分析研究主要围绕睑板腺图像分类、睑板腺区域分割和睑板腺腺体分割三方面展开。睑板腺图像分类方法能初步达成MGD的自动分级[6];睑板腺区域分割方法的提出则进一步实现睑板腺缺失比的粗略估计[7];睑板腺腺体自动分割旨在实现单个腺体的提取,不仅能得到更为精确的缺失比,还可以计算腺体数量、长宽和弯曲度等形态参数[1]。近年来,深度学习理论的不断发展及其在医学领域的成功运用,促进了学者们对红外睑板腺图像智能分析可行性和有效性的进一步验证[6-8]。本研究初步尝试了深度学习技术在红外睑板腺图像智能分析中的应用,引入UNet++网络结构旨在构建高效的睑板腺腺体自动分割模型,从而服务于后续睑板腺缺失率与其他形态生物参数的精确计算,以满足个性化、智能化的干眼诊疗需求[5]。

1 资料和方法

1.1资料选取2020-01/2021-06于福建省立医院眼科就诊的干眼患者106例212眼,应用眼表综合分析仪Keratograph 5M采集红外睑板腺图像。为了便于识别,拍摄时选择增强对比模式以突出显示腺体,采集到的原始图像均为RGB模式,分辨率为1578像素×966像素。剔除过于模糊、拍摄范围不全、睫毛遮挡、存在大面积过强反光的图像,最终纳入图像193幅。本研究经福建省立医院伦理委员会审批通过,所有受检查者均知情同意。

1.2方法

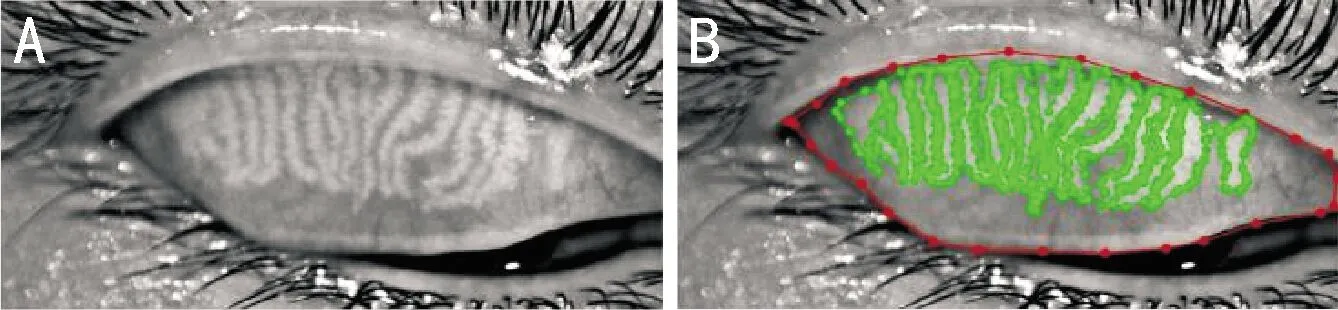

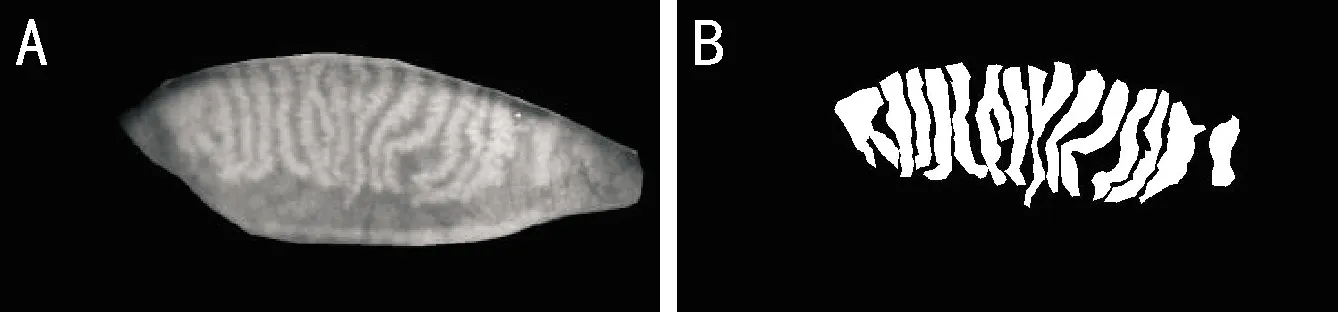

1.2.1数据处理与标记基于既往研究[8]经验,作为初步探索,本研究仅使用上眼睑图像。由于获取的原始图像十分规则,故将图像左上角740像素×350像素范围设为裁剪区域,通过批量裁剪得到规格相同、仅包含上眼睑区域的睑板腺图像,见图1A。每幅图像初始由3名有1a以上临床工作经验的眼科医师使用Labelme软件中的多边形工具分别对睑结膜范围和各个睑板腺进行标记。当标记结果出现分歧时,由第4名更高年资的眼科医师进行判定。最终,所有的标记结果由第4名眼科医师再次进行审核与修正。人工标记结果见图1B。根据标记结果,每张裁剪后的原始图像分别生成2张二值图像:睑结膜区域掩模和腺体的人工标注。将睑结膜区域掩模与裁剪后的图像相乘,消除睫毛等干扰,处理后得到的最终图像及其对应的人工标注图见图2。最终,这193组图像共同构成本研究的实验数据集,按照7∶1∶2的比例划分为训练集、验证集和测试集,其中训练集和验证集用于模型训练和参数调优,测试集则用于验证本研究提出方法的效果。训练时批处理大小设为8,训练周期数设为500,通过初始学习率为0.0003的Adam优化器优化模型,为避免过拟合,每50个周期衰减学习率为一半。

图1 裁剪后的上眼睑红外睑板腺图像 A:裁剪后的原始图像;B:人工标记的上眼睑睑结膜区域(红色)与腺体(绿色)。

图2 实验数据集中的图例 A:处理后图像;B:腺体的人工标注图。

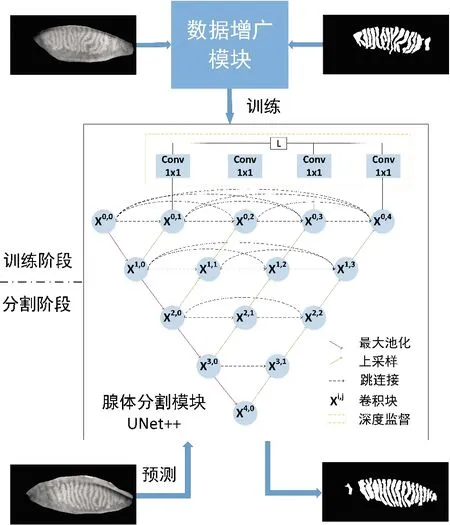

1.2.2基于UNet++的睑板腺腺体分割模型本研究引入UNet++构建睑板腺腺体分割模型,睑板腺腺体自动分割的工作流程见图3。本研究将睑板腺腺体分割问题视为一幅图像中每个像素点进行二分类的问题,睑板腺腺体分割的具体实现分为训练和分割两个阶段,包括数据增广、腺体分割等模块。

图3 基于UNet++的睑板腺腺体分割工作流程。

1.2.2.1数据增广模块数据增广模块主要克服训练过程中数据样本不足的问题,增强数据样本的多样性。传统的数据增广方法需要针对数据集设计专门的增广策略,并在增广过程中设置、调整变换幅度。本研究引入一种自动数据增广策略[9],每次迭代会从裁剪、翻转、剪切、平移、旋转、均衡化、对比度变化、亮度变化等11种数据增广方式中随机选择N种,并为这N种数据增广方式随机选择对应的变换幅度M。理想情况下,经过数据增广后的训练样本可扩增至MN×CN11倍。通过实验,本研究最终将N设为2,变换幅度M的选择范围为1~10。本研究中数据增广模块不需要人工设计数据增广策略,在一定程度上为腺体分割模型提供更多的数据样本,增强了模型的泛化能力。

1.2.2.2睑板腺腺体分割模块红外睑板腺图像为灰度图像,图像中没有特别丰富的语义信息,实验过程中发现不宜采用特别复杂的网络模型。2015年提出的UNet[10]是专门针对医学图像分割应用需求设计的模型,其利用跳连接融合浅层和深层语义特征图,克服下采样造成的信息丢失,显著提高了医学图像分割的精度。UNet++[11]是对UNet的改进,其重新设计了跳连接,进一步减少了编码器和解码器之间特征融合的语义差距,并通过深度监督对模型进行优化,使得模型可以剪枝,加快模型的推理速度。因此,本研究引入UNet++模型作为睑板腺腺体自动分割的主干网络。

1.2.3损失函数为处理训练过程中平滑梯度和处理类别不平衡的问题[12-13],本研究使用混合损失L对模型进行优化。混合损失L定义为像素级交叉熵损失LCE和Dice系数损失LDC之和,如公式(1)所示。

L=LCE+LDC

(1)

(2)

(3)

其中,yc,i和pc,i分别代表类别c和第i个像素人工标注和智能分析的分割结果;M为类别数;N为每批次的总像素数。

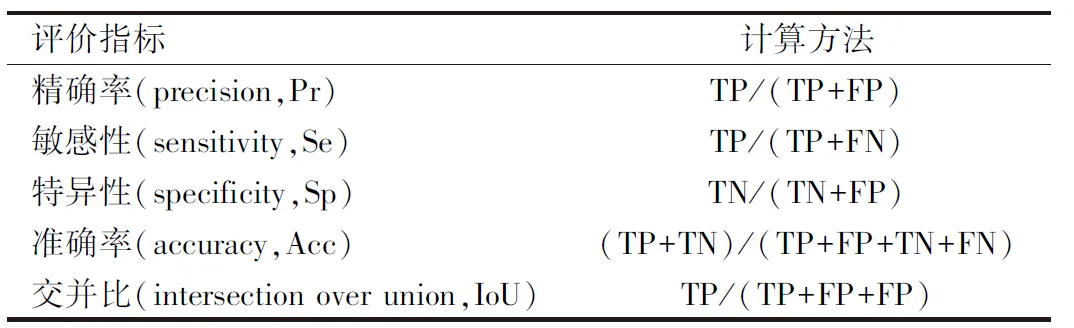

1.2.4评价指标为了评价本研究提出的睑板腺腺体自动分割方法的性能,本研究以人工标注的睑板腺腺体作为金标准,将自动分割出的睑板腺腺体与之进行逐像素对比。当人工标注和自动分割结果一致时,即为分割正确的像素,反之为分割错误的像素,可得到4种统计数量:分割正确的睑板腺像素个数(真阳性,TP)、分割错误的睑板腺像素个数(假阴性,FN)、分割正确的非睑板腺像素个数(真阴性,TN)和分割错误的非睑板腺像素个数(假阳性,FP)。进而,计算常用的评价指标(表1),其中敏感性(sensitivity,Se)越高说明自动分割模型“找全”睑板腺腺体的能力越强;特异性(specificity,Sp)越高表明模型能更好地“找对”睑板腺腺体;交并比(intersection over union,IoU)反映了人工标注与自动分割结果的重叠程度,重叠程度越大表明方法的性能越好。

表1 本研究采用的性能评价指标

2 结果

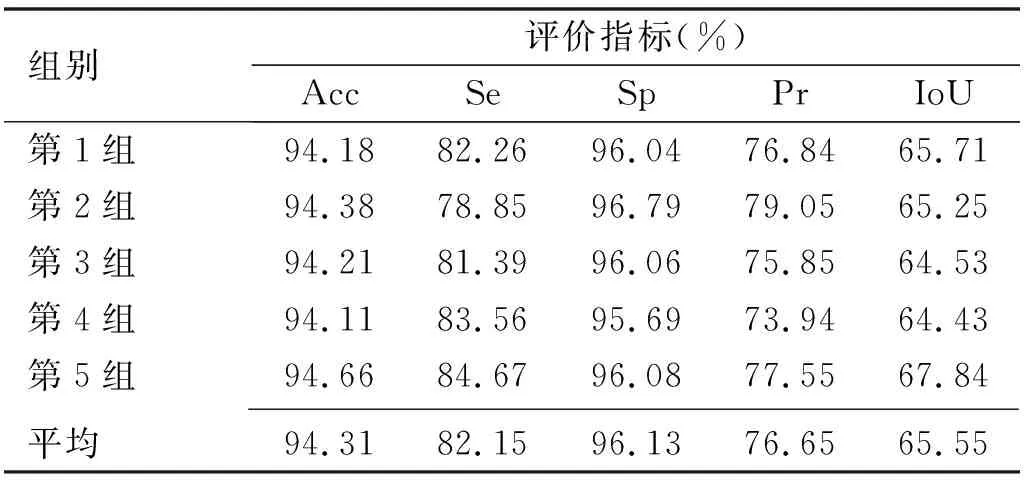

将193组图像按顺序划分为5组,各包含39、39、39、39、37组图像。将这5组分别作为测试集,其余图像作为训练集和验证集,采用5组交叉验证方式对本研究提出的睑板腺腺体自动分割方法的性能进行评估(表2),平均准确率为94.31%,平均敏感性为82.15%,平均特异性为96.13%,平均交并比为65.55%。交叉验证过程中各指标的数值均比较平稳,说明所提出的睑板腺腺体自动分割方法具有较好的稳定性。图4展示了基于UNet++的睑板腺腺体分割的可部分可视化效果,前3行图示分割效果几乎完美,自动分割结果与人工标注结果极为接近,其中最佳结果准确率高达为96.98%,敏感性为91.28%,特异性为97.79%;中间3行图示随机展示了3组一般情况,可以看出多数腺体(尤其是落在眼睑中间区域的腺体)可以较好地被识别,充分说明了本研究提出的睑板腺腺体自动分割方法的有效性;最后2行图示则展示了少数分割结果较差的样例,最差情况下腺体分割的准确率为87.48%,敏感性仅为50.53%。此外,本研究提出的睑板腺腺体自动分割方法完成单张图像的处理平均用时仅为0.11s,效率远远优于临床医师手动标记的情况。

图4 本研究提出的睑板腺腺体自动分割方法结果展示 A:输入图像;B:腺体分割结果;C:腺体的人工标注结果。

表2 基于UNet++的睑板腺腺体分割方法的性能

3 讨论

红外睑板腺图像中睑板腺腺体自动分割的研究目前仍处于起步阶段,已开始得到越来越多的关注。Arita等[14]首次提出一种基于快速傅里叶变换和γ校正分割腺体的方法;随后,研究者们结合阈值分割、形态学等传统方法[15-18]开展了一系列工作。传统的基于图像处理的腺体分割方法依赖研究者主观设计的手工特征,往往需要设置相应的经验参数,仍存在一定的主观性。深度学习方法可以直接从数据中学习特征,不需要明确指定提取规则或设计手工特征,已被广泛应用于医学图像分析领域,在视网膜血管分割[19]、脑肿瘤分割[20]、皮肤病变分割[21]等多个问题上取得不错的效果。Prabhu等[22]首次提出了一种基于UNet的睑板腺腺体自动分割方法,在此基础上,Dai等[23]进一步提出了参数更小的基于mini UNet的腺体分割模型,他们的工作均验证了深度学习方法用于睑板腺腺体分割的可行性和有效性。但遗憾的是,多数研究并未描述具体的可比较的性能指数,仅少数研究报道了相关量化结果。本研究提出的睑板腺腺体自动分割方法敏感性为82.15%,特异性为96.13%,精确率为76.65%,交并比为65.55%。Wang等[24]提出的方法的敏感性为53.9%,精确率为62.7%,交并比为58.4%。Xiao等[8]提出的方法的敏感性为81.39%,特异性为95.65%。可以明显看出本研究所提出的睑板腺腺体自动分割方法在几个评价指标上均表现最佳。尽管目前还没有针对红外睑板腺图像自动分析研究的公开数据集,现有方法缺乏统一的评价工具和标准,不利于研究者对方法进行直观比较,上述结果仍能在一定程度上体现出本研究提出的睑板腺腺体自动分割方法的优越性。

目前认为,当受到光照强度和高亮反光点的影响时,自动分割方法难以得到良好的腺体分割效果。本研究提出的睑板腺腺体自动分割方法引入深度学习技术,综合考虑腺体与其邻近区域的关系和信息,在一定程度上克服了强反光点对周边腺体分割的影响。然而当图像中存在伪影、腺体发生严重形变时,本研究提出的模型会出现误判腺体的情况,靠近两端的区域存在相邻的腺体分割后黏连的现象,还需在后续的研究中克服这些现象,进一步提高分割的精度。

1骆仲舟, 邓宇晴, 王耿媛, 等. 基于红外成像原理的睑板腺图像量化分析系统. 眼科学报 2021; 36(1): 30-37