基于无人机影像的城市植被精细分类

2022-06-29张文豪张翰超

林 怡,张文豪,宇 洁*,张翰超

基于无人机影像的城市植被精细分类

林 怡1,张文豪1,宇 洁1*,张翰超2

(1.同济大学测绘与地理信息学院,上海 200092;2.中国测绘科学研究院摄影测量与遥感研究所,北京 100830)

针对传统植被资源调查方法工作量大、成本高、效率低的问题,利用高分辨率无人机遥感影像,联合地物光谱-纹理-空间信息,构建了一种适用于描述城市不同植被种类的多维特征空间,在此基础上对三种应用广泛的分类算法(基于像素的、面向对象的支持向量机及深度学习Mobile-Unet语义分割模型)开展了对比分析研究.结果表明:本文提出的联合地物光谱-纹理-空间信息的特征空间构建方法能够有效地描述城市不同类型植被的特征差异,提升影像分割、植被分类的精度;在分类精度上,基于像素和面向对象的支持向量机分类结果的总体精度均超过90%,深度学习方法的总体分类精度为84%;在算法效率上,传统机器学习方法也优于深度学习方法.因此,得出结论针对城市小区域、小样本的植被精细分类,传统机器学习分类方法比深度学习方法效果更好.

无人机影像;城市植被;精细分类;多维特征空间;机器学习;深度学习

植被是城市环境的重要组成部分,是反映区域生态环境的标志之一.根据现行的《城市绿地分类标准》(CJJ/T85-2017)[1],城市管理部门通常采用绿地率、人均绿地面积两大绿化指标作为评价城市绿地建设水平的标准[2].但实际评价中,因为不同植被类型所含生物量不同,导致能实现的绿化作用与生态功能不尽相同[3].因此,需要针对不同植被类型进行具体评价.为此,植被类型的精细识别技术是研究的关键.城市公共植被的遥感精细分类及信息提取在城市土地利用变化、生态环境监测、城市植被监测以及城市规划等各个领域都具有重要的研究意义和应用价值.

传统植被资源调查需要实地测量,工作量大、成本高且效率低下[4].随着遥感与人工智能技术的发展,遥感影像的自动化处理与解译在植被调查工作中得到更广泛的应用.国内外学者已经在高分辨率遥感影像的基础上,利用传统基于像素的分类方法[5]、面向对象分类方法[6]和基于深度学习的语义分割方法(FCN[7]、SegNet[8]、U-Net[9]等)进行了植被的提取研究,如Li等[10]对WorldView-2/3影像进行面向对象的城市植被分类,比较了支持向量机(SVM)和随机森林(RF)方法的分类精度;徐知宇等[11]利用改进的U-Net模型,对北京市3个典型绿地区域的高分二号影像进行分类,总体分类精度达到92.73%.但卫星影像实时性不高,影像质量易受天气影响,且对于城市不同类型的植被信息提取来说,其空间分辨率仍不够高.因此,研究者们开始利用分辨率更高、获取信息更快的无人机进行植被信息的获取[12],为城市植被的精细管理开拓了一条更为高效的途径.

目前,越来越多的研究者尝试将无人机数据与深度学习方法结合来实现植被精细提取,如杨蜀秦等[13]应用改进的语义分割网络DeepLab V3+对无人机影像进行三种农作物的分类,与SVM算法相比取得了更好的分类效果,证明了深度学习算法的准确性与有效性;Torres等[14]用无人机获取的高分辨率影像和5个深度神经网络(SegNet, U-Net, FC- DenseNet,和两个DeepLabv3+的变形网络)对巴西城市地区濒临灭绝的树种进行单树种分类,该论文比较了多种语义分割网络在进行单树种分割时的精度,并且证明该方法可以用于树种的识别.在实际生活中,多树种分类更具意义.如戴鹏钦等[15]将基于Res-U-Net的FCN模型应用于无人机影像的林场树种分类,实现不同树种高精度识别;林志玮等[16]基于无人机航拍图像建立FC-DenseNet-103模型,将植被与非植被细分为13类实现精细的树种识别,最终平均识别正确率达到75.67%; Schiefer等[17]采用U-Net模型对无人机森林影像进行了13个植被类别的精细分类,其分类结果平均F1分数为0.73.以上研究均证实了无人机影像与语义分割网络结合对于精细植被分类的有效性.而Sothe等[18]同样利用无人机数据,但获取的是高光谱影像并与点云数据融合,分别使用卷积神经网络、随机森林等三种方法对巴西南部亚热带森林的16类树种分类,并对其精度和效率作比较.无论是无人机RGB影像还是高光谱影像,在这些大范围植被分布区域都能以较高精度实现植被的精细分类任务.

而城市植被具有分布较为分散、细碎,同一区域内植被类型较为单一等特点,与山区、林区、湿地[19]等研究区域相比,城市的植被分类研究还是有其特殊性的,而且城市植被精细分类的研究也并不多见.因此,本研究以城市植被为对象,借鉴李艳等[20]、杨礼[21]采用的植被分类准则,并结合不同植被类型的生态效益将植被分为乔木、小乔木、灌木、草地、水生植物等类别.其中灌木有两种主要形态,单株灌木和灌木丛,为了减小类内差异,提升分类的准确性,本研究将单株灌木和灌木丛区分为两个植被类别.由此构建了适合于城市植被的分类体系.

综上,本文以小区域、小样本的城市植被精细分类为目标,利用无人机影像,构建适用于描述不同植被类型的多维特征空间(光谱-纹理-空间),在此基础上对三种分类算法(基于像素的SVM、面向对象的SVM以及基于深度学习的Mobile-Unet模型)进行多方面对比分析.

1 研究区概况及数据

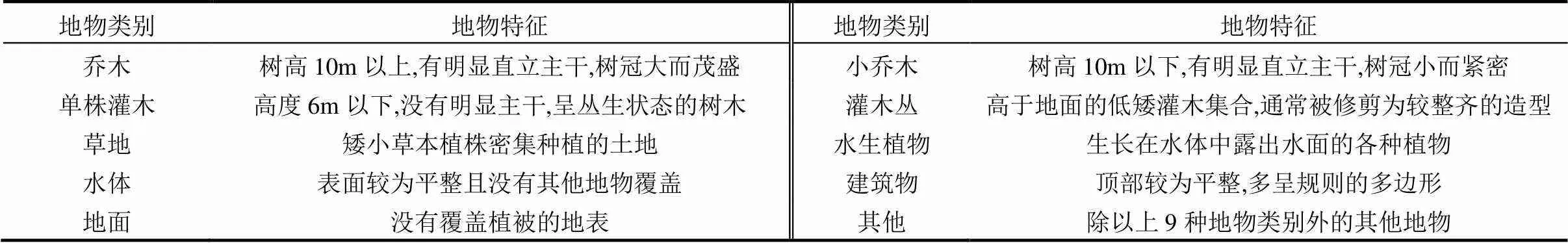

表1 分类地物形态

本文的研究区域为河南省焦作市滨河花园小区(35.18°N, 113.25°E),面积约为0.2km2,地面平均高程为94.7m,区域内植被物种丰富.经过实地考察,区域内部包括多种典型城市地物类别,依据之前研究中城市植被分类准则、结合小区内部的实际情况和不同植被的绿化效益,本研究将研究区域划分10个类别(表1).其包含两大区域:植被区域(乔木、小乔木、单株灌木、灌木丛、草地、水生植物,共6类),非植被区域(水体、建筑物、地面、其他,共4类).每种地物的形态描述见表1

本研究选用的无人机平台是北方天图TTA八旋翼无人机,搭载SONY ILCE-5100三波段RGB数码相机,平均航高为175m,拍摄时间为2017年6月,夏季植被茂盛.共获取研究区影像128张,每张影像大小为6000×4000像素.数据获取时天气晴朗,拍摄高度较低,建筑物和较高的树木有一定程度畸变.

2 研究方法

2.1 无人机影像预处理

本研究利用Pix4D mapper软件完成了无人机影像、POS数据和地面控制点等数据的预处理:导入数据、快速检查、加入控制点、自动空三、点云加密等,最终得到了研究区的正射影像(DOM)和数字表面模型(DSM),地面分辨率均为5cm.

2.2 联合光谱-纹理-空间信息的多维特征空间构建

如何构建特征空间是遥感影像高精度信息提取的关键[19].本研究针对城市不同类型植被的特性,利用ENVI 5.3软件对影像进行了处理和运算,构建了一种联合光谱-纹理-空间信息的多维特征空间,主要包含:正射影像RGB波段、植被指数集、纹理特征集和三维空间特征,共15维特征.

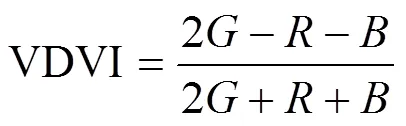

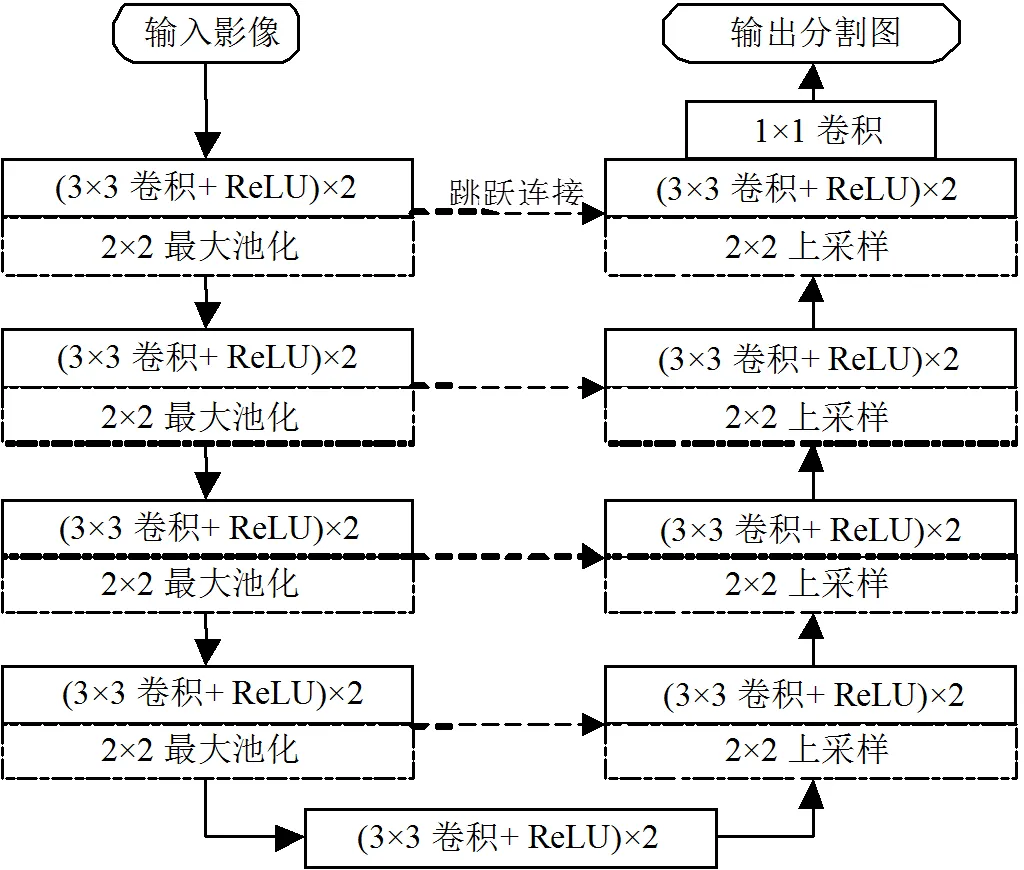

(1)植被指数:由于本研究实验采用的无人机影像仅包含RGB三个波段,无法通过计算归一化植被指数(NDVI)获取植被信息,因此选择可见光波段差异植被指数(VDVI)[22]、红绿比值指数(RGRI)[23]、超绿超红差分指数(EXGR)[24]三个指数参与植被信息的提取.3种指数计算式分别为(1)~(3):

(2)纹理特征:高分辨率无人机影像最大的优势是地物纹理清晰.由表1可知,不同植被类别的纹理有较大差异,这些差异使纹理成为进行地物识别的一个重要特征.因此除植被指数外,本文也使用灰度共生矩阵(GLCM)提取纹理信息,其提出者Haralick进一步定义了14种纹理特征参数[25],本研究选取了其中最常用的8个纹理特征:均值、方差、同质性、对比度、相异性、熵、二阶矩和相关性.

(3)三维空间特征:除上述植被指数、纹理等特征,研究还利用了无人机影像的另一优势,即生成三维点云,进而加密生成DSM.从而可以得到地物点的高度值,形成包含高度信息的三维空间特征.

2.3 三种分类方法比较

2.3.1 基于像素的SVM方法 传统的遥感影像分类方法是基于像素的分类,以单个像素作为分类的单元,该方法的优点是对中、低空间分辨率的遥感影像信息提取效果较好.在传统基于像素的分类方法中,SVM方法以其所需样本少、分类精度高、运行时间短的优势而被广泛应用[26].SVM是Vapnik[27]提出的一种建立在统计学习理论的结构风险最小化原则和VC维理论基础上的新型机器学习方法,其核心思想就是把待学习样本非线性映射到高维核空间,在高维核空间创建具有低VC维的最优分类超平面[28]将不同类别区分开.

本研究在实地考察的基础上,针对10种地物类别所占面积不同,按比例每类随机选取4000到30000个样本作为训练样本和测试样本.在构建的联合光谱-空间信息的多维植被特征空间基础上,调用scikit-learn库中的SVM函数,选取核函数为径向基函数的SVM模型进行基于像素的植被分类.

2.3.2 面向对象的SVM方法 基于像素的分类方法以像素为单位,因此无法有效利用像素之间存在的空间关系,尤其是高分辨率影像中丰富的空间、结构和纹理信息往往被忽略,且易出现“椒盐现象”[29].因此针对具有较低光谱分辨率但空间信息极为丰富的高分辨率遥感影像,面向对象分类方法[30]应运而生.对象是同质相邻像素的集合,以对象为分类基本单元不仅利用了其光谱信息,更加有效地利用了对象的空间几何与纹理信息,使得分类效果更好、精度更高.与基于像素的SVM方法不同,此时进入SVM分类器的是经过分割后同质对象.

面向对象分类的第一步是影像分割,影像分割的效果会影响下一步分类的结果.实验发现,植被颜色指数CIVE[31]有助于提升影像分割的效果,指数计算见式(4),因此研究将无人机正射影像RGB波段、DSM和CIVE影像共5个波段作为面向对象分类的输入,多次实验确定5个波段的权重分别为=1,=0,=0, CIVE=1, DSM=1.然后通过控制变量方法比较不同尺度参数的分割效果,最终确定尺度参数40、形状参数0.2和紧致度参数0.5,利用eCognition软件完成影像的多尺度分割.基于多尺度分割的结果,构建联合光谱-纹理-空间信息的多维特征空间,在实地考察的基础上为10个地物类别选择一定数量的对象作为训练和测试样本.选取核函数为径向基函数的SVM模型进行面向对象的不同类型植被分类.

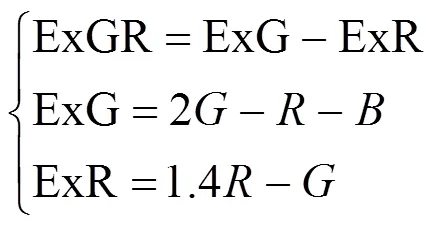

2.3.3 基于深度学习的Mobile-Unet模型 在全卷积神经网络(FCN)的基础上,Ronneberger等[9]提出了改进的语义分割模型U-Net,其延续了FCN的思想,利用卷积层、池化层进行特征提取,用反卷积层恢复为原图像大小.

U-Net结构见图1,整个网络由左右两个部分组成,左侧的压缩通道和右侧的扩展通道,两个部分通过网络的跳跃连接实现低层特征与高层特征融合.U-Net的优点是可以用少量的数据进行训练得到不错的分割效果,十分符合小研究区范围遥感影像分类任务的要求.

所用操作系统为Ubuntu18.04,采用Python语言,模型基于PyTorch深度学习框架实现,GPU为Nvidia GeForce RTX 2060 6G,由于实验条件的限制,本研究将U-Net的骨干网络替换为轻量级的MobileNet[32],使得用更少的参数、更快的运算速度,达到较好的结果.MobileNet的创新就是将VGG网络中的标准卷积层替换为深度可分离卷积层,该层就是把普通卷积层拆分成了一个深度卷积和一个逐点卷积.深度卷积是将卷积核拆分成为单通道形式,每一个特征图对应一个卷积核进行卷积,得到和输入特征图通道数一致的输出特征图.然而,这样一来特征图的维度过少,可能无法提取足够的信息,于是在深度卷积层后增加逐点卷积层,即用1×1的卷积核对特征图进行升维,使其输出的特征图维数和标准卷积层一致.最终网络整体的参数量只有标准卷积的1/9左右.其优势在于使用较小的数据集也可以完成训练并达到较高的精度.

图1 U-Net结构

研究基于实地调查结果对无人机影像进行了手动类别标注,得到标签图像.将正射影像图加上DSM影像构成的四波段影像作为网络的原始输入,样本尺寸为512×512像素,共100张.由于样本量较小,因此采用数据增强算法增加样本数量,最终共得到295个样本标签对,形成了一个小型无人机样本数据集,如图2.

本研究获取的样本数量较少,数据集规模较小,因此可以利用Mobile-Unet的优势进行小样本集的语义分割.网络输入影像大小为512×512像素,类别数为10.将数据集输入模型中,以7:3的比例划分训练集和验证集.运用迁移学习的思想,使用ImageNet训练集的预训练网络参数作为模型参数的初始值进行训练.学习率设置为0.0001,batch大小8,训练次数100,使用交叉熵函数作为网络的损失函数.

2.4 精度评价指标

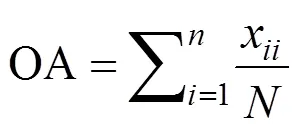

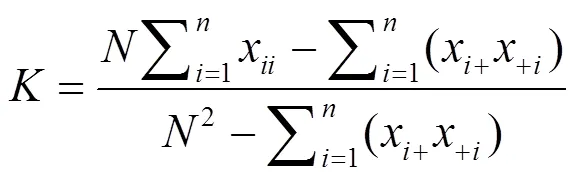

遥感分类精度评价一般是比较分类预测图像与参考图像的一致性,常用方法是混淆矩阵.本文采用混淆矩阵对分类后影像的全部像元进行类别统计,并将总体分类精度(overall accuracy, OA)、Kappa系数、用户精度(落在该类别上的检验点,被正确分类为该类别的比率)和生产者精度(该类别的地面真实参考数据被正确分类的概率)作为评价指标.

总体分类精度是常用的一种精度评价指标,表示每一个像素正确分类的概率,被正确分类的像元沿着混淆矩阵的对角线分布.Kappa系数则是一个综合指标,其同时考虑了对角线以外的各种漏分和错分像元,表示预测结果和实际分类结果是否一致,取值[-1,1].具体见式(5)、(6):

式中:x为正确分类的像元个数,x+、+i为混淆矩阵各行、各列之和,为像元总数,为类别数.

3 实验与分析

3.1 联合光谱-纹理-空间信息的多维空间

3.1.1 光谱特征 根据式(1)~(3)计算得到的植被指数如图3所示.可以看出,VDVI可以很好的将植被与非植被区域区别开来,植被区域颜色较亮而非植被区域像素的灰度值较小颜色暗,但水体和植被区域难以区分.RGRI与VDVI的表现正相反,植被区域颜色较暗而非植被区域稍亮,但图像中草地与树木(乔木、小乔木、单株灌木、灌木丛)有一定的颜色差,因此在草、树混杂的区域可以更好的区分二者.EXGR同样可以区分植被与非植被,其优势在于对非植被区域的地物类别有更好的区分能力,但效果不如RGRI和VDVI图像.这三种植被指数的另一个优点在于不受原图中阴影的影响,可以将阴影中的植被、甚至植被纹理很好的表现出来,见图4.

图3 原始影像与可见光植被指数影像

图4 阴影中植被的表现

3.1.2 纹理特征 为避免数据冗余,提升运行效率,对无人机3波段影像中信息熵最大的红波段进行8个纹理特征的计算,得到8幅纹理特征影像.

3.1.3 三维空间特征 图6是生成的具有不同地物高程信息DSM影像,图中的灰度值代表地物的高度值,颜色越亮表示地物高度越高,反之则越低.

图5 纹理特征影像

图6 DSM影像

3.2 分类结果比较及精度评定

3.2.1 基于像素分类的结果与分析 经过SVM分类及分类后处理,得到结果影像如图7所示.

研究用混淆矩阵对结果进行精度评价,得到总体分类精度92.8%,Kappa系数值为0.917,具体精度指标如表2所示,分类耗时4.75h.从混淆矩阵中可以看出,小乔木与单株灌木和草地类别之间存在错分情况,原因在于部分小乔木与单株灌木高度差别不大,部分树木纹理相似导致混淆;而小乔木与草地间的错分在于一部分小乔木比较低矮且在影像上面积很小,因此无法正确区分被错误分类为其背景类别,即草地.单株灌木与灌木丛之间的错分情况较为严重,两者高度相当,且纹理信息十分相似,同为灌木类但在形态上差异较大,因此基于像素的分类方法很难将二者区别开来.由于该分类算法无法充分利用影像的纹理和结构信息,会出现一棵乔木中心高的区域被分为乔木类,而四周低矮的部分则有可能被分为小乔木类的情况,出现“同物异类”现象导致分类精度下降.但总体来看,除单株灌木、灌木丛外,其余类别的类别精度均在79%以上,总体分类结果良好.

表2 基于像素分类混淆矩阵

3.2.2 面向对象分类的结果与分析 经过无人机正射影像的多尺度分割、SVM方法的训练和分类等步骤,最终得到面向对象方法分类的结果,如图8所示.分类的总体精度为93.1%,Kappa系数值为0.918,具体分类指标如表3所示,面向对象方法分类耗时4.267h.

从分类混淆矩阵表中可以看出,与基于像素的分类结果相比,小乔木、灌木丛和草地的分类精度略有提高,水生植物和水体的精度略有降低,而地面和其他两个类别出现错分导致分类精度下降.乔木和单株灌木类别没有大的变化,但单株灌木与灌木丛由于形状不同,在影像分割时得以区分,因此混淆程度有所降低.综上,面向对象和基于像素的分类结果精度相差不大,而在6种植被类别的分类精度看来,面向对象的分类效果较好,很大程度上避免了“椒盐现象”.

图7 基于像素分类结果

图8 面向对象分类结果

3.2.3 基于Mobile-Unet模型分类的结果与分析 在训练过程中,训练次数设置为100,随着次数不断增加,训练集和验证集的损失值不断下降,精度提高.但迭代次数增加到一定大小时,训练集的损失依然在减小,但验证集的损失不再下降,此时即出现了过拟合.为了避免过拟合的发生,在验证集的损失不再下降时停止训练.实验中训练次数增加至39时验证集损失不再下降,因此停止训练,训练集与验证集的损失值变化如图9所示.

选择3个没有参与训练、验证区域的影像进行切割并预测,预测结果的混淆矩阵见表4,原图、标签图像与预测结果的比较如图10所示,图10(a)的精度为84.0%,图10(b)的精度为83.8%,图10(c)的精度为82.0%,预测的总体精度为83.3%,Kappa系数0.832,分类精度低于上述两种机器学习方法,耗时6.533h.从预测图像中可以看出,采用卷积神经网络方法进行植被分类也能取得很好的效果,但水生植被分类效果较差.

表3 面向对象分类混淆矩阵

图9 训练集、验证集的损失曲线

3.2.4 三种方法性能比较 分析三种分类方法的性能指标对比见表5.对比三种分类方法,可以看出在本论文的小样本、小区域植被分类中,机器学习的方法优于深度学习方法.一方面是机器学习分类中选取了实践经验中十分有效的特征构成了联合光谱-纹理-空间信息的多维特征空间,使得机器学习的精度得以提升;另一方面是深度学习方法受到小样本和计算机性能的限制,导致其在精度和效率上难以发挥自身优势.

表4 深度学习分类混淆矩阵(万)

表5 三种分类方法结果对比

4 讨论

通过以上三种分类算法的比较实验,也可以分别看到几种算法的不足.①基于像素的分类方法无法充分利用遥感影像的纹理、结构信息,会产生“椒盐现象”和“同物异类”现象,并且每次分类都需要手动选取样本,分类的效果常常取决于样本的选择,自动化程度较低,因此本研究建立了联合光谱-纹理-空间信息的多维特征空间,结果表明分类精度有一定的提升;②面向对象的分类方法可以充分利用影像的纹理、结构信息,能够更好地识别具有规则形状的地物,理论上应该明显高于基于像素方法的分类精度,但在高分影像的复杂场景中,很难准确的对地物进行分割,而分割结果的好坏直接影响到分类的精度,因此,面向对象方法的分类精度仅比基于像元方法高0.3%,自动化程度也不高;③基于深度学习“端到端”的方法能够更好地实现自动化且能够处

理高分影像中复杂场景的分类,但对计算能力和样本量的需求较高,更适用于大范围、样本数据量较大的植被分类问题.本研究由于研究区较小,无法制作足够数量的数据集,且实验条件有限,因此选择了样本需求量较小的U-Net和网络参数量较少的MobileNet进行结合的Mobile-Unet分割模型.实验结果表明,小样本卷积神经网络提取出的特征并没有人工选取的特征更有效.因此,分类精度也会低于一般的机器学习分类方法.

由于本研究受限于小样本和缺乏可以迁移的遥感影像样本数据集,基于深度学习方法的城市植被精细分类并不具有优势.然而众所周知,利用深度学习的方法进行分类具有巨大的潜力.其一,传统的分类方法,需要人工提取或选择特征,且都是浅层特征,而深度学习方法可以提取高级语义特征,在大数据集的应用上非常具有优势;其二,一般的机器学习方法在每次分类时都需要针对具体应用手动选取样本,泛化能力较差,而深度学习方法自己学习到的特征泛化能力更好,鲁棒性更强.未来可以不断扩展植被分类数据集,在更大范围内(如整个城市)、选择效果更好的深度卷积网络进行植被分类研究,才能让深度学习发挥其价值.

5 结论

5.1 本文使用的联合光谱-纹理-空间信息的植被多特征空间能够提高基于像素方法和面向对象方法进行植被精细分类的精度,同时CIVE植被指数的加入也提高了面向对象方法的初步分割效果.

5.2 基于像素的SVM分类和面向对象的SVM分类总体精度都达到90%以上,基于深度学习方法的Mobile-Unet模型分类总体精度约为83%,两类基于SVM的分类方法均能够很好地提取不同绿化效益的植被,在算法效率上,明显要优于Mobile-Unet模型.可见,在研究区域小、数据量有限的情况下,无论从效率还是精度来看,传统的基于机器学习的方法比深度学习方法更适用.

[1] CJJ/T 85-2017 城市绿地分类标准[S].

CJJ/T 85-2017 Standard for classification of urban green space [S].

[2] 白晓琼,王 汶,林子彦,等.基于高空间分辨率遥感影像的三维绿度度量[J]. 国土资源遥感, 2019,31(4):53-59.

Bai X Q, Wang W, Lin Z Y, et al. Three-dimensional measuring for green space based on high spatial resolution remote sensing images [J]. Remote Sensing for Land and Resources, 2019,31(4):53-59.

[3] 费鲜芸.高分辨率遥感影像在城市绿地信息提取中的应用研究 [D]. 泰安:山东农业大学, 2006.

Fei X Y. The study of urban green space surveying based on high resolution RS images [D]. Taian: Shandong Agricultural University, 2006.

[4] 赵康兵.高分辨率遥感影像技术应用研究——以城市绿化精细化调查为例 [J]. 南京工程学院学报(自然科学版), 2019,17(4):50-56.

Zhao K B. Application of high resolutionremote sensing image technology—taking urban greening investigation as an example [J]. Journal of Nanjing Institute of Technology (Natural Science Edition), 2019,17(4):50-56.

[5] 颜梅春.高分辨率影像的植被分类方法对比研究[J]. 遥感学报, 2007,(2):235-240.

Yan M C. Research and contrast on several vegetation-classification methods of high-resolution satellite image data [J]. Journal of Remote Sensing, 2007,(2):235-240.

[6] 韩文霆,张立元,张海鑫,等.基于无人机遥感与面向对象法的田间渠系分布信息提取[J]. 农业机械学报, 2017,48(3):205-214.

Han W T, Zhang L Y, Zhang H X, et al. Extraction method of sublateral canal distribution information based on UAV remote sensing [J]. Transactions of the Chinese Society for Agricultural Machinery, 2017,48(3):205-214.

[7] Shelhamer E, Long J, Darrell T. Fully convolutional networks for semantic segmentation [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017,39(4):640-651.

[8] Badrinarayanan V, Kendall A, Cipolla R.SegNet: A deep convoluntional encoder-decoder architecture for image segmentation [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017,39(12):2481-2495.

[9] Ronneberger O, Fischer P, Brox T.U-Net: Convolutional networks for biomedicalimage segmentation [C]// International Conference on Medical Image Computing and Computer-Assisted Intervention. Springer, Cham, 2015:234-241.

[10] Li D, Ke Y, GongH, et al. Object-based urban tree species classification using bi-temporal WorldView-2 and World View- 3images [J]. Remote Sensing, 2015,7(12):16917-16937.

[11] 徐知宇,周 艺,王世新,等.面向GF-2遥感影像的U-Net城市绿地分类[J]. 中国图象图形学报, 2021,26(3):0700-0713.

Xu Z Y, Zhou Y, Wang S X, et al. U-Net for urban green space classification in Gaofen-2remote sensingimages [J]. Journal of Image and Graphics, 2021,26(3):0700-0713.

[12] 周 涛,胡振琪,韩佳政,等.基于无人机可见光影像的绿色植被提取 [J]. 中国环境科学, 2021,41(5):2380-2390.

Zhou T, Hu Z Q, Han J Z, et al. Green vegetation extraction based on visible light image of UAV [J]. China Environmental Science, 2021, 41(5):2380-2390.

[13] 杨蜀秦,宋志双,尹瀚平,等.基于深度语义分割的无人机多光谱遥感作物分类方法[J]. 农业机械学报, 2021,52(3):185-192.

Yang S Q, Song Z S, Yin H P, et al. Crop classification method of UVA multispectral remote sensing based on deep semantic segmentation [J]. Transactions of the Chinese Society for Agricultural Machinery, 2021,52(3):185-192.

[14] Torres D L, Feitosa R Q, Happ P N, et al. Applying fully convolutional architectures for semantic segmentation of a single tree species in urban environment on high resolution UAV optical imagery [J]. Sensors, 2020,20(2):563.

[15] 戴鹏钦,丁丽霞,刘丽娟,等.基于FCN的无人机可见光影像树种分类[J]. 激光与光电子学进展, 2020,57(10):36-45.

Dai P Q, Ding L X, Liu L J, et al. Tree species identification based on FCN using the visible images obtained from an unmanned aerial vehicle [J]. Laser & Optoelectronics Progress, 2020,57(10):36-45.

[16] 林志玮,涂伟豪,黄嘉航,等.基于FC-DenseNet的低空航拍光学图像树种识别[J]. 国土资源遥感, 2019,31(3):225-233.

Lin Z W, Tu W H, Huang J H, et al. Tree species recognition of UAV aerial images based on FC-DenseNet [J]. Remote Sensing for Land and Resources, 2019,31(3):225-233.

[17] Schiefer F, Kattenborn T, Frick A, et al.U-Net: Mapping forest tree species in high resolution UAV-based RGB-imagery by means of convolutional neural networks [J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2020,170:205-215.

[18] Sothe C, De Almeida C M, Schimalski M B, et al.Comparative performance of convolutional neural network, weighted and conventional support vector machine and random forest for classifying tree species using hyperspectral and photogrammetric data [J]. GIS & Remote Sensing, 2020,57(3):369-394.

[19] 左萍萍,付波霖,蓝斐芜,等.基于无人机多光谱的沼泽植被识别方法 [J]. 中国环境科学, 2021,41(5):2399-2410.

Zuo P P, Fu B L, Lan F W, et al. Classification method of swamp vegetation using UAV multispectral data [J]. China Environmental Science, 2021,41(5):2399-2410.

[20] 李 艳,和太平.广东省茂名市居住区绿地植物资源及应用调查分析 [J]. 安徽农业科学, 2021,49(8):116-119.

Li Y, He T P.Investigation and application analysis of green land plantresources in residential area of Maoming city, Guangdong Province [J]. Journal of Anhui Agricultural Sciences, 2021,49(8):116- 119.

[21] 杨 礼.融合UAV遥感影像与SFM点云的树木识别及参数提取 [D]. 焦作:河南理工大学, 2018.

Yang L. Tree parameters extraction using UAV remote sensing image and SFM point cloud [D]. Jiaozuo: Henan Polytechnic University, 2018.

[22] 汪小钦,王苗苗,王绍强,等.基于可见光波段无人机遥感的植被信息提取 [J]. 农业工程学报, 2015,31(5):152-159.

Wang X Q, Wang M M, Wang S Q, et al. Extraction of vegetation information from visible unmanned aerial vehicle images [J]. Transactions of the Chinese Society of Agricultural Engineering, 2015,31(5):152-159.

[23] Verrelst J, Schaepman M E, Koetz B, et al.Angular sensitivity analysis of vegetation indices derived from CHRIS/PROBA data [J]. Remote Sensing of Environment, 2008,112(5):2341-2353.

[24] Meyer G E, Neto J C. Verification of color vegetation indices for automated crop imaging applications [J]. Computers & Electronics in Agriculture, 2008,63(2):282-293.

[25] 宋荣杰,宁纪锋,刘秀英,等.基于纹理特征和SVM的QuickBird影像苹果园提取[J]. 农业机械学报, 2017,48(3):188-197.

Song R J, Ning J F, Liu X Y, et al. Apple orchard extraction with Quick Birdimagery based ontexture features and support vector machine [J]. Transactions of the Chinese Society for Agricultural Machinery, 2017,48(3):188-197.

[26] 郑亚卿,杨张海,高凯旋,等.基于多时相Landsat-8的森林生态系统树种精细分类[J]. 测绘与空间地理信息, 2021,44(6):158-161.

Zheng Y Q, Yang Z H, Gao K X, et al. Sophisticated classification of tree species in forest ecosystembased on multi-temporal Landsat-8 [J]. Geomatics & Spatial Information Technology, 2021,44(6):158-161.

[27] Vapnik V N. The nature of statistical learning theory [M]. New York: Springer-verlag, 1995.

[28] 边肇祺,张学工.模式识别第二版[M]. 北京:清华大学出版社, 2000.

Bian Z Q, Zhang X G. Pattern recognition (The second edition) [M]. Beijing:Tsinghua University Press, 2000.

[29] 王志盼,沈 彦,王 亮,等.单类分类框架下的高分辨率遥感影像建筑物变化检测算法 [J]. 武汉大学学报(信息科学版), 2020,45(10): 1610-1618.

Wang Z P, Shen Y, Wang L, et al. High resolutionremote sensing image building change detection basedon one class classifier framework [J]. Geomatics and Information Science of Wuhan University, 2020,45(10):1610-1618.

[30] Baatz M, Schape A. Object-oriented and multi-scale image analysis in semantic networks [C]// Proceedings of the 2nd International Symposium on Operationalization of Remote Sensing, Enschede, Netherlands, 1999:16-20.

[31] 周小成,郑 磊,黄洪宇.基于多特征优选的无人机可见光遥感林分类型分类 [J]. 林业科学, 2021,57(6):24-36.

Zhou X C, Zheng L, Huang H Y. Classification of forest stand based on multi-feature optimization of UAV visible light remote sensing [J]. Scientia Silvae Sinicae, 2021,57(6):24-36.

[32] Howard A G, Zhu M, Chen B, et al. MobileNets: Efficient convolutional neural networks for mobile vision applications [J]. arXiv:1704.04861, 2017.

Fine classification of urban vegetation based on UAV images.

LIN Yi1, ZHANG Wen-hao1, YU Jie1*, ZHANG Han-chao2

(1.College of Surveying and Geo-Informatics, Tongji University, Shanghai 200092, China;2.Institute of Photogrammetry and Remote Sensing, Chinese Academy of Surveying and Mapping, Beijing 100830, China)., 2022,42(6):2852~2861

The fine classification and information extraction of urban public vegetation based on remote sensing methods hasgreat significance in urban land use change, urban ecological environment monitoring and urban planning. Aiming toreducethe heavy workload, high cost and enhancetheefficiency of traditional vegetation resource survey methods, a multi-dimensional feature space including spectral, spatial and texture features for describing different types of urban vegetation was proposed in this study. Then a comparison experiment of three typical classification algorithms (pixel-based, object-oriented support vector machine and deep learning semantic segmentation model-Mobile-Unet) was accomplished. The experimental results indicate that: The proposed spectrum-texture-spatial feature extraction method can describe different types of urban vegetation effectively, and improve the accuracy of image segmentation and vegetation classification significantly. In terms of classification accuracy, the overall accuracy of pixel-based and object-oriented support vector machine classification exceed 90%, while the overall accuracy of deep learning method is only 84%. In terms of efficiency, traditional machine learning methods are also superior to deep learning method. Therefore, for the fine classification of different vegetation in small urban areas with small samples, traditional machine learning classification methods are more effective than deep learning method.

unmanned aerial vehicle image;urban vegetation;fine classification;multi-dimensional feature space;machine learning;deep learning

TP751.1 ,X87

A

1000-6923(2022)06-2852-10

林 怡(1970-),女,浙江温州人,研究员,博士,主要从事数字摄影测量与城市、环境遥感研究.发表论文80余篇.

2021-11-17

地理信息工程国家重点实验室开放基金课题(SKLGIE2018- K-3-1);上海市“科技创新行动计划”科技攻关项目(20dz1201200);自然资源部测绘科学与地球空间信息技术重点实验室开放研究基金课题(2020-2-3)

*责任作者, 助理教授, 2011_jieyu@tongji.edu.cn