红外与可见光图像多特征自适应融合方法

2022-06-22王君尧王志社武圆圆陈彦林邵文禹

王君尧,王志社,武圆圆,陈彦林,邵文禹

(太原科技大学 应用科学学院,山西 太原 030024)

0 引言

红外传感器具备全天时全天候工作能力,能够获取捕捉目标的热辐射信息,但所获取的红外图像存在分辨率低、对比度差、边缘模糊等缺点。可见光传感器通过光反射成像,能够获取场景、纹理和细节等信息,但容易受恶劣天气、光照等环境因素影响。红外与可见光传感器成像机理不同,成像频段不同,表征前景目标和后景细节的特征信息差异大,成像条件和成像特性都具有很强的互补性。因此,图像融合技术可以整合红外与可见光图像的互补特征信息,从而合成一幅有利于人眼观察或其他视觉任务的单一图像,能够广泛应用于实时监控[1]、目标跟踪[2]、目标检测[3]、行人识别[4]等领域。

传统图像融合方法通常依据目标特性或成像机制等先验知识,构建相应特征提取模型,再设计相应的融合规则,通过反变换得到最终的融合图像。常见的融合方法有多尺度变换[5]、稀疏表示[6]、显著性融合[7]和混合方法[8-9]等。传统的融合方法依赖固定的数学模型,仅能对某一类特征敏感,且无差别提取红外与可见光图像特征,特征提取能力不足。此外,需要人工设计相应的融合规则,计算复杂度高,且规则单一,缺乏对图像特征自适应的提取能力。因此,传统方法的融合图像容易导致细节丢失、图像扭曲和人造纹理等问题,无法达到理想效果。

近年来,由于卷积运算具有较强特征提取能力,基于深度学习融合方法[10-13]利用大量图像数据,不断训练网络模型,获取最优模型参数,有效地提高了图像融合性能。文献[14]提出了DenseFuse,在编码器中引入密集连接模块,利用中间层特征增强特征表征能力,但其网络结构简单,且不能提取图像的多尺度特征。文献[15]提出了IFCNN,选择不同的特征融合策略以适应不同的融合要求,实现多任务图像融合。文献[16]提出了UNFusion,构建了多尺度编码器与解码器,且采用密集连接结构,可以有效地提取和重建多尺度深度特征。尽管这些方法取得了较好的融合效果,但仍需人工设计相应的融合规则,是非端到端方法。为解决上述问题,文献[17]提出FusionGAN,首次将生成对抗网络引入图像融合领域中,将图像融合问题视为特征对抗问题。接着,又提出了GANMcC[18],进一步将图像融合问题转化为多分类限定问题。文献[19]设计了RFN-Nest,采用两阶段训练,先训练编码器和解码器,再训练融合规则。这些虽然规避了融合规则的人为限制,但无法依据源图像特征自适应变化,造成图像特征提取不充分,导致融合结果不能同时保留红外目标特征与可见光纹理细节。

针对上述问题,本文提出了红外与可见光图像多特征自适应融合方法。首先,构建了多尺度密集连接网络,在解码和编码器中建立密集连接,可以聚合所有不同尺度不同层的中间特征,有效地提高了网络模型的特征提取和重构能力。其次,构造了多特征自适应损失函数,依据VGG-16 网络提取源图像各自的特征信息,自适应监督融合网络训练,从而获得更加平衡的融合结果。

1 融合方法

1.1 网络结构

多特征自适应融合方法的原理框架如图1所示,其中,左半部分为编码器(encoder),普通卷积层Conv1-4 采用3×3 卷积核,用于提取4 个不同尺度的浅层特征。ECB 表示编码卷积模块,由卷积核为1×1、3×3 的两个卷积层组成,用于提取图像深层特征。网络的右半部分为解码器(decoder),DCB 表示解码卷积模块,包含了两个3×3 卷积层,用于重构图像特征。卷积层Conv5 用于输出最终结果,采用Sigmoid 作为激活函数,而其他卷积层都采用PReLU 作为激活函数。此外,向下箭头表示下采样操作,采用步长卷积运算,而向上箭头表征上采样操作,采用最近邻插值法。可以看出,垂直方向表明了网络的尺度变化,水平方向表征了网络的深度变化,利用密集跳转连接,可以聚合所有不同尺度不同层级的中间特征,进一步提高网络的特征提取与重构能力。

图1 多特征自适应融合方法原理Fig.1 The principle of multi-feature adaptive fusion method

在训练时,将红外与可见光图像分别输入至VGG-16 网络的3 个通道中,并于最大池化前获取5个不同尺度的特征图,最后通过计算,得到多特征自适应权重ωir、ωvis,以控制损失函数中的比例参数,自适应调整不同源图像与融合图像之间的特征误差,获得信息更加均衡的结果。在测试时,网络无需加载VGG-16 网络与多特征自适应损失函数,仅将红外与可见光图像进行通道合并(concatenate),输入至编码器,最后,将获取的不同尺度的特征图通过解码器,重构得到融合结果。

1.2 多特征自适应损失函数

红外与可见光图像融合应同时保留红外图像与可见光图像的特征信息,即红外目标与可见光纹理细节。若某一源图像包含丰富的信息,那么其特征保留的比例应该增加,使融合结果与该源图像具有较高的相似性。而现有的融合方法等同看待源图像的固有特征,无法针对源图像的固有特征的差异性,自适应调节融合图像与源图像之间的特征保留比例,造成信息损失。为此,本文方法综合考虑不同类型源图像的特征差异,设计了统一的信息度量。通过计算源图像与融合结果之间的相似关系,自适应调整损失函数的参数,以监督网络训练过程,有效解决了此类问题。本文结合红外与可见光源图像的各自的固有特征,以像素结构与像素强度为度量准则,构造了多特征自适应损失函数。依据VGG-16网络提取源图像各自的特征信息,自适应监督融合网络训练,均衡地提取可见光图像的纹理细节与红外图像的目标亮度,从而获得更加平衡的融合结果。

在训练时,采用VGG-16 网络提取源图像I的多尺度特征,其中j表示尺度,j=1,2,…,5,k表示通道索引,取值区间为[1,Cj]。通过计算特征图的梯度特征来获取源图像的结构信息保留度δS,权重越高代表结构信息保留程度越高,如公式(1)所示:

计算结构信息保留度可以评估边缘和细节等高频信息,但容易引起图像像素强度以及目标特征信息损失,因此需要获取源图像的像素强度信息保留度δI,以均衡测量源图像与融合图像之间的特征相似性,如公式(2)所示:

综合上述的结构特征保留度和像素强度保留度,总的特征信息保留度如公式(3)所示:

式中:α为超参数,用于权衡δS 与δI的比例关系。

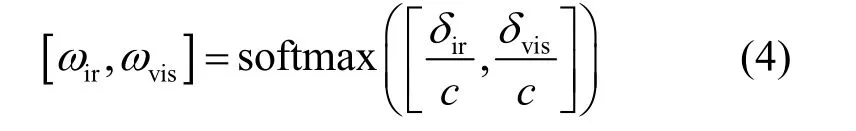

每组源图像Iir、Ivis可由信息保留度δir、δvis 计算得到ωir、ωvis,如公式(4)所示:

式中:超参数c用于缩放数值,以获得更好的权重分配。softmax 函数将多特征自适应权重ωir、ωvis 映射到区间[0,1],且ωir+ωvis=1。

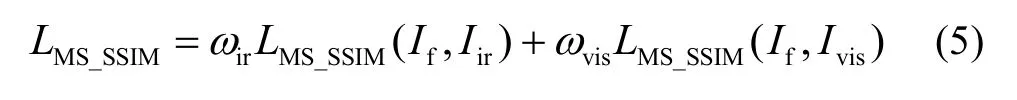

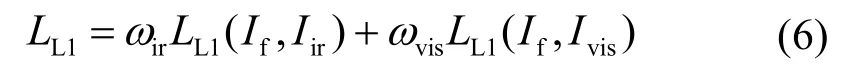

将多特征自适应权重应用于损失函数,以监督网络训练。多特征自适应损失函数从结构相似性和强度分布两个方面实现相似约束。结构相似性指数测度(SSIM)通过在亮度、对比度和结构3 个方面衡量两幅图像相似度,以该指标来测量融合结果与源图像之间的信息损失,如公式(5)所示:

由于结构相似性指数测度容易引起亮度变化和颜色偏差。因此,本文采用L1 损失函数以保留图像目标亮度信息,弥补SSIM 损失函数的不足,如公式(6)所示:

总损失函数如公式(7)所示,其中β为超参数,以均衡两类损失函数差异。

2 实验

2.1 实验参数设定

在训练阶段,选取TNO 数据集中的红外与可见光图像为训练集。为了扩大训练数据集,以滑动步长为12,将其裁剪为大小为256×256 的红外与可见光图像对,共10563 对,灰度值取值范围为[0,255]。此外,设置迭代数(epoch)为1,优化器为Adam,学习率(learning rate)为0.001,每批训练量(batch size)为8。超参数设置为α=1,c=2,β=0.87。测试及训练配置为Intel i9-9900、GeForce RTX 2080Ti和32 GB 内存。选定的编译环境为pytorch。

在测试阶段,选取 TNO[20]、Roadscene[21]与OTCBVS[22]为验证数据集,以验证方法的有效性。将本文方法与MDLatLRR(multi-level decomposition of LatLRR)[6]、DenseFuse[14]、IFCNN[15]、UNFusion[16]、GANMcC[18]、U2Fusion[23]、RFN-Nest[19]这7 种典型方法进行比较。在定性比较中,为了便于观察,将融合图像中的红外目标与可见光细节分别标注,并将局部细节放大。定量评价指标选择信息熵(entropy,EN)[24]、非线性相关信息熵(nonlinear correlation information entropy,NCIE)[25]、标准差(standard deviation,SD)[26]、相关差异和(the sum of the correlation differences,SCD)[27]、视觉信息融合保真度(the visual information fidelity for fusion,VIFF)[28]、多尺度结构相似性(multi-scale structural similarity index measure,MS_ SSIM)[29],可从图像特征信息、结构相似性、视觉感知等方面评估融合性能。

2.2 消融实验

2.2.1 密集连接有效性验证

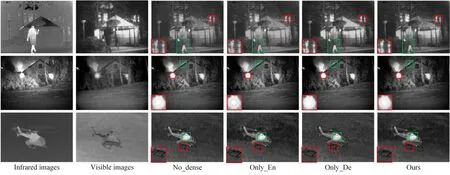

为验证密集连接的有效性,采用3 个对比验证模型,分别是编码器和解码器都无密集连接,记作No_Dense,仅编码器有密集连接,记作Only_En,仅解码器有密集连接,记作Only_De。实验选择TNO数据集中的Kaptein_1654、House、Helicopter 三组典型的红外与可见光图像进行定性比较,如图2所示。可以看出,No_Dense、Only_En 模型融合结果丢失了可见光图像的纹理细节,降低了目标与背景的对比度,且图像的背景出现噪点,部分边缘细节处产生伪光晕;Only_De 模型结果在一定程度上提高了图像对比度,但仍缺乏纹理结构信息。例如,在Helicopter 结果中,天空云彩的结构与灰度分布有所缺失。相比之下,本文方法在提高目标亮度的同时突出了图像细节与对比度,图像较为清晰,视觉效果优于对比模型。

图2 密集连接的定性比较结果Fig.2 Qualitative comparison results of dense skip connections

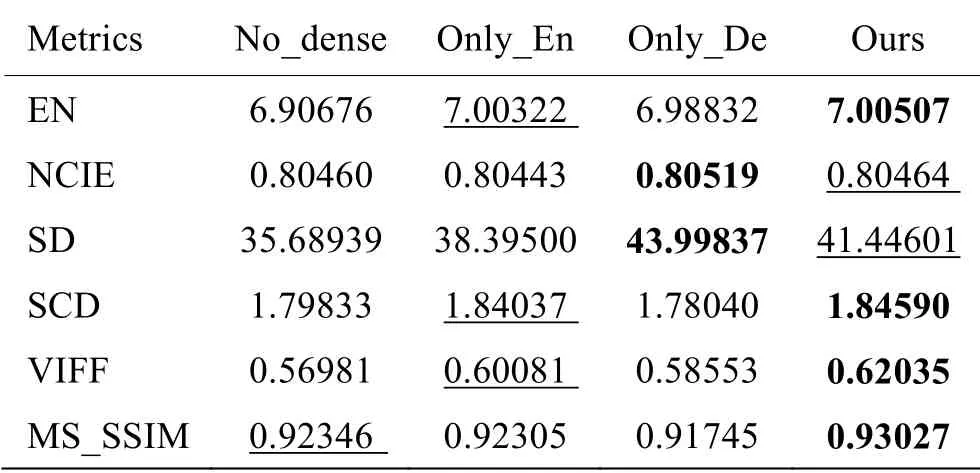

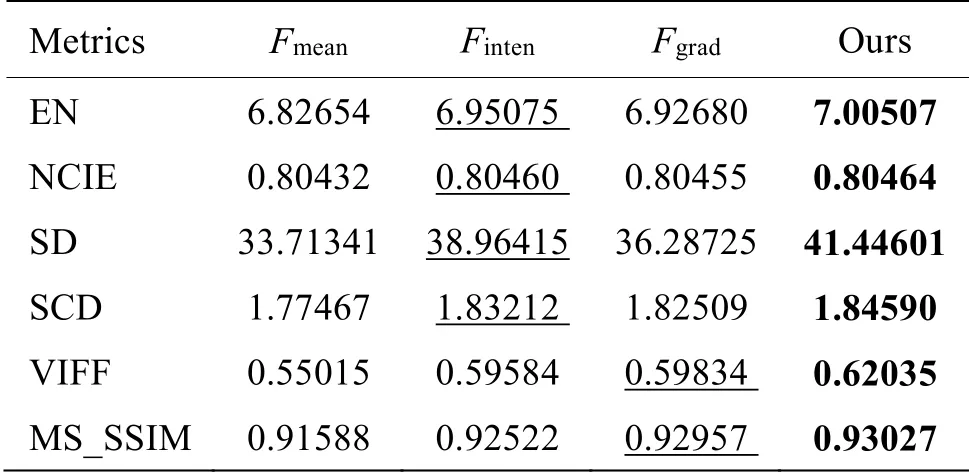

此外,为了避免视觉感知偏差,本文采用TNO数据集的25 组图像以及6 个指标,在客观方面量化比较模型有效性,表1 给出了密集连接的定量比较结果。观察表中数据,本文模型获得的融合结果在EN、SCD、VIFF 与MS_SSIM 指标上获得最优值,且NCIE,SD 指标仅次于Only_De。从结果可以看出,密集连接可以实现特征复用,有效增强图像特征表示能力。且在解码和编码器中建立密集连接在主客观评价上均优于其他模型,即 No_Dense、Only_En 以及Only_De,表明本文模型可以有效聚合所有不同尺度不同层的中间特征,提高网络模型的特征提取和重构能力。

表1 密集连接的定量比较结果Table 1 Quantitative comparison results of dense skip connection

2.2.2 多特征自适应损失函数有效性验证

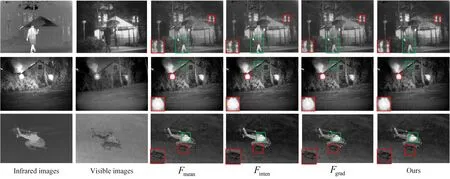

为验证多特征自适应损失函数的有效性,采用3个对比验证模型,分别是仅保留像素亮度测量准则的融合模型,记作Finten,仅保留梯度测量准则的融合模型,记作Fgrad,直接采用固定权重系数,即ωir、ωvis 取值为0.5,记作Fmean。图3 给出了多特征自适应损失函数的定性比较结果,由图观察得知,Finten融合结果边缘细节不清晰,出现伪光晕,且图像对比度不高。Fgrad、Fmean突出了可见光细节,但目标亮度与对比度依旧不高。相比于对比验证模型,本文设计的多特征自适应模块既保留了红外图像的目标亮度,又突出了可见光细节,取得更好的主观融合效果。通过定性比较,证明了多特征自适应损失函数的优越性。

图3 多特征自适应模块的定性比较结果Fig.3 Qualitative comparison results of multi-feature adaptive modules

此外,表2 给出了多特征自适应损失函数的定量比较结果,进一步验证本文模型设计的合理性与有效性。观察表中数据,本文方法在所有指标上均获得最大值,与主观评价结果一致,表明多特征自适应损失函数可以有效获取源图像纹理结构以及像素强度的信息保留度,实现源图像与融合图像的特征相似性约束,包括边缘细节、亮度变化以及灰度分布等,并平衡了两类图像的差异信息,获得良好的融合结果。

表2 多特征自适应损失函数的定量比较结果Table 2 Quantitative comparison results of multi-feature adaptive loss function

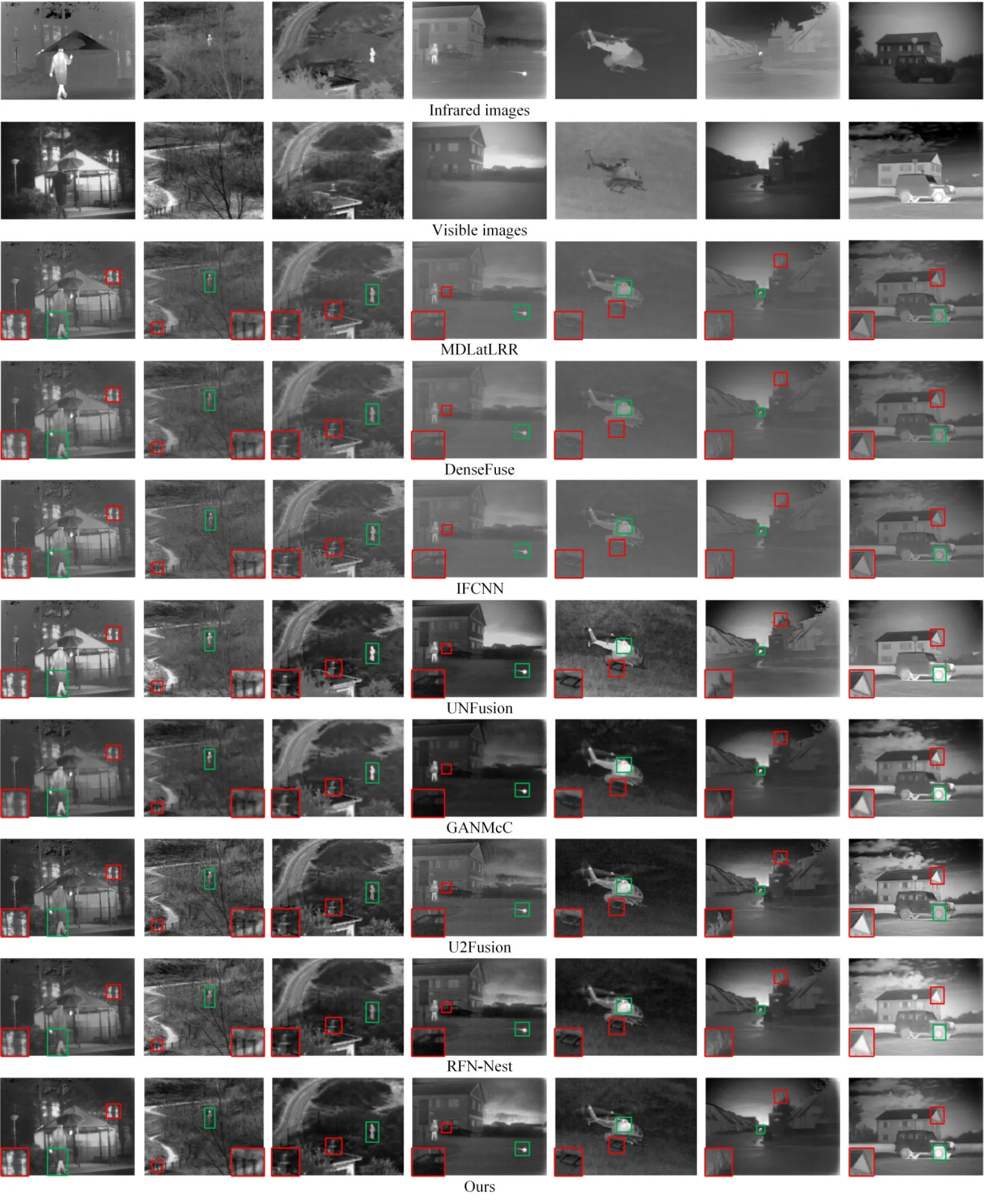

2.3 TNO 数据集

为了验证本文方法的优越性,从TNO 数据集中选取25 组图像进行实验验证,其中选取7 组典型的红外与可见光图像进行主观评价, 包括Kaptein_1654、Sandpath、Nato_camp、Movie_18、Helicopter、Movie_01 和Marne_04。TNO 数据集的定性比较结果如图 4所示。观察结果得知,MDLatLRR、DenseFuse 以及IFCNN 融合结果保留了可见光图像纹理细节,但是目标亮度严重缺乏,且图像背景较暗,导致其对比度偏低,部分细节不明显。GANMcC 获得的融合结果倾向于保留红外典型目标,而损失了大量的可见光结构信息,例如Sandpath 结果中,路边围栏模糊不清。U2Fusion 和RFN-Nest 获得较为良好的结果。图像清晰,同时保留了丰富的细节,提高了目标与背景的对比度,但是其结果中典型目标亮度依旧不高。相比之下,UNFusion 和本文方法可以同时具有两类图像的差异信息,在不损失目标亮度的同时,突出细节,保留丰富的场景信息。主观评价结果表明,本文方法能够获得较好的融合效果。

图4 TNO 数据集的定性比较结果Fig.4 Qualitative comparison results of TNO datasets

表3 给出了TNO 数据集的定量比较结果,从客观角度验证融合方法的有效性,由表可知,本文方法在指标EN、SD、SCD 以及MS_SSIM 上获得最优值,并在指标NCIE 和VIFF 上仅次于UNFusion 以及U2Fusion。表明本文方法融合结果良好,具有较高的对比度以及图像质量。

表3 TNO 数据集的定量比较结果Table 3 Quantitative comparison results of TNO datasets

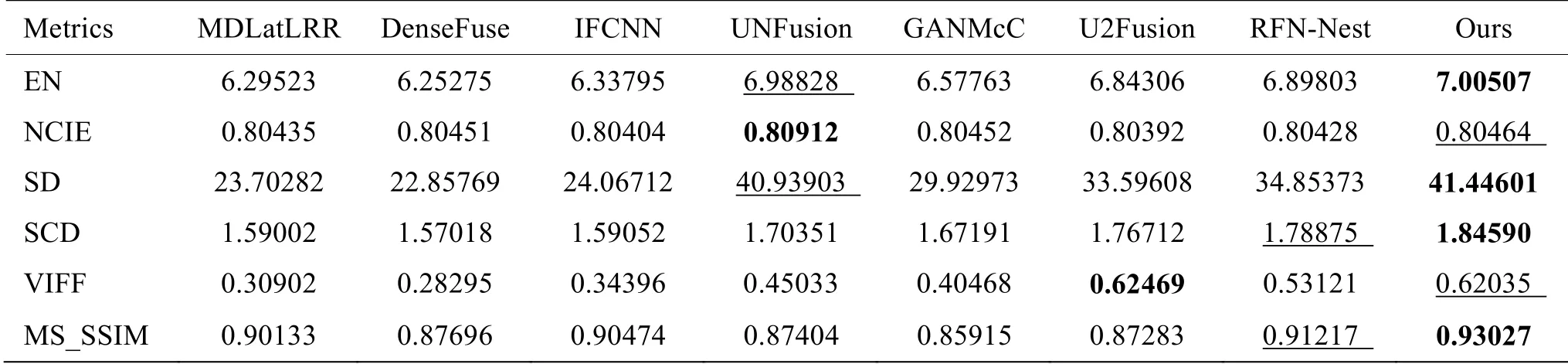

2.4 Roadscene 数据集

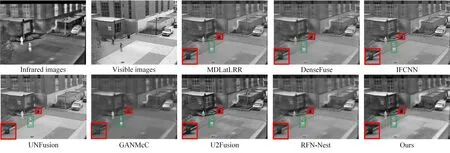

为进一步验证该融合方法的有效性,选取Roadscene 数据集中的221 组图像进行实验验证,图5 为Roadscene 数据集的定性比较结果,观察可知,MDLatLRR、DenseFuse、IFCNN 的融合图像倾向于可见光图像,提取红外图像的亮度信息不足,且图像对比度低。GANMcC、RFN-Nest 结果倾向于红外图像,保留了目标亮度,但损失大量纹理细节,且目标边缘模糊,RFN-Nest 存在较为严重的伪影。UNFusion 虽可均衡获得红外目标与可见光细节,但丢失了天空云彩的边缘纹理。U2Fusion 及本文方法获得优于其他方法的融合结果,根据定性分析,两者结果差异不明显,故从定量分析进一步比较融合性能。

图5 Roadscene 数据集的定性比较结果Fig.5 Qualitative comparison results of Roadscene datasets

Roadscene 数据集的定量比较如表4所示,本文方法取得了EN、SD、SCD 与VIFF 指标的最大值。EN、SD 值最高,证明多特征自适应融合方法整合不同尺度不同层级的中间层特征后,提取到更多的特征信息。SCD、VIFF 取得最优值,则说明在图像质量与视觉效果比较中,本文方法优于其他典型方法。虽然NCIE 指标略次于UNFusion 和U2Fusion,MS_SSIM 指标仅次于U2Fusion,但综合分析,多特征自适应融合方法的融合效果综合性能更优。

表4 Roadscene 数据集的定量比较结果Table 4 Quantitative comparison results of Roadscene datasets

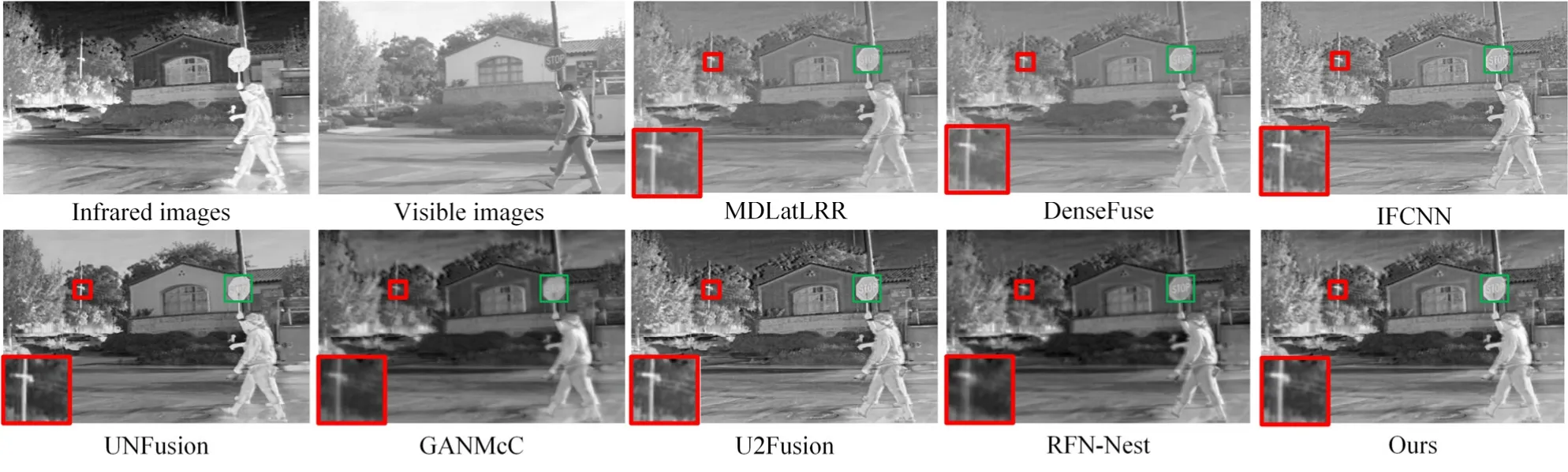

2.5 OTCBVS 数据集

为更进一步验证该融合方法的鲁棒性,选取了OTCBVS 基准数据集的40 组红外与可见光图像对进行实验。图6 给出了OTCBVS 数据集的定性比较结果,其中,MDLatLRR、DenseFuse、IFCNN 结果保留了可见光纹理信息,但对比度低,导致部分细节不清晰。GANMcC 目标亮度较高,但缺乏大量结构信息,例如,图像中几乎没有地缝,且目标边缘模糊。RFN-Nest 目标亮度不高,可见光边缘细节模糊,且存在伪影。在定性比较中,U2Fusion、UNFusion以及本文方法的融合结果优于其他方法。而从主观上来看,三者结果差异不明显,因此从客观上比较他们的融合性能。

图6 OTCBVS 数据集的定性比较结果Fig.6 Qualitative comparison results of OTCBVS datasets

表5 为OTCBVS 数据集的定量比较结果,对比可得,本文方法在EN、SD、MS_SSIM、VIFF、SCD指标均优于其他方法,仅 NCIE 指标略次于UNFusion。进一步验证了本文的融合性能。

表5 OTCBVS 数据集的定量比较结果Table 5 Quantitative comparison results of OTCBVS datasets

本文采用TNO、Roadscene 与OTCBVS 三个公开数据集进行实验验证,综合视觉感知以及多个指标进行评价。相比于其他典型方法,主观上更均衡地保留了两类图像的典型特征,包括红外图像目标特征以及可见光图像的纹理特征,客观上随着数据集的变化,评价指标趋势基本一致,表明本文方法具有较强的鲁棒性与优越性。

3 结论

本文提出了多特征自适应红外与可见光图像融合方法。首先,采用了多尺度密集连接的网络结构,充分利用不同尺度的浅层及深层特征;其次,设计多特征自适应损失函数,引入VGG-16 网络提取特征并用于计算特征的信息保留度,进而约束损失函数。特征自适应损失函数针对性地提取了红外图像的目标信息和可见光图像的纹理细节信息,监督网络模型获得更平衡的融合结果。消融实验验证了密集连接与多特征自适应损失函数的有效性。此外,在TNO、Roadscene 和OTCBVS 三种不同的数据集上,与7 种典型方法进行了主客观实验,结果表明本文方法的优越性和鲁棒性。