类人型机器人动作情感识别研究

2022-05-27李洁袁雪纯张千

李洁,袁雪纯,张千

类人型机器人动作情感识别研究

李洁,袁雪纯,张千

(河北工业大学,天津 300401)

为优化人与机器人动作情感交互方式,研究类人型机器人动作单模态情绪表达的可识别性,探究类人型机器人动作情绪识别的影响因素。以类人型机器人NAO为例,采用问卷调查的方式,基于离散情绪模型,获取机器人NAO动作表达情绪的识别性、效价和唤醒度,研究类人型机器人动作的情绪识别性、效价和唤醒度,基于认知匹配理论研究类人型机器人动作与真人模拟动作、真人自然动作情绪表达差异的影响因素。人类能够通过类人型机器人动作的单模态情绪表达,在不同情感语义上进行比较细腻的情绪识别,机器人形态及动作的幅度、速度、力量是情绪识别的影响因素。建立类人型机器人动作与情感语义、效价及唤醒度的关系模型,以及类人型机器人动作情绪能量图,为机器人情感表达和动作交互设计提供较为系统的参考模型。

类人型机器人;动作单模态;情绪识别;机器人形态

智能时代与体验经济的到来,使情感机器人成为服务机器人研究领域的热点。类人型机器人外形与人相似,被赋予丰富的情感功能,通过语言、屏幕、肢体动作、面部表情等多感觉模态与人类进行情感沟通。人类有38%的沟通信息通过身体动作进行传递[1],因此,研究机器人动作的情感识别性和影响因素十分有意义。

1 研究概述

近10年来,类人型机器人动作的情感研究逐渐受到学者的关注[2-7],相关研究主要集中在如何建立机器人动作模型来表达情感方面。如Nayak等[8]探索了通过肢体语言自动表达角色心理状态的可能性。Sial等[9]建立了机器人运动参数与情感变化之间的关系模型。王梅等[10]提出了人体动作姿势识别方法,建立了人体手臂与四自由度机械手臂的人–机动作映射规则。

在人与机器人交互过程中,对于用户情感的相关研究,学者多采用问卷调查的方式对其进行评价,如Bretan等[11]通过离散情感模型,得到了被试者对机器人情绪行为的分类结果。邢妍[12]通过用户体验数据,建立了用户情感曲线,最终构建了服务机器人交互过程模型。牛国臣等[13]提出了基于个性的机器人情感生成机制和情感决策模型,来建立从个性到情感空间、从情感空间到各种行为输出的映射。李抒桐[14]按照情感的类别和强弱,提出了情感改进模型,并将模型中的情感量化并代入了情感特征值公式,实现了对各种情感状态的评估。吴伟国等[15]针对类人型机器人,在PAD三维情感空间内,建立了更具普遍性的人工情感计算模型,可针对外界刺激自主地产生个性化的情绪响应,有效模拟了人类情绪的变化过程。徐桂芝等[16]通过引入深度分离卷积算法,对人脸表情进行了特征提取和分类,设计了机器人面部情绪识别和肢体情感表达的人机交互系统。钟翔伟等[17]制作了真人动作数据与机器人动作数据的动画视频,根据实验得到了交互动作的感性量评价分值,为类人型机器人的交互行为设计提供了定量评估方法。江浩等[18]提出了智能终端产品的最简情感表达方法,设计开发了一款最简情感表达设计的辅助工具。目前,对于类人型机器人情绪动作情感体验的相关研究较少,且尚未有研究探索类人型机器人动作与真人动作之间情绪表达的差异,以及情绪动作表达的影响因素。文章旨在研究机器人动作单模态情绪表达的可识别性,探究机器人动作情绪识别的影响因素,为类人型机器人动作设计提供参考。

2 机器人动作的情感识别

2.1 实验一:设计

实验目的:验证人类能否通过机器人动作单模态进行情感识别;研究机器人动作单模态情感识别的心理范式。

实验对象:选取NAO机器人作为实验对象,NAO机器人由法国阿尔德巴兰(Aldebaran Robotics)公司研发,身高58 cm,全身拥有25个自由度,机器人的眼睛、耳朵、躯干、脚等部位都装有LED灯,可通过动作、语音、眼灯与人进行交互。

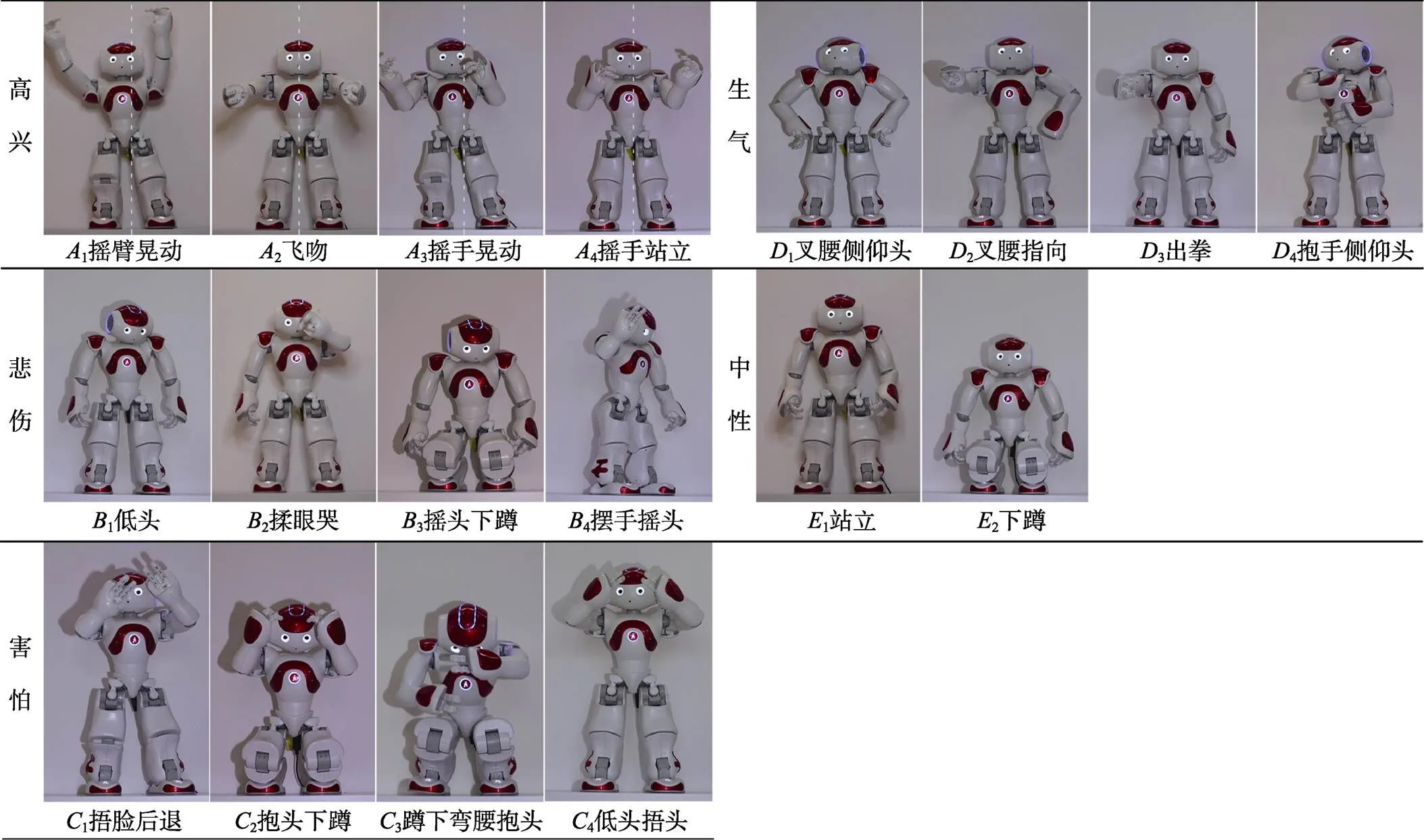

实验设计:控制机器人其他交互变量,基于动作单模态进行情感识别研究。通过文献梳理及焦点小组讨论,收集到高兴、生气、悲伤、害怕4种情绪的人类动作,每种情绪筛选4个动作,另选取2个中性动作,通过编程软件Choregraphe为机器人NAO进行动作编程。将机器人NAO的18个动作拍成视频并制成问卷,见图1。

图1 机器人动作样本

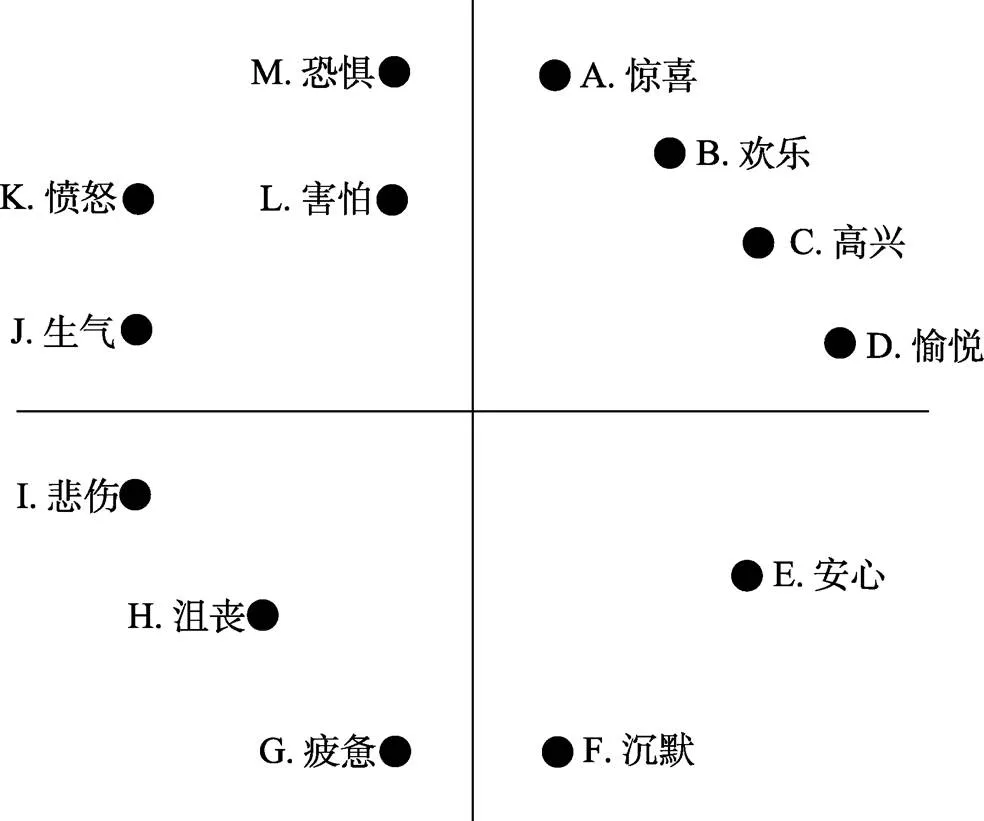

问卷设计:Q1—Q3分别测量机器人动作情绪识别、效价和唤醒度。情绪识别:将高兴、生气、悲伤、害怕,以及中性的情绪词汇,依据情绪效价和唤醒度扩充至13个,结合Russel[19]提出的离散情绪模型来设计成本实验情绪模型,见图2。被试者通过观看机器人动作视频,从Q1情绪模型中选取1~2个情绪词汇,Q2效价(0消极—7积极)、Q3唤醒度(0平静—7强烈)通过李克特量表测量。定向发放网络问卷,共收回问卷50份、有效问卷45份,被试者年龄为19~22岁(=19.96,=0.85),其中男性15人、女性30人。

图2 情绪模型

2.2 试验数据分析

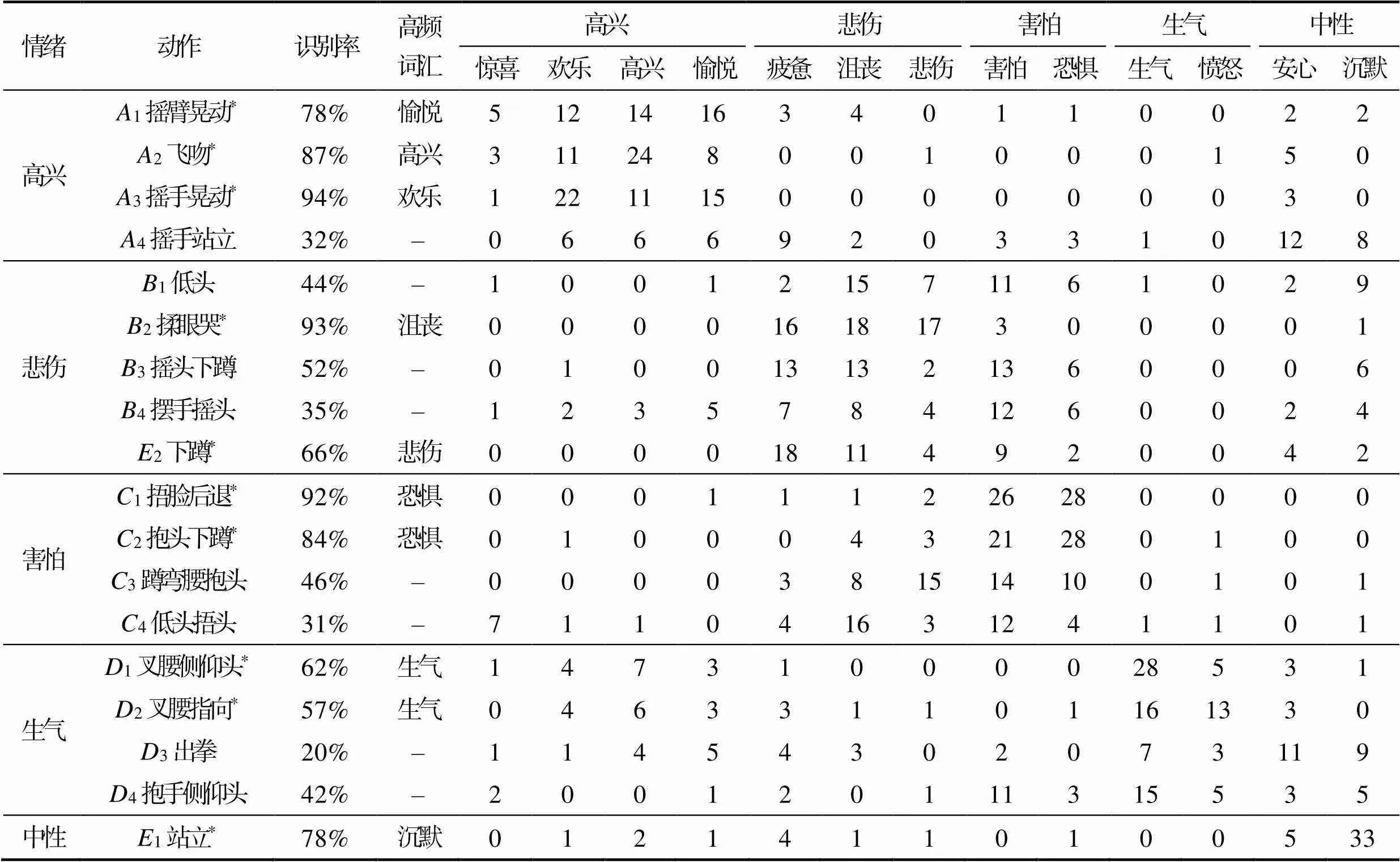

2.1.1 情绪识别

动作情绪识别结果见表1。通过SPSS方差分析得出具有情绪识别显著性的动作:高兴(1摇臂晃动78%、3飞吻87%、4摇手晃动94.2%)、悲伤(2揉眼哭93%、2蹲66%)、害怕(1捂脸后退92%、2抱头下蹲84%)、生气(1叉腰侧仰头62%、2叉腰指向57%)、中性(1站立78%)。18个样本动作中有10个动作具有显著性,证明机器人动作单模态表达的情绪可以被识别。根据每个动作情绪识别的高频词汇来统计动作表达情绪的细腻性,例如通过动作可以区分高兴、愉悦和欢乐等情绪。情绪识别率显示:高兴情绪最容易被识别;悲伤和害怕情绪容易混淆,3、4、3、4等4个动作均表现出悲伤和害怕,且差异性不显著;生气情绪表现出识别率低的特点;站立动作被识别为中性情绪,下蹲动作被识别为悲伤情绪,且具有显著性。

表1 动作情绪识别结果

Tab.1 Result of action emotion recognition

注:*表示<0.05。

2.1.2 效价和唤醒度

1)效价表达情绪的积极性。对Q2数据进行统计分析(见表2):高兴动作表达出最强烈的积极性;生气动作也表达出积极情绪;中性动作的效价平均值为3.51处于消极和积极的中值;悲伤动作表达出消极情绪;害怕动作表现出的情绪消极性最高。同类情绪中不同动作的效价具有差异性,且Q2的效价结果与Q1的高频词汇语义结果相对应,证明了机器人可以通过动作单模态传达十分细腻的情感。

表2 动作效价排序

Tab.2 Ranking of action potency

2)唤醒度表达情绪的强烈程度。对Q3数据进行统计分析(见表3):害怕动作表现出最强烈的情绪效应,唤醒度最高,其次是高兴和生气动作,两者强烈程度相似,再次是悲伤动作,最后中性动作表现出的情绪唤醒度最低。同类情绪中不同动作的唤醒度具有差异性,并且Q3的唤醒度结果与Q1的高频词汇语义结果相对应,证明了机器人可以通过动作单模态传达十分细腻的情感。

表3 动作唤醒度排序

Tab.3 Sequence of action arousal

2.3 实验一:结论

人类能够通过机器人动作单模态进行有效的情感识别,并且是比较细腻的情感识别,具体表现在机器人动作与情感语义、效价及唤醒度的模型关系,见图3。

图3 动作–语义–效价–唤醒度模型

人类身体形态常作为隐喻形式用于人工产品形态,人类动作也常作为理解产品功能和交互方式的范式。千百万年来,通过劳动、社交、艺术活动等形式,形成了以人的身体美学为范式的认知及交互准则,因此机器人动作的情感识别也是建立在人类动作交互范式基础之上的。实验中10个具有情绪识别显著性的动作可以分为2类范式:一是人类自然动作,即人在相应情绪中自然表现出来的动作,可以被人类共同理解。自然动作有1摇臂晃动、4摇手晃动、2下蹲、1捂脸后退、2抱头下蹲,动作情绪表现为高兴会自然地手臂上扬、身体有节奏的晃动,悲伤会不自觉地表现出向下的趋势(如下蹲或低头),害怕会本能地后退蜷缩并且用手形成遮挡,生气动作中肢体会下意识地产生向外的速度和力量,这是人类的本能反应。二是人类语义动作,即在特定社会环境中形成的特定人群共同理解的动作含义,此类动作含义受人群、地域、时间等因素的影响。语义动作有3飞吻、2揉眼哭、1叉腰侧仰头、2叉腰指向,这些动作形成了特定的社会语义,能够准确地表达动作情感,但人类也会因社会文化差异而产生对动作不同的理解。

3 机器人动作情感识别的影响因素研究

人类以自身身体形态和动作语义为基础来理解机器人,形成了机器人动作情感识别的心理范式。然而,机器人形态千差万别,即使是类人型机器人也与人类形态有差别,在交互过程中人类的认知系统会根据机器人形态自动调节,形成与机器人形态相匹配的动作情感认知模型。实验二在机器人动作单模态情感识别心理范式基础之上,基于机器人形态来研究机器人动作情感识别的影响因素。

3.1 实验二:设计

为探究动作的形态载体,即人和机器人形态差异能否影响动作的情感识别,并进一步探寻影响动作情感识别的特征因素,实验二进行了机器人与真人动作的对比实验。

实验设计:通过实验一识别结果,选取最具代表性的3个机器人动作与真人动作进行对比研究,选取的动作有1摇臂晃动(高兴)、2抱头下蹲(害怕)、3出拳(生气)。

实验方法:为机器人NAO的3个动作拍摄真人比对视频,分别由真人录制2组动作,一组为真人完全模拟机器人动作,另一组为保留动作类型的真人自然动作。控制真人视频样本的面部表情,被试者需全程佩戴口罩,服装低调朴素,并严格控制除动作之外影响情感识别的其他变量。

问卷设计:将每个动作的机器人视频、真人模拟视频和真人自然视频设为一组,每个视频设有情绪识别度、效价和唤醒度3个问题,问题(Q1:你同意视频中动作表达的情绪是xx吗?Q2:你认为视频中情绪表达的消极/积极程度是?Q3:你认为视频中情绪表达的强烈程度是?)均采用7级李克特量表形式。定向发放网络问卷,共收回问卷50份,有效问卷43份,被试者年龄为18~22岁(=19.93,=0.83),其中男14人、女29人。

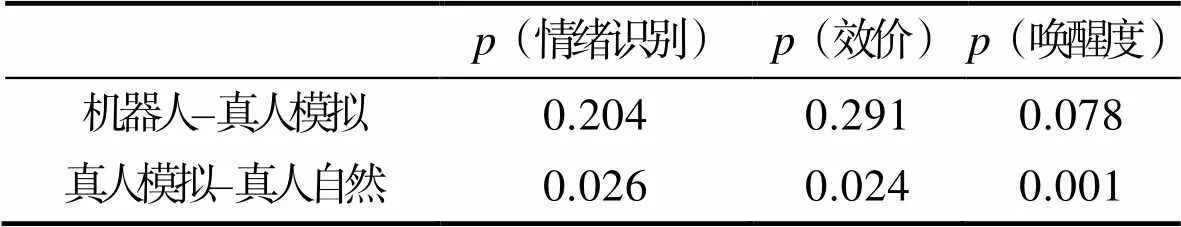

3.2 实验二:数据

采用网格坐标法对数据进行定位,选取动作主要关节部位(头部、颈部、腕部和膝部),并通过关节坐标点的变化来计算动作幅度和速度,见表4。

表4 实验二样本数据

Tab.4 Sample data of Experiment 2

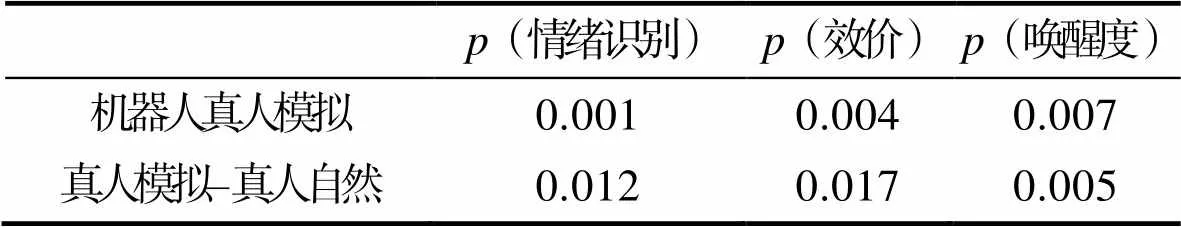

3.2.1 高兴–摇臂晃动

摇臂晃动动作考察高兴情绪识别。SPSS方差分析结果见表5,机器人动作和真人自然动作在情绪识别、效价及唤醒度上没有显著性差异,均高于真人模拟动作且具有显著性差异。实验中机器人和真人模拟动作幅度趋于一致,但真人模拟动作的情绪识别性显著低于机器人动作,证明动作载体的形态会影响动作的情绪识别。机器人动作与真人自然动作相比,真人自然动作幅度大于机器人动作幅度,说明人可以根据动作载体形态自动匹配与之相对应的动作幅度,因此幅度是机器人动作情绪识别的影响因素。

表5 高兴-摇臂晃动显著性结果

Tab.5 Significant results of happy-rocker rocking

3.2.2 害怕–抱头下蹲

抱头下蹲考察害怕情绪识别。实验中机器人和真人的身体结构比例不一致,机器人腿部占比小且下蹲幅度小,视频样本中通过控制速度,来保持真人模拟动作与机器人动作下蹲速度的视觉感受一致。SPSS方差分析结果见表6,真人自然动作情绪识别高于机器人动作,也高于真人模拟动作,其中真人自然动作与真人模拟动作有显著性差异=0.042;真人自然动作的唤醒度高于机器人动作和真人模拟动作,有显著性差异。真人自然动作的下蹲速度高于真人模拟动作和机器人动作,且情绪识别及唤醒度与二者具有显著性差异。结果说明,人可以根据动作载体形态自动匹配与之相对应的动作速度,因此速度是机器人动作情绪识别的影响因素。

表6 害怕-抱头下蹲显著性结果

Tab.6 Significant results of fear-head holding squat

3.2.3 生气–出拳

出拳动作考察生气情绪识别。SPSS方差分析结果见表7,真人自然动作识别高于真人模拟动作,高于机器人动作,且三者间具有显著性差异=0.001。真人自然动作的唤醒度高于真人模拟动作和机器人动作,且有显著性差异=0.001。机器人动作和真人模拟动作有情绪识别的显著性差异,说明动作形态载体影响动作情绪识别。由于机器人结构和技术限制无法完成动作的力量性,所以机器人生气情绪识别率较低。真人自然动作力量感明显高于模拟动作和机器人动作,且在情绪识别性和唤醒度上与两者具有显著性差异。实验结果表明力量感是动作情绪识别的影响因素。

表7 生气-出拳显著性结果

Tab.7 Significant results of anger and punch

3.3 实验二:结论

实验证明动作载体的形态影响动作的情绪识别,机器人动作在幅度、速度及力量感上均弱于真人自然动作,但人可以根据动作载体形态自动匹配与之相对应的动作认知模型。机器人动作的幅度、速度和力量是动作情绪识别的影响因素。

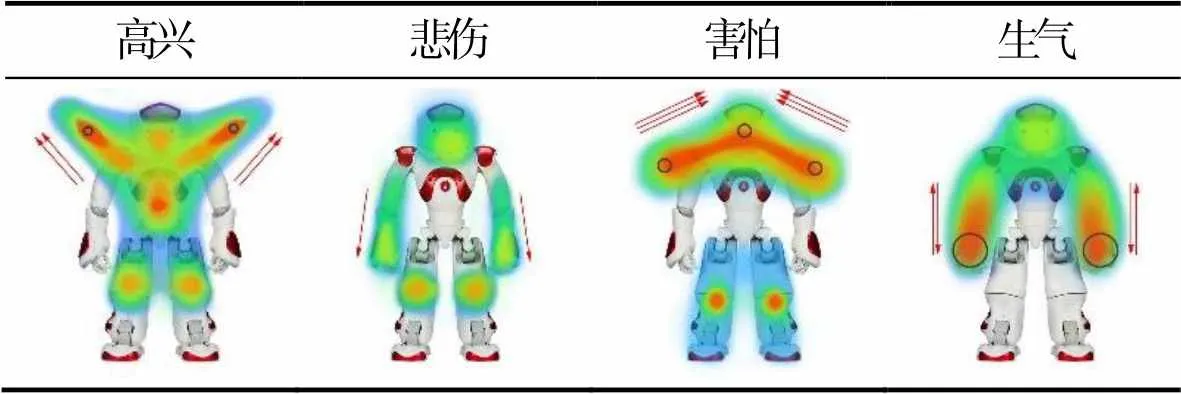

基于实验一的结论,并结合实验二的动作情绪识别影响因素来绘制动作情绪能量表,见表5。分别用范围、箭头、圆圈代表动作的幅度、速度、力量,面积越大代表动作幅度越大,箭头数量越多代表运动速度越快,箭头方向代表运动方向,圆圈越大代表运动力量越强。

表8 机器人动作情绪能量表

Tab.8 Emotional energy diagram of robot action

由表8可知,高兴动作能量图范围大、颜色较深、2个向上箭头、手部有力量点,代表动作幅度大、速度较快、手部力量较弱、动作呈向上趋势;悲伤动作能量图范围较小、颜色浅、1个向下箭头、无力量点,代表动作幅度较小、速度慢、无力量、动作呈向下趋势;害怕动作能量图范围较大、颜色深、3个箭头由外指向内、手腕和手肘没有力量点,代表动作幅度较大、速度快、手臂力量较弱、动作趋势呈收缩和远离趋势;生气动作能量图范围较大、颜色深、2个方向相反的箭头、手部有力量点,代表动作幅度较大、速度快、没有固定运动方向、手部力量强。

4 总结

基于实验一和实验二的结论,综合归纳类人型机器人的情感动作交互设计参考模型,见图4。模型包括机器人情感动作交互范式及动作设计要素,动作设计要素依据4种基本情绪进行拆分,由动作方向、幅度、速度、力量感4个维度构成,为机器人情感表达和动作交互设计提供了一套较为系统的参考。

图4 类人型机器人情感动作交互设计参考模型

5 结语

通过实验验证了:人类能够通过机器人动作单模态进行比较细腻的情绪识别,机器人动作表达的高兴情绪是最容易被识别的,悲伤和害怕情绪容易混淆,生气情绪识别率低,机器人动作单模态的情绪识别有2种心理范式,一是人类自然动作、二是人类语义动作;机器人形态影响动作的情绪识别,人可以根据机器人形态自动匹配与之相对应的动作认知模型,机器人动作幅度、速度和力量是动作情绪识别的影响因素。

通过实验分析总结了:机器人动作与情感语义、效价及唤醒度的模型关系;机器人动作情绪能量图;类人型机器人情感动作交互设计参考模型。文中关于机器人动作情绪感知的研究结果,可以为服务机器人动作交互设计提供参考。

[1] MEHRABIAN A. Communication without Words[J]. Psychology Today, 1968, 2: 53-55.

[2] 王志良, 王巍, 谷学静, 等. 具有情感的类人表情机器人研究综述[J]. 计算机科学, 2011, 38(1): 34-39.

WANG Zhi-liang, WANG Wei, GU Xue-jing, et al. Research Summarization of Humanoid Expression Robot with Emotion[J]. Computer Science, 2011, 38(1): 34-39.

[3] 王巍, 王志良, 郑思仪, 等. 一类具有相同结构的表情机器人共同注意方法[J]. 机器人, 2012, 34(3): 265-274.

WANG Wei, WANG Zhi-liang, ZHENG Si-yi, et al. Joint Attention for a Kind of Facial Expression Robots with the Same Structure[J]. Robot, 2012, 34(3): 265-274.

[4] 柯显信, 尚宇峰, 卢孔笔. 仿人情感交互表情机器人研究现状及关键技术[J]. 智能系统学报, 2013, 8(6): 482-488.

KE Xian-xin, SHANG Yu-feng, LU Kong-bi, et al. Joint Analysis of the Present Research Status and Key Technology of the Humanoid Emotion-interactive Countenance Robot[J]. CAAI Transactions on Intelligent Systems, 2013, 8(6): 482-488.

[5] 柯显信, 陈玉亮, 唐文彬, 等. 仿人面部表情机器人连续表情运动控制系统设计[J]. 微电机, 2011, 44(6): 35-39.

KE Xian-xin, CHEN Yu-liang, TANG Wen-bin, et al. A continuous facial motion control system of facial expression robot[J]. Micromotors, 2013, 8(6): 482-488.

[6] 吴伟国, 宋策, 孟庆梅. 仿人头像机器人"H&Frobot- Ⅲ"语音及口形系统研制与实验[J]. 机械设计, 2008, 25(1): 15-19.

WU Wei-guo, SONG Ce, MENG Qing-mei. Development and Experiment of Speech and Mouth Shape System of Humanoid Robot "H & frobot -Ⅲ"[J]. Journal of Machine Design, 2008, 25(1): 15-19.

[7] 唐文彬. 仿人面部表情机器人及表情实现方法的研究[D]. 上海: 上海大学, 2010.

TANG Wen-bin. Research on Humanoid Facial Expression Robot and Expression Realization Method[D]. Shanghai: Shanghai University, 2010.

[8] NAYAK V, TURK M. Emotional Expression in Virtual Agents through Body Language[M]. Springer Berlin Heidelberg, 2005.

[9] SIAL S B, SIAL M B, AYAZ Y, et al. Interaction of Robot with Humans by Communicating Simulated Emotional States through Expressive Movements[J]. Intelligent Service Robotics, 2016, 9(3): 231-255.

[10] 王梅, 卢熙昌, 屠大维, 等. 基于人体动作姿态识别的机器人仿人运动[J]. 机械工程学报, 2016, 52(21): 26-34.

WANG Mei, LU Xi-chang, TU Da-wei, et al. Humanoid Motion of Manipulator that Based on Human-posture Recognition[J]. Journal of Mechanical Engineering, 2016, 52(21): 26-34.

[11] BRETAN M, HOFFMAN G, WEINBERG G. Emotionally Expressive Dynamic Physical Behaviors in Robots[J]. International Journal of Human-Computer Studies, 2015, 78: 1-16.

[12] 邢妍. 服务机器人交互设计研究与应用[D]. 沈阳: 沈阳工业大学, 2017.

XING Yan. Research and Application of Service Robot Interaction Design[D]. Shenyang: Shenyang University of Technology, 2017.

[13] 牛国臣, 胡丹丹, 高庆吉. 基于个性的机器人情感生成和决策模型构建[J]. 机器人, 2011, 33(6) : 706-711.

NIU Guo-chen, HU Dan-dan, GAO Qing-ji. Robot Emotion Generation and Decision-making Model Construction Based on Personality[J]. Robot, 2011, 33(6): 706-711.

[14] 李抒桐. 类人型机器人的情感化肢体语言模型研究[D]. 哈尔滨: 哈尔滨理工大学, 2014.

LI Shu-tong. Research on Emotional Body Language Model of Humanoid Robot[D]. Harbin: Harbin University of Science and Technology, 2014.

[15] 吴伟国, 李虹漫. PAD情感空间内人工情感建模及人机交互实验[J]. 哈尔滨工业大学学报, 2019, 51(1): 29-37.

WU Wei-guo, LI Hong-man. Artificial Emotion Modeling in PAD Emotional Space and Human-robot Interactive Experiment[J]. Journal of Harbin Institute of Technology, 2019, 51(1): 29-37.

[16] 徐桂芝, 赵阳, 郭苗苗, 等. 基于深度分离卷积的情绪识别机器人即时交互研究[J]. 仪器仪表学报, 2019, 40(10): 161-168.

XU Gui-zhi, ZHAO Yang, GUO Miao-miao, et al. Research on Real-time Interaction for the Emotion Recognition Robot Based on Depthwise Separable Convolution[J]. Chinese Journal of Scientific Instrument, 2019, 40(10): 161-168.

[17] 钟翔伟, 留沧海, 蒋刚. 仿人机器人交互行为设计评估方法[J]. 西南科技大学学报, 2017, 32(1) : 78-84.

ZHONG Xiang-wei, LIU Cang-hai, JIANG Gang. A Study on the Evaluation Method of the Humanoid Robot Interaction Design[J]. Journal of Southwest University of Science and Technology, 2017, 32(1): 78-84.

[18] 江浩, 徐婧珏, 林思远, 等. 智能终端的最简情感表达[J]. 计算机辅助设计与图形学学报, 2020, 32(7): 1042-1051.

JIANG Hao, XU Jing-yu, LIN Si-yuan, et al. Minimal Emotional Expressivity in Intelligent Terminals[J]. Journal of Computer-Aided Design & Computer Graphics, 2020, 32(7): 1042-1051.

[19] RUSSELL J A. A Circumplex Model of Affect[J]. Journal of Personality & Social Psychology, 1980, 39(6): 1161-1178.

Emotion Recognition of Humanoid Robot Action

LI Jie, YUAN Xue-chun, ZHANG Qian

(Hebei University of Technology, Tianjin 300401, China)

In order to optimize the emotional interaction between human and robot, the identifiability of single-mode emotion expression of humanoid robot action was studied, and the influencing factors of humanoid robot action emotion recognition were explored. Taking the humanoid robot NAO as an example, the recognition, potency and arousal degree of the emotion expressed by the NAO action of the robot are obtained by questionnaire survey based on the discrete emotion model. The emotion recognition, potency and arousal degree of the humanoid robot action are studied. Based on the cognitive matching theory, the emotional expression differences between humanoid robot action and human simulated action and human natural action are studied The influencing factors. It is found that human beings can recognize emotions in different emotional semantics through the single-mode emotion expression of humanoid robot action. The robot shape, the amplitude, speed and strength of action are the influencing factors of emotion recognition. The relationship model between humanoid robot action and emotion semantics, valence and arousal degree is established, and the emotion energy diagram of humanoid robot action is also established, which provides a more systematic reference model for robot emotion expression and action interaction design.

humanoid robot; singl- mode emotion expression; emotion recognition; robot shape

TB472

A

1001-3563(2022)10-0066-07

10.19554/j.cnki.1001-3563.2022.10.007

2021-12-15

李洁(1981—),女,硕士,副教授,主要研究方向为工业设计。

责任编辑:马梦遥