实景三维与视频融合技术在核电智慧工地中的研究应用

2022-05-19伦更永

伦更永

1.核工业航测遥感中心,河北 石家庄 050000;

2.中核三维地理信息工程技术研究中心,河北 石家庄 050000

0 引 言

近年来,国内基础建设发展迅速,城市空间规划由数字化走向智慧化,重大工程建设项目管理也正在由数字化向智慧化发展,智慧工地是互联网+技术、物联网技术、感知技术、云计算技术、虚拟现实与实景三维技术应用的高级表现形式。目前,包括城市基础建设工程、矿山开采工程、重大项目建设工地等对现场的监管方法,通常采用常规的视频监控模式,常规的视频监控技术为城市发展、工地建设等的安全生产[1]提供了可靠的技术支持,但传统监控视频面临着视频庞杂、离散、局限、关联性差等诸多问题,无法有效、直观、准确的掌控现场的实时动态,视频资源数据利用率低[2]。

随着三维GIS、实景三维建模技术的兴起,越来越多的建设项目工地采用了更先进的监管手段,融合了三维GIS、三维模型和视频监控技术,但在三维GIS平台中缺少视频监控的整体空间位置场景信息,很难将二维的视频监控数据同实景三维场景进行有效关联[3]。针对上述问题,2007年南加州大学计算机图形学与沉浸技术实验室的WANG Lu等[4]提出了利用单目摄像机的标定算法实现视频图像的投影与三维模型的融合。2013年中科院深圳先进技术研究院陈宝权论述了基于三维视频融合的监控分析系统的深度应用[5]。2019年张维和徐华龙研究了全矿井视频和三维模型一张图融合技术,使碎片化视频在三维矿山中实现360°立体全景监控[6]。本文提出了一种在三维GIS框架下,采用视频监控摄像机投影纹理映射和OpenGL技术将实景三维与视频图像进行融合显示,并将融合结果投影显示在模型所对应的真实空间位置,在核电建设项目实景三维场景下实现立体、可视化监控现场的实时动态,有效对数据进行挖掘、分析,服务工程项目管理。

1 实景三维与视频融合技术方法研究及实现

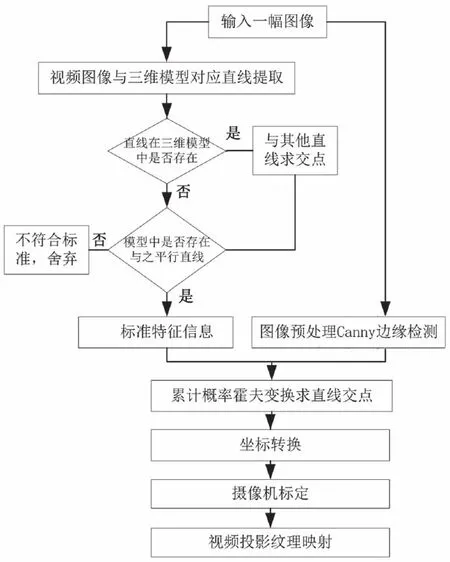

本文以某核电工程工地管理系统建设项目为例,采用无人机倾斜摄影获取高分辨率影像数据,通过Context Capture软件制作分辨率为0.05 m的高精度实景三维模型[7-8],建立基于三维GIS平台的某核电智慧工地管理系统。重点阐述基于三维GIS平台的实景三维模型与视频融合技术方法,提出融合策略(图1),内容主要包括以下3方面。

图1 三维模型与视频融合策略图Fig.1 Strategy diagram of 3D model and video fusion

视频图像与实景三维模型对应直线的提取。采用累计概率霍夫变换算法从视频图像和实景三维模型中提取对应直线点坐标,这样,视频图像具备了与实景三维模型坐标段的对应关系。

摄像机关联参数计算。对视频监控摄像机进行标定,计算出视频监控摄像机内外参数,并推导出与真实视频监控摄像机对应的三维GIS场景中虚拟相机的视点矩阵和透视投影矩阵。

三维场景视频投影纹理映射。利用以上两种矩阵算法,采用OpenGL技术将视频投射到实景三维模型,实现实景三维模型与视频图像的融合。

1.1 视频图像的直线提取

首先基于视频图像进行直线提取。由于提取出的直线数量较多,需对提取出的直线结合实景三维和直线特征进行筛选,筛选出与实景三维模型中有对应关系的直线段。最后根据累计概率霍夫变换算法[9]求解视频图像和实景三维模型,提取对应直线的点坐标。

1)直线特征分类。针对每一帧视频图像建立二维的平面坐标系,其中左上角点作为像素坐标系的原点,向右为x轴的正方向,向下为y轴的正方向。

通过视频图像上直线斜率的绝对值进行直线特征分类,k为图像上直线在坐标系中的斜率,即:水平特征;竖直特征;图像中提取的直线以上两种情况均出现,为水平竖直混合型。

2)直线特征筛选。经过提取算法检测出来的直线,数量较多,要按照特征筛选标准选出所需直线(图2)。

图2 直线特征筛选流程图Fig.2 Flow chart of line feature screening

遍历所有直线,根据直线特征判断实景三维模型中是否存在直线,若存在,则保留,并根据视频图像范围,确定每两条直线交点坐标在图像区域内部,假定交点是(x,y),则xmin<x<xmax,ymin<y<ymax,xmin、xmax、ymin、ymax分别为图像宽度和高度的最小值和最大值。直线若在视频图像范围内,则保留,否则舍弃;直线若不在视频图像范围内,需要判定三维模型中是否有与其相互平行的直线,若存在,则保留,否则舍弃。

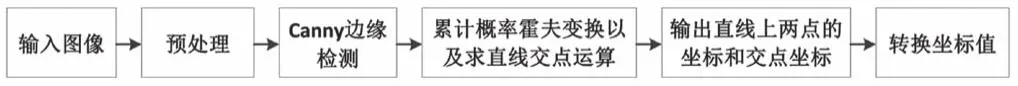

3)直线特征信息计算。经直线特征筛选标准选出直线段,要计算直线端点与其他直线交点坐标。首先输入一组监控视频图像进行预处理,通过Canny算子进行边缘检测[10-11],然后采用累计概率霍夫变换算法检测,并计算视频图像中的直线段和直线段的交点(图3)。

图3 特征信息计算Fig.3 Feature information calculation

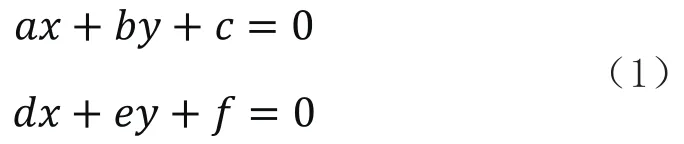

转换坐标值步骤。数据图像默认左上角为坐标原点(0,0),设图像中某点坐标为(x0,y0),坐标应转换为(x0,height-y0),height为图像的高(以像素为单位)。关于求直线交点的问题,引入齐次坐标,设直线的方程为:

在图像中找到直线和特征点后,从实景三维模型中找到和这些特征对应的三维特征直线和特征点,并将三维特征的矢量信息导出。模型得出的矢量信息,需要通过比例尺转换为现实世界的单位米。

1.2 摄像机关联参数计算

通过图像特征提取,至少可以得到两组直线特征对或者一组直线特征对和一组点特征对。根据特征信息,计算摄像机的内外参数。假设摄像机的扭曲参数为零,则内参数矩阵K只有4个自由度。设外参数为R和C~,R和C~有3个自由度,则有摄像机矩阵P=KR[I|-C~|]。用奇异值分解和RQ分解等数学知识可以从P中得到摄像机的中心、方位和内部参数[12]。摄像机位姿的标定算法流程如下。

1)划定摄像机位置搜索的水平范围。在实景三维模型地表划出一个水平的正方形范围,设为摄像机进行定位搜寻的范围,确定摄像机相对于模型的地表高度区间数值。

2)抽出二维图像平面和实景三维模型相对应的特征点对、特征线对,把二维图像平面中相距最远的两对对应点,设定为摄像机姿态预估数值。

3)搜索摄像机点位与焦距之间形成的四维空间,采集样本像点搜索与搜寻范围中心位置距离不断增加的方向保持相同,设定初始值无限大,进入搜索阶段。

4)假如已经搜索了范围内的全部采集样本像点,就需要终止搜索,得到摄像机的内外参数数值。否则,需要进行新的采集样本像点搜索,如果采集样本像点运算后,得到的像机参数为Γ^,平均几何误差为E。如果E<min(E),则令min(E)=E,Γ=Γ^。

5)假如E<3,则以Γ^为初始值,采用Levenberg-Marquardt算法进行优化(最大迭代次数设为10次)。通过优化,如果E<0.3,就需要终止搜索,得到像机的内外参数数值。否则,进入流程4)。

1.3 三维场景视频投影纹理映射

投影纹理映射算法描述了为所有的顶点提供纹理坐标的流程,也描述了在对图元光栅化时纹理坐标的解算流程。这能用来把现实空间物体的视频图像再次投射到物体的三维模型空间。本文主要是用OpenGL将二维纹理坐标(s,t)进行一系列的变换,成为具有多个分量的齐次纹理坐标(s,t,q,r)。首先是整个模型视点向着投影的方向进行变换,其次是透视变换、正交变换,然后进行比例缩放、偏转、平移,把最近的裁剪面映射到与其相符的纹理坐标上。

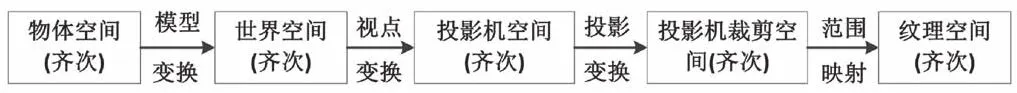

1)不同坐标系的转换。主要是投影纹理映射的流程(图4)。第一,摄像机模型转换,这是来确定三维物体在世界坐标系中的定位点、朝向,该转换的目的是把齐次物体空间转成齐次世界空间;第二,视点转换,这是来确定摄像机在世界坐标系中的定位点、朝向,该转换的目的是把齐次世界空间转成齐次摄像机空间,至此,把世界空间转成眼空间;第三,投影变换,这一步是要明确摄像机的视景体,它的作用是规定某一物体在视野范围的相对体积比例,该转换的目的是把齐次摄像机空间转成齐次摄像机裁剪空间;第四,经过比例缩放、偏转、平移,把通过变换的裁剪坐标映射到[0,1]区间范围,将齐次摄像机裁剪空间转成齐次纹理空间。

图4 投影纹理映射Fig.4 Projected texture mapping

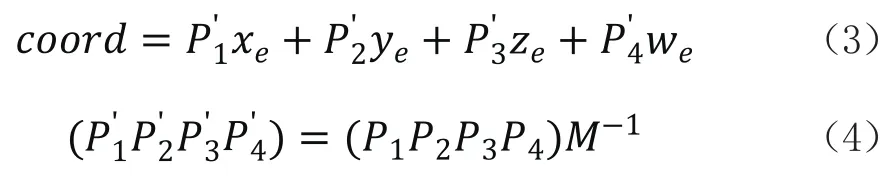

2)模型视点转换。把Eye Linear设为纹理坐标建立模式,采用眼坐标指定自动生成纹理坐标的参考面,设定为一对一映射,把自动生成的纹理坐标的S、T、R3个分量的参考面均设定为值。眼坐标系下的顶点坐标和对应的参考面之间的距离,就是对应自动生成纹理的坐标数值,表达式为:

式中,(xe,ye,ze,we)为物体顶点在眼坐标系中的坐标;P1、P2、P3、P4为参考面的4个参数;M为模型视点转换。

视频图像为纹理创建提供原始图像,对纹理进行操作,最终就是要让纹理与实景三维模型进行吻合。但摄像机的内外参数可以直接确定摄像机投影矩阵和视点矩阵,这两个矩阵可以由摄像机的内参数、外参数求出来。为了增强纹理的真实感,采用透视投影矩阵,让纹理出现观感的透视效果,在实景三维模型中,从观察者视角看物体近大远小。

2 实验结果与分析

2.1 实验结果

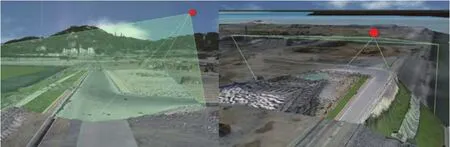

在项目建设现场布设视频摄像机,选取两台海康摄像机进行实验分析,图5、图6分别为BX011和BY002摄像机视频画面与实景三维模型融合实验结果图。

图5 BX011摄像机三维模型与视频融合结果图Fig.5 The fusion image of 3D model from BX011 camera and video

图6 BY002摄像机三维模型与视频融合结果图Fig.6 The fusion image of 3D model from BY002 camera and video

2.2 实验分析

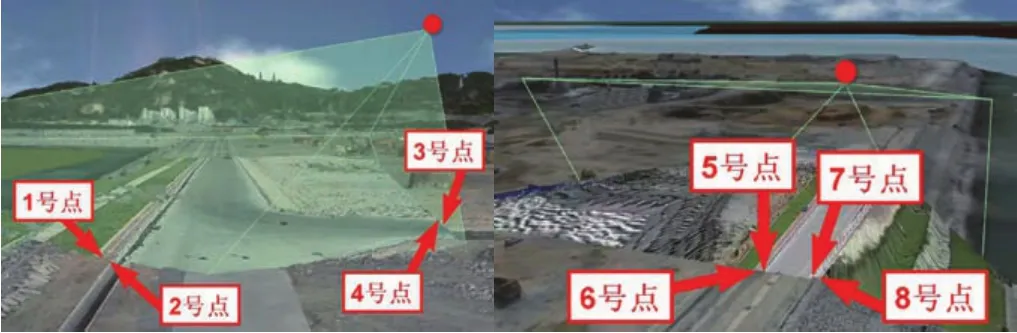

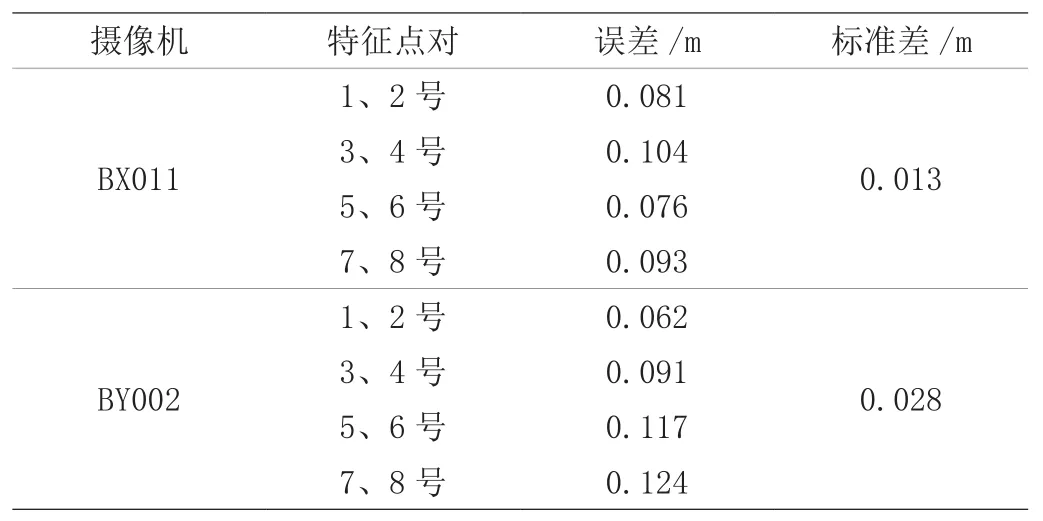

计算实景三维模型与视频融合误差,分别在BX011摄像机与BY002摄像机融合结果图中选取4对不同角度位置的特征点计算融合误差。

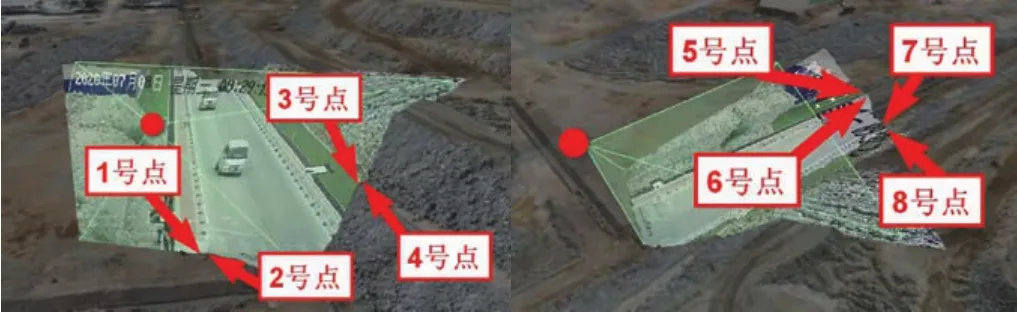

如图7、图8所示,1、2号点对,3、4号点对,5、6号点对,7、8号点对分别为BX011与BY002摄像机视频与投影的同名特征点对。将BX011与BY002摄像机两个特征点对的真实坐标提取出来,计算特征点对之间的距离就是实景三维模型与视频融合的误差。

图7 来自BX011摄像机的融合误差分析图Fig.7 The analysis diagram of fusion error from BX011 camera

图8 来自BY002摄像机的融合误差分析图Fig.8 The analysis diagram of fusion error from BY002 camera

表1为BX011与BY002摄像机的融合误差情况计算表,BX011摄像机选取不同角度的1、2号点对,3、4号点对,5、6号点对,7、8号点对融合误差分别为0.081 m、0.104 m、0.076 m和0.093 m,计算出的标准差为0.013 m;BY002摄像机选取不同角度的1、2号点对,3、4号点对,5、6号点对,7、8号点对融合误差分别为0.062 m、0.091 m、0.117 m和0.124 m,计算出的标准差为0.028 m。从数据分析来看,实景三维与视频融合精准度较高,客观上从融合效果图分析,融合像素分布均匀,效果良好。

表1 三维模型与视频融合误差计算表Tab.1 The calculation table of the fusion error

3 结 论

本文针对视频监控摄像机与实景三维数据互相独立、关联性差的问题,提出一种实景三维与视频融合方法,提高了实景三维与视频监控数据利用率,在实景三维模型中将视频监控的空间分布进行三维可视化,消除视频监控的空间位置靠人记忆、难以与实地匹配关联的弊端,协助管理者有效、直观、准确的掌握施工现场的实时整体态势。实现了实景三维与监控摄像机视频图像的特征级融合,使用投影纹理映射的方法将视频纹理特征序列,投射到实景三维模型中相对应的地理位置上,并对融合结果进行误差分析,选取4对同名特征点对计算特征点对之间的距离,误差结果分析证明,实景三维与视频融合精度较高,视频图像像素分布均匀,融合效果良好。