基于无人机RGB影像估测田间小麦穗数

2022-04-26高姻燕孙义李葆春

高姻燕, 孙义, 李葆春,3*

(1.甘肃农业大学生命科学技术学院,兰州 730070;2.南通大学地理科学学院,脆弱生态环境研究所,江苏 南通 2260073;3.甘肃农业大学甘肃省干旱生境作物学重点实验室,甘肃省作物遗传改良与种质创新实验室,兰州 730070)

小麦(Triticum aestivum)是世界贸易量较大的粮食作物,全球约35%~40%的人口以小麦为主要食物[1-3]。我国作为人口大国,对小麦的需求一直维持在较高水平[4]。近年来,市场竞争和耕地质量的改变导致小麦产量浮动较大[5]。小麦生产关乎我国粮食安全、经济发展和社会稳定[4],及时了解小麦产量信息可为国家经济和宏观决策提供科学依据[6-7]。

作物生产性状的传统监测方法主要有2种:一是通过田间破坏性取样测定,这种方法通常费时、费力、难以定点重复监测,而且容易出现较大的人为误差和干扰[8];二是传统的空间信息技术监测,这种方法具有覆盖范围广、数据周期长和无破坏性等优势[9]。但是,因为传统空间遥感技术存在分辨率较低、难以直接获取作物表型性状和重访周期长等缺点,因而难以实现对农业生产的实时性、连续性监测[10];载人航空遥感技术获取农业生产性状信息的精度比传统空间遥感技术高,但是因为运行成本高、操作复杂以及低空作业危险系数高而难以实现对植物性状的高精度、高频次动态监测[11-13]。因而,亟需探索一种快速、准确、无损且低成本的作物生产性状监测和评估方法。近年来,无人机遥感技术因具备操作简便、价格低廉、机动灵活、高时空分辨率以及控制软件开源等优势[14],逐渐成为农情监测的重要技术手段[15-16]。刘欣谊等[8]利用无人机图像颜色与纹理特征等间接指标对小麦产量进行预测,并指出颜色指数与其产量相关性较好。然而,到目前为止,大部分工作还是基于小范围的尝试性研究,缺乏标准化分析材料(航拍影像)的获取方法,难以在大范围开展田间小麦穗数监测并进一步指导品种繁育、田间管理以及产量估测等工作。

单位面积穗数是决定小麦产量的关键和直接指标之一[17-18],快速、准确地识别并统计小麦穗数对小麦的良种选育和田间管理有重要意义[19-21]。目前,针对室内单株小麦麦穗的识别和测量开展得比较多,陈含等[22]借助Sobel算子边缘检测在模糊背景中分割出麦穗,其与绿色分量法和最大值法的处理结果相比耗时明显减少;路文超等[23]利用图像处理技术拟合麦穗中心曲线,再结合灰度差异统计方法测定穗长和小穗数;Li等[24]基于Laws算法对麦穗进行检测,经过面积和高度阈值改进实现了80%以上的麦穗检测率。针对田间麦穗识别和定量观测的研究还比较少,刘涛等[25]通过颜色和纹理特征对田间撒播和条播小麦麦穗进行识别和计数,结果表明基于颜色特征的方法较为快速和高效;有研究利用超像素分割的方法实现对田间小麦麦穗的分割,但该方法不适宜长势过弱和差异过大的区域[2]。近年来,基于深度学习的目标检测技术日趋成熟,尤其YOLOv3算法检测效果最佳[26],由于具备高精度和实时性,其已经被广泛应用于灾害[27]、生物[28]以及商业[26]等领域的目标自动识别中,但是还缺乏针对田间小麦生产性状方面的研究。

本研究以甘肃省临夏回族自治州典型小麦田为研究对象,借助无人机航拍路径规划和控制系统(fragmentation monitoringand analysis with aerial photography,FragMAP)获取统一标准的田间小麦高分辨率影像,通过YOLOv3算法进行模型训练并实现麦穗的自动识别,以期构建标准统一、实时性的小麦穗数监测方法(FY方法),为田间小麦穗数统计和产量估测提供新的途径,也为小麦种质资源评价和田间管理提供必要的理论和实践指导。

1 材料与方法

1.1 研究区及试验设计

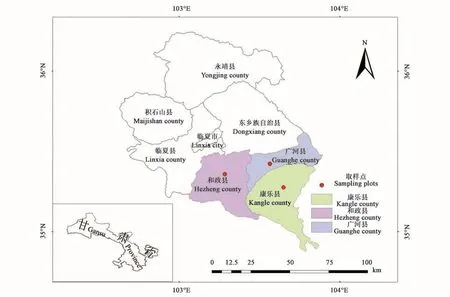

研究区为甘肃省临夏回族自治州的和政县、广河县及康乐县的典型小麦田(图1),位于青藏高原和黄土高原交汇处,平均海拔约1 800 m,年均降水量约510 mm,年均温为7.7℃,全年无霜期为156 d[29-30]。2020年7月下旬,在每个县随机选择具有代表性的春小麦麦田3块,在每块麦田随机选择3个样地进行无人机航拍以获取高分辨率的航拍影像(3个县区×3块麦田×3个样地)。与此同时,在每块麦田布设3个地面验证样方(面积为0.5 m×0.5 m,位于1个航拍样地内)。

图1 研究区域及采样点Fig.1 Study area and filed sampling plots

1.2 数据获取方法

1.2.1 航拍影像获取设备 利用大疆Mavic 2四旋翼无人机(深圳市大疆创新科技有限公司,中国)采集影像数据,共获取田间小麦的航拍照片144张;搭载的RGB相机(集成在Mavic 2云台,深圳市大疆创新科技有限公司)分辨率为2 000万像素,体积小、便携,续航时间约为30 min;高精度的视觉定位系统确保其在全球卫星导航系统信号较弱的情况下也可以精确获取具有地理信息的航拍影像;地形跟随功能保证其在复杂地形中安全飞行,并确保每张航拍照片覆盖的范围一致(尽可能减小样品采集产生的误差);机载惯性导航系统、全球定位系统和自动驾驶系统使无人机能够沿着预先设计的航线飞行,并且能够精确悬停,控制距离为6 km。

1.2.2 航拍影像及地面数据获取 FragMAP系统由南通大学脆弱生态环境研究所自主开发,基于SDK(software development kit)和无人机开展大范围、长期、定点地面监测,并进行信息提取和数据处理[14]。FragMAP由Setter和Flighter 2个安卓应用(APP)组成,其中,Setter APP主要用来设置野外工作点以及航线、航点;Flighter APP则用于控制无人机按照预定航线飞行并在航点拍照,在飞行选项下还兼备调整飞行高度、速度、暂停或终止飞行任务等功能[14]。FragMAP以华为平板电脑为载体,具备多种飞行模式[14],本研究主要使用其中的Belt飞行模式进行田间小麦麦穗自动航拍。具体飞行方式为在40 m×40 m的范围内均匀布设16个航点,无人机在每个航点采用垂直向下的方式拍摄1张照片。飞行高度设置为2 m,飞行速度设置为5 m·s-1,到达航点后停留1 s进行拍摄,拍摄完成后停留1 s确保无人机拍摄照片时处于平稳状态,从而保证航拍照片的质量。具体操作详见Yi[14]的方法。

在每块麦田布设3个地面验证样方,样方面积为0.5 m×0.5 m,记录每个样方内测定的小麦穗数以及完成测定工作所需要的时间等信息。

1.3 麦穗自动识别

1.3.1 影像分割 为了确保后续训练样本的准确性和分辨率,需要对大幅影像进行拆分。利用Python软件将每幅航拍影像平均分割为25等份并自动编码保存,即共获取3 600个田间小麦航拍影像样本。

1.3.2 训练样本获取 利用LabelImg软件标注训练样本中的麦穗。小麦麦穗确定的标准主要按照以下要求:具有清晰的完整麦穗;以图像范围内完整影像为参考标准,麦穗具有较为完整的头部,一般不选择只包含麦穗尾部部分的影像作为训练样本,防止出现同一麦穗在2张影像重复辨别而导致数量高估的错误。将航拍影像与麦穗定位文件匹配后(Python软件完成)导入YOLOv3的相应文件夹,做好模型训练准备。

1.3.3 YOLOv3训练模型 YOLOv3的主体网络Darknet-53由5个残差块组成,每个残差块由多个残差单元(Res×n)组成。通过输入与2个基础组件(Darknetconv2d_BN_Leaky,DBL)单元进行残差操作构建残差单元(Res unit),其中,DBL单元包含卷积层(conv)、批归一化(batch normalization,BN)和带泄露整流激活函数(leaky relu)[26]。

标定500个训练样本数据集后,模型训练处理如下:①随机选择200个样本,迭代次数为1 250(I1250200);②500个训练样本,迭代次数为3 125(I3125500);③500个训练样本,迭代次数为6 250(I6250500)。

1.4 数据分析

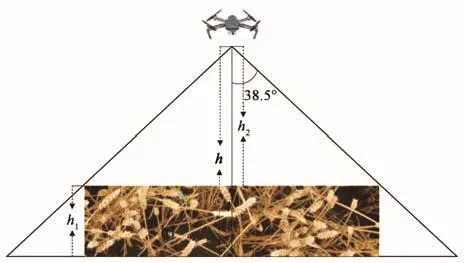

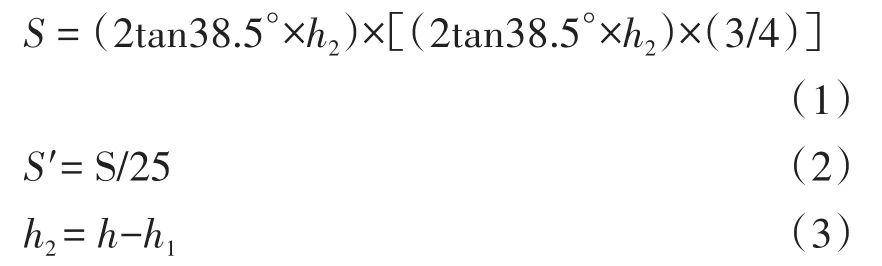

1.4.1 航拍影像面积换算 小麦株高通常为60~100 cm,利用FragMAP系统中Belt模式航拍并获取小麦顶端麦穗信息(图2),需将茎秆部分的高度去除,即无人机的航拍高度设定为2 m(h),以水平地面为基准面,计算过程中需减去小麦植株高度(h1)。航拍照片面积计算需按照h2高度和无人机的视场角进行换算(本研究所使用的无人机Mavic 2,视场角为77°),单幅航拍照片的面积计算公式如下。

图2 无人机航拍获取麦穗信息Fig.2 Collection of wheat ears information by UAV

式中,S为完整的单幅航拍照片所覆盖小麦顶部的面积,(2tan38.5°×h2)为航拍照片长边长度,(2tan38.5°×h2)×(3/4)为航拍照片宽边长度(本研究统一设置航拍照片长宽比为4∶3);S′为平均分割25份后单幅影像覆盖小麦顶部的面积;h2为无人机镜头至小麦顶端的距离,在本研究中将田间小麦平均高度设置为h1,取值范围为0.60~1.00m;h为无人机以水平地面为基准面的拍摄高度。

基于地面样方可获得单位面积的小麦穗数,依据无人机采样和小麦株高等信息获得单幅航拍照片覆盖的面积。结合公式(4)得到与样方相同面积内自动识别得到的麦穗的数量信息,转换公式如下。

式中,S″为地面样方观测面积,本研究取值为0.25 m2;γ为转换系数,因小麦平均株高(随机在样地内选择具有代表性的小麦植株5株,测定其自然状态下的高度并计算平均值)而变化,例如当小麦株高为0.75 m时,可通过公式(3)得到h2为1.25 m,再通过公式(1)和(2)计算S′,从而确定γ为2.107。

1.4.2 统计分析 利用单因素方差分析(one-way ANOVA)比较传统观测方法和FY方法获取样本的观测面积、观测效率以及不同训练样本数量、迭代次数获得的模型进行自动识别小麦穗数的准确率。利用线性回归分析(linear regression analysis)检测2种方法测定麦穗数量的相关关系,并构建预测模型。利用R 4.0.5进行数据分析和图形制作。利用Python完成田间小麦航拍影像拆分、训练样本与标注匹配、模型训练、目标检测以及结果检验。

2 结果与分析

2.1 取样效率比较

2.1.1 观测面积比较 与传统方法相比,FY方法获取田间小麦穗数的观测面积更大。FY方法的单个有效监测单元面积约为2.97 m2(按照小麦株高为0.75 m计算),是传统方法基本单元的12倍。按照统计学最低重复要求,选择3个重复时,单条Belt航线(即1个完整的监测单元)观测范围则是传统方法的63倍。因此,FY方法获取麦穗信息量明显大于传统方法,代表性也更强。

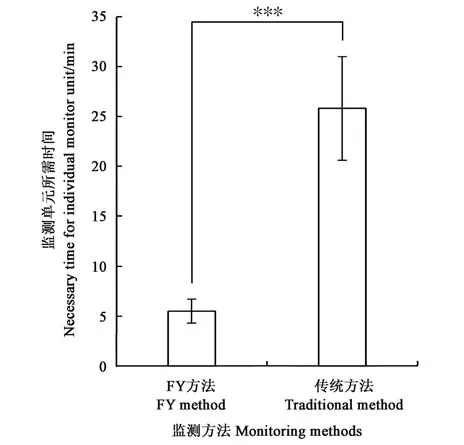

2.1.2 观测效率比较 与传统方法相比,FY方法能够更为高效地获取田间小麦麦穗信息。FY方法利用FragMAP系统自动规划路径和控制飞行,该方式获取小麦麦穗信息(航拍照片)所需时间远低于传统方法(图3)。而且基于FragMAP系统可以多次调用航线进行定点航拍,从而实现小麦穗数的动态监测(包括年际间变化的长期动态监测)。此外,FY方法还具有非破坏性采集样本的特点,可以在无人为活动干扰的情况下进行长期的动态监测。

图3 FY方法与传统方法野外采集样本效率比较Fig.3 Field sampling efficiency of FY and traditional methods

2.2 不同训练模型识别效果比较

I1250200、I3125500和 I6250500方法获得训练模型后,分别输入25幅田间小麦影像样本(不同于构建模型的样本)进行自动识别,获得检测样本自动识别的标示图(图4)。

图4 3种训练处理方式获得最优模型识别小麦麦穗的案例Fig.4 Examples of the recognition by the 3 trained models

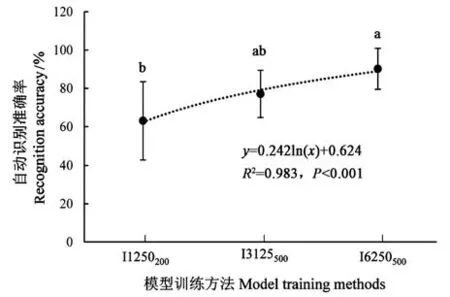

对检测结果统计分析(n=25)发现,利用500个训练样本经过6 250次迭代训练所得到的模型自动识别小麦麦穗的准确率超过90%,显著高于利用200个训练样本经过1 250次迭代获得模型的检测结果(P<0.05)。准确率随着训练样本数量和迭代次数呈非线性增加趋势(图5)。

2.3 FY与传统方法测定小麦穗数的关系

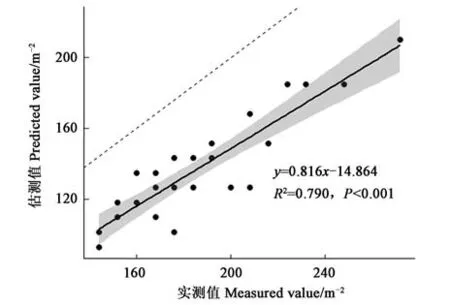

依据航拍影像获取的单位面积小麦穗数与地面测定值构建相关关系(图6),二者呈显著的线性相关关系(R2=0.79,P<0.001)。尽管基于FY方法自动识别获取的小麦穗数精确度较高(图5),但是还有部分麦穗因为遮挡、角度等问题无法被垂直向下拍摄的航拍照片获取,因此拟合曲线处于1∶1线的下方,而且随着麦穗密度的增加这一趋势更为明显(图6)。以该模型为基础,具备成熟的无人机航拍(FragMAP)和深度学习训练模型(YOLOv3)的前提下,通过快速获取样本和分析数据可以高效、快速计算大范围的田间小麦穗数,并进一步预测小麦产量。

图5 训练模型识别麦穗准确率与训练样本数量和迭代次数的关系Fig.5 Relationship between recognition accuracy of training models and sample number and iterations

图6 基于地面实测与FY方法获取数据构建田间小麦穗数预测模型Fig.6 Prediction model based on the data collected using traditional and FY method

3 讨论

利用作物性状特征准确、高效地预测农作物产量是研究的焦点之一[31]。目前,基于不同传感技术监测农作物生长的研究很多,也取得了不少重要的进展[8,32-34],由于没有标准、高效率、适宜大范围采集样本的观测和分析方法,导致难以进一步应用于指导种质资源评价和田间管理。

本研究提出了一种结合无人机取样和目标检测技术估测田间小麦穗数的方法。不同于前期主要基于小区控制试验或者个别样地MOSAIC飞行并拼接等仅适于少量、部分区域的取样方式[2,8],本方法利用FragMAP系统实现了大面积、高效、高分辨率、高频度、定点采集样本[14,35]。本方法充分利用无人机地形跟随功能,采用近地面(航高统一设定为2 m)航拍获取样本的方式,既保证飞行作业安全,也确保了每幅航拍照片的覆盖面积一致和高分辨率,从而提高结果的准确性,构建标准化的田间小麦穗数观测方式。在获取足够的标准化样本数据(无人机航拍影像)基础上,利用YOLOv3实现端到端的训练,YOLOv3采用SOTA算法实现更高的检测精度和更快的信息处理速度[36],减少模型训练的复杂度并大幅度提高图像处理速度。因此,在硬件满足的条件下可以实现小麦穗数实时监测的需求[27]。综上所述,本研究利用YOLOv3能对典型田间小麦样本进行快速检测,并结合地面测定值构建小麦穗数的估测模型,再结合无人机航拍影像实现大范围、高效率、高时效地田间小麦穗数估测。

前期大量的研究成果难以应用于种质资源评价和指导田间生产的主要原因之一是航拍照片获取方法不具备普适性。本研究采用的FragMAP系统简单易学、普适性较高,而且该系统的无人机飞行控制部分可以被独立拆分出来构建应用程序(APP)[37],即根据研究或监测要求设定航线后,其他无人机操作人员随时可以利用安装在移动终端(例如手机)上的应用程序(APP)多次调用航线完成航拍作业,从而实现高频次、定点、协同监测。基于YOLOv3进行田间小麦麦穗自动识别的准确性随着训练样本数量和迭代次数增加而增加(在本研究测试范围之内),考虑到过度训练可能产生变量间过度拟合,在今后的研究中应通过构建较大的训练样本数据集和适当选择迭代次数获取更为适宜的训练模型从而确保麦穗自动识别的精度。本研究构建的估测模型基于3个县区的27个取样点样本,未考虑小麦品种等因素,因此代表性具有局限性。在今后的研究中应该进行多地区、多品种的监测,根据研究区构建特定区域的模型,确保田间小麦穗数的估测精度。