基于改进U-Net的高光谱农林植被分类方法

2022-04-26王克奇彭熙雯张怡卓罗泽蒋大鹏

王克奇 彭熙雯 张怡卓 罗泽 蒋大鹏

摘 要:針对高光谱图像中的“同谱异物”和“同物异谱”现象导致传统机器学习方法难以精确区分,以及深度学习模型处理高维遥感数据耗时较长的问题,本文以河北省雄安新区雄县雄州镇马蹄湾村19种土地覆被类型(农林植被为主)为研究对象,提出一种基于改进U-Net的高光谱农林植被分类方法。该方法以U-Net为基础框架,首先利用主成分分析(Principal Component Analysis, PCA)提取主要光谱波段,降低光谱冗余度;然后提出特征提取模块,该模块使用深度可分离卷积替代U-Net中的传统卷积,提取高光谱图像多尺度特征,降低网络复杂度,并采用非线性更好的h-swish(hard-swish)激活函数提升网络的泛化性能;最后在每个特征提取模块中引入残差连接提取深层次语义信息。结果表明,改进的U-Net对19种覆被分类的整体精度为96.68%,与Mobile-UNet、U-Net、Res-UNet相比,精度分别提高了4.47%、2.92%、0.45%,训练时间较分类精度相近的Res-UNet减少了23.5%。由此可知,残差连接提升了网络分类精度,使模型在描述植被边缘和细节方面表现良好;深度可分离卷积使模型轻量化,减小训练时间;改进的U-Net模型能够准确、快速地对研究区的农林植被进行区分。

关键词:高光谱;植被区分;U-Net;深度可分离卷积;残差连接;模型轻量化

中图分类号:S771.5 文献标识码:A 文章编号:1006-8023(2022)01-0058-09

A Hyperspectral Classification Method for Agroforestry

Vegetation Based on Improved U-Net

WANG Keqi, PENG Xiwen, ZHANG Yizhuo*, LUO Ze, JIANG Dapeng

(College of Mechanical and Electrical Engineering, Northeast Forestry University, Harbin 150040, China)

Abstract:In view of the difficulty in accurately distinguishing between “same spectrum foreign objects” and “same object foreign spectrum” in hyperspectral images caused by traditional machine learning methods, and the time-consuming processing of high-dimensional remote sensing data by deep learning models, 19 land cover types (mainly agroforestry vegetation) in Matiwan village, Xiong’an New Area, Hebei Province, were taken as the research object, and a hyperspectral classification method for agroforestry vegetation based on improved U-Net was proposed. This method was based on U-Net framework. Firstly, Principal Component Analysis (PCA) was used to extract the main spectral bands to reduce spectral redundancy. Then, the feature extraction module was proposed, which used the depthwise separable convolution to replace the traditional convolution in U-Net to extract multi-scale features of hyperspectral images to reduce the complexity of the network, and uses the better nonlinear h-swish (hard-swish) activation function to improve the generalization performance of the network. Finally, residual connection was introduced into each feature extraction module to extract deep semantic information and improve the classification accuracy. The results showed that the overall accuracy of the improved U-Net for 19 cover classification was 96.68%, which was 4.47%, 2.92% and 0.45% higher than that of Mobile-UNet, U-Net and Res-UNet, respectively, and the training time was 23.5% less than that of Res-UNet with similar classification accuracy. Therefore, residual connection improved the accuracy of network classification and made the model perform well in describing vegetation edges and details. Depthwise separable convolution made the model lightweight and reduced the training time. The improved U-Net model can accurately and rapidly distinguish agroforestry vegetation in the study area.

Keywords:Hyperspectral; vegetation differentiation; U-Net; depthwise separable convolution; residual connection; model lightweight

0 引言

随着我国人口的快速增长,农林牧业争地的矛盾日益突出。农林植被分类为农林资源的合理配置提供重要依据,对提高土地利用率,实现精准农业高效估产有重要意义[1]。传统的土地植被覆盖信息获取主要采用人工调查的方式,这种方法虽然制图精度高,但十分耗费人力、物力,且不适用于对大面积植被进行识别[2]。

高光谱遥感技术是近年来迅速发展起来的一种对地观测的技术,其影像具有“图谱合一"、波段数目多和信息量大等显著优势[3]。国内外学者提出了多种高光谱植被分类方法,其中光谱指数法利用植被原始光谱反射率的波段组合计算分析植被类别,分类效果明显,张波等[4]利用光谱平均值的一阶导数和倒数取对数计算归一化植被指数(Normalized Difference Vegetation Index, NDVI),将准噶尔盆地4种植被进行区分。基于植被指数的分类方法虽然有效,但精度普遍不高,且受环境影响大,对于景观破碎、地形复杂地区有很大局限性[5];机器学习方法在高光谱植被分类中取得了很大的进展,张文博等[6]对干旱区的遥感影像进行特征选择,并分别建立决策树、支持向量机、随机森林分类模型,结果表明随机森林分类模型精度最高。但是此类方法需要人工提取特征,影响分类精度。此外,高光谱图像存在“同谱异物”和“同物异谱”现象,表现为光谱类间可分离性小、类内差异性大,机器学习方法无法利用高光谱的空间特征,容易引起误分类问题[7]。

深度学习方法通过自动学习数据中的空间关系获取高级特征信息,简化了复杂的人工设计特征过程,成为高光谱图像植被分类的研究热点[8]。U-Net是基于编码器-解码器结构的全卷积网络,具有简洁的分割逻辑和出色的分割效率,因此在遥感图像分割领域被广泛应用[9]。苏健民等[10]利用U-Net模型对“CCF卫星影像的AI分类与识别竞赛”数据集中的植被、建筑和水域等多种土地类型进行分类;Bragagnolo等[11]基于U-Net对亚马逊的森林植被与非植被区域分类,对森林覆盖变化做出评估。然而当植被类别较多时,U-Net无法充分提取高光谱的空间特征,导致其输出边缘粗糙。残差连接通过恒等映射连接其他卷积层,在提取更深层特征的同时,解决了层数加深导致的梯度消失问题,提高模型分类的准确性。Zhu等[12]提出了基于融合残差网络的高光谱图像土地覆被分类方法,利用残差单元学习更具判别力的高级特征。然而,深度学习方法在处理高维遥感数据时,往往存在模型计算量大、耗时较长的问题。因此,对于遥感图像分类模型轻型化的研究,需要进一步探索。

本文针对U-Net无法充分利用高光谱图像的深层抽象信息,以及传统深度学习语义分割算法在处理遥感图像的过程耗时较长的问题,提出基于改进U-Net的高光谱农林植被分类方法。该模型中提出特征提取模块替代U-Net中的传统卷积层,在特征提取模块中采用计算量更少的深度可分离卷积进行特征提取,采用h-swish(hard-swish)非线性激活函数,并引入残差连接提取深层次语义信息。以河北省雄安新区雄县雄州镇马蹄湾村19种土地覆被类型(农林植被为主)为研究对象,与其他3种分类模型进行比较,为研究区内农林资源规划管理提供有力支撑。

1 材料与方法

1.1 材料

1.1.1 研究区域概况

研究区位于河北省雄安新区雄县雄州镇马蹄湾村,地理坐标为38°9′ E,北纬116°07′ N,是继深圳经济特区和上海浦东新区之后又一具有划时代意义的新区。雄安新区地处冀中腹地,北距北京108 km,东距天津100 km,西距保定70 km,东西长26 km,南北宽25.5 km。全境西北地势较高,东南略低,海拔为7~19 m,为缓倾平原,土层深厚,地形开阔,植被覆盖率很低[13]。

该高光谱影像由中国科学院上海技术物理研究所研制的高分专项航空系统全谱段多模态成像光谱仪采集,参照同步测量的地面和大气数据,经过几何、辐射和大气校正,得到的关于各地表覆盖类型反射率的伪彩色影像,如图1所示。其光谱范围为400~1 000 nm,波段256个,空间分辨率0.5 m[13]。

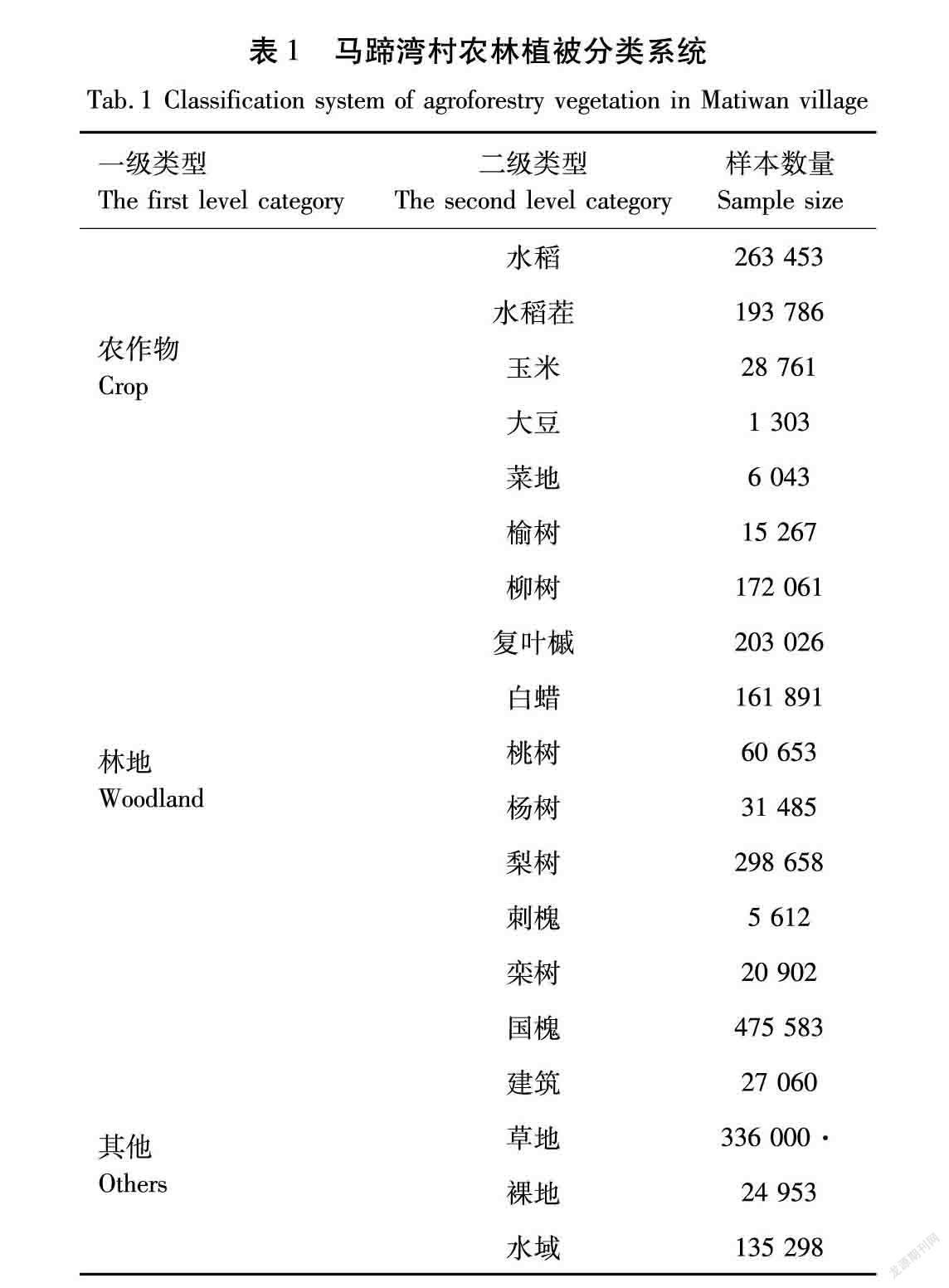

1.1.2 分类系统的构建

依據《土地利用现状分类》(GB/T 21010—2017)和《森林资源规划设计调查主要技术规定》,并结合实际土地覆被情况,建立研究区覆被分类系统。利用分类系统在影像上选取样本,每个像素类别代表其所在位置属于的土地覆被类型,各覆被类型及其包含样本数见表1。

1.1.3 数据分析

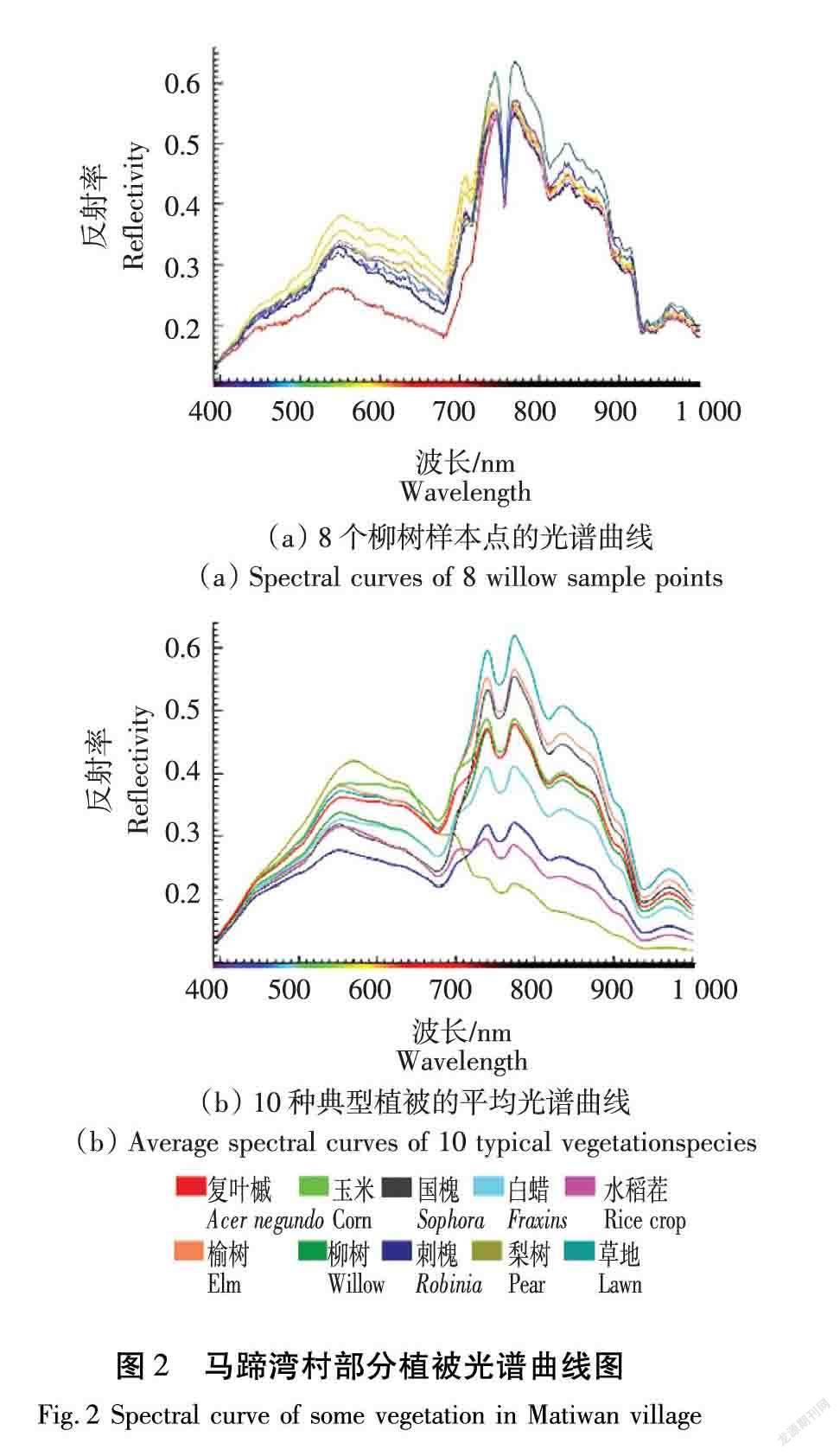

在高光谱图像中,同类别的地物在周围的环境如光照、密度以及成像时间等多种因素作用下,呈现出差异较大的光谱曲线,称为“同物异谱”现象;同时,由于高光谱图像包含的地物种类多样,背景信息复杂,不同的地物在高分辨率下可能呈现出极为相似的光谱曲线,这种现象为 “同谱异物”现象[14]。这2种特点可能导致模型的误分类问题,对高光谱图像的分类任务造成了很大的挑战。

使用ENVI 5.3软件对马蹄湾村高光谱图像进行光谱提取,如图2所示。图2(a)为在柳树样本中随机选取8个像素点获得的光谱曲线,图2(b)为10种典型植被经曲线平滑处理的平均光谱曲线,横坐标为波长,纵坐标为反射率。由图2(a)可以看出,同种植被类别的光谱曲线仍存在差异;由图2(b)可以看出,不同植被类型如榆树和国槐、玉米和复叶槭的光谱信息相似。以上马蹄湾村高光谱图像中存在的“同物异谱”与“同谱异物”现象对模型的泛化性能提出了极高的要求。

1.2 研究方法

1.2.1 深度可分离卷积

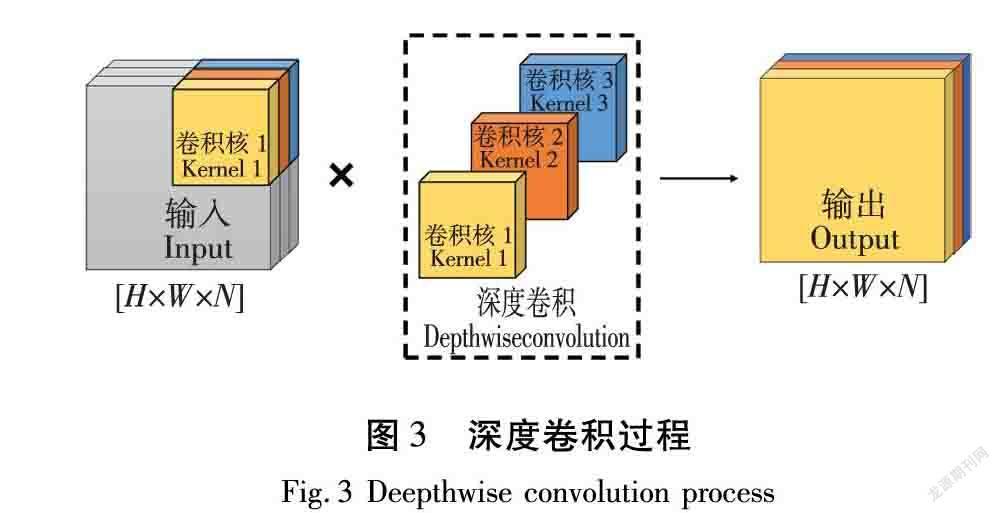

深度可分离卷积是可分解的卷积,分为深度卷积(Depthwise convolution)和逐点卷积(Pointwise convolution)2部分, 具有轻量级和低参数量的特点[15]。

深度卷积由与输入数据的通道数相同的卷积核组成,在与输入通道卷积后,生成的输出特征保留其原始深度与尺寸。图3为尺寸为[H×W×N]的输入图像的深度卷积运算,其中,H为高度,W为宽度,N为通道数。

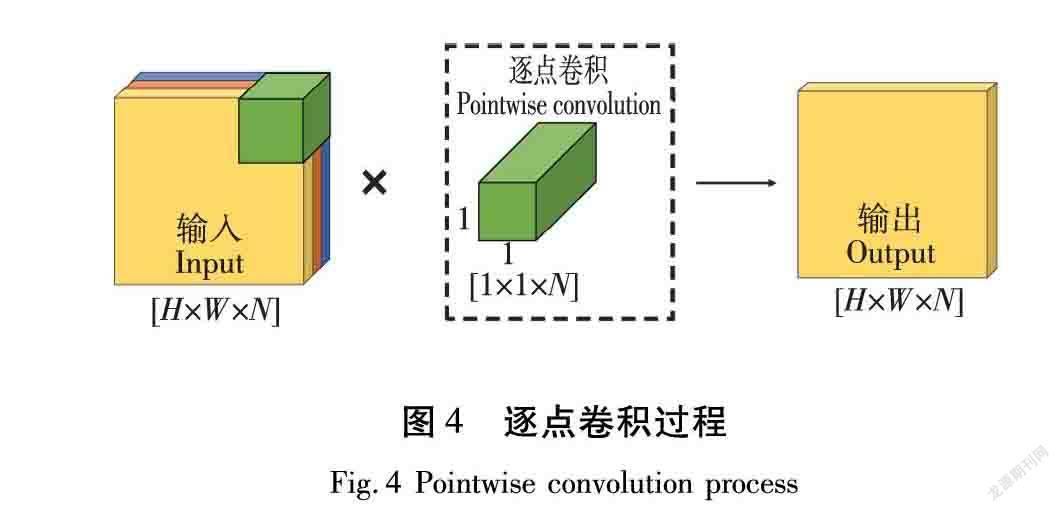

逐点卷积用于将深度卷积输出的特征通道混合,图4为对尺寸为[H×W×N]的输入特征的逐点卷积运算,逐点卷积核大小为[1×1×N],最终得到[H×W×1]的输出特征。

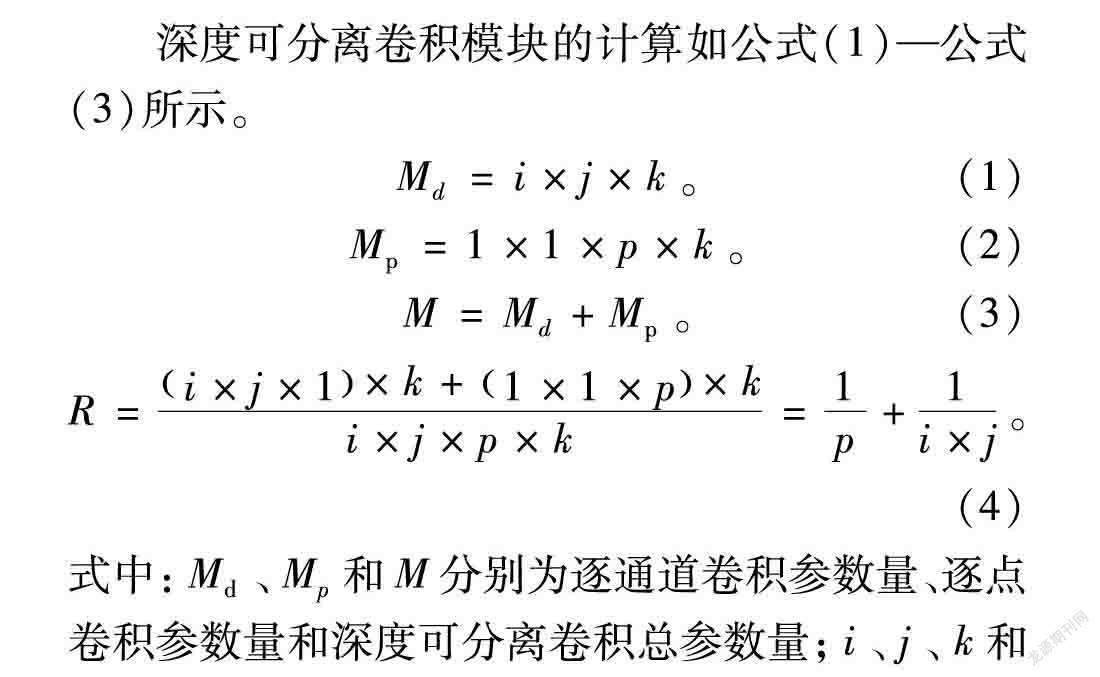

深度可分离卷积模块的计算如公式(1)—公式(3)所示。

Md=i×j×k 。 (1)

Mp=1×1×p×k 。 (2)

M=Md+Mp 。 (3)

R=i×j×1×k+1×1×p×ki×j×p×k=1p+1i×j 。(4)

式中:Md、Mp和M分别为逐通道卷积参数量、逐点卷积参数量和深度可分离卷积总参数量;i、j、k和p分别为卷积核的长、宽、数量和通道数;R为深度可分离卷积与普通卷积参数量比值[16]。

本文采用卷积核的长和宽均为3,高光谱降维后的通道数为6,经公式(4)计算可得R约为0.278,通过该比值可以看出深度可分离卷积的参数量远少于传统卷积参数量,进而可以降低模型复杂度。

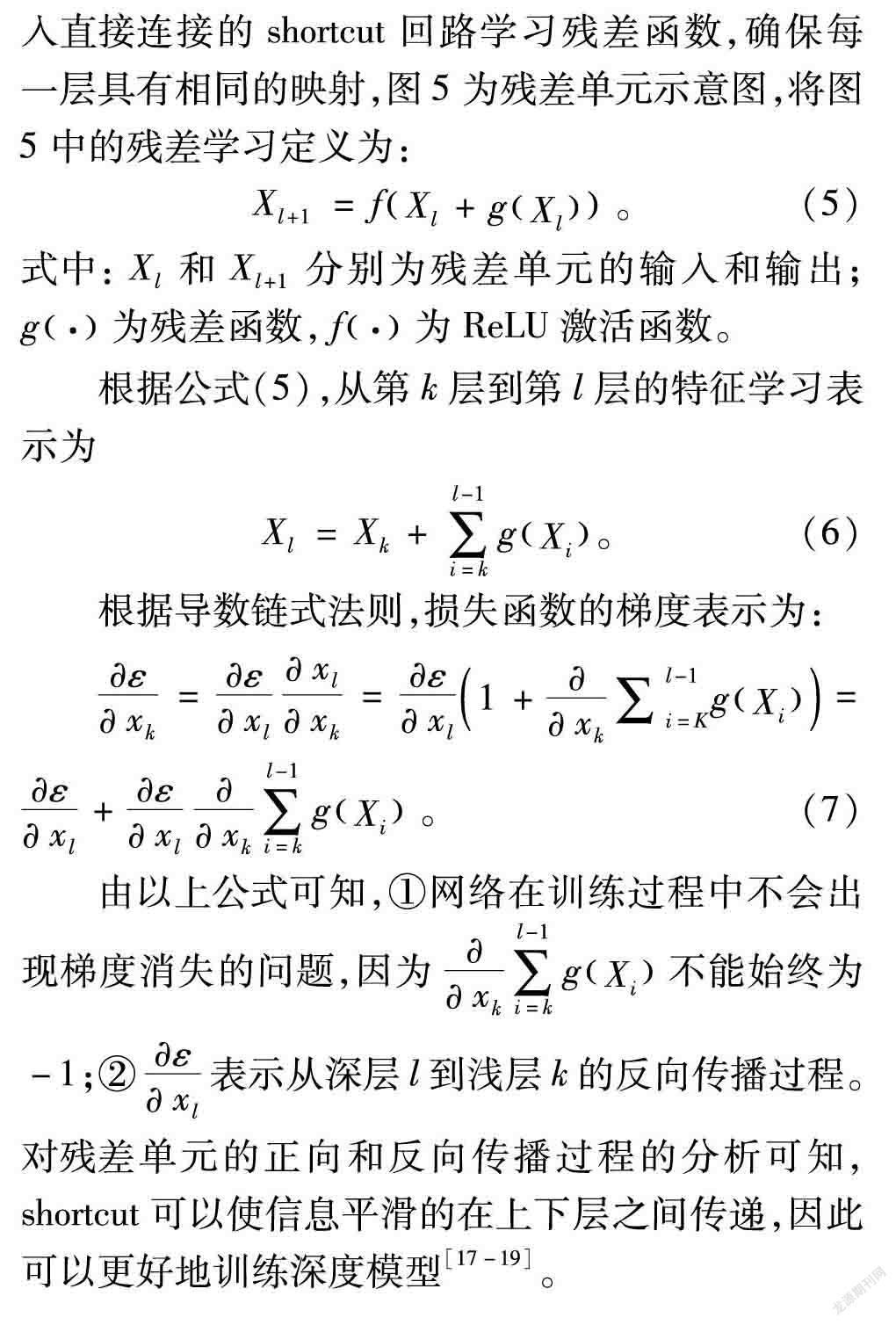

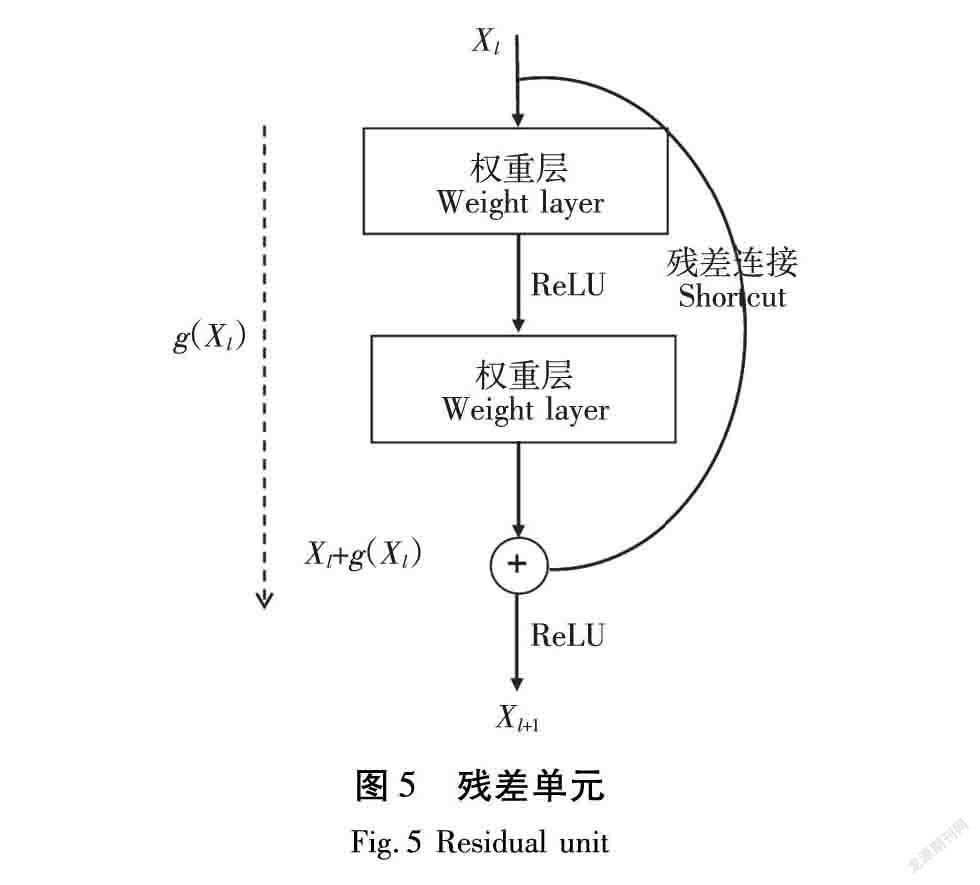

1.2.2 残差单元

残差网络通过在卷积层的输入和输出之间引入直接连接的shortcut回路学习残差函数,确保每一层具有相同的映射,图5为残差单元示意图,将图5中的残差学习定义为:

Xl+1=fXl+gXl 。(5)

式中:Xl和Xl+1分别为残差单元的输入和输出;g·为残差函数,f·为ReLU激活函数。

根据公式(5),从第k层到第l层的特征学习表示为

Xl=Xk+∑l-1i=kgXi。 (6)

根据导数链式法则,损失函数的梯度表示为:

εxk=εxlxlxk=εxl1+xk∑l-1i=KgXi=εxl+εxlxk∑l-1i=kgXi 。 (7)

由以上公式可知,①网络在训练过程中不会出现梯度消失的问题,因为xk∑l-1i=kgXi不能始终为-1;②εxl表示从深层l到浅层k的反向传播过程。对残差单元的正向和反向传播过程的分析可知,shortcut可以使信息平滑的在上下层之间传递,因此可以更好地训练深度模型[17-19]。

1.2.3 改进的U-Net模型

U-Net[20]由全卷积神经网络改进而来,是目前比较流行的图像分割模型。网络模型采用编码器-解码器结构,编码部分对图像特征提取,解码部分对图像部分细节还原,并通过1×1卷积输出期望的分类结果[21]。

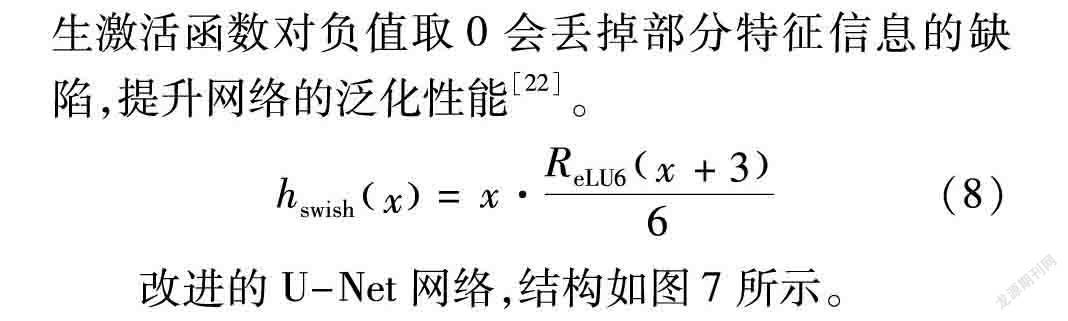

鉴于深度可分离卷积与残差单元的优势,本文提出了特征提取模块,结构如图6所示。该模块分别在3×3的深度卷积(Depthwise convolution)和1×1的逐点卷积(Pointwise convolution)后,进行批处理归一化(BatchNorm)操作,并将输入和输出直接相加进行残差函数的学习,形成残差连接。采用h-swish激活函数(公式中用hswish表示),该激活函数非线性更强,弥补了传统的线性整流函数(Rectified Linear Unit, ReLU,公式中用ReLU表示)及其衍生激活函数对负值取0会丢掉部分特征信息的缺陷,提升网络的泛化性能[22]。

hswishx=x·ReLU6x+36 (8)

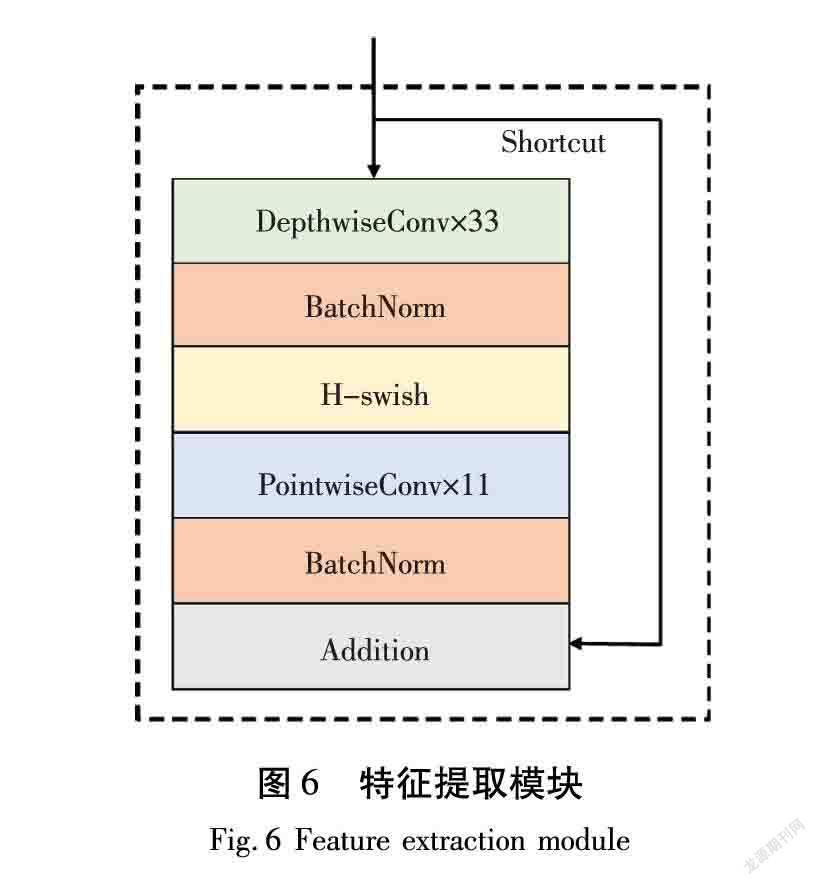

改进的U-Net网络,结构如图7所示。

图7改进的U-Net模型由编码部分、解码部分和跳跃连接组成。其中,编码部分和解码部分均包含5层,每层添加2个特征提取模块,对称的解码和编码部分形成一个U形结构。编码部分通过特征提取模块进行特征提取,并在结构上重复采用2×2的最大池化进行下采样,从上下文中提取图像特征;解码部分同样采用提出的模块替代U-Net中的卷积层,为了在融合中确保相同的分辨率,在每个图层前对基础特征图进行2×2上采样还原图像大小,最后一层通过1×1的卷积核对每一个像素进行分类;跳跃连接部分将从编码和解码部分提取的特征进行尺度融合,以保证浅层的细节信息与深层的背景语义信息更好地结合。

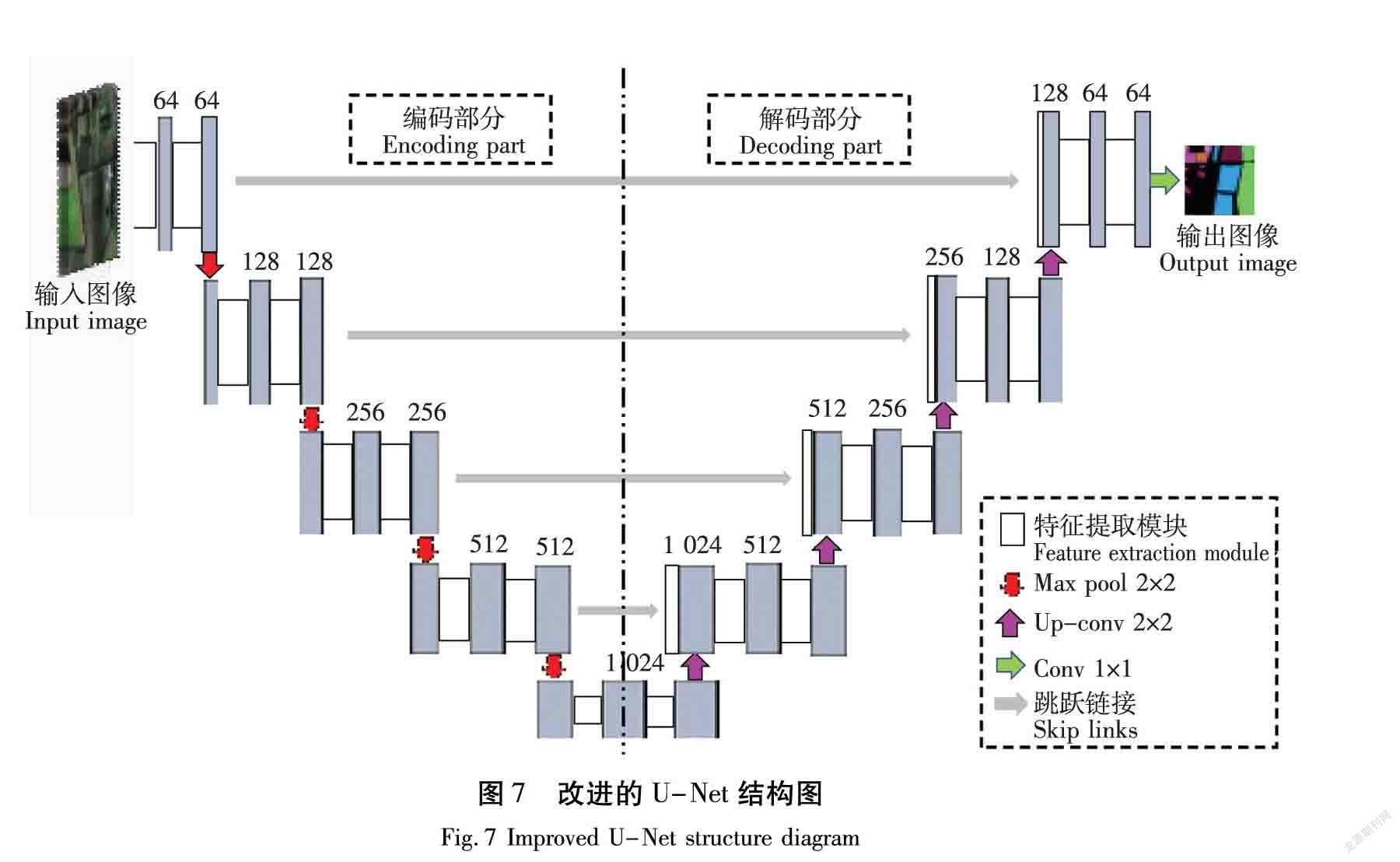

网络在训练过程中将每个像素的分类视为二分类问题,因此使用二元交叉熵損失函数:

Jω,b=-1m∑mi=1yilogy^i+1-yilog1-y^i。

(9)

式中:m为样本量;yi为样本i的标签;y^i为样本i预测值;ω为权重;b为偏置。

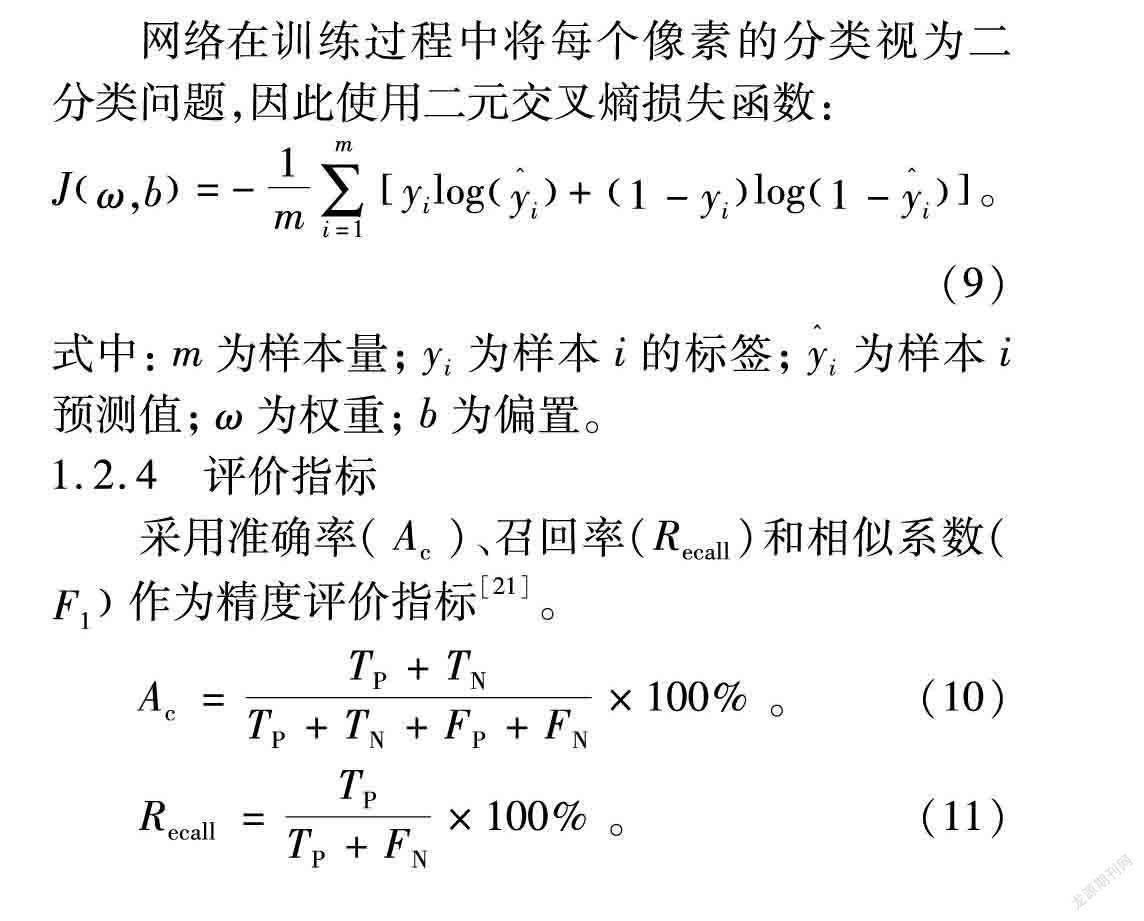

1.2.4 评价指标

采用准确率(Ac)、召回率(Recall)和相似系数(F1作为精度评价指标[21]。

Ac=TP+TNTP+TN+FP+FN×100%。 (10)

Recall=TPTP+FN×100% 。 (11)

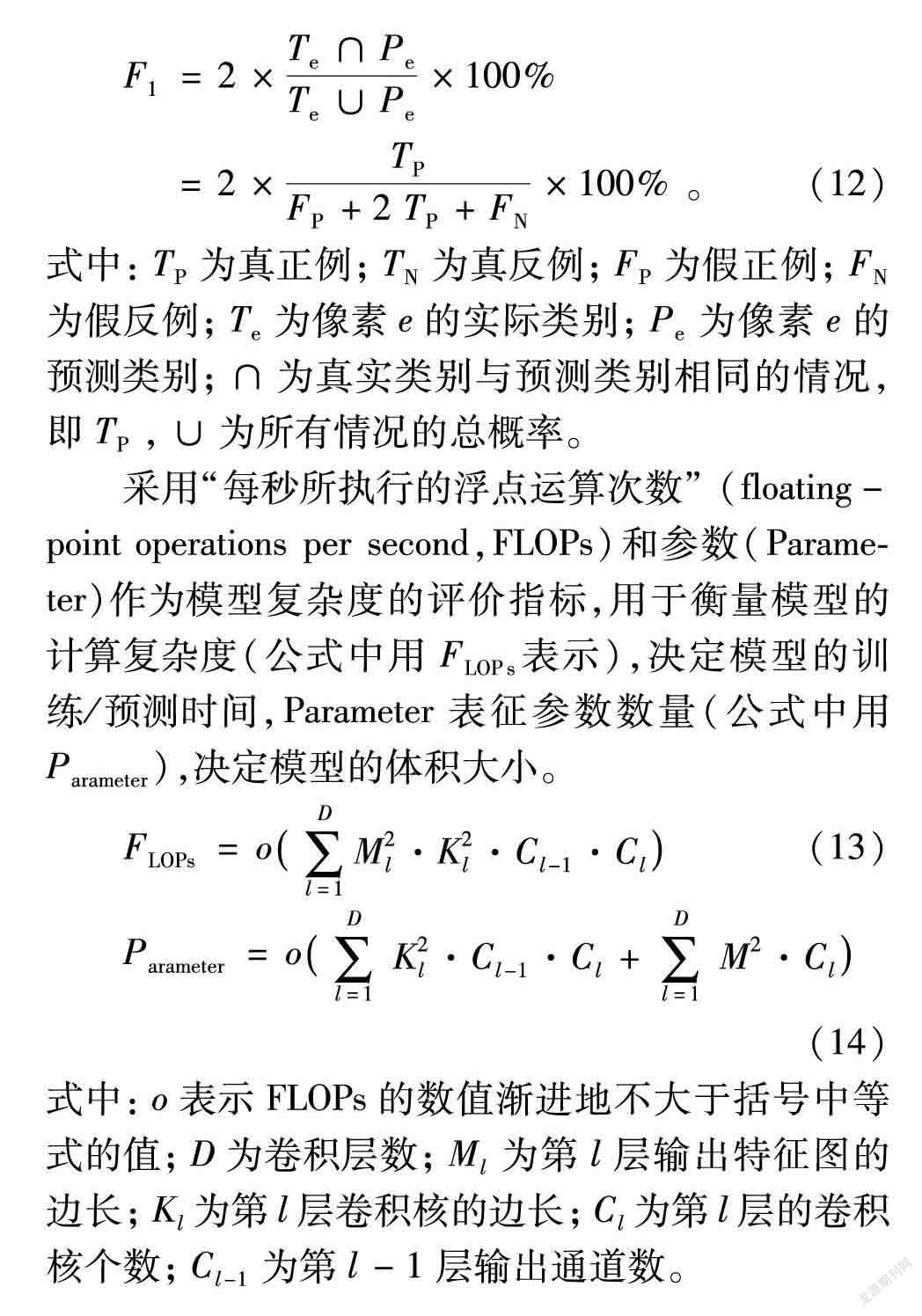

F1=2×Te∩PeTe∪Pe×100%

=2×TPFP+2TP+FN×100%。(12)

式中:TP为真正例;TN为真反例;FP为假正例;FN为假反例;Te为像素e的实际类别;Pe为像素e的预测类别;∩为真实类别与预测类别相同的情况,即TP,∪为所有情况的总概率。

采用“每秒所执行的浮点运算次数” (floating-point operations per second,FLOPs)和参数(Parameter)作为模型复杂度的评价指标,用于衡量模型的计算复杂度(公式中用FLOPs表示),决定模型的训练/预测时间,Parameter表征参数数量(公式中用Parameter),决定模型的体积大小。

FLOPs=o∑Dl=1M2l·K2l·Cl-1·Cl(13)

Parameter=o∑Dl=1K2l·Cl-1·Cl+∑Dl=1M2·Cl (14)

式中:o表示FLOPs的数值渐进地不大于括号中等式的值;D为卷积层数;Ml为第l层输出特征图的边长;Kl为第l层卷积核的边长;Cl为第l层的卷积核个数;Cl-1为第l-1层输出通道数。

2 结果与分析

2.1 实验参数

实验所用计算机配置为NVIDIA Quadro RTX 5000显卡,Intel(R) CoreTM i9-1085H处理器;在Windows操作系统下基于PyCharm2019.2.3平台,使用python3.7编程语言,通過PyTorch框架运行实验。实验时,将主成分分析(Principal Component Analysis,PCA)降维后的高光谱图像按512×512的大小随机剪裁,并依据4∶1的比例分成训练集和测试集。设置批次训练的样本集为4,最大训练迭代次数(epoch)为600代,网络初始学习率为0.000 1;在迭代次数等于100后,学习率变为十万分之一,使网络寻找局部最优解;初始权重为ImageNet的预训练权重。

2.2 对比验证与分析

为验证改进模型的分割性能,本文选取U-Net和以ResNet34、 MobileNetV1替换U-Net的编码器与解码器特征提取部分的Res-UNet与Mobile-UNet模型进行对比实验。

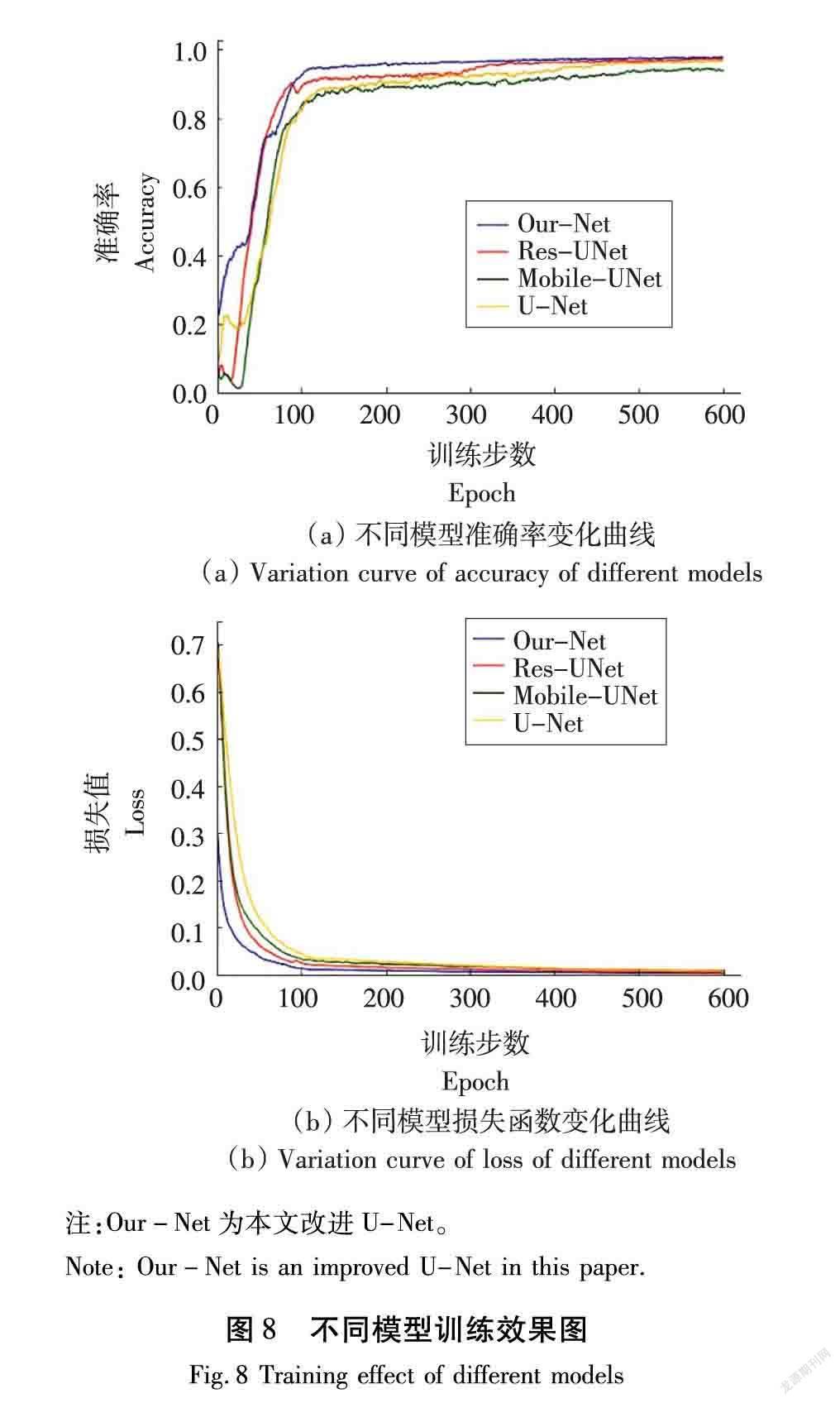

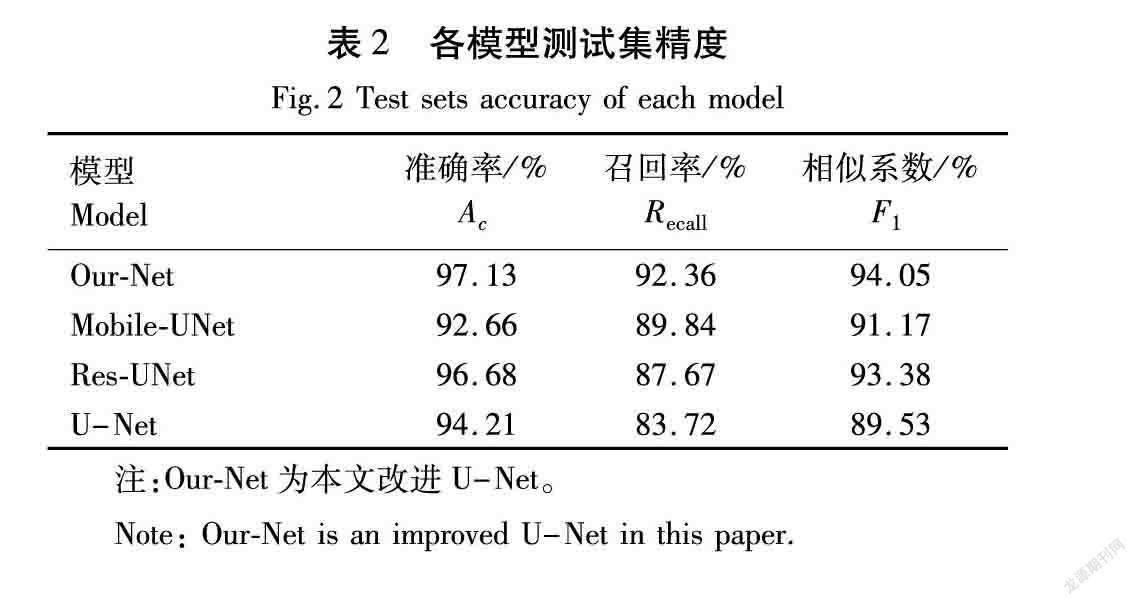

图8为训练过程中准确率与损失函数随迭代次数变化曲线,表2为各模型测试集精度的评价指标。由图8(a)可以看出,本文提出的模型训练(Our-Net)精度最高,Res-UNet与其准确率近似,其次是U-Net,准确率最低的是Mobile-UNet;此外,相较于其他3个模型,改进的U-Net在训练100代左右时趋于稳定,最快达到收敛。由图8(b)可以看出,改进模型的损失下降最快。以上结果表明,深度可分离卷积能够大幅提高模型计算效率,但在一定程度上降低了网络分类精度;残差结构使模型学习到更深层次的特征,进而提升网络分割能力,弥补了深度可分离卷积对特征提取能力不足的缺陷。

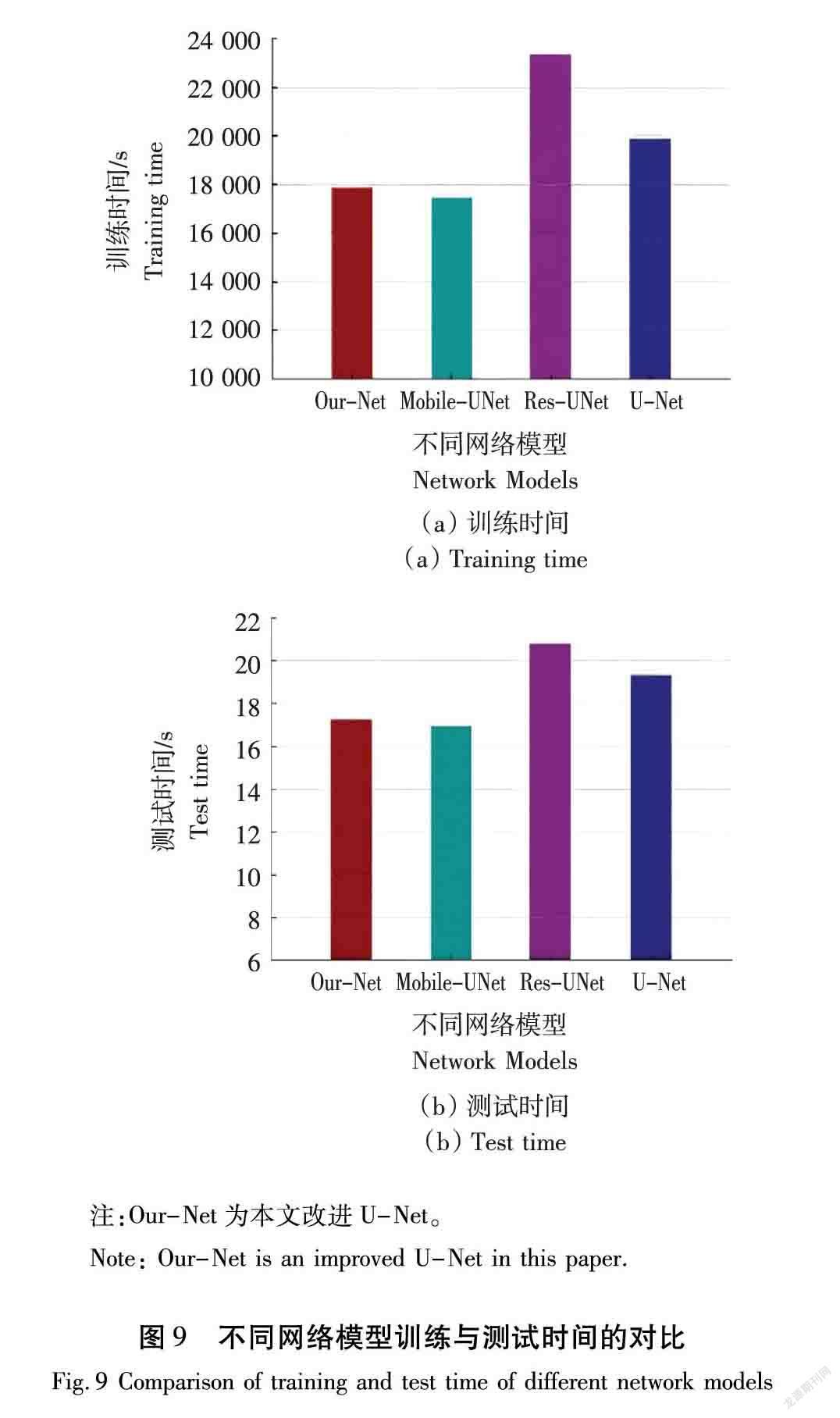

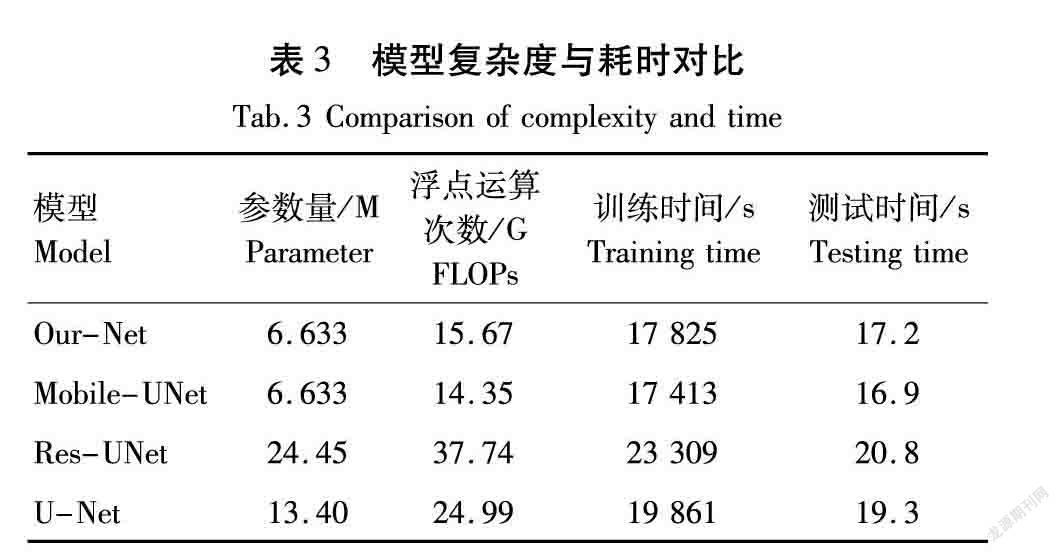

由图9和表3可知,改进U-Net的Parameter分别是U-Net和Res-UNet的0.50、0.27倍; FLOPs分别是U-Net、Res-UNet和Mobile-UNet的0.63、0.42、1.09倍;改进的U-Net与Mobile-UNet的Parameter相同,FLOPs相近,因为残差单元的shortcut连接在网络训练时没有引入额外的参数,不会给网络增加额外计算量,在不增加额外训练时间的情况下更易于优化参数,但会增加模型计算复杂度;改进的U-Net与Mobile-UNet训练和测试时间相近,均少于U-Net和Res-UNet。可见相比于U-Net和Res-UNet使用的传统卷积,深度可分离卷积的分步卷积过程能够在一定程度上减少网络参数量以及计算复杂度,节约计算成本,使模型更加轻量化。

植被之间光谱相似度较高,从而存在错分、漏分的情况,对分类精度产生了一定的影响。此外,由于各覆被类别像元个数分布不平衡,样本量较少的几类地物如大豆、菜地和刺槐分类精度不高。因此,将数据集预处理以增加光谱间差异性,并对小样本类别进行数据扩增以提高整体分类精度将是今后研究的重点。

为观察分类可视化效果,随机选取测试集中的4张图像进行显示,如图10所示。由图10可以看出,本文提出的方法分类效果最优,不仅对小样本植被分类的准确率更接近真实值,而且可以更好地描述不同植被区域的边缘和细节,这是因为残差连接增强了特征的传播能力,提取更多的地物细节信息,减少信息丢失[24]。以上结果表明,改进的U-Net模型在分类精度和时间消耗上均有不错的表现,对植被的分类结果较其他3种方法更佳。

3 结论

本文以河北省雄安新区雄县雄州镇马蹄湾村高光谱影像为研究对象,将深度可分离卷积和残差连接结合作为U-Net的改进策略,对19种土地覆被类别(农林植被为主)进行分类。主要结论如下。

(1) 相比于传统高光谱图像分类任务,改进的U-Net引入的残差连接能够更好地捕捉高光谱图像上下文语义信息,模型整体分类精度较U-Net、Mobile-UNet、Res-UNet分别提高了4.47%、2.92%、0.45%。

(2) 在处理遥感数据时,使用深度可分离卷积可以有效降低模型复杂度,计算复杂度(FLOPs)分别较Res-UNet、U-Net减少了58.5%、37.2%。

(3) 通过对实验结果的定量及定性分析可知,改进的U-Net较好地解决了“同谱异物”和“同物异谱”现象引起的误分类问题,可以在提升分类精度的同时,有效提高分类效率,为研究区内农林资源管理规划提供有力支撑。

【参 考 文 献】

[1]虞佳维,程志庆,张劲松,等.高光谱信息的农林植被种类区分[J].光谱学与光谱分析,2018,38(12):3890-3896.

YU J W, CHENG Z Q, ZHANG J S, et al. An approach to distinguishing between species of trees and crops based on hyperspectral information[J]. Spectroscopy and Spectral Analysis, 2018, 38(12): 3890-3896.

[2]ZHAO F C, WU X M, WANG S. Object-oriented vegetation classification method based on UAV and satellite image fusion[J]. Procedia Computer Science, 2020, 174: 609-615.

[3]FANG B, LI Y, ZHANG H K, et al. Collaborative learning of lightweight convolutional neural network and deep clustering for hyperspectral image semi-supervised classification with limited training samples[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2020, 161: 164-178.

[4]张波,牛婷,房世峰,等.荒漠-绿洲交错地带典型植被光谱特征研究[J].光谱学与光谱分析,2016,36(4):1104-1108.

ZHANG B, NIU T, FANG S F, et al. Research on the spectral characteristic of typical vegetation in desert-oasis crisscross zone[J]. Spectroscopy and Spectral Analysis, 2016, 36(4): 1104-1108.

[5]楊超,邬国锋,李清泉,等.植被遥感分类方法研究进展[J].地理与地理信息科学,2018,34(4):24-32.

YANG C, WU G F, LI Q Q, et al. Research progress on remote sensing classification of vegetation[J]. Geography and Geo-Information Science, 2018, 34(4): 24-32.

[6]张文博,孔金玲,杨园园,等.面向对象的旱区植被遥感精细分类研究[J].测绘科学,2021,46(1):136-140,183.

ZHANG W B, KONG J L, YANG Y Y, et al. Fine vegetation classification of remote sensing in arid areas based on object-oriented method[J]. Science of Surveying and Mapping, 2021, 46(1): 136-140, 183.

[7]魏立飞,余铭,钟燕飞,等.空-谱融合的条件随机场高光谱影像分类方法[J].测绘学报,2020,49(3):343-354.

WEI L F, YU M, ZHONG Y F, et al. Hyperspectral image classification method based on space-spectral fusion conditional random field[J]. Acta Geodaetica et Cartographica Sinica, 2020, 49(3): 343-354.

[8]张怡卓,徐苗苗,王小虎,等.残差网络分层融合的高光谱地物分类[J].光谱学与光谱分析,2019,39(11):3501-3507.

ZHANG Y Z, XU M M, WANG X H, et al. Hyperspectral image classification based on hierarchical fusion of residual networks[J]. Spectroscopy and Spectral Analysis, 2019, 39(11): 3501-3507.

[9]LU Y, QIN X J, FAN H Y, et al. WBC-Net: a white blood cell segmentation network based on UNet++ and ResNet[J]. Applied Soft Computing, 2021, 101: 107006.

[10]苏健民,杨岚心,景维鹏.基于U-Net的高分辨率遥感图像语义分割方法[J].计算机工程与应用,2019,55(7):207-213.

SU J M, YANG L X, JING W P. U-net based semantic segmentation method for high resolution remote sensing image[J]. Computer Engineering and Applications, 2019, 55(7): 207-213.

[11]BRAGAGNOLO L, DA SILVA R V, GRZYBOWSKI J M V. Amazon forest cover change mapping based on semantic segmentation by U-Nets[J]. Ecological Informatics, 2021, 62: 101279.

[12]ZHU H, MA M R, MA W P, et al. A spatial-channel progressive fusion ResNet for remote sensing classification[J]. Information Fusion, 2021, 70: 72-87.

[13]岑奕,张立福,张霞,等.雄安新区马蹄湾村航空高光谱遥感影像分类数据集[J].遥感学报,2020,24(11):1299-1306.

CEN Y, ZHANG L F, ZHANG X, et al. Aerial hyperspectral remote sensing classification dataset of Xiong’an New Area (Matiwan Village)[J]. Journal of Remote Sensing, 2020, 24(11): 1299-1306.

[14]ORTAC G, OZCAN G. Comparative study of hyperspectral image classification by multidimensional Convolutional Neural Network approaches to improve accuracy[J]. Expert Systems With Applications, 2021, 182: 115280.

[15]KULKARNI U, S M M, GURLAHOSUR S V, et al. Quantization friendly MobileNet (QF-MobileNet) architecture for vision based applications on embedded platforms[J]. Neural Networks, 2021, 136: 28-39.

[16]KC K, YIN Z D, WU M Y, et al. Depthwise separable convolution architectures for plant disease classification[J]. Computers and Electronics in Agriculture, 2019, 165: 104948.

[17]王明常,朱春宇,陳学业,等.基于FPN res-unet的高分辨率遥感影像建筑物变化检测[J].吉林大学学报(地球科学版),2021,51(1):296-306.

WANG M C, ZHU C Y, CHEN X Y, et al. Building change detection in high resolution remote sensing images based on FPN res-unet[J]. Journal of Jilin University (Earth Science Edition), 2021, 51(1): 296-306.

[18]岳振兴,岳彩荣,邹会敏.基于KPCA的AISA eagle Ⅱ机载高光谱数据的降维与树种识别[J].西部林业科学,2020,49(4):83-90.

YUE Z X, YUE C R, ZOU H M. Dimension reduction and tree species recognition of AISA eagle II airborne hyperspectral data based on KPCA[J]. Journal of West China Forestry Science, 2020, 49(4): 83-90.

[19]刘歆.基于遥感影像的土地资源利用区划自动识别技术[J].自动化技术与应用,2021,40(9):99-103.

LIU X. Automatic recognition technology of land resources division based on remote sensing image[J]. Techniques of Automation and Applications, 2021, 40(9): 99-103.

[20]RONNEBERGER O, FISCHER P, BROX T. U-net: convolutional networks for biomedical image segmentation[C]//Medical Image Computing and Computer-Assisted Intervention - MICCAI 2015, Munich, Germany, 2015:234-241.

[21] LIU S P, LI Y M, ZHOU J J, et al. Segmenting nailfold capillaries using an improved U-net network[J]. Microvascular Research, 2020, 130: 104011.

[22]杨晋生,杨雁南,李天骄.基于深度可分离卷积的交通标志识别算法[J].液晶与显示,2019,34(12):1191-1201.

YANG J S, YANG Y N, LI T J. Traffic sign recognition algorithm based on depthwise separable convolutions[J]. Chinese Journal of Liquid Crystals and Displays, 2019, 34(12): 1191-1201.

[23]刘浩,骆剑承,黄波,等.基于特征压缩激活unet网络的建筑物提取[J].地球信息科学学报,2019,21(11):1779-1789.

LIU H, LUO J C, HUANG B, et al. Building extraction based on SE-unet[J]. Journal of Geo-Information Science, 2019, 21(11): 1779-1789.

[24]DIAKOGIANNIS F I, WALDNER F, CACCETTA P, et al. ResUNet-a: a deep learning framework for semantic segmentation of remotely sensed data[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2020, 162: 94-114.