基于多尺度小波U型网络的低光照图像增强

2022-04-25马璐

马 璐

(宿州职业技术学院计算机信息系,安徽 宿州 234000)

0 引言

通常,成像系统为了提高低光照场景的图像照度需要延长曝光时间,这不仅需要保证成像系统的平稳性,还降低了图像采集的实时性,并且含有较多的噪声。实时采集低光照环境的图像存在照度偏暗、部分内容难以辨识等问题(该类图像通常被称为低光照图像),甚至极低光照环境的图像照度非常低,以至于图像全局内容难以依靠人眼视觉进行分辨,并且存在严重噪声(该类图像通常被称为极低光照图像)。而低光照图像增强算法[1-3]可以通过图像后期处理提高图像亮度,降低硬件设备升级成本,具有较好的应用价值

当前,低光照图像增强主要包括基于直方图均衡化的方法、基于Retinex 的方法和基于深度学习的方法[1]。基于直方图均衡化的方法通过调整不同灰度值的像素来达到图像直方图分布均匀,并将这种映射关系作为图像增强函数。例如,Ibrahim 等人[4]提出亮度保持的动态直方图均衡化,根据局部最大值为不同分区的直方图分配新的动态范围,再分别进行直方图均衡化。但是,该方法引入大量噪声,并且非低光照区域出现亮度饱和现象。基于Retinex 的方法假设图像是由受光照影响的照度分量和依赖于物质属性的反射分量所合成,从而将低光照图像增强转化为其反射分量的计算,如单尺度Retinex[5]和多尺度Retinex[6]。但是该类方法容易丢失纹理细节信息,生成的图像照度存在失真甚至过曝光。虽然文献[7-9]通过改进照度分量的约束提高了光照的自然度,但色彩失真和噪声问题仍然比较显著。基于深度学习的方法依赖于先验数据信息,通过大量的先验图像数据集对构建的学习模型进行训练,学习低光照到正常光照的映射关系。Lore 等人[10]搭建了深度卷积网络进行图像对比度增强和去噪。而后,Shen 等人[11]结合多尺度Retinex 方法提出多尺度Retinex 网络,通过多尺度对数变换和卷积差分直接学习低光照与高光照图像间的映射。Wei 等人[12]提出了Retinex 卷积网络,利用卷积网络模拟反射分量和照度分量的分解。基于深度学习的方法能够生成亮度自然和色彩保真度高的图像,并且具有较好的去噪效果。但是,现有方法将低频光照映射和高频噪声去除进行同步学习,导致图像纹理细节丢失严重。并且,低光照图像和正常光照图像存在显著差异,其高分辨率特征间的相关性较小,造成网络训练收敛较慢和波动较大,最终影响低光照图像增强的质量。

为了提高低光照图像增强质量,本文提出一种基于多尺度小波U 型网络的低光照图像增强方法。考虑到低光照图像含有大量噪声,本文构建了一种小波U型网络,引入离散小波变换构建特征分频单元,分离低频照度特征和高频纹理特征,增强网络对低频照度特征和高频纹理信息的感知,有效抑制噪声和增强纹理细节。此外,构建多尺度感知损失函数,通过约束不同尺度图像的损失增强低光照和高光照图像间特征的相关性,指导网络从低频的照度和色彩信息到高频的纹理信息的逐级重建,加快和优化小波U 型网络的收敛。

1 多尺度小波U 型网络

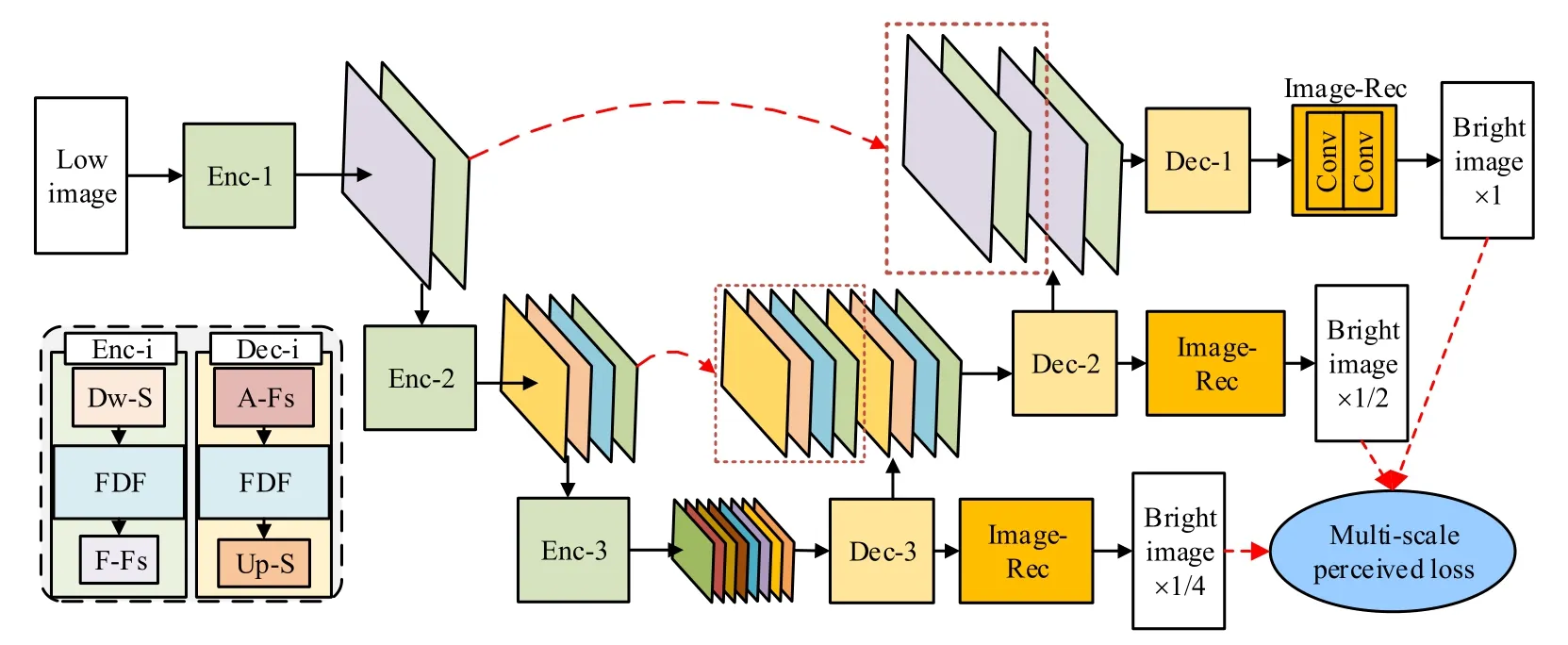

本文提出一种基于多尺度小波U 型网络用于低光照图像增强,其网络架构与图像处理流程如图1所示。该网络包括多级编码器(Enc)、解码器(Dec)和图像重建层(image reconstruction,image-Rec)。编码器由下采样单元(down-sampling,Dw-S)、特征分频单元(frequency decomposition of features,FDF)和特征融合单元(feature fusion,F-Fs)组成,而解码器由特征注意力融合单元(attention fusion,A-Fs)、特征分频单元和上采样模块(Up-Sampling,Up-S)组成。小波U 型网络采用多尺度感知损失函数(Multi-scale perceived loss)约束训练过程,分别对U 型网络中不同尺度的增强图像计算其损失值,包括L1 损失、结构损失和内容损失。

图1 多尺度小波U 型网络结构Fig.1 The architecture of multi-scale wavelet U-shaped network

输入图像先经过多级编码器进行编码,每级编码器分别对上一级的输出特征进行特征下采样、特征分频推理和特征融合;然后通过多级解码器进行解码,特征注意力融合单元采用通道注意力机制将同级编码器和前级解码器的输出特征进行融合,再依次进行特征分频推理和上采样重建高分辨率信息;最后利用由两个卷积层(Conv)级联而成的图像重建层将解码器的输出特征重建为RGB 图像。

1.1 基于特征分频的编码器和解码器

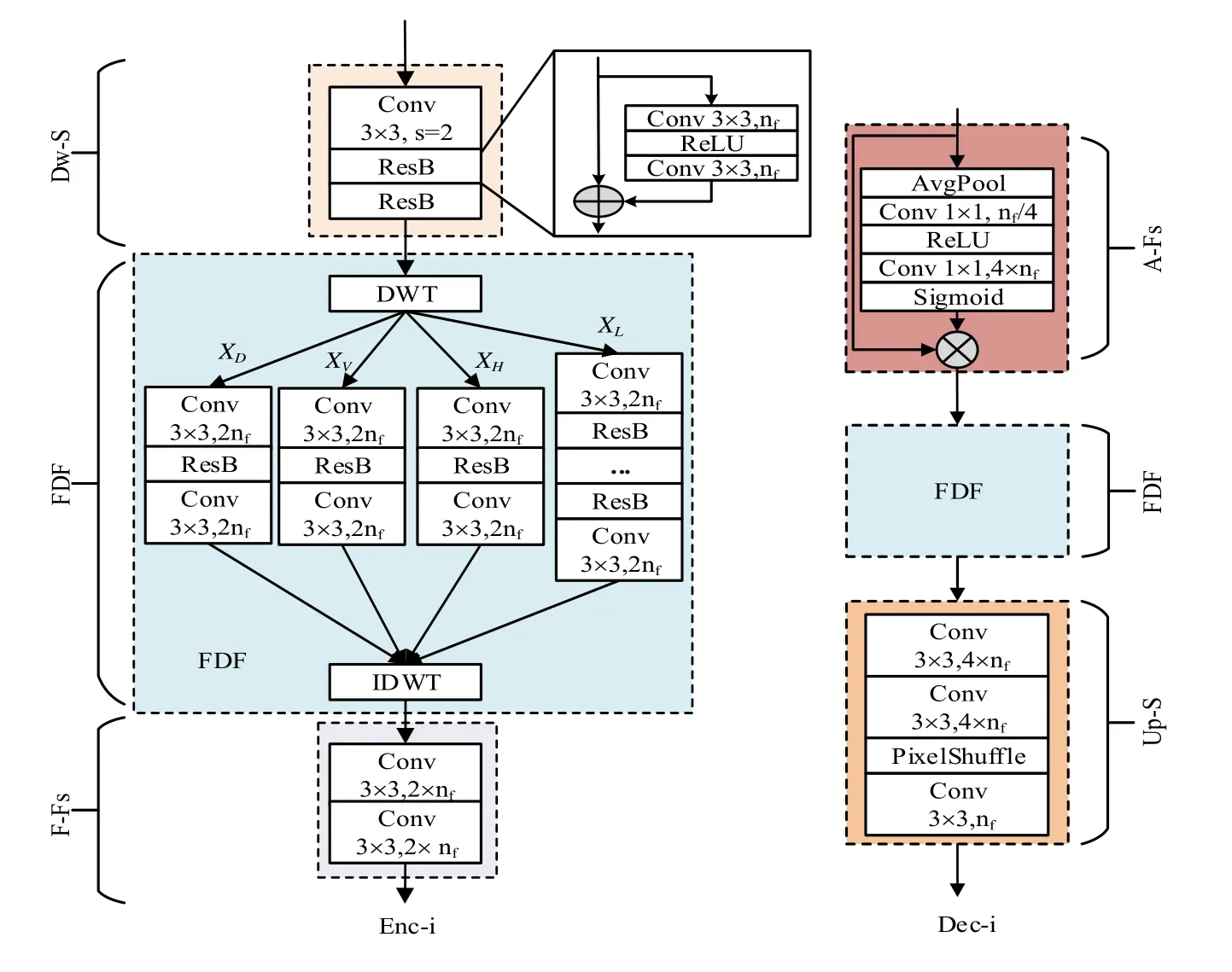

由于低光照图像含有大量噪声,因此图像去噪是低光照图像增强任务面临的重要问题之一。常见的基于深度学习的低光照图像增强方法对亮度增强和去噪并不加以区分,直接通过深度卷积网络学习低光照图像和参考图像间的映射关系[10-11]。但是,噪声作为一种高频信息则会干扰图像高频纹理细节的保持,导致去噪的同时丢失了大量纹理信息。而小波变换能够分解图像高频信息和低频信息,被广泛应用于图像去噪。因此,本文提出一种基于小波变换的特征分频推理单元,并联合下采样、特征融合、注意力融合和上采样模块组成基于特征分频的编码器和解码器,具体结构如图2所示。

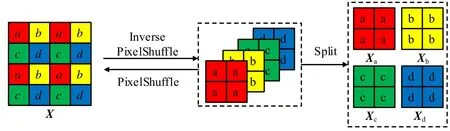

如图2所示,下采样层由一个卷积核为3×3、步长为2 的卷积层(Conv 3×3,s=2)和两个残差块(ResB)组成,它对编码器的输入信息进行下采样;而解码器的输入为上一级解码器的输出特征和同级编码器的输出特征,它们具有不同的感受野且对图像增强的贡献并不相同,因此注意力融合单元采用通道注意力融合方法[13]对这些特征进行自适应加权融合。在通道注意力融合方法中,均值池化层×(Avg Pool)、2 个卷积核为1×1 的卷积层、ReLU 激活层和Sigmoid层级联生成各特征通道的权值,这些权值与各通道特征相乘得到通道注意力特征,从而提高较大贡献的特征响应。编码器的尾端是由两个卷积层组成的特征融合层,对特征分频的高频信息和低频信息进行融合;解码器的尾端是对特征进行2 倍尺度因子的上采样,而上采样模块使用高效的Pixel Shuffle 方法[14]进行上采样计算,先由两个卷积层生成通道数为4×nf的特征,再通过将不同通道特征中的相同空间位置像素进行嵌入排列得到通道数为nf的上采样特征,其示意图如图3所示。

图2 基于特征分频的编码器(左)和解码器(右)Fig.2 Encoder (left) and decoder (right) based on frequency decomposition of features

图3 Pixel Shuffle 和逆Pixel Shuffle 方法示意图Fig.3 Schematic diagram of Pixel Shuffle and inverse Pixel Shuffle method

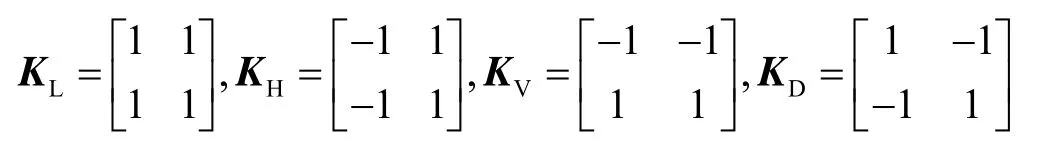

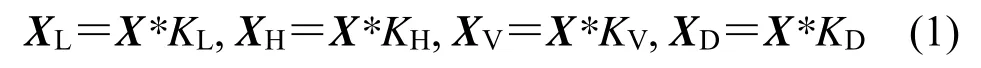

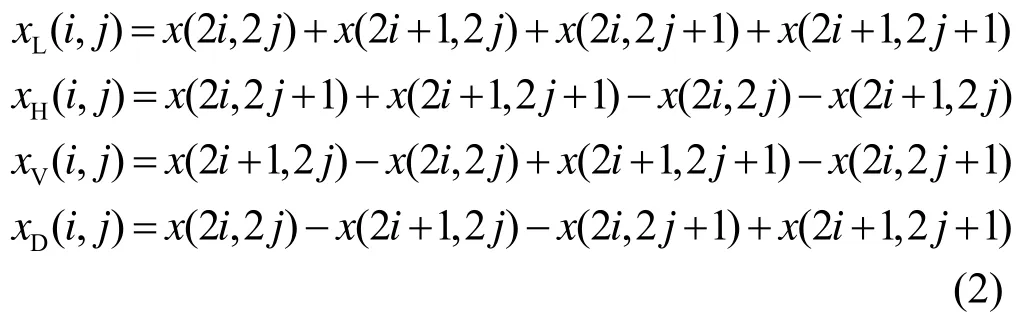

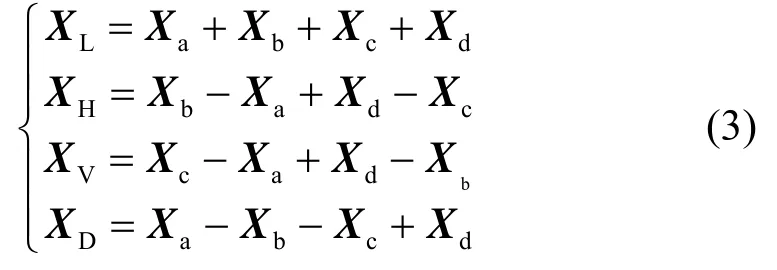

特征分频单元是编码器和解码器进行特征推理计算的核心组成部分,主要包括离散小波变换(DWT)、逆离散小波变换(IDWT)以及卷积层和残差块级联组成的推理层。根据二维Haar 小波变换可知,输入特征X被分解为低频特征XL、水平方向高频特征XH、垂直方向高频特征XV和对角方向高频特征XD,对应的滤波器为:

则各小波分量可表示为:

式中:*表示卷积计算。由公式(1)可知,XL,XH,XV和XD中在(i,j)位置的响应值为:

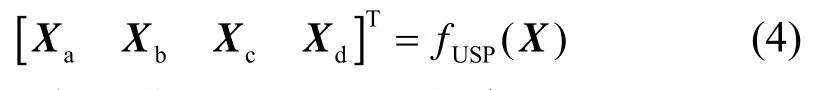

式中:x(2i,2j)表示X在(2i,2j)位置的响应值,且0≤2i<h,0≤2j<w(h和w为X的高和宽)。根据公式(2),XL,XH,XV和XD可进一步表示为:

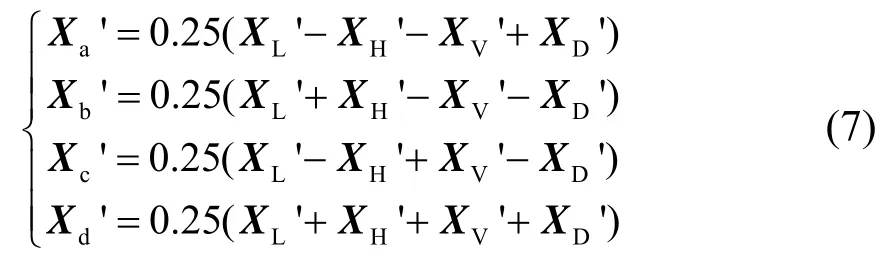

式中:Xa是对X中的偶数行和偶数列进行采样得到;Xb是对X的偶数行和奇数列采样得到;Xc是对X的奇数行和偶数列采样得到;Xd是对X的奇数行和奇数列采样得到。Xa、Xb、Xc和Xd的具体采样操作如图3所示,该采样方法与Pixel Shuffle 上采样方法相反,因此可以采用逆Pixel Shuffle 方法对X进行采样,并将采样结果分解为Xa、Xb、Xc和Xd,计算公式可表示为:

式中:fUPS(·)表示逆Pixel Shuffle 方法。

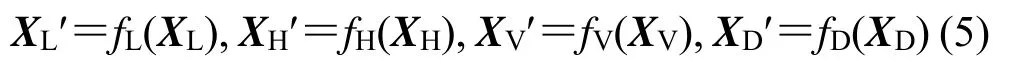

通过公式(3)和(4)可计算得XL,XH,XV和XD。接着,将XL,XH,XV和XD通过特征分频单元的推理层进一步进行特征卷积计算。该推理层由两个卷积层和若干个残差块组成,如图2所示,其公式可表示为:

式中:fL(·),fH(·),fV(·)和fD(·)分别为XL,XH,XV和XD对应推理层的卷积计算。由于XH,XV和XD为仅含有纹理细节特征的高频分量,信息量较少,因此它们的推理层采用1 个残差块。而XL含有照度、颜色和大量低频结构的信息,信息量较大,因此其推理层采用32 个残差块。最后XL',XH',XV'和XD'通过IDWT进行重建。根据公式(3)和(4)可知,IDWT 可表示为:

式中:fPS(·)表示Pixel Shuffle 方法,Xa'、Xb'、Xc'和Xd'为:

特征分频推理单元引入小波变换将输入特征分解为低频分量和不同方向的高频分量。低频分量包括图像的照度特征、颜色信息等低频信息,而高频分量则只含有输入特征的边缘纹理信息。高频信息与低频信息的分离减少了显著变化的低频照度特征对变化不明显的高频纹理特征的干扰,使网络在进行学习时能够更好地感知图像的纹理细节特征,从而提高增强图像中纹理细节的清晰度。同时,被分离的低频信息减少了对高频纹理信息的特征表示,从而优化照度和颜色等低频信息的映射关系,提高增强图像照度和颜色信息的视觉效果。

1.2 多尺度感知损失函数

在图像超分辨率重建中,大尺度因子的图像超分辨率任务可通过若干个小尺度因子的图像超分辨率任务级联完成,并且其效果优于大尺度因子的图像超分辨率[15]。基于此,本文提出一种多尺度感知损失函数,分别对不同尺度的增强图像进行约束,从而实现对增强图像从低频信息到高频信息的逐级重建。此外,低分辨率图像移除了部分高频信息,不仅有效抑制噪声,并且简化亮度和颜色等低频信息的映射关系,从而加快网络的收敛。

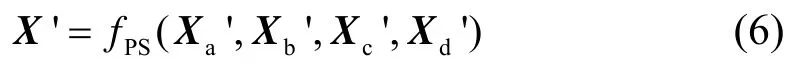

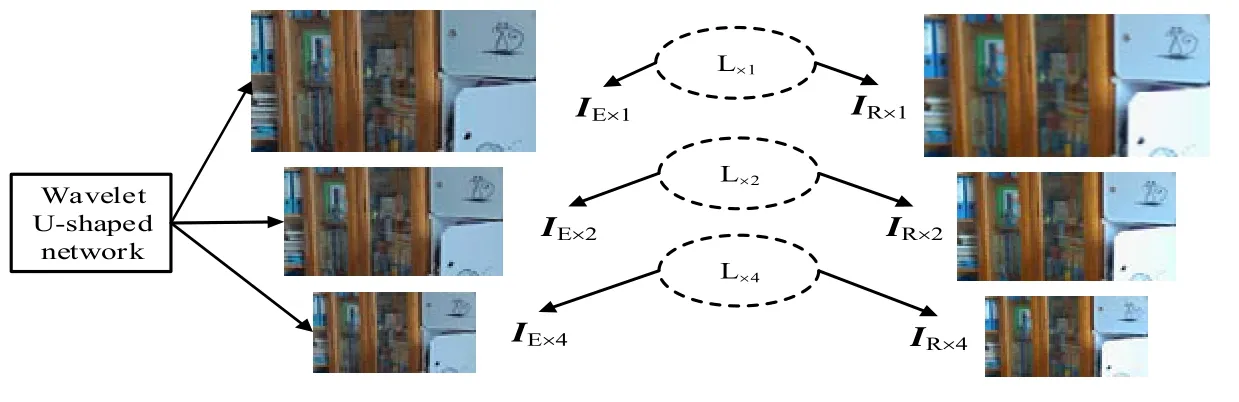

多尺度感知损失Lt由3 个尺度图像的损失组成:L×1、L×2和L×4,其中每个尺度图像的损失是L1 损失、结构损失和内容损失的加权和,Lt的示意图如图4所示。

如图4所示,IE×1、IE×2和IE×4为小波U 型网络生成的3 种不同分辨率的图像,IR×1、IR×2和IR×4分别为高光照参考图像及其2 倍和4 倍下采样图像,L×1、L×2和L×4则分别表示这3 种不同尺度下所计算的小波U型网络损失。通常,高分辨率图像相比于其低分辨率图像含有更多高频纹理信息,而颜色、照度等低频信息则基本相同,因此高分辨率图像可表示:

图4 多尺度感知损失示意图Fig.4 Schematic diagram of multi-scale perceived loss

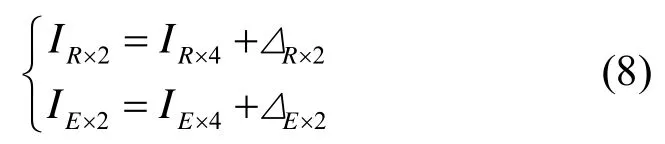

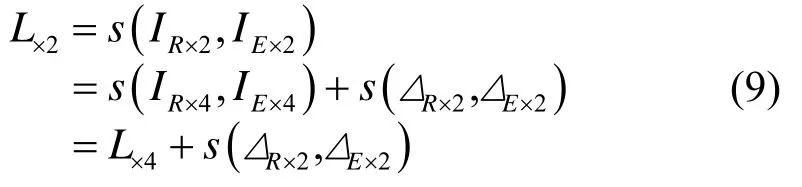

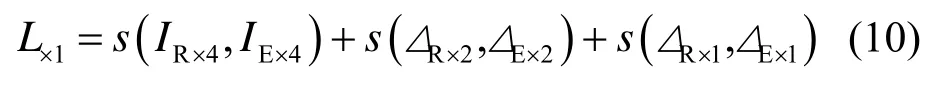

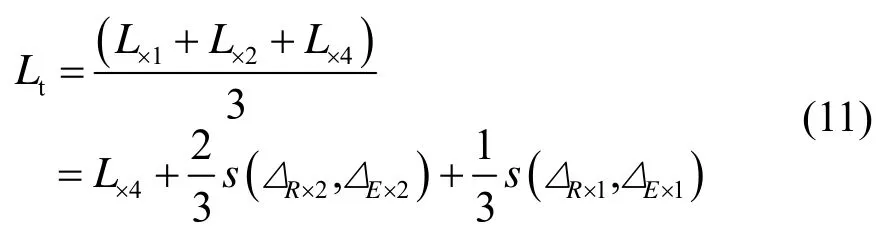

式中:ΔR×2和ΔE×2分别表示IR×2和IE×2相对于IR×4和IE×4所多余的高频信息。根据公式(8),L×2可表示为:

式中:s(·)表示计算两张图像的距离。同理:

式中:ΔR×1和ΔE×1表示IR×1和IE×1相对于IR×2和IE×2所多余的高频信息。

由公式(9)和(10)可知,大尺度图像的损失函数对网络学习的约束比小尺度图像的损失函数更严格。但是,直接采用大尺度图像的损失函数会导致高频噪声干扰网络学习对纹理的感知能力,并且高维度的图像特征间含有较多弱相关性的冗余信息,导致网络收敛困难。因此,本文以照度增强和纹理重建的优先级顺序设计多尺度损失函数Lt:

根据公式(11)可知,L×4具有最高权重,表示Lt对低频信息的感知最强,从而驱动网络模型优先学习图像低频信息的重建,即图像照度增强,并避免了高频噪声的干扰。其次,和项则表示网络模型对图像纹理信息逐级重建,而文献[15]则证明了小尺度逐级重建高频纹理的方式优于大尺度直接重建的方式。

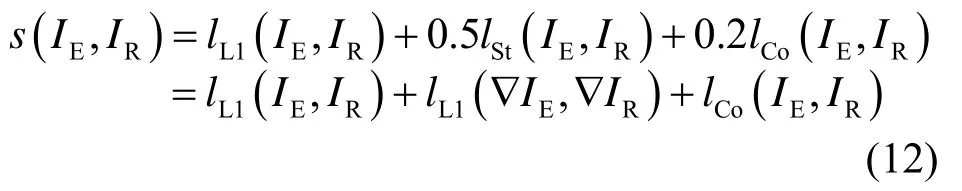

此外,s(IE,IR)表示为:

式中:IE和IR表示增强图像和高光照参考图像;∇表示计算梯度图;lL1(·) 表示L1 损失;lCo(·) 表示内容损失,此处采用文献[16]中的内容损失函数,而结构损失lSt(·)表示计算两张图像梯度图的L1 损失。

2 实验与分析

2.1 实验配置

实验平台为搭载Intel Core i7-7800X CPU,32 G 内存,GTX 1080Ti 显卡和Windows 7 系统的计算机,实验主要使用 MATLAB R2014a 仿真软件以及Tensorflow 1.10 和Pytorch 1.1 深度学习框架。为了学习低光照图像增强的特征映射关系,采用低光照数据集(low-light dataset,LOL)[12]作为训练集,其中包括485 对低光照和相应的高光照图像用于网络的训练,15对极低光照和正常光照的室内图像用于网络的测试。此外,测试数据集还包括低光照图像增强数据集(lowlight image enhancement,LIME)[9]、自然保护增强算法数据集(naturalness preserved enhancement,NPE)[7]、多曝光融合算法数据集(multi-exposure fusion,MEF)[17]、商业相机数字图像(digital images of commercial measures,DICM)[18]和来自Vassilios Vonikakis 的多曝光数据集(VV),它们共计101 张低光照图像,分别存在室内灯光、户外遮挡光照、阴雨天、日落和夜晚等原因所导致的低光照问题。峰值信噪比(peak signal to noise ratio,PSNR)、结构相似度(structural similarity,SSIM)和亮度顺序误差(lightness order error,LOE)[19]和自然图像质量评价(natural image quality evaluator,NIQE)[20]图像质量评价方法被用于增强图像的客观评价,其中PSNR、SSIM、LOE 为全参考评价方法,NIQE 为无参考评价方法。并且,所评价图像的质量越好,PSNR 和SSIM 的数值则越大,而LOE和NIQE 的数值则越小。

2.2 客观评价的比较和分析

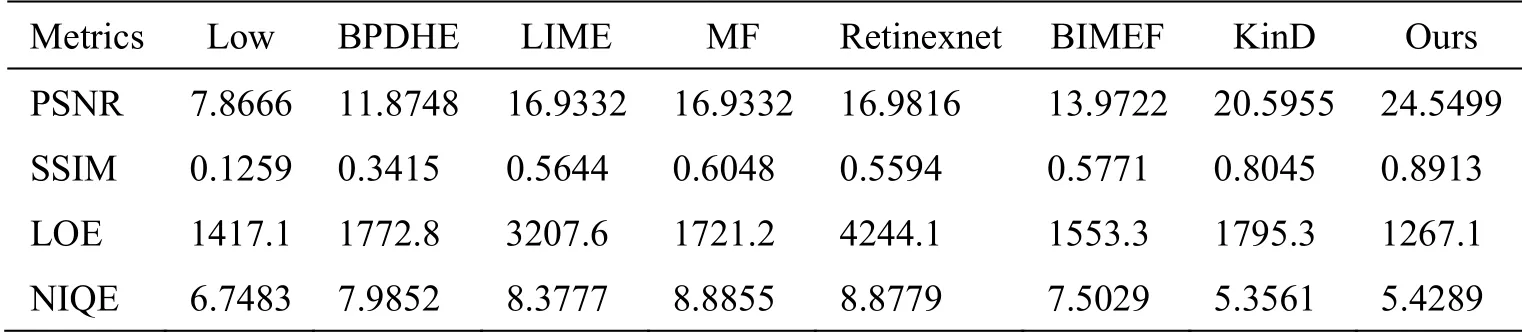

为了验证本文算法的性能,本文分别采用BPDHE[4]、LIME[9]、MF[21]、Retinexnet[12]、BIMEF[22]和KinD[23]作为对比低光照增强方法,其中BPDHE 为基于直方图均衡的方法,LIME、MF 为基于Retinex的方法,BIMEF 方法在Retinex 基础上引入相机模型,Retinexnet 和KinD 为基于深度学习的方法。6 种对比方法和本文方法在LOL 数据集上的客观评价结果如表1所示,Low 表示原始低光照图像的评价结果。

根据表1可知,本文方法在全参考图像质量评价PSNR、SSIM 和LOE 上取的结果最优,且相对其他方法提高显著,说明增强图像更接近正常光照图像,图像纹理保持较好,图像亮度与参考图像亮度间的相似性也有所提高。而在无参考图像质量评价指标NIQE 上也取得次优结果,且与最优方法KinD 的结果非常接近,说明增强图像引入较少噪声,亮度和颜色的自然度较好。而基于直方图均衡的方法BPDHE取得较差的PSNR 和SSIM 结果,但LOE 和NIQE 评价结果整体优于基于Retinex 的方法LIME 和MF,因此BPDHE 虽然丢失了大量的图像纹理细节,但图像亮度有所增强且颜色保持较好。基于Retinex 的方法LIME 和MF 相对BPDHE 在PSNR 和SSIM 评价上取得显著提高,增强图像纹理结构信息保持较好,但图像色彩和亮度的失真以及噪声的引入导致LOE 和NIQE 评价较差,而BIMEF 性能相比于基于直方图均衡的方法和基于Retinex 的方法取得较折中的性能。针对基于深度学习的方法 Retinexnet 和 KinD,Retinexnet 虽然使用深度卷积网络实现低光照图像增强,但性能与基于Retinex 的方法不相上下,KinD 方法则在PSNR、SSIM 和NIQE 评价上取得显著提高,说明图像纹理保持较好且图像色彩和亮度的自然度也有所提高,整体图像增强性能提高。

表1 不同低光照增强算法在LOL 数据集上的结果Table 1 Results of different low light enhancement algorithms on LOL dataset

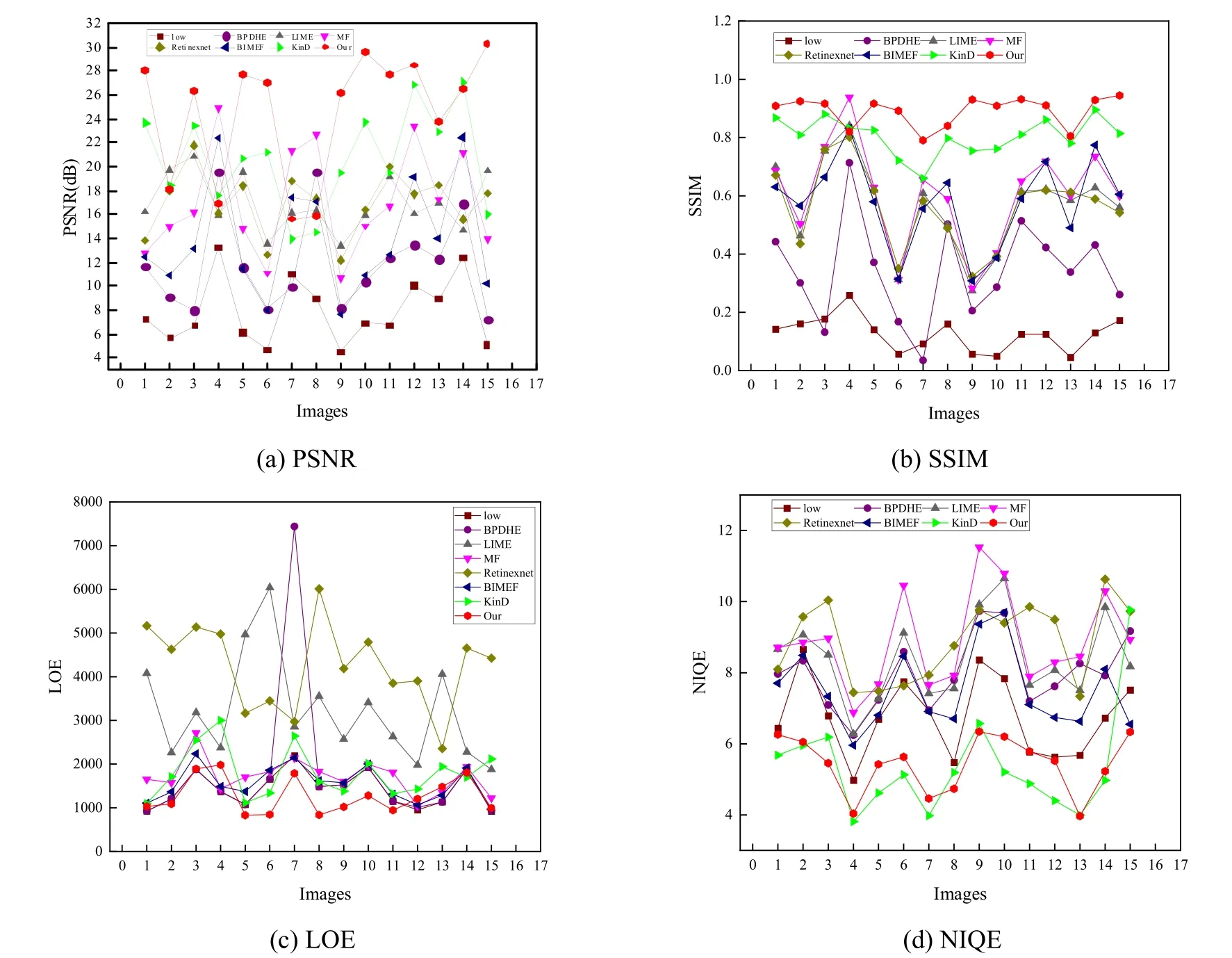

为了更直观和详细地比较这些方法对于单张图像的增强效果,LOL 中15 张图像的PSNR、SSIM、LOE 和NIQE 评价结果如图5所示。从图中可以看到,大部分图像取得最佳PSNR 和SSIM 评价,说明增强图像在全局像素和纹理增强方面提高显著;而LOE 评价也说明大部分增强图像的亮度信息在一定程度上也得到改善;在NIQE 评价方面,本文方法则与KinD 方法不相上下,并且它们显著优于其他方法。此外,一些图像虽然在部分评价上表现较差(如第4、7 和8 张图像),但在其他评价指标上则表现较好,因此这些图像质量在整体上也获得提高。

图5 LOL 数据集的单张图像客观评价结果Fig.5 Objective evaluation results of single image in LOL dataset

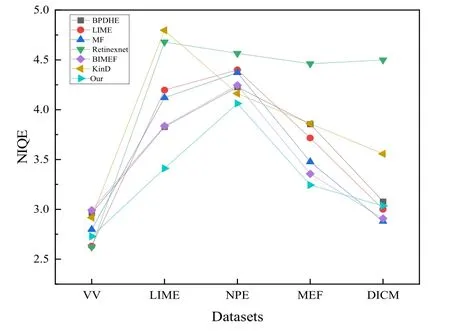

为了进一步验证所提方法的有效性,在VV、LIME、NPE、MEF 和DICM 数据集上进行测试和比较,并计算各对比方法的NIQE 评价指标,结果如图6所示。

图6 不同方法在多个数据集上的图像增强结果Fig.6 Image enhancement results of different methods on multiple datasets

根据图6可知,本文方法在LIME、NPE 和MEF数据集上取得最佳评价,并且在VV 和DICM 数据集上也取的具有竞争力的评价结果。因此本文方法能够有效增强低光照图像,生成的增强图像具有较好的自然度和清晰度,噪声相对较少。

2.3 主观评价的比较和分析

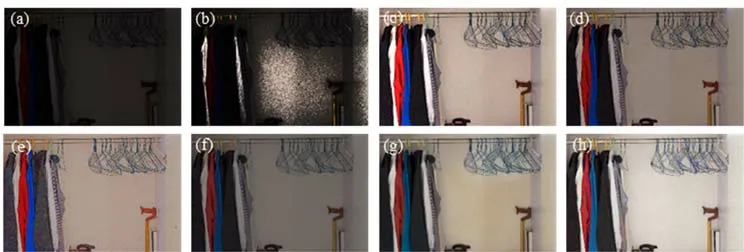

考虑到NIQE 评价指标偏向于对图像自然度、清晰度和噪声情况的评价,并易受图像照度影响而产生误差,因此实验提供部分增强图像的可视化结果,从而更直观地比较各对比方法的性能,可视化结果如图7~图9所示。从图中可以看到,BPDHE 方法亮度增强效果并不明显,甚至出现局部过亮现象,如图7增强结果中背景墙;LIME 方法的图像增强效果比较明显,但色彩过于饱和导致图像自然度下降,如图8中衣服的红色和人脸的肤色;MF 一定程度上缓解了色彩过于饱和的问题,但整体亮度有所下降,如图7的背景墙、图8的前景物体和背景湖面;Retinexnet 不仅加剧了色彩过度饱和问题,还产生大量噪声,如图8色彩过度饱和及图9中引入大量噪声;BIMEF 相对于MF 方法增强图像的亮度进一步下降,但噪声的显著性有所降低。而KinD 方法在图像亮度增强和噪声抑制方面表现都比较好,但色彩饱和度偏低且亮度有些偏暗,如图7中白色墙壁和红色衣服的色彩饱和度偏低,图8和图9整体亮度偏暗。本文方法不仅抑制了颜色过饱和的问题,并且在保证纹理信息的同时有效提高了图像亮度,如图7的红色衣服和白色墙壁、图8的肤色和全局亮度以及图9的夜空和全局亮度,这些增强图像相对其他方法的结果具有更佳的视觉效果。

图7 LOL 数据集中的146.png 图像增强结果:(a) Low;(b) BPDHE;(c) LIME;(d) MF;(e) Retinexnet;(f) BIMEF;(g) KinD;(h) OursFig.7 Enhancement results of “146.png” in LOL dataset:(a) Low;(b) BPDHE;(c) LIME;(d) MF;(e) Retinexnet;(f) BIMEF;(g) KinD;(h) Ours

图8 VV 数据集中的P1020044.jpg 图像增强结果:(a) Low;(b) BPDHE;(c) LIME;(d) MF;(e) Retinexnet;(f) BIMEF;(g) KinD;(h) OursFig.8 Enhancement results of “p1020044.jpg” in VV dataset:(a) Low;(b) BPDHE;(c) LIME;(d) MF;(e) Retinexnet;(f) BIMEF;(g) KinD;(h) Ours

图9 LIME 数据集10.bmp 图像增强结果:(a) Low;(b) BPDHE;(c) LIME;(d) MF;(e) Retinexnet;(f) BIMEF;(g) KinD;(h) OursFig.9 Enhancement results of “10.bmp” in LIME dataset:(a) Low;(b) BPDHE;(c) LIME;(d) MF;(e) Retinexnet;(f) BIMEF;(g) KinD;(h) Ours

总体来看,在客观评价方面,本文方法能够获得最佳的PSNR、SSIM 和LOE 评价结果,分别相比于次优结果高约16%、9%和22%,而在多个测试数据集上,本文方法也取得整体上最优的NIQE 评价结果。主观评价上,本文方法能够显著提高图像亮度,充分保持图像纹理细节信息,并有效抑制颜色过饱和及噪声问题,图像整体视觉效果最佳。

2.4 消融实验

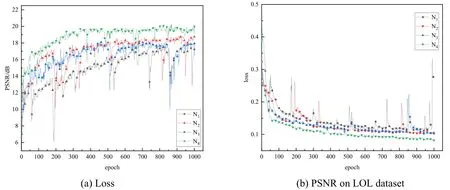

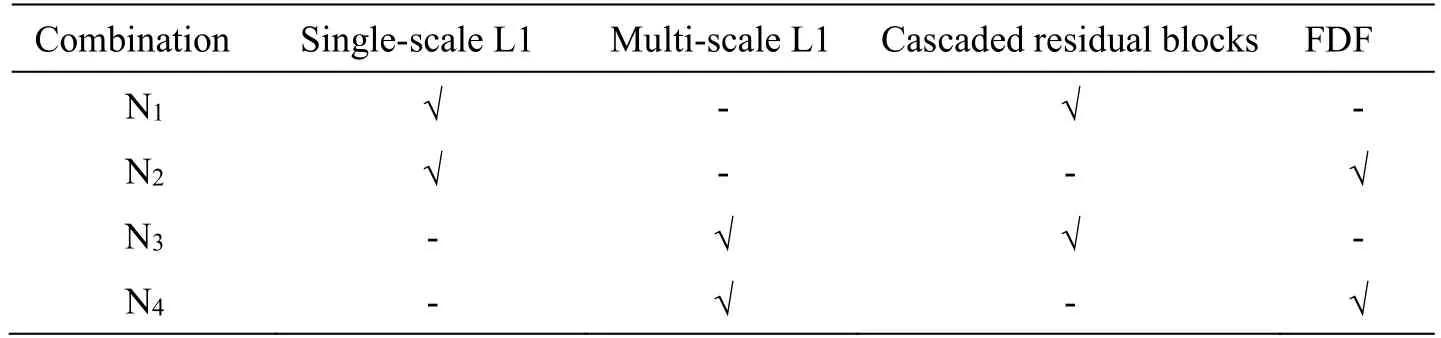

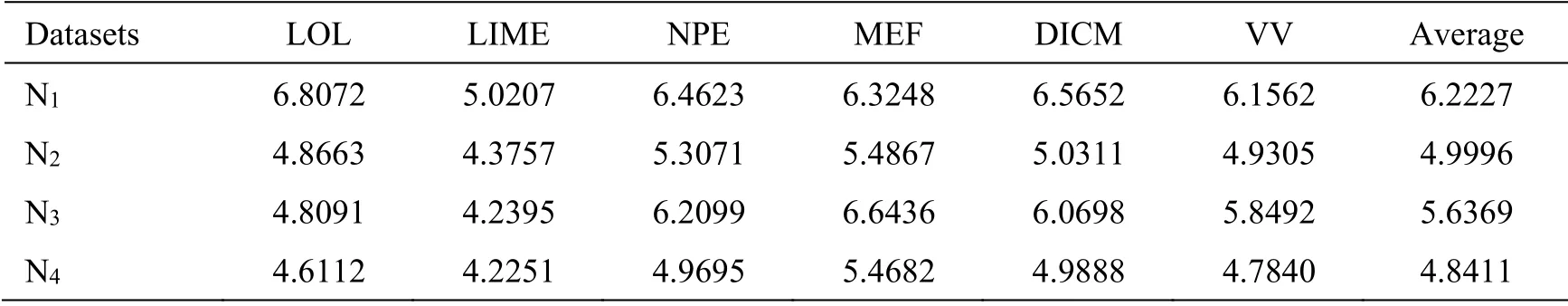

为了验证特征分频和多尺度感知损失函数的有效性,本文设置编/解码器的推理层可选择为特征分频单元和残差块级联,损失函数设置为单尺度感知L1损失函数和多尺度感知L1 损失函数。同时,为了减小训练时间成本,设置网络的特征通道数减半,分频单元中残差块数减半,其它设置与3.2 节模型一致。不同组合的网络可分别记为N1、N2、N3和N4,如表2所示。N1、N2、N3和N4的训练过程如图10所示,其中图10(a)为训练过程中损失值的曲线,图10(b)为每个epoch 所训练的网络在LOL 数据集上进行测试的PSNR 值曲线。N1、N2、N3和N4网络分别在LOL、LIME、NPE、MEF、DICM 和VV 数据集上进行测试,并计算增强图像的NIQE 评价指标,结果如表3所示。

图10 四种不同组合配置的网络训练过程Fig.10 Training process of 4 networks with different configurations

表2 不同网络的编/解码器和损失函数的配置Table 2 Configuration of codecs and loss function for different networks

由图10可知,在单尺度损失函数下,N2前期收敛速度快于N1,最终收敛结果优于N1,并且N2在验证集LOL 上的PSNR 值显著高于N1;在多尺度损失函数下,N4的损失函数前期收敛效率和最终收敛结果都优于N3,且N4在验证集LOL 上的PSNR 值也显著高于N3。同时,根据表3可知,相比于N1和N3网络,N2和N4网络生成的增强图像在NIQE 评价指标方面分别平均下降约1.22 和0.80。由此可见,特征分频能够加速网络前期的收敛,优化网络收敛和增强网络的性能。

表3 不同组合网络的性能比较Table 3 Performance comparison of different combination networks

为了验证多尺度感知损失函数的优越性,分别将单尺度损失函数和多尺度感知损失函数应用于残差块级联和特征分频两种网络的训练过程。由图10可知,在残差块级联的网络方面,N3在前期的收敛速度快于N1网络,其最终的收敛效果和验证集的PSNR 值略优于N1;在特征分频的网络方面,N4网络相比于N2网络在前期训练收敛更快且最终收敛效果和平稳性更好,同时N4在验证集上的PSNR 值取得显著提高。此外,根据表3中LOL、LIME、NPE、MEF、DICM 和VV 测试数据集的NIQE 评价结果可知,N3和N4网络相比于N1和N2网络分别平均下降约0.5859和0.1584。由此可见,多尺度感知损失函数不仅能够加速和优化网络的收敛,还在一定程度上提高了网络性能。

2.5 真实低光照图像增强

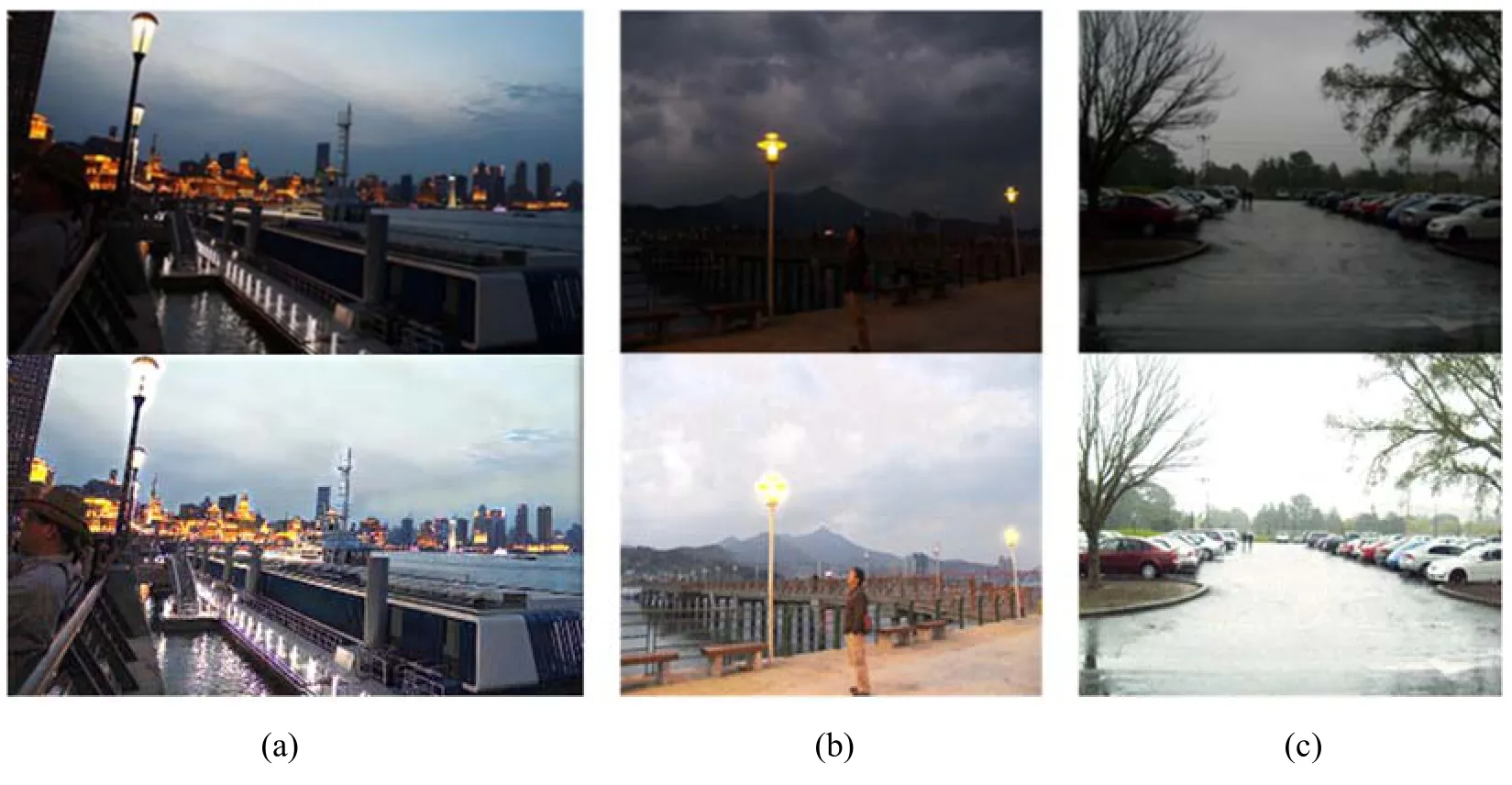

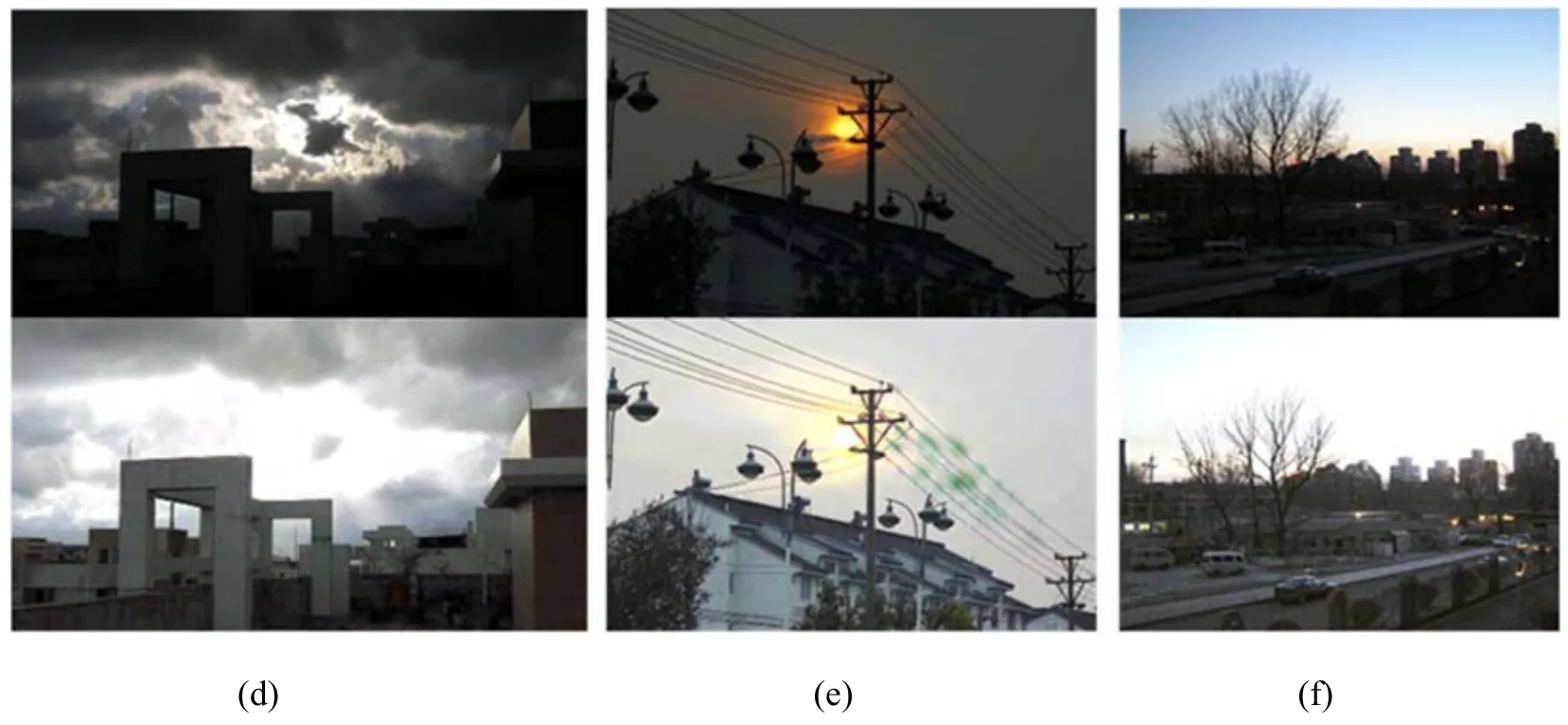

为了验证本文方法对于真实图像的有效性,本文采集了6 张不同低光照场景的图像,包括夜晚场景、阴雨天、早晨和傍晚场景,并对这6 张真实低光照图像进行测试,结果如图11所示。从图11中可以看出,低光照图像的照度被明显提高,视觉显著性和视觉效果都获得明显的提升。并且,所提方法对夜晚和阴雨天场景的低光照图像效果更佳,色彩和纹理保持都比较好。而对于早晨或傍晚场景,所提方法能够有效增强暗光区域的照度,且色彩保持较好,而明亮区域会出现轻微的过曝光现象。

图11 真实低光照图像增强结果:其中(a)和(b)为夜晚场景,(c)和(d)为阴雨天场景,(e)和(f)为早晨或傍晚场景Fig.11 The results of real low-light image enhancement,where (a) and (b) are night scenes,(c) and (d) are overcast and rainy scenes,and(e) and (f) are morning or evening scenes

总体而言,本文方法能够有效增强夜晚、阴雨天、早晨或傍晚等不同场景的低光照图像,提高图像视觉显著性和视觉效果。

3 结论

针对成像系统对低光照环境图像实时成像结果中存在的照度低和噪声多的特点,本文提出了一种基于多尺度小波U 型网络的低光照图像增强方法。该方法采用由多级编码器和解码器组成的U 型网络,并引入小波变换构建特征分频单元以用于编码器和解码器的特征推理,从而分离高频纹理信息和低频照度信息,减小高频纹理重建和去噪及低频照度增强的互相干扰。此外,采用多尺度感知损失函数指导小波U 型网络进行训练,实现由低频到高频信息的逐级重建。本文方法分别在LOL、LIME、NPE、MEF、DICM 和VV 数据集上进行测试,实验结果表明,所提方法能够有效增强图像照度,其客观评价指标PSNR、SSIM和LOE 分别比其他算法的次优结果高16%、9%和22%,主观视觉效果上有效抑制色彩过度饱和、图像噪声和纹理丢失问题。并且,消融实验表明了特征分频和多尺度感知损失函数加速了网络前期收敛,提高了网络收敛效果和性能。