基于Mask R-CNN深度学习的羊绒羊毛纤维识别技术

2022-03-29从明芳李子印卢鸯韩高锋谢凌佳王启真

从明芳 李子印 卢鸯 韩高锋 谢凌佳 王启真

摘 要:为提高羊绒羊毛纤维定量的自动化程度,引入基于掩模区域卷积神经网络(Mask R-CNN)深度学习技术,对通过光学显微镜采集的图片进行图片处理、算法模型优化,以及学习和训练,建立起山羊绒和绵羊毛的自动识别模型。采用测试集对所建立的模型进行了验证测试,结果表明,对山羊绒和绵羊毛纤维的自动识别正确率达到95%以上,证实了所建立的识别技术的可行性。

关键词:山羊绒;绵羊毛;图像处理;深度学习;Mask R-CNN

中图分类号:TS102.3

文献标志码:A

文章编号:1009-265X(2022)02-0036-05

Recognition technology of cashmere and wool fibers based onmask R-CNN deep learning

CONG Mingfang1, LI Ziyin2, LU Yang1, HAN Gaofeng1,XIE Lingjia1, WANG Qizhen2

(1.Zhejiang Light Industrial Products Inspection and Research Institute, Hangzhou 310018, China;

2.College of Optical and Electronic Technology, China Jiliang University, Hangzhou 310018, China)

Abstract: To enhance the level of automation for wool fiber quantification, the mask R-CNN deep learning technology was introduced for the processing of the pictures collected by the optical microscope, optimization of algorithm model, learning and training. An automatic recognition model of cashmere and sheep wool was established. Through the verification test using a test set, it was found that the accuracy of automatic recognition of cashmere and sheep wool fibers reached more than 95%, confirming the feasibility of the recognition technology developed in this paper.

Key words: cashmere; sheep wool; image processing; deep learning; mask R-CNN

收稿日期:20210402 网络出版日期:20210804

基金项目:国家市场监督管理总局科技计划项目(2019MK031)

作者简介:从明芳(1986-),女,浙江杭州人,工程师,硕士,主要从事纺织品检测方面的研究。

通信作者:卢鸯,E-mail:69270913@qq.com

山羊绒纤维因条干均匀、手感柔滑、表面光泽好,被誉为“纤维之王”,素有“软黄金”之美称,由于产量稀少而价格昂贵[1]。山羊绒与绵羊毛同属蛋白质纤维,在外观形态上非常相似,但价格差距悬殊,因此有些不良商家利用这一特点在羊绒制品中掺入细支绵羊毛、改性绵羊毛等以次充好。为切实维护企业、商家利益与消费者保护权益,打击假冒伪劣,需要对相关制品中羊绒羊毛的成分含量进行准确定量。目前对山羊绒与绵羊毛的鉴别和定量方法有显微镜法、扫描电镜法、光谱法、染色法、DNA分析法等[2-5],其中应用最广泛的是显微镜法,即通过观察山羊绒与绵羊毛在显微镜下纤维直径、鳞片厚度和光滑程度、翘角大小等形态特征来进行鉴别,在区分

出纤维种类后,根据根数比计算得到含量。但是由于这些形态特征并不十分明显,通过人工目测识别与计数,不仅对人员的专业技能要求高,耗时耗力,而且准确度受主观因素影响较大,不同机构、不同检测人员的检验结果常常会有较大的差异[6]。

随着计算机图像技术和人工智能技术的高速发展,应用显微图片与图像处理技术结合实现自动识别已成为山羊绒纤维鉴别技术研究的发展方向之一[2],近年来有不少将图像识别、深度学习理论等应用于山羊绒和绵羊毛鉴别的研究和探索[6-9],但目前市场上仍未见标准化、能广泛使用的自动识别方法和设备。从已有的实践探索中可知,计算机图像识别法的结果与所建模型数据库的完整性密切相关,不仅要求模型数据库具有代表性,并且要有足够的数据量,否则可能对结果造成不良的影响[1]。本文在采集大量山羊絨及绵羊毛纤维数据库样本基础上,将其在显微镜下观测的图像进行存储,通过图片处理、算法模型优化,采用掩模区域卷积神经网络(Mask region-based convolutional neural networks,Mask R-CNN)进行学习和训练,期望将两类纤维的识别准确度提高,为实现替代人工的自动识别提供参考。

1 实 验

1.1 样本采集

为提高自动识别数据库的代表性,本文在纤维样本的采集上一方面涵盖从原料到成品,包括羊毛散纤维、羊毛毛条、羊毛织片、羊毛呢料、羊绒散纤维、羊绒织片、羊绒呢料等多种类型样品。因为不同类型的样品所经历的加工过程不同,在显微形态上可能会有所差异[10]。另一方面尽量采集得到来自不同产地、不同种类和不同品质的羊毛、羊绒样品。

1.2 图像采集

图像的采集方法依据GB/T 16988-2013《特种动物纤维与绵羊毛混合物含量的测定》标准,取样后采用切片器制备纤维纵向切片,将试样切片放至显微镜载物台上,放大500倍,调节焦距尽量使纤维边缘显示一细线。由专业人员采集光学电子显微镜下各类纤维的纵向形态图片,通过人工识别方式对每根纤维类别进行标记。采集得到图片15000张左右,内含约60000根纤维,用于后续的研究。

1.3 图像处理及模型构建

1.3.1 纤维的分离

显微镜采集到的纤维图像中,每一根纤维并不都是独立、完整的,常存在纤维间的交错,且纤维交错的方式错综复杂,如图1(a)所示。因此,首先需要将纤维与背景进行分离,将分割后的纤维图像转化为灰度图像,以利于減少来自背景的气泡或杂质干扰,并使纤维图像轮廓得到增强,有利于接下来的分离和特征提取。然后,通过分水岭算法,利用图像的梯度信息,将邻域内差值较小的像素点连接成封闭的轮廓,配合给定的标记点将图片中的羊绒羊毛纤维分割为单根纤维。分离后的图片如图1(b)所示。

1.3.2 纤维图像的纹理特征提取

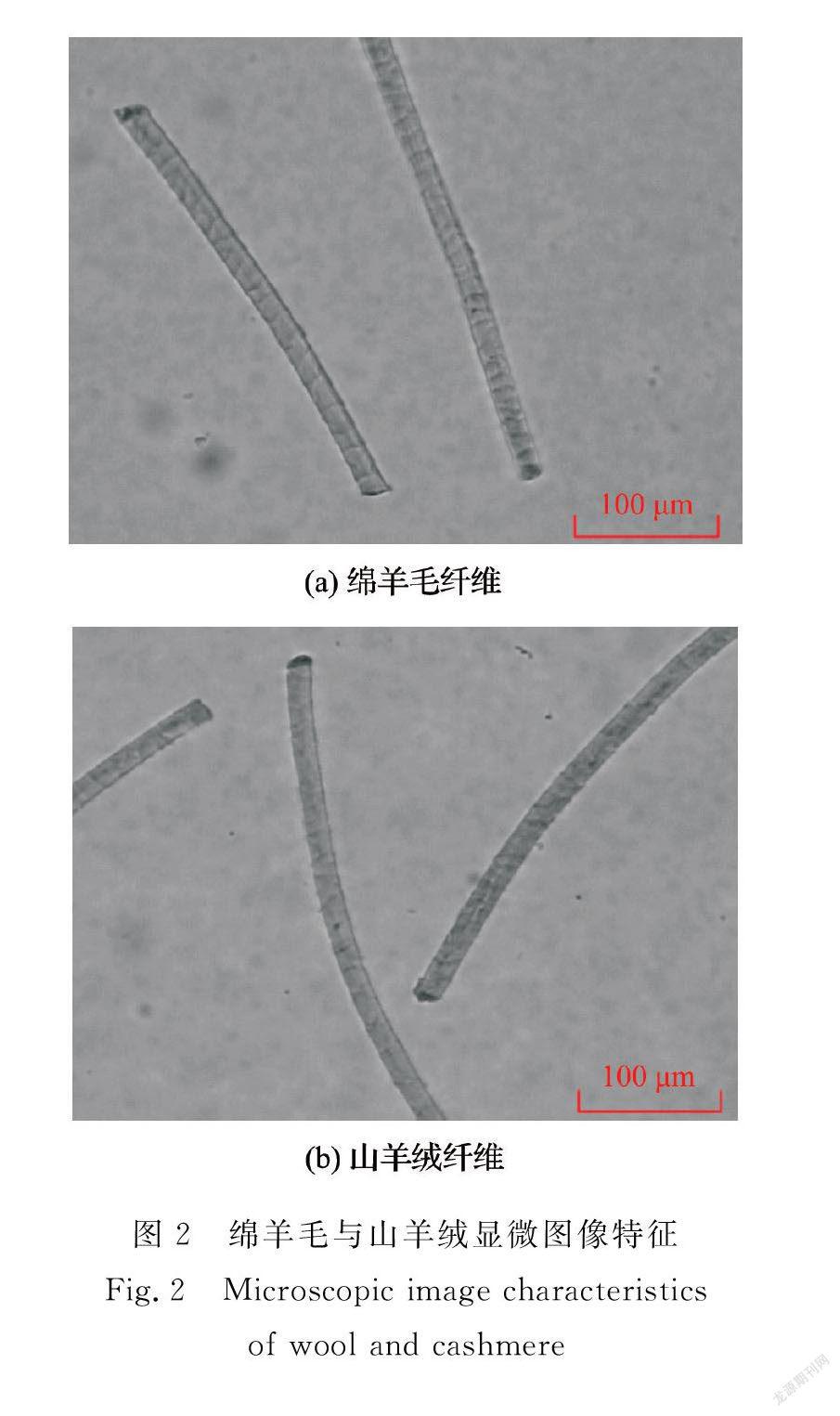

显微镜下山羊绒和绵羊毛的外观特征差异主要表现在纤维鳞片形状、整齐度、鳞片表面光滑程度、厚度、粗细均匀程度及光泽等方面。绵羊毛与山羊绒显微图像特征如图2所示,山羊绒在显微镜下光线的透过性能好、纤维毛干均匀、鳞片较薄、包覆紧密、翘角很小、鳞片间距大,而绵羊毛纤维毛干不均匀、扭转较多、鳞片厚、翘角大、鳞片的覆盖面较小或根本不覆盖、鳞片间距小。在实际检测中,往往需要综合考虑这些特征参数, 而不能仅仅依据其中一两个参数作出判断。本文采用卷积神经网络技术建立模型,在网络的训练过程中,梯度下降更新出的网络模型参数会自动提取纤维的各类特征。

2 模型构建

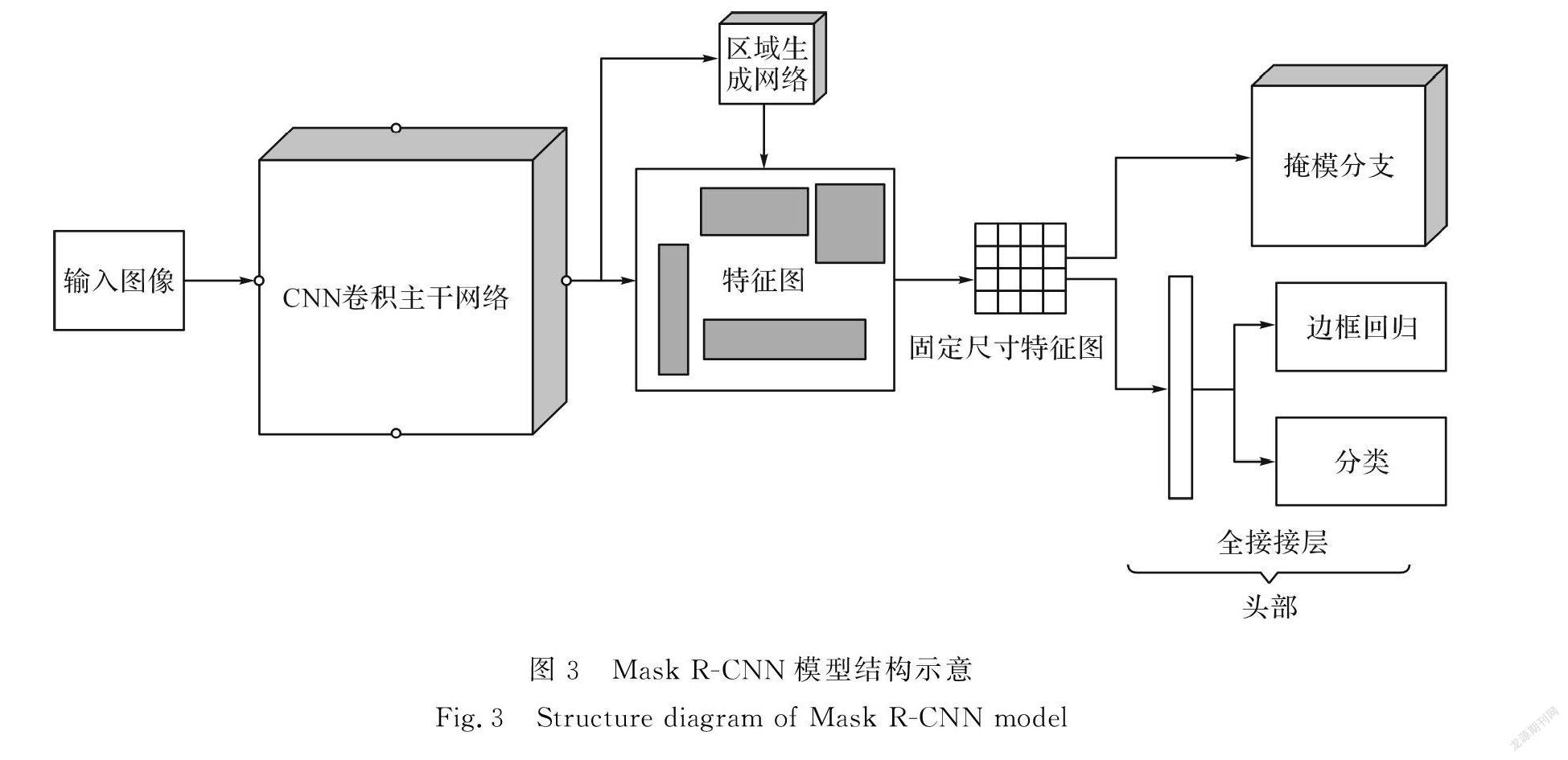

传统的纤维识别需要先把单根纤维分割后,获取纤维的特征,然后利用识别算法进行分类,而Mask R-CNN卷积神经网络能够在完成语义分割任务的同时实现目标的分割和识别分类。对于图像,语义分割技术不仅能识别出图像中的目标,预测出其蒙版、包围框,还能够预测出目标的种类,因此本文采用Mask R-CNN卷积神经网络进行纤维分割和识别以提高处理的效率。

Mask R-CNN卷积神经网络结构如图3所示,其中重要的结构有卷积主干网络(CNN convolutional backbone)、区域生成网络(RPN)、预测蒙版的掩模分支(Mask branch)、预测包围框的边框回归(Box regression)结构、类别识别的分类(Classification)结构。

Mask R-CNN计算流程如下:

a)输入一幅图片,图片应与训练网络时的预处理方式保持一致,如图像RGB颜色通道的放置顺序等;

b)将图片输入到训练好的神经网络中计算获得特征图,如本研究中用的是ResNet-50残差神经网络;

c)对这个特征图中的每一区域设定一个兴趣区域,这个区域称为候选区域,这样就可以在特征图中获得多个兴趣区域;

d)将这些候选兴趣区域送入区域生成网络(RPN网络)进行二值分类和边框回归。二值分类能区分兴趣区域的前景和背景,边框回归能通过兴趣区域选框预测目标真实选框,由此来过滤掉一部分候选区域;

e)对这些剩下兴趣区域进行热点区域对齐(ROIAlign)操作,ROIAlign取消了量化操作,使用插值使特征聚集连续,将原图和特征图对应进而将特征和特征图对应;

f)对这些兴趣区域进行N类分类、边框回归和生成对应掩模。

Mask R-CNN网络是由深度卷积网络发展而来的,但其中的很多结构都不相同,特定优化的结构可以提升网络拟合能力,能提升训练速度,减少过拟合风险,实现特殊任务执行。

3 结果与分析

3.1 Mosaic数据增强

Mosaic数据增强利用了4张图片,对4张图片进行拼接,每一张图片都有其对应的包围框,将4张图片拼接之后就获得一张新的图片,同时也获得这张图片对应的框框,将这样一张新的图片传入到神经网络当中去学习,相当于一下子传入4张图片进行学习。

Mosaic数据增强时每次读取4张图像,分别对4张图片进行翻转(对原始图片进行左右的翻转)、缩放(对原始图片进行大小的缩放)、色域变化(对原始图片的明亮度、饱和度、色调进行改变)等操作。操作完成之后然后再将原始图片按照第一张图片摆放在左上,第二张图片摆放在左下,第三张图片摆放在右下,第四张图片摆放在右上4个方向位置摆好。完成4张图片的摆放之后,利用矩阵的方式将4张图片它固定的区域截取下来,然后将它们拼接起来,拼接成一张新的图片,新的图片上含有框框等一系列的内容。

3.2 训练过程及结果

以上实验均是在同一台计算机上完成的,配置如下:CPU:IntelCorei7-9700K@3.6GHz;RAM:32.0GB;RAM frequency:3000MHz;GPU:NVIDIA GeForce RTX 2080 Ti;VRAM:11GB。

训练神经网络时,使用的是Python语言,IDE使用的是PyCharm,深度神经网络使用的是Pytorch库来进行编写,并使用Qt5.9.2进行界面设计编写。

在训练时,其显存使用量约为9 GB,一次训练耗时约11h。而在推断时,测试300张图像,用时95.6s,平均速度0.319帧/s。在对一个标准批次,数量为20张的图像测试时间为6~7s。训练数据见表1。

训练超参数:超参数是一类必须在训练前设定的参数值,它们不能由训练得来。合理设定的超参数能够减少训练时间,降低模型损失值,提高模型鲁棒性。在识别羊绒羊毛纤维时,需要根据纤维的特性,合理设置超参数。表2所示的训练超参数表是通过多次尝试得到的参数,这组参数能较好地实现网络的训练。

在设定训练超参数时,将启用4个数据加载器DATALOADER,以满足运算时读取数据的需求,加快训练速度。由于羊绒羊毛的形状大多都是长条形,所以将训练锚框ANCHOR的角度设定为-90,0和90,锚框ANCHOR的长宽比例设定为0.33,1.0和3.0。网络的训练将使用阶梯式学习率,总迭代次数MAX_ITER为30000,分别在36000和50000次时降低学习率,这样不仅训练速度提升,最终的模型损失值也能较低。求解器SOLVER使用的是Adam算法基础学习率BASE_LR为0.00012,指数衰减率ρ 1=0.9和ρ 2=0.999;数值稳定小常数。

训练结果:在测试集上,对600张图像进行测试,结果与人工识别结果进行对比, 结果一致性在95%以上,具体测试结果如表3所示。

3.3 验证结果分析

使用Mask R-CNN卷积神经网络,一次性从图像中得出纤维分类并分割,达到了较高的识别准确率,与人工检测结果的一致性达到了95%以上,推断速度达到了0.319帧/秒。对比其与传统方法对羊绒羊毛纤维检测识别能力,使用深度卷积神经网络进行识别,其效果更加优秀。

3.4 测试实例

为了测试所建立模型的识别效果,单独采用测试集的100张图片(其中纯羊毛和纯羊绒各20张图片,绵羊毛与山羊绒混合的60张图片),输入所建立的羊毛羊绒自动识别模型进行测试,以图片中每根纤维的识别准确性(与人工判别一致性)为评价标准,针对每张图片,对应输出识别结果。输出方式如图4所示。

经统计,20张纯羊毛图片含羊毛140根,识别正确134根;20张纯羊绒图片中含羊绒128根,识别正确123根;60张羊毛羊绒纤维混合的图片中,含羊毛120根,羊绒75根,识别正确187根。与人工识别结果相比,纤维自动识别正确率达到95%以上,说明模型能够较好地实现对两类纤维的自动判别。具体统计结果见表4。

4 结 论

本文介绍了基于深度卷积神经网络技术深度学习的羊绒羊毛纤维识别模型建立过程,分析了图像处理及模型构建中数据增强及训练过程,并采用测试集对所建立的模型进行了验证测试,形成结论如下:

a)通过大量山羊绒及绵羊毛纤维显微图片样本的训练,将两类纤维的识别准确度提高到95%以上,为实现替代人工的自动识别奠定了坚实基础。

b)由于山羊绒及绵羊毛纤维在显微镜下的形态差异本身并不明显,且有的样品经过织造或染整加工,纤维形态会发生部分变化,采用经典目光法判断时,不同人员之间的结果也会存在一定的分歧,还需要采集更多的山羊绒及绵羊毛纤维样本扩充数据库, 同时优化算法,以进一步提高识别的精准程度,实现将其应用于实际检验,建立起比传统人工识别更客观、高效的检测方法。

参考文献:

[1]顾昊,王满,闫畅,等.羊绒纤维鉴别方法综述[J].中国纤检,2017(1):69-71.

GU Hao, WANG Man, YAN Chang, et al. Review on the detection methods of cashmere fiber[J]. China Fiber Inspection, 2017(1): 69-71.

[2]馬海,吴桂芳,李志东,等.山羊绒纤维鉴别技术的现状与发展趋势[J].毛纺科技,2017,45(3):5-9.

MA Hai, WU Guifang, LI Zhidong,et al. Current situation and development trend of cashmere identification technology[J].Wool Textile Journal,2017, 45(3): 5-9.

[3]刘心如,张利平,王建福,等.可见-近红外漫反射光谱技术对羊毛和羊绒的鉴别研究[J].光谱学与光谱分析,2013,33(8):2092-2095.

LIU Xinru, ZHANG Liping, WANG Jianfu,et al. Use of visible and near infrared reflectance spectroscopy to identify the cashmere and wool[J].Spectroscopy and Spectral Analysis, 2013,33(8) :2092-2095.

[4]陈国培,赖心田,唐复润,等.羊毛及羊绒制品实时荧光PCR鉴定方法研究[J].纺织导报,2013(2):88-91.

CHEN Guopei, LAI Xintian, TANG Furun, et al. Real-time PCR identification of wool and cashmere products[J].China Textile Leader, 2013(2):88-91.

[5]董晓东,杨素英,丁楠,等.DNA分析技术在动物纤维鉴别领域的研究进展[J].中国纤检,2015(17):70-72.

DONG Xiaodong, YANG Suying, DING Nan, et al. The research advances of DNA technology in identiifcation for animal fibers[J]. China Fiber Inspection, 2015(17):70-72.

[6]季益萍,王瑞,杨锁廷,等.计算机图像识别技术检测羊绒羊毛混纺比[J].毛纺科技,2008,36(10):58-60.

JI Yiping, WANG Rui, YANG Suoting, et al. Identifying blend ratio of wool and cashmere by computer image recognition technology[J].Wool Textile Journal, 2008, 36(10): 58-60.

[7]邢文宇,邓娜,辛斌杰,等.基于多特征融合图像分析技术的羊毛与羊绒鉴别[J].纺织学报,2019,40(3):146-152.

XING Wenyu, DENG Na, XIN Binjie, et al. Identification of wool and cashmere based on multi-feature fusion image analysis technology[J].Journal of Textile Research, 2019, 40(3): 146-152.

[8]王军庆,马佩佩,李保荣,等.基于图像处理的羊毛/山羊绒鉴别方法研究进展[J].纺织科技进展,2020(9):8-11.

WANG Junqing, MA Peipei, LI Baorong, et al. Research progress of wool/cashmere identification method based on image processing[J].Progress in Textile Science & Technology, 2020(9): 8-11.

[9]刘爽,许忠保,李春桥,等.基于数字图像处理的羊绒与羊毛识别研究[J].棉纺织技术,2019,47(10):30-34.

LIU Shuang, XU Zhongbao, LI Chunqiao, et al. Study on the recognition of cashmere and wool based on digital image processing[J].Cotton Textile Technology, 2019, 47(10) : 30-34.

[10]盛冠忠,李龙.关于山羊绒鉴别有关问题的探讨[J].毛纺科技,2007,35(12):52-55.

SHENG Guanzhong, LI Long. Study on distinguishing problem of cashmere fiber[J]. Wool Textile Journal, 2007, 35(12): 52-55.