颜色显著性检测平台的设计与分析

2022-03-14徐彬竞

徐彬竞,施 霖

(昆明理工大学 信息工程与自动化学院,云南 昆明 650500)

0 引 言

图像显著性区域检测方法能够定位并提取人类视觉系统感兴趣的区域。显著性检测广泛应用于各种计算机视觉任务中,如以显著性检测内容来指导图像内容描述[1-2],在图像定位和分类任务中,显著性检测内容转化无监督学习为实例学习[3],以及用于构建测试视觉问答模型性能的数据集[4]等。1998年,ITTI等人[5]从图像强度、结构方面入手,通过数学归纳法描述显著性特征。图像显著性的早期检测方法主要利用图像的纹理、颜色等低级特征,或是水平线、中心点等中级特征信息来得到显著性图。例如,ZHAI等人[6]提出基于线性复杂度计算图像显著性检测方法(Linear computational Complexity Salient Region Detection,LC);基于对频率的考虑,ACHANTA等人[7]提出了基于频率调谐的图像显著性检测方法(Frequency-tuned Salient Region Detection,FT)。此后,深度学习的发展,使大量神经网络得以应用在显著性检测领域。在卷积神经网络(Convolutional Neural Networks,CNN)的基础上,大量神经网络模型被提出并加入到显著性检测任务中。例如,LIU等人[8]提出PiCANet模型来选择性地关注图像全局或局部上下文,并为每个像素构建信息丰富的上下文特征;QIN等人[9]提出U2-Net模型能够从浅层和深层捕获更丰富的图像局部和全局信息,并且可以基本无视分辨率的影响;LIU等人[10]提出PoolNet模型将池化运算更好地运用于显著性检测上;QIN等人[11]提出BASNet模型包括一个预测-细化结构和一个混合损失结构,可以实现于高度准确的显著性预测。

颜色特征由于具有强大的鲁棒性,即旋转不变性和尺度不变性,故在图像显著性研究方面具有重要价值。视觉颜色显著性研究能有效指导工业生产、生活、交通等领域的安全标志的识别性,从而减少事故的发生[12]。颜色特征在图像检索方面由于其高效性而有着广泛的运用[13]。工作记忆表征的颜色特征有着较强的引导效力,相比较其他刺激特征(如方向、形状)更具有优先性[14]。在设计领域,颜色语义有着装饰审美性、诠释产品功能、提升产品价值等功能[15]。颜色特征显著性可以在医学图像处理领域更好地识别病理特征[16]。

图像的显著性检测在图像处理中有着重要的作用。颜色特征是图像信息重要的组成部分,如何有效地提取颜色显著性区域就成为重要的问题。传统的显著性检测方法往往更注重图像的低层次特征信息,颜色显著性检测往往基于对比度、RGB值等信息而非语义信息。神经网络的出现,很大程度上解决了无视语义信息的问题,但现有显著性数据集大都聚焦于物体显著性检测而非颜色显著性检测,例如DUTS数据集[17]、HKU-IS数据集[18]等。没有相关数据集则无法完成颜色显著检测神经网络训练。

因此,本文设计了一种获取眼动注视点数据的颜色显著性实验平台,采用EyeTribe眼动仪,由实验获取被试关注图片上颜色信息时的视线位置数据并标注于图像,从而制作出数据集。相较于手工标注,眼动注视点数据能准确记录人眼看到图像时的视觉注意位置[19],能更好地反映出被试对于图像颜色信息的注意信息。首先,用此数据集中训练集分别利用传统算法FT和LC进行显著性区域检测。其次,分别利用PiCANet、PoolNet、U2-Net及BASNet4种显著性检测神经网络模型进行训练。最终,对比各方法的显著性检测结果评价指标,得到在该任务上表现最为优异的方法。

1 方法与实验

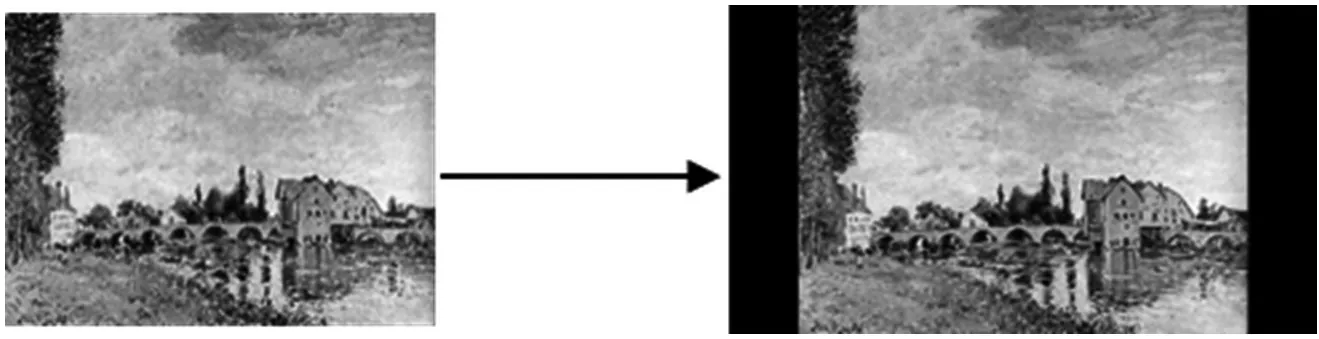

本次实验选取印象派画作中较为著名的100幅画作,按照1 920×1 020的分辨率缩放,空白区域以黑色填充的方式标准化后作为实验显示图像,如图1所示。印象派画作有着显著的色彩特点:按照光谱色选用颜料作画,画面对比度强,使用高纯度色彩,运用主观色彩[20]。这些特点使其在色彩信息的表达上更加丰富与突出,同时语义信息更加强烈。如此,能够更好地获取被试对颜色信息刺激后的反应。

图1 图像标准化

1.1 平台设计

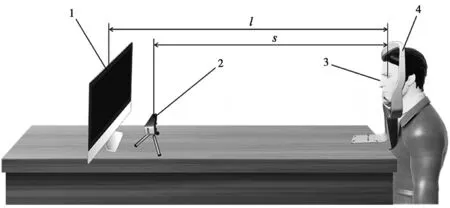

本文设计的颜色显著性检测实验平台,采用EyeTribe眼动仪作为视线位置记录装置。该装置是一种眼动追踪系统,可以通过从人眼睛的角膜反射点位置获取视线在显示屏上的投影位置。眼睛注视坐标是相对于人正在观看的屏幕计算的,由屏幕坐标系给出的一对(x,y)坐标表示。围绕该眼动仪配备了显示器、头部固定支架,如图2所示。其中s为被试头部与眼动仪水平距离,其值为35.55 mm;l为被试头部与显示器的水平距离,其值为40.00 mm。

图2 实验平台示意图

该实验平台经过多次测试,可以满足对被试眼动轨迹的准确记录的需求,下面将结合基于此平台的颜色显著性实验,进一步介绍本设计。

1.2 颜色显著性实验

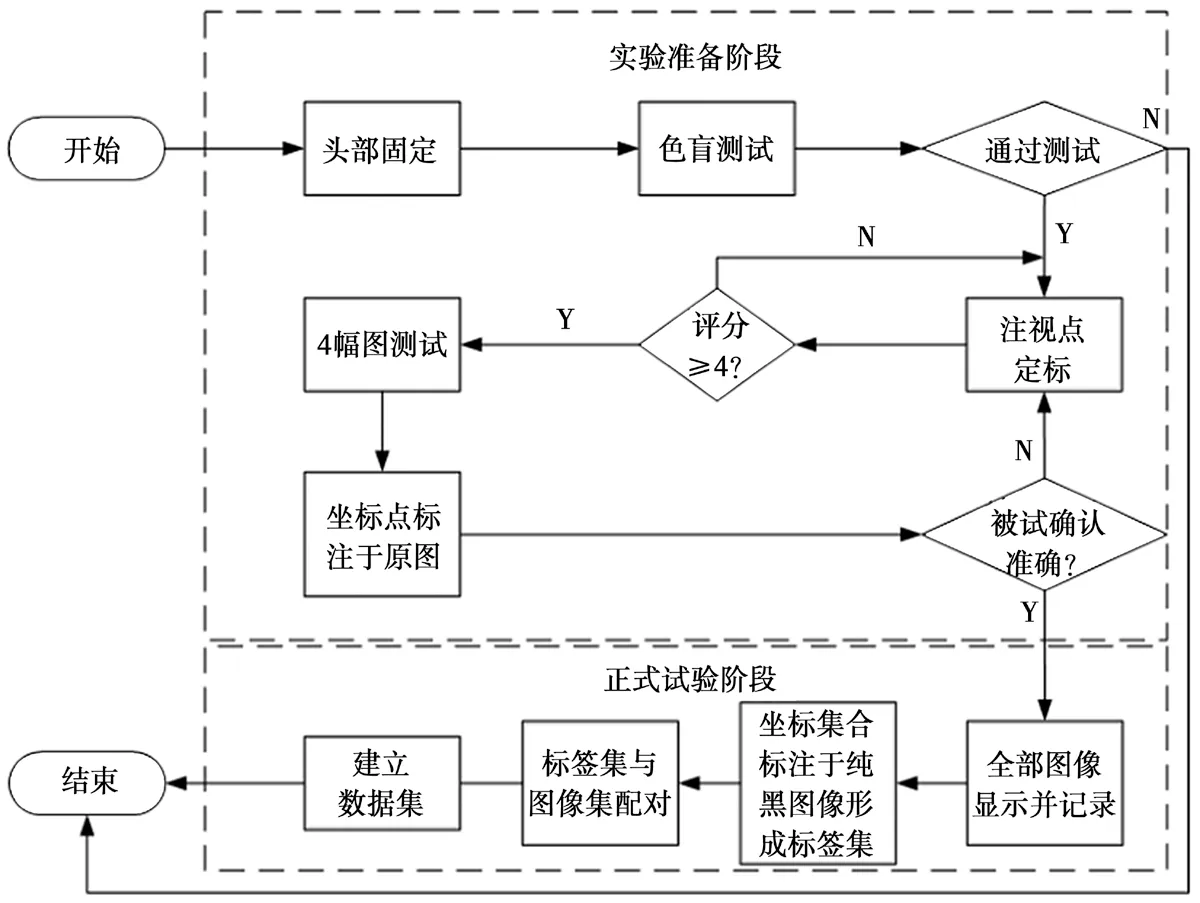

本文的颜色显著性实验完整过程如图3所示。实验分为两个模块:模块A为实验准备阶段,确定被试通过色盲测试且眼动仪能准确记录被试注视点;模块B为正式实验阶段,记录被试对整个图片集的颜色显著区域注视点集合,并生成数据集。

图3 实验流程图

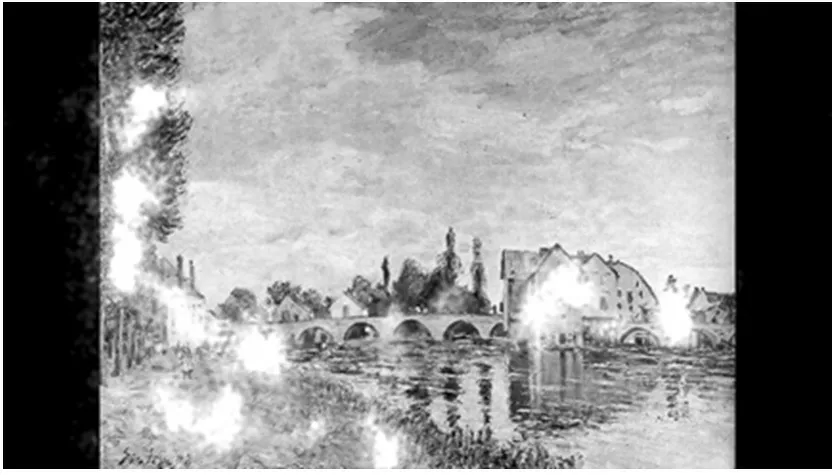

被试将头部放置于头部固定支架,首先进行色盲测试。确认被试色觉正常后,实验全程被试都以此姿势进行实验。之后,定标程序开始运行。显示器上显示游标,被试跟随游标移动注视点,直至完成眼动定标,获得评分,直至评分大于等于4(意味着此校准结果非常适合眼动追踪,视线误差角度<0.7°),继续进行后续实验。显示器将显示标准化后的图像,首先显示4副图像进行测试。当图片显示时,请被试欣赏并依次注视图片上最感兴趣的多个颜色区域而非物体,每幅图像显示22 s。当4幅图全部实验完毕,将每幅图像注视点坐标集合以alpha值为0.5的白色点的形式标注于该图像,如 图4所示。被试确认标注白色区域正确。至此,实验准备工作完成。

图4 被试确认用标注图

实验正式开始时,显示器将会依次显示100幅标准化后的图像,每幅图像显示时间为22 s,同样令被试依次注视图片上最感兴趣的多个颜色区域。实验结束后,获取被试对所有图像注视点的坐标集合。

1.3 数据集建立

在13个被试正确完成实验后,将所获得的注视点坐标集合以alpha值为0.5的白色点的形式标注于分辨率为1 920×1 080的黑色图像上,如图5所示。采用该方法获得的图片集合即为神经网络训练的颜色显著性检测标签。与标准化后的图像两两配对,成为颜色显著性检测数据集,其中20%为测试集,80%为训练集。

图5 实验生成神经网络训练用数据集示例

2 实验结果与分析

对实验获取数据集中的测试集分别使用传统方法和深度学习方法进行显著性检测,并与实验获得的真值进行对比,如图6所示。通过F-measure最大值MaxF和MAE值来评估颜色显著性检测最优方法。

图6 各算法颜色显著性检测效果示意图

2.1 传统方法

基于频率调谐的图像显著性检测(Frequencytuned Salient Region Detection,FT)方法利用了颜色和亮度的特性,从原始图像中保留比其他现有技术更多的频率内容,是一种利用颜色和亮度的低水平特征计算图像显著性的频率调整方法。该方法易于实现,速度快,并提供全分辨率显著性图。

基于线性复杂度计算图像显著性检测(Linear computational Complexity Salient Region Detection,LC)方法通过计算图像特征值的直方图,遍历整个图像的计算特征值距离矩阵,为每一个对应像素值分配显著值得到显著图,将显著图归一化并显示。

2.2 深度学习方法

传统方法着重关注图像中的基础、低级的特征信息,并未考虑到图像中的语义信息关联。近年来,卷积神经网络(Convolutional Neural Networks,CNNs)将语义信息的关联纳入预测中,随后全卷积神经网络(Fully Convolutional Networks,FCNs)的出现大大提高了检测的效率与性能,并逐步替代了传统的图像显著性检测方法。语境在显著性检测任务中扮演着重要的角色。本文采用4个在显著性检测任务中质量较好的神经网络对颜色显著性实验获得的数据集进行训练。PiCANet颜色显著性检测时,区别于基于浅层颜色信息的传统方法,PiCANet能够充分考虑语境信息以及语义信息,将图像中更符合人类视觉特征的颜色显著区域检测出来。语境在显著性检测任务中起着重要作用,但并非所有上下文信息都有助于显著性检测的最终决策,一些相关区域通常更有用,而其他嘈杂的语义信息应该被丢弃,由此提出了一种新的像素级上下文注意网络PiCANet,该模型选择性地关注全局或局部上下文,并为每个像素构建信息丰富的上下文特征。由于CNN的金字塔状结构特征,较浅的阶段通常具有更大的空间尺寸并保留丰富、详细的低级信息,而更深的阶段包含更多高级语义知识,更擅长定位显著对象的确切位置。

2.2.1 PoolNet

检测颜色显著性时,PoolNet具有更大的感受野,能考虑到更大范围的颜色信息,同时,该网络模型对颜色边缘的检测也具有更好的效果。U形结构在深度学习中是常见的结构,此结构能够通过在分类网络上构建自上而下的路径来构建丰富的特征图。首先,高层语义信息会逐渐传递到较浅层,因此较深层捕获的位置信息可能会同时逐渐被稀释。其次,CNN的感受野大小与其层次深度不成正比,并且会产生边界损失。PoolNet基于U形结构通过扩展池化模型来解决这些问题。该模型通过设计两个简单的基于池化模块GGM(全局引导模块)和FAM(特征聚合模块),从而将池化更好地运用于显著性检测上。GGM在特征图上的每层都能关注到显著物体,在每次横向连接的时候都加入高层的语义信息。FAM帮助模型降低上采样导致的混叠效应,同时对感受野进行放大。

2.2.2 U2-Net

进行颜色显著性检测时,U2-Net没有使用图像分类的预训练主干模型,可以从头训练,得到更符合颜色显著性检测的模型。其体系结构是一个两层嵌套的U结构,这使得网络能获得更深入的特征颜色信息,同时以高分辨率图像计算,而不会显著增加内存和计算成本。利用残差U型模块不同尺度、不同感受野的混合,能够捕捉更多的全局颜色信息。

2.2.3 BASNet

进行颜色显著性检测时,大多数网络都更加关注于区域提取的准确率。为了获得高精度颜色边界和精细显著性结构的分割,BASNet采用深层编码器-解码器的结构先得到一个全局的、粗糙的结果,之后采用RRM(残差求精模块)修正结果,得到局部的、精细的结果。该模型引入结构相似性损失,最后三种损失(BCE损失,SSIM损失,IoU损失)相加。为解决边界模糊问题,该模型更注重边界质量,计算时,边界的损失值比物体内部或其他地方损失值的权重更高,以降低交叉传播图像边界和区域中训练时的信息所带来的假错率,从而获取更加准确的颜色显著性区域的边界。

2.3 评价指标对比

本文主要采用显著性检测中MAE值和F-Measure 最大值MaxF这两个评价指标对颜色显著性检测结果进行评价。

2.3.1 平均绝对离差MAE

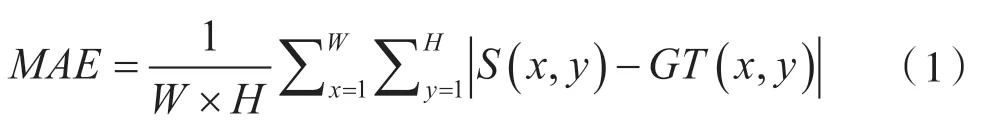

平均绝对离差(Mean Absolute Deviation,MAE) 的计算方法如式(1)所示:

式中:W和H分别表示图像的宽度和高度,S为该模型计算得到的显著图,GT为颜色显著实验获取的被试注视点标注真值。一般地,MAE值越小表示该方法效果越好。

2.3.2 F-measure

精度(Precision)和召回率(Recall)的计算方式如式(2)、式(3)所示:

式中:M为二值化下预测的显著性图,G为颜色显著实验获取的被试注视点标注真值图。

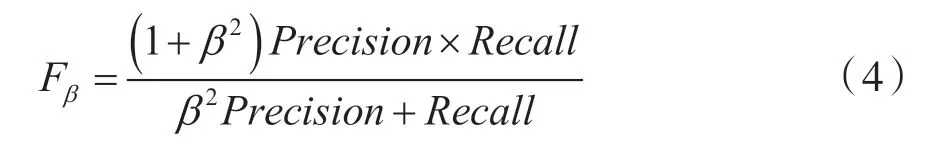

F-measure综合了查全率和查准率,计算方式如式(4)所示:

式中:β代表非负权重,用以平衡召回率与准确率之间的关系。通常,β2取值为0.3.在对比时往往选取F-measure的最大值MaxF作为模型的评价标准。一般地,F-measure值越大,表示该模型性能越好。

2.4 显著性检测方法对比

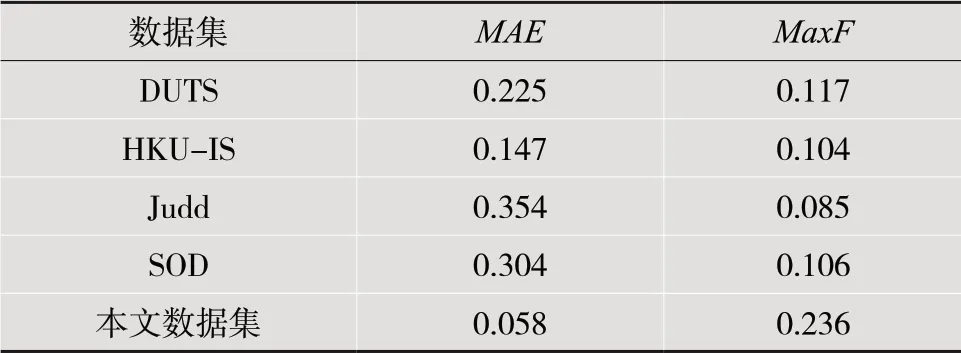

为了从数据上直观地对比本文所选取的方法,在表1中展示了不同的颜色显著性检测方法在本次实验所得数据集上的性能参数,并使用平均绝对离差MAE、F-measure的最大值MaxF作为评价指标。所有数据均以测试集结果作为对比。通过表中数据对比可知,不论是以MAE参数还是MaxF参数来看,传统方法在颜色显著性检测时性能均不佳。因为传统方法不是面向颜色显著性检测设计的算法,同时不能充分考虑图像中的语义信息。对比神经网络模型时,PiCANet、U2-Net、BASNet在该精度下的MAE值同为最优,再对比MaxF值,BASNet在本次实验中拥有最佳性能,说明BASNet模型首先获得粗糙检测结果再精细化结果更符合人眼关注颜色时的特征。同时,BASNet更加关注显著性区域的边界,故得到更精确的颜色显著性检测 区域。

表1 各算法颜色显著性检测评价指标对比

2.5 显著性检测数据集对比

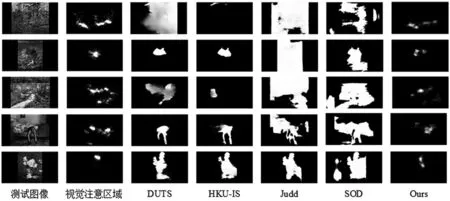

显著性检测领域常用的数据集有DUTS、HKU-IS、 Judd及SOD数据集。将本次实验生成的数据集和常用显著性检测数据集分别用BASNet训练后,预测结果对比示例如图7所示,MAE值与MaxF值对比如表2所示。本文方法所获得数据集在MAE值和MaxF值上表现均为最优。

图7 各数据集显著性检测效果示意图

表2 各数据集颜色显著性检测评价指标对比

3 结 语

利用本文搭建的实验平台开展颜色显著性实验,准确记录被试观察图像中颜色显著性区域并获取数据。对比分析各个显著性检测方法,结果表明,在颜色显著性检测任务上,BASNet表现最优。以最优方法分别对传统显著性检测数据集和本文实验所得数据集训练后,结果表明,本文数据集具有最好的性能。本文的实验结果可为进一步提升颜色显著性检测效果奠定基础。