基于无人机影像和深度学习的渭北旱塬区土地利用精准分类

2022-03-09张志博赵西宁姜海晨高晓东石亮亮牛雨婷

张志博,赵西宁,姜海晨,袁 浩,杨 龙,高晓东,石亮亮,牛雨婷

基于无人机影像和深度学习的渭北旱塬区土地利用精准分类

张志博1,赵西宁2,姜海晨3,袁 浩4,杨 龙5,高晓东2※,石亮亮4,牛雨婷3

(1. 西北农林科技大学旱区农业水土工程教育部重点实验室,杨凌 712100;2. 中国科学院水利部水土保持研究所,杨凌 712100;3. 西北农林科技大学资源环境学院,杨凌 712100;4. 西北农林科技大学信息工程学院,杨凌 712100;5. 西北农林科技大学经济管理学院,杨凌 712100)

为明确基于无人机影像的旱塬区土地利用精准分类方法,尤其是算法的选择,该研究通过获取渭北旱塬区白水县通积村不同航拍高度无人机正射遥感影像,利用多种深度学习算法和机器学习算法对土地利用分类进行研究。首先,采用大疆御2Pro获取研究区80和160 m不同高度航拍影像;然后对不同航拍高度目视解译结果和多种深度学习、机器学习模型预测结果进行对比分析;最后,基于表现最佳算法对其进行创新和改进。结果表明:深度学习算法的表现远远优于传统机器学习算法,其中深度学习算法中表现最好的DeepLabv3+像素精度为90.06%,比随机森林(Random Forest,RF)和支持向量机(Support Vector Machine,SVM)分别高出24.65和21.32个百分点。基于DeepLabv3+改进的DeepLabv3+_BA模型整体分类效果最好,其像素精度为91.37%,比FCN、SegNet、UNet和DeepLabv3+分别高出7.43、10.12、2.27和1.31个百分点。各种算法在160 m数据集上各指标精度高于80 m。改进模型DeepLabv3+_BA具有较高的地物分类精度及较强的鲁棒性,该研究可为基于无人机影像和深度学习的土地利用信息普查提供技术参考。

无人机;遥感;土地利用;可见光影像;深度学习;机器学习

0 引 言

实时准确的土地利用空间分布信息是土地资源现代化管理的基础,因此土地利用精准分类识别是国土资源遥感的研究热点之一[1]。目前常使用卫星多光谱影像作为土地利用信息提取的基础数据[2-3]。由于受数据获取成本、空间分辨率和回访周期的限制[4],常用的卫星数据无法识别精细尺度的作物细节,且数据获取过于依赖卫星过境时的天气状况[5],实时性和准确性均受到限制。近年来低空无人机遥感技术迅速发展[6],具有灵活性高、操作简单、空间分辨率高,且在云下操作等优势[7],弥补了传统卫星遥感的应用限制,成为目前小区域土地利用遥感数据获取的主要手段[8]。当采用无人机影像进行土地利用分类时,相比于中低分辨率遥感影像,高分辨率无人机影像的纹理、形状及上下文关系等信息更加丰富[9],可用于构建可见光影像的分类特征。

利用无人机影像进行土地利用分类常用的方法包括机器学习方法和深度学习方法。机器学习方法主要以支持向量机(Support Vector Machine,SVM)[10]和随机森林(Random Forest,RF)[11]为代表,这两种监督分类方法都需要对分类地区有一定的先验知识,利用样本区干预分类类别及结果,存在“椒盐”现象,且对图像的特征提取不够全面[12-13]。近年来,源于多层人工神经网络的深度学习算法,具有多层非线性网络结构能够从大量数据中学习数据本质特征的能力[14]。其中,深度学习中常用的语义分割模型,如FCN_8s[15]、SegNet[16]、UNet[17]、DeepLabv3+[18]等模型被广泛应用在医学、生物学、遥感等领域,并取得了稳定可信的研究成果[19-20]。目前,深度学习语义分割模型逐渐被用于无人机遥感影像的土地利用分类提取中[21-22]。如田琳静等[23]利用卷积神经网络深度学习方法对农业区土地利用进行监测分类,总体分类精度达93%以上;王协等[24]提出一种多尺度学习与深度卷积神经网络的多尺度神经网络模型,对超高分辨率遥感影像进行土地利用分类,总体精度达91.97%。

在复杂背景中对多种地物进行同步分类提取时仍存在诸多问题。首先,在复杂背景中对多种地物进行同步分类提取,传统影像分类方法需要具备该领域先验知识的专家对特征进行设计和挑选,因此,设计什么类型的特征无疑是一项巨大的工程量;其次,设计和挑选的特征是目标相关的[25],每一个特征参数的组成均针对一种特定的目标进行探测,如何对待分类影像上关键类别的重要特征进行全面覆盖是令人困扰的难题;再次,很多人工设计的低层特征用于分类时需要阈值的参与,从而分类也将变成一种经验性和主观的结果,加之高分遥感影像由于地物细节丰富,导致同物易谱和同谱异物现象时有发生,针对多种影像地物确定阈值无疑增加了高分影像分类自动化的难度[26];最后,也是最重要的一点,人工设计的低层特征和高级语义之间存在着语义鸿沟[27],这是利用低层特征进行高分遥感影像语义分割的重要障碍之一。而深度学习避免了人工对特征描述的设计,更好的利用了原始数据本身特征去挖掘地物分类所需条件,而且通过层次化的端到端构建方式,跨越了语义鸿沟[28]。本研究结合已有研究成果,使用多种机器学习算法和深度学习算法,以渭北旱塬区为典型区域,对多种地物(建筑用地、苹果园、裸地、道路、草地、乔木、麦茬地、玉米地)进行分类提取研究,以期获得基于无人机可见光影像多种地物同步分类的最佳算法,为渭北旱塬区种植结构优化和土地利用精准管理提供技术参考。

1 研究区及数据来源

1.1 研究区概况

研究区位于陕西省渭南市白水县,该区位于109°16′E~109°45′E,35°4′N~35°27′N。白水县属于陕西渭北旱塬区,为关中平原与陕北黄土高原的过度地带,温带大陆性季风气候,年均气温11.6 ℃,年均降水量598.2 mm,日照时数2 309.5 h,雨热同季,蒸发量大,昼夜温差大,光照充足,是国内外公认的世界苹果最佳优生区[29-30]。白水县植被覆盖度为36.3%,森林覆盖率为28.8%,主要为多年生草本、灌木、少量乔木和以苹果为主的经济林[29]。本研究进行航拍时,研究区内主要作物物候特征:小麦处于成熟期、玉米处于拔节期、苹果树处于果实膨大期。

1.2 数据获取

于2021年6月23日和24日上午在西北农林科技大学白水苹果实验站西北方向2.1 km处的通积村进行拍摄,飞行平台为大疆御2 Pro四旋翼无人机系统,三轴稳定云台,俯仰角度为-90°至+30°,最大水平飞行速度72 km/h,最长飞行时间为31 min。影像传感器为哈苏2.54×10-2m CMOS可见光RGB相机,有效像素2 000万,视角约77°,机载内存64 GB。拍摄当天,天气均阴,地面风速均小于2级,满足航摄要求。试验设计飞行高度为80和160 m,飞行高度为80 m时:航线96条,航线总长42.43 km,航向重叠度75%,旁向重叠度60%,共2 248幅航摄原始相片;飞行高度为160 m时,航线20 条,航线总长17.90 km,航向重叠度70%,旁向重叠度55%,共502幅航摄原始相片。2种高度均在同一地点航摄,大疆御2 Pro拍摄的照片自带POS数据,像片控制点的地理定位采用卓林A8手持北斗GPS定位仪,根据像控点选取原则结合研究区大小、地形特点和边界条件,共布设9个控制点,将以上数据导入软件PhotoScan1.4.5进行几何定位配准和拼接,然后得到数字正射影像(Digital Orthophoto Map,DOM),其幅宽长约1.65 km,宽约0.91 km,总面积为1.5 km2。研究区地理位置、正射影像、高空局部航片如图1所示。

图1 研究区概况示意图

1.3 数据预处理

80 m航片拼接生成DOM的空间分辨率为0.020 m,160 m高度的航片拼接生成DOM的空间分辨率为0.042 m,为保证2种高度用于模型提取的DOM具有相同的空间分辨率和提高后续处理效率,均重采样至0.12 m。为了分析航摄原始相片不同高度对模型精度的影响,从80和160 m高度的航摄原始相片中分别挑选出400幅具有代表性的图像,根据研究区现有地物类型划分不同类别,使用Python第三方开源标注工具labelme4.5.6,对挑选出的图像进行逐像素点标注。为保证与拼接生成DOM的空间分辨率相同,挑选出的图像和与之对应的标签图像均重采样至0.12 m,重采样之后图像尺寸为1 024像素×682像素。

为了让模型学习到更多的特征和增强模型的鲁棒性,本研究利用饱和度变换和几何变换的数据增强方式,使用工具为数据增强库Augmentor。分别对挑选出的80和160 m高度图像进行数据扩充,2种高度分别扩充至1 000幅。数据集划分方式均采用5折交叉验证,首先将全部图像随机分成5份,每份200幅图像,每份图像从原图和扩大后图像按照4∶6比例挑选,然后每次不重复地取其中一份做测试集,其余4份做训练集,即每次按照8∶2的比例划分为训练集和测试集,且每次从训练集中随机选出20%的图像作为模型训练的验证集,用以确定模型的超参数,验证集不参与每次结果的测试,共循环5次,保证每种高度的所有图像都进行过训练和测试,得到5个评价模型,最后将5次评价的性能均值作为最后评价结果,数据集有效类别数为8。

2 研究方法

2.1 研究方案

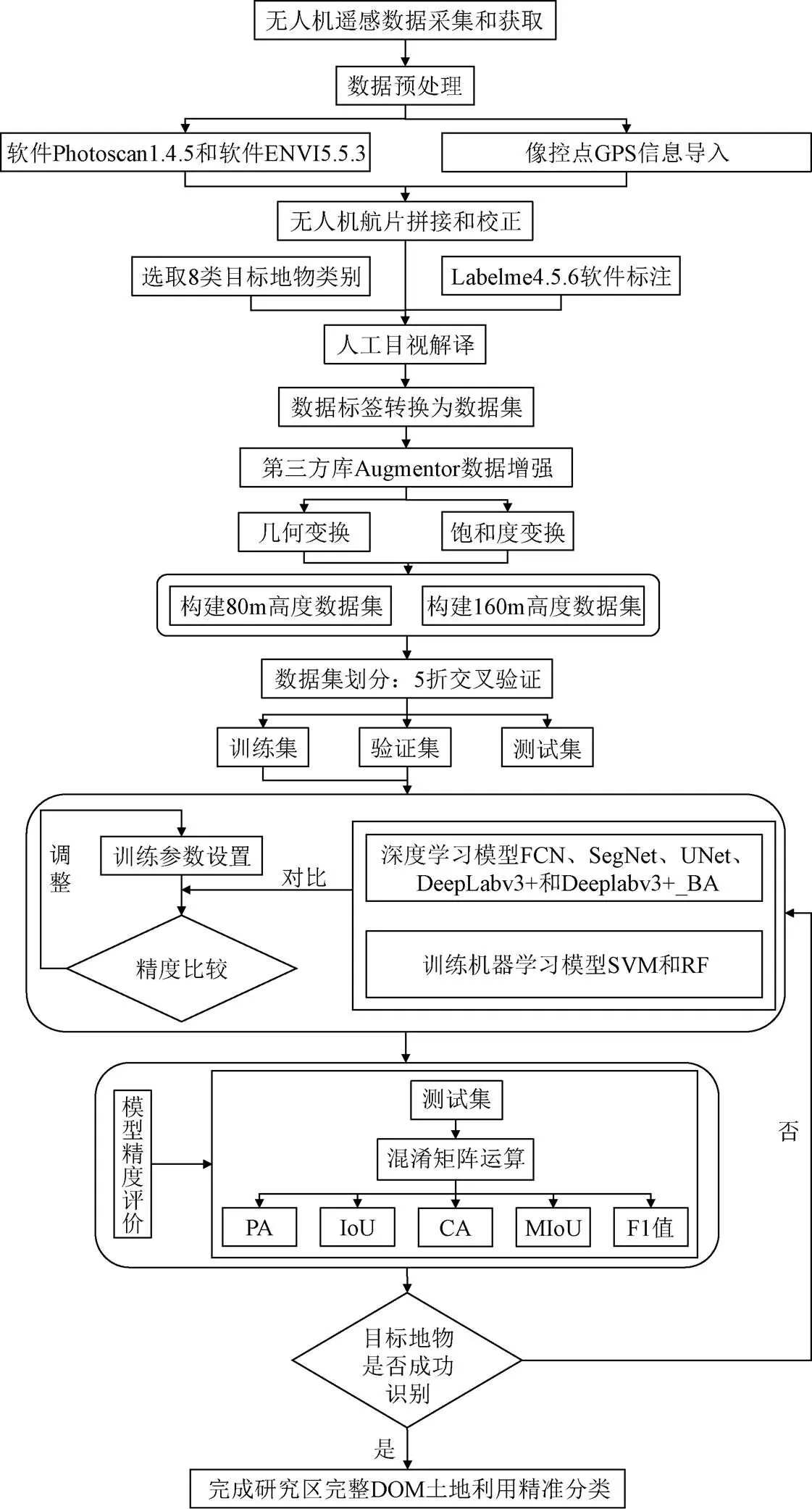

在计算机视觉领域中,遥感图像语义分割与图像分类不同,语义分割是基于像素级的分类任务[27-28]。用于图像分类的输入图像通常只包含一个目标主题,即给定一组图像都标记为单个类别,输出通常是图像所属类别的概率值,而语义分割可以实现端到端的输入和输出[15],即输入是图像输出也是图像,首先根据影像中不同类别区域的特征进行定义标签,然后通过分割算法实现对一整张图进行像素级别的分割预测。总体研究方案如图2所示。

2.2 机器学习分割算法

在计算机视觉领域,机器学习分割算法种类很多,如K最近邻(K-Nearest Neighbor,KNN)、决策树(Decision Tree,DT)、SVM、RF,这些算法的特点不同,其适用情景也不同。KNN分类算法特点是完全跟着数据走,并没有进行数学建模,只适合小数据集;DT一般由3个步骤组成:特征选择、决策树生成、决策树修剪,其特点是它总是在沿着特征做切分,随着层层递进,其划分越来越细,它容易出现过拟合,特别是当类别太多时,错误的可能就会增加比较快,DT更大的用处是作为一些更有用算法的基石,比如RF;RF是一种集成算法,在现实分析中被大量使用,它首先随机选取不同特征和训练样本,生成大量的决策树,然后综合这些决策树的结果来进行最终分类,相对于决策树,RF在准确性上有了很大的提升;SVM的应用也非常广泛,它在支持向量的帮助下,通过类似于深度学习中的梯度下降优化方法,找到最优的分类超平面-具体目标就是令支持向量到超平面之间的垂直距离最宽,其可以通过内积核函数向高维空间做非线性映射,在样本训练集上具有一定的鲁棒性。

注:PA为像素精度;IoU为交并比;CA为每个类别的精度;MIoU为平均交并比;F1为精确率(Precision)和召回率(Recall)的调和平均值;SVM为支持向量机;RF为随机森林。

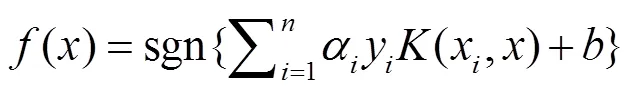

SVM的最优分类函数计算式如下:

RF的决策计算式为

在本研究数据集上分别对KNN、DT、RF和SVM分类算法做了预试验,结果表明RF和SVM分类效果优于KNN和RF,这与多数研究人员的研究结果一致[31],因此,本研究选择机器学习分割算法中的RF和SVM。

2.3 深度学习语义分割算法

基于深度学习经典分类的卷积神经网络中有很多全连接层,而全连接层往往会给网络带来巨大的参数量。相比于卷积神经网络,全卷积神经网络把全连接层全部替换为反卷积层,参数量也少了很多,因此可以对遥感影像进行逐像素的语义分类,从而将深度学习方法应用于语义分割。本研究选用FCN_8s、SegNet、UNet、DeepLabv3+四种经典的语义分割模型完成研究区土地利用精准分类,这4种模型均为编码-解码结构,编码器主要由卷积层、池化层、激活函数等部件组成进行特征提取,对像素位置信息和输入图像特征进行编码;解码器主要由反卷积或反池化、激活函数等部件组成,反卷积或反池化将经过编码的低分辨率特征图解码为高分辨率的特征图,并得到最终的预测分割图。

2.4 基于DeepLabv3+模型的改进

本研究根据实际需求对机器学习分割算法和深度学习语义分割算法中表现最优的DeepLabv3+进行改进。DeepLabv3+是DeepLab系列模型的第四代产品,其与FCN_8s、SegNet、UNet相比最大的改进之处就是引入了空洞卷积空间金字塔池化(Atrous Spatial Pyramid Pooling,ASPP),ASPP增大了模型的感受野,不会造成信息损失,同时对不同层级特征进行融合,合并更多上下文信息。DeepLabv3+的骨干网络为Xception,Xception分为Entry flow、Middle flow 以及Exit flow三个部分。Entry flow前两层卷积层分别由32和64个3×3的卷积构成,紧随其后的是3个深度可分离卷积结构,每个深度可分离卷积结构由3层3×3的深度可分离卷积层构成,并在1×1的卷积层后进行跳跃连接;Middle flow由16个深度可分离卷积结构构成,不进行卷积操作直接进行跳跃连接;Exit flow由一个深度可分离卷积结构构成,在其后有3个3×3深度可分离卷积层。

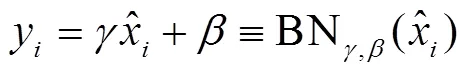

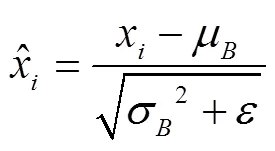

2.4.1 去掉DeepLabv3+中的BN层

批量归一化层(Batch Normalization,BN)专注于标准化任何特定层的输入,原始DeepLabv3+模型中的BN层计算过程如式(3)~(6)。首先计算样本均值,然后计算样本方差,其次进行样本数据标准化处理,最后进行平移和缩放处理。BN层在每次训练迭代时计算批量统计信息(batch_size的均值和方差),因此在训练时需要更大的batch_size,以便有效的逼近小批量的总体均值和方差[32]。本研究输入模型中的图像尺寸为1 024像素× 628像素,图像尺寸较大,而语义分割算法是逐像素点的分类,相应的所需参数量更大,因此在训练时设置的batch_size最大为2,其值较小,而较小的batch_size通过BN层计算出的均值和方差不足以代表整个数据分布,反而会导致最终的训练结果不佳。

据此,本文在原始DeepLabv3+模型的Xception部分中,把Entry flow中前2层单独卷积层后的BN层去掉;去掉Exit flow中后3层单独卷积层后的BN层;在ASPP中,去掉每一层空洞卷积层后的BN层。这使得模型更适用于本研究数据集,在batch_size较小时能得到较好结果,在训练时速度更快更稳定,且均值和方差的计算与训练集相差变小。

2.4.2 修改ASPP模块各层空洞率

DeepLabv3+给出的ASPP模块4层空洞率分别为1、6、12、18,是在COCO(Microsoft Common Objects in Context)数据集上进行试验分析得到的,这样组合设计目的是为了更好地适用于COCO数据集特点和使网络具有更大感受野[33],对一些大物体有较好的分割效果,而对小物体来说其效果还有待提高。该数据集在语义方面与遥感影像差距较大,因此原有的组合设计1、6、12、18并不适用于本研究语义丰富的遥感影像场景。

对于遥感影像这样组合设计的空洞率过大,较大的感受野反而不利于遥感图像中微小物体的分割。因此,如何调整ASPP模块中的空洞率,同时平衡好大小物体之间关系是空洞率组合设计的关键,本文将ASPP模块4层空洞率分别设置为1、3、6、9,修改后的ASPP如图3所示。

注:Conv表示卷积运算;rate表示空洞率。

重新组合后的空洞率从一定程度上降低了网络的感受野,同时处理好了大小物体之间的敏感度。减小空洞率使采样输入信号更密集,缓解了卷积失效,提高了网络对小物体的分割效果。

2.5 试验环境与模型训练

模型训练的电脑参数:NVIDIA GeForce RTX 3090 显卡24 GB 显存,64 GB 内存,6T硬盘,Intel(R) Core(TM) i7-9700K CPU @ 3.60GHz。本研究使用Pytorch 1.7.0框架搭建深度学习语义分割网络,使用的深度神经网络GPU加速库版本和CUDA版本分别为8.0.5和11.0,初始学习率设为1×10-4,选用Adam优化器,使用交叉熵损失函数,以2幅图像为1个批次(batch)进行100次完整迭代,为防止训练后期学习率过大导致网络参数错过全局最优解,调整策略为每迭代30个epoch之后,学习率变为原来的0.5倍,权重衰减率10-4,动量0.9。

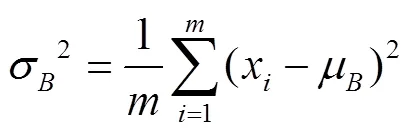

机器学习分割算法SVM和RF本研究均应用Python语言的第三方机器学习库sklearn和计算机视觉库skimage、numpy实现分割过程。SVM分类算法实现基于libsvm[34],libsvm是mayank等开发的一个调试使用SVM的软件包,该软件包提供了很多默认参数,利用该软件包可以较快速地进行支持向量机相关的试验,利用函数自带的参数可以对很多问题进行快速调试。训练时SVM参数设置如表1所示,SVM模型训练函数为

model = SVC(=1.0, kernel='rbf', degree=3, gamma='auto_deprecated', coef0=0.0, shrinking=True, probability=False, tol=0.001, cache_size=200, class_weight=None, verbose=False, max_iter=-1, decision_function_shape='ovr', random_state=None).fit(X, y) (7)

表1 SVM模型训练参数

训练时RF参数设置如表2所示,RF模型训练函数为

model = RandomForestClassifier(n_estimators=250, max_depth=12, min_samples_split=2, min_samples_leaf=1, min_weight_fraction_leaf=0.0, max_features="auto", max_leaf_nodes=None, min_impurity_decrease=0.0, bootstrap=True, oob_score=True, n_jobs=None, random_state=42, verbose=0, warm_start=False, class_weight=None, ccp_alpha=0.0, max_samples=None,).fit(X, y) (8)

表2 RF模型训练参数

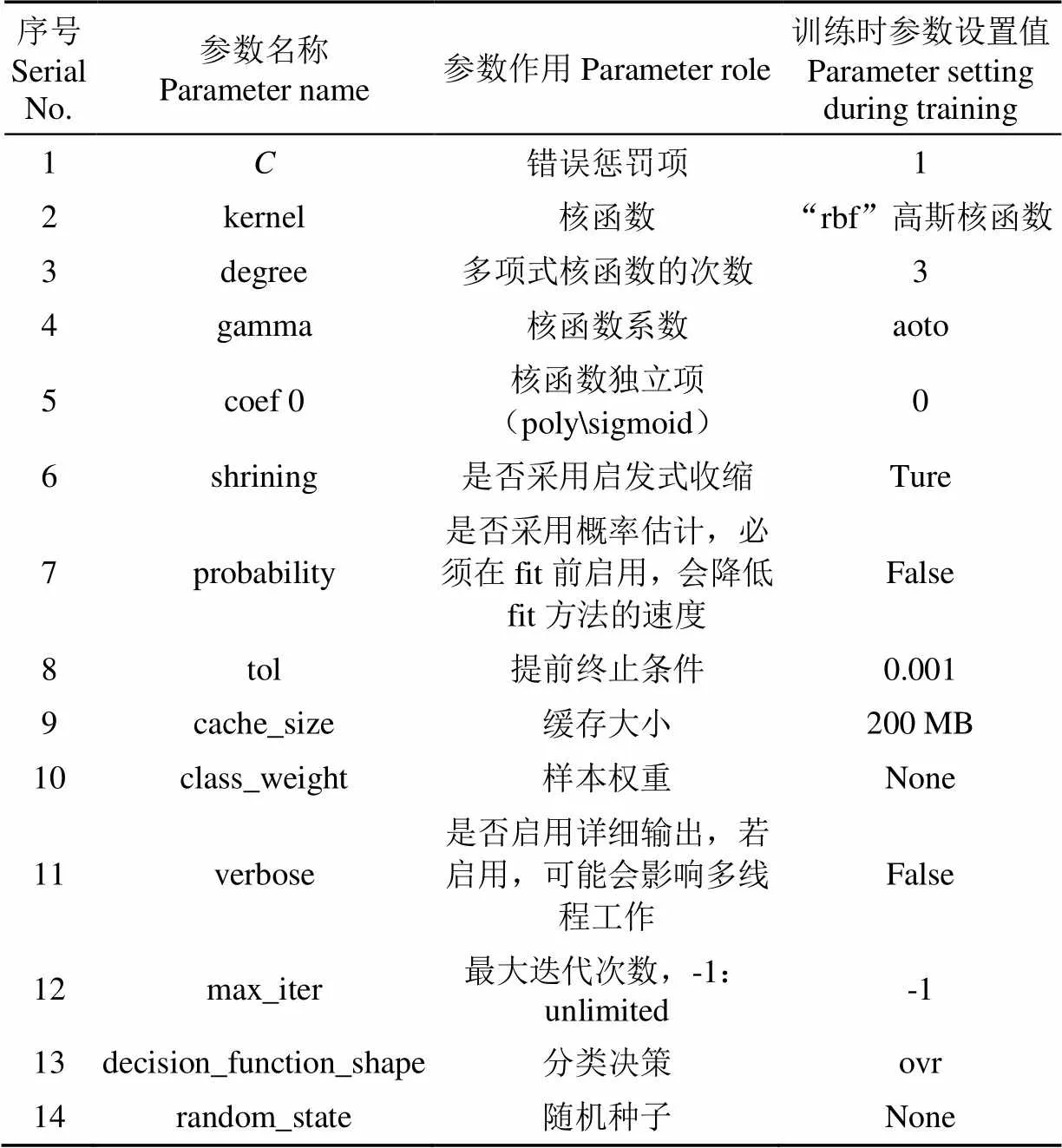

2.6 评价指标

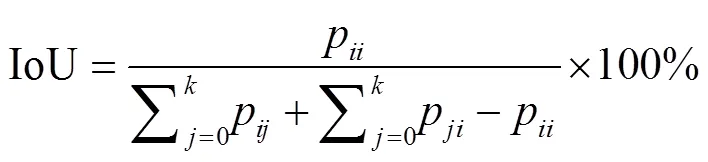

为了客观合理地评价语义分割模型在无人机土地利用影像上的分类与分割精度,本研究采用ISPRS提供的评价指标,像素精度(Pixel Accuracy,PA)、各类别交并比(Intersection over Union,IoU)、平均交并比(Mean Intersection over Union,MIoU)、各类别精度(Class Accuracy,CA),平均类别精度(Mean Class Accuracy,MCA),F1值,计算式分别为

式中表示目标的类别数,共有+1个类别(含目标和背景);、均表示类别号;p正确分类的像素;p和p均表示分类错误的像素;F1值是查准率precision和查全率recall的调和平均值。以上指标能较好地反映不同利用类型土地利用区域上分割的准确性和完整性。

3 结果与分析

本节的结果与分析均在160 m高度的数据集上进行,80 m高度的数据集和160 m高度的数据集不同航拍高度对模型分类性能的影响放在第“4”节讨论中进行分析。

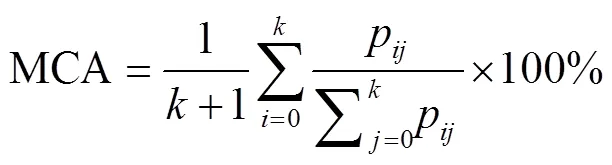

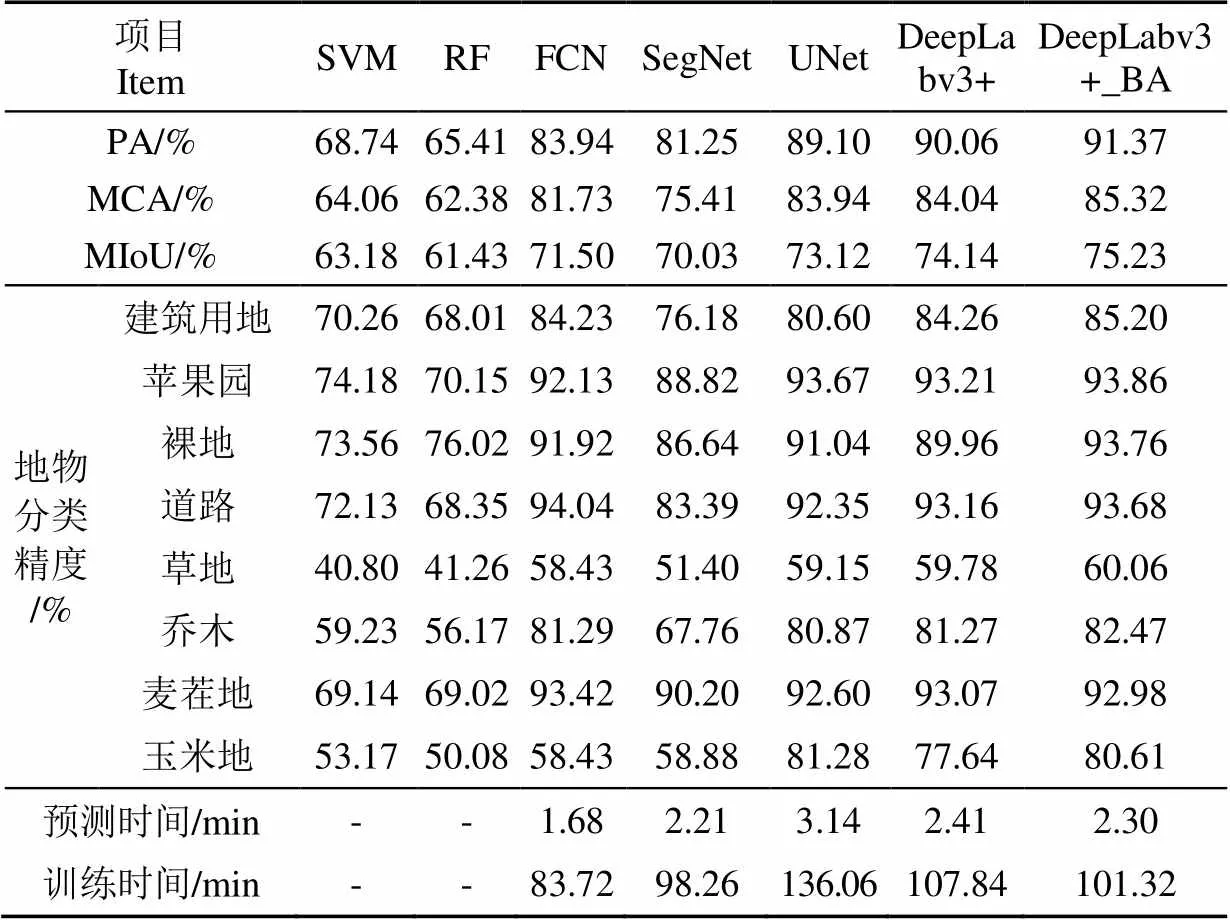

3.1 模型对比分析

本研究将经过改进后的DeepLabv3+命名为DeepLabv3+_BA。在测试集上对7种模型的分类结果进行精度评价,及基于深度学习方法所需训练和预测时间对5种深度学习模型性能进一步进行分析评价,结果如表3和表4所示。由表中结果可知,这7种方法均能识别研究区土地利用类型,但深度学习方分类精度普遍优于机器学习方法,其中,DeepLabv3+模型的像素精度为90.06%,比机器学习模型SVM和RF分别高出21.32和24.65个百分点;DeepLabv3+_BA模型的像素精度为91.37%,比机器学习模型SVM和RF分别高出22.63和25.96个百分点。

表3 不同模型的分类精度和训练预测时间

注:PA表示像素精度,MCA表示平均类别精度,MIoU表示平均交并比。下同。

Note: PA represents Pixel Accuracy, MCA represents Mean Class Accuracy, MIoU represents Mean Intersection over Union. Same as below.

横向对比可以看出,不同模型的同一种评价指标和同一种地物类型的分类精度差别较大。其中,本研究改进模型DeepLabv3+_BA的平均交并比最高为75.23%,比SVM、RF、FCN、SegNet、UNet和DeepLabv3+分别高出12.05、13.8、3.73、5.20、2.11和1.09个百分点。深度学习模型FCN、SegNet、UNet、DeepLabv3+及DeepLabv3+_BA的像素精度PA和平均类别精度明显优于机器学习模型SVM和RF,且深度学习模型除SegNet的平均类别精度为75.41%外,其余深度学习模型的像素精度和平均类别精度均稳定在80%以上。表明将深度学习方法用于基于无人机可见光影像的土地利用分类相比于传统机器学习方法更有优势。

表4 不同模型在不同类别上的F1值

纵向对比可以看出,同一模型在不同地物类型上表现也有所不同。其中,不同模型在苹果园这一地物上分类精度较高,DeepLabv3+_BA的精度为93.86%;不同模型在草地这一类别分类精度较低。造成这种现象的原因是不同地物类型有不同的特征和边界条件,且同一种模型对不同地物类型的敏感程度也不同。苹果园在影像上高程较高,与周围地物差别较大易于区分,而草地低矮,与周围的玉米地、乔木等在形态和纹理上差别较小,容易造成错分漏分。实际分类影像中各类别占比也不同,本文使用计算机视觉开源库numpy 1.21.3和Pillow 8.4.0对训练时各类别样本数量占比关系进行计算和统计,统计结果如下:分类精度较高的苹果园在模型训练时占比也较高,为29.98%,其余各类别占比分别为建筑用地(10.64%)、裸地(9.45%)、道路(9.58%)、草地(9.60%)、乔木(8.20%)、麦茬地(12.74%)和玉米地(9.81%)。

3.2 分类效果分析

图4为不同深度学习模型训练时在8种类别上的精度随迭代次数变化和训练损失曲线变化。由图4可知,随着训练轮数的增加,不同深度学习模型在8种类别上的精度数值均逐渐收敛,其中DeepLabv3+_BA在训练集模型预测建筑用地、苹果园、裸地、道路、草地、乔木、麦茬地、玉米地分别为98.80%、99.47%、99.54%、98.14%、98.89%、99.28%、98.82%,训练集和验证集模型预测平均交并比分别为93.83%、92.71%,训练集和验证集模型预测损失值分别为0.045和0.043。FCN、SegNet、UNet、DeepLabv3+在训练集上平均交并比分别为84.61%、89.00%、86.87%、91.77%。说明5种深度学习模型在设置相同超参数时均能被正确训练。

从图4可以看出,8种土地利用类型中,苹果园在不同模型开始训练时精度最高且收敛速度最快;5种深度学习模型第一次训练后损失值最小的为DeepLabv3+_BA且其相较于其他4种深度学习模型收敛速度最快。5种深度学习模型对建筑用地、麦茬地和苹果园这3种地物分类效果较好,在迭代20次之后,5种模型均达到收敛,说明深度学习模型在训练时能够快速正确地学习到这3种地物的特征。相对而言,不同模型对于草地和裸地分类效果还存在不足,主要是由于这两种地物分布于农田边缘、道路及水渠两侧的洼地里,地势较低,且形态特征不易被区分,造成深度学习模型训练时对这两种地物有效特征的学习难度加大。SegNet模型在训练时对于各类均会出现精度突然下降的凹点,与损失曲线突然上升的凸点相对应,其原因是由于该模型与其他4种深度学习模型相比使用的是“Sigmoid”作为全局激活函数而非“ReLU”,这会导致模型在训练时激活范围过大,造成梯度消失弥散,从而损失曲线表现出震荡的变化规律。

图4 不同类别精度和不同模型训练损失值

FCN、UNet、SegNet、DeepLabv3+和DeepLabv3+_BA其模型主结构均为编码-解码结构。他们编码器的主要功能都是进行特征提取,主要区别在解码器和上采样操作的不同。FCN上采样时是以像素相加的方式进行特征融合,用这种方式直接进行上采样会导致对细节提取不够精细;UNet是以通道数进行拼接以形成更厚的特征,这会造成特征冗余和消耗更多显存;SegNet在解码器和上采样中的最大改进是将最大池化指数转移至解码器中,这虽然改善了分割分辨率,但其评价指标并不如FCN。以上3种语义分割算法均没有充分考虑像素与像素之间的关系,忽略了在通常的基于像素分类的分割方法中使用的空间规整步骤,缺乏空间一致性。DeepLabv3+在解码器和编码器之间引入ASPP,优化了网络对不同空间尺度的目标分割效果,使网络具有了更强的表征能力,DeepLabv3+也参考了目标检测中非常常见的特征融合策略,使网络保留了比较多的浅层信息。本研究基于DeepLabv3+改进得到的DeepLabv3+_BA去掉了编码器和ASPP中的BN层,并对空洞率组合进一步优化,让其更加适用于语义丰富的遥感影像场景。以上模型的不同特点,也决定了它们最终结果的不同表现。

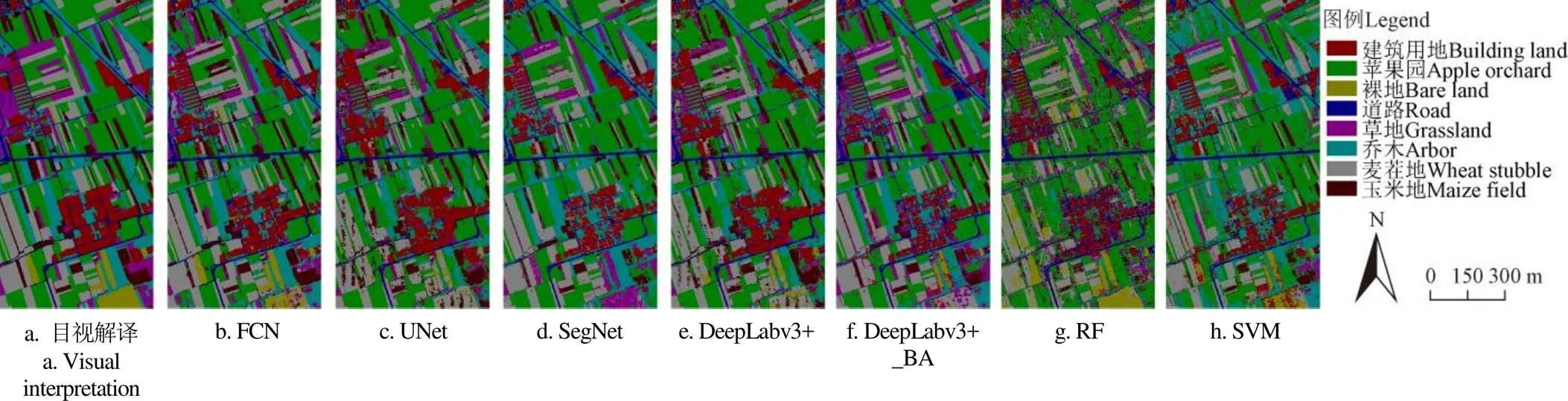

研究区不同模型和目视解译分类结果如图5所示。从研究区分类效果图看,深度学习模型FCN、UNet、SegNet、DeepLabv3+和DeepLabv3+_BA分类出的各种地物地块边界较为完整,其分类效果整体上要好于机器学习模型SVM、RF。从全图来看,DeepLabv3+_BA算法的误分小斑块最少,RF和SVM虽然同为机器学习方法,但RF的误分小斑块较多,为所有模型之最,且有区域性误分现象。从类别来看,在5种深度学习模型中,苹果园误分小斑块数量明显少于其他地物,其原因可能与苹果园的种植模式、冠层形态及物候等因素有关,苹果园为人工种植,具有固定的行距与株距,苹果6月下旬处于果实膨大期,该时期较易识别;虽然小麦和玉米为机械直播式,也具有固定的行距和株距,但小麦收割后的麦茬杂乱无序,且颜色与裸地较为相似,容易造成错分和漏分,玉米6月下旬处于拔节期,长势稀疏,冠层低矮,未到最佳识别期。

图5 研究区不同模型和目视解译分类结果

4 讨 论

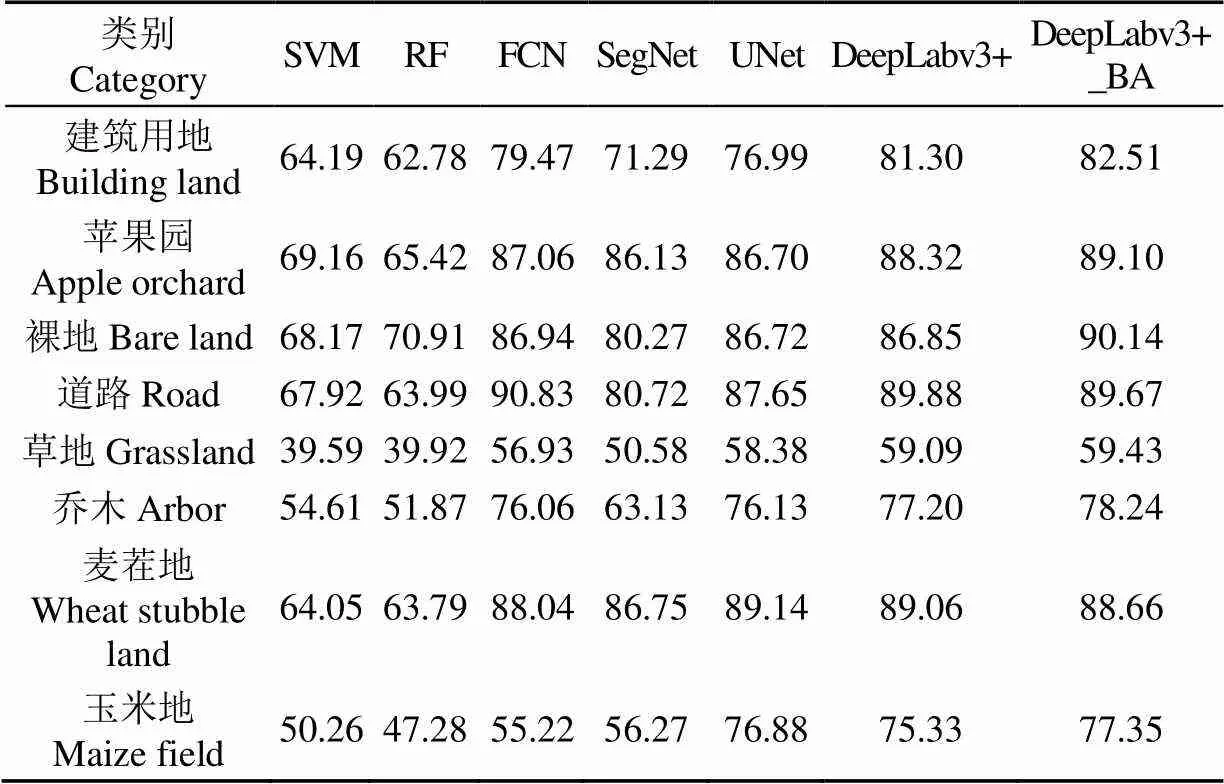

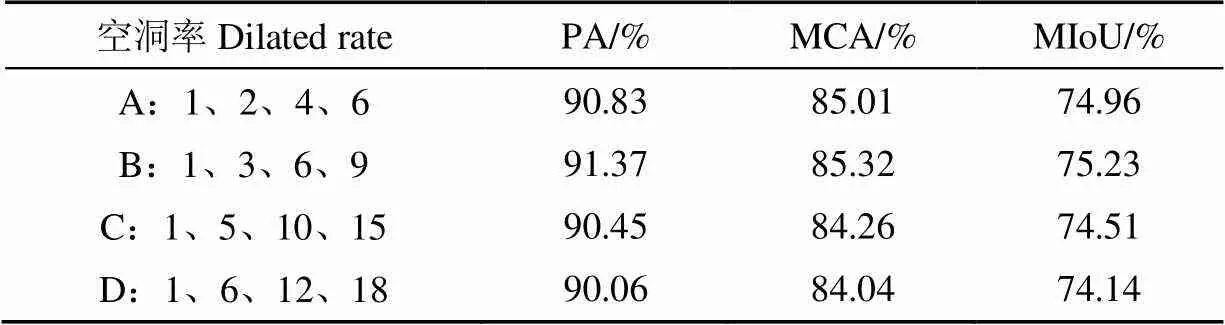

通过不同模型在测试集上分类结果可以看出,表现最好的为DeepLabv3+模型,因此在DeepLabv3+的基础上对算法进行改进,在“2.4.1”的改进下,对ASPP中空洞率进行调整。试验中不同组合空洞率选择为1、2、4、6,1、3、6、9,1、5、10、15,1、6、12、18四类进行试验。不同组合空洞率分类结果如表5所示。从分类结果可以看出,A、B两组在像素精度、平均类别精度、平均交并比上均高于C、D两组,但最小空洞率组合A组和最大空洞率组合D组其结果都不是最佳。B组的像素精度、平均类别精度、平均交并比均高于其他3组,因此最终选择空洞率组合为1、3、6、9的ASPP模块。

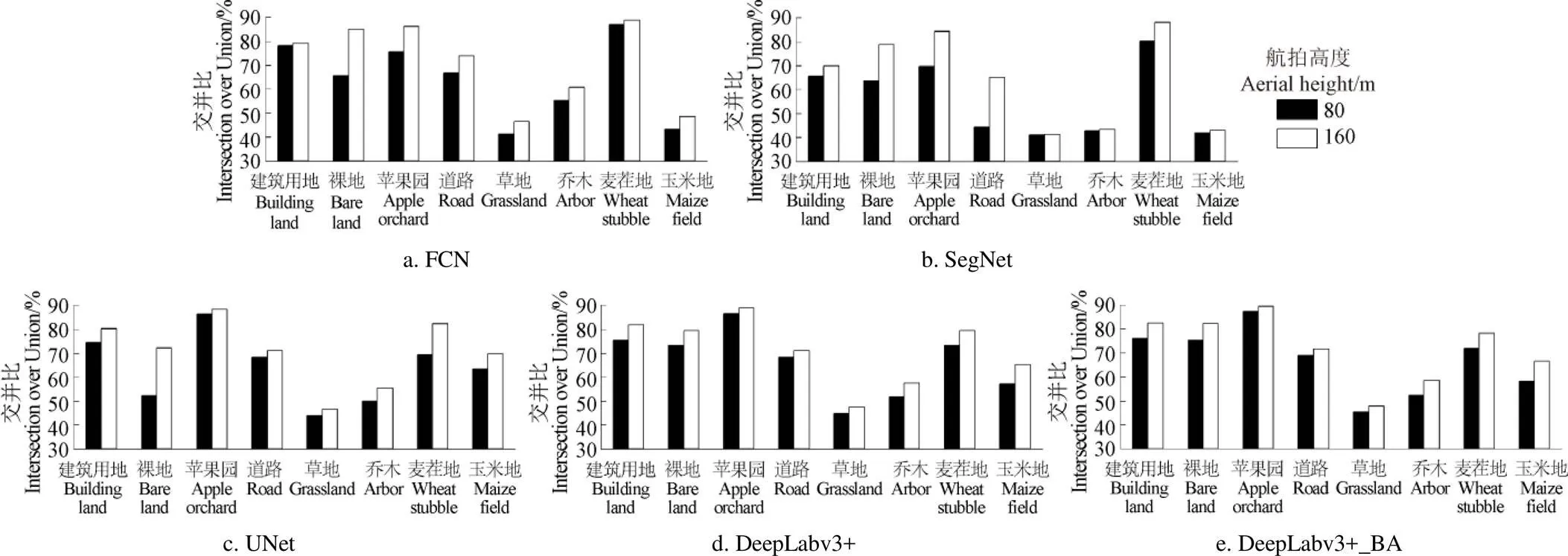

因为不同航拍高度获取的原始相片空间分辨率和视野大小都不同,基于不同航拍高度制作的训练样本,会对模型精度有不同影响[33-34]。而航拍高度高低直接影响土地利用调查时地工作效率,如果航拍高度过低,对同一任务区而言,就需要规划并执行更多小测区任务,才能对任务区进行完整航拍;如果航拍高度太高,原始相片中地物类型就会较难区分,给目视解译带来困难。因此,本研究设置80和160 m两种高度分别进行航拍,探明不同高度对模型精度的影响,结果如图6所示。虽然80 m高度的数据集分辨率高于160 m,但160 m高度时,各深度学习模型分类效果均好于80 m。其原因可能是由于同一张原始相片,160 m具有更大视野,此时相片中地物大小也较为适中。更大视野的相片输入模型训练时,会使模型具有更大的感受野,更大感受野的相片在经过一系列卷积池化操作后形成的特征图会保留有更多有效信息,对模型精度有正反馈影响。

表5 不同组合空洞率分类结果

图6 不同高度对模型分类性能的影响

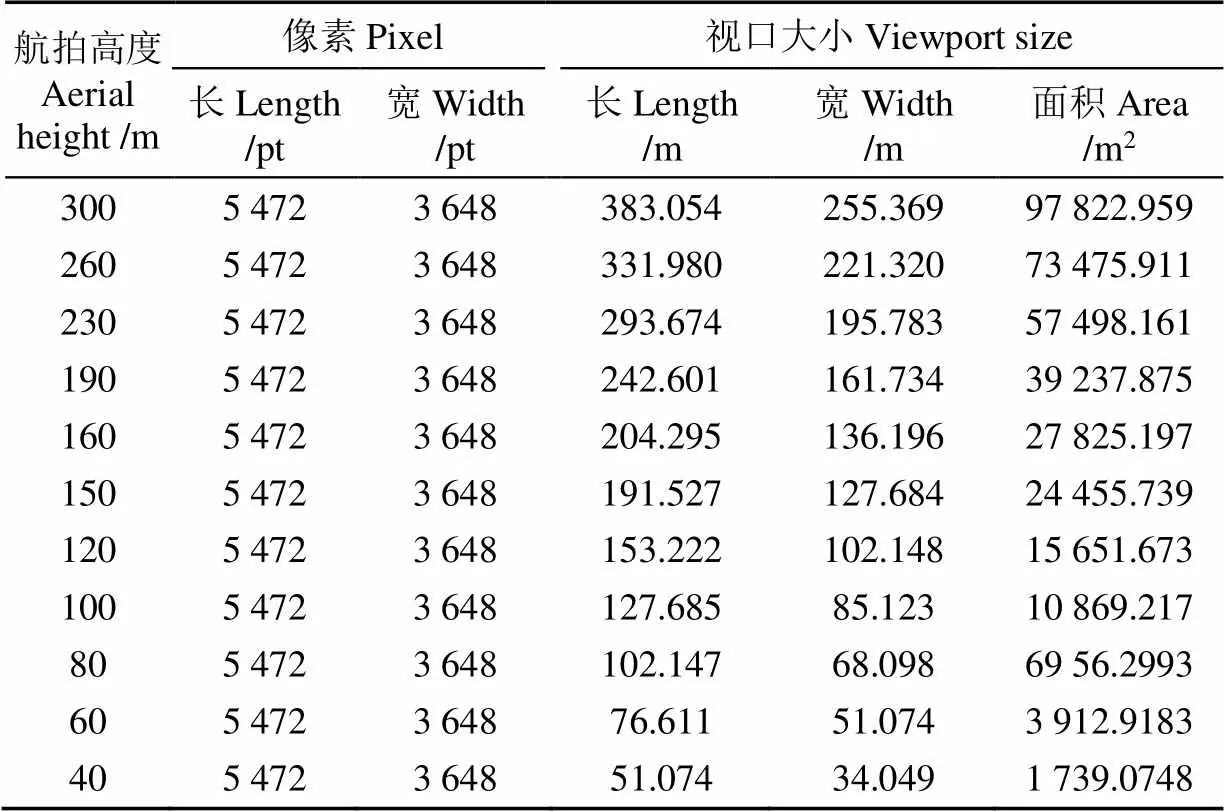

无人机航拍高度与视口面积、视口长度和视口宽度之间的关系如表6所示[35-36]。获取同一区域的DOM,较高的航拍高度相比低高度飞行时设置同样的航向重叠度和旁向重叠度,其航片数量就越少,工作效率就越高,如本研究80 m高度航片数量为2 248张,而160 m仅为502 张,其效率大大提高,但较高的航拍高度会导致较低的分辨率,低分辨率会给目视解译带来困难,进而影响模型精度。对黄土高原的多个地区,如通渭、正宁、扶风、长武、耀州、白水、洛川、延安、子州、绥德、米脂和灵宝等地,利用无人机采取过多种航拍高度对样点进行航拍,高度有40、60、80、100、120、150、160、190、230、260、300 m,发现超过200 m时目视解译时某些地物类型难以区分。因此,在基于无人机影像和深度学习模型进行土地利用分类时,建议采用150~200 m作为航拍高度,此时可以较好地权衡航拍效率和模型精度。

表6 航拍高度与视口长度、宽度和面积之间关系

注:大疆御2Pro的FOV值为75°。

Note: The FOV value of DJI Mavic 2Pro is 75°.

5 结 论

本文基于无人机获取的高分辨率可见光影像,充分利用丰富的空间、纹理和色彩信息构建了用于机器学习和深度学习算法训练的不同高度数据集,训练多种分类模型,并进行精度评价,筛选出表现最优的模型为DeepLabv3+,结合本研究数据集特点改进和优化其模型结构,获得了基于无人机可见光影像的渭北旱塬区土地利用最佳分类模型DeepLabv3+_BA,主要结论如下:

1)本文所用的7种分类方法均能识别研究区土地利用类型,但深度学习方法各精度指标均优于机器学习方法,其中像素精度、平均类别精度、平均交并比整体上平均比机器学习方法分别高出20%、18%、10%以上。

2)DeepLabv3+在所用深度学习方法中分类效果最佳。结合本研究数据集特点,从两个方面对DeepLabv3+进行改进,去掉DeepLabv3+中的批归一化层和修改ASPP模块各层空洞率,得到DeepLabv3+_BA,其各精度指标、训练和预测所花费时间都优于改进前。

3)5种深度学习方法对苹果园、裸地、道路和麦茬地等土地利用类型分类效果较好,且5种深度学习方法的像素精度均稳定在80%以上。深度学习方法可以很好地用于无人机可见光影像土地利用分类,后续可结合不同地区土地利用特点和多时相影像分析进一步提升分类精度。

[1] 刘舒,朱航. 基于超高空间分辩率无人机影像的面向对象土地利用分类方法[J]. 农业工程学报,2020,36(2):87-94.

Liu Shu, Zhu Hang. Object-oriented land use classification based on ultra-high resolution images taken by unmanned aerial vehicle[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(2): 87-94. (in Chinese with English abstract)

[2] Gudmann A, Csikos N, Szilassi P, et al. Improvement in satellite image-based land cover classification with landscape metrics[J]. Remote Sensing, 2020, 12(21): 2072-4292.

[3] Alhassan V, Henry C, Ramanna, S, et al. A deep learning framework for land-use/land-cover mapping and analysis using multispectral satellite imagery[J]. Neural Computing & Applications, 2020, 32(12): 8529-8544.

[4] 戴建国,张国顺,郭鹏,等. 基于无人机遥感可见光影像的北疆主要农作物分类方法[J]. 农业工程学报,2018,34(18):122-129.

Dai Jianguo, Zhang Guoshun, Guo Peng, et al. Classification method of main crops in northern Xinjiang based on UAV visible waveband images[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(18): 122-129. (in Chinese with English abstract)

[5] 李冰,梁燕华,李丹丹,等. 多时相GF-1卫星PMS影像提取农作物种植结构[J]. 中国农业资源与区划,2017,38(9):56-62.

Li Bing, Liang Yanhua, Li Dandan, et al. Crop planting structure extraction based on multi-temporal GF-1 PMS remote sensing images[J]. Journal of China Agricultural Resources and Regional Planning, 2017, 38(9): 56-62. (in Chinese with English abstract)

[6] 郭鹏,武法东,戴建国,等. 基于无人机可见光影像的农田作物分类方法比较[J]. 农业工程学报,2017,33(13):112-119.

Guo Peng, Wu Fadong, Dai Jianguo, et al. Comparison of farmland crop classification methods based on visible light images of unmanned aerial vehicles[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2017, 33(13): 112-119. (in Chinese with English abstract)

[7] 韩文霆,郭聪聪,张立元,等. 基于无人机遥感的灌区土地利用与覆被分类方法[J]. 农业机械学报,2016,47(11):270-277.

Han Wenting, Guo Congcong, Zhang Liyuan, et al. Classification method of land cover and irrigated farm land use based on UAV remote sensing in irrigation[J]. Transactions of the Chinese Society of Agricultural Machinery, 2016, 47(11): 270-277. (in Chinese with English abstract)

[8] 顾铮鸣,金晓斌,杨晓艳,等. 基于无人机遥感影像监测土地整治项目道路沟渠利用情况[J]. 农业工程学报,2018,34(23):85-93.

Gu Zhengming, Jin Xiaobin, Yang Xiaoyan, et al. Monitoring roads and canals utilization condition for land consolidation project based on UAV remote sensing image[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(23): 85-93. (in Chinese with English abstract)

[9] 田琳静,宋文龙,卢奕竹,等. 基于深度学习的农业区土地利用无人机监测分类[J]. 中国水利水电科学研究院学报,2019,17(4):312-320.

Tian Linjing, Song Wenlong, Lu Yizhu, et al. Rapid monitoring and classification of land use in agricultural areas by UAV based on deep learning method[J]. Journal of China Institute of Water Resources and Hydropower Research, 2019, 17(4): 312-320. (in Chinese with English abstract)

[10] 李楠,朱秀芳,潘耀忠,等. 人工蜂群算法优化的SVM遥感影像分类[J]. 遥感学报,2018,22(4):559-569.

Li Nan, Zhu Xiufang, Pan Yaozhong, et al. Optimized SVM based on artificial bee colony algorithm for remote sensing image classification[J]. National Remote Sensing Bulletin, 2018, 22(4): 559-569. (in Chinese with English abstract)

[11] 马玥,姜琦刚,孟治国,等. 基于随机森林算法的农耕区土地利用分类研究[J]. 农业机械学报,2016,47(1):297-303.

Ma Yue, Jiang Qigang, Meng Zhiguo, et al. Random forest classification of land use in farming area[J]. Transactions of the Chinese Society for Agricultural Machinery, 2016, 47(1): 297-303. (in Chinese with English abstract)

[12] 耿仁方,付波霖,蔡江涛,等. 基于无人机影像和面向对象随机森林算法的岩溶湿地植被识别方法研究[J]. 地球信息科学学报,2019,21(8):1295-1306.

Geng Renfang, Fu Bolin, Cai Jiangtao, et al. Object-based karst wetland vegetation classification method using unmanned aerial vehicle images and random forest algorithm[J]. Journal of Geo-information Science, 2019, 21(8): 1295-1306. (in Chinese with English abstract)

[13] 高晗. 基于SVM的图像分类算法[D]. 长春:吉林大学,2019.

Gao Han. lmage Classification Based on SVM[D]. Changchun: Jilin University, 2019. (in Chinese with English abstract)

[14] LeCun Y, Bengio Y, Hinton G. Deep learning[J]. Nature, 2015,521(7553): 436-444.

[15] Shelhamer E, Long J, Darrell T. Fully convolutional networks for semantic segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 37(4): 640-651.

[16] Badrinarayanan V, Kendall A, Cipolla R. SegNet: A deep convolutional encoder-decoder architecture for image segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(12): 2481-2495.

[17] Ronneberger O, Fischer P, Brox T. U-Net: Convolutional networks for biomedical image segmentation[C]. International Conference on Medical Image Computing and Computer-assisted Intervention. Springer, Cham 2015, 234-241.

[18] Chen L C, Zhu Y, Papandreou G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation[C]//2018 European Conference on Computer Vision (ECCV), 2018: 801-818.

[19] 郭庆华,金时超,李敏,等. 深度学习在生态资源研究领域的应用:理论、方法和挑战[J]. 中国科学(地球科学),2020,50(10):1354-1373.

Guo Qinghua, Jin Shichao, Li Mi, et al. Application of deep learning in ecological resource research: Theories, methods, and challenges[J]. Scientia Sinica(Terrae), 2020, 50(10): 1354-1373. (in Chinese with English abstract)

[20] Zhang L, Zhang L, Du B. Deep learning for remote sensing data a technical tutorial on the state of the art[J]. IEEE Geoscience and Remote Sensing Magazine, 2016, 4(2): 22-40.

[21] 冯权泷,牛博文,朱德海,等. 土地利用/覆被深度学习遥感分类研究综述[J]. 农业机械学报,2022,53(3):1-17.

Feng Quanlong, Niu Bowen, Zhu Dehai, et al. Review for deep learning in land use and land cover remote sensing classification[J]. Transactions of the Chinese Society of Agricultural Machinery, 2022, 53(3): 1-17. (in Chinese with English abstract)

[22] 刘文萍,赵磊,周焱,等. 基于深度学习的无人机土地覆盖图像分割方法[J]. 农业机械学报,2020,51(2):221-229.

Liu Wenping, Zhao Lei, Zhou Yan, et al. Deep learning based unmanned aerial vehicle land cover image segmentation method[J]. Transactions of the Chinese Society of Agricultural Machinery, 2020, 51(2): 221-229. (in Chinese with English abstract)

[23] 田琳静,宋文龙,卢奕竹,等. 基于深度学习的农业区土地利用无人机监测分类[J]. 中国水利水电科学研究院学报,2019,17(4):312-320.

Tian Linjing, Song Wenlong, Lu Yizhu, et al. Rapid monitoring and classification of land use in agricultural areas by UAV based on deep learning method[J]. Journal of China Institute of Water Resources and Hydropower Research, 2019, 17(4):312-320. (in Chinese with English abstract)

[24] 王协,章孝灿,苏程. 基于多尺度学习与深度卷积神经网络的遥感图像土地利用分类[J]. 浙江大学学报(理学版),2020,47(6):715-723.

Wang Xie, Zhang Xiaocan, Su Cheng. Land use classification of remote sensing images based on multi-scale learning and deep convolution neural network[J]. Journal of Zhejiang University(Science Edition), 2020, 47(6): 715-723. (in Chinese with English abstract)

[25] Zhao W, Du S. Spectral-spatial feature extraction for hyperspectral image classification: A dimension reduction and deep learning approach[J]. IEEE Transactions on Geoscience and Remote Sensing, 2016, 54(8): 4544-4554.

[26] 陶翊婷. 基于深度学习的高空间分辨率遥感影像分类方法研究[D]. 武汉:武汉大学,2019.

Tao Yiting. Research on Very High Spatial Resolution Remote Sensing Image Classification Method based on Deep Learning[D]. Wuhan: Wuhan University, 2019. (in Chinese with English abstract)

[27] 孙显,付琨,王宏琦. 高分辨率遥感图像理解[M]. 北京:科学出版社,2011:225-260.

[28] Sun W, Wang R. Fully convolutional networks for semantic segmentation of very high resolution remotely sensed images combined with DSM[J]. IEEE Geoscience and Remote Sensing Letters, 2018, 15(3): 474-478.

[29] 董红梅,赵景波,宋友桂,等. 黄土高原白水县不同种植年限苹果园土壤重金属含量特征与风险评价[J]. 水土保持研究,2021,28(5):205-211.

Dong Hongmei, Zhao Jingbo, Song Youjia, et al. Characteristics and risk assessment of heavy metal content in soils of apple orchard with different cultivating years in Baishui County on the Loess Plateau[J]. Research of Soil and Water Conservation, 2021, 28(5): 205-211. (in Chinese with English abstract)

[30] 夏利恒,刘京,尉芳,等. 陕西渭北旱塬区耕地时空格局变化分析[J]. 农业工程学报,2021,37(5):256-264.

Xia Liheng, Liu Jing, Wei Fang, et al. Spatiotemporal pattern change of cultivated land in Weibei Dryland of Shaanxi Province[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(5): 256-264. (in Chinese with English abstract)

[31] Fernandez-Delgado M, Cernadas E, Barro S, et al. Do we need hundreds of classifiers to solve real world classification problems?[J]. Journal of Machine Learning Research, 2014, 15: 24-31.

[32] Ioffe S, Szegedy C. Batch normalization: Accelerating deep network training by reducing internal covariate shift[C]. International Conference on Machine Learning, 2015: 448-456.

[33] 熊风光,张鑫,韩燮,等. 改进的遥感图像语义分割研究[J]. 计算机工程与应用,2022,58(8):185-190.

Xiong Fengguang, Zhang Xin, Han Xie, et al. Research on lmproved semantic segmentation of remote sensing[J]. Computer Engineering and Applications, 2022, 58(8): 185-190. (in Chinese with English abstract)

[34] Mayank S, Sumit S, Jayadeva J. Minimal complexity machines under weight quantization[J]. IEEE Transactions on Computers, 2021, 70(8): 1189-1198.

[35] 姚莉娜,郑皓科,廖辰靖,等. 无人机航拍的最佳飞行高度研究[J]. 机电信息,2020(11):114-115.

Yao Lina, Zheng Haoke, Liao Chenjing, et al. Study on the optimal flying altitude of UAV aerial photography[J]. Mechanical and Electrical Information, 2020(11): 114-115. (in Chinese with English abstract)

[36] 孙坤君,王朝,陈胜军,等. 无人机高度与视口率定的快速量测[J]. 中国水土保持科学,2022,20(3):81-87.

Sun Kunjun, Wang Chao, Chen Shengjun, et al. Rapid measurement of UAV height and Viewport calibration[J]. Science of Soil and Water Conservation, 2022, 20(3): 81-87. (in Chinese with English abstract)

Precise classification of land use in Weibei Dryland using UAV images and deep learning

Zhang Zhibo1, Zhao Xining2, Jiang Haichen3,Yuan Hao4, Yang Long5, Gao Xiaodong2※, Shi Liangliang4, Niu Yuting3

(1.,,,712100,;2.,,712100,;3.,,712100,;4.,,712100,;5.,,712100,)

Accurate land use classification is highly required using Unmanned Aerial Vehicle (UAV) images, especially the data selection. In this study, the UAV orthographic remote sensing images were acquired at different aerial heights in Tongji Village, Baishui County, Weibei dry land, China. The land use was then classified using a variety of deep learning and machine learning. The DJI Mavic 2Pro was used to obtain 80 and 160m aerial images in the study area. There were 96 routes, the total length of routes was 42.43 km, the heading overlap degree was 75%, the side overlap degree was 60%, and a total of 2 248 original aerial photos were taken at a flight height of 80 m. At 160 m flight height, there were 20 routes with a total length of 17.90 km, the heading overlap degree was 70%, the side overlap degree was 55%, and a total of 502 original aerial images were taken in this case. The geo-positioning of the photo control points was performed on the Zhuolin A8 handheld Beidou GPS locator. Agisoft PhotoScan 1.4.5 software was used to splice and process the original single-image data. A comparison was made on the visual interpretation of different aerial photography heights and the prediction of various deep learning and machine learning models. Labelme4.5.6 software was used for the visual interpretation. As such, the best performance was achieved during this time. The results show that the performance of deep learning was far better than that of traditional machine learning. The best-performing of deep learning (DeepLabv3+) presented a pixel accuracy of 90.06%, which was 24.65, and 21.32 percentage points higher than that of random forest (RF) and support vector machine (SVM), respectively. The improved DeepLabv3+_BA model performed the best overall classification. The improvement of deep learning was attributed to two aspects. Firstly, the BN layer was removed after the first two separate convolution layers in the Entry flow in the encoder Xception part of the original DeepLabv3+ model. The BN layer was removed in ASPP after the last three separate convolutional layers in the Exit flow. The BN layer was removed after each dilated convolutional layer. Secondly, the ASPP atrous rate combination design was re-optimized, according to the characteristics of the data set. The pixel accuracy of the improved model was 91.37%, which was 7.43, 10.12, 2.27, and 1.31 percentage points higher than those of FCN, SegNet, UNet, and DeepLabv3+, respectively. The number of iterations required for the best accuracy was reduced by about 50%, compared with the other four deep-learning models. Taking the extraction of apple orchard as an example, the F1 value of DeepLabv3+_BA was 89.10%, which was 19.94, 23.68, 2.04, 2.97, 2.4, and 0.78 percentage points higher than those of SVM, RF, FCN, SegNet, UNet, and DeepLabv3+, respectively. The accuracy of various algorithms was higher than 80 m on 160 m datasets. The performance of various deep learning on the test set demonstrated that the accuracy of DeepLabv3+_BA reached more than 90% for the apple orchard, bare field, stubble field, and road ground object classification. The improved model DeepLabv3+_BA presented higher accuracy and robustness of ground object classification. This finding can also provide a strong reference for the land use information census using UAV images and deep learning.

UAV; remote sensing; land use; visible light image; deep learning; machine learning

10.11975/j.issn.1002-6819.2022.22.022

TP79

A

1002-6819(2022)-22-0199-11

张志博,赵西宁,姜海晨,等. 基于无人机影像和深度学习的渭北旱塬区土地利用精准分类[J]. 农业工程学报,2022,38(22):199-209.doi:10.11975/j.issn.1002-6819.2022.22.022 http://www.tcsae.org

Zhang Zhibo, Zhao Xining, Jiang Haichen, et al. Precise classification of land use in Weibei Dryland using UAV images and deep learning[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(22): 199-209. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2022.22.022 http://www.tcsae.org

2022-09-22

2022-11-09

国家重点研发计划项目(2021YFD1900700);国家杰出青年科学基金项目(42125705)

张志博,博士生,研究方向为农业遥感技术与图像分割。Email:zhang_zhibo@nwafu.edu.cn

高晓东,研究员,博士生导师,研究方向为旱区农田水土过程与调控。Email:gao_xiaodong@nwafu.edu.cn