基于改进Mask R-CNN的水稻茎秆截面参数检测方法

2022-02-08张高亮刘兆朋刘木华陈雄飞梁学海

张高亮 刘兆朋 刘木华 方 鹏 陈雄飞 梁学海

(江西农业大学工学院, 南昌 330045)

0 引言

维管束作为一种木质部和韧皮部束状排列的组织结构,在水稻茎秆、叶片中广泛存在[1-2]。水稻维管束是水分、离子和有机养分运输的重要通道,同时与光合产物的输送息息相关,在水稻产量形成过程中扮演重要角色[3-4]。同时,水稻维管束微观结构也与其茎秆的力学特性密切相关,对作物的抗倒伏能力有重要影响[5-6]。因此,水稻茎秆维管束微观结构特征的测量分析,对筛选培育高产抗倒伏水稻品种有重要作用[6],同时可为相关作业机械的开发设计提供理论依据[7-8]。

利用显微成像技术对作物茎秆进行切片观察是一种主要的作物维管束微观结构表征方法。王芬娥等[9]得到了小麦茎秆在扫描电镜下的解剖构造图像,分析了小麦茎秆承载能力与微观组织结构的相互关系,建立了茎秆横截面的力学模型。ZHANG等[10]研究了毛竹的压缩特性与维管束的关系,通过扫描电镜图像获取了毛竹样品的维管束体积分数,并测定了不同维管束体积分数毛竹样品的抗压强度,研究表明维管束屈曲是毛竹样品破坏的主要原因。赵春花等[11]研究了牧草茎秆力学性能与显微结构的相互关系,结果表明茎秆的强度和刚度主要取决于各自机械组织的厚度、维管束的数量以及各组织及其细胞之间的连接形式和连接强度。段传人等[12]对机械组织厚度、维管束特征等与水稻茎秆抗折力的相关性进行了研究,表明维管束数量、面积与茎秆抗折力显著相关。

上述研究中,显微镜和数码成像装置构成的显微成像系统可以方便快捷的获取微观组织图像,但维管束数目、面积等关键参数仍需人工测量统计,费时费力,严重制约了参数获取的效率。针对这一问题,部分学者对高通量、自动化的作物微观结构参数获取系统进行了研究,实现了对微观结构参数,如维管束数量、面积等的自动统计与测量[13-14]。但现有相关研究中主要基于颜色空间转换、阈值分割等传统图像分割方法实现组织结构的分割识别,算法通用性不强。

深层卷积神经网络的兴起为作物微观结构图像的分割识别提供了新思路。由于卷积神经网络能够对样本图像特征进行自主学习[15],具有极强的表征能力,可以自动提取图像特征,在图像分割和目标检测领域均有优异表现[16-17],在作物微观结构参数测量统计上也已有相关研究。陈燕等[18]为实现小麦茎秆截面微观参数测量,提出了一种融合ResNet 50和Unet网络的维管束和背景区域语义分割模型,实现对小麦茎秆截面尺寸、维管束面积等微观结构参数的检测。LI等[19]将YOLO目标检测算法应用于毛竹微观结构解析领域,实现了毛竹维管束相关参数的自动检测、定位、计数和自动测量,检测模型的精度达到99.59%。目前将深度学习相关技术应用于水稻茎秆截面微观结构分析的研究尚未见报道。

为实现水稻茎秆维管束微观结构特征的分析,搭建基于深度学习的茎秆切片图像大、小维管束的检测分割模型,提出一种基于边缘检测的茎秆截面图像分割方法,对水稻茎秆截面面积、直径以及大、小维管束面积和大、小维管束数量等相关参数进行自动检测。

1 水稻茎秆截面显微图像采集与训练数据集建立

将水稻茎秆进行切片后用Pannoramic 250FLASH型切片扫描仪进行微观显微成像,在切片扫描仪的显微镜头下快速移动进行扫描成像,并通过专用软件系统无缝拼接生成一幅完整的高清全视野数字化切片图像,图像分辨率约为30 000像素×30 000像素,如图1所示。

图1 水稻茎秆切片图像Fig.1 Slice image of rice stem

现有的计算机硬件(处理器I Intel(R) Xeon(R) Platinum 8255C,内存39 GB)很难直接使用超高分辨率的扫描图像做特征提取和模型训练,同时在进行数据集制作时也很难直接对原图像进行人工标注。因此在标注之前首先对超高分辨率的原图像进行预处理。综合考虑图像尺寸和图像细节变化,将原图像等比例压缩90%,得到水稻茎秆切片图像分辨率为3 000像素×3 000像素。

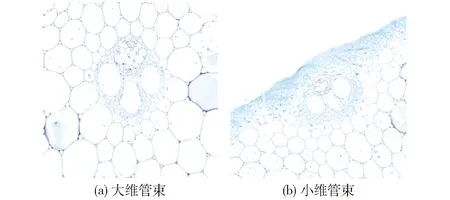

压缩处理后的图像通过颜色变换、添加高斯噪声等方式扩增后,最终获得800幅切片图像,建立样本集。随后在Labelme软件中采用多边形标注工具对图像进行人工标注,标注类别为大维管束、小维管束。参照文献[20-21],依据其在维管束细胞中的位置判断维管束的类别,靠近维管束外侧细胞壁边缘位置为小维管束(面积较小),靠近中间位置的维管束细胞为大维管束(面积较大)。大、小维管束的图像特征如图2所示。在样本集中随机选取70%(560幅)图像作为训练集,选取20%(160幅)图像作为验证集,选取10%(80幅)图像作为测试集。

图2 维管束图像Fig.2 Image of vascular bundle

2 基于Mask R-CNN的水稻维管束图像提取分割网络构建

本文旨在通过深层卷积神经网络实现水稻茎秆切片扫描图像中维管束的分割提取,为后续茎秆截面参数的自动检测提供技术支撑。本文在Mask R-CNN[22]网络架构上进行水稻茎秆切片图像的实例分割模型研究。

现有的Mask R-CNN网络在低分辨率(28像素×28像素)下进行掩膜分割,分割结果不精细,尤其在边缘位置分割模糊。针对现有实例分割网络存在的此类缺陷,文献[23]提出了一种PointRend高精度图像分割模块,该模块在每一次点分类预测中采用一种多层感知机对实例边缘中不确定类别的点进行细分预测,通过逐步迭代最终生成高质量的分割掩膜。

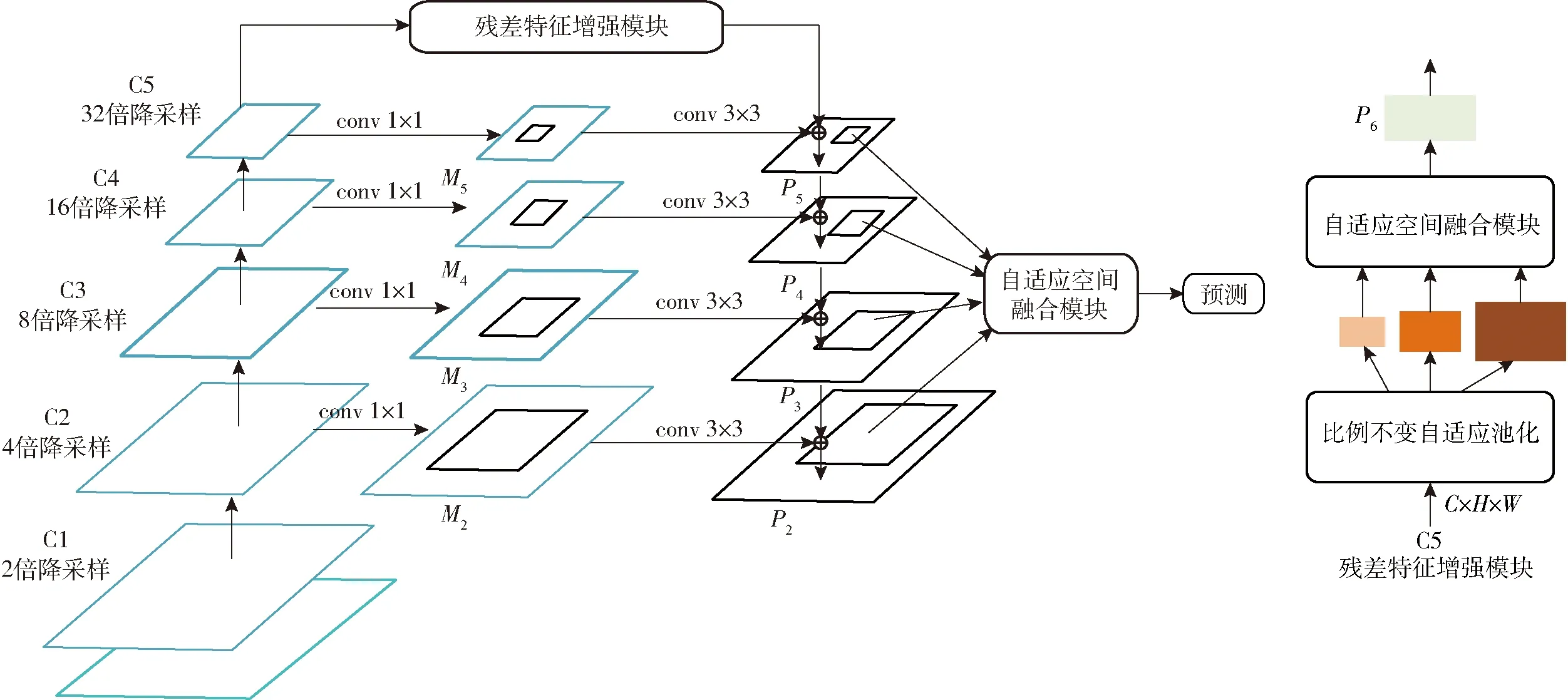

要实现水稻茎秆切片图像中维管束的计数及面积提取,需首先完成维管束细胞图像高质量掩膜的分割提取。因此,本文将PointRend模块引入水稻茎秆维管束图像的分割提取网络中,实现维管束区域图像的高精度分割。水稻茎秆维管束图像分割提取网络结构如图3所示,网络主要由特征提取网络、区域生成网络以及后续实现目标分类、分割、定位的头部网络组成。

图3 水稻茎秆图像分割提取网络结构图Fig.3 Network structure of rice stem image segmentation

2.1 基于多尺度特征学习的特征提取网络构建

在水稻茎秆切片扫描图像中,大部分区域为细胞薄壁组织,大、小维管束细胞只占少部分区域,可供利用的像素特征较少,深度网络难以提取到有效的特征。因此在对水稻茎秆维管束细胞的检测中,需同时利用深层网络的语义信息和浅层网络的表征信息,现有实例分割及目标检测网络通过特征金字塔网络[24](Feature pyramid network, FPN)来实现这一目的。

虽然FPN网络通过特征融合的方式利用了不同层的特征信息,但是在进行特征融合之前,主干网络不同层提取的特征需经过1×1卷积降维至相同通道数后才能进行特征相加。然而,主干网络不同阶段的特征图感受野不一样,包含的语义信息差异较大,直接进行特征融合势必会减弱多尺度特征的表达能力。同时顶层的高级特征和底层的低级特征以“自上而下”的方式进行融合的过程中,来自高层特征的更强语义信息加强了底层特征的表达能力,但高层特征经过1×1卷积降维后,其携带的语义信息势必会丢失,一定程度上削弱了网络的表征能力。文献[25]提出一种用于目标检测领域的多尺度特征学习方法,通过残差特征增强和自适应空间融合等方式,减小了不同尺度特征之间的语义差距及高层特征的信息丢失,显著提升了网络的检测性能。

图4 基于多尺度特征学习的特征提取网络结构图Fig.4 Feature extraction network structure based on multi-scale feature learning

本文将残差特征增强和自适应空间融合方法引入特征提取网络构建中,用于水稻茎秆维管束微观结构的分割提取。图4所示为以深度残差网络(以ResNet 50为例)为主干网络的改进特征提取网络结构图。残差特征增强模块解决了金字塔网络高层特征信息缺失的问题。如图4所示,主干网络第5阶段输出的特征图进行比例不变自适应池化后获得了图像多尺度上下文特征,通过1×1卷积将特征降维到256通道,随后对降维后的特征图进行双线性插值上采样,将特征图尺寸统一至相同尺度,并采用自适应空间融合模块将上下文特征聚合成为新特征,将该特征图与C5降维后的特征图相加得到没有信息损失的特征图P5,随后通过3×3卷积向下进行特征融合。图中C1~C5为ResNet 50网络的5个阶段,M2~M5分别为ResNet 50网络5个阶段生成的特征图经过1×1卷积降维后的特征图,P2~P5分别为不同阶段经过特征融合后生成的特征图。

在FPN网络中,通过感兴趣区域(Region of interest, ROI)的尺度来提取对应层的特征,一般小尺度ROI对应低层级特征,大尺度ROI对应高层级特征,此种机制可能导致描述ROI的特征缺失,不利于最终的分类和分割。因此,对于任意一个ROI,有必要综合考虑其在不同层级对应的特征。文献[23]提出一种利用网络自身进行权重参数学习、然后对不同层级的特征进行加权求和作为ROI最终特征表达的方法,有效利用了不同层级的ROI特征。基于上述两种方法,构建了基于残差特征增强和自适应空间融合的特征提取网络(Augmentation FPN, AugFPN)。

2.2 损失函数优化

Mask R-CNN网络的损失主要来自区域生成网络(Region proposal network, RPN)的分类损失和回归损失。Mask R-CNN网络以smoothL1函数作为网络的回归损失函数,其表达式为[22]

(1)

其中

(2)

式中Lreg——网络回归损失值

Nreg——锚框数量

ti——预测边界框坐标向量

在通过smoothL1函数计算网络的回归损失时,实质上是将预测框的边界视为相互独立的4个点,分别求出4个点的损失值然后相加得到整体损失值,而实际上4个点存在相关性。同时,在评价预测框与真实框的接近程度时,通常使用交并比(Intersection over union, IoU)这一指标,当多个预测框具有相同的smoothL1损失函数时,其IoU值可能差异很大。因此,孤立地对4个点进行优化回归是不合适的,需将4个点构成的预测框看成一个整体进行回归。基于此,有学者提出IoU损失函数[26],其表达式为

LIoU=-lnIoU

(3)

(4)

式中LIoU——交并比损失值

IoU——目标检测网络中预测框与真实框的交并比

I——预测框与真实框的交集区域面积

U——预测框与真实框的并集区域面积

IoU损失值越小,说明网络生成的预测框与真实框之间的差异越小,重合度越高,即模型精度越高。

本文使用IoU损失函数替换原有的smoothL1函数,作为RPN的回归损失函数。

3 水稻茎秆维管束图像分割及截面参数提取试验

3.1 试验条件及参数设置

试验在Ubuntu 18.04系统下进行,试验用计算机处理器为Intel(R) Xeon(R) Platinum 8255C, 内存为39 GB,显卡为Tesla V1001(显存32 GB),使用GPU加速计算,在Python语言环境中选择Pytorch框架实现网络模型的搭建、训练和调试。所有分割网络均按表1对模型参数进行初始化,采用随机梯度下降法对网络进行训练。训练迭代35个周期,每10个周期保存一次权重参数,取精度最高的权重为最终模型。

表1 水稻茎秆图像分割网络初始化训练参数Tab.1 Training parameters for rice stem segmentation network

3.2 模型测试结果分析

对采用不同方式构建的水稻茎秆维管束图像分割模型进行性能试验,具体如下:①ResNet 50和FPN为特征提取网络,以smoothL1函数为回归损失函数的Mask R-CNN模型(简称为ResNet_FPN_Smooth)。②以ResNet 50和FPN为特征提取网络,以smoothL1函数为回归损失函数,且引入Po-intRend模块的Mask R-CNN模型(简称为ResNet_FPN_Smooth_PointRend)。③以ResNet 50和Aug-FPN为特征提取网络,以smoothL1函数为回归损失函数,且引入PointRend模块的Mask R-CNN模型(简称为ResNet_AugFPN_Smooth_PointRend)。④以ResNet 50和AugFPN为特征提取网络,以IoU函数为回归损失函数,且引入PointRend模块的 Mask R-CNN模型(简称为ResNet_AugFPN_IoU_ PointRend)。⑤以MobilenetV2和AugFPN为特征提取网络,以IoU函数为回归损失函数,且引入Poi-ntRend模块的Mask R-CNN模型(简称为Mobilenet_AugFPN_IoU_PointRend)。

上述5个模型训练完成后,用测试集数据对其性能进行测试。将同一幅图像分别输入上述5个模型中,得到图5中的5组预测结果。在分割结果中,为区分大、小维管束,分割结果图像中大、小维管束的分割用不同颜色的掩膜作区分,红色区域为大维管束,蓝色区域为小维管束,对比原图和分割结果图可以看到,每一个大、小维管束区域均能被准确检测及分割。

图5 不同水稻茎秆图像分割模型分割结果Fig.5 Segmentation results of different rice stem segmentation models

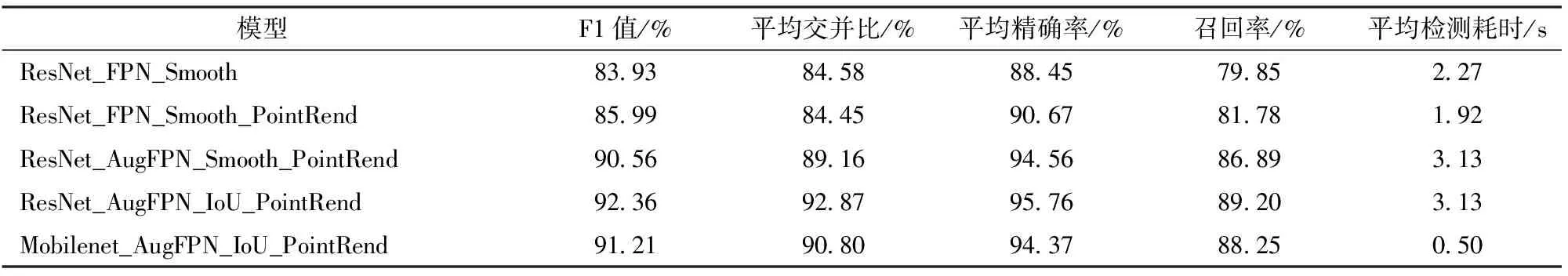

用平均交并比(Mean intersection over union,mIoU)、平均精确率(Precision,P)、召回率(Recall,R)、F1值(F1-score)、平均检测耗时t作为评价指标,衡量模型的分割性能,模型的性能如表2所示。

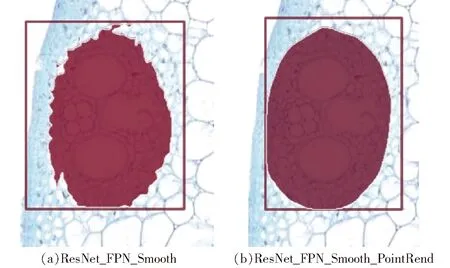

图6为模型ResNet_FPN_Smooth和ResNet_FPN_Smooth_PointRend分割结果放大相同倍数后的局部细节图,可以清晰看出,图6a分割掩膜边缘区域较粗糙,呈现不规则锯齿状,而图6b掩膜的边缘区域分割更加精细,分割误差更小。PointRend模块的引入显著提升了模型在图像边缘区域的分割效果,同时由表2可知,模型的F1值也有一定程度的提升,而平均检测耗时却未有明显增加,说明PointRend模块的引入并未增加网络的计算量。这对于后续实现维管束面积检测具有重要意义。

表2 不同模型性能对比Tab.2 Performance comparison of different models

图6 模型分割结果局部细节图Fig.6 Partial details of model segmentation results

由表2可知,将残差特征增强和自适应空间融合方法引入特征提取网络后,分割模型性能指标有较大程度的提升,其F1值、平均交并比、平均精确率和召回率分别从85.99%、84.45%、90.67%、81.78%提升至90.56%、89.16%、94.56%、86.89%。残差特征增强和自适应空间融合增强了分割网络多尺度特征的表达能力,并更加充分地利用了不同层级的ROI特征,显著提升了分割模型的性能。但同时网络的计算量和复杂程度也有一定程度的增加,模型推理单幅图像的时间从1.92 s增加到3.13 s。

在此基础上,以IoU函数作为RPN网络的回归损失函数,网络性能有小幅提升。网络在训练过程中损失函数的变化情况可以在一定程度上反映训练完成的模型性能。图7为以smoothL1函数为回归损失函数和以IoU函数为回归损失函数的模型训练损失值曲线。训练初期,两个网络损失值均在较短时间内下降到低值。随着训练过程的持续,网络损失值缓慢下降,当训练迭代到第800个步长左右时,网络损失值几乎不再下降,网络达到收敛。从图7可以看出,以IoU函数为回归损失函数的网络训练过程较为平稳,损失值一直处于缓慢、平滑下降的状态,而以smoothL1函数为损失函数的网络训练过程中损失值震荡相对较大。两个网络收敛后,以IoU函数为回归损失函数的模型最终损失值相对更低。IoU函数有效改善了网络的训练过程,模型获得了更优的性能。

图7 网络训练损失值变化曲线Fig.7 Change curves of network training loss

采用残差特征增强和自适应空间融合并以IoU函数作为网络回归损失函数优化得到的维管束图像分割模型性能较优异,但由于模型结构复杂、参数量较大,导致模型推理时间较长,单幅图像平均检测时间在3 s左右。为降低模型推理时间,提高模型的实时性,在前述模型优化方式的基础上,用轻量化的MobilenetV2网络替代ResNet 50网络作为分割网络的主干网络。从表2可以看出,轻量化后的模型分割性能略有下降,其F1值、平均交并比、平均精确率和召回率分别下降1.15、2.07、0.17、0.95个百分点,对模型的分割效果几乎没有影响,而平均检测耗时却大幅降低,有效提升了分割模型的实时性。

3.3 水稻茎秆截面参数提取

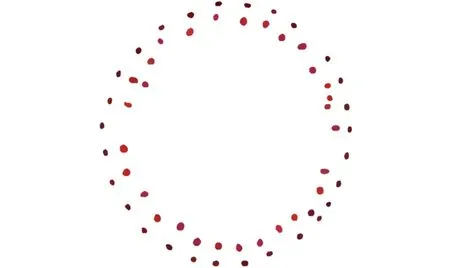

本文构建的水稻茎秆切片图像分割模型可以有效地对切片图像中的大、小维管束进行分类、分割和提取。模型分割后处理的结果如图8所示,由此分别获得大、小维管束的数量和像素面积。

图8 水稻茎秆图像后处理结果Fig.8 Post processing results of rice stem image

图9 水稻茎秆图像截面分割结果Fig.9 Segmentation results of rice stem cross section

采用数字图像处理方法,通过边缘检测、形态学处理及轮廓提取等方法,对茎秆切片截面图像进行分割,分割结果如图9所示。在此基础上输出茎秆截面切片图像的截面像素面积和最大直径。

为将切片图像处理中的像素度量单位转换成物理尺寸单位(μm或μm2),需将人工测量的尺寸与图像处理输出的像素单位建立比例关系。人工测量方法为:采用专用的数字切片浏览软件CaseViewer读取茎秆切片图像文件,人工对图像中的截面、大小维管束区域进行标注,由软件测量出对应区域的实际面积,同时由人工对大小维管束的数量进行统计。本文对10幅切片图像进行了人工测量及模型分割试验,分别得到茎秆截面面积、直径,大小维管束面积的人工测量值及对应的模型预测输出像素值,得到尺寸比例系数分别为0.686 μm/像素和0.472 μm2/像素。

用水稻茎秆切片图像分割算法对120幅水稻茎秆切片图像进行检测,采用均方根误差和平均相对误差来衡量检测精度,同时用专用的数字切片浏览软件CaseViewer读取相应茎秆切片图像文件,人工标注维管束相应区域,由软件测量出维管束6个指标的参数值,对比检测结果和人工测量值的差异,结果如表3所示。

表3 检测结果精度Tab.3 Accuracy of measurement result

由表3可知,本文基于图像处理的水稻茎秆截面参数提取方法具有很高的检测精度,6个参数的平均相对误差均在4.6%以内。小维管束面积检测的平均相对误差最大,达到4.60%,均方根误差为 2 286.79 μm2,这主要是由于小维管束目标较小,模型检测及分割的误差较大,导致检测得到的小维管束面积相对误差较大。由于小维管束的检测难度比大维管束大,小维管束面积和数量检测的平均相对误差均较大。大维管束面积的均方根误差和平均相对误差分别为7 304.74 μm2和3.8%,大维管束数量的均方根误差和平均相对误差分别为0.79个和1.34%,小维管束数量的均方根误差和平均相对误差分别为1.21个和1.92%。由于扫描得到的茎秆切片图像轮廓清晰,背景简单,因此通过边缘检测及轮廓提取可以较完整的分割出茎秆截面,最终的检测结果误差极小,平均相对误差仅为0.58%,均方根误差为202 515.77 μm2。截面直径的均方根误差和平均相对误差分别为183.95 μm和2.00%。

维管束6个参数人工测量值与检测值的对照情况如图10所示,可以看到测量值和检测值拟合决定系数均不小于0.96,各参数检测精度较高,本文方法具有可行性。

图10 维管束各参数人工测量值与检测值对比Fig.10 Comparison of manually measured and detected values of parameters

4 结论

(1)构建了一种基于改进Mask R-CNN网络的水稻茎秆切片图像分割模型,实现了水稻茎秆切片图像中大、小维管束区域的定位、检测和分割。网络以轻量化网络MobilenetV2和残差特征增强及自适应空间融合的FPN网络为特征提取网络,同时引入PointRend增强模块,并将网络回归损失函数优化为IoU函数,最终得到综合性能最优的模型,其F1值为91.21%,平均交并比为90.80%,平均精确率为94.37%,召回率为88.25%,单幅图像平均检测耗时为0.50 s。

(2)提出一种基于图像处理的水稻茎秆截面参数自动检测方法,截面面积、截面直径、大维管束面积、小维管束面积、大维管束数量、小维管束数量6个参数检测的均方根误差分别为202 515.77 μm2、183.95 μm、7 304.74 μm2、2 286.79 μm2、0.79个和1.21个,平均相对误差分别为0.58%、2.00%、3.80%、4.60%、1.34%和1.92%。