基于深度学习的玉米拔节期冠层识别

2022-01-27乔金博李民赞

孙 红,乔金博,李 松,李民赞,宋 迪,乔 浪

基于深度学习的玉米拔节期冠层识别

孙 红1,乔金博2,李 松1,李民赞1※,宋 迪2,乔 浪2

(1. 中国农业大学,现代精细农业系统集成研究教育部重点实验室,北京 100083;2. 中国农业大学,农业部农业信息获取技术重点实验室,北京 100083)

为了满足田间玉米植株快速识别与检测的需求,针对玉米拔节期提出了基于深度学习的冠层识别方法,比较并选取了适于玉米植株精准识别和定位的网络模型,并研制了玉米植株快速识别和定位检测装置。首先拍摄玉米苗期和拔节期图像共计3 000张用于训练深度学习模型,针对拔节期玉米叶片交叉严重的问题,提出了以玉米株心取代玉米整株对象的标记策略。其次在Google Colab云平台训练SSDLite-MobileDet网络模型。为了实现田间快速检测,开发了基于树莓派4B+Coral USB的玉米冠层快速检测装置。结果表明,田间玉米冠层识别模型精度达到91%,检测视频的帧率达到89帧/s以上。研究成果可为田间玉米高精度诊断和精细化作业管理奠定基础。

深度学习;目标检测;识别;拔节期;玉米冠层

0 引 言

随着深度学习技术的发展成熟,在农业领域的应用日益广泛,其中基于深度学习的新一代人工智能传感器研发是提升信息获取技术水平的重要方向[1-2]。玉米作为中国主要粮食作物,其施肥作业多以条施、撒施为主,精准施肥技术是提高农业资源利用率和环境保护的重要途径[3-4]。结合深度学习技术识别玉米植株,并形成智能型传感器为精准化对靶作业提供支持,具有重要现实意义。

针对玉米冠层,传统分析方法关注于形态、灰度差异、颜色等浅层图像特征,使用阈值分割法提取植株对象。Montalvo等[5]利用最大类间方差法(Otsu法)针对俯视图像进行双阈值分割,分离了作物和杂草。胡炼等[6]对静态采集的图像,利用超绿算法(ExG)结合Otsu法实现对棉苗和生菜苗的识别和定位。当前研究主要集中于静态图像的分析,受到环境光和运动等因素的干扰,针对田间复杂动态环境下的检测效果有待提高[6]。

近年来,卷积神经网络(Convolutional Neural Networks,CNN)基于大量的数据集训练,提升了深层次图像特征挖掘的能力,在图像目标分类[7-8]、识别和检测[9-10]等领域形成了YOLO(You Only Look Once)[11-12]、Fast R-CNN(Fast Region-CNN)[13-14]和SSD(Single Shot MultiBox Detector)[15-16]等系列模型,在目标分类、杂草识别、病虫害胁迫、农产品品质分析等对象识别和检测中得到了广泛的应用[13],且具有较高的识别精度和较好的鲁棒性。尽管当前研究在CNN网络的架构、训练参数设置及调整等方面取得了重要的进展,但是网络模型普遍基于实验室高性能GPU(Graphics Processing Unit)运行,导致在实际工程应用中的成本较高[17-18],尚无轻量化、便携化的农业应用设备,无法为玉米田间快速识别提供装备支持。

面向移动端便携式和轻简化应用的需求,基于SSD模型架构,MobileNet、MobileNetV3等具有轻量化特点的网络备受关注。Xiong等[19]通过在搜索空间中加入规则卷积,提出了一种快速的MobileDet网络,模型精度接近VGG16,但模型体积小32倍,且计算复杂度小27倍,比GoogleDet计算量减少2.5倍以上。通过模型改进,在移动CPU(Central Processing Unit)处理器平台上其运行效果比传统MobileNetV3 + SSDLite模型具有优势[19]。因MobileDet和MobileNetV3轻量化的特点,适于移动终端应用,为基于深度学习的智能检测设备研发提供了实施途径。Coral USB 加速棒支持Linux、Macos或Windows10系统,只需连接USB即可为系统添加一个Edge TPU处理器。单个Edge TPU能够每秒执行4万亿次操作,MobileNetV2模型在四核Cortex-A53 @ 1.5GHzCPU上每次推理时间为282 ms,在四核 Cortex-A53 @ 1.5GHz + Edge TPU加速棒上每次推理时间为14 ms,速度提升约20倍。此外Coral USB 加速棒具有体积小、易拆装等特点,适合于移动终端设备的开发。

针对田间玉米冠层的检测与定位,大量研究围绕苗期植株展开。宗泽等[20]使用Fast R-CNN对苗期玉米植株图像进行识别,基于GPU的离线识别准确率达到了92.9%。孟庆宽等[21]采用一种轻度卷积神经网络对苗期玉米和杂草进行识别,识别速度达到了32.26帧/s,准确率为88.27%。然而,随着玉米生育期的推进,叶面积增大,叶片交叉与冠层连片等限制了上述数据集和模型的应用。此外,离线识别的模式不利于快速获取、分析与变量管理一体化精准作业模式的构建,也不利于提高智能化管理水平。

因此,本研究拟针对玉米拔节期冠层连片的问题,改进数据集标注对象,进而在SSDLite-MobileDet轻量化深度学习模型的基础上,研制一款便携式田间玉米植株快速识别与智能定位装置,以期为田间信息高效获取与精准化管理提供技术和装备支持。

1 材料与方法

1.1 研究路线

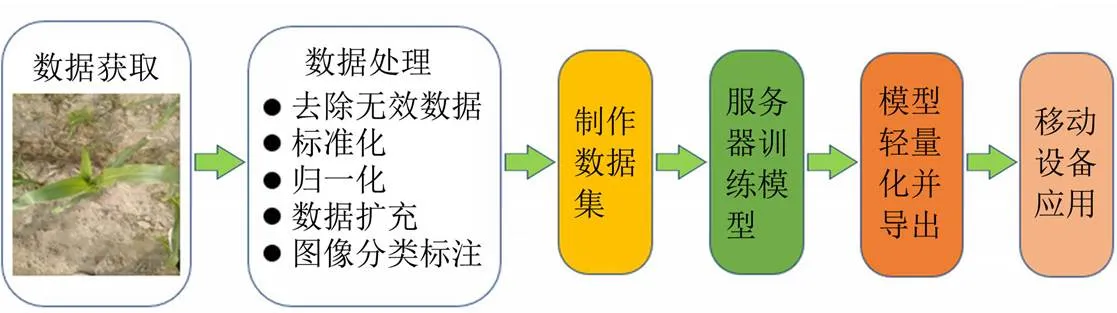

应用深度学习开展玉米冠层识别与检测的技术流程如图1所示,包括数据获取与处理、制作数据集、模型训练及量化和移动设备快速检测应用。在深度学习中,准备数据集时包括数据标注、数据增强、数据清洗、标准化或规范化处理。之后再选取合适的目标检测模型进行训练与模型的优化。训练完成后的模型再导出部署到移动设备,最终完成深度学习在农业应用方面的落地与实施。

图1 玉米冠层识别与检测技术流程

1.2 数据获取

1.2.1 模型训练数据集

拍摄玉米冠层图像,制作训练数据集。2020年7月-9月之间,拍摄株高10~110 cm之间玉米苗期和拔节期图像共计3 000张。其中,2020年7月3日到8月20日,在河北省衡水旱作研究所试验基地,拍摄衡玉321冠层图像2 600张;2020年9月6日到20日在中国农业大学上庄实验站拍摄郑单958冠层图像400张。拍摄使用魅族pro6s手机,原始图像分辨率为3 008×4 000(像素),格式为JPEG。数据集涵盖不同光照环境和不同生长期,如图2所示分别为晴天苗期、阴天苗期、晴天拔节期和阴天拔节期图像的样例。苗期植株为3~6叶期,拔节期植株为7~10叶期。

1.2.2 装置性能验证

模型训练完成后,嵌入玉米冠层快速检测装置。为验证检测装置性能,应用2个批次视频数据,包括宗泽[20]于2017-2018年每年5-7月在中国农业大学上庄实验站拍摄的玉米苗期视频和2021年6-8月在中国农业大学上庄实验站拍摄玉米拔节期视频。通过对视频图像中的玉米植株识别,测试嵌入快速检测装置后模型对目标识别的准确性。

1.3 数据集制作

1.3.1 图像归一化与特征标注

针对大田环境下拔节期玉米冠层连片的情况,本文提出一种基于株心的植株标注策略,以避免叶片交叉时的误识别,提高单株识别准确度。在对图像进行压缩与批量命名以后,将输入图像分辨率调整为726像素×545像素。通过专业标注软件Labelme使用绿框标注目标玉米植株,拔节期冠层株心标注时框取玉米株心的最大外接矩形。标注文件格式保存为.xml文件,文件包含标注特征的位置及像素信息。

1.3.2 数据增强

为应对大田多样化的环境,增加玉米植株识别模型的鲁棒性与泛化能力,对数据进行数据增强。在扩充训练的数据量方面,数据增强的方法主要有翻转、旋转、缩放、裁剪、平移等[13,22]。几何形变,扩充样本集数量,避免因为样本大小或者尺度等问题造成模型参数提取失真或模型过拟合。在抑制噪声方面,数据增强的方法主要有添加噪声、改变图像亮度、对比度等,通过改变图像的视觉效果模拟复杂噪声干扰和光照环境的影响,进而抑制因图像噪音、图像模糊等质量不高导致的训练模型精度不高的问题。本文采用上述2类方式分别对训练集和交叉验证集进行数据扩充,构建的玉米冠层图像数据集如图3和表1所示。按7:2:1的比例划分为训练集,交叉验证集与测试集,对划分后的训练集和交叉验证集进行扩增,扩增后训练集图像10 500张、交叉验证集图像3 000张、测试集图像300张。

表1 数据集说明

1.4 基于SSDLite+MobileDet的玉米冠层识别

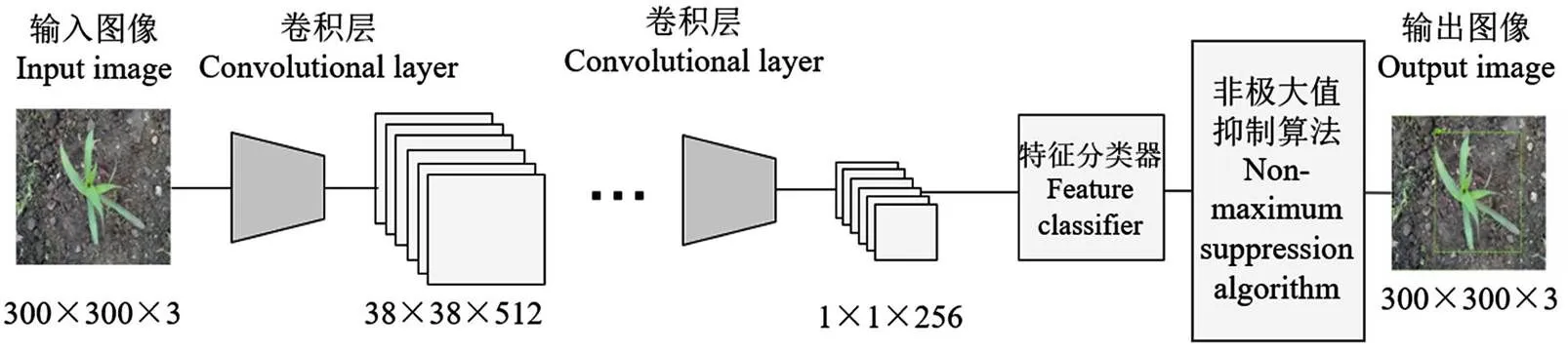

为了对拔节期玉米冠层进行快速检测,并通过模型移植,在移动端设备上研制便携式装置,研究采用MobileDet网络代替SSDLite原来的VGG16网络。对象检测旨在对目标对象进行定位和分类,并用矩形标记显示被检测对象分类的可信度。目标检测算法分为训练和预测2个环节,其中训练环节用于通过数据集特征学习得到分类器,预测环节使用训练好的分类器对未知图像中的特征提取和分类,最终得到检测结果。图4为目标检测算法流程图。检测中的正负样本是程序识别感兴趣区域ROI(Region Of Interest),即SSDLite中在不同分辨率的特征图中的默认框,这些框中的一部分被选为待检测目标,即正样本,一部分被选为非待检测目标,即负样本,另外一部分被当作背景或者不参与运算。交并比IOU(Intersection Over Union)≥0.5为正样本,<0.5为负样本,选取负样本中置信度损失函数值高的进行训练,正负样本的比例1:3。

图4 目标检测算法流程图

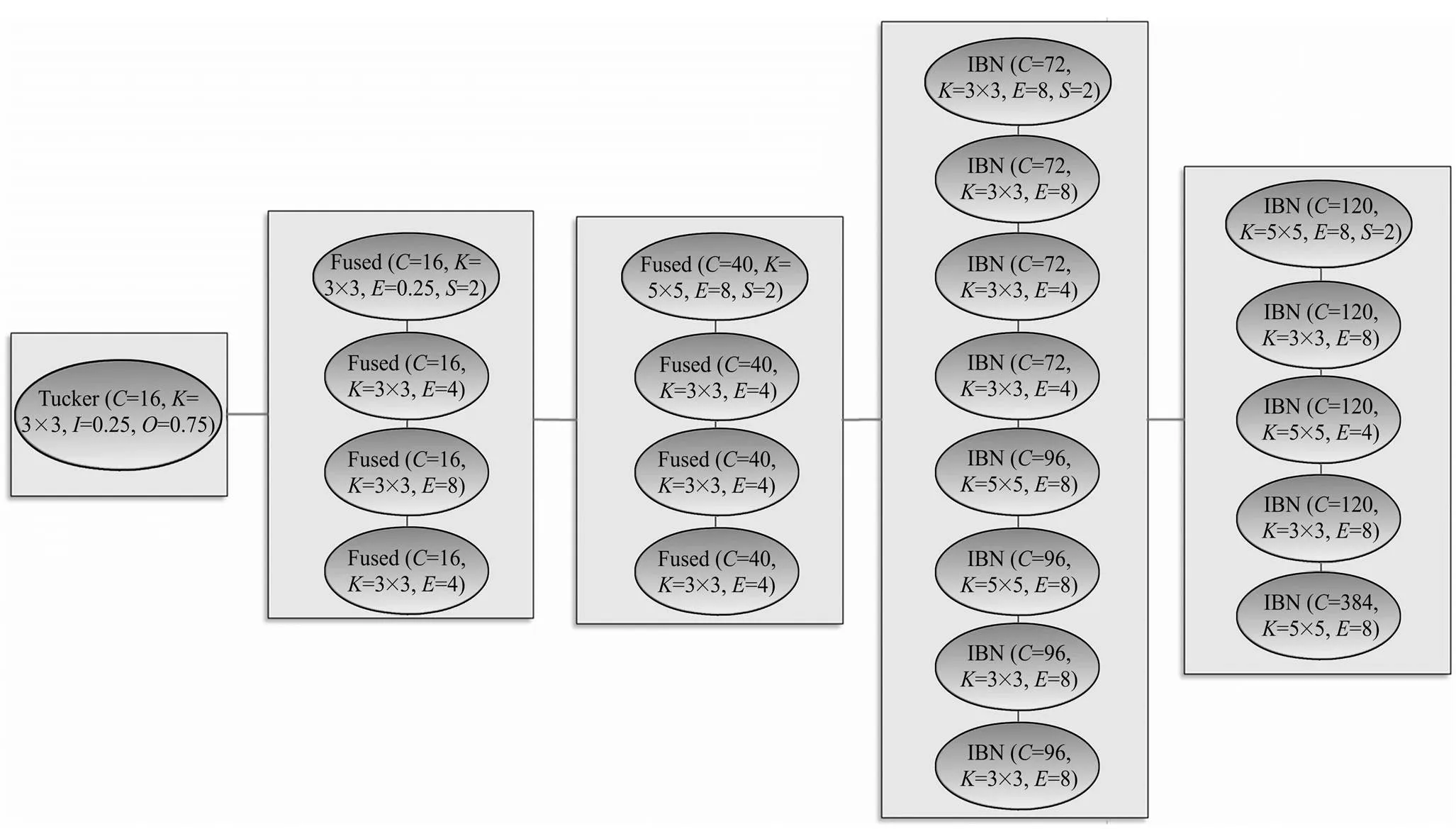

在SSD(Single Shot MultiBox Detector)的基础上将特征图分类和位置加权使用的标准卷积替换为深度可分离卷积,得到面向移动端设计的改进轻量化模型SSDLite。通常特征提取需要由特有的特征提取神经网络来完成,如VGG、MobileNet,ResNet等[23-24],在BackBone后的全连接层辅助实现特征提取和输出。SSDLite算法优化了这一过程,检测速度提高。同时SSDLite算法综合利用不同卷积层的特征,结合YOLO中的回归思想和Faster R-CNN中的Anchor机制,使用全图各个位置的多尺度区域进行回归,既保持了YOLO速度快的特性,也保证了窗口预测的跟Faster R-CNN一样精准。图5为SSDLite框架结构图,通过卷积层(Convlayers)的扫描窗口提取图像特征信息,生成目标检测的特征分类器(Detector classifier),输出后进入非极大值抑制算法(Fast NMS)最终输出检测图像。SSDLite模型包含类别损失函数和位置损失函数,其中类别损失函数使用加权FocalLoss损失函数,位置损失函数使用加权平滑L1范数。图6为MobileDet网络结构图。

1.5 检测装置设计

1.5.1 硬件设计

完成模型训练后,为实现玉米冠层快速检测,设计了玉米冠层快速检测装置,总体结构模块如图7所示。系统包括树莓派控制模块、加速计算模型、图像采集模块、电源模块和显示模块。

图5 SSDLite模型框架

注:IBN、Tucker和Fused为卷积块,C为通道数,K为卷积核大小,E为扩增因子,I为输入压缩比,O为输出压缩比。

图7 移动设备组成模块示意图

树莓派4B移动设备实物如图8所示,广角摄像头安装在设备底部,其感光芯片为OV5647,用于采集640×480分辨率的玉米视频信息,并通过CSI接口传输采集到的视频信息给树莓派4B。树莓派4B处理器为BCN2711四核1.5GHz Cortex-A72处理器、4G运行内存,运行系统为Rsapbian Buster,配置有USB3.0接口。通过USB3.0接口外部扩展Coral USB加速棒快速计算模块。模型运行结果在外接的3.5寸显示屏上显示,显示屏分辨率为320×480,通过SPI协议与树莓派进行视频传输。使用PiSugar2pro锂电池进行供电,该锂电池自带5V3A输出能力,电池容量为5 000 mAh,可供移动检测设备持续工作10 h以上。

1. 树莓派控制模块 2. 电源模块 3. 树莓派CSI广角摄像头 4. Coral USB加速棒 5. 3.5寸触摸屏 6. SD存储卡

1.5.2 软件设计

为了实现田间玉米冠层的实时识别与定位,将深度学习模型配置在树莓派系统上。实现时为树莓派系统搭建可供量化后模型应用的环境,主要包括搭建TPU环境以运行深度学习模型与Coral USB加速器,Python3.7、Tensorflow框架以支持深度学习模型与系统运行,安装OpenCV库以实现图像处理。具体软件运行流程为:开机自启动程序并进行系统初始化,摄像头采集到的视频逐帧传入深度学习模型,在加速棒的运算下实现对玉米冠层的识别与定位,将识别与定位结果标注在图像上,检测后的图像经过OpenCV处理成视频进行存储和播放。软件流程图如图9所示。

模型量化时,将连续取值的浮点型模型权重近似为有限多个离散值,数据类型由FP32转换为INT8,减少量化为后的模型内存占用,并在树莓派4B和Coral USB设备上使用。最终将模型量化为与Coral USB边缘处理器相适配的.tflite格式。将量化完成的tflite模型在树莓派平台上运行。

2 试验与分析

2.1 试验方法

2.1.1 训练环境

模型训练在Google Colab云服务器下完成。操作系统为linux18.04,配置环境为cuda10.1和tensorflow1.15.2, GPU为Colab分配的TESLA T4 16GB GPU。在云服务器端使用Tensorflow框架对目标检测模型进行训练。

2.1.2 模型训练

本文在SSDLite-MobileDet模型的基础上选用轻量化的MobileDet网络对玉米株心进行检测识别。在MobileNet的基础上,采用线性瓶颈逆残差结构(Inverted residual bottleneck)和基于squeeze and excitation结构的MnasNet轻量级模型,并与MobileNetv3模型进行对比,根据试验结果选取更适合于移动端系统的SSDLite-MobileDet作为最终的玉米植株冠层检测模型。

2.2 结果与分析

2.2.1 模型训练结果对比

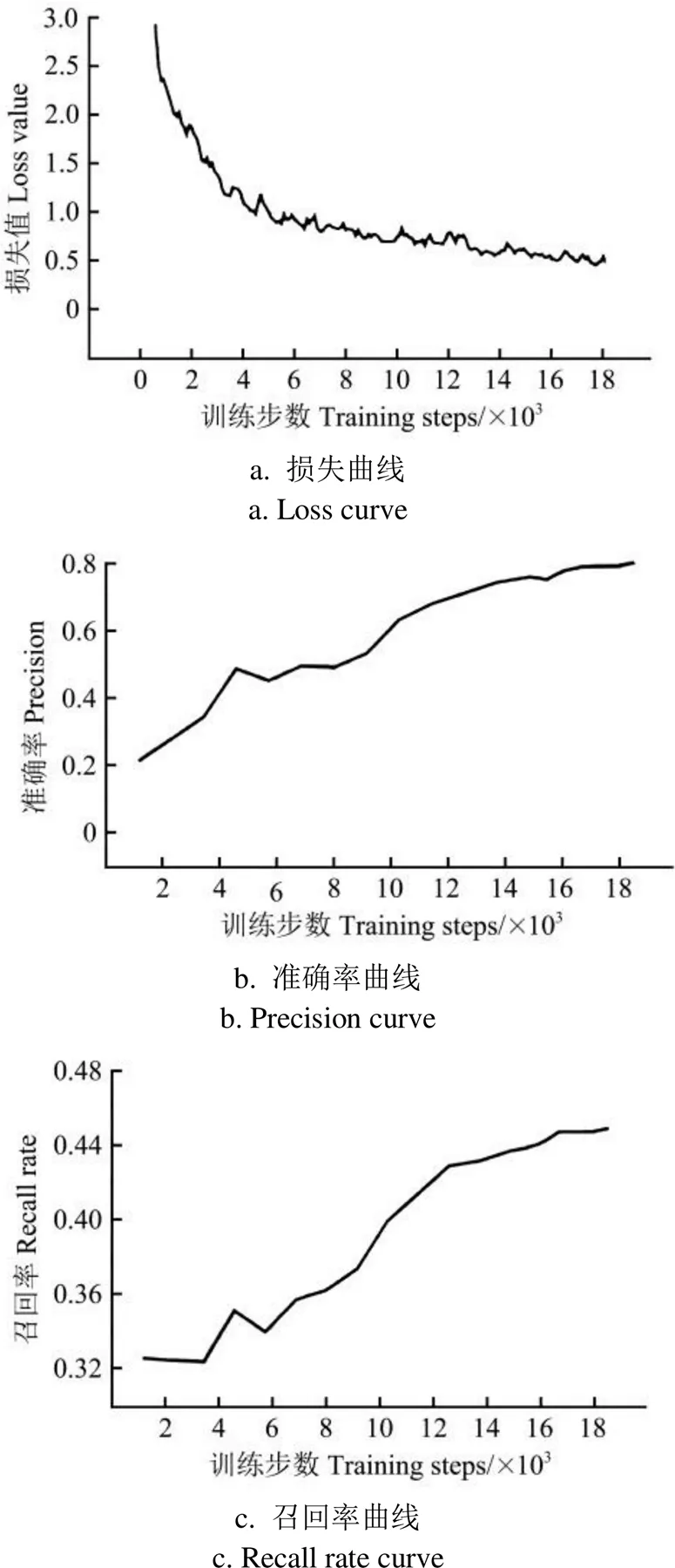

利用相同的数据集和训练参数训练模型,使用300张测试集图像对模型识别效果进行评估。模型训练结果如表2和图10所示,SSDLite-MobileDet与SSDLite-MobileNetV3的损失值下降到0.5时趋于平稳,精度与召回率[25]表现略低,主要原因是数据集环境多样,株心与叶片之间的特征相似,需要提取的特征部分与背景差异显著性不高。MobileDet网络识别速度达到110帧/s,准确率达92.4%,高于MobileNetV3的70帧/s和91.3%,在精度和速度上都优于MobileNetV3。最终选择SSDLite-MobileDet作为最终的玉米冠层检测模型。

图10 SSDLite-MobileDet模型训练结果

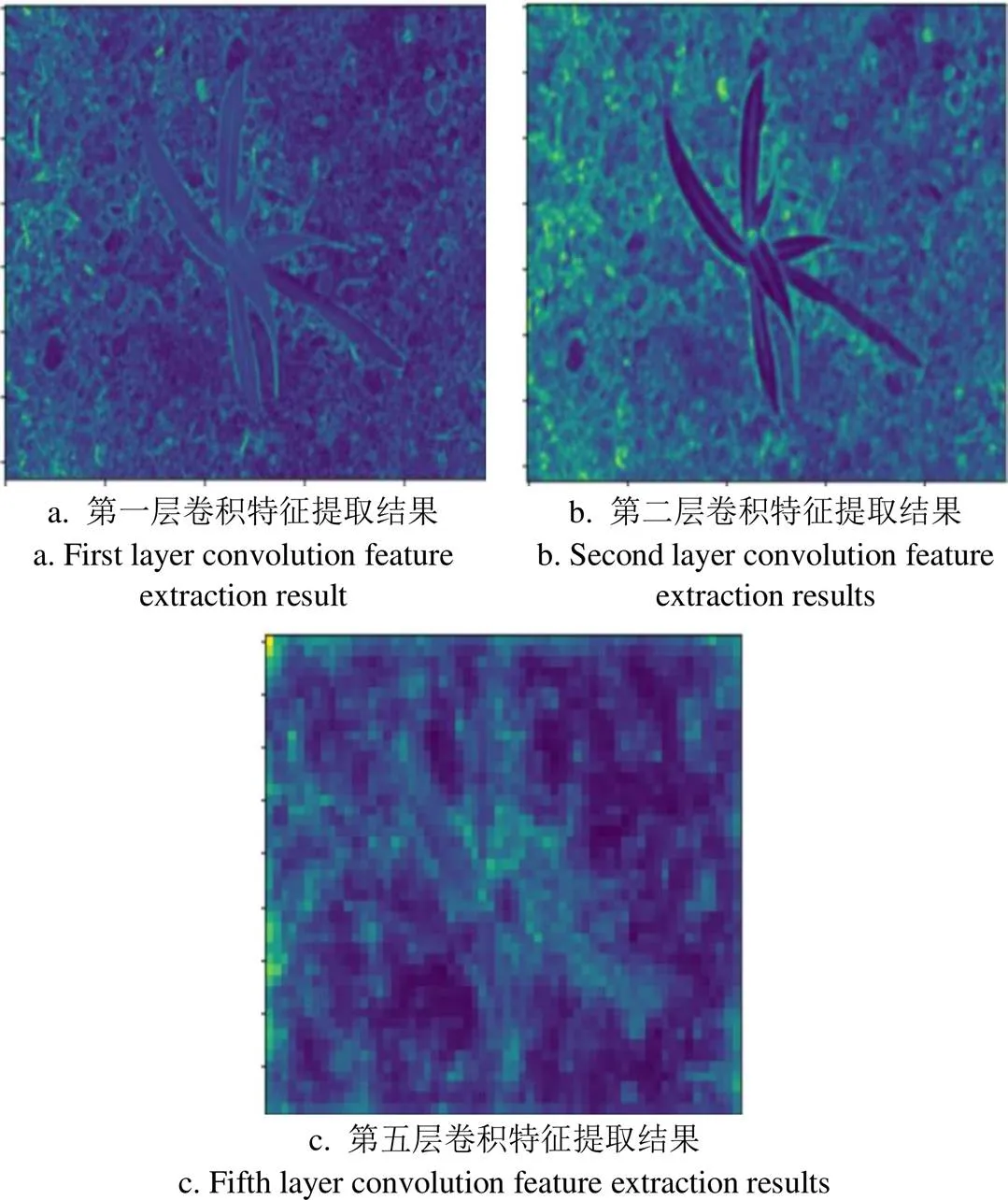

2.2.2 模型训练进程与可视化过程

为了提高模型检测速度,以MobileNet网络结构作为SSDLite模型特征提取器。为了理解SSDLite模型特征提取器在训练时对玉米特征提取的过程,对训练过程中玉米图像特征提取部分进行可视化分析。图11为部分卷积层(Cov)可视化结果。由图11可知,随着卷积网络层数的加深,输出图像像素降低,提取特征更多,层次更深,特征映射包含目标的信息更丰富。第一层和第二层主要提取图像的颜色和形状等特征,沿叶片结构的梯度变化明显。可视化到第五层,玉米冠层的特征提取不仅限于单一颜色指数,融合更多特征,对周围环境有更强的判别能力。可以发现,在网络层数达到深层次后,输出的信息更多是检测目标的信息,背景图的信息逐渐被网络层隐去,最终提取出需要检测的目标信息,保证了对识别目标深度特征的提取和学习。

图11 部分卷积层结果可视化

2.2.3 不同环境下识别结果

为探究不同标注策略对玉米冠层识别的影响,使用精度和速度较优的SSDLite-MobileDet模型,比较了传统整株标注和基于株心的植株标注策略对玉米冠层识别的效果。

完成模型训练后对玉米冠层进行识别结果如图12所示。由于植株间间隔大,使用整株标注方式对单株样本可以准确识别。但拔节期各植株冠层叶片交叉严重,不易分辨出各株玉米,采用整株标注方式时,模型将整张图像误识别为单株玉米,无法满足对拔节期玉米识别与高精度定位的需求。

使用玉米株心作为识别目标的标注策略时,玉米拔节期冠层识别结果如图12b所示。当呈现如图12a中多棵玉米叶片总体平行局部交叉情况,和如图12b中相邻植株交叉连片情况时,该标注方式下模型都可以准确识别并定位单株株心,提高了识别和定位准确性。因此后续研究以玉米株心标注策略为基础,评价模型识别和定位准确性。

根据图像类型将300张测试集图像分为不同组别作为模型输入数据集测试模型在不同环境下的检测精度。由于大田环境复杂,不能以传统IOU作为评价指标。本文识别出的玉米株数与总玉米株数的比值作为模型精度指标,误检和漏检均判定为该株玉米识别失败。测试结果如表3所示。由表3可知,当图像为单株个体时,如苗期玉米与拔节期不交叉时的情况,识别精度可达98%以上,即使玉米处于交叉和不同光照情况,平均识别精度也可达92.4%。

图12 不同标注方式玉米冠层检测结果

表3 不同环境下的识别结果

如图13所示,在强光、遮挡与弱光条件下对玉米株心的检测也有较高的精确度。对于没有识别出来的玉米,主要原因是部分图像过拟合,模型识别过于敏感和部分玉米植株遮挡严重,摄像机不能拍摄到冠层株心。但大部分玉米冠层能够实现定位与检测,基本可以满足在大田环境下对玉米冠层的快速检测。

图13 不同环境下玉米冠层识别结果

3 快速检测验证

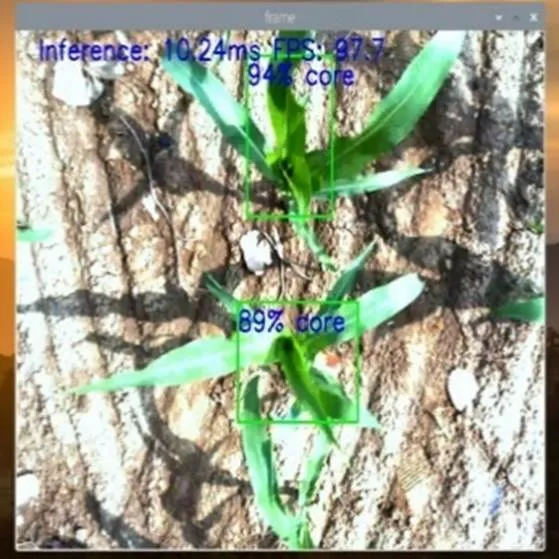

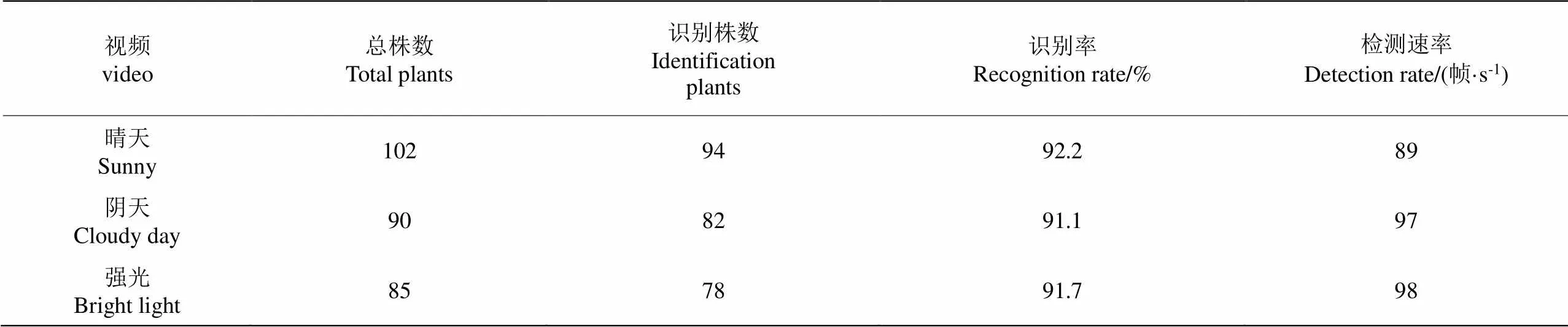

按照1.5.2节量化后,模型配置在树莓派4B中,通过Coral USB加速后,运行模型并实现对田间作物快速检测。使用在中国农业大学上庄实验站拍摄的玉米视频模拟田间真实输入环境,以验证模型和快速检测装备的应用性。对拔节期玉米。选取晴天、阴天和强光3段有代表性的视频进行测试。图14为树莓派4B移动设备快速检测效果图。

图14 移动设备检测效果

研究中以视频中识别的玉米株数与视频中总玉米株数的比值作为模型识别精度,其中对于视频中一株玉米出现误检或漏检即判定为该株玉米识别失败,识别结果如表4所示。由表4可知,在树莓派4B上玉米冠层检测可以达到91%以上的准确率,模型处理速度平均达89帧/s以上,可以满足田间玉米冠层便携、快速检测的应用 需求。

表4 移动端玉米冠层快速检测结果

4 结 论

本文针对玉米冠层的快速识别,采集玉米不同生长期的图像,制作玉米苗期与拔节期的图像数据集,采用深度学习轻量化网络训练模型,开发了一套基于深度学习的玉米植株快速识别装置,主要结论如下:

1)基于Google Colab云平台训练,对比了SSDLite-MobileDet和SSDLite-MobileNetv3两类轻量化模型,结果显示SSDLite-MobileDet模型网络识别速度达到110帧/s,准确率达92.4%。

2)针对拔节期玉米交叉情况严重,环境复杂不易识别的情况,提出了基于玉米株心标注的识别方法,本文模型在拔节期无交叉时的情况下,识别精度可达98%以上,即使玉米处于交叉和不同光照情况,平均识别精度也可达92.4%。

3)选用SSDLite-MobileDet模型,基于树莓派4B和Coral USB深度学习加速器研制便携式设备,移植本文网络模型进行应用,测试视频最终识别准确率为91%以上,平均速率达89帧/s以上。

[1] 赵春江. 智慧农业发展现状及战略目标研究[J]. 智慧农业,2019,1(1):1-7.

Zhao Chunjiang. State-of-the-art and recommended developmental strategic objectives of smart agriculture[J]. Smart Agriculture, 2019, 1(1): 1-7. (in Chinese with English abstract)

[2] Liakos K G, Busato P, Moshou D, et al. Machine learning in agriculture: A review[J]. Sensors, 2018, 18(8): 2674.

[3] 张辉,张永江,杨易. 美国、加拿大精准农业发展实践及启示[J]. 世界农业,2018(1):175-178.

[4] 苑严伟,张小超,吴才聪,等. 玉米免耕播种施肥机精准作业监控系统[J]. 农业工程学报,2011,27(8):222-226.

Yuan Yanwei, Zhang Xiaochao, Wu Caicong, et al. Precision control system of no-tillage corn planter[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2011, 27(8): 222-226. (in Chinese with English abstract)

[5] Montalvo M, Pajares G, Guerrero J M, et al. Automatic detection of crop rows in maize fields with high weeds pressure[J]. Expert Systems with Applications An International Journal, 2012, 39(15): 11889-11897.

[6] 胡炼,罗锡文,曾山,等. 基于机器视觉的株间机械除草装置的作物识别与定位方法[J]. 农业工程学报,2013,29(10):12-18.

Hu Lian, Luo Xiwen, Zeng Shan, et al. Plant recognition and localization for intra-row mechanical weeding device based on machine vision[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2013, 29(10): 12-18. (in Chinese with English abstract)

[7] 周云成,许童羽,郑伟,等. 基于深度卷积神经网络的番茄主要器官分类识别方法[J]. 农业工程学报,2017,33(15):219-226.

Zhou Yuncheng, Xu Tongyu, Zheng Wei, et al. Classification and recognition approaches of tomato main organs based on DCNN[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2017, 33(15): 219-226. (in Chinese with English abstract)

[8] Quiroz I A, Alferez G H. Image recognition of legacy blueberries in a chilean smart farm through deep learning[J]. Computers and Electronics in Agriculture, 2020, 168: 105044

[9] 王璨,武新慧,李志伟. 基于卷积神经网络提取多尺度分层特征识别玉米杂草[J]. 农业工程学报,2018,34(5):144-151.

Wang Can, Wu Xinhui, Li Zhiwei. Recognition of maize and weed based on multi-scale hierarchical features extracted by convolutional neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(5): 144-151. (in Chinese with English abstract)

[10] 黄双萍,孙超,齐龙,等. 基于深度卷积神经网络的水稻穗瘟病检测方法[J]. 农业工程学报,2017,33(20):169-176.

Huang Shuangping, Sun Chao, Qi Long, et al. Rice panicle blast identification method based on deep convolution neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2017, 33(20): 169-176. (in Chinese with English abstract)

[11] Li X, Pan J D, Xie F P, et al. Fast and accurate green pepper detection in complex backgrounds via an improved Yolov4-tiny model[J]. Computers and Electronics in Agriculture, 2021,191:106503.

[12] Tian Y N, Yang G D, W Z, et al. Apple detection during different growth stages in orchards using the improved YOLO-V3 model[J]. Computers and Electronics in Agriculture, 2019, 157: 417-426.

[13] 孙红,李松,李民赞,等. 农业信息成像感知与深度学习应用研究进展[J]. 农业机械学报,2020,51(5):1-17.

Sun Hong, Li Song, Li Minzan, et al. Research progress of image sensing and deep learning in agriculture[J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(5): 1-17. (in Chinese with English abstract)

[14] Wan S, Goudos S K. Faster R-CNN for multi-class fruit detection using a robotic vision system[J]. Computer Networks, 2020, 168(2): 107036.

[15] Liu Wei, Anguelov D, Erhan D, et al. SSD: Single shot multibox detector[C]. European Conference on Computer Vision, Berlin, 2016: 21-37.

[16] 袁培森,黎薇,任守纲,等. 基于卷积神经网络的菊花花型和品种识别[J]. 农业工程学报,2018,34(5):152-158.

Yuan Peisen, Li Wei, Ren Shougang, et al. Recognition for flower type and variety of chrysanthemum with convolutional neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(5): 152-158. (in Chinese with English abstract)

[17] Espejo-Garcia B, Mylonas N, Athanasakos L, et al. Towards weeds identification assistance through transfer learning[J]. Computers and electronics in agriculture. 2020, 171:105306.

[18] Mads D, Henrik K, Henrik S M, et al. Plant species classification using deep convolutional neural network[J]. Biosystems Engineering, 2016, 151: 72-80.

[19] Xiong Y Y, Liu H X, Gupta S, et al. MobileDets: Searching for object detection architectures for mobile accelerators[J/OL]. arXiv, [2021-03-31]. https://arxiv.org/abs/2004.14525.

[20] 宗泽,赵硕,刘刚. 苗期玉米冠层识别与质心定位方法研究[J]. 农业机械学报,2019,50(S1):27-33.

Zong Ze, Zhao Shuo, Liu Gang. Coronal identification and centroid location of maize seedling stage[J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(S1): 27-33. (in Chinese with English abstract)

[21] 孟庆宽,张漫,杨晓霞,等. 基于轻量卷积结合特征信息融合的玉米幼苗与杂草识别[J]. 农业机械学报,2020,51(12):238-245.

Meng Qingkuan, Zhang Man, Yang Xiaoxia, et al. Recognition of maize seedling and weed based on light weight convolution and feature fusion[J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(12): 238-245. (in Chinese with English abstract)

[22] 刘慧力, 贾洪雷, 王刚, 等. 基于深度学习与图像处理的玉米茎秆识别方法与试验[J]. 农业机械学报,2020,51(4):207-215.

Lui Huili, Jia Honglei, Wang Gang, et al. Method and experiment of maize stems recognition based on deep learning and image processing[J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(4): 207-215. (in Chinese with English abstract)

[23] Ahmad A, Saraswat D, Aggarwal V, et al. Performance of deep learning models for classifying and detecting common weeds in corn and soybean production systems[J]. Computers and Electronics in Agriculture, 2021, 184(3): 106081.

[24] Liu H J, Sun H, Li M Z, et al. Application of color featuring and deep learning in maize plant detection[J]. Remote sensing, 2020, 12(14): 2229.

[25] Zhang J, Karkee M, Zhang Q, et al. Multi-class object detection using faster R-CNN and estimation of shaking locations for automated shake-and-catch apple harvesting[J]. Computers and Electronics in Agriculture, 2020, 173: 105384.

Recognition of the maize canopy at the jointing stage based on deep learning

Sun Hong1, Qiao Jinbo2, Li Song1, Li Mingzan1※, Song Di2, Qiao Lang2

(1.,,,1000831,;2.,,,100083,)

A rapid and accurate detection of a maize plant has been widely determined the food safety and quality assurance in modern agriculture. However, there is a great challenge on the complex environment of canopy leaves at the jointing stage. It is also necessary to select a feasible network model suitable for the precise identification and positioning of maize plants in the field. In this study, a novel device was developed for canopy recognition during the maize jointing stage using deep learning. A total of 3000 images of maize in the seedling and jointing stages were also taken to train the model of deep learning. Furthermore, a labeling strategy was proposed for the sample set, where the whole maize object was replaced with the center of the maize plant. Some data enhancement techniques were utilized to increase the robustness and generalization ability of the identification model for maize plants, including the passive brightness, chroma, rotation, mirroring, and blurring. After that, three datasets of maize plants were achieved, including 10 500 training sets, 3 000 cross-validation sets, and 300 test sets. In the model training, the SSDLite-MobileDet network model was first trained on the Google Colab cloud platform, and then compared with the SSDLite-MobileNetV3 model. Finally, an optimal SSDLite-MobileDet model was achieved with a speed of 110 frames/s and an accuracy of 92.4%. More importantly, some strategies were proposed to improve the performance of the model. 1) The specific procedure of extraction was visualized for the maize images during model training using a Convolutional Neural Network (CNN). It was found that the target information was significantly enriched in the output feature mapping, as the number of CNN layers deepened gradually. 2) The heart of the plant was labelled to avoid the serious leaf crossing at the jointing stage of maize. Thus, the novel model presented an average recognition accuracy of 92.4% under severe leaf crossing and different lighting conditions. 3) A rapid detection device was built for the maize crops with Raspberry Pi 4B+Coral USB, including Raspberry Pi 4B control, accelerator fast calculation, camera image acquisition, power, and image display module. As such, a rapid and accurate platform was obtained to collect, process, and display the images of the maize canopy in the field. 4) The model that trained on the GPU was quantized to transplant the trained model to the device. The data type of FP32 was converted to INT8, thereby ensuring that the quantized model occupied less memory. 5) A software was designed to run the SSDLite-MobileDet lightweight model on Raspberry Pi 4B, further to realize the acquisition, recognition, and display of maize images. The specific operation included system initialization, model loading, images acquisition, model processing, maize canopy recognition, positioning, and display. Finally, a field experiment was carried out to evaluate the rapid detection device for the maize crops, where the frame rate of the detected video was more than 89 frame/s, and the application recognition accuracy rate reached 91%. The findings can also offer strong support to the high-precision diagnosis and refined operation of maize in the field.

deep learning; target detection; recognition; jointing stage; maize canopy

10.11975/j.issn.1002-6819.2021.21.007

S147.2

A

1002-6819(2021)-21-0053-09

孙红,乔金博,李松,等. 基于深度学习的玉米拔节期冠层识别[J]. 农业工程学报,2021,37(21):53-61.doi:10.11975/j.issn.1002-6819.2021.21.007 http://www.tcsae.org

Sun Hong, Qiao Jinbo, Li Song, et al. Recognition of the maize canopy at the jointing stage based on deep learning[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(21): 53-61. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2021.21.007 http://www.tcsae.org

2021-07-16

2021-09-14

国家重点研发计划(2019YFE0125500);国家自然科学基金资助项目(31971785和31971786);中国农业大学研究生培养项目(QYJC202101,JG202026,JG2019004和YW2020007)

孙红,博士,教授,研究方向为农业信息化技术。Email:sunhong@cau.edu.cn

李民赞,博士,教授,研究方向为精细农业系统。Email:limz@cau.edu.cn