基于RPCA和LatLRR分解的红外与可见光的图像融合

2022-01-25高清维卢一相

丁 健,高清维,卢一相,孙 冬

〈图像处理与仿真〉

基于RPCA和LatLRR分解的红外与可见光的图像融合

丁 健,高清维,卢一相,孙 冬

(安徽大学 电气工程与自动化学院,安徽 合肥 23061)

红外光和可见光图像的融合在视频监控、目标跟踪等方面发挥着越来越重要的作用。为了得到融合效果更好的图像,提出了一种新的基于鲁棒性低秩表示的图像分解与深度学习结合的方法。首先,利用鲁棒性主成分分析对训练集图像进行去噪处理,利用快速的潜在低秩表示学习提取突出特征的稀疏矩阵,并对源图像进行分解,重构形成低频图像和高频图像。然后,低频部分利用自适应加权策略进行融合,高频部分利用深度学习的VGG-19网络进行融合。最后,将新的低频图像与新的高频图像进行线性叠加,得到最后的结果。实验验证了本文提出的图像融合算法在主观评价与客观评价上均具有一定的优势。

图像融合;深度学习;潜在低秩表示;稀疏矩阵

0 引言

红外与可见光图像融合是为了得到信息更加丰富的图像。如今,红外与可见光图像的融合在很多方面发挥着作用。尤其对军事应用和现实监控装置有着重要的影响。红外图像通过热辐射能够捕捉潜在目标,但是分辨率低。相反,可见光图像能够提供大量的主要信息,但图像质量容易受外界环境的影响。如今,对于红外与可见光的图像已经有大量研究,但是很难实现融合图像噪声小,没有光晕同时包含丰富的细节信息。融合的目的就是为了让融合图像提供两张图像中的有用信息以提高图像质量,这对于人类视觉的观察以及目标的跟踪都十分有利。

图像融合的方法大多是基于像素级的融合。像素级的图像融合可以划分为变换域和空间域的图像融合。在变换域中常用的融合方法包括平稳小波变换(stationary wavelet transform, SWT)[1]和离散小波变换(discrete wavelet transform, DWT)[2],以及之后出现的双树复杂小波变化(dual-tree complex wavelet transform, DTCWT)[3],非下采样剪切波变换(non - sampling under shear wave transformation, NSST)[4]等。但是这些方法对于图像细节信息的利用并不足够。空间域的图像融合方法包括全变分最小化(total variation minimization, TV)以及加权平均法[5]。但是往往效果不是很理想。基于稀疏域的图像融合采用学习字典对图像进行稀疏表示。最常用的方法是基于稀疏表示(sparse representation, SR)。Lin等人提出了一种新的基于SR的图像融合方法[6]。此外,基于稀疏表示和其它算法相结合的算法也很多,如低秩表示(low rank representation, LRR)和稀疏表示联合[7]、NSST联合稀疏表示[8]以及SR和脉冲耦合神经网络(pulse coupled neural network, PCNN)[9]。但基于SR的方法中,字典的学习通常十分耗费时间。此外,常用的方法也包括基于低秩表示的图像融合方法。Li等人提出了一种基于潜在性低秩表示(latent low rank representation, LatLRR)的图像融合方法[10],LatLRR是一种无监督的提取方法,能够从数据中鲁棒地提取出特征,为本文的算法提供了思路。

过去的几年,深度学习不断兴起,并且融合效果得到证明。Yu、Liu等人提出了一种基于卷积稀疏表示(convolutional sparse representation, CSR)[11]以及基于卷积神经网络(Convolutional neural network, CNN)的融合方法[12],但是,基于CNN的方法只适用于多视角图像融合,基于CSR的方法存在较多的噪声,且融合后的图像突出特征并不明显。Prabahakar等提出了基于CNN的简单的图像融合算法,可是该方法的深度特征没有得到很好的利用[12]。为了解决这些缺点,Liu等提出了一种基于预训练网络的融合框架[13]。首先,经过图像分解得出源图像的高频分量和低频分量。采用平均策略对低频分量进行融合,利用深度学习框架获得融合的高频分量。将融合后的低频部分和融合后的高频部分结合起来,重建之后得出融合图像。但是该方法的图像分解方法十分简单,至于深度学习的优势没有更好地体现出来。

为了更好地融合可见光与红外图像,本文提出了一种基于RPCA(robust principal component analysis)和LatLRR分解与VGG网络结合的融合方法。为了降低噪声对融合效果产生影响,实现更好的图像分解效果,本文利用RPCA对训练数据进行去噪,之后利用无噪声的LatLRR学习得到稀疏矩阵,对源图像进行分解重建。为了保留更多的有用的图像信息,分解后的高频图像利用预训练的融合框架VGG-19提取深层次的特征进行融合,分解后的低频图像利用自适应加权融合,最后将融合后的高频图像与低频图像叠加,得到最终的融合图像。实验结果表明,该方法不仅很好地利用了可见光图像的纹理信息,也充分利用了红外光图像的特征信息,从而取得了比较不错的融合效果。

1 相关理论

目前,常用来进行特征提取的方法为深度学习和稀疏表示[14]。Liu等人提出了利用LatLRR进行子空间聚类以及特征提取,取得了很好的效果[15]。但研究发现LatLRR模型解决方法是不唯一的,使得选择LatLRR模型的解决方法变得困难[18]。故本文提出利用RPCA和LatLRR结合的图像分解方法。RPCA和LatLRR是无监督的特征提取方法,经验证可以实现很好的图像分解效果。

1.1 RPCA对训练集图像去噪

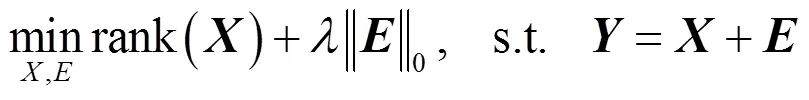

PCA在噪声较小时,效果比较好;当噪声较大时,即使只有少部分的数据被干扰,也会使PCA的性能大大降低。针对这种现象,Wright等人提出了鲁棒主成分分析(RPCA),RPCA的作用是将矩阵分解成两个部分,稀疏矩阵和低秩矩阵[17]。只要噪声矩阵是足够稀疏的,不管大小都可以恢复出低秩矩阵。其模型如(1)所示:

因为公式(1)是NP难的,故将式(1)松弛到如下凸优化问题(2):

式中:为稀疏噪声数据;为去除噪声后的训练数据。

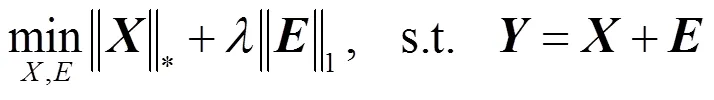

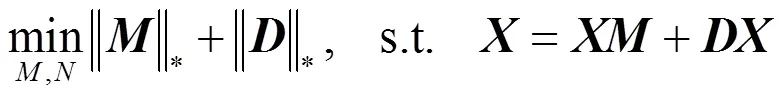

1.2 无噪声的LatLLR

在样本数量足够的情况下,LRR才可以很好地起作用。为了解决样本数据不足,Liu等人提出了潜在低秩表示(LatLRR)[15]。如公式(3)所示:

式中:||||*代表核范数;代表无噪声的数据;代表低秩矩阵;代表稀疏矩阵可以用来进行特征的提取。

2 基于RPCA和LatLRR分解的图像融合

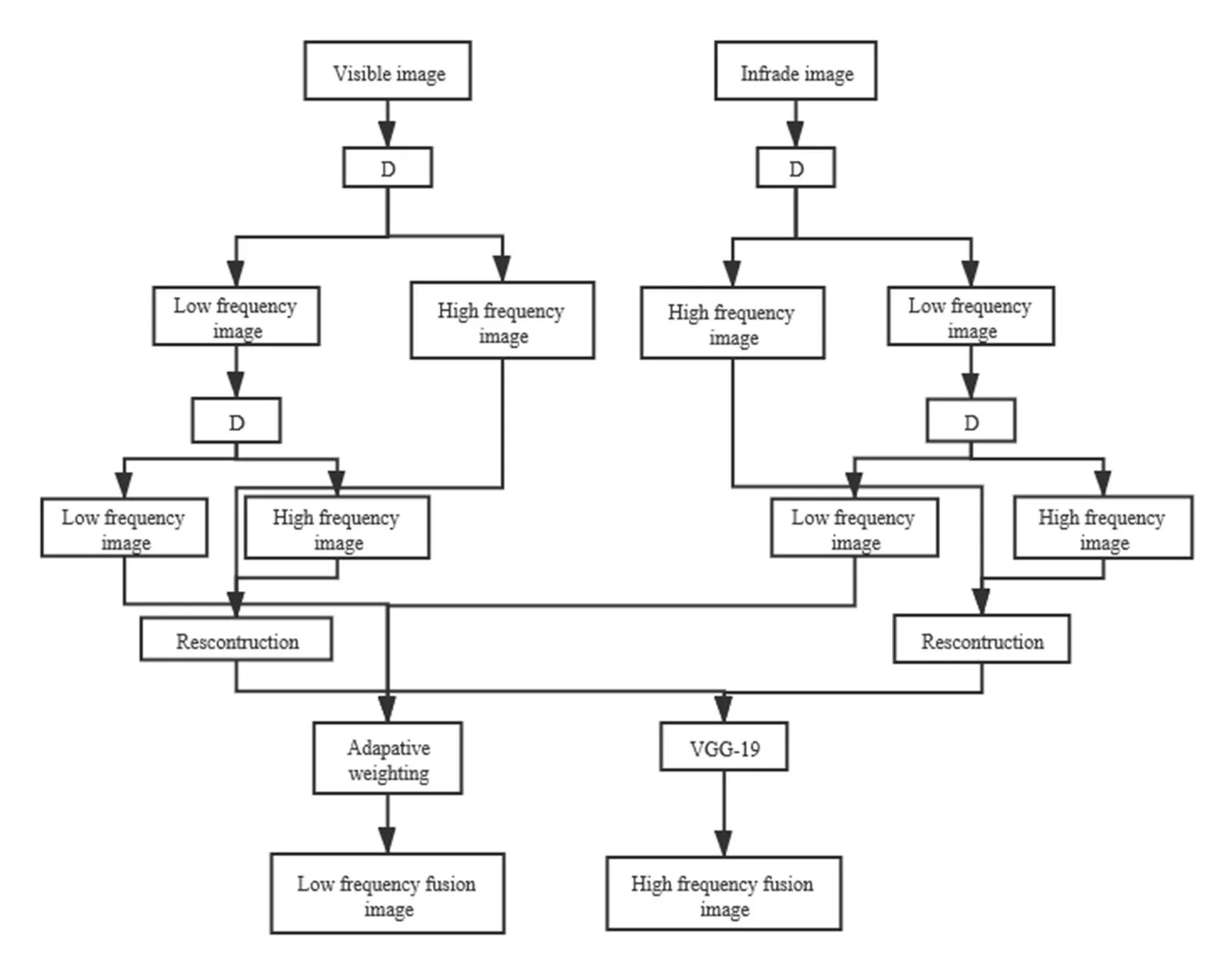

本文针对红外与可见光图像,首先,利用RPCA和LatLRR学习用于提取显著特征的矩阵,将源图像分解重构成低频图像和高频图像。之后,低频部分利用自适应权重策略进行融合,高频部分利用VGG-19网络进行融合。最后,将新的低频图像与新的高频图像进行叠加,得到融合图像。本文融合步骤如图1所示。

图1 图像融合过程

对于输入的源图像I利用重叠的窗口滑动将源图像分解成多个图像块。将每个图像块变成列向量重组成一个初始矩阵。通过公式(4)、(5)将初始矩阵分解得到高频部分和低频部分[10]:

=×(I) (4)

=I-() (5)

式中:代表图像分解的次数;代表源图像的序号;是稀疏矩阵;()代表前文提到的窗口滑动以及重组;()代表前文提到的图像重建。

当一张源图像经过次分解之后,得到高频分量1:k和低频分量。对1:k使用上文提到的窗口滑动以及重组方法进行重建,得到一张高频图像分量。

2.1 稀疏矩阵

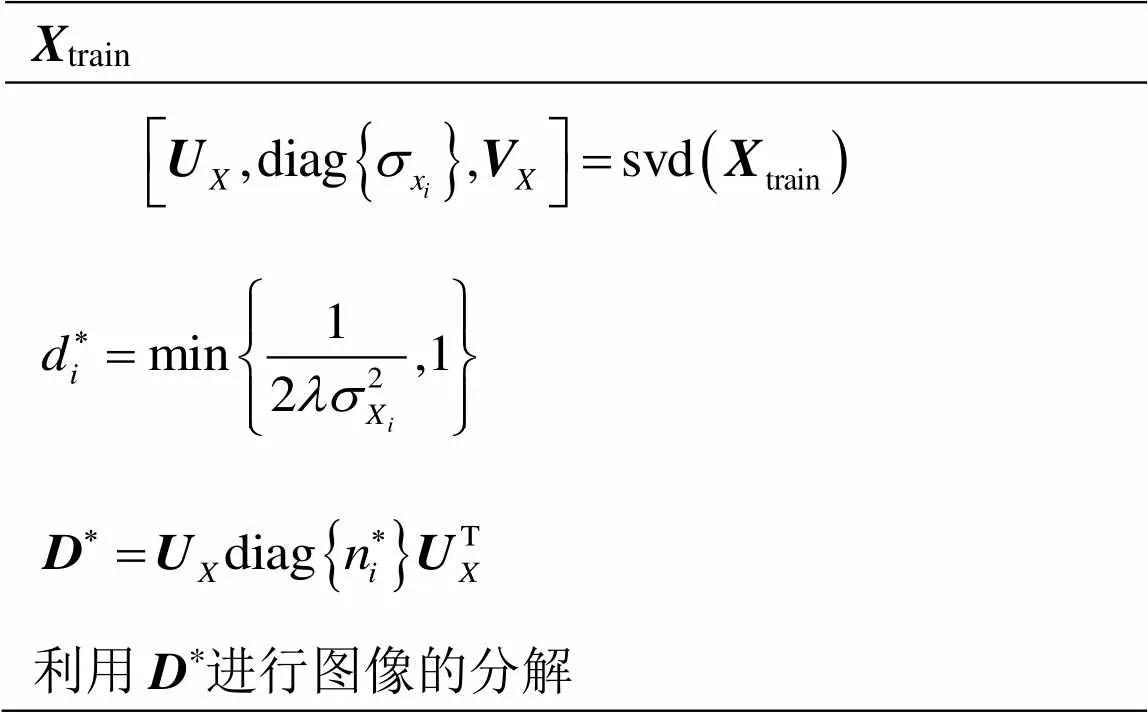

本文利用RPCA和无噪声的LatLRR训练得到稀疏矩阵。1.2中利用RPCA得到无噪声数据,再利用8×8滑动窗口将这些无噪声数据分解成多个图像块,产生矩阵train。稀疏矩阵训练过程如表1所示[16]。表1中的方法实验操作简洁,能够实现更好的图像分解效果。

表1 稀疏矩阵D的训练过程

2.2 低频分量融合

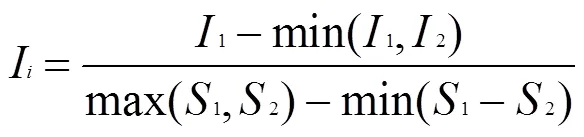

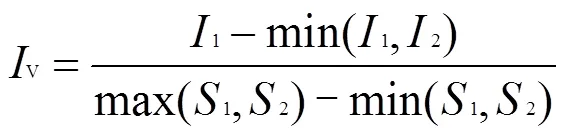

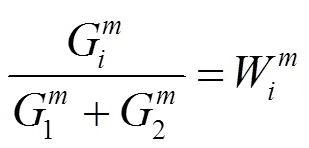

图像的低频部分代表图像的主要部分,因此低频分量的图像融合的效果起着重要的作用[19]。虽然加权平均法和绝对值法可以达到低频融合的目的,但效果较差。本文采用自适应加权法,利用RPCA和无噪声的LatLRR对图像进行分解,分解得到低频分量1,2通过公式(6)、(7)、(8)、(9)得到低频融合的权重1,2。

式中:S(,)=I(,)-,(,)表示图像的像素点;表示图像的平均像素点;={1,2}分别代表可见光和红外图像。I和I分别表示红外与可见光低频分量计算结果。

融合后的低频图像可以表示为(10):

I=1×1+2×2(10)

2.3 高频分量融合

为了突出融合图像的细节特征和边缘部分,本文采用已经训练好的VGG-19提取高频图像特征。VGG-19网络结构中包含3个全连接层,5个池化层以及5个卷积层。通过公式(11)能够得到VGG-19网络的特征[20]:

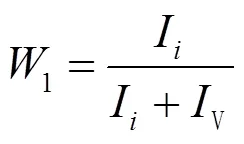

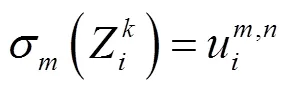

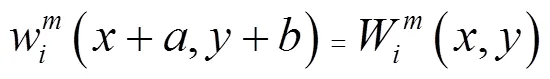

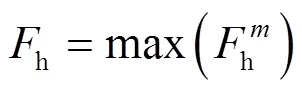

式中:(×)代表VGG-19网络中的一层,={1,2,3,4,5},代表5个卷积组。通过如下步骤可以得到权重w。

式中:,Î{0,1,…,(2-1-1)},代表块平均策略中块的大小,本文中=1,与代表求和的窗口范围。

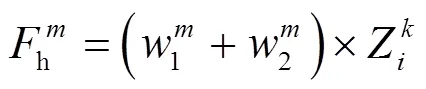

本文中有5组权重矩阵w,每一组的高频分量融合如公式(16)表示:

再由公式(17)选择出融合效果最好的高频分量融合图。

3 实验结果与分析

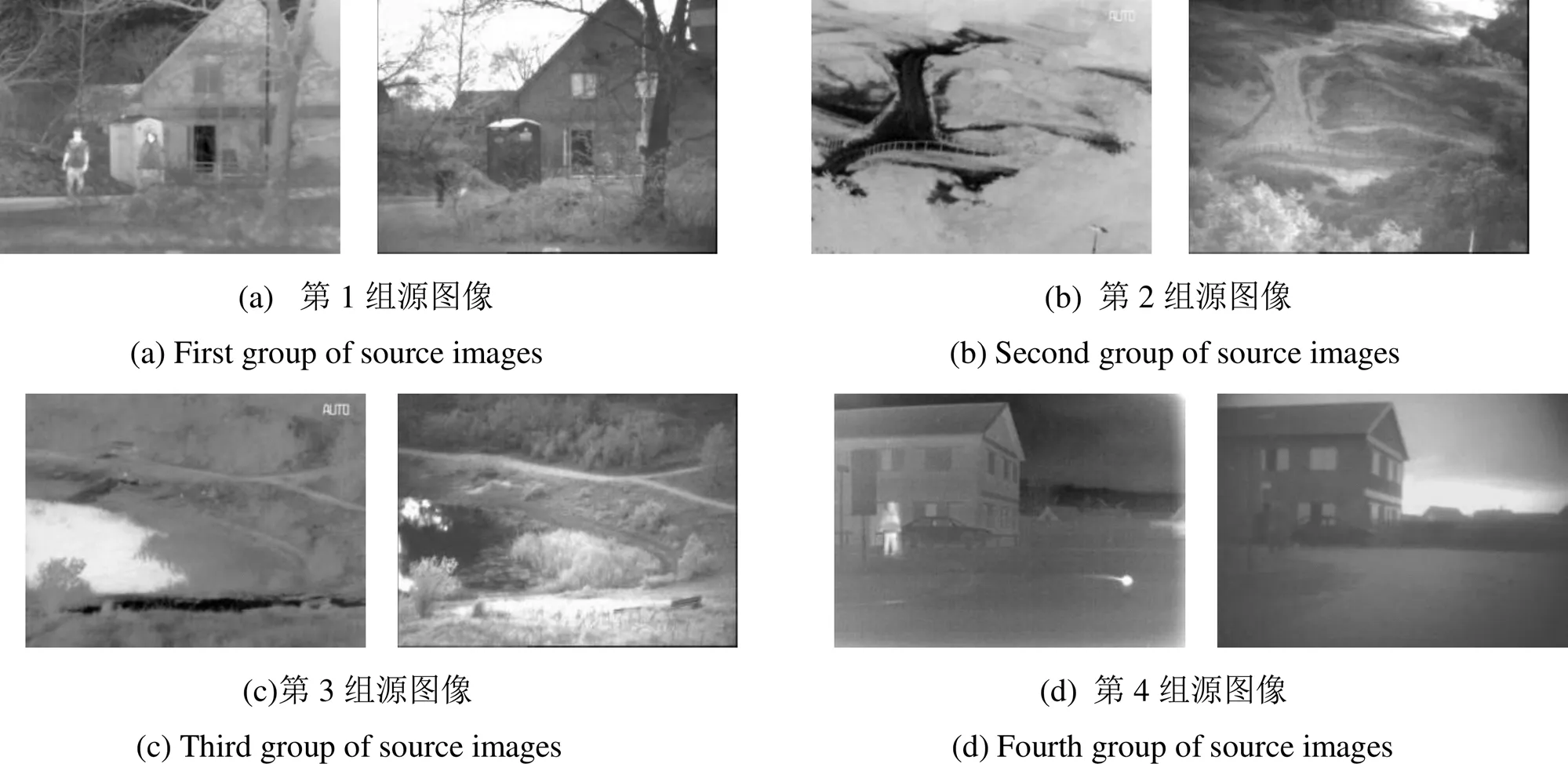

为了验证本实验方法的有效性和可行性,在WINDOWS 10和MATLAB 2018A的基础上进行了4组实验,如图2所示。本文从TNO Image Fusion Dataset中选取6组经过配准的源图像进行稀疏矩阵的训练,另外选择了4种具有代表性的图像融合方法与本文的方法进行比较。

图2 4组红外与可见光源图像

3.1 测评指标

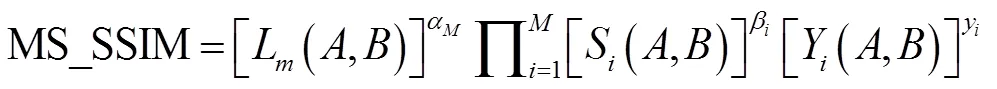

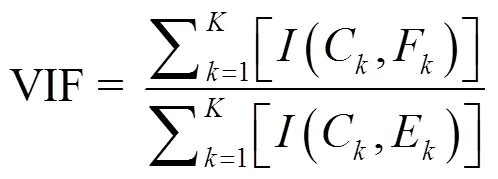

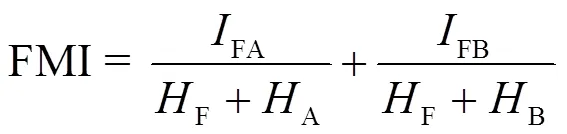

本文选取了多层级图像结构相似性,差分相关性之和,视觉信息保真度,特征相互信息,abf五种评价指标。

1)多层级图像结构相似性(Multi scale structural similarity index,MS_SSIM)能更好地与人眼的视觉系统的视觉感知相一致[21]。并且在一定的尺度下,评价效果优于SSIM。公式如下:

式中:(,),(,),(,)分别表示亮度比较,对比度比较和结构比较。与、分别代表该比较的重要程度。

2)差分相关性之和(difference and correlation, SCD)在图像融合的应用中,要求融合图像应包含尽可能多的来自输入图像的信息[22]。SCD反应图像的反差大小,反差越大,则融合图像效果越好,公式如下:

1=-2(19)

2=-1(20)

SCD=1,1)+2,2) (21)

式中:S表示源图像;表示融合后的图像;D表示融合图像与源图像之间的差异。(×)计算相关度,={1,2},分别代表红外与可见光图像。

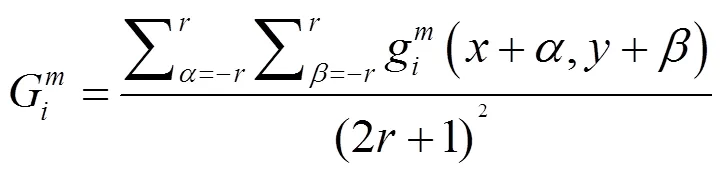

3)视觉信息保真度(visual information fidelity, VIF)基于视觉信息保真度提出的衡量融合图像质量的指标[23]。VIF越大,则图像融合的效果就越好,可以表示为:

式中:代表图像块中的子带;和分别代表参考图像和融合图像;(×)代表互信息量的计算。

4)特征相互信息(feature mutual information ,FMI)与质量相关的大多数信息都包含在细节信息里,并且与一些特征(如边缘、纹理和对比度)相关[24]。FMI值越大,代表融合图像细节信息越多,公式如下:

式中:FA与FB分别表示源图像;A、B表示源图像的熵值;F表示融合后图像的熵值。

5)abf表示融合过程中人为添加到融合图像上的噪声比率。abf的值越小,图像融合的效果就越好。

3.2 仿真结果及分析

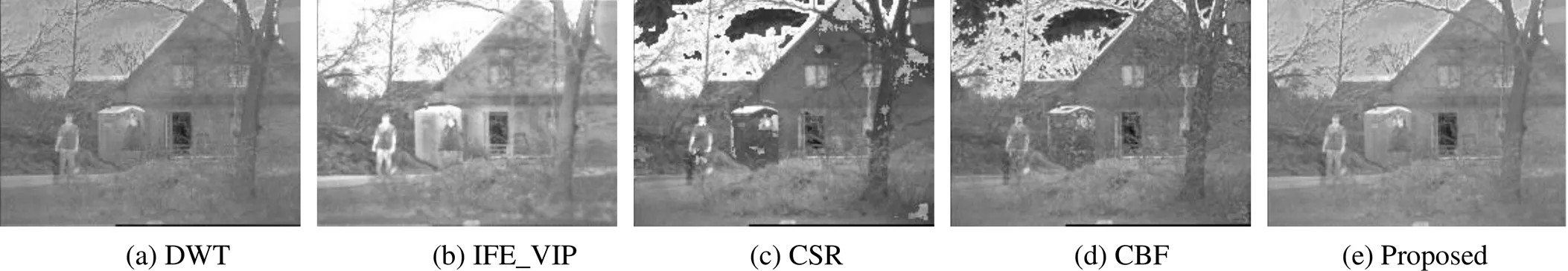

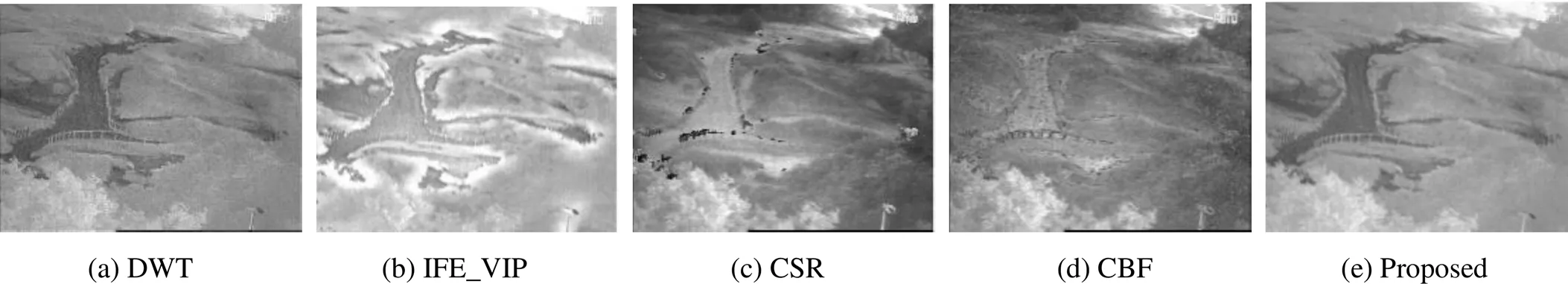

本文分别选用基于离散小波(DWT)的图像融合算法以及基于红外特征提取和视觉信息度保存(Infrared feature extraction and visual information preservation , IFE_VIP)的图像融合算法[27]、基于卷积稀疏表示的图像融合(CSR)[25]以及基于交叉双边滤波器的图像融合方法(Cross bilateral filter, CBF)[26]与本文提出的融合算法进行对比。DWT通过小波变换将图像分解成高频部分以及低频部分,低频部分采用均值,高频部分采用区域能量最大值;IFE_VIP利用四叉树分解以及贝塞尔插值提取红外图像背景图,将其与可见光图像线性叠加;CSR通过双尺度图像分解将图像分解成高频部分以及低频部分,高频部分利用基于稀疏表示的方法,低频部分采用平均策略;CBF通过从源图像中利用双边交叉滤波进行权值计算,直接用于源图像的融合。从主观角度来看,所有融合算法均达到图像融合的目的,但融合效果却不尽相同。

DWT的融合图像的亮度低,细节信息损失严重,如图3中的叶子。CBF融合图像虽然亮度适中但是却产生了黑色斑点,如图4中图像的边缘以及主体部分。由于高频分量融合步骤简单,DWT和CBF均存在人工信息以及突出特征不明显的问题。IFE_VIP很好地保存了背景细节和主体目标,但是人的部分存在过度增强,如图3和图4中人的部分。由于IFE_VIP的图像分解能力有限,融合图像的边缘产生了光晕,如融合后图5的边缘部分。本文提出的融合算法因为使用RPCA和LatLRR分解所以融合图像不会产生光晕,且不易受到噪声的影响。CSR的融合图像和CBF效果类似,产生了较大范围的黑色斑块或者斑点,例如图6,CSR在融合后图像的边缘部分产生了黑色斑块,CBF融合后的图像在纹理信息处产生了很多明显的黑色斑点。由于CSR在变换域需要融合系数,如果这些系数产生小的变化,空间域就会产生较大的变化。所以,易受到伪像的影响。本文提出的融合算法对比度适中,保留细节信息完整,没有产生光晕,实现了更好的融合效果。

图3 第1组仿真结果

图4 第2组仿真结果

图5 第3组仿真结果

但是主观判断误差较大,并容易受外界影响。故本文选取了MS_SSIM,SCD,VIF,FMI,abf五种评价指标。

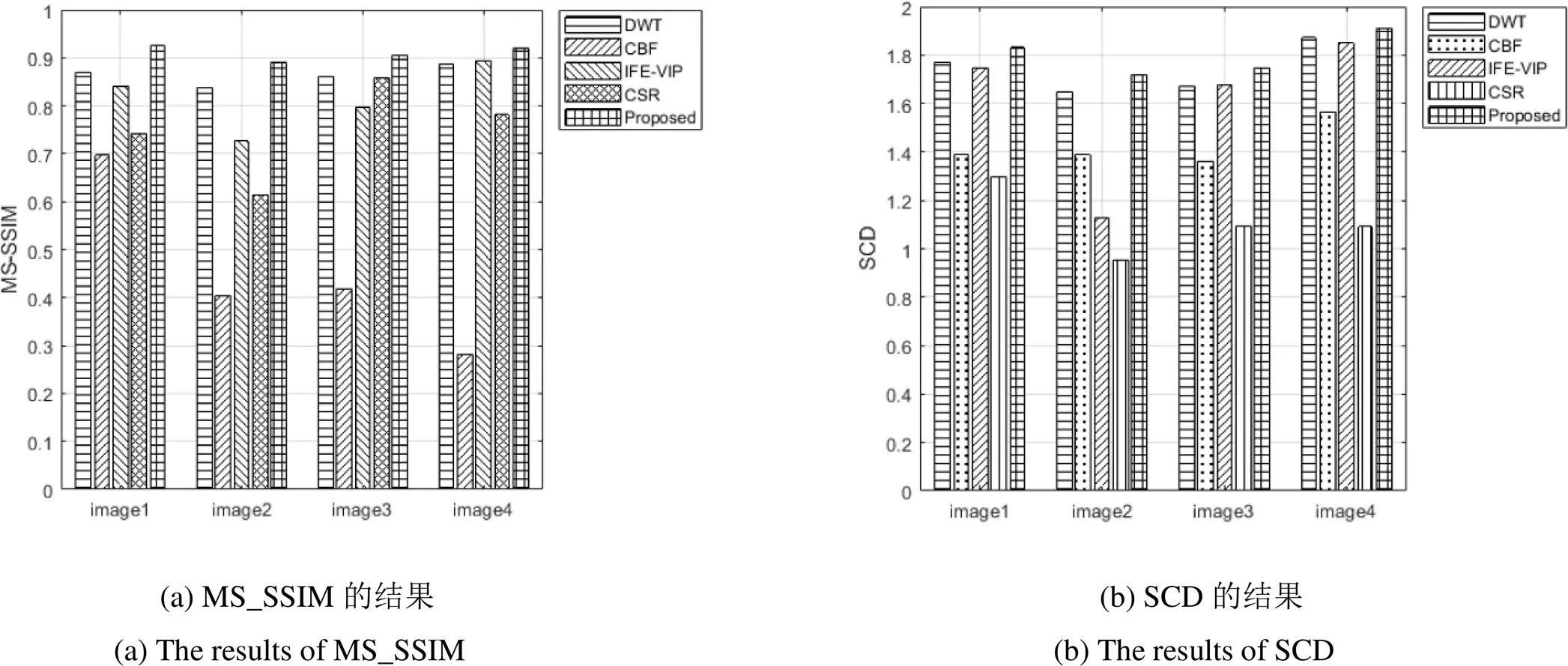

从图7中可知本文提出的融合算法在FMI、SCD、MS_SSIM这3个指标上完全优于对比算法,表明本文算法得出的融合图像与源图像结构更相似,且包含的源图像转移的信息更多,细节信息也更多。在指标VIF上仅对于第3组源图像的值略低于CBF算法,但其它组均高于对比算法。在abf指标上,远远低于对比算法,正是由于对于训练集图像进行了PRCA去噪,才会使得融合图像的噪声更小。

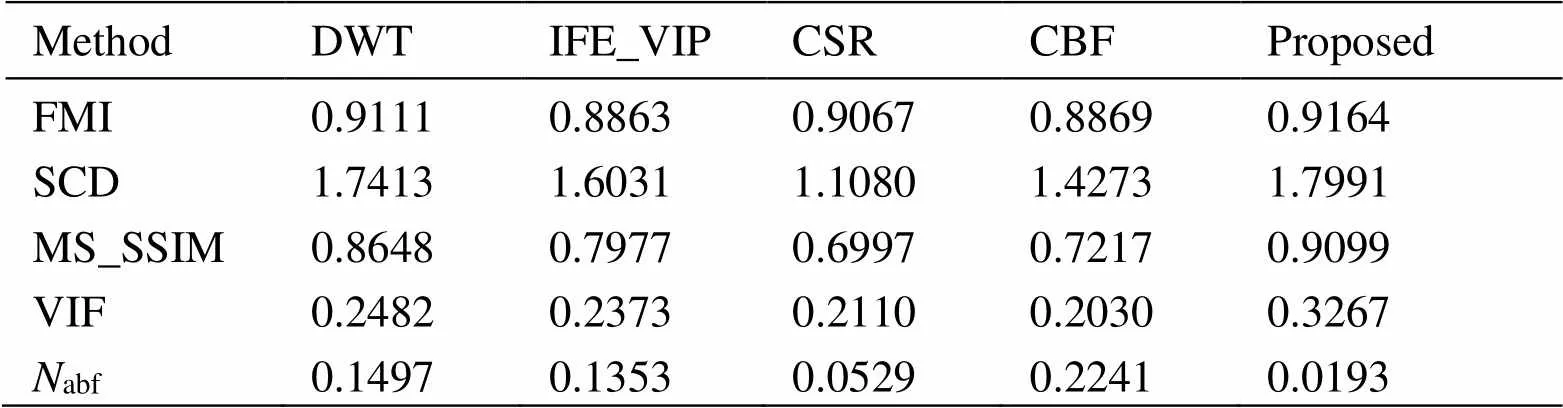

从表2中可以看出,本文提出的融合算法在FMI、SCD、MS_SSIM、VIF、abf这5种指标上,平均值均高于其他算法,说明本文算法融合后的图像包含更多的有效信息,与理想结果更接近,得到的融合图像更加清晰,且增加的人工噪声更少。

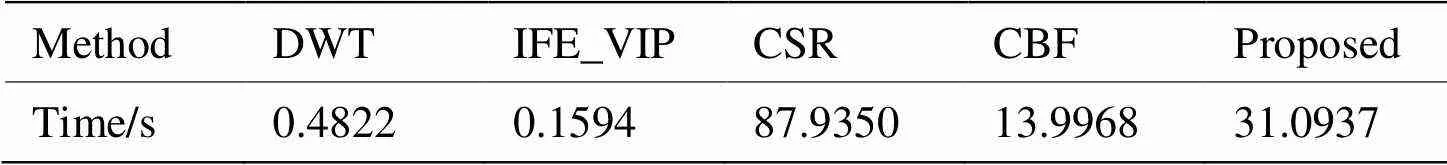

表3列出了5种算法在TNO Image Fusion Dataset上运行时间的对比,虽然本文方法运行时间较长,但是融合后的图像细节信息更加丰富、噪声更小,融合效果更加出色。

表2 不同融合图像的客观评价结果

表3 不同融合方法的计算时间对比

4 结论

为了解决红外与可见光图像融合中细节纹理信息易丢失以及深度学习对于图像融合方法中源图像分解过于简单、LatLRR的解决选择困难等问题,本文提出了一种基于RPCA改进的LatLRR分解的红外光与可见光的图像融合方法。首先利用RPCA和LatLRR快速训练得到稀疏矩阵,其次,利用稀疏矩阵与滑动窗口技术对源图像进行分解重构,得到高频图像分量和低频图像分量。高频图像部分利用已经训练好的VGG-19网络进行特征提取,得到融合后的高频图像。低频部分利用自适应加权策略,得到融合后的低频图像。最后,将融合后的高频图像与低频图像线性相加得到最后的融合图像。实验结果表明,在主观和客观两方面,本文所提出的方法均具有更好的融合效果。下一步将着重于优化算法中的参数以适应多种类型图像融合。

[1] DENG Y, LI C, ZHANG Z, et al. Image fusion method for infrared and visible light images based on SWT and regional gradient[C]//20173rd(), 2017: 976-979, doi: 10.1109/ITOEC.2017.8122499.

[2] BEN H A, Yun H, Hamid K, et al. A multiscale approach to pixel-level image fusion[J]., 2005, 12(2): 135-146.

[3] Goshtasby A A, Nikolov S. Image fusion: advances in the state of the art[J]., 2007, 8(2): 114-118.

[4] LUO X Q, LI X Y, WANG P F, et al. Infrared and visible image fusion based on NSCT and stacked sparse autoencoders[J]., 2018, 77(17): 22407-22431.

[5] MA J, MA Y, LI C. Infrared and visible image fusion methods and applications: a survey[J]., 2019, 45: 153-178.

[6] YANG J, Wright J, HUANG T S, et al. Image super-resolution via sparse representation[C]//, 2010, 19(11): 2861-2873, Doi: 10.1109/TIP.2010.2050625.

[7] 王文卿, 高钰迪, 刘涵, 等. 基于低秩稀疏表示的红外与可见光图像序列融合方法[J]. 西安理工大学学报, 2019, 35(3): 8. WANG W Q, GAO Y D, LIU H, et al. Fusion method of infrared and visible image sequences based on low rank sparse representation[J]., 2019, 35(3): 8.

[8] 康家银, 陆武, 张文娟. 融合NSST和稀疏表示的PET和MRI图像融合[J]. 小型微型计算机系统, 2019(12): 2506-2511. KANG J Y, LU W, ZHANG W J. Pet and MRI image fusion based on NSST and sparse representation[J]., 2019(12): 2506-2511.

[9] 王建, 吴锡生. 基于改进的稀疏表示和PCNN的图像融合算法研究[J]. 智能系统学报, 2019, 14(5): 7. WANG J, WU X S. Image fusion algorithm based on improved sparse representation and PCNN[J]., 2019, 14(5): 7.

[10] LI H, WU X, Kittler J. MD LatLRR: A Novel Decomposition Method for Infrared and Visible Image Fusion[C]//, 2020, 29: 4733-4746. Doi: 10. 1109/TIP. 2020. 2975984.

[11] YU L, XUN C, Ward R K, et al. Image fusion with convolutional sparse representation[J]., 2016(99): 1-1.

[12] Prabhakar K R, Srikar V S, Babu R V. Deep fuse: a deep unsupervised approach for exposure fusion with extreme exposure image pairs[C]//,, 2017: 4724-4732.

[13] LIU Y, CHEN X, CHENG J, et al. Infrared and visible image fusion with convolutional neural networks[J]., 2018, 16(3): S0219691318500182.

[14] WANG X Z, YIN J F, ZHANG K, et al. Infrared weak-small targets fusion based on latent low-rank representation and DWT[J]., 2019, 7: 112681-112692. Doi: 10.1109/ACCESS.2019.2934523.

[15] LIU G, YAN S. Latent Low-rank representation for subspace segmentation and feature extraction[C]//,2011: 1615-1622. Doi: 10.1109/ICCV.2011.6126422.

[16] WANG Y M, Morariu V I, Davis L S. Unsupervised feature extraction inspired by latent low-rank representation[C]//, 2015: 542-549. Doi: 10. 1109/WACV.2015.78.

[17] Wright J, MA Y, Mairal J, et al. Sparse representation for computer vision and pattern recognition[J]., 2010, 98(6): 1031-1044.

[18] ZHANG H, LIN Z, ZHANG C, et al. Robust latent low rank representation for subspace clustering[J]., 2014, 145(5): 369-373.

[19] 谢艳新. 基于LatLRR和PCNN的红外与可见光融合算法[J]. 液晶与显示, 2019, 34(4): 100-106. XIE Y X. Infrared and visible light fusion algorithm based on latLRR and PCNN[J]., 2019, 34(4): 100-106.

[20] LI H, WU X J, Kittler J. Infrared and visible image fusion using a deep learning framework[C]//24th(), 2018: 2705-2710. Doi: 10.1109/ICPR.2018. 8546006.

[21] WANG Z, Simoncelli E P, Bovik A C. Multiscale structural similarity for image quality[C]//, 2003, 2: 1398-140. Doi: 10.1109/ACSSC. 2003.1292216.

[22] Aslantas V L, Bendes E. A new image quality metric for image fusion: The sum of the correlations of differences[J]., 2015, 69(12):1890-1896.

[23] lantas V, Bendes E. A new image quality metric for image fusion: The sum of the correlations of differences[J]., 2015, 69(12): 1890-1896.

[24] Haghighat M, Razian M A. Fast-FMI: Non-reference image fusion metric[C]//, 2014: 1-3.

[25] LIU Y, CHEN X, Ward R, et al. Image fusion with convolutional sparse representation[J]., 2016, 23(12): 1882-1886. Doi: 10.1109/LSP.2016.2618776.

[26] Kumar B K S. Image fusion based on pixel significance using cross bilateral filter[J]., 2015, 9(5): 1193-1204.

[27] ZHANG Y, ZHANG L, BAI X, et al. Infrared and visual image fusion through infrared feature extraction and visual information preservation[J]., 2017, 83: 227-237.

Infrared and Visible Image Fusion Algorithm Based on the Decomposition of Robust Principal Component Analysis and Latent Low Rank Representation

DING Jian,GAO Qingwei,LU Yixiang,SUN Dong

(School of Electrical Engineering and Automation, Anhui University, Hefei 230601, China)

The fusion of infrared and visible images plays an important role in video surveillance, target tracking, etc. To obtain better fusion results for images, this study proposes a novel method combining deep learning and image decomposition based on a robust low-rank representation. First, robust principal component analysis is used to denoise the training set images. Next, rapid latent low rank representation is used to learn a sparse matrix to extract salient features and decompose the source images into low-frequency and high-frequency images. The low-frequency components are then fused using an adaptive weighting strategy, and the high-frequency components are fused by a VGG-19 network. Finally, the new low-frequency image is superimposed with the new high-frequency image to obtain a fused image. Experimental results demonstrate that this method has advantages in terms of both the subjective and objective evaluation of image fusion.

image fusion, deep learning, latent low rank representation, sparse matrix

TN391

A

1001-8891(2022)01-0001-08

2020-10-13;

2021-03-30.

丁健(1997-),男,安徽芜湖人,硕士研究生,研究方向为图像处理。E-mail: 1522523398@qq.com。

高清维(1965-),男,安徽合肥人,教授,博导,研究方向为数字图像处理、信号处理、模式识别等。E-mail: qingweigao@ahu.edu.cn。

国家自然科学基金项目(61402004,61370110);安徽省高等学校自然科学基金项目(KJ2018A0012)。